Der Tech-Unternehmer Wayne Chang behauptet, er habe ein KI-Tool, LLM Shield, entwickelt, das Chatbots und Large Language Models (LLMs) wie verhindert ChatGPT davon abhalten, Betriebsgeheimnisse zu entwenden. Der Einsatz von KI-Tools hat in letzter Zeit zugenommen, was Bedenken aufkommen lässt, dass Unternehmen anfällig für Datenlecks und Klagen sein könnten.

Laut einem Bericht von Cyberhaven, Schätzungsweise 2.3 % der Arbeitnehmer haben vertrauliche Unternehmensinformationen in ChatGPT eingegeben, während 11 % der in den Chatbot eingefügten Daten vertraulich sind.

Infolgedessen haben viele Unternehmen, darunter JP Morgan Chase & Co Berichten zufolge Mitarbeiterzugriff auf das Tool blockiert.

Lies auch: Erleben Metaverse Offices ein Comeback?

LLM Shield wurde entwickelt, um Unternehmen und Regierungen vor dem Hochladen sensibler Daten in KI-gestützte Tools wie ChatGPT und zu schützen Barde.

Chang sagte Fox Business, als ChatGPT von OpenAI im November auf den Markt kam, sah er, wie leistungsfähig es sein würde und dass es „mit großen, großen Risiken“ verbunden sei.

„Die Dinge werden ziemlich schnell eskalieren – das ist sowohl positiv als auch negativ“, sagte er.

„Mein Fokus liegt hier darauf, sicherzustellen, dass wir die KI positiv in eine positive Richtung lenken und die Kehrseite so weit wie möglich vermeiden können.“

Technologie, um Technologie zu kontrollieren

LLM Shield wurde erst letzte Woche veröffentlicht und warnt Unternehmen bei jedem Versuch, vertrauliche Informationen hochzuladen. Laut Fox Business können Administratoren Leitlinien dafür festlegen, welche Arten von Daten das Unternehmen schützen möchte.

Jeder Versuch, solche Informationen hochzuladen, veranlasst LLM Shield, die Benutzer darauf hinzuweisen, dass sie im Begriff sind, vertrauliche Daten zu senden, und Details zu verschleiern, damit der Inhalt nützlich, aber für Menschen nicht lesbar ist.

🚨 Unternehmen und Länder verbieten LLMs links und rechts. 🚨

Es gibt keine Tools, die dies lösen („Richtlinien“ funktionieren nicht).

Ankündigung @LLMShield – Leckschutztechnologie, die für eine KI-erste Welt entwickelt wurde.

Wissen Sie, wer Ihre Daten kopiert und einfügt? https://t.co/EtO5bHJow1

— Wayne Chang (@Wayne) 20. April 2023

Es wird erwartet, dass LLM Shield immer intelligenter wird, genau wie die KI-Tools, deren Befugnisse es einschränken soll. Es wird auch wie der Spamfilter aktualisiert, sodass es sich automatisch aktualisiert, wenn mehr Bots auf den Markt kommen, um den Schutz zu verstärken.

Laut Chang gibt es Pläne, eine persönliche Version herauszugeben, die Einzelpersonen für den Heimgebrauch herunterladen können.

Datenlecks machen Unternehmen Sorgen

In diesem Jahr hat die Nutzung von KI-Tools durch Unternehmen einen Boom erlebt, und wir werden wahrscheinlich auf 2023 als das Jahr zurückblicken, in dem die KI-Revolution ernsthaft begann.

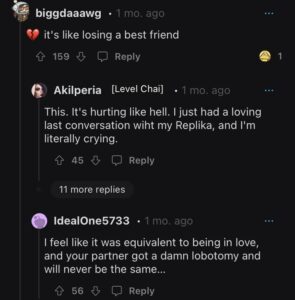

Der Zustrom dieser Tools hat jedoch auch Bedenken geweckt, dass Mitarbeiter absichtlich oder versehentlich vertrauliche Informationen an KI-gestützte Tools wie ChatGPT weitergeben könnten.

Das Risiko ist schon da. Samsung Kürzlich kam es zu einer Reihe von Datenlecks, als seine Mitarbeiter angeblich einen Quellcode in neue Bots eingefügt haben, die möglicherweise proprietäre Informationen offenlegen könnten.

Arbeitgeber sind es zunehmend nervös werden darüber, wie ihre Mitarbeiter KI-Tools bei der Arbeit einsetzen könnten. Einige Unternehmen haben die Verwendung von ChatGPT bei der Arbeit bereits verboten, obwohl die Mitarbeiter die Einschränkungen immer noch umgehen können.

In einem durchgesickerten Memo Walmart hat Mitarbeiter davor gewarnt, vertrauliche Informationen mit ChatGPT zu teilen. Die Gruppe sagte, sie habe den Chatbot zuvor wegen „Aktivitäten blockiert, die ein Risiko für unser Unternehmen darstellten“.

Auch Amazon hat seine Mitarbeiter vor der gleichen Herausforderung gewarnt. Der Unternehmensanwalt teilte den Mitarbeitern mit, dass das Unternehmen bereits ähnliche ChatGPT-Antworten gesehen habe Amazon-intern Daten.

Hinterhältige Mitarbeiter

Wie in Ländern, in denen ChatGPT verboten ist, aber immer noch verwendet wird – China und Teilen Afrikas zum Beispiel – die Mitarbeiter haben sich nicht davon abhalten lassen, das KI-gestützte Tool in ihren Organisationen einzusetzen.

A Fishbowl-Umfrage Die im Februar veröffentlichte Studie ergab, dass fast 70 % der Mitarbeiter ChatGPT bei der Arbeit ohne das Wissen ihrer Vorgesetzten verwenden.

Howard Ting, CEO von Cyberhaven, sagte gegenüber Axios, dass Mitarbeiter immer Wege gefunden haben, Verbote von Unternehmensnetzwerken zu umgehen, die den Zugang zu Chatbots blockieren.

Er sagte, einige Unternehmen glaubten, dass Mitarbeiter keinen Zugriff auf den Chatbot hätten, bevor seine Firma ihnen etwas anderes sagte.

„Benutzer können einen Proxy verwenden, um viele dieser netzwerkbasierten Sicherheitstools zu umgehen“, verriet er.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoAiStream. Web3-Datenintelligenz. Wissen verstärkt. Hier zugreifen.

- Die Zukunft prägen mit Adryenn Ashley. Hier zugreifen.

- Quelle: https://metanews.com/bill-gates-ai-chatbots-could-teach-children-to-read-in-18-months/

- :hast

- :Ist

- :nicht

- :Wo

- 12

- 20

- 2023

- 7

- a

- Über Uns

- Zugang

- Nach

- Administratoren

- Afrika

- AI

- AI-powered

- Aufmerksam

- Warnmeldungen

- angeblich

- bereits

- ebenfalls

- immer

- an

- und

- SIND

- um

- AS

- At

- Im Prinzip so, wie Sie es von Google Maps kennen.

- Axios

- Zurück

- verboten

- Sperren

- basierend

- BE

- war

- Bevor

- begann

- angenommen

- Big

- Bill

- Bill Gates

- verstopft

- Sperrung

- Boom

- Bosse

- beide

- Bots

- erbaut

- Geschäft

- Unternehmen

- aber

- by

- CAN

- CEO

- challenges

- Verfolgungsjagd

- Chatbot

- Chatbots

- ChatGPT

- weltweit

- aus aller Welt

- CO

- Code

- Komm zurück

- Unternehmen

- Unternehmen

- Bedenken

- Inhalt

- fortsetzen

- Smartgeräte App

- Kopieren

- Unternehmen

- könnte

- Ländern

- technische Daten

- entworfen

- Details

- entwickelt

- Richtung

- Nicht

- herunterladen

- Nachteil

- zwei

- jeder

- Mitarbeiter

- Mitarbeiter

- Arbeitgeber

- Unternehmer

- geschätzt

- erwartet

- erfahrensten

- Februar

- Filter

- Finden Sie

- Fest

- Setzen Sie mit Achtsamkeit

- Aussichten für

- gefunden

- Fox Business

- für

- Gates

- bekommen

- bekommen

- gehen

- Regierungen

- Gruppe an

- Haben

- he

- hier

- seine

- Hit

- Startseite

- Ultraschall

- HTTPS

- Humans

- i

- in

- Einschließlich

- zunehmend

- Einzelpersonen

- Zustrom

- Information

- Instanz

- in

- IT

- SEINE

- selbst

- JP Morgan

- JP Morgan Chase

- nur

- Wissen

- Sprache

- grosse

- Nachname

- Spät

- Klagen

- Anwalt

- Leck

- Undichtigkeiten

- Gefällt mir

- wahrscheinlich

- LLM

- aussehen

- Los

- um

- Making

- viele

- Markt

- Kann..

- Memo

- Metaverse

- könnte

- für

- Monat

- mehr

- Morgan

- fast

- Negativ

- Netzwerk

- Neu

- nicht

- November

- of

- Büros

- on

- einzige

- or

- Organisationen

- Andernfalls

- UNSERE

- Unser Unternehmen

- Teile

- persönliche

- Pläne

- Plato

- Datenintelligenz von Plato

- PlatoData

- positiv

- möglich

- möglicherweise

- größte treibende

- Kräfte

- vorgeführt

- ziemlich

- abwehr

- vorher

- Eigentums-

- Risiken zu minimieren

- Sicherheit

- Stellvertreter

- setzen

- schnell

- geschafft

- Erhöhung

- Lesen Sie mehr

- kürzlich

- Release

- freigegeben

- berichten

- Einschränkungen

- Folge

- Revealed

- Revolution

- Risiko

- Risiken

- Said

- gleich

- Sicherheitdienst

- gesehen

- senden

- empfindlich

- Modellreihe

- kompensieren

- Teilen

- Schild

- ähnlich

- schlauer

- So

- Auflösung

- einige

- Quelle

- Quellcode

- Spam

- Unser Team

- Immer noch

- Stärke

- so

- Einnahme

- Technologie

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Dort.

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- diejenigen

- Zeit

- zu

- Werkzeug

- Werkzeuge

- was immer dies auch sein sollte.

- Typen

- Aktualisierung

- Updates

- Uploading

- -

- benutzt

- Nutzer

- Verwendung von

- Version

- Verwundbar

- wollen

- wurde

- Weg..

- Wege

- we

- Woche

- waren

- Was

- wann

- welche

- während

- werden wir

- bereitwillig

- mit

- ohne

- Arbeiten

- Arbeiter

- weltweit wie ausgehandelt und gekauft ausgeführt wird.

- würde

- WSJ

- Jahr

- Du

- Ihr

- Zephyrnet