Betrug im Internet könnte jetzt viel gefährlicher werden, da Betrüger ungehinderten Zugang zu ChatGPT, Techradar haben Berichte.

Der weit verbreitete KI-gestützte Chatbot ChatGPT macht ständig Schlagzeilen. Mit seiner Fähigkeit, alles zu schreiben, vom Debuggen von Iframe-Code bis hin zu komplexem Computerprogrammiercode, hat ChatGPT KI als technisches Schlagwort des Jahres etabliert.

Trotz seiner enormen Popularität und seines Engagements hat ChatGPT Bedenken hinsichtlich Ethik und Regulierung ausgelöst.

Lies auch: ChatGPT-Benutzer „Jailbreak“-KI, entfesseln Dan Alter Ego

Eine kürzlich berichten Die von Cybersicherheitsforschern der Norton Labs veröffentlichte Studie legte drei wichtige Möglichkeiten dar, wie Bedrohungsakteure ChatGPT missbrauchen könnten. Der Bericht weist darauf hin, dass ChatGPT missbraucht werden könnte, um Internetbetrug effektiver zu machen: durch die Generierung von Deep-Fake-Inhalten, die Erstellung von Phishing und die Erstellung von Malware.

„Norton Labs geht davon aus, dass Betrüger auch die Fähigkeiten großer Sprachmodelle im Auge behalten und Möglichkeiten testen, ihre Cyberkriminalität zu verbessern, um sie realistischer und glaubwürdiger zu machen“, heißt es in dem Bericht.

Die Fähigkeit des Tools, „qualitativ hochwertige Fehlinformationen oder Desinformationen in großem Umfang“ zu produzieren, könnte Bot-Farmen dabei helfen, Zwietracht effektiver zu intensivieren. Dies könnte es böswilligen Akteuren ermöglichen, mühelos „Zweifel zu schüren und Erzählungen in mehreren Sprachen zu manipulieren“, so Norton.

Sehr überzeugende „Fehlinformation“

Businesspläne, Strategien und Firmenbeschreibungen überzeugend zu schreiben ist für ChatGPT ein Kinderspiel. Dieses Potenzial erhöht jedoch auch das Risiko von Fehlinformationen, die sich in einen Betrug verwandeln können.

„Die von ChatGPT generierten Inhalte sind nicht nur manchmal unbeabsichtigt falsch, sondern ein schlechter Akteur kann diese Tools auch verwenden, um absichtlich Inhalte zu erstellen, die dazu dienen, Menschen auf irgendeine Weise zu schaden“, heißt es in dem Bericht.

Seine Fähigkeit, „qualitativ hochwertige Fehlinformationen oder Desinformationen in großem Maßstab zu generieren, könnte zu Misstrauen führen und Erzählungen in verschiedenen Sprachen prägen“.

Das Schreiben von Bewertungen von Produkten ist mit ChatGPT immer einfacher geworden, was nicht nachverfolgt werden kann, da es jedes Mal individuelle Antworten mit denselben bereitgestellten Informationen generiert. Trotz seiner Fähigkeit stellt es die Herausforderung dar, „gefälschte Rezensionen und schäbige Produkte zu erkennen“.

Besorgniserregend ist, dass das Tool auch für Mobbing verwendet werden könnte.

„Die Verwendung dieser Tools in Belästigungskampagnen in sozialen Medien, um Menschen zum Schweigen zu bringen oder zu schikanieren, ist ebenfalls ein mögliches Ergebnis, das eine abschreckende Wirkung auf die Sprache haben würde“, heißt es in dem Bericht.

ChatGPT in Phishing-Kampagnen

ChatGPT ist besonders gut darin, menschlich klingenden Text in verschiedenen Sprachen zu generieren, wobei die Leser nicht wissen, ob der Text von KI oder von Menschen erstellt wurde. Selbst OpenAI, der Entwickler von ChatGPT, kann nicht erkennen, ob ein Text von KI geschrieben wurde, und erklärt, dass „es unmöglich ist, alle KI-geschriebenen Texte zuverlässig zu erkennen“.

Die Aussicht, dass ChatGPT in Phishing-Kampagnen verwendet wird, ist real.

„Böswillige Akteure können ChatGPT verwenden, um Phishing-E-Mails oder Social-Media-Beiträge zu erstellen, die scheinbar aus legitimen Quellen stammen, wodurch es schwieriger wird, diese Art von Bedrohungen zu erkennen und sich dagegen zu wehren“, heißt es in dem Bericht.

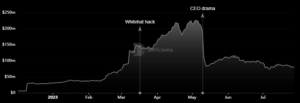

Da seine Popularität zunimmt, ist eine wahrscheinliche Folge eine Zunahme der Anzahl von „Phishing-Kampagnen und ihrer Raffinesse“.

Der Bericht schlug vor, dass „böswillige Akteure ChatGPT mit realen Beispielen für nicht böswillige Nachrichten von den Unternehmen füttern können, die sie imitieren möchten, und der KI befehlen, neue Nachrichten auf der Grundlage des gleichen Stils mit böswilliger Absicht zu erstellen.“

Solche Kampagnen könnten sich als äußerst erfolgreich erweisen, wenn es darum geht, Einzelpersonen dazu zu verleiten, persönliche Informationen preiszugeben oder Geld an kriminelle Organisationen zu senden. Norton Labs riet Verbrauchern, vorsichtig zu sein, wenn sie „auf Links klicken oder persönliche Informationen angeben“.

ChatGPT kann Malware erstellen

Das Generieren von Code und das Anpassen verschiedener Programmiersprachen ist einfach ein fester Bestandteil der Dienste von ChatGPT. Es ist also kein Wunder, dass Betrüger es verwenden, um Malware zu generieren.

„Mit der richtigen Eingabeaufforderung können unerfahrene Malware-Autoren beschreiben, was sie tun möchten, und funktionierende Code-Snippets erhalten“, heißt es in dem Bericht. Dies stellt eine ernsthafte Bedrohung durch Malware-Angriffe dar, die weit genug fortgeschritten sind, um Chaos anzurichten.

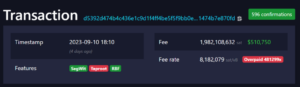

„Ein Beispiel ist die Generierung von Code, der erkennt, wenn eine Bitcoin-Wallet-Adresse in die Zwischenablage kopiert wird, damit sie durch eine bösartige Adresse ersetzt werden kann, die vom Malware-Autor kontrolliert wird“, erklärte der Bericht.

Infolgedessen wird die Verfügbarkeit eines solchen Chatbots zu einer Steigerung der Komplexität von Malware führen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://metanews.com/chatgpt-is-being-used-to-make-quality-scams/

- :Ist

- 7

- 8

- a

- Fähigkeit

- Fähig

- Über Uns

- Missbrauch

- Zugang

- Nach

- Akteure

- Adresse

- advanced

- gegen

- AI

- AI-powered

- Hilfe

- Alle

- und

- vorwegnehmen

- erscheinen

- SIND

- AS

- At

- Anschläge

- Autor

- Autoren

- Verfügbarkeit

- Badewanne

- basierend

- BE

- weil

- werden

- Sein

- Bitcoin

- Bitcoin Wallet

- Wander- und Outdoorschuhen

- Schikane

- Geschäft

- by

- Kampagnen

- CAN

- kann keine

- Fähigkeiten

- Kapazität

- Verursachen

- vorsichtig

- challenges

- Chatbot

- ChatGPT

- Code

- Unternehmen

- Unternehmen

- Komplex

- Computer

- Bedenken

- KUNDEN

- Inhalt

- Generierung von Inhalten

- ständig

- gesteuert

- könnte

- Handwerk

- erstellen

- Schaffung

- Kriminell

- Internet-Sicherheit

- Gefährlich

- beschreiben

- Entwickler:in / Unternehmen

- anders

- schwer

- Offenlegung

- Zwietracht

- Desinformation

- zweifeln

- jeder

- bewirken

- Effektiv

- effektiv

- E-Mails

- ermöglichen

- Engagement

- Entitäten

- etablierten

- Ethik

- Sogar

- alles

- Beispiel

- Beispiele

- erklärt

- Fälschung

- Farms

- Aussichten für

- Betrügern

- für

- erzeugen

- erzeugt

- erzeugt

- Erzeugung

- Generation

- bekommen

- gut

- Haben

- mit

- Schlagzeilen

- hoch

- aber

- HTTPS

- riesig

- human

- identifizieren

- unmöglich

- in

- Erhöhung

- Steigert

- zunehmend

- angegeben

- Krankengymnastik

- Einzelpersonen

- Information

- Absicht

- absichtlich

- Internet

- IT

- SEINE

- Wesentliche

- Labs

- Sprache

- Sprachen

- grosse

- führen

- Lebensdauer

- Links

- wenig

- Los

- um

- Making

- Malware

- max-width

- Medien

- Nachrichten

- könnte

- Fehlinformationen

- Misstrauen

- für

- Geld

- mehr

- mehrere

- Erzählungen

- Neu

- Notizen

- Anfänger

- Anzahl

- of

- on

- EINEM

- OpenAI

- Auftrag

- Ergebnis

- Teil

- besonders

- Personen

- persönliche

- Phishing

- Pläne

- Plato

- Datenintelligenz von Plato

- PlatoData

- Play

- Spielen für

- Beliebt

- Popularität

- Posen

- möglich

- BLOG-POSTS

- Potenzial

- produziert

- Produziert

- Produkte

- Programmierung

- Programmiersprachen

- Aussicht

- Belegen

- vorausgesetzt

- Bereitstellung

- veröffentlicht

- Lesen Sie mehr

- Leser

- echt

- wahres Leben

- realistisch

- kürzlich

- Rechtliches

- ersetzt

- berichten

- Forscher

- Folge

- Bewertungen

- Risiken

- gleich

- Skalieren

- Betrug

- Betrüger

- Betrug

- Sendung

- ernst

- Lösungen

- Form

- Schweigen

- einfach

- So

- Social Media

- Social Media

- Social Media Beiträge

- einige

- Quellen

- Rede

- Trotz

- angegeben

- Strategien

- Stil

- erfolgreich

- so

- Tech

- Testen

- Vielen Dank

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Diese

- Bedrohung

- Bedrohungsakteure

- Bedrohungen

- nach drei

- Durch

- Zeit

- zu

- Werkzeug

- Werkzeuge

- WENDE

- Typen

- entfesseln

- -

- Nutzer

- Wallet

- Weg..

- Wege

- Was

- ob

- welche

- weit

- werden wir

- mit

- arbeiten,

- würde

- schreiben

- geschrieben

- Zephyrnet