GPUs sind ein leistungsstarkes Tool für Machine-Learning-Workloads, obwohl sie nicht unbedingt das richtige Tool für jeden KI-Job sind, so Michael Bronstein, Leiter der Graph-Learning-Forschung bei Twitter.

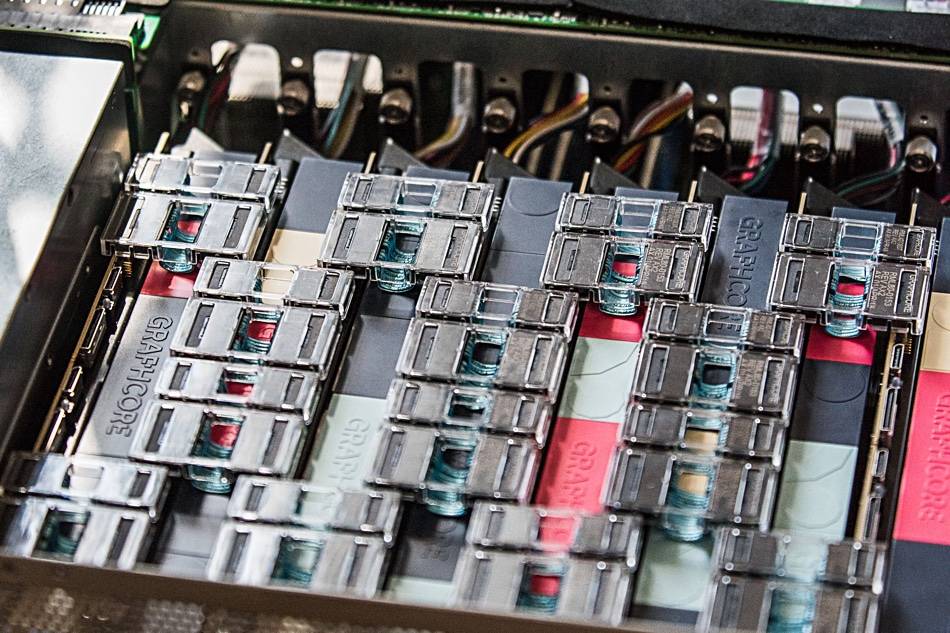

Sein Team hat kürzlich gezeigt, dass die KI-Hardware von Graphcore eine „Beschleunigung um eine Größenordnung beim Vergleich eines einzelnen IPU-Prozessors mit einer Nvidia A100-GPU“ in TGN-Modellen (Temporal Graph Network) bietet.

„Die Wahl der Hardware für die Implementierung von Graph ML-Modellen ist ein entscheidendes, aber oft übersehenes Problem“, heißt es in a gemeinsamer Artikel geschrieben von Bronstein mit Emanuele Rossi, einem ML-Forscher bei Twitter, und Daniel Justus, einem Forscher bei Graphcore.

Graphische neuronale Netze bieten eine Möglichkeit, Ordnung in komplexen Systemen zu finden, und werden häufig in sozialen Netzwerken und Empfehlungssystemen verwendet. Die dynamische Natur dieser Umgebungen macht es jedoch besonders schwierig, diese Modelle zu trainieren, erklärte das Trio.

Die Gruppe untersuchte die Lebensfähigkeit der IPUs von Graphcore im Umgang mit mehreren TGN-Modellen. Anfängliche Tests wurden an einem kleinen TGN-Modell durchgeführt, das auf dem basiert JODIE Wikipedia-Datensatz, der Benutzer mit Änderungen verknüpft, die sie an Seiten vorgenommen haben. Das Diagramm bestand aus 8,227 Benutzern und 1,000 Artikeln für insgesamt 9,227 Knoten. JODIE ist ein Open-Source-Vorhersagesystem, das entwickelt wurde, um zeitliche Interaktionsnetzwerke zu verstehen.

Die Experimente des Trios ergaben, dass große Chargengrößen im Vergleich zu kleineren Chargengrößen zu einer verschlechterten Validierung und Inferenzgenauigkeit führten.

„Der Knotenspeicher und die Graph-Konnektivität werden beide erst aktualisiert, nachdem ein vollständiger Batch verarbeitet wurde“, schrieb das Trio. „Daher können sich die späteren Ereignisse innerhalb einer Charge auf veraltete Informationen stützen, da sie sich früherer Ereignisse nicht bewusst sind.“

Durch die Verwendung einer Stapelgröße von 10 konnte die Gruppe jedoch eine optimale Validierungs- und Inferenzgenauigkeit erreichen, stellte jedoch fest, dass die Leistung auf der IPU der einer GPU immer noch überlegen war, selbst bei Verwendung großer Stapelgrößen.

„Bei Verwendung einer Stapelseite von 10 kann TGN auf der IPU etwa 11-mal schneller trainiert werden, und selbst bei einer großen Stapelgröße von 200 ist das Training auf der IPU immer noch dreimal schneller“, heißt es in dem Beitrag. „In allen Arbeitsgängen bewältigt die IPU kleine Losgrößen effizienter.“

Das Team geht davon aus, dass der schnelle Speicherzugriff und der hohe Durchsatz, die der große prozessorinterne SRAM-Cache von Graphcore bietet, der IPU einen Vorteil verschafften.

Dieser Leistungsvorsprung erstreckte sich auch auf Grafikmodelle, die den prozessorinternen Speicher der IPU überstiegen – jede IPU verfügt über einen 1 GB SRAM-Cache – was die Verwendung von langsamerem DRAM-Speicher erfordert, der an die Chips angeschlossen ist.

Beim Testen eines Graphenmodells, das aus 261 Millionen Folgen zwischen 15.5 Millionen Twitter-Nutzern besteht, hat die Verwendung von DRAM für den Knotenspeicher den Durchsatz um den Faktor zwei verringert, fand Bronsteins Team heraus.

Als jedoch mehrere Unterdiagramme basierend auf einem synthetischen Datensatz mit der 10-fachen Größe des Twitter-Diagramms induziert wurden, stellte das Team fest, dass der Durchsatz unabhängig von der Diagrammgröße skaliert wurde. Mit anderen Worten, der Leistungseinbruch war das Ergebnis der langsameren Speichernutzung und nicht das Ergebnis der Modellgröße.

„Mit dieser Technik auf der IPU kann TGN auf nahezu beliebige Graphgrößen angewendet werden, die nur durch die Menge des verfügbaren Hostspeichers begrenzt sind, während ein sehr hoher Durchsatz während des Trainings und der Inferenz beibehalten wird“, heißt es in dem Artikel.

Das Team kam zu dem Schluss, dass die IPU-Architektur von Graphcore bei Workloads, bei denen Rechen- und Speicherzugriff heterogen sind, einen erheblichen Vorteil gegenüber GPUs aufweist.

Generell gilt jedoch, dass ML-Forscher ihre Hardwareauswahl sorgfältig abwägen und nicht standardmäßig GPUs verwenden sollten.

„Die Verfügbarkeit von Cloud-Computing-Diensten, die die zugrunde liegende Hardware abstrahieren, führt in dieser Hinsicht zu einer gewissen Faulheit“, schrieb das Trio. „Wir hoffen, dass unsere Studie mehr Aufmerksamkeit auf dieses wichtige Thema lenkt und den Weg für zukünftige, effizientere Algorithmen und Hardwarearchitekturen für Graph-ML-Anwendungen ebnet.“ ®

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Das Register

- Zephyrnet