1LIACS, Universität Leiden, Niels Bohrweg 1, 2333 CA Leiden, Niederlande

2QuSoft, Centrum Wiskunde & Informatica (CWI), Science Park 123, 1098 XG Amsterdam, Niederlande

3Institut für Physik, Universität Amsterdam, Science Park 904, 1098 XH Amsterdam, Niederlande

4LION, Universität Leiden, Niels Bohrweg 2, 2333 CA Leiden, Niederlande

Findest du dieses Paper interessant oder möchtest du darüber diskutieren? Scite oder hinterlasse einen Kommentar zu SciRate.

Abstrakt

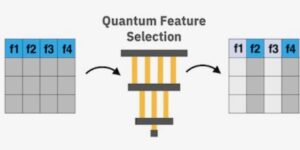

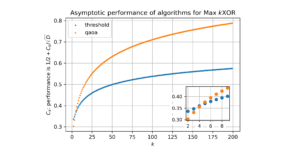

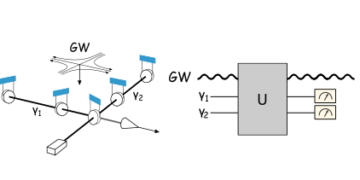

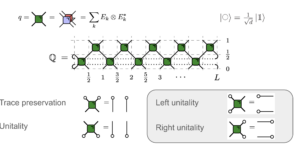

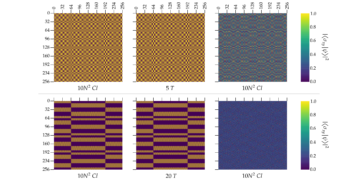

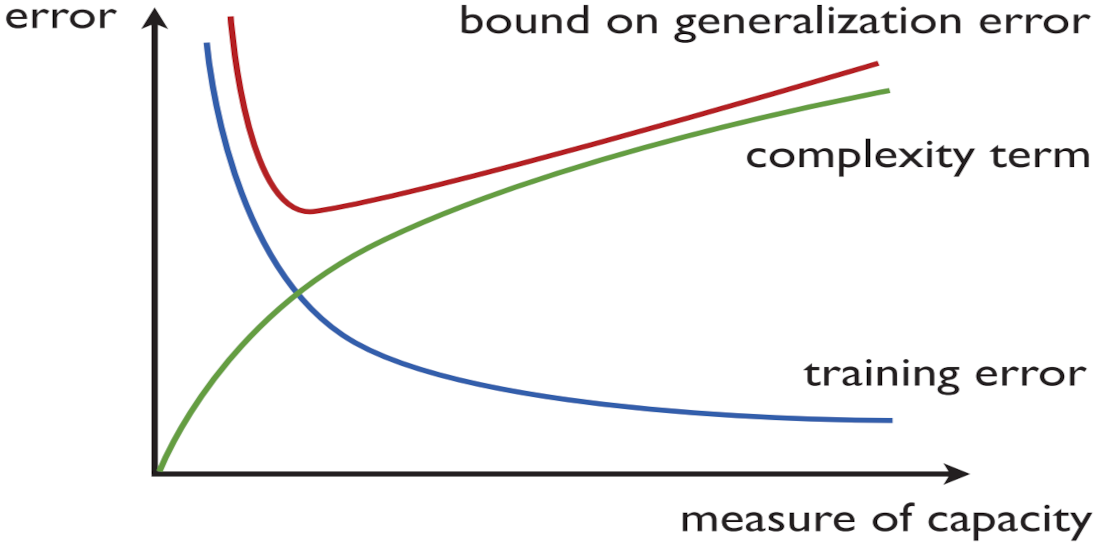

Modelle des maschinellen Quantenlernens (QML), die auf parametrisierten Quantenschaltkreisen basieren, werden oft als Kandidaten für die kurzfristige „Killeranwendung“ des Quantencomputers hervorgehoben. Das Verständnis der empirischen und Generalisierungsleistung dieser Modelle steckt jedoch noch in den Kinderschuhen. In diesem Artikel untersuchen wir, wie man zwischen Trainingsgenauigkeit und Generalisierungsleistung (auch als strukturelle Risikominimierung bezeichnet) für zwei prominente QML-Modelle, die von Havlíček et al. [1], und Schuld und Killoran [2]. Erstens beweisen wir anhand von Beziehungen zu gut verstandenen klassischen Modellen, dass zwei Modellparameter – dh die Dimension der Summe der Bilder und die Frobenius-Norm der vom Modell verwendeten Observablen – die Komplexität des Modells und damit seine Verallgemeinerungsleistung genau steuern . Zweitens beweisen wir anhand von Ideen, die von der Prozesstomographie inspiriert sind, dass diese Modellparameter auch die Fähigkeit der Modelle, Korrelationen in Sätzen von Trainingsbeispielen zu erfassen, genau steuern. Zusammenfassend ergeben sich aus unseren Ergebnissen neue Optionen zur strukturellen Risikominimierung für QML-Modelle.

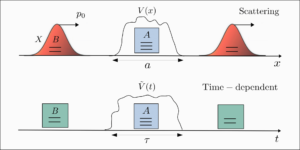

Ausgewähltes Bild: Illustration der strukturellen Risikominimierung (Quelle: Mohri, Mehryar, Afshin Rostamizadeh und Ameet Talwalkar. Foundations of Machine Learning. MIT Press, 2018).

► BibTeX-Daten

► Referenzen

[1] Vojtěch Havlíček, Antonio D. Córcoles, Kristan Temme, Aram W. Harrow, Abhinav Kandala, Jerry M. Chow und Jay M. Gambetta. „Überwachtes Lernen mit quantenerweiterten Merkmalsräumen“. Natur 567 (2019). arXiv:1804.11326.

https://doi.org/10.1038/s41586-019-0980-2

arXiv: 1804.11326

[2] Maria Schuld und Nathan Killoran. „Quantenmaschinelles Lernen in Feature-Hilbert-Räumen“. Physical Review Letters 122 (2019). arXiv:1803.07128.

https://doi.org/ 10.1103/PhysRevLett.122.040504

arXiv: 1803.07128

[3] Frank Arute, Kunal Arya, Ryan Babbush, Dave Bacon, Joseph C. Bardin, Rami Barends, Rupak Biswas, Sergio Boixo, Fernando GSL Brandao, David A. Buell, et al. „Quantenüberlegenheit mit einem programmierbaren supraleitenden Prozessor“. Natur 574 (2019). arXiv:1910.11333.

https://doi.org/10.1038/s41586-019-1666-5

arXiv: 1910.11333

[4] John Preskill. „Quantencomputing in der NISQ-Ära und darüber hinaus“. Quantum 2 (2018). arXiv:1801.00862.

https://doi.org/10.22331/q-2018-08-06-79

arXiv: 1801.00862

[5] Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C. Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R. McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio, et al. „Variative Quantenalgorithmen“. Nature Reviews Physics 3 (2021). arXiv:2012.09265.

https://doi.org/10.1038/s42254-021-00348-9

arXiv: 2012.09265

[6] Jarrod R. McClean, Jonathan Romero, Ryan Babbush und Alán Aspuru-Guzik. „Die Theorie der Variations-Hybrid-Quanten-klassischen Algorithmen“. Neue Zeitschrift für Physik 18 (2016). arXiv:1509.04279.

https://doi.org/10.1088/1367-2630/18/2/023023

arXiv: 1509.04279

[7] Abhinav Kandala, Antonio Mezzacapo, Kristan Temme, Maika Takita, Markus Brink, Jerry M Chow und Jay M Gambetta. „Hardwareeffizienter Variations-Quanten-Eigenlöser für kleine Moleküle und Quantenmagnete“. Natur 549 (2017). arXiv:1704.05018.

https: / / doi.org/ 10.1038 / nature23879

arXiv: 1704.05018

[8] Peter JJ O’Malley, Ryan Babbush, Ian D. Kivlichan, Jonathan Romero, Jarrod R. McClean, Rami Barends, Julian Kelly, Pedram Roushan, Andrew Tranter, Nan Ding, et al. „Skalierbare Quantensimulation molekularer Energien“. Körperliche Überprüfung X 6 (2016). arXiv:1512.06860.

https://doi.org/ 10.1103/PhysRevX.6.031007

arXiv: 1512.06860

[9] Edward Farhi, Jeffrey Goldstone und Sam Gutmann. „Ein quantennaher Optimierungsalgorithmus“ (2014). arXiv:1411.4028.

arXiv: 1411.4028

[10] Marcello Benedetti, Erika Lloyd, Stefan Sack und Mattia Fiorentini. „Parametrisierte Quantenschaltkreise als Modelle für maschinelles Lernen“. Quantenwissenschaft und -technologie 4 (2019). arXiv:1906.07682.

https://doi.org/10.1088/2058-9565/ab4eb5

arXiv: 1906.07682

[11] Barbara M. Terhal und David P. DiVincenzo. „Adaptive Quantenberechnung, Quantenschaltkreise mit konstanter Tiefe und Arthur-Merlin-Spiele“. Quanteninformation und -berechnung 4 (2004). arXiv:quant-ph/0205133.

https:///doi.org/10.48550/arXiv.quant-ph/0205133

arXiv: quant-ph / 0205133

[12] Michael J. Bremner, Richard Jozsa und Dan J. Shepherd. „Die klassische Simulation von Pendelquantenberechnungen impliziert den Zusammenbruch der Polynomhierarchie“. Proceedings of the Royal Society A: Mathematical, Physical and Engineering Sciences 467 (2011). arXiv:1005.1407.

https: / / doi.org/ 10.1098 / rspa.2010.0301

arXiv: 1005.1407

[13] Edward Grant, Marcello Benedetti, Shuxiang Cao, Andrew Hallam, Joshua Lockhart, Vid Stojevic, Andrew G. Green und Simone Severini. „Hierarchische Quantenklassifikatoren“. npj Quantum Information 4 (2018). arXiv:1804.03680.

https://doi.org/10.1038/s41534-018-0116-9

arXiv: 1804.03680

[14] Diego Ristè, Marcus P. Da Silva, Colm A. Ryan, Andrew W. Cross, Antonio D. Córcoles, John A. Smolin, Jay M. Gambetta, Jerry M. Chow und Blake R. Johnson. „Demonstration des Quantenvorteils beim maschinellen Lernen“. npj Quantum Information 3 (2017). arXiv:1512.06069.

https://doi.org/10.1038/s41534-017-0017-3

arXiv: 1512.06069

[15] Mehryar Mohri, Afshin Rostamizadeh und Ameet Talwalkar. „Grundlagen des maschinellen Lernens“. MIT-Presse. (2018).

[16] Peter L. Bartlett. „Die Probenkomplexität der Musterklassifizierung mit neuronalen Netzen: Die Größe der Gewichte ist wichtiger als die Größe des Netzwerks“. IEEE-Transaktionen zur Informationstheorie 44 (1998).

https: / / doi.org/ 10.1109 / 18.661502

[17] Maria Schuld. „Überwachte quantenmechanische Lernmodelle sind Kernel-Methoden“ (2021). arXiv:2101.11020.

arXiv: 2101.11020

[18] Matthias C. Caro und Ishaun Datta. „Pseudo-Dimension von Quantenschaltkreisen“. Quantenmaschinenintelligenz 2 (2020). arXiv:2002.01490.

https://doi.org/10.1007/s42484-020-00027-5

arXiv: 2002.01490

[19] Kaifeng Bu, Dax Enshan Koh, Lu Li, Qingxian Luo und Yaobo Zhang. „Zur statistischen Komplexität von Quantenschaltkreisen“ (2021). arXiv:2101.06154.

https: / / doi.org/ 10.1103 / PhysRevA.105.062431

arXiv: 2101.06154

[20] Kaifeng Bu, Dax Enshan Koh, Lu Li, Qingxian Luo und Yaobo Zhang. „Auswirkungen von Quantenressourcen auf die statistische Komplexität von Quantenschaltkreisen“ (2021). arXiv:2102.03282.

arXiv: 2102.03282

[21] Kaifeng Bu, Dax Enshan Koh, Lu Li, Qingxian Luo und Yaobo Zhang. „Rademacher-Komplexität verrauschter Quantenschaltkreise“ (2021). arXiv:2103.03139.

arXiv: 2103.03139

[22] Amira Abbas, David Sutter, Christa Zoufal, Aurélien Lucchi, Alessio Figalli und Stefan Woerner. „Die Macht quantenneuronaler Netze“. Naturinformatik 1 (2021). arXiv:2011.00027.

https://doi.org/10.1038/s43588-021-00084-1

arXiv: 2011.00027

[23] Yuxuan Du, Zhuozhuo Tu, Xiao Yuan und Dacheng Tao. „Effizientes Maß für die Aussagekraft von Variationsquantenalgorithmen“. Physical Review Letters 128 (2022). arXiv:2104.09961.

https://doi.org/ 10.1103/PhysRevLett.128.080506

arXiv: 2104.09961

[24] Leonardo Banchi, Jason Pereira und Stefano Pirandola. "Verallgemeinerung beim Quantenmaschinenlernen: Ein Quanteninformationsstandpunkt". PRX Quantum 2 (2021). arXiv:2102.08991.

https: / / doi.org/ 10.1103 / PRXQuantum.2.040321

arXiv: 2102.08991

[25] Hsin-Yuan Huang, Michael Broughton, Masoud Mohseni, Ryan Babbush, Sergio Boixo, Hartmut Neven und Jarrod R. McClean. „Macht der Daten im Quantenmaschinenlernen“. Naturkommunikation 12 (2021). arXiv:2011.01938.

https://doi.org/10.1038/s41467-021-22539-9

arXiv: 2011.01938

[26] Yunchao Liu, Srinivasan Arunachalam und Kristan Temme. „Eine rigorose und robuste Quantenbeschleunigung beim überwachten maschinellen Lernen“. Naturphysik 17, 1013–1017 (2021). arXiv:2010.02174.

https: / / doi.org/ 10.1038 / s41567-021-01287-z

arXiv: 2010.02174

[27] Bernhard Schölkopf, Alexander J. Smola, Francis Bach, et al. "Lernen mit Kerneln: Support-Vektor-Maschinen, Regularisierung, Optimierung und mehr". MIT-Presse. (2002).

https: / / doi.org/ 10.7551 / mitpress / 4175.001.0001

[28] Vladimir N Vapnik und A Ya Chervonenkis. „Über die gleichmäßige Konvergenz relativer Häufigkeiten von Ereignissen zu ihren Wahrscheinlichkeiten“. In Maße der Komplexität. Springer (2015).

https://doi.org/10.1007/978-3-319-21852-6_3

[29] Michael J. Kearns und Robert E. Schapire. „Effizientes verteilungsfreies Lernen probabilistischer Konzepte“. Zeitschrift für Computer- und Systemwissenschaften 48 (1994).

https://doi.org/10.1016/S0022-0000(05)80062-5

[30] Michael M. Wolf. „Mathematische Grundlagen des überwachten Lernens“. https://www-m5.ma.tum.de/foswiki/pub/M5/Allgemeines/MA4801_2020S/ML_notes_main.pdf (2020).

https: // www-m5.ma.tum.de/foswiki/pub/M5/ Allgemeines / MA4801_2020S / ML_notes_main.pdf

[31] Dyon van Vreumingen. „Quantum Feature Space Learning: Charakterisierung und mögliche Vorteile“. Masterarbeit. Universität Leiden. (2020).

[32] Jae-Eun Park, Brian Quanz, Steve Wood, Heather Higgins und Ray Harishankar. „Verbesserung der praktischen Anwendung auf Quanten-SVM: Theorie zur Praxis“ (2020). arXiv:2012.07725.

arXiv: 2012.07725

[33] John Shawe-Taylor, Peter L. Bartlett, Robert C. Williamson und Martin Anthony. „Strukturelle Risikominimierung über datenabhängige Hierarchien“. IEEE-Transaktionen zur Informationstheorie (1998).

https: / / doi.org/ 10.1109 / 18.705570

[34] Martin Anthony und Peter L Bartlett. „Funktionslernen durch Interpolation“. Kombinatorik, Wahrscheinlichkeit und Computing 9 (2000).

https: / / doi.org/ 10.1017 / S0963548300004247

[35] Peter L. Bartlett und Philip M. Long. "Vorhersage, Lernen, einheitliche Konvergenz und maßstabsabhängige Dimensionen". Zeitschrift für Computer- und Systemwissenschaften 56 (1998).

https: / / doi.org/ 10.1006 / jcss.1997.1557

[36] Scott Aaronson. „Die Lernbarkeit von Quantenzuständen“. Proceedings of the Royal Society A: Mathematical, Physical and Engineering Sciences 463 (2007). arXiv:quant-ph/0608142.

https: / / doi.org/ 10.1098 / rspa.2007.0113

arXiv: quant-ph / 0608142

Zitiert von

[1] Matthias C. Caro, Hsin-Yuan Huang, M. Cerezo, Kunal Sharma, Andrew Sornborger, Lukasz Cincio und Patrick J. Coles, „Verallgemeinerung des Quantenmaschinenlernens aus wenigen Trainingsdaten“, Naturkommunikation 13, 4919 (2022).

[2] Matthias C. Caro, Hsin-Yuan Huang, Nicholas Ezzell, Joe Gibbs, Andrew T. Sornborger, Lukasz Cincio, Patrick J. Coles und Zoë Holmes, „Out-of-distribution generalization for learning quanten dynamics“, arXiv: 2204.10268.

[3] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu, Shan You und Dacheng Tao, „Erlernbarkeit von Quantenneuronalen Netzen“, PRX-Quantum 2 4, 040337 (2021).

[4] Joe Gibbs, Zoë Holmes, Matthias C. Caro, Nicholas Ezzell, Hsin-Yuan Huang, Lukasz Cincio, Andrew T. Sornborger und Patrick J. Coles, „Dynamische Simulation durch Quantenmaschinenlernen mit nachweisbarer Verallgemeinerung“, arXiv: 2204.10269.

[5] Sofiene Jerbi, Lukas J. Fiderer, Hendrik Poulsen Nautrup, Jonas M. Kübler, Hans J. Briegel und Vedran Dunjko, „Quantum Machine Learning Beyond Kernel Methods“, arXiv: 2110.13162.

[6] Matthias C. Caro, Elies Gil-Fuster, Johannes Jakob Meyer, Jens Eisert und Ryan Sweke, „Codierungsabhängige Verallgemeinerungsgrenzen für parametrisierte Quantenschaltkreise“, arXiv: 2106.03880.

[7] Supanut Thanasilp, Samson Wang, M. Cerezo und Zoë Holmes, „Exponentielle Konzentration und Untrainierbarkeit bei Quantenkernmethoden“, arXiv: 2208.11060.

[8] Masahiro Kobayashi, Kohei Nakaji und Naoki Yamamoto, „Überanpassung beim Quantenmaschinenlernen und Verschränkung von Dropout“, arXiv: 2205.11446.

[9] Brian Coyle, „Maschinelle Lernanwendungen für verrauschte Quantencomputer mittlerer Größe“, arXiv: 2205.09414.

[10] Evan Peters und Maria Schuld, „Verallgemeinerung trotz Überanpassung in Quantenmaschinenlernmodellen“, arXiv: 2209.05523.

[11] Marco Fanizza, Yihui Quek und Matteo Rosati, „Quantenprozesse lernen ohne Eingabekontrolle“, arXiv: 2211.05005.

[12] Dylan Herman, Rudy Raymond, Muyuan Li, Nicolas Robles, Antonio Mezzacapo und Marco Pistoia, „Expressivity of Variational Quantum Machine Learning on the Boolean Cube“, arXiv: 2204.05286.

[13] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu, Shan You und Dacheng Tao, „Erratum: Learnability of Quantum Neural Networks [PRX QUANTUM 2, 040337 (2021)]“, PRX-Quantum 3 3, 030901 (2022).

[14] Chih-Chieh Chen, Masaru Sogabe, Kodai Shiba, Katsuyoshi Sakamoto und Tomah Sogabe, „General Vapnik-Chervonenkis Dimensionsgrenzen für das Lernen von Quantenschaltungen“, Zeitschrift für Physik: Komplexität 3 4, 045007 (2022).

[15] Yuxuan Du, Yibo Yang, Dacheng Tao und Min-Hsiu Hsieh, „Demystify Problem-Dependent Power of Quantum Neural Networks on Multi-Class Classification“, arXiv: 2301.01597.

Die obigen Zitate stammen von SAO / NASA ADS (Zuletzt erfolgreich aktualisiert am 2023, 01:15:10 Uhr). Die Liste ist möglicherweise unvollständig, da nicht alle Verlage geeignete und vollständige Zitationsdaten bereitstellen.

On Der von Crossref zitierte Dienst Es wurden keine Daten zum Zitieren von Werken gefunden (letzter Versuch 2023-01-15 10:53:12).

Dieses Papier ist in Quantum unter dem veröffentlicht Creative Commons Namensnennung 4.0 International (CC BY 4.0) Lizenz. Das Copyright verbleibt bei den ursprünglichen Copyright-Inhabern wie den Autoren oder deren Institutionen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. Hier zugreifen.

- Quelle: https://quantum-journal.org/papers/q-2023-01-13-893/

- 1

- 10

- 11

- 1994

- 1998

- 2011

- 2012

- 2014

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 28

- 7

- 9

- a

- Abbas

- Fähigkeit

- oben

- ABSTRACT

- Zugang

- Genauigkeit

- Vorteil

- Vorteilen

- Zugehörigkeiten

- Udo

- Algorithmus

- Algorithmen

- Alle

- amsterdam

- und

- Heinrich

- Anwendung

- Anwendungen

- Autor

- Autoren

- Balance

- basierend

- Christoph

- zwischen

- Beyond

- Blockieren

- Break

- Norbert

- Rand

- CA

- namens

- Kandidaten

- Erfassung

- casper

- chen

- Einstufung

- eng

- Zusammenbruch

- Kommentar

- Unterhaus

- Kommunikation

- Pendeln

- abschließen

- Komplexität

- Berechnung

- Berechnungen

- Computer

- Computer

- Computing

- Konzentration

- Konzepte

- konstante

- Smartgeräte App

- Konvergenz

- Urheberrecht

- Cross

- CWI

- technische Daten

- Dave

- Christian

- Tiefe

- Trotz

- Diego

- Abmessungen

- Größe

- diskutieren

- Dokument

- Dynamik

- Ludwig

- Entwicklung

- Era

- Erika

- Veranstaltungen

- Beispiele

- exponentiell

- Merkmal

- wenige

- gefunden

- Foundations

- für

- FS

- Games

- Allgemeines

- ABSICHT

- gewähren

- Grün

- Harvard

- Hierarchie

- Besondere

- Inhaber

- Ultraschall

- Hilfe

- aber

- HTTPS

- Hybrid

- hybrider Quantenklassiker

- Ideen

- IEEE

- Image

- Bilder

- wichtig

- Verbesserung

- in

- Information

- Varianten des Eingangssignals:

- inspirierte

- Institutionen

- Intelligenz

- interessant

- International

- eingeführt

- Januar

- JavaScript

- JOE

- Peter

- Johnson

- Zeitschrift

- Nachname

- lernen

- Verlassen

- Li

- Lizenz

- Liste

- Lang

- Maschine

- Maschinelles Lernen

- Maschinen

- Magnete

- Marco

- Rainer

- Martin

- Master

- mathematisch

- max-width

- messen

- Maßnahmen

- Methoden

- Meyer

- Michael

- Minimierung

- MIT

- Modell

- für

- Molekular-

- Monat

- mehr

- Natur

- Netzwerk

- Netzwerke

- Neuronale Netze

- Neu

- Nicolas

- Lärm

- XNUMXh geöffnet

- Optimierung

- Optionen

- Original

- Papier

- Parameter

- Park

- Schnittmuster

- Leistung

- Jürgen

- physikalisch

- Physik

- Plato

- Datenintelligenz von Plato

- PlatoData

- möglich

- Werkzeuge

- Praktisch

- Praxis

- Presse

- Verfahren

- Prozessdefinierung

- anpassen

- Prozessor

- prominent

- Belegen

- die

- veröffentlicht

- Herausgeber

- Verlag

- Quant

- Quantenvorteil

- Quantenalgorithmen

- Quantencomputer

- Quantencomputing

- Quanteninformation

- Quantenmaschinelles Lernen

- ROMME

- RAY

- Referenzen

- Beziehungen

- bleibt bestehen

- Downloads

- Die Ergebnisse

- Überprüfen

- Bewertungen

- Daniel

- rigoros

- Rise

- Risiko

- ROBERT

- robust

- Rosati

- königlich

- Lutz

- Sam

- Wissenschaft

- Wissenschaft und Technologie

- WISSENSCHAFTEN

- Scott Aaronson

- Sets

- Sharma

- Shiba

- Bernd

- Simulation

- Größe

- klein

- Gesellschaft

- Quelle

- Raumfahrt

- Räume

- Staaten

- statistisch

- Steve

- Immer noch

- strukturell

- Studie

- Stil

- Erfolgreich

- so

- geeignet

- ZUSAMMENFASSUNG

- supraleitend

- Support

- System

- Technologie

- Das

- ihr

- deswegen

- Titel

- zu

- Ausbildung

- Transaktionen

- für

- Verständnis

- verstanden

- Universität

- aktualisiert

- URL

- Volumen

- W

- ohne

- Wolf

- Werk

- X

- Jahr

- Du

- Yuan

- Zephyrnet