Maschinelles Lernen (ML) hat das Geschäft in den letzten Jahren branchenübergreifend verbessert – vom Empfehlungssystem bis hin zu Ihrem Hauptvideo Account, zur Dokumentenverdichtung und zur effizienten Suche mit Alexadie Sprachunterstützung von . Es bleibt jedoch die Frage, wie Sie diese Technologie in Ihr Unternehmen integrieren können. Im Gegensatz zu herkömmlichen regelbasierten Methoden leitet ML automatisch Muster aus Daten ab, um Ihre gewünschte Aufgabe auszuführen. Dies umgeht zwar die Notwendigkeit, Regeln für die Automatisierung zu kuratieren, bedeutet aber auch, dass ML-Modelle nur so gut sein können wie die Daten, mit denen sie trainiert wurden. Die Datenerstellung ist jedoch oft eine herausfordernde Aufgabe. Bei der Amazon Machine Learning Solutions Lab, sind wir wiederholt auf dieses Problem gestoßen und möchten unseren Kunden diesen Weg erleichtern. Wenn Sie diesen Prozess auslagern möchten, können Sie verwenden Amazon SageMaker Ground Truth Plus.

Am Ende dieses Beitrags können Sie Folgendes erreichen:

- Verstehen Sie die Geschäftsprozesse, die mit der Einrichtung einer Datenerfassungspipeline verbunden sind

- Identifizieren Sie AWS Cloud-Services zur Unterstützung und Beschleunigung Ihrer Datenkennzeichnungspipeline

- Führen Sie eine Datenerfassungs- und Kennzeichnungsaufgabe für benutzerdefinierte Anwendungsfälle aus

- Erstellen Sie qualitativ hochwertige Daten nach geschäftlichen und technischen Best Practices

In diesem Beitrag konzentrieren wir uns auf den Datenerstellungsprozess und verlassen uns auf AWS-Services, um die Infrastruktur- und Prozesskomponenten zu handhaben. Wir verwenden nämlich Amazon Sagemaker Ground Truth um die Kennzeichnungsinfrastruktur-Pipeline und die Benutzeroberfläche zu handhaben. Dieser Dienst verwendet einen Point-and-Go-Ansatz, um Ihre Daten zu sammeln Amazon Simple Storage-Service (Amazon S3) und richten Sie einen Etikettierungs-Workflow ein. Für die Etikettierung bietet es Ihnen die integrierte Flexibilität, Datenetiketten mit Ihrem privaten Team zu erwerben, an Amazon Mechanischer Türke force, oder Ihren bevorzugten Etikettierungsanbieter von AWS-Marktplatz. Schließlich können Sie verwenden AWS Lambda und Amazon SageMaker-Notizbücher zur Verarbeitung, Visualisierung oder Qualitätskontrolle der Daten – entweder vor oder nach der Etikettierung.

Jetzt, da alle Teile niedergelegt sind, können wir mit dem Prozess beginnen!

Der Datenerstellungsprozess

Entgegen der landläufigen Meinung ist der erste Schritt zur Datenerstellung nicht die Datenerhebung. Es ist entscheidend, von den Benutzern rückwärts zu arbeiten, um das Problem zu artikulieren. Was interessiert die Benutzer beispielsweise am endgültigen Artefakt? Wo sehen Experten die für den Anwendungsfall relevanten Signale in den Daten? Welche Informationen über die Anwendungsfallumgebung könnten dem Modell zur Verfügung gestellt werden? Wenn Sie die Antworten auf diese Fragen nicht kennen, machen Sie sich keine Sorgen. Nehmen Sie sich etwas Zeit, um mit Benutzern und Feldexperten zu sprechen, um die Nuancen zu verstehen. Dieses anfängliche Verständnis wird Sie in die richtige Richtung lenken und Sie auf den Erfolg vorbereiten.

Für diesen Beitrag gehen wir davon aus, dass Sie diesen anfänglichen Prozess der Benutzeranforderungsspezifikation abgedeckt haben. Die nächsten drei Abschnitte führen Sie durch den anschließenden Prozess der Erstellung hochwertiger Daten: Planung, Quelldatenerstellung und Datenkommentierung. Pilotierungsschleifen bei der Datenerstellung und den Annotationsschritten sind unerlässlich, um die effiziente Erstellung von gekennzeichneten Daten sicherzustellen. Dies beinhaltet die Iteration zwischen Datenerstellung, Annotation, Qualitätssicherung und Aktualisierung der Pipeline nach Bedarf.

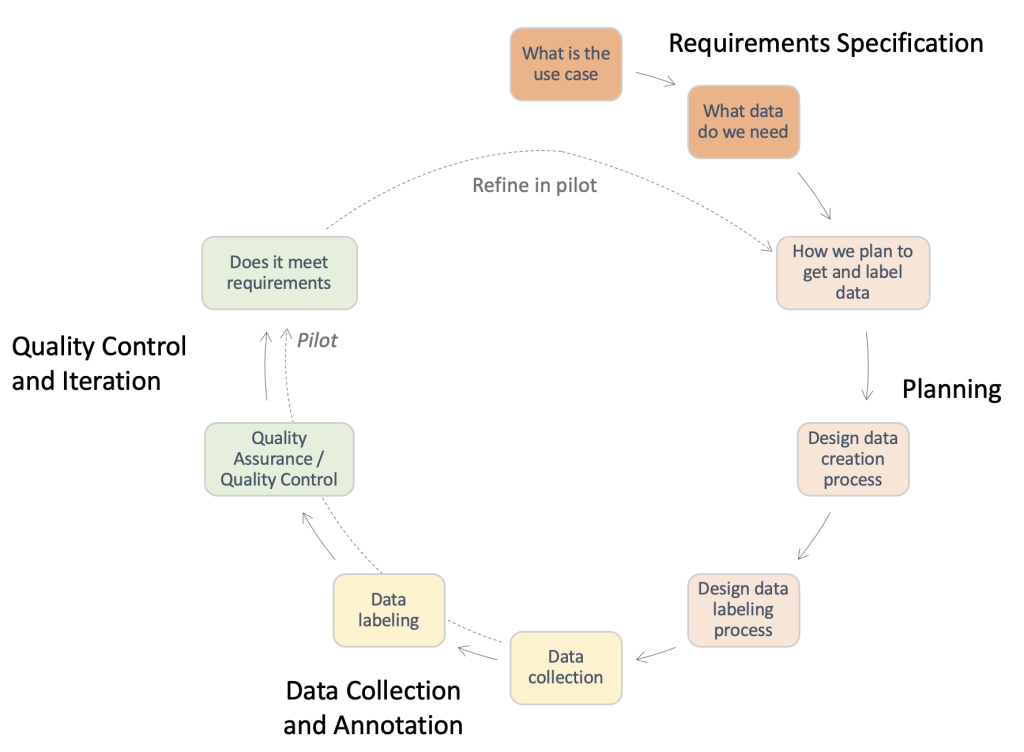

Die folgende Abbildung bietet einen Überblick über die Schritte, die in einer typischen Datenerstellungspipeline erforderlich sind. Sie können ausgehend vom Anwendungsfall rückwärts arbeiten, um die benötigten Daten zu identifizieren (Anforderungsspezifikation), einen Prozess zum Abrufen der Daten erstellen (Planung), den eigentlichen Datenerfassungsprozess implementieren (Datenerfassung und -anmerkung) und die Ergebnisse bewerten. Pilotläufe, die mit gestrichelten Linien hervorgehoben sind, ermöglichen es Ihnen, den Prozess zu iterieren, bis eine qualitativ hochwertige Datenerfassungspipeline entwickelt wurde.

Überblick über die Schritte, die in einer typischen Datenerstellungspipeline erforderlich sind.

Planung

Ein standardmäßiger Datenerstellungsprozess kann zeitaufwändig sein und wertvolle Personalressourcen verschwenden, wenn er ineffizient durchgeführt wird. Warum sollte es zeitaufwändig sein? Um diese Frage zu beantworten, müssen wir den Umfang des Datenerstellungsprozesses verstehen. Um Ihnen zu helfen, haben wir eine Checkliste auf hoher Ebene und eine Beschreibung der wichtigsten Komponenten und Interessengruppen zusammengestellt, die Sie berücksichtigen müssen. Die Beantwortung dieser Fragen kann zunächst schwierig sein. Abhängig von Ihrem Anwendungsfall sind möglicherweise nur einige davon anwendbar.

- Benennen Sie den rechtlichen Ansprechpartner für erforderliche Genehmigungen – Die Verwendung von Daten für Ihre Anwendung kann eine Überprüfung der Lizenz oder des Lieferantenvertrags erfordern, um die Einhaltung der Unternehmensrichtlinien und Anwendungsfälle sicherzustellen. Es ist wichtig, Ihre rechtliche Unterstützung während der Datenerfassung und der Anmerkungsschritte des Prozesses zu identifizieren.

- Identifizieren Sie den Sicherheitskontaktpunkt für die Datenverarbeitung –Der Verlust gekaufter Daten kann zu ernsthaften Bußgeldern und Konsequenzen für Ihr Unternehmen führen. Es ist wichtig, Ihre Sicherheitsunterstützung während der Datenerfassung und der Anmerkungsschritte zu identifizieren, um sichere Praktiken zu gewährleisten.

- Detaillierte Anwendungsfallanforderungen und Definition von Richtlinien für Quelldaten und Anmerkungen – Das Erstellen und Annotieren von Daten ist aufgrund der erforderlichen hohen Spezifität schwierig. Stakeholder, einschließlich Datengeneratoren und Kommentatoren, müssen vollständig aufeinander abgestimmt sein, um eine Verschwendung von Ressourcen zu vermeiden. Zu diesem Zweck ist es üblich, ein Richtliniendokument zu verwenden, das jeden Aspekt der Annotationsaufgabe spezifiziert: genaue Anweisungen, Grenzfälle, eine beispielhafte Vorgehensweise und so weiter.

- Richten Sie sich an den Erwartungen für das Sammeln Ihrer Quelldaten aus - Folgendes berücksichtigen:

- Führen Sie Recherchen zu potenziellen Datenquellen durch – Zum Beispiel öffentliche Datensätze, vorhandene Datensätze anderer interner Teams, selbst gesammelte oder von Anbietern gekaufte Daten.

- Qualitätsbewertung durchführen – Erstellen Sie eine Analyse-Pipeline in Bezug auf den endgültigen Anwendungsfall.

- Richten Sie sich an den Erwartungen zum Erstellen von Datenanmerkungen aus - Folgendes berücksichtigen:

- Identifizieren Sie die technischen Beteiligten – Dies ist normalerweise eine Person oder ein Team in Ihrem Unternehmen, das in der Lage ist, die technische Dokumentation zu Ground Truth zu verwenden, um eine Annotationspipeline zu implementieren. Diese Stakeholder sind auch für die Qualitätsbewertung der annotierten Daten verantwortlich, um sicherzustellen, dass sie den Anforderungen Ihrer nachgelagerten ML-Anwendung entsprechen.

- Identifizieren Sie die Datenannotatoren – Diese Personen verwenden vorgegebene Anweisungen, um Ihre Quelldaten innerhalb von Ground Truth mit Labels zu versehen. Je nach Anwendungsfall und Anmerkungsrichtlinien müssen sie möglicherweise über Domänenkenntnisse verfügen. Sie können eine interne Arbeitskraft Ihres Unternehmens einsetzen oder für eine bezahlen Personal, das von einem externen Anbieter verwaltet wird.

- Stellen Sie die Überwachung des Datenerstellungsprozesses sicher – Wie Sie den vorangegangenen Punkten entnehmen können, ist die Datenerstellung ein detaillierter Prozess, an dem zahlreiche spezialisierte Stakeholder beteiligt sind. Daher ist es von entscheidender Bedeutung, es Ende-zu-Ende im Hinblick auf das gewünschte Ergebnis zu überwachen. Die Überwachung des Prozesses durch eine dedizierte Person oder ein Team kann Ihnen helfen, einen kohärenten, effizienten Datenerstellungsprozess sicherzustellen.

Je nach Route, für die Sie sich entscheiden, müssen Sie außerdem Folgendes beachten:

- Erstellen Sie das Quell-Dataset – Dies bezieht sich auf Fälle, in denen vorhandene Daten für die jeweilige Aufgabe nicht geeignet sind oder rechtliche Einschränkungen Sie daran hindern, sie zu verwenden. Es müssen interne Teams oder externe Anbieter (nächster Punkt) eingesetzt werden. Dies ist häufig bei hoch spezialisierten Domänen oder Bereichen mit geringer öffentlicher Forschung der Fall. Zum Beispiel allgemeine Fragen eines Arztes, Kleidungsstücke oder Sportexperten. Es kann intern oder extern sein.

- Recherchieren Sie Anbieter und führen Sie einen Onboarding-Prozess durch – Wenn externe Anbieter verwendet werden, muss ein Vertragsabschluss- und Onboarding-Prozess zwischen beiden Einheiten eingerichtet werden.

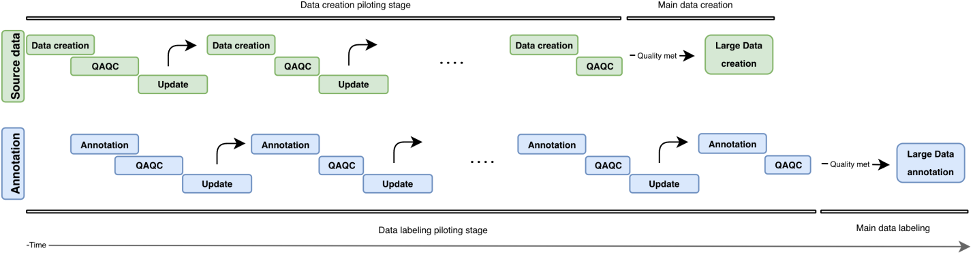

In diesem Abschnitt haben wir die Komponenten und Stakeholder überprüft, die wir berücksichtigen müssen. Doch wie sieht der eigentliche Ablauf aus? In der folgenden Abbildung skizzieren wir einen Prozessablauf für die Datenerstellung und -annotation. Der iterative Ansatz verwendet kleine Datenstapel, sogenannte Piloten, um die Bearbeitungszeit zu verkürzen, Fehler frühzeitig zu erkennen und die Verschwendung von Ressourcen bei der Erstellung von Daten von geringer Qualität zu vermeiden. Wir beschreiben diese Pilotrunden später in diesem Beitrag. Wir behandeln auch einige Best Practices für die Datenerstellung, Annotation und Qualitätskontrolle.

Die folgende Abbildung veranschaulicht die iterative Entwicklung einer Datenerstellungspipeline. Vertikal finden wir den Datenbeschaffungsblock (grün) und den Annotationsblock (blau). Beide Blöcke haben unabhängige Pilotrunden (Datenerstellung/Anmerkung, QAQC und Aktualisierung). Es werden zunehmend Daten aus höheren Quellen erstellt und können verwendet werden, um immer qualitativ hochwertigere Anmerkungen zu erstellen.

Überblick über die iterative Entwicklung in einer Datenerstellungspipeline.

Erstellung von Quelldaten

Der Eingabeerstellungsprozess dreht sich um die Bereitstellung Ihrer interessanten Elemente, die von Ihrem Aufgabentyp abhängen. Dies können Bilder (Zeitungsscans), Videos (Verkehrsszenen), 3D-Punktwolken (medizinische Scans) oder einfach Text (Untertitelspuren, Transkriptionen) sein. Stellen Sie beim Bereitstellen Ihrer aufgabenbezogenen Elemente im Allgemeinen Folgendes sicher:

- Reflektieren Sie den realen Anwendungsfall für das eventuelle KI/ML-System – Das Setup zum Sammeln von Bildern oder Videos für Ihre Trainingsdaten sollte dem Setup für Ihre Eingabedaten in der realen Anwendung genau entsprechen. Dies bedeutet, konsistente Platzierungsoberflächen, Lichtquellen oder Kamerawinkel zu haben.

- Berücksichtigung und Minimierung von Variabilitätsquellen - Folgendes berücksichtigen:

- Entwickeln Sie Best Practices für die Aufrechterhaltung von Datenerfassungsstandards – Abhängig von der Granularität Ihres Anwendungsfalls müssen Sie möglicherweise Anforderungen spezifizieren, um die Konsistenz zwischen Ihren Datenpunkten zu gewährleisten. Wenn Sie beispielsweise Bild- oder Videodaten von einzelnen Kamerapunkten erfassen, müssen Sie möglicherweise die konsistente Platzierung Ihrer Objekte von Interesse sicherstellen oder eine Qualitätsprüfung der Kamera vor einer Datenerfassungsrunde verlangen. Dies kann Probleme wie Kameraneigung oder Unschärfe vermeiden und nachgelagerte Overheads wie das Entfernen von Out-of-Frame- oder verschwommenen Bildern sowie die Notwendigkeit, den Bildrahmen manuell auf Ihren Interessenbereich zu zentrieren, minimieren.

- Vermeiden Sie Schwankungsquellen in der Testzeit – Wenn Sie während der Testzeit eine Variabilität in einem der bisher erwähnten Attribute erwarten, stellen Sie sicher, dass Sie diese Variabilitätsquellen während der Trainingsdatenerstellung erfassen können. Wenn Sie beispielsweise davon ausgehen, dass Ihre ML-Anwendung in mehreren verschiedenen Lichteinstellungen funktioniert, sollten Sie darauf abzielen, Trainingsbilder und -videos mit verschiedenen Lichteinstellungen zu erstellen. Je nach Anwendungsfall kann auch die Variabilität der Kamerapositionierung die Qualität Ihrer Etiketten beeinflussen.

- Integrieren Sie gegebenenfalls vorhandenes Domänenwissen - Folgendes berücksichtigen:

- Eingaben zu Fehlerquellen – Domänenpraktiker können aufgrund ihrer langjährigen Erfahrung Einblicke in Fehlerquellen geben. Sie können Feedback zu den Best Practices für die beiden vorherigen Punkte geben: Welche Einstellungen spiegeln den realen Anwendungsfall am besten wider? Was sind die möglichen Quellen für Schwankungen während der Datenerhebung oder zum Zeitpunkt der Verwendung?

- Best Practices für die domänenspezifische Datenerfassung – Auch wenn Ihre technischen Interessengruppen möglicherweise bereits eine gute Vorstellung von den technischen Aspekten haben, auf die sie sich in den gesammelten Bildern oder Videos konzentrieren sollten, können Fachexperten Feedback dazu geben, wie die Daten am besten bereitgestellt oder gesammelt werden können, damit diese Anforderungen erfüllt werden.

Qualitätskontrolle und Qualitätssicherung der erstellten Daten

Nachdem Sie nun die Datensammlungspipeline eingerichtet haben, könnte es verlockend sein, so viele Daten wie möglich zu sammeln. Warten Sie eine Minute! Wir müssen zunächst prüfen, ob die durch das Setup gesammelten Daten für Ihren realen Anwendungsfall geeignet sind. Wir können einige erste Muster verwenden und das Setup durch die Erkenntnisse, die wir aus der Analyse dieser Musterdaten gewonnen haben, iterativ verbessern. Arbeiten Sie während des Pilotprozesses eng mit Ihren technischen, geschäftlichen und Anmerkungs-Stakeholdern zusammen. Dadurch wird sichergestellt, dass Ihre resultierende Pipeline die Geschäftsanforderungen erfüllt und gleichzeitig ML-fähige gekennzeichnete Daten mit minimalem Overhead generiert.

Anmerkungen

Die Annotation von Eingaben ist der Punkt, an dem wir unseren Daten den magischen Touch verleihen – die Labels! Abhängig von Ihrem Aufgabentyp und Datenerstellungsprozess benötigen Sie möglicherweise manuelle Annotatoren oder Sie können standardmäßige automatisierte Methoden verwenden. Die Datenannotationspipeline selbst kann eine technisch anspruchsvolle Aufgabe sein. Ground Truth erleichtert diesen Weg für Ihre technischen Stakeholder mit seinen integriertes Repertoire an Etikettierungs-Workflows für gängige Datenquellen. Mit ein paar zusätzlichen Schritten können Sie damit auch bauen benutzerdefinierte Kennzeichnungsworkflows über vorkonfigurierte Optionen hinaus.

Stellen Sie sich bei der Entwicklung eines geeigneten Annotations-Workflows folgende Fragen:

- Benötige ich einen manuellen Annotationsprozess für meine Daten? In einigen Fällen können automatisierte Etikettierungsdienste für die anstehende Aufgabe ausreichen. Die Überprüfung der Dokumentation und der verfügbaren Tools kann Ihnen dabei helfen, festzustellen, ob für Ihren Anwendungsfall eine manuelle Anmerkung erforderlich ist (weitere Informationen finden Sie unter Was ist Datenkennzeichnung?). Der Datenerstellungsprozess kann unterschiedliche Kontrollebenen hinsichtlich der Granularität Ihrer Datenanmerkung ermöglichen. Abhängig von diesem Prozess können Sie manchmal auch die Notwendigkeit einer manuellen Annotation umgehen. Weitere Informationen finden Sie unter Erstellen Sie mit Amazon SageMaker Ground Truth einen benutzerdefinierten Q&A-Datensatz, um ein Hugging Face Q&A NLU-Modell zu trainieren.

- Was bildet meine Grundwahrheit? In den meisten Fällen wird die Grundwahrheit aus Ihrem Annotationsprozess stammen – das ist der springende Punkt! In anderen kann der Benutzer Zugriff auf Ground-Truth-Labels haben. Dies kann Ihren Qualitätssicherungsprozess erheblich beschleunigen oder den für mehrere manuelle Anmerkungen erforderlichen Aufwand reduzieren.

- Was ist die Obergrenze für die Abweichung von meinem Grundwahrheitszustand? Arbeiten Sie mit Ihren Endbenutzern zusammen, um die typischen Fehler im Zusammenhang mit diesen Etiketten, die Quellen solcher Fehler und die gewünschte Fehlerreduzierung zu verstehen. Auf diese Weise können Sie erkennen, welche Aspekte der Beschriftungsaufgabe am schwierigsten sind oder wahrscheinlich Anmerkungsfehler aufweisen.

- Gibt es bereits bestehende Regeln, die von den Benutzern oder Praktikern verwendet werden, um diese Artikel zu kennzeichnen? Verwenden und verfeinern Sie diese Richtlinien, um eine Reihe von Anweisungen für Ihre manuellen Kommentatoren zu erstellen.

Pilotieren des Eingangsanmerkungsprozesses

Berücksichtigen Sie beim Pilotieren des Eingabeannotationsprozesses Folgendes:

- Gehen Sie die Anweisungen mit den Kommentatoren und Praktikern durch – Anweisungen sollten prägnant und spezifisch sein. Bitten Sie Ihre Benutzer um Feedback (Sind die Anweisungen korrekt? Können wir Anweisungen überarbeiten, um sicherzustellen, dass sie für Nichtfachleute verständlich sind?) und Kommentatoren (Ist alles verständlich? Ist die Aufgabe klar?). Fügen Sie nach Möglichkeit ein Beispiel für gut und schlecht gekennzeichnete Daten hinzu, damit Ihre Kommentatoren erkennen können, was erwartet wird und wie häufige Kennzeichnungsfehler aussehen könnten.

- Sammeln Sie Daten für Anmerkungen – Überprüfen Sie die Daten mit Ihrem Kunden, um sicherzustellen, dass sie den erwarteten Standards entsprechen, und um sich an den erwarteten Ergebnissen der manuellen Annotation auszurichten.

- Stellen Sie Ihrem Pool manueller Annotatoren Beispiele als Testlauf zur Verfügung – Was ist die typische Varianz zwischen den Annotatoren in dieser Reihe von Beispielen? Untersuchen Sie die Varianz für jede Anmerkung innerhalb eines bestimmten Bildes, um die Konsistenztrends zwischen Annotatoren zu identifizieren. Vergleichen Sie dann die Abweichungen zwischen den Bildern oder Videobildern, um zu ermitteln, welche Beschriftungen schwierig zu platzieren sind.

Qualitätskontrolle der Anmerkungen

Die Qualitätskontrolle von Anmerkungen besteht aus zwei Hauptkomponenten: der Bewertung der Konsistenz zwischen den Kommentatoren und der Bewertung der Qualität der Anmerkungen selbst.

Sie können dieselbe Aufgabe mehreren Kommentatoren zuweisen (z. B. beschriften drei Kommentatoren die Schlüsselpunkte auf demselben Bild) und den Durchschnittswert zusammen mit der Standardabweichung dieser Beschriftungen unter den Kommentatoren messen. Auf diese Weise können Sie Ausreißer-Anmerkungen identifizieren (falsche Bezeichnung verwendet oder Bezeichnung weit entfernt von der durchschnittlichen Anmerkung), die umsetzbare Ergebnisse anleiten können, z. B. die Verfeinerung Ihrer Anweisungen oder die Bereitstellung weiterer Schulungen für bestimmte Annotatoren.

Die Bewertung der Qualität von Annotationen selbst ist an die Variabilität der Annotatoren und (falls verfügbar) die Verfügbarkeit von Domänenexperten oder Ground-Truth-Informationen gebunden. Gibt es bestimmte Labels (über alle Ihre Bilder hinweg), bei denen die durchschnittliche Varianz zwischen Annotatoren konstant hoch ist? Sind irgendwelche Etiketten weit von Ihren Erwartungen entfernt, wo sie sein sollten oder wie sie aussehen sollten?

Basierend auf unserer Erfahrung kann ein typischer Qualitätsregelkreis für die Datenannotation wie folgt aussehen:

- Wiederholen Sie die Anweisungen oder das Image-Staging basierend auf den Ergebnissen des Testlaufs – Werden Objekte verdeckt oder entspricht die Bildinszenierung nicht den Erwartungen von Kommentatoren oder Benutzern? Sind die Anweisungen irreführend oder haben Sie Beschriftungen oder häufige Fehler in Ihren Beispielbildern übersehen? Können Sie die Anweisungen für Ihre Kommentatoren präzisieren?

- Wenn Sie zufrieden sind, dass Sie alle Probleme aus dem Testlauf behoben haben, machen Sie eine Reihe von Anmerkungen – Um die Ergebnisse aus dem Stapel zu testen, folgen Sie dem gleichen Qualitätsbewertungsansatz zur Bewertung der Variabilität von Beschriftungen zwischen Annotatoren und Bildern.

Zusammenfassung

Dieser Beitrag dient als Leitfaden für Geschäftsbeteiligte, um die Komplexität der Datenerstellung für KI/ML-Anwendungen zu verstehen. Die beschriebenen Prozesse dienen auch als Leitfaden für technische Praktiker, um Qualitätsdaten zu generieren und gleichzeitig geschäftliche Einschränkungen wie Personal und Kosten zu optimieren. Wenn es nicht gut gemacht wird, kann eine Datenerstellungs- und Kennzeichnungspipeline bis zu 4–6 Monate dauern.

Mit den in diesem Beitrag beschriebenen Richtlinien und Vorschlägen können Sie Hindernissen vorbeugen, die Zeit bis zur Fertigstellung verkürzen und die Kosten auf Ihrem Weg zur Erstellung hochwertiger Daten minimieren.

Über die Autoren

Jasleen Grewal ist Applied Scientist bei Amazon Web Services, wo sie mit AWS-Kunden zusammenarbeitet, um reale Probleme mithilfe von maschinellem Lernen zu lösen, mit besonderem Schwerpunkt auf Präzisionsmedizin und Genomik. Sie hat einen starken Hintergrund in Bioinformatik, Onkologie und klinischer Genomik. Sie setzt sich leidenschaftlich für den Einsatz von KI/ML und Cloud-Diensten ein, um die Patientenversorgung zu verbessern.

Jasleen Grewal ist Applied Scientist bei Amazon Web Services, wo sie mit AWS-Kunden zusammenarbeitet, um reale Probleme mithilfe von maschinellem Lernen zu lösen, mit besonderem Schwerpunkt auf Präzisionsmedizin und Genomik. Sie hat einen starken Hintergrund in Bioinformatik, Onkologie und klinischer Genomik. Sie setzt sich leidenschaftlich für den Einsatz von KI/ML und Cloud-Diensten ein, um die Patientenversorgung zu verbessern.

Boris Arontschik ist Manager im Amazon AI Machine Learning Solutions Lab, wo er ein Team von ML-Wissenschaftlern und -Ingenieuren leitet, um AWS-Kunden dabei zu helfen, Geschäftsziele zu erreichen, indem sie KI/ML-Lösungen nutzen.

Boris Arontschik ist Manager im Amazon AI Machine Learning Solutions Lab, wo er ein Team von ML-Wissenschaftlern und -Ingenieuren leitet, um AWS-Kunden dabei zu helfen, Geschäftsziele zu erreichen, indem sie KI/ML-Lösungen nutzen.

Miguel Romero Calvo ist Angewandte Wissenschaftlerin an der Amazon ML-Lösungslabor wo er mit internen AWS-Teams und strategischen Kunden zusammenarbeitet, um ihr Geschäft durch ML- und Cloud-Einführung zu beschleunigen.

Miguel Romero Calvo ist Angewandte Wissenschaftlerin an der Amazon ML-Lösungslabor wo er mit internen AWS-Teams und strategischen Kunden zusammenarbeitet, um ihr Geschäft durch ML- und Cloud-Einführung zu beschleunigen.

Lin Lee Cheong ist Senior Scientist und Manager im Amazon ML Solutions Lab-Team bei Amazon Web Services. Sie arbeitet mit strategischen AWS-Kunden zusammen, um künstliche Intelligenz und maschinelles Lernen zu erforschen und anzuwenden, um neue Erkenntnisse zu gewinnen und komplexe Probleme zu lösen.

Lin Lee Cheong ist Senior Scientist und Manager im Amazon ML Solutions Lab-Team bei Amazon Web Services. Sie arbeitet mit strategischen AWS-Kunden zusammen, um künstliche Intelligenz und maschinelles Lernen zu erforschen und anzuwenden, um neue Erkenntnisse zu gewinnen und komplexe Probleme zu lösen.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon ML-Lösungslabor

- Amazon Sage Maker

- Amazon Sagemaker Ground Truth

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Professionelle AWS-Services

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet