In diesem Beitrag zeigen wir, wie Sie Schäden durch Naturkatastrophen trainieren, bereitstellen und vorhersagen können Amazon SageMaker mit raumbezogenen Funktionen. Wir verwenden die neuen Geodatenfunktionen von SageMaker, um neue Inferenzdaten zum Testen des Modells zu generieren. Viele staatliche und humanitäre Organisationen benötigen im Katastrophenfall ein schnelles und genaues Situationsbewusstsein. Die Kenntnis von Schweregrad, Ursache und Ort des Schadens kann bei der Reaktionsstrategie und Entscheidungsfindung des Ersthelfers hilfreich sein. Der Mangel an genauen und zeitnahen Informationen kann zu unvollständigen oder fehlgeleiteten Hilfsmaßnahmen beitragen.

Da die Häufigkeit und Schwere von Naturkatastrophen zunimmt, ist es wichtig, dass wir Entscheidungsträger und Ersthelfer mit einer schnellen und genauen Schadensbewertung ausstatten. In diesem Beispiel verwenden wir Geodaten, um Schäden durch Naturkatastrophen vorherzusagen. Geodaten können unmittelbar nach einer Naturkatastrophe zur schnellen Identifizierung von Schäden an Gebäuden, Straßen oder anderen kritischen Infrastrukturen verwendet werden. In diesem Beitrag zeigen wir Ihnen, wie Sie ein georäumliches Segmentierungsmodell trainieren und bereitstellen, das für die Klassifizierung von Katastrophenschäden verwendet werden kann. Wir unterteilen die Anwendung in drei Themen: Modelltraining, Modellbereitstellung und Inferenz.

Modelltraining

In diesem Anwendungsfall haben wir ein benutzerdefiniertes PyTorch-Modell mit erstellt Amazon Sage Maker zur Bildsegmentierung von Gebäudeschäden. Die raumbezogenen Funktionen in SageMaker umfassen trainierte Modelle, die Sie verwenden können. Diese integrierten Modelle umfassen Wolkensegmentierung und -entfernung sowie Landbedeckungssegmentierung. Für diesen Beitrag trainieren wir ein benutzerdefiniertes Modell zur Schadenssegmentierung. Wir haben das SegFormer-Modell zunächst mit Daten aus dem xView2-Wettbewerb trainiert. Der SegFormer ist eine transformatorbasierte Architektur, die im Papier von 2021 vorgestellt wurde SegFormer: Einfaches und effizientes Design für semantische Segmentierung mit Transformern. Es basiert auf den Transformer-Architekturen, die bei Workloads zur Verarbeitung natürlicher Sprache sehr beliebt sind. Die SegFormer-Architektur ist jedoch für die semantische Segmentierung ausgelegt. Es kombiniert sowohl den transformatorbasierten Encoder als auch einen leichten Decoder. Dies ermöglicht eine bessere Leistung als frühere Methoden, während erheblich kleinere Modellgrößen als frühere Methoden bereitgestellt werden. Sowohl vortrainierte als auch untrainierte SegFormer-Modelle sind in der beliebten Hugging Face Transformer Library erhältlich. Für diesen Anwendungsfall laden wir eine vortrainierte SegFormer-Architektur herunter und trainieren sie mit einem neuen Datensatz.

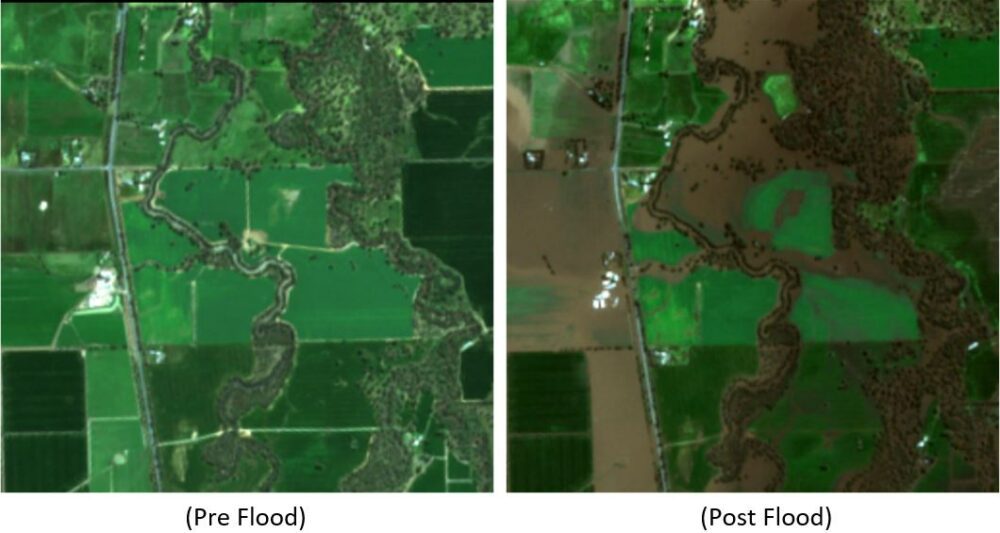

Der in diesem Beispiel verwendete Datensatz stammt aus der xView2 Data-Science-Wettbewerb. Dieser Wettbewerb veröffentlicht die xBD-Datensatz, einer der größten und hochwertigsten öffentlich verfügbaren Datensätze mit hochauflösenden Satellitenbildern, die mit Gebäudestandorten und Schadenswerten (Klassen) vor und nach Naturkatastrophen kommentiert sind. Der Datensatz enthält Daten aus 15 Ländern, darunter 6 Arten von Katastrophen (Erdbeben/Tsunami, Überschwemmung, Vulkanausbruch, Lauffeuer, Wind) mit Geodaten, die 850,736 Gebäudeanmerkungen auf 45,362 km² Bildmaterial enthalten. Das folgende Bild zeigt ein Beispiel des Datensatzes. Dieses Bild zeigt das Bild nach der Katastrophe mit der überlagerten Segmentierungsmaske für Gebäudeschäden. Jedes Bild enthält Folgendes: Satellitenbild vor der Katastrophe, Gebäudesegmentierungsmaske vor der Katastrophe, Satellitenbild nach der Katastrophe und Gebäudesegmentierungsmaske nach der Katastrophe mit Schadensklassen.

In diesem Beispiel verwenden wir nur die Bilder vor und nach der Katastrophe, um die Schadensklassifizierung nach der Katastrophe vorherzusagen (Segmentierungsmaske). Wir verwenden keine Gebäudesegmentierungsmasken aus der Zeit vor der Katastrophe. Dieser Ansatz wurde der Einfachheit halber gewählt. Es gibt andere Möglichkeiten, sich diesem Datensatz zu nähern. Eine Reihe der Siegeransätze für den xView2-Wettbewerb nutzten eine zweistufige Lösung: Erstens die Segmentierungsmaske für Gebäudeumrisse vor der Katastrophe vorhersagen. Die Gebäudeumrisse und die Nachschadensbilder werden dann als Input für die Vorhersage der Schadensklassifizierung verwendet. Wir überlassen dies dem Leser, andere Modellierungsansätze zu untersuchen, um die Klassifizierungs- und Erkennungsleistung zu verbessern.

Die vortrainierte SegFormer-Architektur ist so aufgebaut, dass sie ein einzelnes dreifarbiges Kanalbild als Eingabe akzeptiert und eine Segmentierungsmaske ausgibt. Es gibt eine Reihe von Möglichkeiten, wie wir das Modell hätten modifizieren können, um sowohl die Bilder vor als auch nach dem Satelliten als Eingabe zu akzeptieren, aber wir haben eine einfache Stapeltechnik verwendet, um beide Bilder zusammen zu einem Bild mit sechs Farbkanälen zu stapeln. Wir haben das Modell mit Standard-Augmentationstechniken auf dem xView2-Trainingsdatensatz trainiert, um die Segmentierungsmaske nach einer Katastrophe vorherzusagen. Beachten Sie, dass wir die Größe aller Eingabebilder von 1024 auf 512 Pixel geändert haben. Dies sollte die räumliche Auflösung der Trainingsdaten weiter reduzieren. Das Modell wurde mit SageMaker unter Verwendung einer einzelnen p3.2xlarge-GPU-basierten Instanz trainiert. Ein Beispiel für die Ausgabe des trainierten Modells ist in den folgenden Abbildungen dargestellt. Der erste Satz von Bildern sind die Vor- und Nachschadensbilder aus dem Validierungssatz.

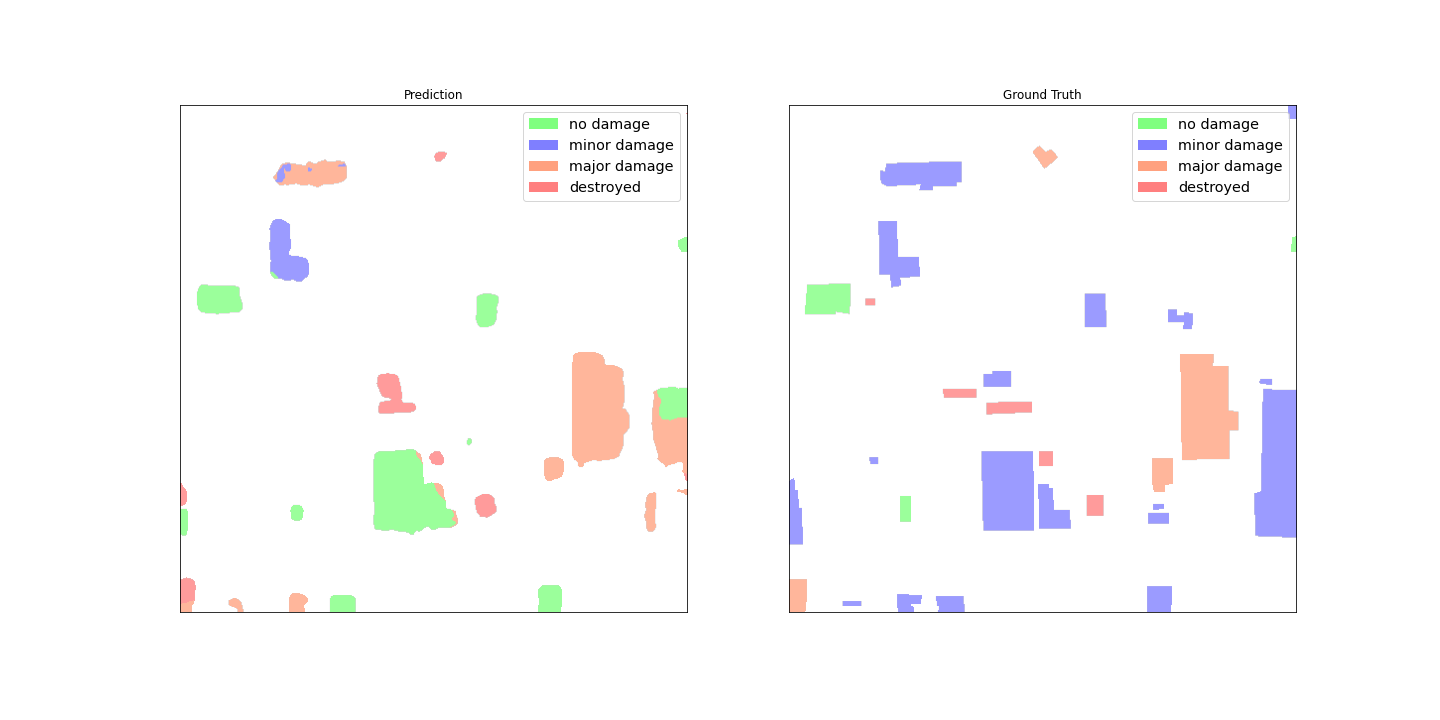

Die folgenden Abbildungen zeigen die vorhergesagte Schadensmaske und die Ground-Truth-Schadensmaske.

Auf den ersten Blick scheint es, als würde das Modell im Vergleich zu den Ground-Truth-Daten nicht gut abschneiden. Viele der Gebäude sind falsch klassifiziert, verwechseln kleinere Schäden mit keinen Schäden und zeigen mehrere Klassifizierungen für einen einzelnen Gebäudeumriss. Ein interessanter Befund bei der Überprüfung der Modellleistung ist jedoch, dass es anscheinend gelernt hat, die Gebäudeschadensklassifizierung zu lokalisieren. Jedes Gebäude kann in klassifiziert werden No Damage, Minor Damage, Major Damage, oder Destroyed. Die prognostizierte Schadensmaske zeigt, dass das Modell das große Gebäude in der Mitte größtenteils klassifiziert hat No Damage, aber die obere rechte Ecke wird als klassifiziert Destroyed. Diese Schadenslokalisierung von Untergebäuden kann Einsatzkräfte weiter unterstützen, indem sie den lokalisierten Schaden pro Gebäude anzeigt.

Modellbereitstellung

Das trainierte Modell wurde dann auf einem asynchronen SageMaker-Inferenzendpunkt bereitgestellt. Beachten Sie, dass wir einen asynchronen Endpunkt gewählt haben, um längere Inferenzzeiten, größere Nutzlasteingabegrößen und die Möglichkeit zu ermöglichen, den Endpunkt auf null Instanzen (keine Gebühren) herunterzuskalieren, wenn er nicht verwendet wird. Die folgende Abbildung zeigt den High-Level-Code für die asynchrone Endpunktbereitstellung. Wir komprimieren zuerst das gespeicherte PyTorch-Zustandswörterbuch und laden die komprimierten Modellartefakte in hoch Amazon Simple Storage-Service (Amazon S3). Wir erstellen ein SageMaker-PyTorch-Modell, das auf unseren Inferenzcode und unsere Modellartefakte verweist. Der Inferenzcode ist erforderlich, um unser Modell zu laden und bereitzustellen. Weitere Einzelheiten zum erforderlichen benutzerdefinierten Inferenzcode für ein SageMaker-PyTorch-Modell finden Sie unter Verwenden Sie PyTorch mit dem SageMaker Python SDK.

Die folgende Abbildung zeigt den Code für die Auto Scaling-Richtlinie für den asynchronen Inferenzendpunkt.

Beachten Sie, dass es andere Endpunktoptionen wie Echtzeit, Batch und serverlos gibt, die für Ihre Anwendung verwendet werden könnten. Sie sollten die Option auswählen, die für den Anwendungsfall am besten geeignet ist, und sich daran erinnern Amazon SageMaker Inference Recommender steht zur Verfügung, um Endpunktkonfigurationen für maschinelles Lernen (ML) zu empfehlen.

Modellschlussfolgerung

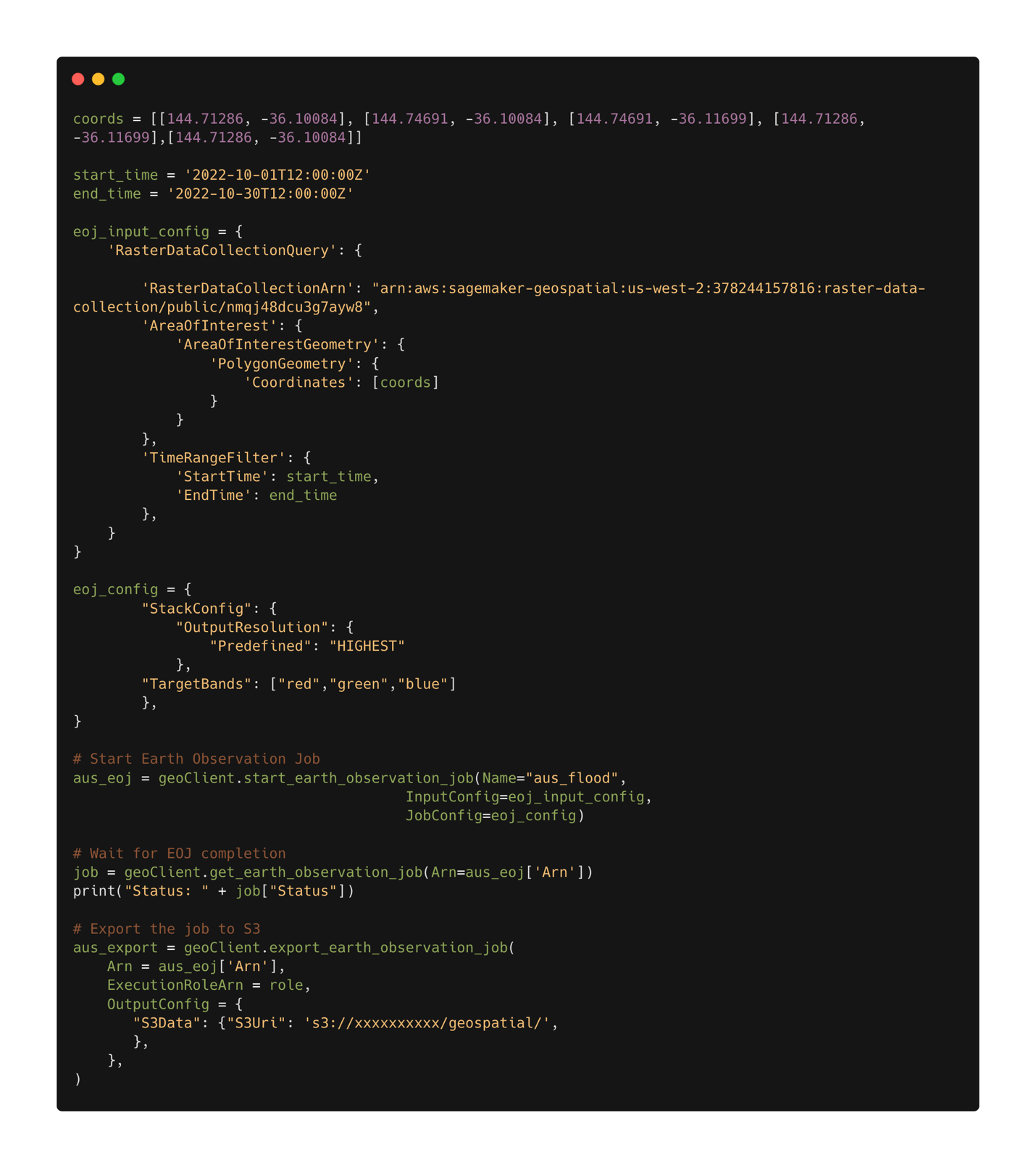

Wenn das trainierte Modell bereitgestellt ist, können wir es jetzt verwenden Geodatenfunktionen von SageMaker um Daten für Rückschlüsse zu sammeln. Mit den raumbezogenen Funktionen von SageMaker sind mehrere integrierte Modelle sofort einsatzbereit. In diesem Beispiel verwenden wir die Bandstapeloperation zum Stapeln der roten, grünen und blauen Farbkanäle für unsere Erdbeobachtungsaufgabe. Der Job sammelt die Daten aus dem Sentinel-2-Datensatz. Um einen Erdbeobachtungsjob zu konfigurieren, benötigen wir zunächst die Koordinaten des interessierenden Ortes. Zweitens benötigen wir den Zeitraum der Beobachtung. Damit können wir jetzt einen Erdbeobachtungsauftrag über die Stacking-Funktion einreichen. Hier stapeln wir die roten, grünen und blauen Bänder, um ein Farbbild zu erzeugen. Die folgende Abbildung zeigt die Jobkonfiguration, die verwendet wurde, um Daten aus den Überschwemmungen in Rochester, Australien, Mitte Oktober 2022 zu generieren. Wir verwenden Bilder von vor und nach der Katastrophe als Eingabe für unser trainiertes ML-Modell.

Nachdem die Jobkonfiguration definiert ist, können wir den Job senden. Wenn der Auftrag abgeschlossen ist, exportieren wir die Ergebnisse nach Amazon S3. Beachten Sie, dass wir die Ergebnisse erst nach Abschluss des Auftrags exportieren können. Die Ergebnisse des Auftrags können an einen vom Benutzer in der Exportauftragskonfiguration angegebenen Amazon S3-Speicherort exportiert werden. Mit unseren neuen Daten in Amazon S3 können wir jetzt mithilfe des bereitgestellten Modells Schadensvorhersagen erhalten. Zuerst lesen wir die Daten in den Speicher und stapeln die Bilder vor und nach der Katastrophe zusammen.

Die Ergebnisse der Segmentierungsmaske für die Überschwemmungen in Rochester sind in den folgenden Bildern dargestellt. Hier können wir sehen, dass das Modell Orte innerhalb der überschwemmten Region als wahrscheinlich beschädigt identifiziert hat. Beachten Sie auch, dass sich die räumliche Auflösung des Inferenzbildes von den Trainingsdaten unterscheidet. Eine Erhöhung der räumlichen Auflösung könnte die Modellleistung verbessern; Aufgrund der mehrskaligen Modellarchitektur ist dies jedoch für das SegFormer-Modell weniger problematisch als für andere Modelle.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie man Schäden durch Naturkatastrophen trainiert, bereitstellt und vorhersagt SageMaker mit raumbezogenen Funktionen. Wir haben die neuen Geodatenfunktionen von SageMaker verwendet, um neue Inferenzdaten zum Testen des Modells zu generieren. Der Code für diesen Beitrag wird gerade veröffentlicht, und dieser Beitrag wird mit Links zum vollständigen Schulungs-, Bereitstellungs- und Rückschlusscode aktualisiert. Diese Anwendung ermöglicht es Ersthelfern, Regierungen und humanitären Organisationen, ihre Reaktion zu optimieren und unmittelbar nach einer Naturkatastrophe ein kritisches Situationsbewusstsein bereitzustellen. Diese Anwendung ist nur ein Beispiel dafür, was mit modernen ML-Tools wie SageMaker möglich ist.

Probieren Sie die raumbezogenen Funktionen von SageMaker noch heute mit Ihren eigenen Modellen aus; Wir sind gespannt, was Sie als nächstes bauen.

Über den Autor

Aaron Sengstacken ist ein auf maschinelles Lernen spezialisierter Lösungsarchitekt bei Amazon Web Services. Aaron arbeitet eng mit Kunden des öffentlichen Sektors jeder Größe zusammen, um Anwendungen für maschinelles Lernen zu entwickeln und bereitzustellen. Er interessiert sich für maschinelles Lernen, Technologie und Weltraumforschung.

Aaron Sengstacken ist ein auf maschinelles Lernen spezialisierter Lösungsarchitekt bei Amazon Web Services. Aaron arbeitet eng mit Kunden des öffentlichen Sektors jeder Größe zusammen, um Anwendungen für maschinelles Lernen zu entwickeln und bereitzustellen. Er interessiert sich für maschinelles Lernen, Technologie und Weltraumforschung.

- Fortgeschritten (300)

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Sage Maker

- Geodaten von Amazon SageMaker

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Geodaten-ML

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet