Die Zunahme sozialer Online-Aktivitäten wie soziale Netzwerke oder Online-Spiele geht häufig mit feindseligem oder aggressivem Verhalten einher, das zu unerwünschten Äußerungen von Hassreden, Cybermobbing oder Belästigung führen kann. Viele Online-Gaming-Communities bieten beispielsweise Voice-Chat-Funktionen an, um die Kommunikation zwischen ihren Benutzern zu erleichtern. Obwohl Voice-Chat oft freundliches Geplänkel und Trashtalk unterstützt, kann es auch zu Problemen wie Hassreden, Cybermobbing, Belästigung und Betrug führen. Durch die Kennzeichnung schädlicher Sprache können Organisationen zivilisierte Gespräche führen und eine sichere und integrative Online-Umgebung aufrechterhalten, in der Benutzer frei erstellen, teilen und teilnehmen können. Heutzutage verlassen sich viele Unternehmen bei der Überprüfung giftiger Inhalte ausschließlich auf menschliche Moderatoren. Es ist jedoch kostspielig, menschliche Moderatoren einzusetzen, um diese Anforderungen in ausreichender Qualität und Geschwindigkeit zu erfüllen. Infolgedessen laufen viele Unternehmen Gefahr, mit hohen Abwanderungsraten, Reputationsschäden und behördlichen Bußgeldern konfrontiert zu werden. Darüber hinaus werden Moderatoren durch die Überprüfung des toxischen Inhalts häufig psychisch belastet.

Amazon Transcribe ist ein automatischer Spracherkennungsdienst (ASR), der es Entwicklern erleichtert, ihren Anwendungen Sprach-zu-Text-Funktionen hinzuzufügen. Heute freuen wir uns, dies bekannt zu geben Amazon Transcribe-Toxizitätserkennung, eine auf maschinellem Lernen (ML) basierende Funktion, die sowohl audio- als auch textbasierte Hinweise verwendet, um sprachbasierte toxische Inhalte in sieben Kategorien zu identifizieren und zu klassifizieren, darunter sexuelle Belästigung, Hassrede, Drohungen, Missbrauch, Schimpfwörter, Beleidigungen und grafische Sprache . Zusätzlich zum Text verwendet die Toxicity Detection Sprachmerkmale wie Töne und Tonhöhen, um die toxische Absicht in der Sprache zu erkennen.

Dies ist eine Verbesserung gegenüber Standardsystemen zur Inhaltsmoderation, die darauf ausgelegt sind, sich nur auf bestimmte Begriffe zu konzentrieren, ohne die Absicht zu berücksichtigen. Die meisten Unternehmen haben eine SLA von 7–15 Tagen, um von Benutzern gemeldete Inhalte zu überprüfen, da Moderatoren sich lange Audiodateien anhören müssen, um zu beurteilen, ob und wann die Konversation toxisch wurde. Mit Amazon Transcribe Toxicity Detection überprüfen Moderatoren nur den spezifischen Teil der Audiodatei, der als toxischer Inhalt gekennzeichnet ist (im Gegensatz zur gesamten Audiodatei). Der Aufwand, den menschliche Moderatoren überprüfen müssen, wird um 95 % reduziert, sodass Kunden ihr SLA auf nur wenige Stunden verkürzen und proaktiv mehr Inhalte moderieren können, die über die von den Benutzern gemeldeten Inhalte hinausgehen. Es ermöglicht Unternehmen, Inhalte in großem Umfang automatisch zu erkennen und zu moderieren, eine sichere und integrative Online-Umgebung bereitzustellen und Maßnahmen zu ergreifen, bevor es zu Benutzerabwanderung oder Rufschädigung kommen kann. Die für die Erkennung toxischer Inhalte verwendeten Modelle werden von Amazon Transcribe gepflegt und regelmäßig aktualisiert, um Genauigkeit und Relevanz zu gewährleisten.

In diesem Beitrag erfahren Sie, wie Sie:

- Identifizieren Sie schädliche Sprachinhalte mit Amazon Transcribe Toxicity Detection

- Verwenden Sie die Amazon Transcribe-Konsole zur Toxizitätserkennung

- Erstellen Sie einen Transkriptionsauftrag mit Toxizitätserkennung mithilfe von AWS-Befehlszeilenschnittstelle (AWS CLI) und Python SDK

- Verwenden Sie die Amazon Transcribe-API-Antwort zur Toxizitätserkennung

Erkennen Sie Toxizität im Audio-Chat mit Amazon Transcribe Toxicity Detection

Amazon Transcribe bietet jetzt eine einfache, ML-basierte Lösung zur Kennzeichnung schädlicher Sprache in gesprochenen Gesprächen. Diese Funktion ist besonders nützlich für soziale Medien, Spiele und allgemeine Anforderungen, da Kunden nicht mehr ihre eigenen Daten bereitstellen müssen, um das ML-Modell zu trainieren. Die Toxizitätserkennung klassifiziert toxische Audioinhalte in die folgenden sieben Kategorien und stellt für jede Kategorie einen Konfidenzwert (0–1) bereit:

- Profanität – Rede, die Wörter, Phrasen oder Akronyme enthält, die unhöflich, vulgär oder beleidigend sind.

- Hass-Rede – Äußerungen, die eine Person oder Gruppe aufgrund ihrer Identität (z. B. Rasse, ethnische Zugehörigkeit, Geschlecht, Religion, sexuelle Orientierung, Fähigkeiten und nationale Herkunft) kritisieren, beleidigen, denunzieren oder entmenschlichen.

- Sexuell – Sprache, die auf sexuelles Interesse, Aktivität oder Erregung hinweist und sich direkt oder indirekt auf Körperteile, körperliche Merkmale oder das Geschlecht bezieht.

- Beleidigungen – Äußerungen, die eine erniedrigende, erniedrigende, spöttische, beleidigende oder herabwürdigende Sprache beinhalten. Diese Art von Sprache wird auch als Mobbing bezeichnet.

- Gewalt oder Bedrohung – Äußerungen, die Drohungen beinhalten, die darauf abzielen, einer Person oder Gruppe Schmerz, Verletzung oder Feindseligkeit zuzufügen.

- Grafik – Rede, die visuell beschreibende und unangenehm lebendige Bilder verwendet. Diese Art von Sprache ist oft absichtlich ausführlich, um das Unbehagen des Empfängers zu verstärken.

- Belästigung oder Beleidigung – Äußerungen, die darauf abzielen, das psychische Wohlbefinden des Empfängers zu beeinträchtigen, einschließlich erniedrigender und objektivierender Ausdrücke.

Sie können auf Toxicity Detection entweder über die Amazon Transcribe-Konsole oder durch direkten Aufruf der APIs über die AWS CLI oder die AWS SDKs zugreifen. Auf der Amazon Transcribe-Konsole können Sie die Audiodateien hochladen, die Sie auf Toxizität testen möchten, und erhalten mit nur wenigen Klicks Ergebnisse. Amazon Transcribe identifiziert und kategorisiert giftige Inhalte wie Belästigung, Hassrede, sexuelle Inhalte, Gewalt, Beleidigungen und Obszönitäten. Amazon Transcribe bietet außerdem einen Konfidenzwert für jede Kategorie und liefert so wertvolle Einblicke in den Toxizitätsgrad des Inhalts. Die Toxizitätserkennung ist derzeit in der Standard-Amazon-Transcribe-API für die Stapelverarbeitung verfügbar und unterstützt die Sprache US-Englisch.

Komplettlösung für die Amazon Transcribe-Konsole

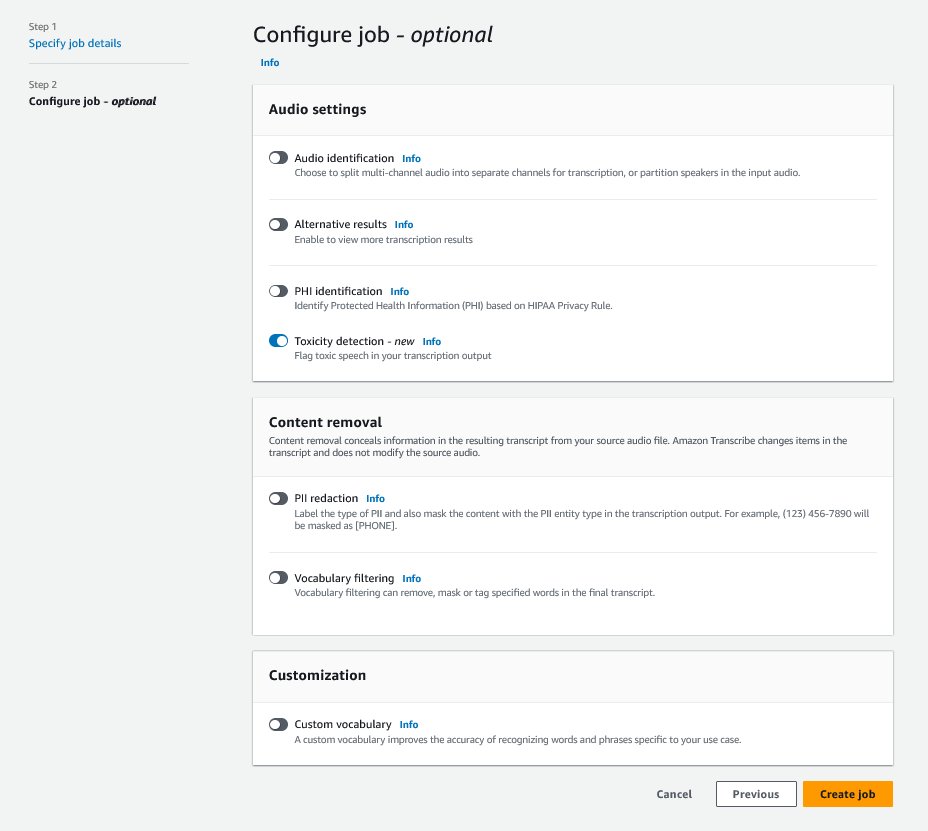

Melden Sie sich zunächst bei der an AWS-Managementkonsole und gehen Sie zu Amazon Transcribe. Um einen neuen Transkriptionsauftrag zu erstellen, müssen Sie Ihre aufgezeichneten Dateien in einen hochladen Amazon Simple Storage-Service (Amazon S3)-Bucket, bevor sie verarbeitet werden können. Aktivieren Sie die Option auf der Seite mit den Audioeinstellungen, wie im folgenden Screenshot gezeigt Toxizitätserkennung und fahren Sie mit der Erstellung des neuen Jobs fort. Amazon Transcribe verarbeitet den Transkriptionsauftrag im Hintergrund. Während der Job fortschreitet, können Sie damit rechnen, dass sich der Status in ändert FERTIGGESTELLT wenn der Vorgang abgeschlossen ist.

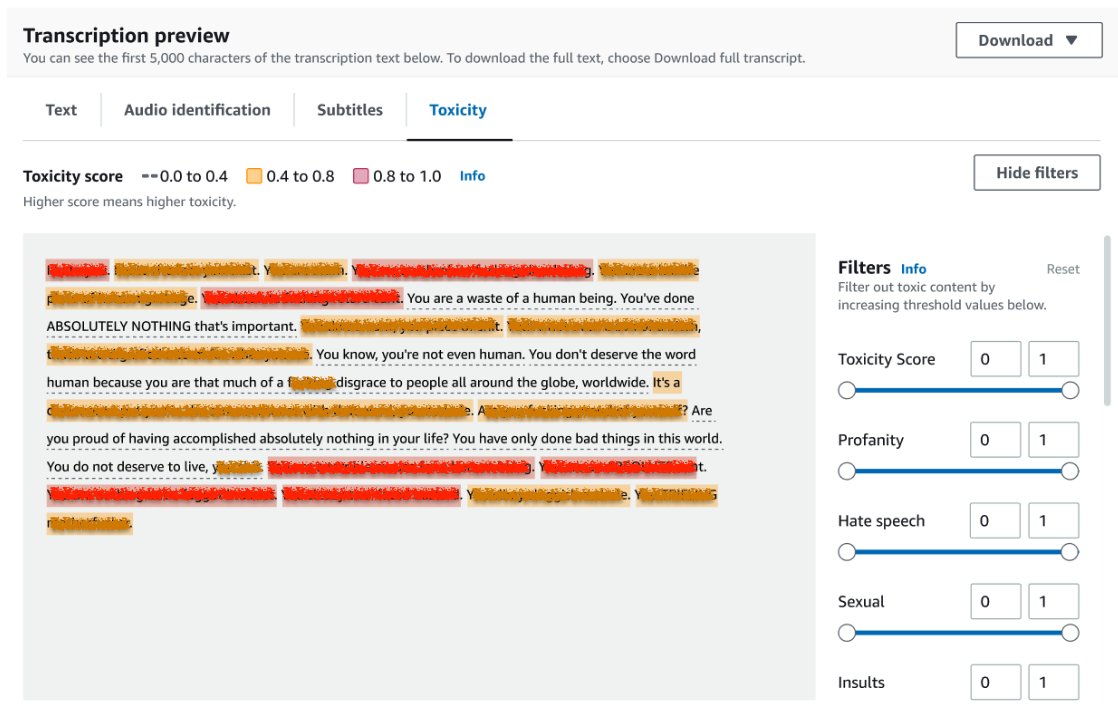

Um die Ergebnisse eines Transkriptionsauftrags zu überprüfen, wählen Sie den Auftrag aus der Auftragsliste aus, um ihn zu öffnen. Scrollen Sie nach unten zum Transkriptionsvorschau Abschnitt, um die Ergebnisse zu überprüfen Toxizität Tab. Die Benutzeroberfläche zeigt farbcodierte Transkriptionssegmente an, um den Grad der Toxizität anzuzeigen, der durch den Konfidenzwert bestimmt wird. Um die Anzeige anzupassen, können Sie die Umschaltleisten im verwenden Filter Feld. Mit diesen Balken können Sie die Schwellenwerte anpassen und die Toxizitätskategorien entsprechend filtern.

Der folgende Screenshot hat Teile des Transkriptionstextes verdeckt, da sensible oder toxische Informationen vorhanden waren.

Transkriptions-API mit einer Anfrage zur Toxizitätserkennung

In diesem Abschnitt führen wir Sie durch die Erstellung eines Transkriptionsauftrags mit Toxizitätserkennung mithilfe von Programmierschnittstellen. Wenn sich die Audiodatei noch nicht in einem S3-Bucket befindet, laden Sie sie hoch, um den Zugriff durch Amazon Transcribe sicherzustellen. Ähnlich wie beim Erstellen eines Transkriptionsauftrags auf der Konsole müssen Sie beim Aufrufen des Auftrags die folgenden Parameter angeben:

- TranscriptionJobName – Geben Sie einen eindeutigen Jobnamen an.

- MediaFileUri – Geben Sie den URI-Speicherort der Audiodatei auf Amazon S3 ein. Amazon Transcribe unterstützt die folgenden Audioformate: MP3, MP4, WAV, FLAC, AMR, OGG oder WebM

- Sprachcode - Einstellen

en-US. Zum jetzigen Zeitpunkt unterstützt Toxicity Detection nur US-Englisch. - Toxizitätskategorien – Übergeben Sie die

ALLGeben Sie den Wert an, um alle unterstützten Toxizitätserkennungskategorien einzuschließen.

Im Folgenden finden Sie Beispiele für das Starten eines Transkriptionsauftrags mit aktivierter Toxizitätserkennung mithilfe von Python3:

Sie können denselben Transkriptionsauftrag mit Toxizitätserkennung mit dem folgenden AWS CLI-Befehl aufrufen:

Transkriptions-API mit Reaktion zur Toxizitätserkennung

Die JSON-Ausgabe der Toxizitätserkennung von Amazon Transcribe enthält die Transkriptionsergebnisse im Ergebnisfeld. Durch die Aktivierung der Toxizitätserkennung wird ein zusätzliches Feld namens hinzugefügt toxicityDetection unter dem Ergebnisfeld. toxicityDetection enthält eine Liste transkribierter Elemente mit den folgenden Parametern:

- Text – Der rohe transkribierte Text

- Toxizität – Ein Konfidenzwert der Erkennung (ein Wert zwischen 0 und 1)

- Kategorien – Ein Konfidenzwert für jede Kategorie toxischer Sprache

- Startzeit – Die Startposition der Erkennung in der Audiodatei (Sekunden)

- endzeit – Die Endposition der Erkennung in der Audiodatei (Sekunden)

Das Folgende ist ein Beispiel für eine abgekürzte Toxizitätserkennungsantwort, die Sie von der Konsole herunterladen können:

Zusammenfassung

In diesem Beitrag haben wir einen Überblick über die neue Amazon Transcribe Toxicity Detection-Funktion gegeben. Wir haben auch beschrieben, wie Sie die JSON-Ausgabe der Toxizitätserkennung analysieren können. Weitere Informationen finden Sie in der Amazon Transcribe-Konsole und testen Sie die Transkriptions-API mit Toxicity Detection.

Amazon Transcribe Toxicity Detection ist jetzt in den folgenden AWS-Regionen verfügbar: USA Ost (Ohio), USA Ost (Nord-Virginia), USA West (Oregon), Asien-Pazifik (Sydney), Europa (Irland) und Europa (London). Um mehr zu erfahren, besuchen Sie Amazon Transcribe.

Erfahren Sie mehr darüber Inhaltsmoderation auf AWS und unseren ML-Anwendungsfälle für die Inhaltsmoderation. Machen Sie den ersten Schritt dorthin Optimieren Sie Ihre Content-Moderationsvorgänge mit AWS.

Über den Autor

Lana Zhang ist Senior Solutions Architect beim AWS WWSO AI Services-Team, spezialisiert auf KI und ML für Inhaltsmoderation, Computer Vision und Verarbeitung natürlicher Sprache. Mit ihrem Fachwissen widmet sie sich der Förderung von AWS AI/ML-Lösungen und unterstützt Kunden bei der Transformation ihrer Geschäftslösungen in verschiedenen Branchen, darunter soziale Medien, Spiele, E-Commerce sowie Werbung und Marketing.

Lana Zhang ist Senior Solutions Architect beim AWS WWSO AI Services-Team, spezialisiert auf KI und ML für Inhaltsmoderation, Computer Vision und Verarbeitung natürlicher Sprache. Mit ihrem Fachwissen widmet sie sich der Förderung von AWS AI/ML-Lösungen und unterstützt Kunden bei der Transformation ihrer Geschäftslösungen in verschiedenen Branchen, darunter soziale Medien, Spiele, E-Commerce sowie Werbung und Marketing.

Sumit Kumar ist Senior Product Manager, Technical beim AWS AI Language Services-Team. Er verfügt über 10 Jahre Erfahrung im Produktmanagement in verschiedenen Bereichen und ist begeistert von KI/ML. Außerhalb der Arbeit reist Sumit gerne und spielt gerne Cricket und Rasentennis.

Sumit Kumar ist Senior Product Manager, Technical beim AWS AI Language Services-Team. Er verfügt über 10 Jahre Erfahrung im Produktmanagement in verschiedenen Bereichen und ist begeistert von KI/ML. Außerhalb der Arbeit reist Sumit gerne und spielt gerne Cricket und Rasentennis.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Automobil / Elektrofahrzeuge, Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- BlockOffsets. Modernisierung des Eigentums an Umweltkompensationen. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- :hast

- :Ist

- :nicht

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- 95%

- a

- Fähigkeit

- Über uns

- Missbrauch

- Zugang

- entsprechend

- Buchhaltung

- Genauigkeit

- über

- Action

- Aktivitäten

- Aktivität

- hinzufügen

- Zusatz

- Fügt

- Marketings

- aggressiv

- AI

- KI-Dienste

- AI / ML

- Alle

- erlauben

- bereits

- ebenfalls

- Obwohl

- Amazon

- Amazon Transcribe

- Amazon Web Services

- unter

- an

- machen

- Bekannt geben

- Bienen

- APIs

- Anwendungen

- SIND

- AS

- Asien

- Asien-Pazifik-

- Unterstützung

- At

- Attrition

- Audio-

- automatische

- Im Prinzip so, wie Sie es von Google Maps kennen.

- verfügbar

- AWS

- Hintergrund

- Riegel

- Grundlage

- BE

- wurde

- weil

- Bevor

- Verhalten

- zwischen

- Beyond

- Körper

- beide

- Break

- Schikane

- Geschäft

- by

- namens

- Aufruf

- CAN

- capability

- Kategorien

- Kategorie

- Verursachen

- Übernehmen

- aus der Ferne überprüfen

- Auswählen

- klassifizieren

- Kommunikation

- Communities

- Unternehmen

- abschließen

- Abgeschlossene Verkäufe

- Computer

- Computer Vision

- Vertrauen

- Konsul (Console)

- enthält

- Inhalt

- Gespräch

- Gespräche

- bedeckt

- erstellen

- Erstellen

- Kricket

- Kritisiert

- Zur Zeit

- Kunden

- anpassen

- technische Daten

- Tage

- gewidmet

- beschrieben

- entworfen

- entdecken

- Entdeckung

- entschlossen

- Entwickler

- Direkt

- Direkt

- Display

- verschieden

- Domains

- nach unten

- herunterladen

- zwei

- e-commerce

- jeder

- Osten

- Einfache

- entweder

- eliminieren

- ermöglichen

- freigegeben

- ermöglichen

- Ende

- Englisch

- gewährleisten

- Enter

- Unternehmen

- Ganz

- Arbeitsumfeld

- insbesondere

- Ethnizität

- Europa

- bewerten

- Beispiel

- Beispiele

- aufgeregt

- erwarten

- teuer

- ERFAHRUNGEN

- Expertise

- extra

- erleichtern

- zugewandt

- Gescheitert

- Merkmal

- wenige

- Feld

- Reichen Sie das

- Mappen

- Filter

- Ende

- Vorname

- markiert

- Setzen Sie mit Achtsamkeit

- Folgende

- Aussichten für

- freundlich

- für

- Funktionalität

- Gaming

- Geschlecht

- Allgemeines

- bekommen

- Go

- Goes

- Grafik

- Gruppe an

- Guide

- schädlich

- Haben

- he

- hilft

- hier (auf dänisch)

- hier

- GUTE

- STUNDEN

- Ultraschall

- Hilfe

- aber

- HTML

- http

- HTTPS

- human

- identifizieren

- Identitätsschutz

- if

- wirkt

- importieren

- Verbesserung

- in

- das

- Dazu gehören

- Einschließlich

- Inklusive

- Erhöhung

- zeigen

- zeigt

- Branchen

- Information

- Einblicke

- Beleidigung

- beabsichtigt

- Absicht

- Absicht

- absichtlich

- Interesse

- Schnittstellen

- in

- Irland

- IT

- Artikel

- Job

- jpg

- JSON

- nur

- Behalten

- Sprache

- führen

- LERNEN

- lernen

- Niveau

- Line

- Liste

- Standorte

- London

- liebt

- Maschine

- Maschinelles Lernen

- halten

- MACHT

- Management

- Manager

- viele

- Marketing

- Medien

- Triff

- ML

- Modell

- für

- Mäßigung

- mehr

- vor allem warme

- sollen

- Name

- National

- Natürliche

- Verarbeitung natürlicher Sprache

- Need

- Bedürfnisse

- Vernetzung

- Neu

- jetzt an

- of

- bieten

- vorgenommen,

- Ohio

- on

- Online

- online Spielen

- einzige

- XNUMXh geöffnet

- Einkauf & Prozesse

- or

- Oregon

- Organisationen

- Herkunft

- UNSERE

- Möglichkeiten für das Ausgangssignal:

- aussen

- Überblick

- besitzen

- Pazifik

- Seite

- Schmerzen

- Parameter

- teilnehmen

- Teile

- passieren

- leidenschaftlich

- person

- Sätze

- physikalisch

- Tonhöhe (Pitch)

- Plato

- Datenintelligenz von Plato

- PlatoData

- spielend

- Teil

- Position

- Post

- Präsenz

- Probleme

- Prozessdefinierung

- Verarbeitet

- Verarbeitung

- Produkt

- Produktmanagement

- Produkt-Manager

- PROFANITÄT

- Programmierung

- Die Förderung der

- die

- vorausgesetzt

- bietet

- Bereitstellung

- Python

- Qualität

- Rennen

- Honorar

- Roh

- bereit

- Anerkennung

- aufgezeichnet

- Veteran

- Reduziert

- Referenzen

- Regionen

- Regulierungsbehörden

- Relevanz

- Religion

- verlassen

- Berichtet

- Antwort

- Folge

- Die Ergebnisse

- Überprüfen

- Überprüfung

- Risiko

- Safe

- gleich

- Skalieren

- Skalierung

- Betrug

- Ergebnis

- blättern

- SDKS

- Sekunden

- Abschnitt

- auf der Suche nach

- Segment

- Segmente

- Senior

- empfindlich

- Dienstleistungen

- kompensieren

- Einstellungen

- sieben

- Geschlecht

- Sexuell

- Teilen

- sie

- gezeigt

- Konzerte

- Schild

- ähnlich

- Einfacher

- Social Media

- Social Media

- Soziales Netzwerk

- allein

- Lösung

- Lösungen

- spezialisieren

- spezifisch

- Rede

- Spracherkennung

- Speech-to-Text

- Geschwindigkeit

- gesprochen

- Standard

- Anfang

- begonnen

- Beginnen Sie

- Status

- Schritt

- Lagerung

- so

- ausreichend

- Unterstützte

- Unterstützt

- Sydney

- Systeme und Techniken

- Nehmen

- sprechen

- Team

- Technische

- AGB

- Test

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- ihr

- Sie

- Diese

- vom Nutzer definierten

- fehlen uns die Worte.

- Bedrohungen

- Durch

- Zeit

- zu

- heute

- gegenüber

- gegenüber

- Training

- Transformieren

- reisen

- was immer dies auch sein sollte.

- versuchen

- tippe

- ui

- für

- einzigartiges

- Unverlangt

- aktualisiert

- us

- -

- benutzt

- Mitglied

- Nutzer

- verwendet

- Verwendung von

- wertvoll

- Wert

- Vielfalt

- Gewalt

- Virginia

- Seh-

- Besuchen Sie

- Stimme

- vs

- vulgär

- warten

- wollen

- we

- Netz

- Web-Services

- GUT

- West

- wann

- während

- werden wir

- mit

- ohne

- Worte

- Arbeiten

- Schreiben

- Jahr

- noch

- Du

- Ihr

- Zephyrnet