Daten verändern jeden Bereich und jedes Unternehmen. Da die Daten jedoch schneller wachsen, als die meisten Unternehmen nachverfolgen können, ist das Sammeln von Daten und die Gewinnung von Wert aus diesen Daten eine Herausforderung. EIN Moderne Datenstrategie kann Ihnen dabei helfen, mit Daten bessere Geschäftsergebnisse zu erzielen. AWS bietet das umfassendste Angebot an Services für die End-to-End-Datenreise um Ihnen zu helfen Erschließen Sie Wert aus Ihren Daten und verwandle es in Einsicht.

Data Scientists können bis zu 80 % ihrer Zeit damit verbringen, Daten für Machine Learning (ML)-Projekte vorzubereiten. Dieser Vorbereitungsprozess ist weitgehend undifferenziert und langwierig und kann mehrere Programmier-APIs und benutzerdefinierte Bibliotheken umfassen. Amazon SageMaker Data Wrangler unterstützt Data Scientists und Data Engineers bei der Vereinfachung und Beschleunigung der Tabellen- und Zeitreihendatenvorbereitung und Feature-Engineering über eine visuelle Schnittstelle. Sie können Daten aus mehreren Datenquellen importieren, z Amazon Simple Storage-Service (Amazon S3), Amazonas Athena, Amazon RedShift, oder sogar Lösungen von Drittanbietern wie Schneeflocke or DataBricks, und verarbeiten Sie Ihre Daten mit über 300 integrierten Datentransformationen und einer Bibliothek mit Codeausschnitten, sodass Sie Funktionen schnell normalisieren, transformieren und kombinieren können, ohne Code schreiben zu müssen. Sie können Ihre benutzerdefinierten Transformationen auch in PySpark, SQL oder Pandas einbringen.

Dieser Beitrag zeigt, wie Sie Ihre Datenvorbereitungsjobs so planen können, dass sie automatisch ausgeführt werden. Wir untersuchen auch die neue Data Wrangler-Funktion parametrisierter Datensätze, mit der Sie die in einen Datenfluss aufzunehmenden Dateien mithilfe parametrisierter URIs angeben können.

Lösungsüberblick

Data Wrangler unterstützt jetzt das Importieren von Daten mit einem parametrisierten URI. Dies ermöglicht weitere Flexibilität, da Sie jetzt alle Datensätze importieren können, die den angegebenen Parametern entsprechen, die vom Typ String, Number, Datetime und Pattern im URI sein können. Darüber hinaus können Sie Ihre Data Wrangler-Transformationsjobs jetzt nach einem Zeitplan auslösen.

In diesem Beitrag erstellen wir einen Beispielfluss mit dem Titanic-Dataset, um zu zeigen, wie Sie mit diesen beiden neuen Funktionen von Data Wrangler experimentieren können. Um den Datensatz herunterzuladen, siehe Titanic – Maschinelles Lernen aus der Katastrophe.

Voraussetzungen:

Um alle in diesem Beitrag beschriebenen Funktionen nutzen zu können, müssen Sie die neueste Kernel-Version von Data Wrangler ausführen. Weitere Informationen finden Sie unter Aktualisieren Sie Data Wrangler. Außerdem müssen Sie laufen Amazon SageMaker-Studio JupyterLab 3. Informationen zum Anzeigen und Aktualisieren der aktuellen Version finden Sie unter JupyterLab-Versionierung.

Dateistruktur

Für diese Demonstration folgen wir einer einfachen Dateistruktur, die Sie replizieren müssen, um die in diesem Beitrag beschriebenen Schritte zu reproduzieren.

- Im Atelier, Erstellen Sie ein neues Notizbuch.

- Führen Sie das folgende Code-Snippet aus, um die von uns verwendete Ordnerstruktur zu erstellen (stellen Sie sicher, dass Sie sich im gewünschten Ordner in Ihrem Dateibaum befinden):

- Kopieren Sie die

train.csvundtest.csvDateien aus dem ursprünglichen Titanic-Datensatz in die Ordnertitanic_dataset/trainundtitanic_dataset/test, Bzw. - Führen Sie das folgende Code-Snippet aus, um die Ordner mit den erforderlichen Dateien zu füllen:

Wir teilen die train.csv Datei des Titanic-Datensatzes in neun verschiedene Dateien namens part_x, wobei x die Nummer des Teils ist. Teil 0 enthält die ersten 100 Datensätze, Teil 1 die nächsten 100 und so weiter bis Teil 8. Jeder Knotenordner des Dateibaums enthält eine Kopie der neun Teile der Trainingsdaten mit Ausnahme der train und test Ordner, die enthalten train.csv und test.csv.

Parametrisierte Datensätze

Benutzer von Data Wrangler können jetzt Parameter für die aus Amazon S3 importierten Datensätze angeben. Datensatzparameter werden am URI der Ressourcen angegeben, und ihr Wert kann dynamisch geändert werden, was mehr Flexibilität bei der Auswahl der zu importierenden Dateien ermöglicht. Parameter können von vier Datentypen sein:

- Nummer – Kann den Wert einer beliebigen Ganzzahl annehmen

- Schnur – Kann den Wert einer beliebigen Textzeichenfolge annehmen

- Schnittmuster – Kann den Wert eines beliebigen regulären Ausdrucks annehmen

- Datumzeit – Kann den Wert jedes der unterstützten Datums-/Zeitformate annehmen

In diesem Abschnitt bieten wir eine exemplarische Vorgehensweise für diese neue Funktion. Dies ist nur verfügbar, nachdem Sie Ihren Datensatz in Ihren aktuellen Flow importiert haben, und nur für Datensätze, die aus Amazon S3 importiert wurden.

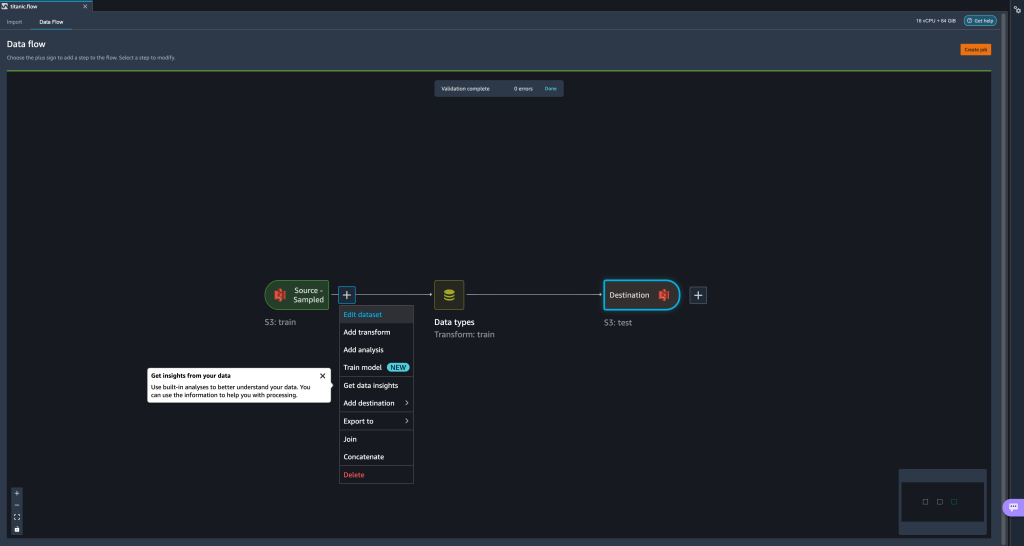

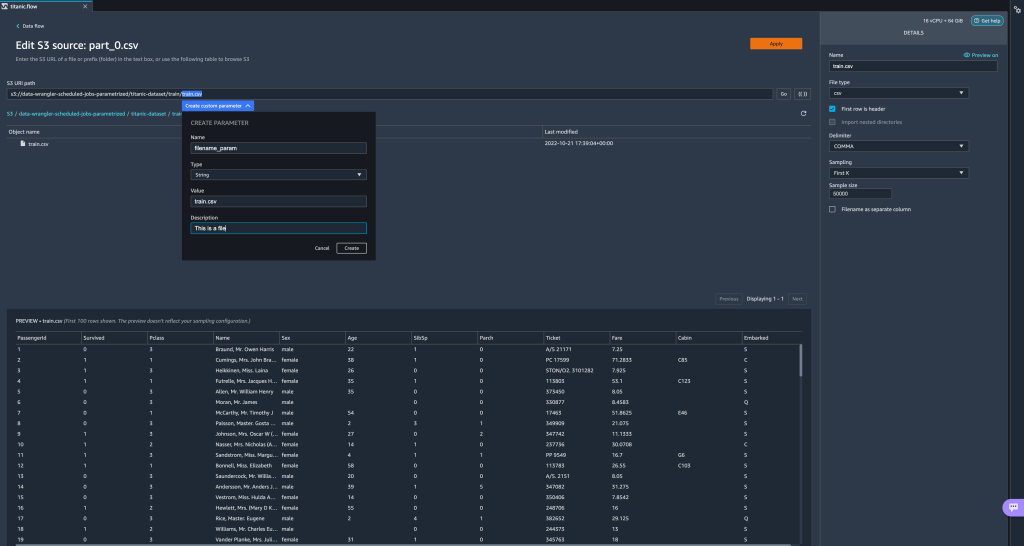

- Wählen Sie in Ihrem Datenfluss das Pluszeichen (+) neben dem Importschritt und wählen Sie aus Datensatz bearbeiten.

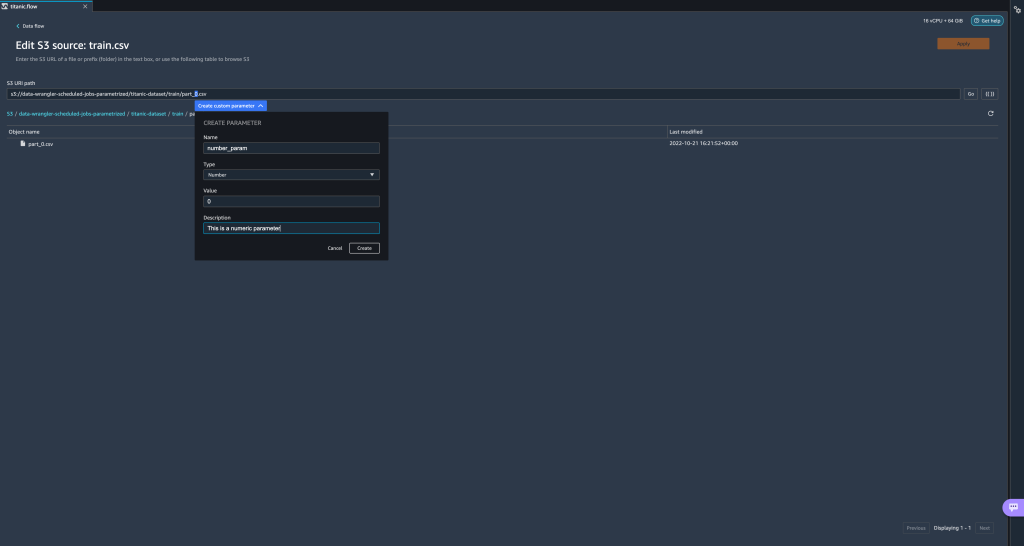

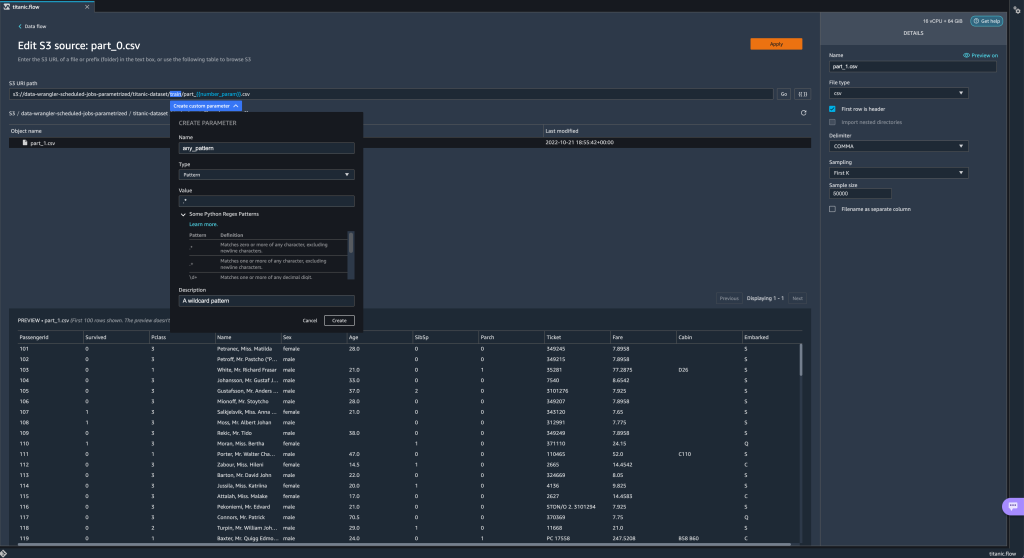

- Die bevorzugte (und einfachste) Methode zum Erstellen neuer Parameter besteht darin, einen Abschnitt Ihrer URI zu markieren und auszuwählen Benutzerdefinierten Parameter erstellen im Dropdown-Menü. Sie müssen für jeden Parameter, den Sie erstellen möchten, vier Dinge angeben:

- Name und Vorname

- Typ

- Standardwert

- Beschreibung

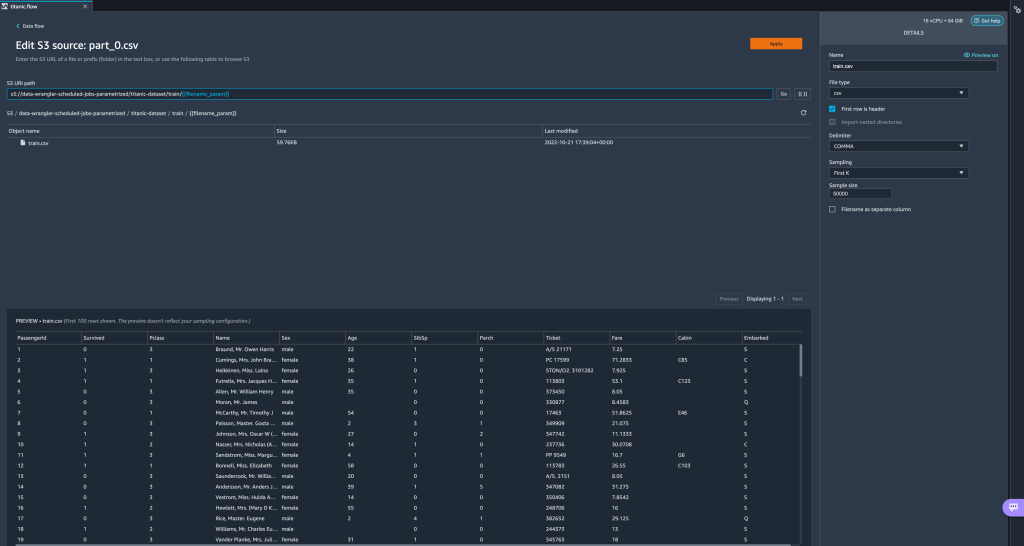

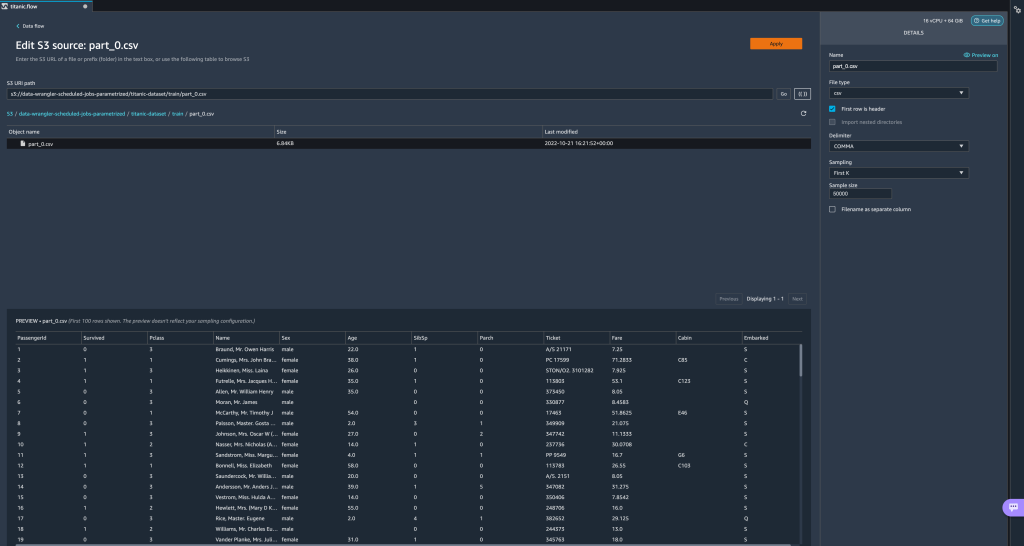

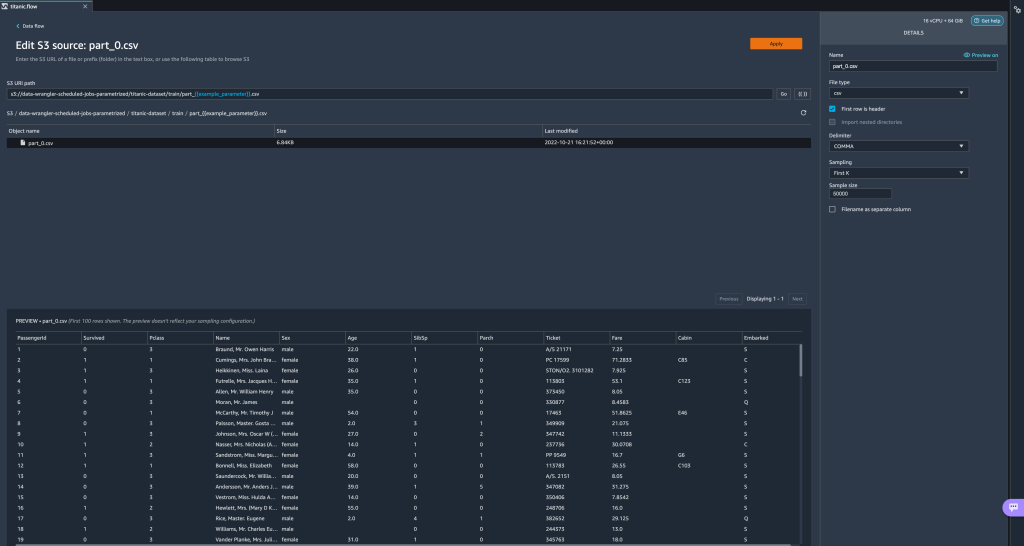

Hier haben wir einen Parameter vom Typ String mit dem Namen erstelltfilename_parammit einem Standardwert vontrain.csv. Jetzt können Sie den Parameternamen sehen, der in doppelte Klammern eingeschlossen ist und den Teil des URI ersetzt, den wir zuvor hervorgehoben haben. Denn der definierte Wert für diesen Parameter wartrain.csv, sehen wir jetzt die Dateitrain.csvin der Importtabelle aufgeführt.

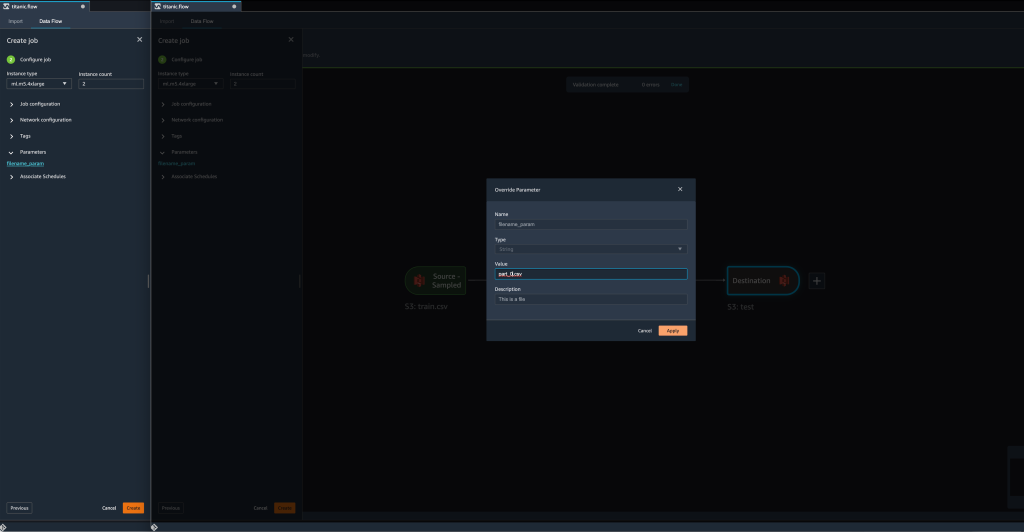

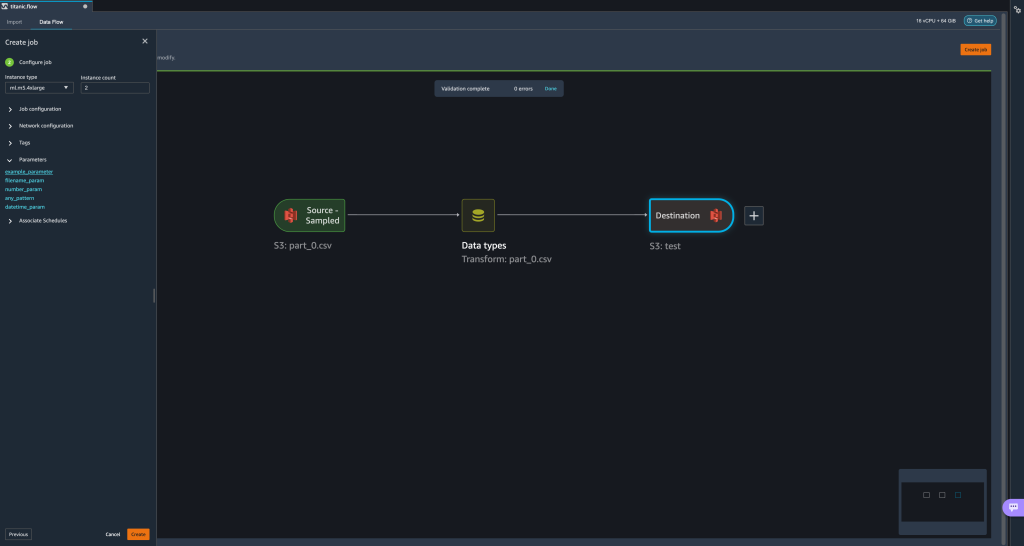

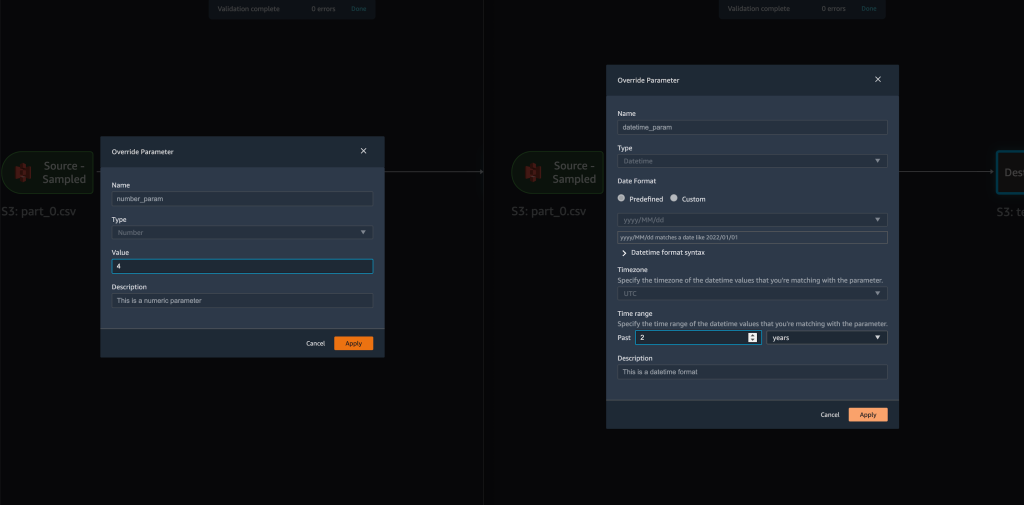

- Wenn wir versuchen, einen Transformationsjob zu erstellen, auf der Job konfigurieren Schritt, wir sehen jetzt a Parameter Abschnitt, wo wir eine Liste aller unserer definierten Parameter sehen können.

- Die Auswahl des Parameters gibt uns die Möglichkeit, den Wert des Parameters zu ändern, in diesem Fall den Eingabedatensatz zu ändern, der gemäß dem definierten Fluss transformiert werden soll.

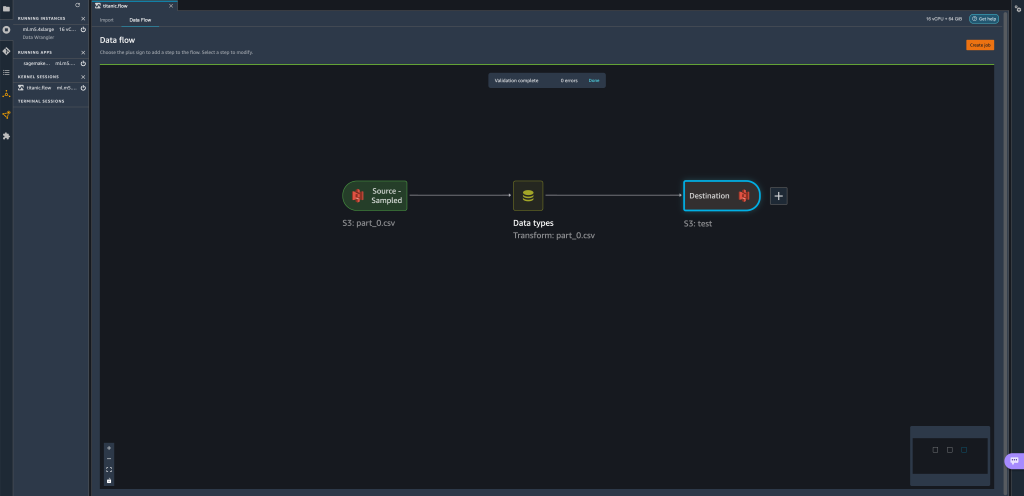

Angenommen, wir ändern den Wert vonfilename_paramfürtrain.csvzupart_0.csv, übernimmt nun den Verwandlungsjobpart_0.csv(vorausgesetzt, eine Datei mit dem Namenpart_0.csvbefindet sich im selben Ordner) wie die neuen Eingabedaten.

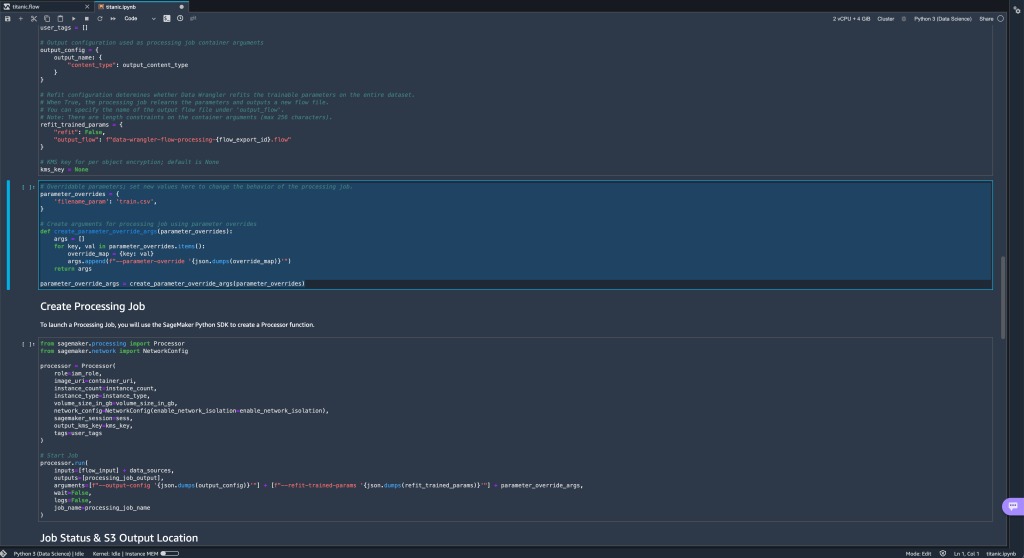

- Wenn Sie außerdem versuchen, Ihren Flow an ein Amazon S3-Ziel (über ein Jupyter-Notebook) zu exportieren, sehen Sie jetzt eine neue Zelle mit den von Ihnen definierten Parametern.

Beachten Sie, dass der Parameter seinen Standardwert annimmt, aber Sie können ihn ändern, indem Sie seinen Wert in der ersetzenparameter_overridesWörterbuch (während die Schlüssel des Wörterbuchs unverändert bleiben).

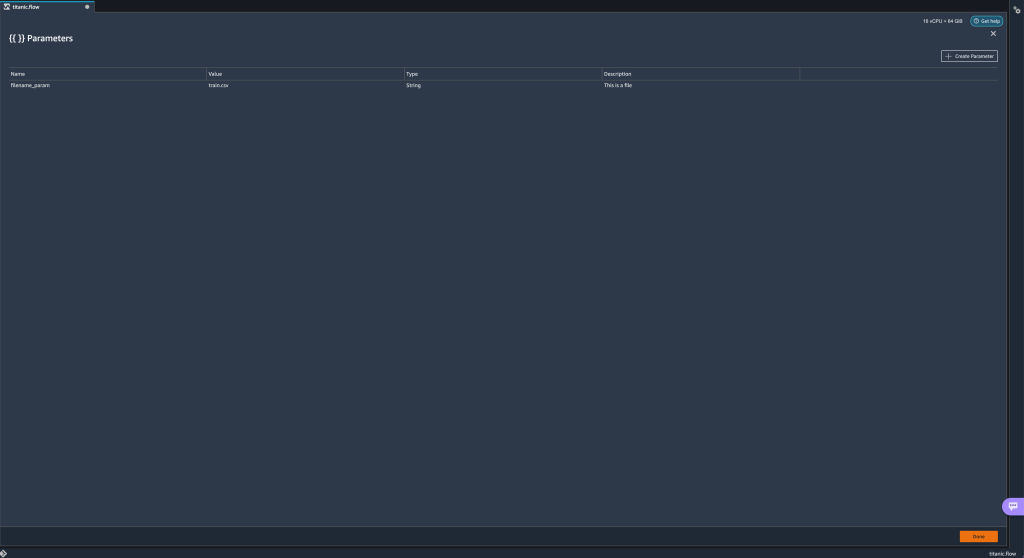

Darüber hinaus können Sie neue Parameter aus der erstellen Parameter UI - Öffnen Sie es, indem Sie das Parametersymbol ({{}}) befindet sich neben dem Go Möglichkeit; beide befinden sich neben dem URI-Pfadwert.

Es öffnet sich eine Tabelle mit allen Parametern, die derzeit in Ihrer Flow-Datei vorhanden sind (

Es öffnet sich eine Tabelle mit allen Parametern, die derzeit in Ihrer Flow-Datei vorhanden sind (filename_paramAn diesem Punkt). - Sie können neue Parameter für Ihren Flow anlegen, indem Sie wählen Parameter erstellen.

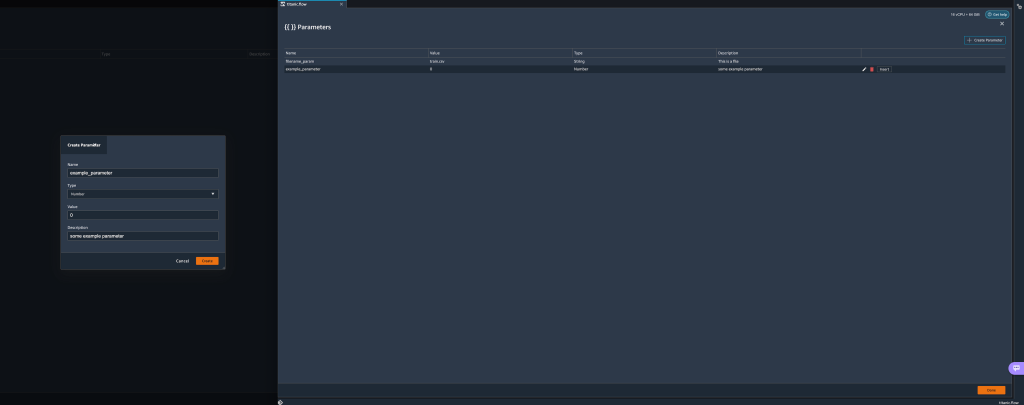

Ein Popup-Fenster wird geöffnet, in dem Sie einen neuen benutzerdefinierten Parameter erstellen können. - Hier haben wir eine neue erstellt

example_parameterals Typ Zahl mit einem Standardwert von 0. Dieser neu erstellte Parameter wird nun in der aufgeführt Parameter Tisch. Wenn Sie den Mauszeiger über den Parameter bewegen, werden die Optionen angezeigt Bearbeiten, Löschen und Insert.

- Aus dem Inneren der Parameter UI können Sie einen Ihrer Parameter in die URI einfügen, indem Sie den gewünschten Parameter auswählen und wählen Insert.

Dadurch wird der Parameter am Ende Ihrer URI hinzugefügt. Sie müssen es in den gewünschten Abschnitt innerhalb Ihres URI verschieben.

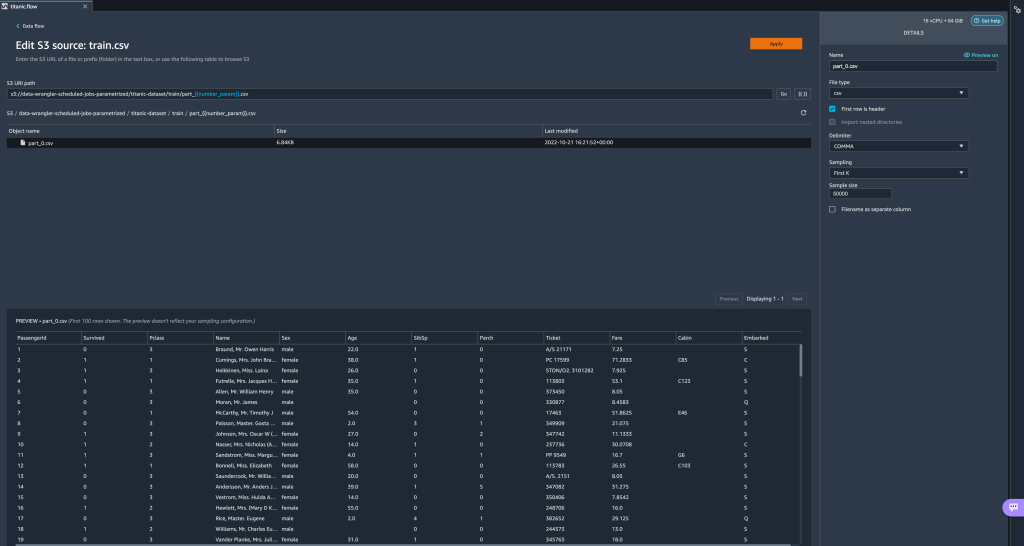

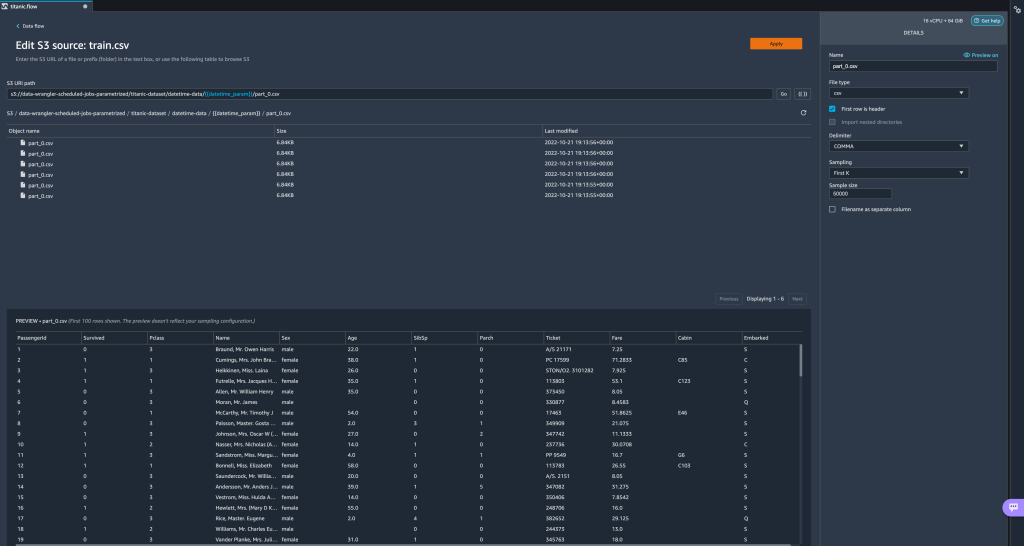

- Ändern Sie den Standardwert des Parameters, übernehmen Sie die Änderung (vom Modal), wählen Sie Go, und wählen Sie das Aktualisierungssymbol aus, um die Vorschauliste mit dem ausgewählten Dataset basierend auf dem Wert des neu definierten Parameters zu aktualisieren.

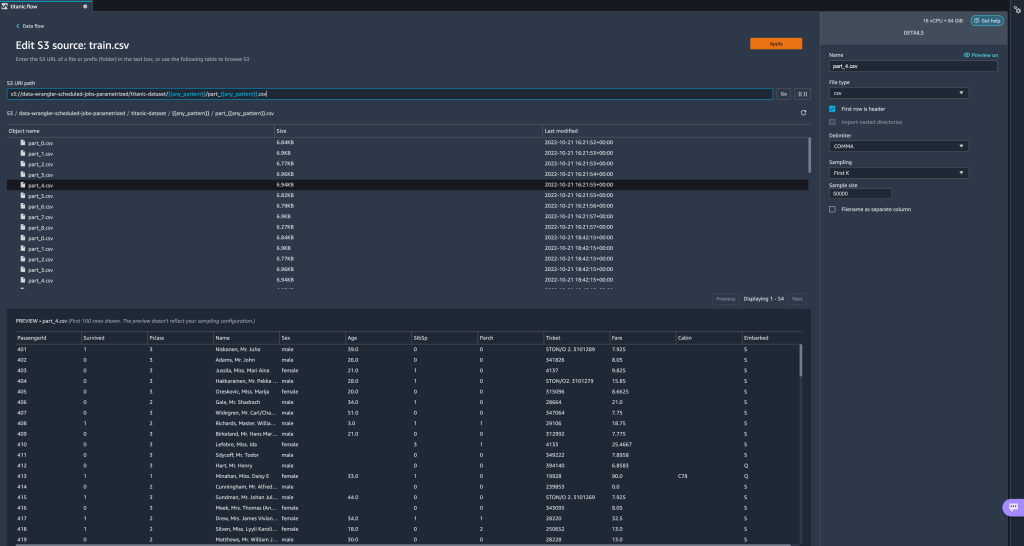

Sehen wir uns nun andere Parametertypen an. Angenommen, wir haben jetzt einen Datensatz, der in mehrere Teile aufgeteilt ist, wobei jede Datei eine Teilenummer hat.

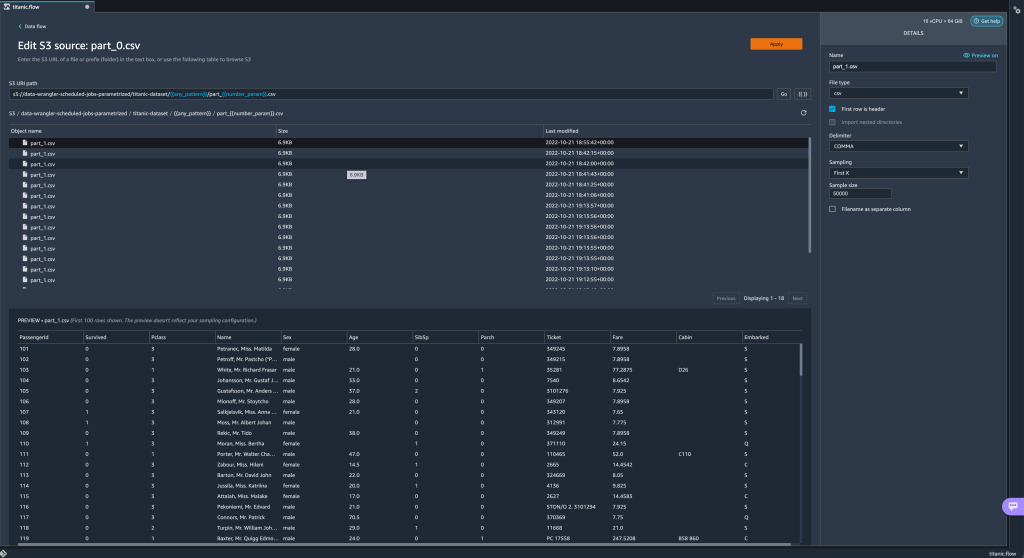

Sehen wir uns nun andere Parametertypen an. Angenommen, wir haben jetzt einen Datensatz, der in mehrere Teile aufgeteilt ist, wobei jede Datei eine Teilenummer hat. - Wenn wir die Dateinummer dynamisch ändern möchten, können wir einen Number-Parameter definieren, wie im folgenden Screenshot gezeigt.

Beachten Sie, dass die ausgewählte Datei diejenige ist, die mit der im Parameter angegebenen Nummer übereinstimmt.

Beachten Sie, dass die ausgewählte Datei diejenige ist, die mit der im Parameter angegebenen Nummer übereinstimmt. Lassen Sie uns nun demonstrieren, wie ein Pattern-Parameter verwendet wird. Angenommen, wir möchten alle importieren

Lassen Sie uns nun demonstrieren, wie ein Pattern-Parameter verwendet wird. Angenommen, wir möchten alle importieren part_1.csvDateien in allen Ordnern unter dertitanic-dataset/Mappe. Musterparameter können jeden gültigen regulären Ausdruck annehmen; Es werden einige Regex-Muster als Beispiele gezeigt. - Erstellen Sie einen Pattern-Parameter namens

any_patternum einen beliebigen Ordner oder eine Datei unter dem abzugleichentitanic-dataset/Ordner mit Standardwert.*.Beachten Sie, dass der Platzhalter kein einzelnes * (Sternchen) ist, sondern auch einen Punkt enthält. - Markieren Sie die

titanic-dataset/Teil des Pfads und erstellen Sie einen benutzerdefinierten Parameter. Diesmal wählen wir die Schnittmuster Art. Dieses Muster wählt alle aufgerufenen Dateien aus

Dieses Muster wählt alle aufgerufenen Dateien aus part-1.csvaus einem der Ordner daruntertitanic-dataset/. Ein Parameter kann mehr als einmal in einem Pfad verwendet werden. Im folgenden Beispiel verwenden wir unseren neu erstellten Parameter

Ein Parameter kann mehr als einmal in einem Pfad verwendet werden. Im folgenden Beispiel verwenden wir unseren neu erstellten Parameter any_patternzweimal in unserem URI, um mit einer der Teildateien in einem der Ordner darunter übereinzustimmentitanic-dataset/. Schließlich erstellen wir einen Datetime-Parameter. Datetime-Parameter sind nützlich, wenn wir es mit Pfaden zu tun haben, die nach Datum und Uhrzeit partitioniert sind, wie die von generierten Amazon Kinesis Data Firehose (sehen Dynamische Partitionierung in Kinesis Data Firehose). Für diese Demonstration verwenden wir die Daten im datetime-data-Ordner.

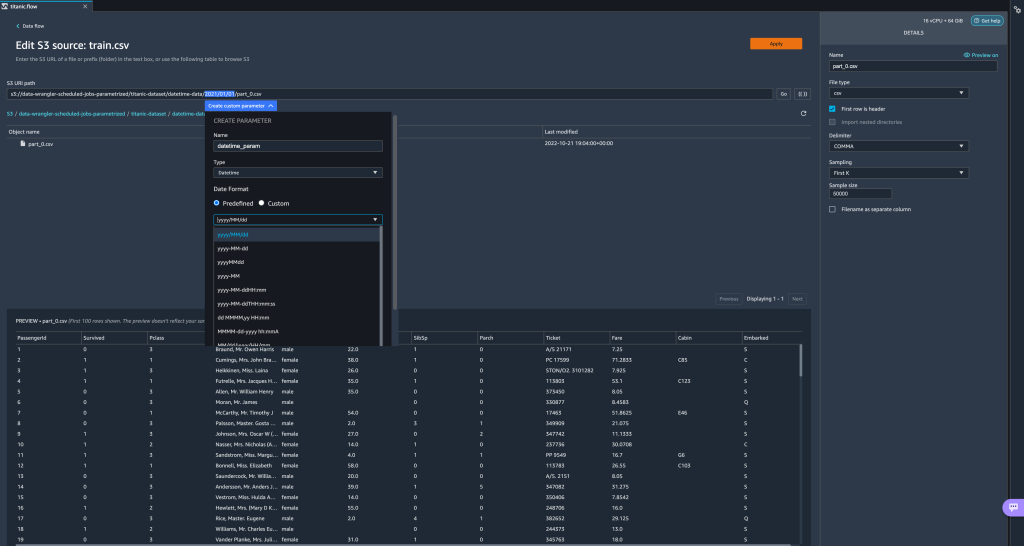

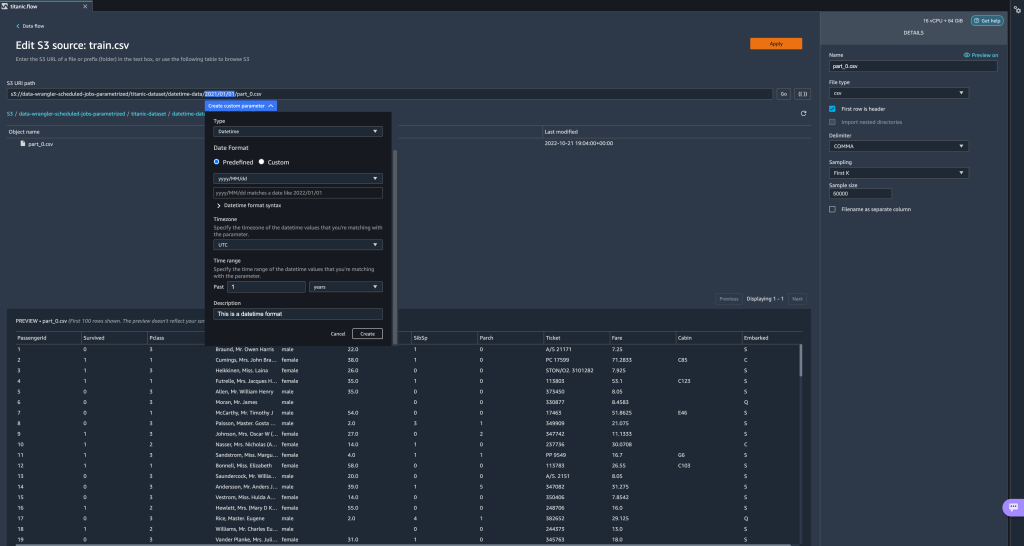

Schließlich erstellen wir einen Datetime-Parameter. Datetime-Parameter sind nützlich, wenn wir es mit Pfaden zu tun haben, die nach Datum und Uhrzeit partitioniert sind, wie die von generierten Amazon Kinesis Data Firehose (sehen Dynamische Partitionierung in Kinesis Data Firehose). Für diese Demonstration verwenden wir die Daten im datetime-data-Ordner. - Wählen Sie den Teil Ihres Pfads aus, der ein Datum/eine Uhrzeit ist, und erstellen Sie einen benutzerdefinierten Parameter. Wählen Sie das Datumzeit Parametertyp.

Wenn Sie den Datetime-Datentyp auswählen, müssen Sie weitere Details eingeben. - Zunächst müssen Sie ein Datumsformat angeben. Sie können eines der vordefinierten Datums-/Uhrzeitformate auswählen oder ein benutzerdefiniertes Format erstellen.

Für die vordefinierten Datums-/Uhrzeitformate bietet die Legende ein Beispiel für ein Datum, das dem ausgewählten Format entspricht. Für diese Demonstration wählen wir das Format jjjj/MM/tt.

- Geben Sie als Nächstes eine Zeitzone für die Datums-/Uhrzeitwerte an.

Beispielsweise kann das aktuelle Datum in einer Zeitzone der 1. Januar 2022 sein, in einer anderen Zeitzone jedoch der 2. Januar 2022. - Schließlich können Sie den Zeitbereich auswählen, mit dem Sie den Bereich der Dateien auswählen können, die Sie in Ihren Datenfluss aufnehmen möchten.

Sie können Ihren Zeitraum in Stunden, Tagen, Wochen, Monaten oder Jahren angeben. Für dieses Beispiel möchten wir alle Dateien des letzten Jahres abrufen. - Geben Sie eine Beschreibung des Parameters ein und wählen Sie aus Erstellen.

Wenn Sie mehrere Datasets mit unterschiedlichen Zeitzonen verwenden, wird die Zeit nicht automatisch konvertiert; Sie müssen jede Datei oder Quelle vorverarbeiten, um sie in eine Zeitzone zu konvertieren. Die ausgewählten Dateien sind alle Dateien in den Ordnern, die den Daten des letzten Jahres entsprechen.

Die ausgewählten Dateien sind alle Dateien in den Ordnern, die den Daten des letzten Jahres entsprechen.

- Wenn wir nun einen Datentransformationsjob erstellen, sehen wir eine Liste aller unserer definierten Parameter und können ihre Standardwerte überschreiben, sodass unsere Transformationsjobs die angegebenen Dateien auswählen.

Planen Sie Verarbeitungsaufträge

Sie können jetzt Verarbeitungsjobs planen, um die Ausführung der Datentransformationsjobs zu automatisieren und Ihre transformierten Daten entweder nach Amazon S3 oder zu exportieren Amazon SageMaker Feature Store. Sie können die Jobs mit der Zeit und Periodizität planen, die Ihren Anforderungen entspricht.

Geplante Verarbeitungsjobs verwenden Amazon EventBridge Ohne eine erfahrene Medienplanung zur Festlegung von Regeln und Strategien beschleunigt der programmatische Medieneinkauf einfach die Rate der verschwenderischen Ausgaben. um die Ausführung des Jobs zu planen. Daher müssen Sie als Voraussetzung dafür sorgen, dass die AWS Identity and Access Management and (IAM)-Rolle, die von Data Wrangler verwendet wird, nämlich die Amazon Sage Maker Ausführungsrolle der Studio-Instanz verfügt über Berechtigungen zum Erstellen von EventBridge-Regeln.

Konfigurieren Sie IAM

Fahren Sie mit den folgenden Aktualisierungen der IAM SageMaker-Ausführungsrolle fort, die der Studio-Instanz entspricht, auf der der Data Wrangler-Flow ausgeführt wird:

- Hänge an AmazonEventBridgeFullAccess verwaltete Richtlinie.

- Hängen Sie eine Richtlinie an, um die Berechtigung zum Erstellen eines Verarbeitungsauftrags zu erteilen:

- Erteilen Sie EventBridge die Berechtigung, die Rolle zu übernehmen, indem Sie die folgende Vertrauensrichtlinie hinzufügen:

Wenn Sie alternativ eine andere Rolle zum Ausführen des Verarbeitungsauftrags verwenden, wenden Sie die in den Schritten 2 und 3 beschriebenen Richtlinien auf diese Rolle an. Einzelheiten zur IAM-Konfiguration finden Sie unter Erstellen Sie einen Zeitplan zur automatischen Verarbeitung neuer Daten.

Erstellen Sie einen Zeitplan

Öffnen Sie zum Erstellen eines Zeitplans Ihren Flow im Data Wrangler-Flow-Editor.

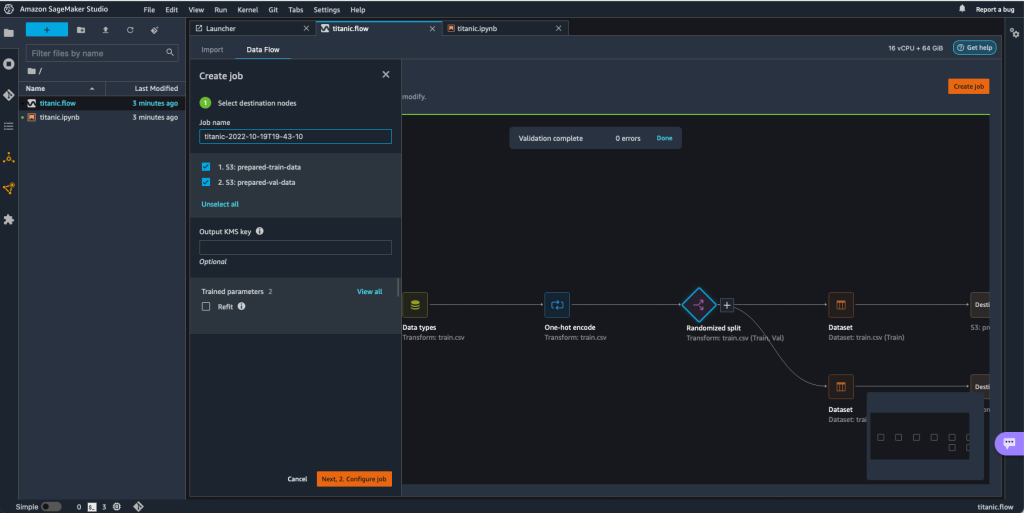

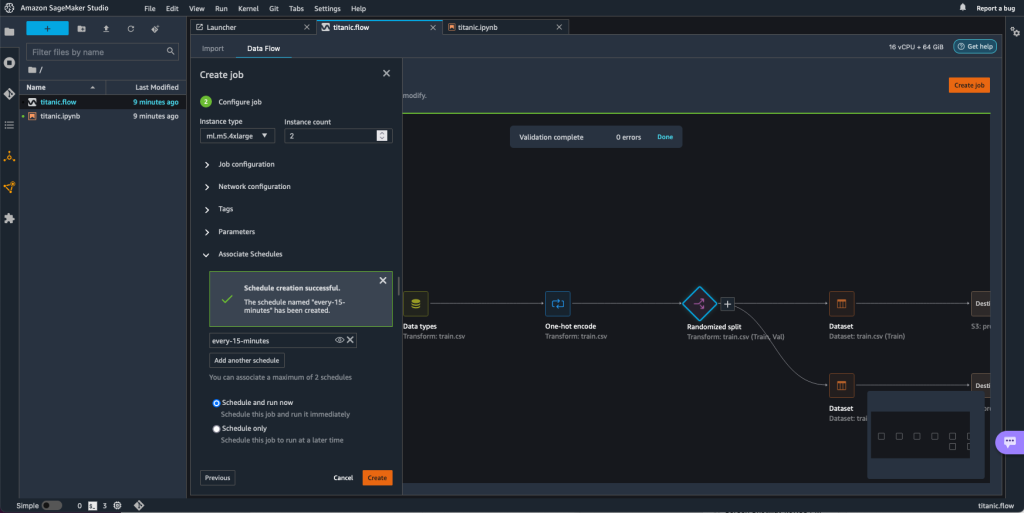

- Auf dem Datenfluss Tab, wählen Sie Job erstellen.

- Konfigurieren Sie die erforderlichen Felder und wählen Sie aus Als nächstes 2. Job konfigurieren.

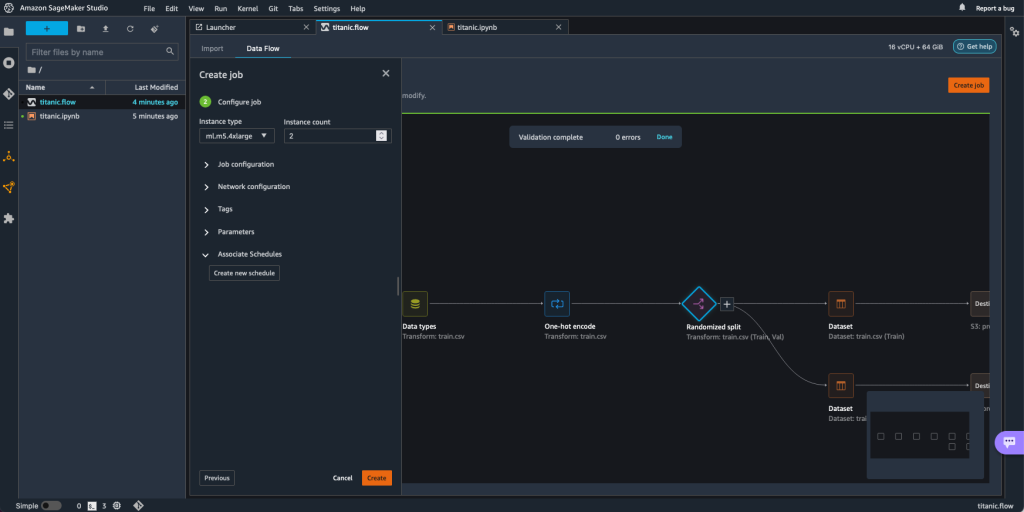

- Erweitern Sie die Funktionalität der Assoziierte Zeitpläne.

- Auswählen

Neuen Zeitplan erstellen.

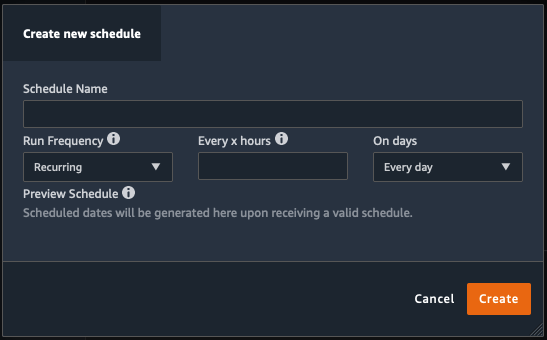

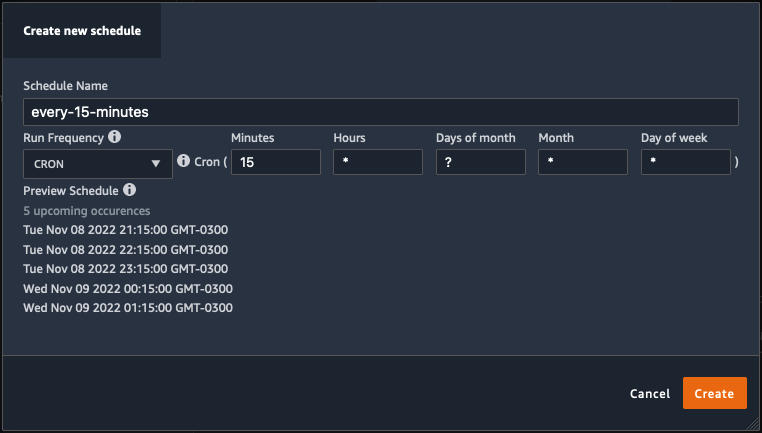

Das Neuen Zeitplan erstellen Es öffnet sich ein Dialog, in dem Sie die Details des Zeitplans für den Verarbeitungsjob definieren.

Der Dialog bietet große Flexibilität, um Ihnen bei der Definition des Zeitplans zu helfen. Sie können den Verarbeitungsjob beispielsweise zu einer bestimmten Zeit oder alle X Stunden an bestimmten Wochentagen ausführen lassen.

Die Periodizität kann bis auf Minutenebene granular sein.

- Definieren Sie den Zeitplannamen und die Periodizität und wählen Sie dann Erstellen um den Zeitplan zu speichern.

- Sie haben die Möglichkeit, den Verarbeitungsjob sofort zusammen mit der Zeitplanung zu starten, die sich um zukünftige Läufe kümmert, oder den Job nur nach Zeitplan laufen zu lassen.

- Sie können auch einen zusätzlichen Zeitplan für denselben Verarbeitungsjob definieren.

- Um die Einplanung des Bearbeitungsjobs abzuschließen, wählen Sie Erstellen.

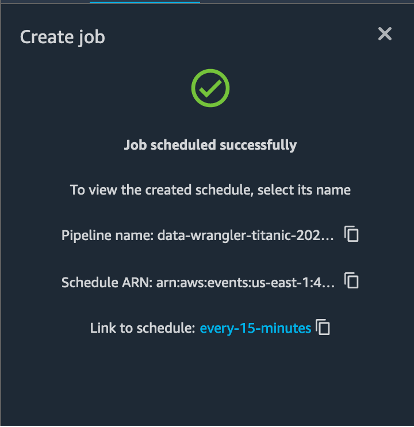

Sie sehen die Meldung „Auftrag erfolgreich geplant“. Wenn Sie sich entschieden haben, den Job nur gemäß dem Zeitplan auszuführen, sehen Sie außerdem einen Link zu der soeben erstellten EventBridge-Regel.

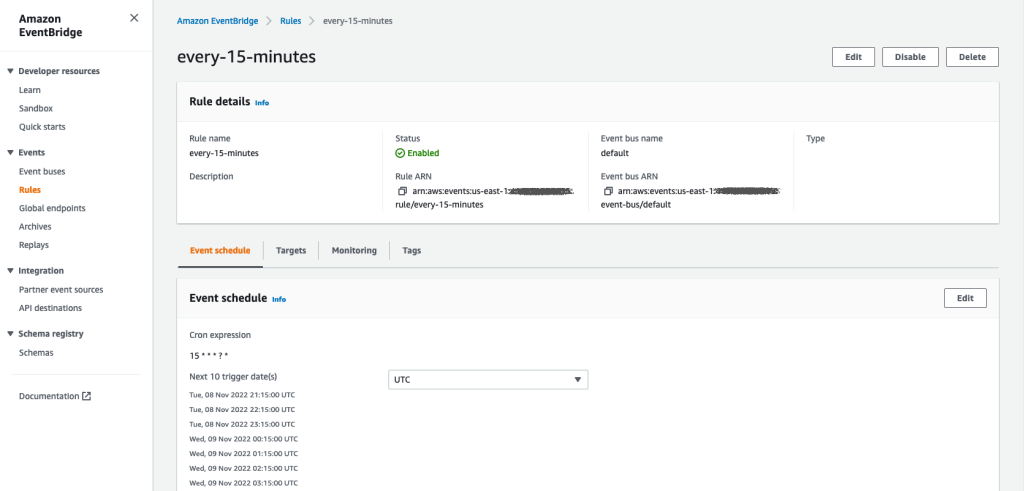

Wenn Sie den Zeitplan-Link wählen, öffnet sich eine neue Registerkarte im Browser, die die EventBridge-Regel anzeigt. Auf dieser Seite können Sie weitere Änderungen an der Regel vornehmen und ihren Aufrufverlauf verfolgen. Um die Ausführung Ihres geplanten Verarbeitungsjobs zu stoppen, löschen Sie die Ereignisregel, die den Zeitplannamen enthält.

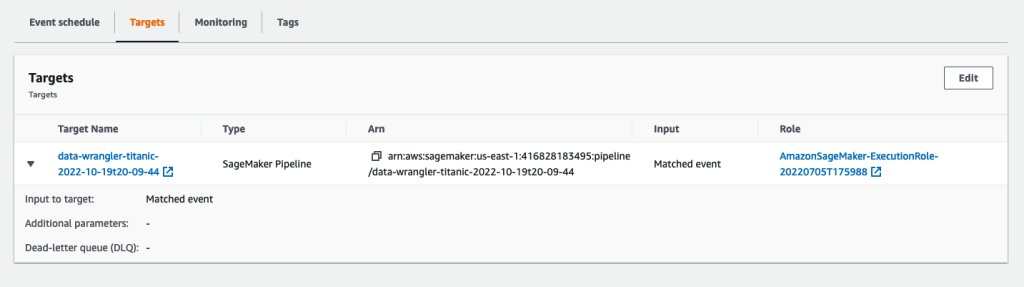

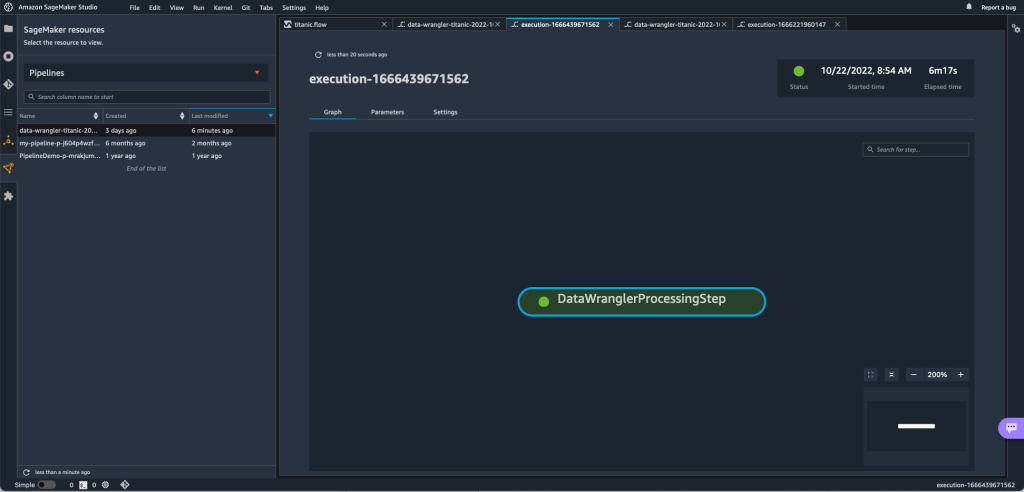

Die EventBridge-Regel zeigt als Ziel eine SageMaker-Pipeline, die gemäß dem definierten Zeitplan ausgelöst wird, und den Verarbeitungsauftrag, der als Teil der Pipeline aufgerufen wird.

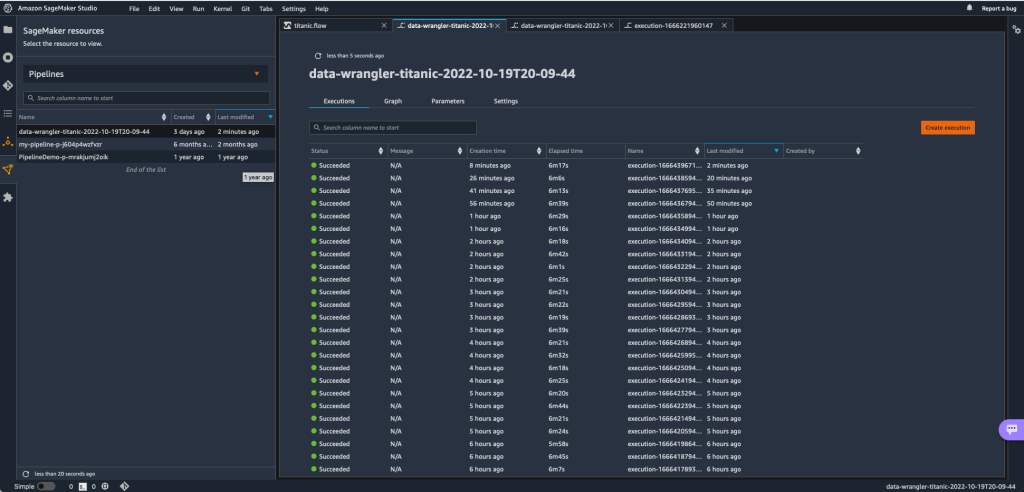

Um die Ausführungen der SageMaker-Pipeline zu verfolgen, können Sie zurück zu Studio gehen, die auswählen SageMaker-Ressourcen Symbol, wählen Sie Pipelines, und wählen Sie den Pipelinenamen aus, den Sie nachverfolgen möchten. Sie können jetzt eine Tabelle mit allen aktuellen und vergangenen Läufen und dem Status dieser Pipeline sehen.

Sie können weitere Details anzeigen, indem Sie auf einen bestimmten Eintrag doppelklicken.

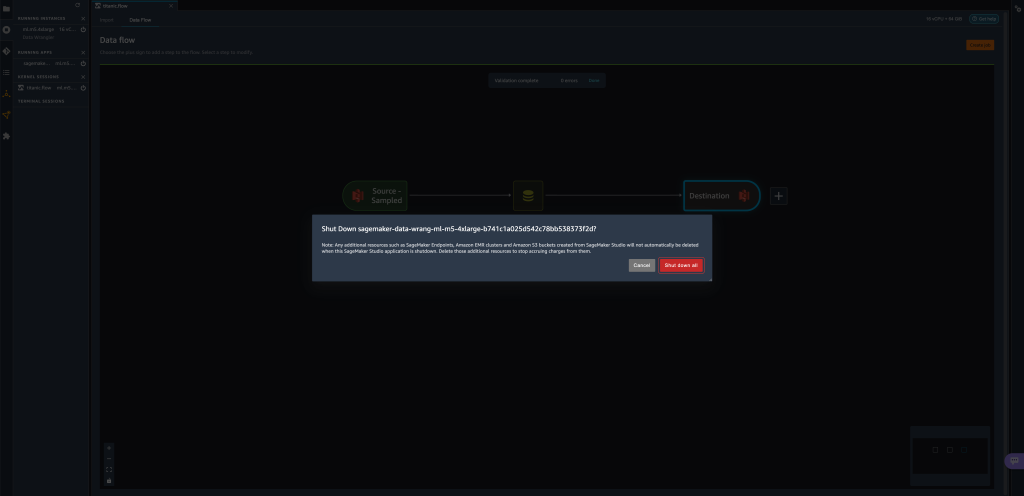

Aufräumen

Wenn Sie Data Wrangler nicht verwenden, wird empfohlen, die Instanz, auf der es ausgeführt wird, herunterzufahren, um zusätzliche Gebühren zu vermeiden.

Um zu vermeiden, dass Arbeit verloren geht, speichern Sie Ihren Datenfluss, bevor Sie Data Wrangler herunterfahren.

- Um Ihren Datenfluss in Studio zu speichern, wählen Sie Reichen Sie das, Dann wählen Data Wrangler-Flow speichern Save. Data Wrangler speichert Ihren Datenfluss automatisch alle 60 Sekunden.

- Um die Data Wrangler-Instanz herunterzufahren, wählen Sie in Studio Ausführen von Instanzen und Kernels.

- Der LAUFENDE APPS, wählen Sie das Symbol zum Herunterfahren neben dem

sagemaker-data-wrangler-1.0App.

- Auswählen

Alles schließen zu bestätigen.

Data Wrangler wird auf einer ml.m5.4xlarge-Instanz ausgeführt. Diese Instanz verschwindet aus LAUFENDE INSTANZEN wenn Sie die Data Wrangler-App schließen.

Nachdem Sie die Data Wrangler-App heruntergefahren haben, muss sie beim nächsten Öffnen einer Data Wrangler-Flussdatei neu gestartet werden. Das kann ein Paar Minuten dauern.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie Sie Parameter verwenden können, um Ihre Datensätze mithilfe von Data Wrangler-Flows zu importieren und darauf Datentransformationsaufträge zu erstellen. Parametrisierte Datasets ermöglichen mehr Flexibilität bei den von Ihnen verwendeten Datasets und ermöglichen Ihnen die Wiederverwendung Ihrer Flows. Wir haben auch gezeigt, wie Sie geplante Jobs einrichten können, um Ihre Datenumwandlungen und -exporte zu entweder Amazon S3 oder Feature Store zu einem Zeitpunkt und in einer Periodizität, die Ihren Anforderungen entspricht, direkt von der Benutzeroberfläche von Data Wrangler aus zu automatisieren.

Weitere Informationen zur Verwendung von Datenflüssen mit Data Wrangler finden Sie unter Erstellen und verwenden Sie einen Data Wrangler-Flow und Amazon SageMaker Preise. Informationen zu den ersten Schritten mit Data Wrangler finden Sie unter Vorbereiten von ML-Daten mit Amazon SageMaker Data Wrangler.

Über die Autoren

David Laredo ist ein Prototyping-Architekt für das Prototyping- und Cloud-Engineering-Team bei Amazon Web Services, wo er an der Entwicklung mehrerer Prototypen für maschinelles Lernen für AWS-Kunden mitgewirkt hat. Er arbeitet seit 6 Jahren im maschinellen Lernen, trainiert und verfeinert ML-Modelle und implementiert End-to-End-Pipelines zur Produktion dieser Modelle. Seine Interessengebiete sind NLP, ML-Anwendungen und End-to-End-ML.

David Laredo ist ein Prototyping-Architekt für das Prototyping- und Cloud-Engineering-Team bei Amazon Web Services, wo er an der Entwicklung mehrerer Prototypen für maschinelles Lernen für AWS-Kunden mitgewirkt hat. Er arbeitet seit 6 Jahren im maschinellen Lernen, trainiert und verfeinert ML-Modelle und implementiert End-to-End-Pipelines zur Produktion dieser Modelle. Seine Interessengebiete sind NLP, ML-Anwendungen und End-to-End-ML.

Givanildo Alves ist ein Prototyping-Architekt im Prototyping- und Cloud-Engineering-Team bei Amazon Web Services, der Kunden hilft, Innovationen zu entwickeln und zu beschleunigen, indem er die Kunst des Möglichen auf AWS zeigt, nachdem er bereits mehrere Prototypen rund um künstliche Intelligenz implementiert hat. Er blickt auf eine lange Karriere im Software Engineering zurück und arbeitete zuvor als Software Development Engineer bei Amazon.com.br.

Givanildo Alves ist ein Prototyping-Architekt im Prototyping- und Cloud-Engineering-Team bei Amazon Web Services, der Kunden hilft, Innovationen zu entwickeln und zu beschleunigen, indem er die Kunst des Möglichen auf AWS zeigt, nachdem er bereits mehrere Prototypen rund um künstliche Intelligenz implementiert hat. Er blickt auf eine lange Karriere im Software Engineering zurück und arbeitete zuvor als Software Development Engineer bei Amazon.com.br.

Adrian Fuentes ist Programmmanager im Prototyping- und Cloud-Engineering-Team bei Amazon Web Services und führt Innovationen für Kunden in den Bereichen maschinelles Lernen, IoT und Blockchain durch. Er verfügt über mehr als 15 Jahre Erfahrung in der Verwaltung und Implementierung von Projekten und 1 Jahr Betriebszugehörigkeit bei AWS.

Adrian Fuentes ist Programmmanager im Prototyping- und Cloud-Engineering-Team bei Amazon Web Services und führt Innovationen für Kunden in den Bereichen maschinelles Lernen, IoT und Blockchain durch. Er verfügt über mehr als 15 Jahre Erfahrung in der Verwaltung und Implementierung von Projekten und 1 Jahr Betriebszugehörigkeit bei AWS.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Machine Learning

- Amazon SageMaker Data Wrangler

- Ankündigungen

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- Datenverarbeitung

- tiefe Lernen

- Google Ai

- Mittel (200)

- Maschinelles Lernen

- Parametrisierte Datensätze

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Geplante Jobs

- Syntax

- Technische Anleitung

- Zephyrnet