Dies ist ein Gastbeitrag, der von Nafi Ahmet Turgut, Hasan Burak Yel und Damla Şentürk von Getir gemeinsam verfasst wurde.

Gegründet in 2015, gebracht hat sich als Vorreiter im Bereich der ultraschnellen Lebensmittellieferung positioniert. Dieses innovative Technologieunternehmen hat mit seinem überzeugenden Angebot an „Lebensmitteln in wenigen Minuten“ das Segment der Zustellung auf der letzten Meile revolutioniert. Mit einer Präsenz in der Türkei, Großbritannien, den Niederlanden, Deutschland und den Vereinigten Staaten hat sich Getir zu einer multinationalen Kraft entwickelt, mit der man rechnen muss. Heute stellt die Marke Getir ein diversifiziertes Konglomerat dar, das neun verschiedene Branchen umfasst, die alle synergetisch unter einem einzigen Dach arbeiten.

In diesem Beitrag erklären wir, wie wir eine End-to-End-Pipeline zur Vorhersage von Produktkategorien aufgebaut haben, um kommerzielle Teams dabei zu unterstützen Amazon Sage Maker und AWS-Charge, wodurch die Modelltrainingsdauer um 90 % verkürzt wird.

Das detaillierte Verständnis unseres bestehenden Produktsortiments ist eine entscheidende Herausforderung, der wir uns wie viele andere Unternehmen im heutigen schnelllebigen und wettbewerbsintensiven Markt stellen müssen. Eine wirksame Lösung für dieses Problem ist die Vorhersage von Produktkategorien. Ein Modell, das einen umfassenden Kategoriebaum generiert, ermöglicht es unseren Vertriebsteams, unser bestehendes Produktportfolio mit dem unserer Wettbewerber zu vergleichen, was uns einen strategischen Vorteil verschafft. Daher besteht unsere zentrale Herausforderung in der Erstellung und Implementierung eines genauen Produktkategorie-Vorhersagemodells.

Wir nutzten die leistungsstarken Tools von AWS, um diese Herausforderung zu bewältigen und uns effektiv im komplexen Bereich des maschinellen Lernens (ML) und der prädiktiven Analyse zurechtzufinden. Unsere Bemühungen führten zur erfolgreichen Erstellung einer End-to-End-Produktkategorie-Vorhersage-Pipeline, die die Stärken von SageMaker und AWS Batch vereint.

Diese Fähigkeit der prädiktiven Analyse, insbesondere der genauen Prognose von Produktkategorien, hat sich als unschätzbar wertvoll erwiesen. Es lieferte unseren Teams wichtige datengesteuerte Erkenntnisse, die das Bestandsmanagement optimierten, die Kundeninteraktionen verbesserten und unsere Marktpräsenz stärkten.

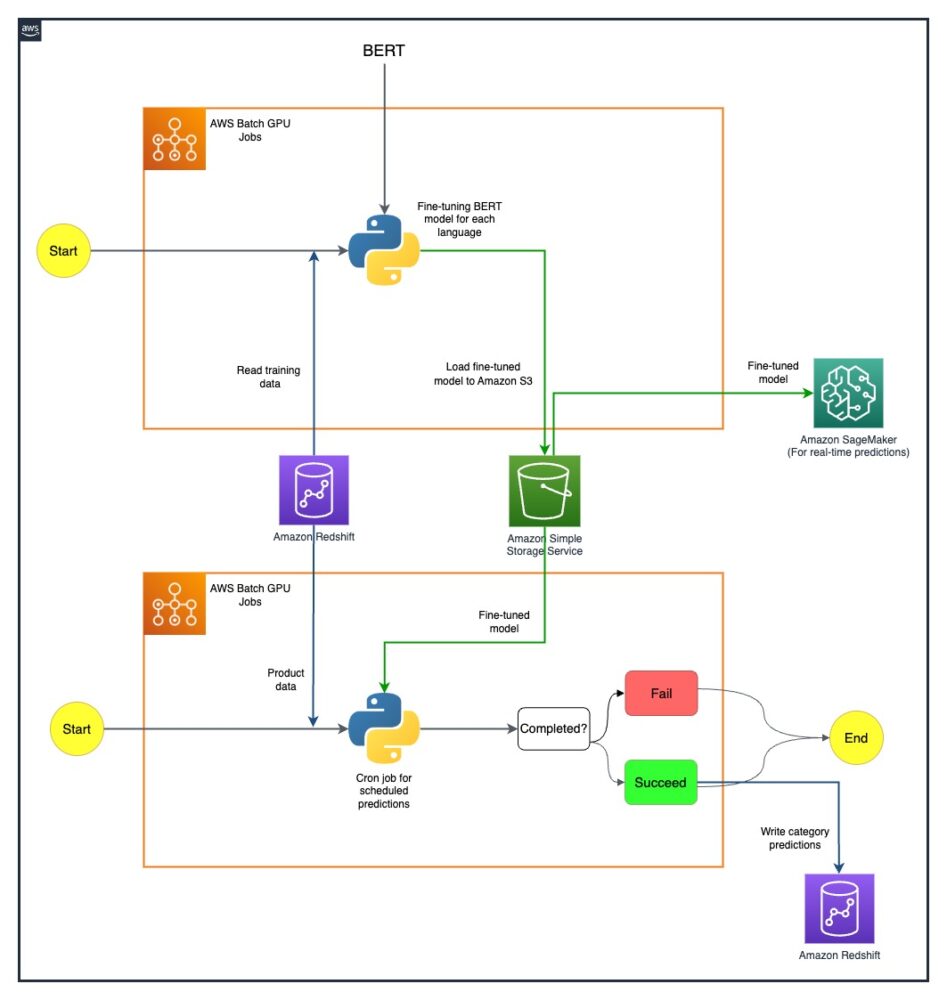

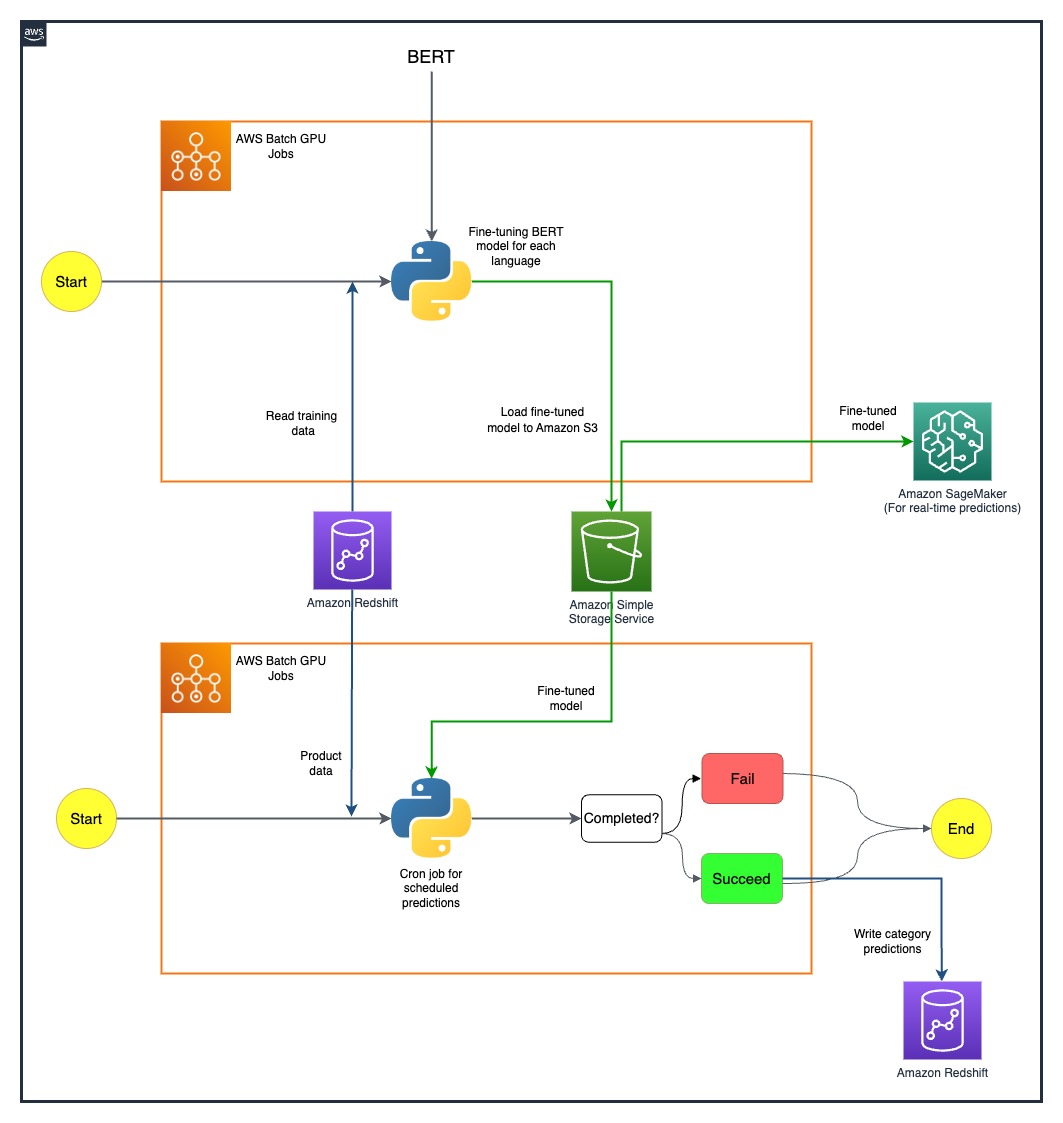

Die Methodik, die wir in diesem Beitrag erläutern, reicht von der Anfangsphase der Erfassung von Feature-Sets bis zur endgültigen Implementierung der Vorhersagepipeline. Ein wichtiger Aspekt unserer Strategie war der Einsatz von SageMaker und AWS Batch zur Verfeinerung vorab trainierter BERT-Modelle für sieben verschiedene Sprachen. Darüber hinaus unsere nahtlose Integration mit dem Objektspeicherservice von AWS Amazon Simple Storage-Service (Amazon S3) war der Schlüssel zur effizienten Speicherung und zum Zugriff auf diese verfeinerten Modelle.

SageMaker ist ein vollständig verwalteter ML-Dienst. Mit SageMaker können Datenwissenschaftler und Entwickler schnell und mühelos ML-Modelle erstellen und trainieren und sie dann direkt in einer produktionsbereiten gehosteten Umgebung bereitstellen.

Als vollständig verwalteter Service unterstützt Sie AWS Batch bei der Ausführung von Batch-Computing-Workloads jeder Größenordnung. AWS Batch stellt Rechenressourcen automatisch bereit und optimiert die Arbeitslastverteilung basierend auf der Menge und dem Umfang der Arbeitslasten. Mit AWS Batch müssen Sie keine Batch-Computing-Software installieren oder verwalten, sodass Sie sich auf die Analyse von Ergebnissen und die Lösung von Problemen konzentrieren können. Wir haben GPU-Jobs verwendet, die uns dabei helfen, Jobs auszuführen, die die GPUs einer Instanz nutzen.

Lösungsübersicht

Fünf Personen aus dem Data-Science-Team und dem Infrastrukturteam von Getir arbeiteten bei diesem Projekt zusammen. Das Projekt wurde innerhalb eines Monats abgeschlossen und nach einer Testwoche in der Produktion bereitgestellt.

Das folgende Diagramm zeigt die Architektur der Lösung.

Die Modellpipeline wird für jedes Land separat betrieben. Die Architektur umfasst zwei AWS Batch GPU-Cronjobs für jedes Land, die nach definierten Zeitplänen ausgeführt werden.

Wir haben einige Herausforderungen durch den strategischen Einsatz von SageMaker- und AWS Batch-GPU-Ressourcen gemeistert. Der Prozess zur Behebung der einzelnen Schwierigkeiten wird in den folgenden Abschnitten detailliert beschrieben.

Feinabstimmung mehrsprachiger BERT-Modelle mit AWS Batch-GPU-Jobs

Wir suchten nach einer Lösung zur Unterstützung mehrerer Sprachen für unsere vielfältige Benutzerbasis. BERT-Modelle waren aufgrund ihrer nachgewiesenen Fähigkeit, komplexe Aufgaben in natürlicher Sprache effektiv zu bewältigen, eine offensichtliche Wahl. Um diese Modelle an unsere Bedürfnisse anzupassen, haben wir die Leistungsfähigkeit von AWS durch die Verwendung von Einzelknoten-GPU-Instanzjobs genutzt. Dies ermöglichte uns die Feinabstimmung vorab trainierter BERT-Modelle für jede der sieben Sprachen, für die wir Unterstützung benötigten. Durch diese Methode stellten wir eine hohe Präzision bei der Vorhersage von Produktkategorien sicher und überwanden mögliche Sprachbarrieren.

Effiziente Modellspeicherung mit Amazon S3

Unser nächster Schritt bestand darin, uns mit der Modellspeicherung und -verwaltung zu befassen. Hierfür haben wir uns für Amazon S3 entschieden, das für seine Skalierbarkeit und Sicherheit bekannt ist. Durch die Speicherung unserer fein abgestimmten BERT-Modelle auf Amazon S3 konnten wir verschiedenen Teams in unserem Unternehmen einfachen Zugriff gewähren und so unseren Bereitstellungsprozess erheblich optimieren. Dies war ein entscheidender Aspekt für die Agilität unserer Abläufe und eine nahtlose Integration unserer ML-Bemühungen.

Erstellen einer End-to-End-Vorhersagepipeline

Um unsere vorab trainierten Modelle optimal nutzen zu können, war eine effiziente Pipeline erforderlich. Wir haben diese Modelle zunächst auf SageMaker bereitgestellt, eine Aktion, die Echtzeitvorhersagen mit geringer Latenz ermöglichte und dadurch unser Benutzererlebnis verbesserte. Für größere Batch-Vorhersagen, die für unseren Betrieb gleichermaßen wichtig waren, nutzten wir AWS Batch GPU-Jobs. Dies gewährleistete eine optimale Nutzung unserer Ressourcen und sorgte für eine perfekte Balance aus Leistung und Effizienz.

Entdecken Sie zukünftige Möglichkeiten mit SageMaker-MMEs

Während wir uns weiterentwickeln und nach Effizienzsteigerungen in unserer ML-Pipeline streben, ist eine Möglichkeit, die wir gerne erkunden möchten, die Verwendung von SageMaker-Multimodell-Endpunkten (MMEs) für die Bereitstellung unserer fein abgestimmten Modelle. Mit MMEs können wir möglicherweise die Bereitstellung verschiedener fein abgestimmter Modelle optimieren und so eine effiziente Modellverwaltung gewährleisten, während wir gleichzeitig von den nativen Funktionen von SageMaker wie Schattenvarianten, automatischer Skalierung usw. profitieren Amazon CloudWatch Integration. Diese Erkundung steht im Einklang mit unserem kontinuierlichen Streben nach der Verbesserung unserer prädiktiven Analysefähigkeiten und der Bereitstellung erstklassiger Erlebnisse für unsere Kunden.

Zusammenfassung

Unsere erfolgreiche Integration von SageMaker und AWS Batch hat nicht nur unsere spezifischen Herausforderungen gemeistert, sondern auch unsere betriebliche Effizienz erheblich gesteigert. Durch die Implementierung einer ausgefeilten Produktkategorie-Vorhersage-Pipeline sind wir in der Lage, unsere Vertriebsteams mit datengesteuerten Erkenntnissen zu versorgen und so eine effektivere Entscheidungsfindung zu ermöglichen.

Unsere Ergebnisse sagen Bände über die Wirksamkeit unseres Ansatzes. Wir haben eine Vorhersagegenauigkeit von 80 % auf allen vier Ebenen der Kategoriegranularität erreicht, was eine wichtige Rolle bei der Gestaltung der Produktsortimente für jedes von uns belieferte Land spielt. Dieses Maß an Präzision erweitert unsere Reichweite über Sprachbarrieren hinaus und stellt sicher, dass wir unsere vielfältige Benutzerbasis mit höchster Genauigkeit bedienen.

Darüber hinaus konnten wir durch den strategischen Einsatz geplanter AWS Batch-GPU-Jobs die Dauer unseres Modelltrainings um 90 % reduzieren. Diese Effizienz hat unsere Prozesse weiter rationalisiert und unsere betriebliche Agilität gestärkt. Die effiziente Modellspeicherung mit Amazon S3 hat bei diesem Erfolg eine entscheidende Rolle gespielt, da sie sowohl Echtzeit- als auch Batch-Vorhersagen in Einklang bringt.

Weitere Informationen zum Einstieg in die Erstellung eigener ML-Pipelines mit SageMaker finden Sie unter Amazon SageMaker-Ressourcen. AWS Batch ist eine ausgezeichnete Option, wenn Sie nach einer kostengünstigen, skalierbaren Lösung für die Ausführung von Batch-Jobs mit geringem Betriebsaufwand suchen. Um zu beginnen, siehe Erste Schritte mit AWS Batch.

Über die Autoren

Nafi Ahmet Turgut schloss sein Masterstudium in Elektrotechnik und Elektronik ab und arbeitete als wissenschaftlicher Mitarbeiter. Sein Schwerpunkt lag auf der Entwicklung von Algorithmen für maschinelles Lernen, um Anomalien nervöser Netzwerke zu simulieren. Er kam 2019 zu Getir und arbeitet derzeit als Senior Data Science & Analytics Manager. Sein Team ist für den Entwurf, die Implementierung und die Wartung von End-to-End-Algorithmen für maschinelles Lernen und datengesteuerten Lösungen für Getir verantwortlich.

Nafi Ahmet Turgut schloss sein Masterstudium in Elektrotechnik und Elektronik ab und arbeitete als wissenschaftlicher Mitarbeiter. Sein Schwerpunkt lag auf der Entwicklung von Algorithmen für maschinelles Lernen, um Anomalien nervöser Netzwerke zu simulieren. Er kam 2019 zu Getir und arbeitet derzeit als Senior Data Science & Analytics Manager. Sein Team ist für den Entwurf, die Implementierung und die Wartung von End-to-End-Algorithmen für maschinelles Lernen und datengesteuerten Lösungen für Getir verantwortlich.

Hasan Burak Yel erhielt seinen Bachelor-Abschluss in Elektrotechnik und Elektronik an der Boğaziçi-Universität. Er arbeitete bei Turkcell und konzentrierte sich hauptsächlich auf Zeitreihenprognosen, Datenvisualisierung und Netzwerkautomatisierung. Er kam 2021 zu Getir und arbeitet derzeit als Data Science & Analytics Manager mit der Verantwortung für die Bereiche Suche, Empfehlung und Wachstum.

Hasan Burak Yel erhielt seinen Bachelor-Abschluss in Elektrotechnik und Elektronik an der Boğaziçi-Universität. Er arbeitete bei Turkcell und konzentrierte sich hauptsächlich auf Zeitreihenprognosen, Datenvisualisierung und Netzwerkautomatisierung. Er kam 2021 zu Getir und arbeitet derzeit als Data Science & Analytics Manager mit der Verantwortung für die Bereiche Suche, Empfehlung und Wachstum.

Damla Şentürk erhielt ihren Bachelor-Abschluss in Computertechnik von der Galatasaray-Universität. Sie setzt ihren Master in Computertechnik an der Boğaziçi-Universität fort. Sie kam 2022 zu Getir und arbeitete als Datenwissenschaftlerin. Sie hat an kommerziellen, Lieferketten- und Entdeckungsprojekten gearbeitet.

Damla Şentürk erhielt ihren Bachelor-Abschluss in Computertechnik von der Galatasaray-Universität. Sie setzt ihren Master in Computertechnik an der Boğaziçi-Universität fort. Sie kam 2022 zu Getir und arbeitete als Datenwissenschaftlerin. Sie hat an kommerziellen, Lieferketten- und Entdeckungsprojekten gearbeitet.

Esra Kayabali ist Senior Solutions Architect bei AWS, spezialisiert auf den Analysebereich, einschließlich Data Warehousing, Data Lakes, Big Data Analytics, Batch- und Echtzeit-Datenstreaming und Datenintegration. Sie verfügt über 12 Jahre Erfahrung in der Softwareentwicklung und Architektur. Ihre Leidenschaft gilt dem Lernen und Lehren von Cloud-Technologien.

Esra Kayabali ist Senior Solutions Architect bei AWS, spezialisiert auf den Analysebereich, einschließlich Data Warehousing, Data Lakes, Big Data Analytics, Batch- und Echtzeit-Datenstreaming und Datenintegration. Sie verfügt über 12 Jahre Erfahrung in der Softwareentwicklung und Architektur. Ihre Leidenschaft gilt dem Lernen und Lehren von Cloud-Technologien.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- :hast

- :Ist

- :nicht

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- Fähigkeit

- Fähig

- Über Uns

- Zugang

- Zugriff

- Genauigkeit

- genau

- erreicht

- Leistung

- Erreichen

- über

- Action

- zusätzlich

- Adresse

- angesprochen

- Vorteil

- Nach der

- gegen

- Algorithmen

- Richtet sich aus

- Alle

- erlaubt

- erlaubt

- entlang

- ebenfalls

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- an

- Analytik

- Analyse

- und

- und Infrastruktur

- Anomalien

- jedem

- Architektur

- SIND

- AS

- Aussehen

- Sortiment

- At

- Auto

- Im Prinzip so, wie Sie es von Google Maps kennen.

- Automation

- Avenue

- AWS

- Balance

- Balancing

- Barrieren

- Base

- basierend

- BE

- werden

- war

- Benchmark

- profitieren

- BESTE

- Beyond

- Big

- Big Data

- Boosted

- beide

- Marke

- bauen

- Building

- erbaut

- Unternehmen

- aber

- by

- CAN

- Fähigkeiten

- capability

- kapitalisiert

- Kategorien

- Kategorie

- sorgen

- Hauptgeschäftsstelle

- Kette

- challenges

- Herausforderungen

- Wahl

- Cloud

- vereint

- kommerziell

- Unternehmen

- zwingend

- wettbewerbsfähig

- Konkurrenz

- Abgeschlossene Verkäufe

- Komplex

- umfassend

- Berechnen

- Computer

- Informationstechnik

- Computing

- Konglomerat

- fortsetzen

- weiter

- kontinuierlich

- Land

- Schaffung

- kritischem

- wichtig

- Zur Zeit

- Kunde

- Kunden

- technische Daten

- Datenanalyse

- Datenwissenschaft

- Datenwissenschaftler

- Datenvisualisierung

- datengesteuerte

- Decision Making

- definiert

- Grad

- Lieferanten

- einsetzen

- Einsatz

- Bereitstellen

- Einsatz

- Entwerfen

- detailliert

- Entwickler

- Entwicklung

- anders

- Schwierigkeit

- Direkt

- Verteilung

- verschieden

- abwechslungsreich

- Domain

- Domains

- zwei

- Dauer

- jeder

- Einfache

- Effektiv

- effektiv

- Wirksamkeit

- Wirkungsgrade

- Effizienz

- effizient

- effizient

- mühelos

- Bemühungen

- Elektronik

- ermächtigen

- freigegeben

- umfassend

- End-to-End

- Entwicklung

- verbesserte

- Eine Verbesserung der

- gesichert

- sorgt

- Gewährleistung

- Arbeitsumfeld

- gleichermaßen

- etablierten

- entwickelt sich

- Ausgezeichnet

- vorhandenen

- ERFAHRUNGEN

- Erfahrungen

- Erklären

- Exploration

- ERKUNDEN

- erweitert

- Gesicht

- erleichtern

- schnelllebig

- Merkmal

- Feld

- Finale

- Vorname

- Setzen Sie mit Achtsamkeit

- konzentriert

- Folgende

- Aussichten für

- Zwingen

- Prognose

- vier

- für

- voll

- weiter

- Zukunft

- Sammlung

- erzeugt

- Deutschland

- bekommen

- GPU

- GPUs

- Abschluss

- Wachstum

- GUEST

- Guest Post

- Griff

- Haben

- he

- Hilfe

- hilft

- hier (auf dänisch)

- GUTE

- seine

- gehostet

- Ultraschall

- Hilfe

- HTML

- http

- HTTPS

- if

- Implementierung

- Umsetzung

- wichtig

- wichtiger Aspekt

- in

- Dazu gehören

- Einschließlich

- Information

- Infrastruktur

- Anfangs-

- innovativ

- Einblicke

- installieren

- Instanz

- Integration

- Interaktionen

- in

- unschätzbar

- Inventar

- Bestandsverwaltung

- IT

- SEINE

- selbst

- Jobs

- beigetreten

- jpg

- Scharf

- Wesentliche

- bekannt

- Seen

- Sprache

- Sprachen

- Latency

- lernen

- geführt

- Niveau

- Cholesterinspiegel

- Gefällt mir

- suchen

- Sneaker

- kostengünstig

- Maschine

- Maschinelles Lernen

- hauptsächlich

- Aufrechterhaltung

- um

- verwalten

- verwaltet

- Management

- Manager

- Weise

- viele

- Markt

- Meister

- Methode

- Methodik

- Minuten

- ML

- Modell

- für

- Monat

- mehr

- multinationalen

- mehrere

- nativen

- Natürliche

- Navigieren

- Need

- Bedürfnisse

- Niederlande

- Netzwerk

- weiter

- neun

- nicht

- Objekt

- offensichtlich

- of

- bieten

- on

- EINEM

- einzige

- Betriebs-

- Einkauf & Prozesse

- optimal

- optimiert

- Verbessert

- Option

- or

- Auftrag

- Organisation

- UNSERE

- Überwindung

- besitzen

- besonders

- leidenschaftlich

- Personen

- perfekt

- Leistung

- Phase

- Pipeline

- Plato

- Datenintelligenz von Plato

- PlatoData

- gespielt

- spielt

- Mappe

- positioniert

- Möglichkeiten

- Post

- Potenzial

- möglicherweise

- Werkzeuge

- größte treibende

- Präzision

- Vorhersage

- Prognose

- Prognosen

- Vorausschauende Analytik

- Präsenz

- Aufgabenstellung:

- Probleme

- Prozessdefinierung

- anpassen

- Produkt

- Produktion

- Projekt

- Projekte

- zuverlässig

- die

- vorausgesetzt

- Bereitstellung

- Verfolgung

- Menge

- schnell

- Bereiche

- erreichen

- Echtzeit

- Echtzeitdaten

- Received

- Software Empfehlungen

- Veteran

- Reduziert

- Reduzierung

- verfeinern

- raffiniert

- representiert

- falls angefordert

- Forschungsprojekte

- Downloads

- Verantwortung

- für ihren Verlust verantwortlich.

- Die Ergebnisse

- revolutioniert

- Rollen

- Führen Sie

- Laufen

- sagemaker

- Skalierbarkeit

- skalierbaren

- Skalieren

- Skalierung

- vorgesehen

- Wissenschaft

- Wissenschaftler

- Wissenschaftler

- nahtlos

- Suche

- Abschnitte

- Sicherheitdienst

- sehen

- Suchen

- Segment

- ausgewählt

- Senior

- Modellreihe

- brauchen

- Lösungen

- kompensieren

- sieben

- Shadow

- Gestaltung

- sie

- Konzerte

- bedeutend

- Einfacher

- Singular

- So

- Software

- Software-Entwicklung

- Lösung

- Lösungen

- Auflösung

- einige

- anspruchsvoll

- gesucht

- sprechen

- spezialisiert

- spezifisch

- begonnen

- Staaten

- Schritt

- Lagerung

- Speicherung

- Strategisch

- Strategisch

- Strategie

- Streaming

- rationalisieren

- gestrafft

- Rationalisierung

- gestärkt

- Stärken

- erfolgreich

- Oberteil

- liefern

- Supply Chain

- Support

- angehen

- Tailor

- und Aufgaben

- Einführungen

- Team

- Teams

- Tech

- Technologieunternehmen

- Technologies

- Testen

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Niederlande

- Großbritannien

- ihr

- Sie

- dann

- damit

- deswegen

- Diese

- fehlen uns die Worte.

- Durch

- Zeit

- Zeitfolgen

- zu

- heute

- heutigen

- gemeinsam

- Werkzeuge

- Wegbereiter

- Training

- Ausbildung

- Baum

- Türkei

- XNUMX

- Uk

- Regenschirm

- für

- Vereinigt

- USA

- Universität

- us

- -

- benutzt

- Mitglied

- Benutzererfahrung

- Verwendung von

- seit

- das Äußerste

- verschiedene

- Vertikalen

- Visualisierung

- lebenswichtig

- Volumen

- wurde

- we

- Netz

- Web-Services

- Woche

- waren

- welche

- während

- mit

- .

- gearbeitet

- arbeiten,

- Werk

- Jahr

- Du

- Ihr

- Zephyrnet