Yara ist das weltweit führende Unternehmen für Pflanzenernährung und ein Anbieter von Umwelt- und Landwirtschaftslösungen. Yaras Ambition konzentriert sich auf den Aufbau einer naturbelassenen Ernährungszukunft, die Wert für Kunden, Aktionäre und die Gesellschaft insgesamt schafft und eine nachhaltigere Wertschöpfungskette für Lebensmittel liefert. Yara unterstützt unsere Vision einer Welt ohne Hunger und eines respektierten Planeten und verfolgt eine Strategie des nachhaltigen Wertwachstums, der Förderung einer klimafreundlichen Pflanzenernährung und emissionsfreier Energielösungen. Yara ist auch der weltweit größte Produzent von Ammoniak, Nitraten und NPK Düngemittel. Ihr Produktionssegment ist daher ein integraler Baustein für die Erfüllung ihrer Mission – mit dem klaren Ziel, weltweit führend in Bezug auf Kennzahlen wie Sicherheit, Umweltbelastung, Qualität und Produktionskosten zu werden. Das langfristige Ziel von Yara ist die „Anlage der Zukunft“ mit null Emissionen und niedrigen Kosten.

Aufbauend auf einer Lean-Transformation verstärkt Yara seinen Fokus auf digitale Lösungen, um ihm zu helfen, seine Ambitionen zu erreichen. Um diese Bemühungen zu leiten, gründete Yara eine globale Einheit namens Digital Production. Der Erfolg der digitalen Produktion und ihrer Lösungen hat für Yara höchste Priorität, und Yara hat seine Bemühungen in diesem Bereich erheblich ausgebaut. Ein entscheidender Schwerpunktbereich ist die Nutzung der riesigen Datenmenge, die im Rahmen ihrer Geschäftstätigkeit generiert wird. Daher baut Yara datengesteuerte Produkte, die ihnen helfen, die Produktion zu optimieren, die Qualität der Produkte zu steigern, die Zuverlässigkeit von Produktionsstätten zu erhöhen, Emissionen zu reduzieren, die Sicherheit und Produktivität von Arbeitern zu erhöhen, manuelle Prozesse zu automatisieren und vieles mehr.

Energie ist für viele Produktionsanlagen ein wesentlicher Kostenfaktor; Daher hat die Energieeffizienz einen erheblichen Einfluss auf die Rentabilität. Allerdings fehlt es oft an handfesten Referenzen, wie gute Leistung aussieht und wie man dorthin kommt. Die Energielastkurve (ELC) von Yara ist eine Lösung, die die beste historische Leistung beim Energieverbrauch im Vergleich zur aktuellen Leistung nutzt. Weicht der aktuelle Verbrauch zu stark vom historischen Bestwert ab, gibt das Tool den Betreibern Empfehlungen, um den Energieverbrauch zu steuern.

Um ELC in Produktionsanlagen bereitzustellen und es auf mehrere Standorte auf der ganzen Welt zu skalieren, musste Yara eine MLOps-Plattform aufbauen. Dies würde sicherstellen, dass Yara Modelle zuverlässig und effizient trainiert, bereitstellt und wartet. Um dies auf mehrere Standorte zu skalieren, musste Yara außerdem die Bereitstellungs- und Wartungsprozesse automatisieren. In diesem Beitrag diskutieren wir, wie Yara verwendet wird Amazon Sage Maker Funktionen, einschließlich der Modellregistrierung, Amazon SageMaker-Modellmonitor und Amazon SageMaker-Pipelines Optimierung des Lebenszyklus des maschinellen Lernens (ML) durch Automatisierung und Standardisierung von MLOps-Praktiken. Wir geben einen Überblick über die Einrichtung und zeigen den Prozess des Erstellens, Trainierens, Bereitstellens und Überwachens von ML-Modellen für Anlagen auf der ganzen Welt.

Lösungsübersicht

ELC nutzt Internet of Things (IoT) Sensordaten einer Anlage. Diese Sensoren messen Metriken wie Produktionsdurchsatz, Umgebungsbedingungen und Rohmaterialbedingungen usw. Diese Daten werden verwendet, um ein Energievorhersagemodell zu trainieren, das dann verwendet wird, um stündliche Vorhersagen zu generieren. Anlagenbetreiber überwachen den tatsächlichen Energieverbrauch und vergleichen ihn mit dem von ELC prognostizierten optimalen Verbrauch. Wenn der aktuelle Energieverbrauch zu stark vom optimalen Punkt abweicht, bietet ELC eine Aktion zur Anpassung interner Prozessvariablen, um die Energieeffizienz basierend auf analytischen Modellen zu optimieren.

ELC wird in der Cloud gehostet. Um Sensordaten einer Anlage in Echtzeit zu streamen, nutzt Yara AWS IoT Greengrass um sicher zu kommunizieren AWS IoT-Kern und IoT-Daten in die AWS-Cloud exportieren. AWS IoT SiteWise ist ein Managed Service, der Gerätedaten von Industrieanlagen in großem Umfang sammeln, organisieren, suchen und nutzen kann. Yara hat APIs mit erstellt Amazon API-Gateway um die Sensordaten Anwendungen wie ELC zugänglich zu machen.

Das ELC-Anwendungs-Backend wird über Amazon ECS bereitgestellt und betreibt ELC-Dashboards am Frontend, die von Anlagenbetreibern verwendet werden. Die ELC-Anwendung ist dafür verantwortlich, den Anlagenbetreibern stündliche Vorhersagewerte für den Energieverbrauch bereitzustellen. Jede Anlage ist mit einem eigenen Modell ausgestattet, da ihre Energieverbrauchscharakteristika unterschiedlich sind. Darüber hinaus werden Werke basierend auf ihrem Standort in verschiedene AWS-Regionen geclustert.

Das folgende Diagramm veranschaulicht diese Architektur.

Für den Aufbau von ELC und die Skalierung auf mehrere Anlagen benötigten wir eine MLOps-Lösung, die Folgendes unterstützt:

- Skalierbarkeit – Es kann entsprechend dem Datenvolumen skaliert werden. Einige Anlagen produzieren mehr Daten als andere; Jede Anlage kann mehrere Gigabyte Daten pro Tag produzieren.

- Erweiterbarkeit – Es kann in neuen Regionen und Konten bereitgestellt werden.

- Wiederholbarkeit – Es hat gemeinsame Vorlagen, die wir verwenden können, um eine neue Anlage an Bord zu nehmen.

- Flexibilität – Es kann die Bereitstellungskonfiguration basierend auf den Anforderungen jeder Anlage ändern.

- Zuverlässigkeit und Überwachung – Es kann Tests durchführen und hat einen klaren Einblick in den Status aller aktiven Anlagen. Im Fehlerfall kann es zum vorherigen stabilen Zustand zurückkehren.

- Wartung – Die Lösung sollte einen geringen Wartungsaufwand haben. Es sollte nach Möglichkeit serverlose Dienste verwenden, um den Platzbedarf der Infrastruktur zu reduzieren.

Für ML entschied sich Yara für SageMaker. SageMaker ist ein vollständig verwalteter Dienst, der den gesamten ML-Workflow abdeckt. Die folgenden Funktionen waren ausschlaggebend für die Auswahl von SageMaker:

- SageMaker-Framework-Container – Yara hatte ELC-Vorhersagemodelle auf TensorFlow trainiert, und mit SageMaker-Framework-Containern konnte Yara diese Modelle mit minimalen Codeänderungen in SageMaker übertragen und verschieben.

- SageMaker-Pipelines – SageMaker-Pipelines bieten eine Python-Schnittstelle für Data Scientists zum Schreiben von ML-Pipelines. Ein großer Teil des ELC-Codes besteht aus einer Trainings- und einer Inferenzpipeline, die in Python definiert sind.

- SageMaker-Modellregistrierung – Die SageMaker-Modellregistrierung ermöglicht die Katalogisierung und Versionskontrolle von Modellen. Darüber hinaus erleichtert es die Verwaltung von Modellmetadaten, wie z. B. Trainingsmetriken.

- SageMaker Modellmonitor – Yara wollte die Qualität und Verteilung der eingehenden Daten sowie die Leistung des ELC-Modells überwachen. SageMaker Model Monitor APIs bieten Daten- und Modellqualitätsüberwachung.

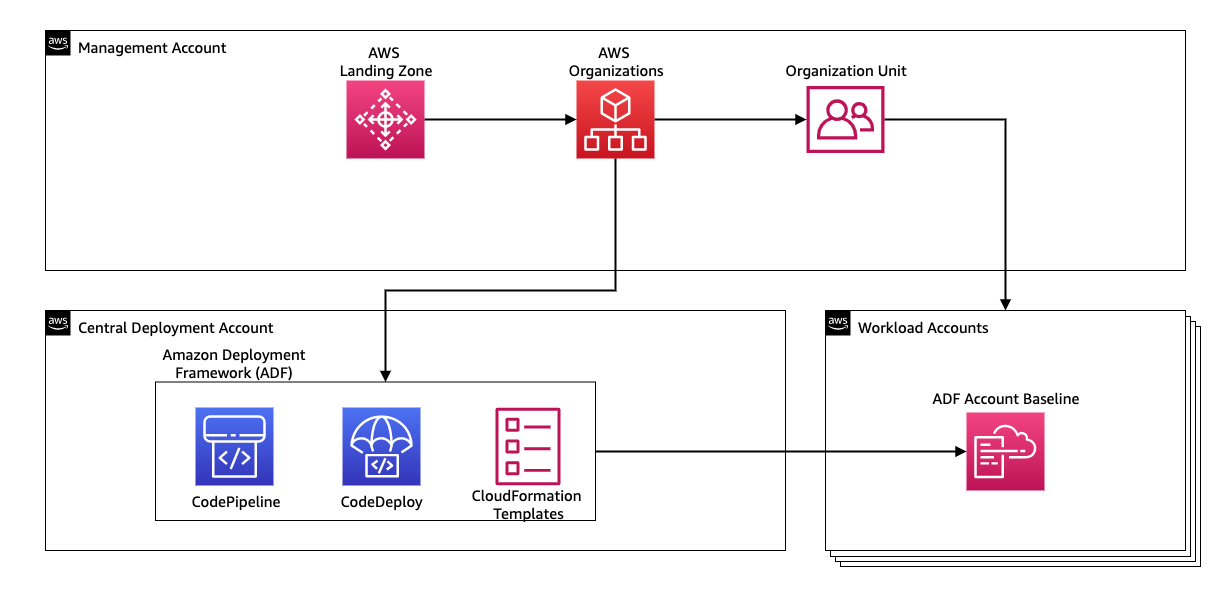

Zur Verwaltung der kontinuierlichen Integration und kontinuierlichen Bereitstellung (CI/CD) für die ML-Pipelines verwendet Yara Amazon-Bereitstellungs-Framework (ADF). ADF ist ein Open-Source-Framework, das von AWS entwickelt wurde, um Ressourcen über mehrere AWS-Konten und -Regionen innerhalb einer AWS-Organisation hinweg zu verwalten und bereitzustellen. ADF ermöglicht gestaffelte, parallele, kontenübergreifende und regionsübergreifende Bereitstellungen von Anwendungen oder Ressourcen über die in definierte Struktur AWS-Organisationen, während Sie Dienste wie z AWS CodePipeline, AWS CodeBuild, AWS-CodeCommit und AWS CloudFormation um das schwere Heben und Verwalten im Vergleich zu einem herkömmlichen CI/CD-Setup zu erleichtern.

Lösungsüberblick

Die gesamte Lösung für die MLOps-Plattform wurde innerhalb von zwei Monaten in Zusammenarbeit mit erstellt Professionelle AWS-Services. Das an dem Projekt arbeitende Team bestand aus Data Scientists, Data Engineers und DevOps-Spezialisten. Um eine schnellere Entwicklung in einer Umgebung mit mehreren Teams zu ermöglichen, entschied sich Yara für die Verwendung AWS-Landung Zone und Organisationen, um verschiedene AWS-Konten zentral zu erstellen, zu verwalten und zu steuern. Beispielsweise verfügt Yara über ein zentrales Bereitstellungskonto und verwendet Workload-Konten zum Hosten von Geschäftsanwendungen. ELC ist ein Anwendungsfall für die Prozessoptimierung und wird eingesetzt, um Workload-Konten zu optimieren. Das Team von Yara Digital Production arbeitet auch an ML-Anwendungsfällen in anderen Bereichen als der Optimierung. Das MLOps-Framework unterstützt die Bereitstellung für alle Workload-Konten, solange die Konten über Organisationen erstellt werden.

Das folgende Diagramm veranschaulicht diese Architektur.

Die Verwendung eines zentralen Bereitstellungskontos erleichtert die Verwaltung gemeinsamer Artefakte und CI/CD-Pipelines. In Bezug auf die Zugriffsverwaltung und Sicherheit dieser gemeinsamen Artefakte ist es ein einfacheres Design, da Berechtigungsgrenzen und Verschlüsselungsschlüssel zentral an einem Ort verwaltet werden. In den folgenden Abschnitten führen wir Sie durch die Schritte, die erforderlich sind, um einen neuen Anwendungsfall in die MLOps-Plattform von Yara zu integrieren.

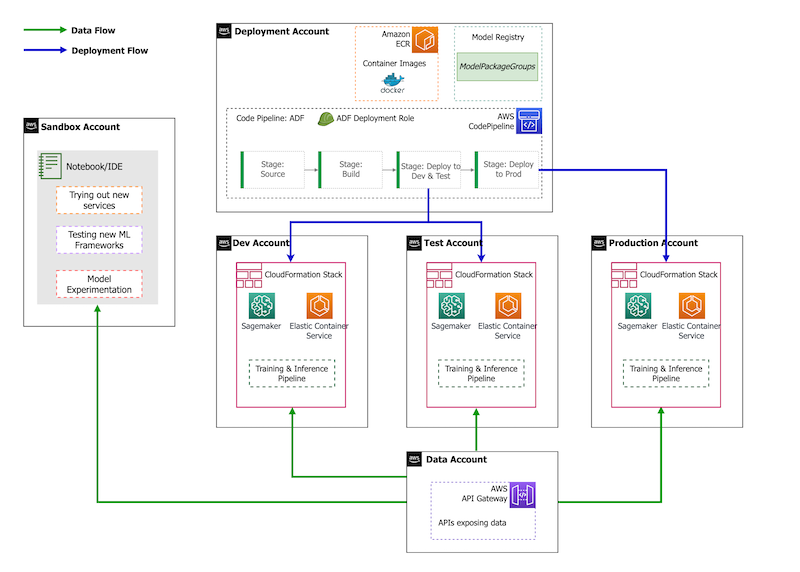

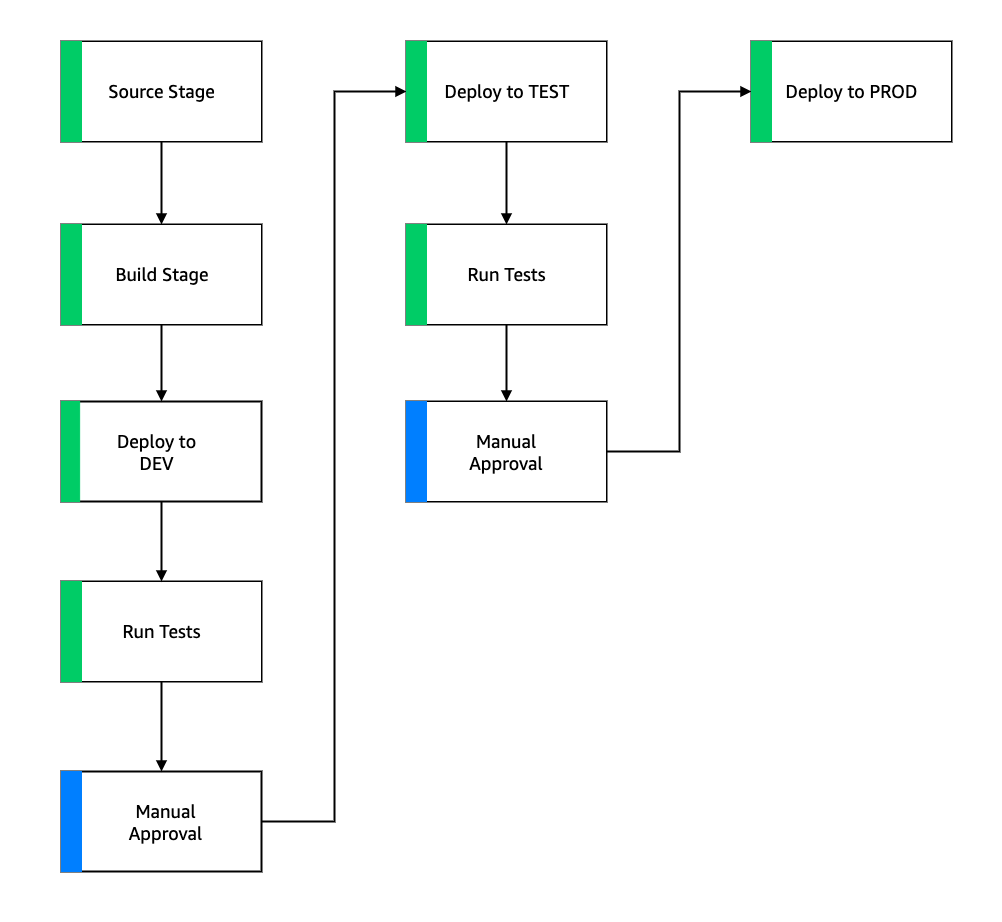

In Bezug auf die Kontostrategie verfügt Yara über eine Sandbox-, DEV-, TEST- und PROD-Einrichtung. Das Sandbox-Konto dient zum Experimentieren und Ausprobieren neuer Ideen. Das DEV-Konto ist der Ausgangspunkt der CI/CD-Pipelines, und die gesamte Entwicklung beginnt hier. Das Bereitstellungskonto enthält die CI/CD-Pipelinedefinition und kann für die Konten DEV, TEST und PROD bereitgestellt werden. Diese Kontoeinrichtung ist in der folgenden Abbildung dargestellt.

Onboarding eines neuen Anwendungsfalls

Für diesen Beitrag gehen wir davon aus, dass wir einen funktionierenden Prototyp eines Anwendungsfalls haben, den wir nun operationalisieren wollen. Falls dieser Anwendungsfall zu einem neuen Produktbereich gehört, müssen wir zuerst die Konten mithilfe von Organisationen bereitstellen, wodurch ADF automatisch ausgelöst wird, um diese Konten für die Bereitstellung zu booten. Yara verfolgt eine Kontostrategie DEV>TEST>PROD; Diese Konfiguration ist jedoch nicht obligatorisch. Datenkonten legen APIs für den Datenzugriff offen, und für einen neuen Anwendungsfall müssen Rollen die erforderlichen zugewiesen werden AWS Identity and Access Management and (IAM)-Berechtigungen, damit sie auf die Daten-APIs zugreifen können.

Als Nächstes müssen wir definieren, für welche Konten dieser Anwendungsfall bereitgestellt wird. Dies erfolgt mithilfe einer Bereitstellungskarte in ADF. Die Bereitstellungszuordnung ist eine Konfigurationsdatei, die die Zuordnung von Stufen und Zielen für die Pipeline enthält. Zum Ausführen der Bereitstellungszuordnung verwendet ADF CodePipeline. ADF bietet die Flexibilität, Parameter pro Zielumgebung zu verwalten, in der der Stack bereitgestellt wird. Dies erleichtert die Verwaltung von Bereitstellungen und das Testen mit kleineren Instanzen.

Zum Verschlüsseln aller Artefakte wie Code, Daten und Modelldateien generieren wir eine AWS-Schlüsselverwaltungsservice (AWS KMS)-Schlüssel. Sie können auch serverseitige Verschlüsselung verwenden. Da auf einige der generierten Artefakte jedoch kontenübergreifend zugegriffen wird, müssen wir unseren eigenen Schlüssel generieren und seine Berechtigungsrichtlinien verwalten, um kontenübergreifenden Zugriff zu gewähren.

Schließlich müssen wir eine Modellpaketgruppe erstellen, um verschiedene Versionen eines Modells mithilfe der SageMaker-Modellregistrierung zu gruppieren. Dies ist die SageMaker-Funktion zum Verfolgen und Verwalten von Modellen, während sie sich durch den ML-Lebenszyklus bewegen.

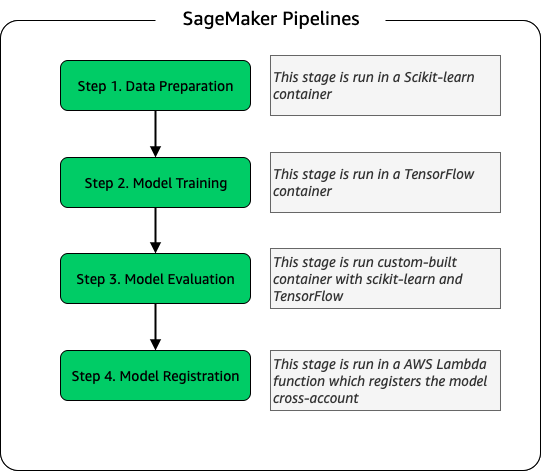

Modellieren Sie die Trainingspipeline

Für jede neue Anlage, die für ELC an Bord genommen wird, erstellen wir eine neue SageMaker-Schulungspipeline. Diese Pipeline besteht aus Datenvorverarbeitungs- und Modelltrainingsschritten. SageMaker-Pipelines passen gut zu Yara, da sie eine Python-Schnittstelle zum Definieren eines ML-Workflows bieten. Darüber hinaus können verschiedene Schritte des Workflows so konfiguriert werden, dass sie unterschiedlich skalieren. Sie können zum Beispiel eine viel größere Instanz für das Training definieren als für den Modellbewertungsschritt. Eingabe- und Ausgabeparameter für jeden Schritt der Pipeline werden gespeichert, was es einfach macht, jeden Lauf und seine Ausgaben zu verfolgen. Der grobe Überblick über den Schulungsworkflow lautet wie folgt.

Als Teil der Modellbewertungsphase wird ein Bewertungsdatensatz verwendet, um Metriken wie Genauigkeit und Abweichung des quadratischen Mittelwerts (RMSE) für das trainierte Modell zu generieren. Diese Metriken werden den Modellmetadaten hinzugefügt, bevor das Modell in der Modellregistrierung registriert wird. Derzeit werden Modelle manuell in höhere Umgebungen hochgestuft, und der Modellgenehmiger kann die Modellmetriken anzeigen, um sicherzustellen, dass die neue Version eine bessere Leistung als das aktuelle Modell erbringt.

Modelle werden mit der Modellregistrierung versioniert, wobei jede Anlage ihre eigene Modellpaketgruppe hat. Darüber hinaus können Sie die Modellregistrierung verwenden, um nachzuverfolgen, welche Modellversionen in welchen Umgebungen bereitgestellt werden. Ein Modell kann in a sein Abgelehnt, Ausstehende manuelle Genehmigung, oder Genehmigt Zustand, und nur Modelle, die in der sind Genehmigt Staat eingesetzt werden kann. Dies bietet auch Schutz vor versehentlicher Bereitstellung einer nicht genehmigten Version des Modells.

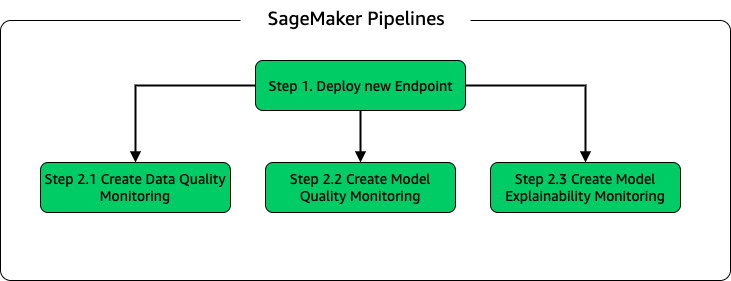

Modellrückschluss und Überwachungspipeline

Um das Modell bereitzustellen und die Modellüberwachung einzurichten, richten wir eine zweite SageMaker-Pipeline ein. Die ELC-Anwendung liefert Anlagenbetreibern Vorhersagen auf Abruf, daher wird auf die Modelle über API-Aufrufe aus dem ELC-Backend zugegriffen. SageMaker-Inferenzendpunkte bieten eine vollständig verwaltete Modell-Hosting-Lösung mit einer API-Schicht; Endpunkte nehmen Modelleingaben als Nutzlast und geben Vorhersagen zurück. Da die Latenz auch ein entscheidender Faktor für Endbenutzer ist, die nicht lange auf aktualisierte Vorhersagen warten möchten, entschied sich Yara für SageMaker-Echtzeit-Inferenz-Endpunkte, die sich besonders für Workloads mit sehr geringen Latenzanforderungen eignen. Da die ELC-Anwendung keine Ausfallzeit haben darf, während aktualisierte Modelle bereitgestellt werden, verlässt sie sich schließlich auf die Blau/Grün-Bereitstellungsfunktion von SageMaker-Echtzeit-Endpunkten, um sicherzustellen, dass die alte Modellversion weiterhin Vorhersagen liefert, bis die neue Version bereitgestellt wird .

Das folgende Diagramm veranschaulicht die Bereitstellungs- und Überwachungskonfiguration.

Zur Modellüberwachung führt Yara SageMaker aus Datenqualität, Modellqualität und Modellerklärbarkeit Überwachung. Die Datenqualitätsüberwachung prüft auf Konsistenz und erstellt Datenverteilungsstatistiken. Die Überwachung der Modellqualität überprüft die Modellleistung und vergleicht die Modellgenauigkeit mit den Trainingsmetriken. Modellüberwachungsberichte werden stündlich generiert. Diese Berichte werden verwendet, um die Modellleistung in der Produktion zu überwachen. Die Überwachung der Modellerklärbarkeit wird verwendet, um zu verstehen, welche Merkmale am meisten zu einer Vorhersage beitragen.

Diese Ergebnisse der Modellerklärbarkeit werden auf dem ELC-Dashboard geteilt, um Anlagenbetreibern mehr Kontext darüber zu bieten, was den Energieverbrauch antreibt. Dies unterstützt auch die Bestimmung der Maßnahmen zur Anpassung des internen Prozesses, falls der Energieverbrauch vom optimalen Punkt abweicht.

CI/CD-Fluss

Der CI/CD-Fluss für die Trainingspipelines beginnt im DEV-Konto. Yara folgt einem funktionsbasierten Entwicklungsmodell, und wenn eine neue Funktion entwickelt wird, wird der Feature-Zweig mit dem Trunk zusammengeführt, wodurch die Bereitstellung gestartet wird. ELC-Modelle werden im DEV-Konto trainiert und nachdem das Modell trainiert und bewertet wurde, wird es in der Modellregistrierung registriert. Ein Modellgenehmiger führt Plausibilitätsprüfungen durch, bevor er den Modellstatus auf aktualisiert Genehmigt. Diese Aktion generiert ein Ereignis, das die Bereitstellung der Modellrückschlusspipeline auslöst. Die Modellrückschlusspipeline stellt die neue Modellversion auf einem SageMaker-Endpunkt in DEV bereit.

Nach dem Deployment des Endpoints werden Tests gestartet, um das Verhalten des Setups zu überprüfen. Zum Testen verwendet Yara CodeBuild-Testberichte. Mit dieser Funktion können Entwickler Komponententests, Konfigurationstests und Funktionstests vor und nach der Bereitstellung ausführen. In diesem Fall führt Yara Funktionstests durch, indem es Testnutzlasten an SageMaker-Endpunkte weiterleitet und die Antwort auswertet. Nachdem diese Tests bestanden wurden, fährt die Pipeline damit fort, die SageMaker-Endpunkte für TEST bereitzustellen. Das ELC-Backend wird auch für TEST bereitgestellt, wodurch End-to-End-Tests für die App in dieser Umgebung möglich sind. Darüber hinaus führt Yara in TEST Benutzerakzeptanztests durch. Der Auslöser für die Bereitstellung von TEST zu PROD ist eine manuelle Genehmigungsaktion. Nachdem die neue Modellversion sowohl Funktions- als auch Benutzerakzeptanztests in TEST bestanden hat, genehmigt das Engineering-Team die Modellbereitstellung für PROD.

Die folgende Abbildung veranschaulicht diesen Arbeitsablauf.

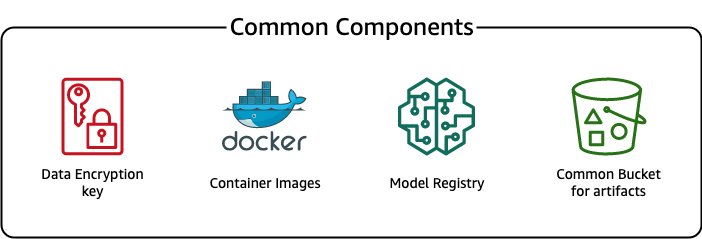

Gemeinsame Komponenten

Für ELC verwenden wir mehrere Komponenten, die für alle Bereitstellungsphasen (DEV, TEST, PROD) und Modelle gleich sind. Diese Komponenten befinden sich in unserem Bereitstellungskonto und umfassen die Modellversionskontrolle, ein Container-Image-Repository, einen Verschlüsselungsschlüssel und einen Bucket zum Speichern allgemeiner Artefakte.

Die Verwendung gemeinsamer Artefakte bietet mehrere Vorteile. Beispielsweise müssen die Ressourcen nicht für jedes Konto erstellt werden, wodurch die Kompatibilität zwischen den Konten erzwungen wird. Das bedeutet, dass wir Container-Images einmal erstellen und sie in allen Zielkonten wiederverwenden, wodurch die Erstellungszeit verkürzt wird.

Diese Pipeline speichert die verschiedenen Modellversionen in einer gemeinsamen Modellregistrierung im Bereitstellungskonto. Von diesem zentralen Ort aus können Modelle in allen Konten bereitgestellt werden, ohne sie zu übertragen. Ebenso erleichtert die Verwendung eines zentral gespeicherten Verschlüsselungsschlüssels die Verwaltung des Schlüssels und der kontoübergreifenden Berechtigungen.

Ein Nachteil der Verwendung gemeinsamer Artefakte besteht darin, dass der Onboarding-Schritt eines neuen Anwendungsfalls aufwändiger werden kann. Um einen neuen Anwendungsfall zu integrieren, muss eine neue Modellregistrierung und bei Bedarf ein neues Container-Image-Repository erstellt werden. Wir empfehlen außerdem, einen neuen Verschlüsselungsschlüssel zu erstellen, um Ressourcen und gespeicherte Daten strikt zu trennen.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie Yara SageMaker und ADF verwendet hat, um eine hochgradig skalierbare MLOps-Plattform zu erstellen. ML ist eine funktionsübergreifende Fähigkeit, und Teams stellen Modelle für verschiedene Geschäftsbereichskonten bereit. Daher ist ADF, das eine native Integration mit Organisationen bietet, ein idealer Kandidat, um Konten zu booten, um CI/CD-Pipelines einzurichten. Betrieblich werden ADF-Pipelines im zentralen Bereitstellungskonto ausgeführt, was es einfach macht, einen Gesamtzustandsüberblick über Bereitstellungen zu erhalten. Schließlich verwendet ADF von AWS verwaltete Dienste wie CodeBuild, CodeDeploy, CodePipeline und CloudFormation, wodurch es einfach zu konfigurieren und zu warten ist.

SageMaker bietet ein breites Spektrum an ML-Funktionen, die es Teams ermöglichen, sich mehr auf die Lösung von Geschäftsproblemen und weniger auf den Aufbau und die Wartung der Infrastruktur zu konzentrieren. Darüber hinaus bietet SageMaker Pipelines eine Vielzahl von APIs zum Erstellen, Aktualisieren und Bereitstellen von ML-Workflows, wodurch es sich hervorragend für MLOps eignet.

Schließlich bietet MLOps die Best Practices für die zuverlässige und effiziente Bereitstellung und Wartung von ML-Modellen in der Produktion. Es ist entscheidend für Teams, die ML-Lösungen in großem Maßstab erstellen und bereitstellen, um MLOps zu implementieren. Im Fall von Yara reduziert MLOps den Aufwand für das Onboarding einer neuen Anlage, die Einführung von Updates für ELC und die Qualitätsüberwachung der Modelle erheblich.

Weitere Informationen zum Bereitstellen von Anwendungen mit ADF finden Sie unter Beispiele.

Über die Autoren

Shaheer Mansur ist Data Scientist bei AWS. Sein Fokus liegt auf dem Aufbau von Plattformen für maschinelles Lernen, die KI-Lösungen in großem Maßstab hosten können. Seine Interessengebiete sind MLOps, Feature Stores, Model Hosting und Model Monitoring.

Shaheer Mansur ist Data Scientist bei AWS. Sein Fokus liegt auf dem Aufbau von Plattformen für maschinelles Lernen, die KI-Lösungen in großem Maßstab hosten können. Seine Interessengebiete sind MLOps, Feature Stores, Model Hosting und Model Monitoring.

Timo Becker ist Senior Data Scientist bei Yara International. Innerhalb der Digitalen Produktion liegt sein Fokus auf der Prozessoptimierung der Ammoniak- und Salpetersäureproduktion. Er hat einen Doktortitel in Thermodynamik und ist leidenschaftlich daran interessiert, Verfahrenstechnik und maschinelles Lernen zusammenzubringen.

Timo Becker ist Senior Data Scientist bei Yara International. Innerhalb der Digitalen Produktion liegt sein Fokus auf der Prozessoptimierung der Ammoniak- und Salpetersäureproduktion. Er hat einen Doktortitel in Thermodynamik und ist leidenschaftlich daran interessiert, Verfahrenstechnik und maschinelles Lernen zusammenzubringen.

Yongyos Kaewpitakkun ist Senior Data Scientist im Digital Production Team bei Yara International. Er hat einen Doktortitel in KI/Maschinelles Lernen und viele Jahre praktische Erfahrung in der Nutzung von maschinellem Lernen, Computer Vision und Modellen zur Verarbeitung natürlicher Sprache, um herausfordernde Geschäftsprobleme zu lösen.

Yongyos Kaewpitakkun ist Senior Data Scientist im Digital Production Team bei Yara International. Er hat einen Doktortitel in KI/Maschinelles Lernen und viele Jahre praktische Erfahrung in der Nutzung von maschinellem Lernen, Computer Vision und Modellen zur Verarbeitung natürlicher Sprache, um herausfordernde Geschäftsprobleme zu lösen.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon-Bereitstellungs-Framework

- Amazon Machine Learning

- Amazon Sage Maker

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Kohlenstoff-Emissionen

- Fallstudie

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Kundenlösungen

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- MLOps

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- SageMaker-Pipelines

- Skala ai

- Syntax

- Zephyrnet