Amazon-Prognose ist ein vollständig verwalteter Dienst, der statistische und maschinelle Lernalgorithmen (ML) verwendet, um hochgenaue Zeitreihenprognosen zu liefern. Kürzlich haben wir auf der Grundlage von Amazon Forecast einem unserer Einzelhandelskunden geholfen, innerhalb von 8 Wochen eine genaue Bedarfsprognose zu erstellen. Die Lösung verbesserte die manuelle Prognose um durchschnittlich 10 % in Bezug auf die WAPE metrisch. Dies führt zu einer direkten Einsparung von monatlich 16 Arbeitsstunden. Darüber hinaus schätzen wir, dass der Umsatz durch Erfüllung der richtigen Anzahl von Artikeln um bis zu 11.8 % steigen könnte. In diesem Beitrag stellen wir den Workflow und die kritischen Elemente vor, die implementiert werden müssen – vom Proof of Concept (POC) bis zur Produktion – eines Bedarfsprognosesystems mit Amazon Forecast, das sich auf die Herausforderungen in der Einzelhandelsbranche konzentriert.

Hintergrund und aktuelle Herausforderungen der Bedarfsprognose im Einzelhandel

Das Ziel der Bedarfsprognose besteht darin, die zukünftige Nachfrage aus historischen Daten abzuschätzen und die Lagerauffüllung und Kapazitätszuweisung zu unterstützen. Mit Bedarfsprognosen sind Einzelhändler in der Lage, an jedem Standort in ihrem Netzwerk die richtige Bestandsmenge zu positionieren, um die Nachfrage zu decken. Daher kann ein genaues Prognosesystem eine Vielzahl von Vorteilen für verschiedene Geschäftsfunktionen bieten, wie zum Beispiel:

- Steigern Sie den Umsatz durch bessere Produktverfügbarkeit und reduzieren Sie den Aufwand für den Transfer zwischen den Filialen

- Bereitstellung zuverlässigerer Einblicke zur Verbesserung der Kapazitätsauslastung und zur proaktiven Vermeidung von Engpässen bei der Kapazitätsbereitstellung

- Minimierung der Lager- und Produktionskosten und Verbesserung des Lagerumschlags

- Präsentation eines insgesamt besseren Kundenerlebnisses

ML-Techniken sind von großem Wert, wenn eine große Menge an qualitativ hochwertigen Daten vorhanden ist. Heute ist ein erfahrungsbasiertes Nachschubmanagement oder eine Bedarfsprognose für die meisten Einzelhändler immer noch der Mainstream. Mit dem Ziel, das Kundenerlebnis zu verbessern, sind immer mehr Einzelhändler bereit, erfahrungsbasierte Bedarfsprognosesysteme durch ML-basierte Prognosen zu ersetzen. Einzelhändler stehen jedoch bei der Implementierung von ML-basierten Bedarfsprognosesystemen in der Produktion vor mehreren Herausforderungen. Wir fassen die verschiedenen Herausforderungen in drei Kategorien zusammen: Datenherausforderungen, ML-Herausforderungen und betriebliche Herausforderungen.

Datenherausforderungen

Eine große Menge sauberer, qualitativ hochwertiger Daten ist eine Schlüsselvoraussetzung für genaue ML-basierte Vorhersagen. Qualitätsdaten, einschließlich historischer Verkäufe und verkaufsbezogener Daten (wie Inventar, Artikelpreise und Werbeaktionen), müssen gesammelt und konsolidiert werden. Die Vielfalt der Daten aus mehreren Ressourcen erfordert eine moderne Datenplattform, um Datensilos zu vereinen. Darüber hinaus ist der zeitnahe Zugriff auf Daten für häufige und feinkörnige Bedarfsprognosen erforderlich.

ML-Herausforderungen

Die Entwicklung fortschrittlicher ML-Algorithmen erfordert Fachwissen. Die Implementierung der richtigen Algorithmen für das richtige Problem erfordert sowohl fundiertes Domänenwissen als auch ML-Kompetenzen. Darüber hinaus erfordert das Lernen aus großen verfügbaren Datensätzen eine skalierbare ML-Infrastruktur. Darüber hinaus erfordert die Aufrechterhaltung von ML-Algorithmen in der Produktion ML-Kompetenzen, um die Grundursache der Modellverschlechterung zu analysieren und das Modell korrekt neu zu trainieren.

Um praktische Geschäftsprobleme zu lösen, ist die Erstellung genauer Prognosen nur ein Teil der Geschichte. Entscheidungsträger benötigen probabilistische Prognosen mit unterschiedlichen Quantilen, um wichtige Abwägungsentscheidungen zwischen Kundenerlebnis und Finanzergebnissen treffen zu können. Sie müssen den Stakeholdern auch Prognosen erklären und Was-wäre-wenn-Analysen durchführen, um zu untersuchen, wie sich verschiedene Szenarien auf die Prognoseergebnisse auswirken könnten.

Operative Herausforderungen

Die Reduzierung des operativen Aufwands für die Aufrechterhaltung eines kostengünstigen Prognosesystems ist die dritte Hauptherausforderung. In einem gängigen Szenario der Bedarfsprognose hat jeder Artikel an jedem Standort seine eigene Prognose. Gefordert ist ein System, das jederzeit hunderttausende Prognosen verwalten kann. Darüber hinaus müssen geschäftliche Endnutzer das Prognosesystem in vorhandene nachgelagerte Systeme, wie z. B. vorhandene Supply-Chain-Management-Plattformen, integrieren, damit sie ML-basierte Systeme verwenden können, ohne vorhandene Tools und Prozesse zu ändern.

Diese Herausforderungen sind besonders akut, wenn Unternehmen groß, dynamisch und wachsend sind. Um diesen Herausforderungen zu begegnen, teilen wir eine Kundenerfolgsgeschichte, die den Aufwand zur schnellen Validierung des potenziellen Geschäftsgewinns reduziert. Dies wird durch Prototyping mit Amazon Forecast erreicht – einem vollständig verwalteten Service, der genaue Prognoseergebnisse liefert, ohne dass zugrunde liegende Infrastrukturressourcen und Algorithmen verwaltet werden müssen.

Rapid Prototyping für ein ML-basiertes Prognosesystem mit Amazon Forecast

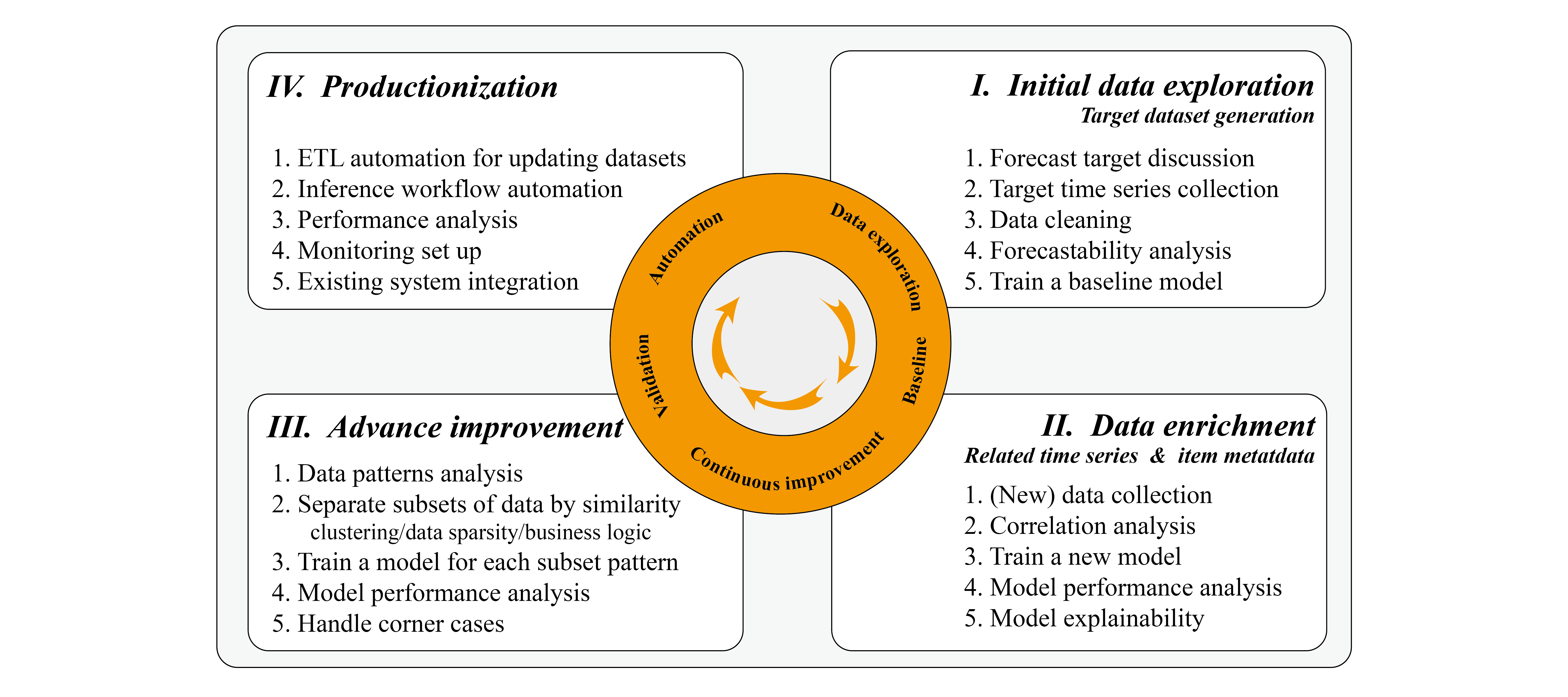

Aufgrund unserer Erfahrung sehen wir oft, dass Einzelhandelskunden bereit sind, einen Proof of Concept für ihre Verkaufsdaten zu initiieren. Dies kann je nach Datenkomplexität und verfügbaren Ressourcen zur Iteration durch den Modelloptimierungsprozess innerhalb eines Bereichs von einigen Tagen bis zu einigen Wochen für das Rapid Prototyping erfolgen. Während des Prototypings empfehlen wir die Verwendung von Sprints, um den Prozess effektiv zu verwalten, und die Unterteilung des POC in Datenexploration, iterative Verbesserung und Automatisierungsphasen.

Datenexploration

Die Datenexploration beinhaltet oft intensive Diskussionen mit Datenwissenschaftlern oder Business-Intelligence-Analysten, um sich mit dem historischen Verkaufsdatensatz und den verfügbaren Datenquellen vertraut zu machen, die sich potenziell auf Prognoseergebnisse auswirken können, wie z. B. Inventar und historische Werbeveranstaltungen. Eine der effizientesten Möglichkeiten besteht darin, die Vertriebsdaten als Zieldatensatz bereits in der frühen Projektphase aus dem Data Warehouse zu konsolidieren. Dies basiert auf der Tatsache, dass Prognoseergebnisse häufig von den Zieldatensatzmustern dominiert werden. Data Warehouses speichern oft alltägliche Geschäftsdaten, und ein umfassendes Verständnis innerhalb kurzer Zeit ist schwierig und zeitaufwändig. Unser Vorschlag ist, sich auf die Generierung des Zieldatensatzes zu konzentrieren und sicherzustellen, dass dieser Datensatz korrekt ist. Diese Datenexploration und Basislinienergebnisse können oft innerhalb weniger Tage erzielt werden, und dies kann bestimmen, ob die Zieldaten genau prognostiziert werden können. Wir besprechen die Datenvorhersagbarkeit später in diesem Beitrag.

Iteration

Nachdem wir die Basisergebnisse haben, können wir weitere zugehörige Daten hinzufügen, um zu sehen, wie sich diese auf die Genauigkeit auswirken können. Dies geschieht oft durch einen tiefen Einblick in zusätzliche Datensätze; Weitere Informationen finden Sie unter Verwenden verwandter Zeitreihendatensätze und Artikel-Metadaten-Datensätze verwenden.

In einigen Fällen kann es möglich sein, die Genauigkeit in Amazon Forecast zu verbessern, indem die Modelle mit Teilmengen des Datensatzes trainiert werden, die sich ähnlich verhalten, oder indem die spärlichen Daten aus dem Datensatz entfernt werden. Während dieser iterativen Verbesserungsphase besteht der herausfordernde Teil – der für alle ML-Projekte gilt – darin, dass die aktuelle Iteration von den wichtigsten Ergebnissen und Erkenntnissen der vorherigen Iteration abhängt, sodass eine strenge Analyse und Berichterstattung der Schlüssel zum Erfolg sind.

Die Analyse kann quantitativ und empirisch erfolgen. Der quantitative Aspekt bezieht sich auf die Bewertung während des Backtestings und den Vergleich der Genauigkeitsmetrik, wie z WAPE. Der empirische Aspekt bezieht sich auf die Visualisierung der Vorhersagekurve und der tatsächlichen Zieldaten und die Verwendung des Domänenwissens zur Einbeziehung potenzieller Faktoren. Diese Analysen helfen Ihnen, schneller zu iterieren, um die Lücke zwischen prognostizierten Ergebnissen und Zieldaten zu schließen. Darüber hinaus kann die Präsentation solcher Ergebnisse über einen wöchentlichen Bericht den geschäftlichen Endbenutzern oft Vertrauen geben.

Automation

Der letzte Schritt beinhaltet oft die Diskussion von POC zu Produktionsverfahren und Automatisierung. Da das ML-Projekt durch die Gesamtprojektdauer eingeschränkt ist, haben wir möglicherweise nicht genug Zeit, um alle Möglichkeiten zu erkunden. Daher kann die Angabe des potenziellen Bereichs durch die Ergebnisse während des Projekts oft Vertrauen schaffen. Darüber hinaus kann die Automatisierung geschäftlichen Endbenutzern dabei helfen, Prognosen über einen längeren Zeitraum auszuwerten, da sie einen vorhandenen Prädiktor verwenden können, um Prognosen mit den aktualisierten Daten zu erstellen.

Die Erfolgskriterien können mit generierten Ergebnissen sowohl aus technischer als auch aus betriebswirtschaftlicher Sicht bewertet werden. Während des Bewertungszeitraums können wir potenzielle Vorteile für Folgendes abschätzen:

- Erhöhung der Prognosegenauigkeit (technisch) – Berechnen Sie die Vorhersagegenauigkeit in Bezug auf tatsächliche Verkaufsdaten und vergleichen Sie sie mit dem bestehenden Prognosesystem, einschließlich manueller Prognosen

- Abfall reduzieren (Geschäft) – Reduzieren Sie zu hohe Prognosen, um Verschwendung zu reduzieren

- Verbesserung der Lagerbestandsquoten (Geschäft) – Reduzieren Sie Unterprognosen, um die Lagerbestände zu verbessern

- Schätzung der Steigerung des Bruttogewinns (Geschäft) – Reduzieren Sie Verschwendung und verbessern Sie die Lagerbestände, um den Bruttogewinn zu steigern

Wir fassen den Entwicklungsworkflow im folgenden Diagramm zusammen.

In den folgenden Abschnitten diskutieren wir die wichtigen Elemente, die bei der Implementierung zu berücksichtigen sind.

Schritt-für-Schritt-Workflow zur Entwicklung eines Prognosesystems

Generierung von Zieldatensätzen

Der erste Schritt besteht darin, den Zieldatensatz für die Prognose zu generieren. In der Einzelhandelsbranche bezieht sich dies auf die historischen Zeitreihen von Nachfrage- und Verkaufsdaten für Einzelhandelsartikel (SKUs). Ein wichtiger Aspekt bei der Aufbereitung des Datensatzes ist die Granularität. Wir sollten die Datengranularität sowohl von den Geschäftsanforderungen als auch von den technischen Anforderungen berücksichtigen.

Das Geschäft definiert, wie Prognoseergebnisse im Produktionssystem resultieren:

- Horizon – Die Anzahl der prognostizierten Zeitschritte. Dies hängt vom zugrunde liegenden Geschäftsproblem ab. Wenn wir den Lagerbestand jede Woche auffüllen wollen, dann erscheint eine Wochenprognose oder Tagesprognose angemessen.

- Körnung – Die Granularität Ihrer Prognosen: Zeithäufigkeit wie täglich oder wöchentlich, unterschiedliche Filialstandorte und unterschiedliche Größen desselben Artikels. Am Ende kann die Vorhersage eine Kombination aus jeder Filial-SKU mit täglichen Datenpunkten sein.

Obwohl der oben genannte Prognosehorizont und die Granularität definiert werden sollten, um die Geschäftsanforderungen zu priorisieren, müssen wir möglicherweise Kompromisse zwischen Anforderungen und Machbarkeit eingehen. Nehmen wir als Beispiel das Schuhgeschäft. Wenn wir den Verkauf jeder Schuhgröße auf jeder Ladenebene vorhersagen wollen, werden die Daten schnell spärlich und das Muster ist schwer zu finden. Um den Bestand jedoch aufzufüllen, müssen wir diese Granularität schätzen. Um dies zu tun, müssen alternative Lösungen möglicherweise ein Verhältnis zwischen verschiedenen Schuhgrößen schätzen und dieses Verhältnis verwenden, um feinkörnige Ergebnisse zu berechnen.

Wir müssen oft die geschäftlichen Anforderungen und das Datenmuster, das erlernt und für Prognosen verwendet werden kann, in Einklang bringen. Um eine quantitative Qualifizierung der Datenmuster zu ermöglichen, schlagen wir vor, die Datenvorhersagbarkeit zu verwenden.

Datenvorhersagbarkeit und Datenmusterklassifizierung

Eine der wichtigsten Erkenntnisse, die wir aus dem Zieldatensatz gewinnen können, ist seine Fähigkeit, Qualitätsprognosen zu erstellen. Dies kann in der sehr frühen Phase des ML-Projekts analysiert werden. Prognosen glänzen, wenn Daten Saisonalität, Trends und zyklische Muster zeigen.

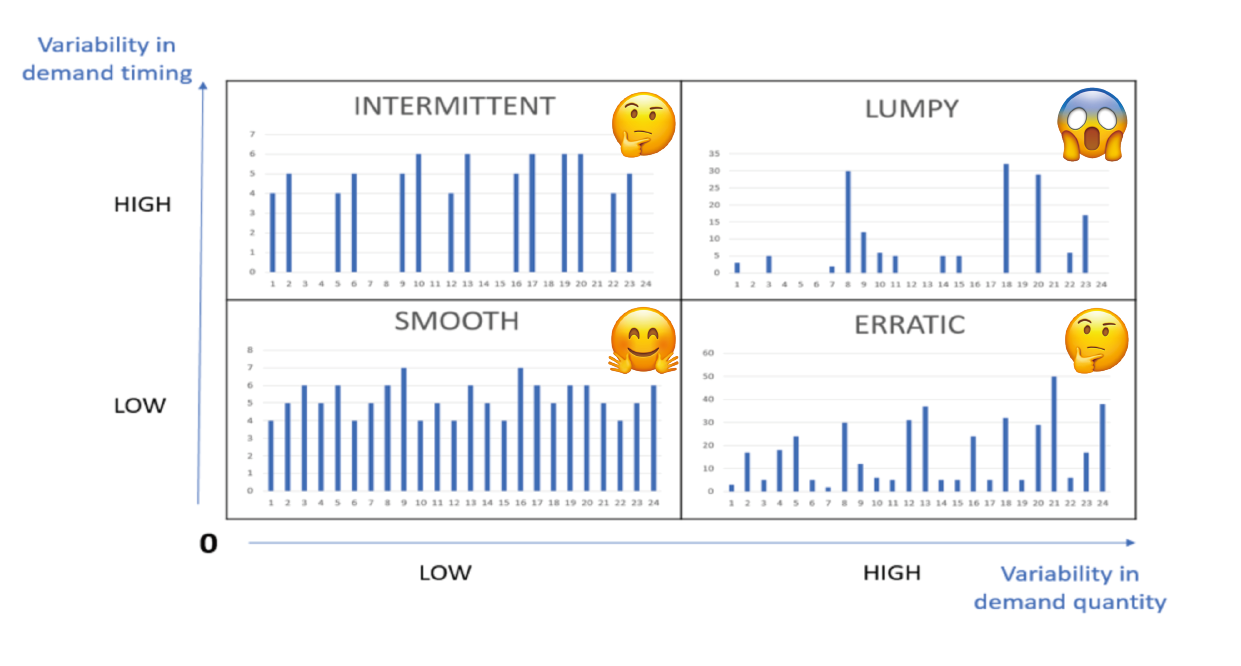

Um die Prognostizierbarkeit zu bestimmen, gibt es zwei Hauptkoeffizienten: Variabilität im Bedarfszeitpunkt und Variabilität in der Bedarfsmenge. Schwankungen im Bedarfszeitpunkt bedeuten das Intervall zwischen zwei Bedarfsfällen und messen die Bedarfsregelmäßigkeit in der Zeit. Schwankungen in der Nachfragemenge bedeuten Schwankungen in den Mengen. Die folgende Abbildung veranschaulicht einige unterschiedliche Muster. Die Prognosegenauigkeit hängt stark von der Prognostizierbarkeit des Produkts ab. Weitere Informationen finden Sie unter Bedarfsklassifizierung: Warum Vorhersagbarkeit wichtig ist.

Es ist erwähnenswert, dass diese Prognostizierbarkeitsanalyse für jedes feinkörnige Element gilt (z. B. SKU-Geschäft-Farbe-Größe). Es ist durchaus üblich, dass in einem Produktionssystem für Bedarfsprognosen verschiedene Artikel unterschiedlichen Mustern folgen. Daher ist es wichtig, die Elemente nach unterschiedlichen Datenmustern zu trennen. Ein typisches Beispiel sind Schnelldreher und Langsamdreher; Ein weiteres Beispiel wären dichte und spärliche Daten. Darüber hinaus besteht bei einem feinkörnigen Gegenstand eine größere Wahrscheinlichkeit, dass ein klumpiges Muster entsteht. Beispielsweise können in einem Bekleidungsgeschäft die Verkäufe eines beliebten Artikels täglich recht reibungslos verlaufen, aber wenn wir die Verkäufe des Artikels für jede Farbe und Größe weiter trennen, wird es bald spärlich. Daher kann das Reduzieren der Granularität von SKU-Store-Color-Size auf SKU-Store das Datenmuster von klumpig zu glatt und umgekehrt ändern.

Es ist erwähnenswert, dass diese Prognostizierbarkeitsanalyse für jedes feinkörnige Element gilt (z. B. SKU-Geschäft-Farbe-Größe). Es ist durchaus üblich, dass in einem Produktionssystem für Bedarfsprognosen verschiedene Artikel unterschiedlichen Mustern folgen. Daher ist es wichtig, die Elemente nach unterschiedlichen Datenmustern zu trennen. Ein typisches Beispiel sind Schnelldreher und Langsamdreher; Ein weiteres Beispiel wären dichte und spärliche Daten. Darüber hinaus besteht bei einem feinkörnigen Gegenstand eine größere Wahrscheinlichkeit, dass ein klumpiges Muster entsteht. Beispielsweise können in einem Bekleidungsgeschäft die Verkäufe eines beliebten Artikels täglich recht reibungslos verlaufen, aber wenn wir die Verkäufe des Artikels für jede Farbe und Größe weiter trennen, wird es bald spärlich. Daher kann das Reduzieren der Granularität von SKU-Store-Color-Size auf SKU-Store das Datenmuster von klumpig zu glatt und umgekehrt ändern.

Außerdem tragen nicht alle Artikel gleichermaßen zum Umsatz bei. Wir haben beobachtet, dass der Artikelbeitrag häufig der Pareto-Verteilung folgt, bei der Top-Artikel den größten Teil des Umsatzes beitragen. Der Verkauf dieser Top-Artikel verläuft oft reibungslos. Artikel mit einem niedrigeren Verkaufsrekord sind oft klumpig und unregelmäßig und daher schwer abzuschätzen. Das Hinzufügen dieser Artikel kann die Genauigkeit der Top-Verkaufsartikel tatsächlich verringern. Basierend auf diesen Beobachtungen können wir die Artikel in verschiedene Gruppen unterteilen, das Prognosemodell auf Top-Verkaufsartikel trainieren und die niedrigeren Verkaufsartikel als Sonderfälle behandeln.

Datenanreicherung und zusätzliche Datensatzauswahl

Wenn wir zusätzliche Datensätze verwenden möchten, um die Leistung von Prognoseergebnissen zu verbessern, können wir uns darauf verlassen Zeitreihen-Datensätze und Metadaten-Datensätze. In der Einzelhandelsdomäne könnten basierend auf Intuition und Domänenwissen Merkmale wie Inventar, Preis, Werbung und Winter- oder Sommersaison als zugehörige Zeitreihen importiert werden. Der einfachste Weg, die Nützlichkeit von Features zu identifizieren, ist die Feature-Wichtigkeit. In Forecast erfolgt dies durch die Erklärbarkeitsanalyse. Vorhersage Prädiktor Erklärbarkeit hilft uns besser zu verstehen, wie sich die Attribute in den Datensätzen auf Prognosen für das Ziel auswirken. Die Prognose verwendet eine Metrik namens Impact Scores, um die relative Auswirkung jedes Attributs zu quantifizieren und zu bestimmen, ob sie die Prognosewerte erhöhen oder verringern. Wenn ein oder mehrere Attribute einen Impact-Score von null haben, dann haben diese Attribute keinen signifikanten Einfluss auf die Prognosewerte. Auf diese Weise können wir schnell die Funktionen entfernen, die weniger Auswirkungen haben, und die potenziellen iterativ hinzufügen. Es ist wichtig zu beachten, dass Wirkungsbewertungen die relative Wirkung von Attributen messen, die zusammen mit Wirkungsbewertungen aller anderen Attribute normalisiert werden.

Wie bei allen ML-Projekten erfordert die Verbesserung der Genauigkeit durch zusätzliche Funktionen iterative Experimente. Sie müssen mit mehreren Kombinationen von Datensätzen experimentieren und dabei die Auswirkungen inkrementeller Änderungen auf die Modellgenauigkeit beobachten. Sie können versuchen, mehrere Forecast-Experimente über die Forecast-Konsole oder mit auszuführen Python-Notebooks mit Prognose-APIs. Darüber hinaus können Sie mit an Bord gehen AWS CloudFormation, das von AWS bereitgestellte fertige Lösungen für gängige Anwendungsfälle bereitstellt (z. B. die Verbesserung der Prognosegenauigkeit mit einer Lösung für maschinelles Lernen). Forecast trennt den Datensatz automatisch und erstellt Genauigkeitsmetriken zur Bewertung von Prädiktoren. Weitere Informationen finden Sie unter Bewertung der Prädiktorgenauigkeit. Dies hilft Data Scientists, schneller zu iterieren, um das leistungsstärkste Modell zu erzielen.

Fortgeschrittene Verbesserung und Behandlung von Eckfällen

Wir haben erwähnt, dass Prognosealgorithmen Saisonalität, Trends und zyklische Merkmale aus Daten lernen können. Für Artikel mit diesen Merkmalen und der entsprechenden Datendichte und dem entsprechenden Volumen können wir Forecast verwenden, um Schätzungen zu erstellen. Wenn wir jedoch mit klumpigen Datenmustern konfrontiert werden, insbesondere wenn das Datenvolumen klein ist, müssen wir möglicherweise anders damit umgehen, z. B. mit einer empirischen Schätzung auf der Grundlage eines Regelsatzes.

Für dichte SKUs verbessern wir die Prognosegenauigkeit weiter, indem wir die Modelle mit sich ähnlich verhaltenden Teilmengen des Zeitreihendatensatzes trainieren. Die von uns verwendeten Teilmengen-Trennstrategien sind Geschäftslogik, Produkttyp, Datendichte und vom Algorithmus gelernte Muster. Nachdem die Teilmengen generiert wurden, können wir mehrere Prognosemodelle für die verschiedenen Teilmengen trainieren. Ein solches Beispiel finden Sie unter Cluster-Zeitreihendaten zur Verwendung mit Amazon Forecast.

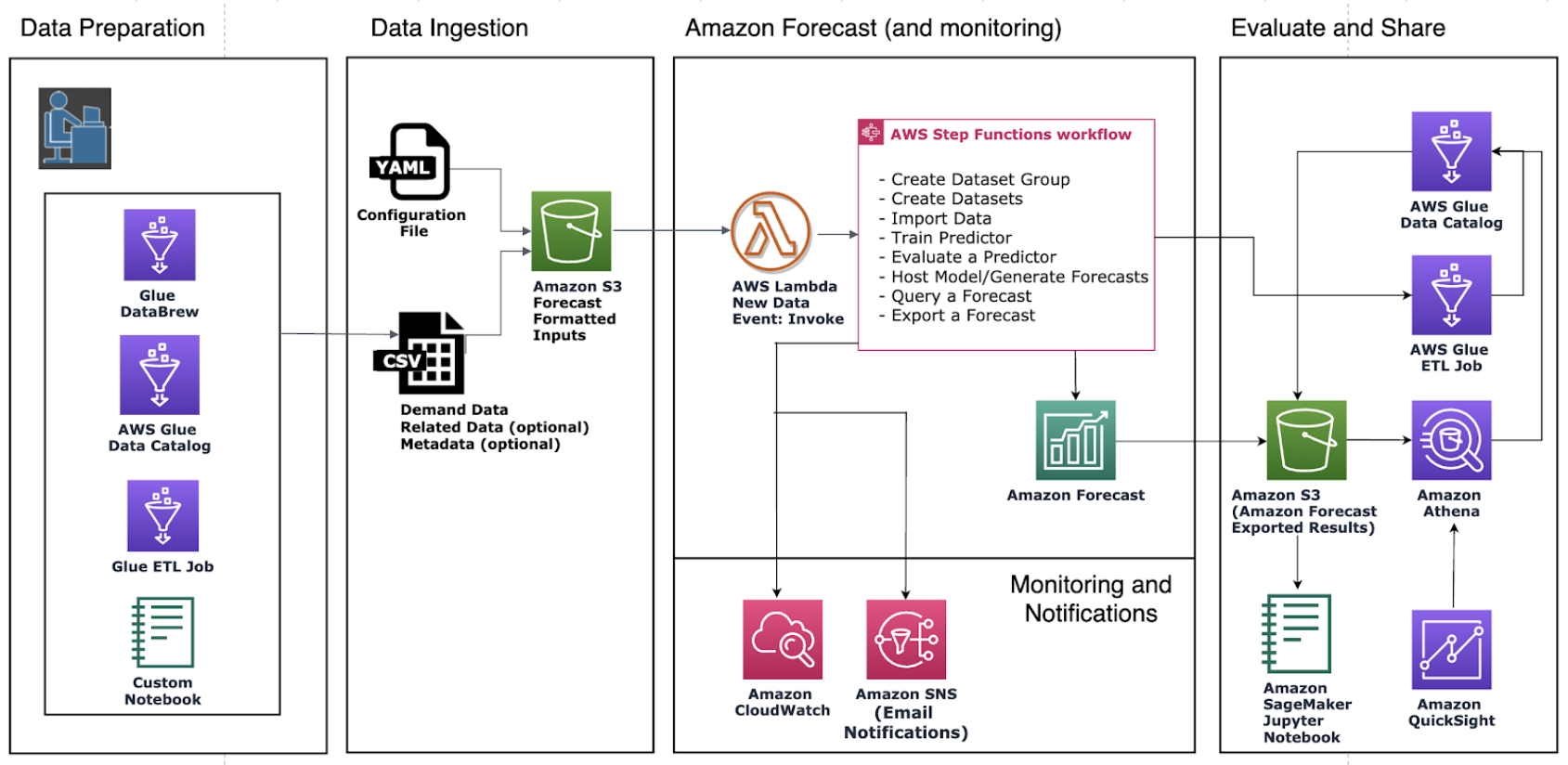

In Richtung Produktion: Aktualisierung des Datensatzes, Überwachung und Umschulung

Sehen wir uns eine Beispielarchitektur mit Forecast an, wie im folgenden Diagramm dargestellt. Jedes Mal, wenn ein Endbenutzer einen neuen Datensatz konsolidiert Amazon Simple Storage-Service (Amazon S3), es löst aus AWS Step-Funktionen um verschiedene Komponenten zu orchestrieren, einschließlich der Erstellung des Dataset-Importauftrags, der Erstellung einer automatischen Vorhersage und der Generierung von Prognosen. Nachdem die Prognoseergebnisse generiert wurden, werden sie im Schritt Create Forecast Export nach Amazon S3 für nachgelagerte Verbraucher exportiert. Weitere Informationen zur Bereitstellung dieser automatisierten Pipeline finden Sie unter Automatisierung mit AWS CloudFormation. Es verwendet einen CloudFormation-Stack, um Datasets automatisch in einem S3-Bucket bereitzustellen und eine Forecast-Pipeline auszulösen. Sie können denselben Automatisierungsstapel verwenden, um Prognosen mit Ihren eigenen Datensätzen zu erstellen.

Es gibt zwei Möglichkeiten, aktuelle Trends in das Prognosesystem zu integrieren: Aktualisieren von Daten oder erneutes Trainieren des Prädiktors.

Um die Prognose mit aktualisierten Daten zu generieren, die aktuelle Trends widerspiegeln, müssen Sie die aktualisierte Eingabedatendatei in einen S3-Bucket hochladen (die aktualisierten Eingabedaten sollten immer noch alle Ihre vorhandenen Daten enthalten). Die Prognose trainiert einen Prädiktor nicht automatisch neu, wenn Sie ein aktualisiertes Dataset importieren. Du kannst Prognosen erstellen wie Sie es normalerweise tun. Prognose sagt den Prognosehorizont ab dem letzten Tag in den aktualisierten Eingabedaten voraus. Daher fließen aktuelle Trends in alle neuen Schlussfolgerungen ein, die von Forecast erstellt werden.

Wenn Sie jedoch möchten, dass Ihr Prädiktor anhand der neuen Daten trainiert wird, müssen Sie einen neuen Prädiktor erstellen. Möglicherweise müssen Sie das Modell neu trainieren, wenn sich Datenmuster (Saisonalität, Trends oder Zyklen) ändern. Wie erwähnt in Überwachen Sie kontinuierlich die Vorhersagegenauigkeit mit Amazon Forecast, schwankt die Leistung eines Prädiktors im Laufe der Zeit aufgrund von Faktoren wie Änderungen des wirtschaftlichen Umfelds oder des Verbraucherverhaltens. Daher muss der Prädiktor möglicherweise neu trainiert oder ein neuer Prädiktor erstellt werden, um sicherzustellen, dass weiterhin hochgenaue Vorhersagen getroffen werden. Mit der Hilfe von Prädiktorenüberwachung, kann Forecast die Qualität Ihrer Prädiktoren nachverfolgen, sodass Sie den betrieblichen Aufwand reduzieren und gleichzeitig fundiertere Entscheidungen über die Beibehaltung, Umschulung oder Neuerstellung Ihrer Prädiktoren treffen können.

Zusammenfassung

Amazon Forecast ist ein Zeitreihen-Prognosedienst, der auf ML basiert und für die Analyse von Geschäftskennzahlen entwickelt wurde. Wir können Nachfrageprognosen mit hoher Genauigkeit integrieren, indem wir historische Verkäufe und andere relevante Informationen wie Inventar, Werbeaktionen oder Saison kombinieren. Innerhalb von 8 Wochen haben wir einem unserer Einzelhandelskunden dabei geholfen, eine genaue Bedarfsprognose zu erstellen – eine Verbesserung von 10 % im Vergleich zur manuellen Prognose. Dies führt zu einer direkten Einsparung von monatlich 16 Arbeitsstunden und einer geschätzten Umsatzsteigerung von bis zu 11.8 %.

In diesem Beitrag wurden gängige Vorgehensweisen vorgestellt, um Ihr Prognoseprojekt vom Proof-of-Concept in die Produktion zu bringen. Starten Sie jetzt mit Amazon-Prognose um hochpräzise Prognosen für Ihr Unternehmen zu erhalten.

Über die Autoren

Yanwei Cui, PhD, ist Lösungsarchitekt für Machine Learning bei AWS. Er begann mit der Forschung zu maschinellem Lernen am IRISA (Research Institute of Computer Science and Random Systems) und verfügt über mehrere Jahre Erfahrung in der Entwicklung von industriellen Anwendungen mit künstlicher Intelligenz in den Bereichen Computer Vision, Verarbeitung natürlicher Sprache und Vorhersage des Online-Benutzerverhaltens. Bei AWS teilt er die Domänenexpertise und hilft Kunden, Geschäftspotenziale zu erschließen und mit maschinellem Lernen in großem Maßstab umsetzbare Ergebnisse zu erzielen. Außerhalb der Arbeit liest und reist er gerne.

Yanwei Cui, PhD, ist Lösungsarchitekt für Machine Learning bei AWS. Er begann mit der Forschung zu maschinellem Lernen am IRISA (Research Institute of Computer Science and Random Systems) und verfügt über mehrere Jahre Erfahrung in der Entwicklung von industriellen Anwendungen mit künstlicher Intelligenz in den Bereichen Computer Vision, Verarbeitung natürlicher Sprache und Vorhersage des Online-Benutzerverhaltens. Bei AWS teilt er die Domänenexpertise und hilft Kunden, Geschäftspotenziale zu erschließen und mit maschinellem Lernen in großem Maßstab umsetzbare Ergebnisse zu erzielen. Außerhalb der Arbeit liest und reist er gerne.

Gordon Wang ist Senior Data Scientist im Professional Services Team bei Amazon Web Services. Er unterstützt Kunden in vielen Branchen, darunter Medien, Fertigung, Energie, Einzelhandel und Gesundheitswesen. Seine Leidenschaft gilt Computer Vision, Deep Learning und MLOps. In seiner Freizeit liebt er Laufen und Wandern.

Gordon Wang ist Senior Data Scientist im Professional Services Team bei Amazon Web Services. Er unterstützt Kunden in vielen Branchen, darunter Medien, Fertigung, Energie, Einzelhandel und Gesundheitswesen. Seine Leidenschaft gilt Computer Vision, Deep Learning und MLOps. In seiner Freizeit liebt er Laufen und Wandern.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon-Prognose

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Best Practices

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Nachfragevorhersage

- Google Ai

- Mittel (200)

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Einzelhandel

- Skala ai

- Syntax

- Technische Anleitung

- Zeitfolgen

- Zephyrnet