Inhaltsmoderation ist der Prozess des Screenings und Überwachens von nutzergenerierten Inhalten online. Um eine sichere Umgebung sowohl für Benutzer als auch für Marken zu schaffen, müssen Plattformen Inhalte moderieren, um sicherzustellen, dass sie den vordefinierten Richtlinien für akzeptables Verhalten entsprechen, die für die Plattform und ihr Publikum spezifisch sind.

Wenn eine Plattform Inhalte moderiert, können akzeptable benutzergenerierte Inhalte (UGC) erstellt und mit anderen Benutzern geteilt werden. Unangemessenes, toxisches oder verbotenes Verhalten kann verhindert, in Echtzeit blockiert oder im Nachhinein entfernt werden, abhängig von den Tools und Verfahren zur Inhaltsmoderation, über die die Plattform verfügt.

Sie können verwenden Moderation von Amazon Rekognition-Inhalten um unangemessene, unerwünschte oder anstößige Inhalte zu erkennen, um ein sichereres Benutzererlebnis zu schaffen, um Werbetreibenden Markensicherheitsgarantien zu geben und um lokale und globale Vorschriften einzuhalten.

In diesem Beitrag diskutieren wir die Schlüsselelemente, die zur Bewertung des Leistungsaspekts eines Inhaltsmoderationsdienstes in Bezug auf verschiedene Genauigkeitsmetriken erforderlich sind, und stellen ein Beispiel mit Amazon Rekognition vor Inhaltsmoderations-APIs.

Was zu bewerten

Bei der Bewertung eines Inhaltsmoderationsdienstes empfehlen wir die folgenden Schritte.

Bevor Sie die Leistung der API für Ihre Anwendungsfälle bewerten können, müssen Sie einen repräsentativen Testdatensatz vorbereiten. Im Folgenden finden Sie einige allgemeine Richtlinien:

- Sammlung – Nehmen Sie eine ausreichend große Zufallsstichprobe (Bilder oder Videos) der Daten, die Sie letztendlich durch Amazon Rekognition laufen lassen möchten. Wenn Sie beispielsweise vorhaben, von Benutzern hochgeladene Bilder zu moderieren, können Sie eine Woche lang Benutzerbilder für den Test mitnehmen. Wir empfehlen, einen Satz zu wählen, der genügend Bilder enthält, ohne zu groß für die Verarbeitung zu werden (z. B. 1,000–10,000 Bilder), obwohl größere Sätze besser sind.

- Definition – Verwenden Sie die Inhaltsrichtlinien Ihrer Anwendung, um zu entscheiden, welche Arten von unsicheren Inhalten Sie von Amazon Rekognition erkennen möchten Moderationskonzepte Taxonomie. Beispielsweise könnten Sie daran interessiert sein, alle Arten von expliziter Nacktheit und grafischer Gewalt oder Blut zu erkennen.

- Anmerkung – Jetzt brauchen Sie für Ihr Test-Set eine menschengenerierte Ground Truth mit den gewählten Labels, damit Sie maschinelle Vorhersagen damit vergleichen können. Das bedeutet, dass jedes Bild für das Vorhandensein oder Fehlen Ihrer gewählten Konzepte kommentiert wird. Um Ihre Bilddaten zu kommentieren, können Sie verwenden Amazon Sagemaker Ground Truth (GT) zum Verwalten von Bildkommentaren. Sie können sich darauf beziehen GT für Bildbeschriftung, konsolidierende Anmerkungen und Verarbeitung der Anmerkungsausgabe.

Erhalten Sie mit Amazon Rekognition Vorhersagen zu Ihrem Testdatensatz

Als Nächstes möchten Sie Vorhersagen für Ihr Testdataset erhalten.

Der erste Schritt besteht darin, sich für einen Mindestkonfidenzwert (einen Schwellenwert, z. B. 50 %) zu entscheiden, bei dem Sie Ergebnisse messen möchten. Unser Standardschwellenwert ist auf 50 festgelegt, was ein gutes Gleichgewicht zwischen dem Abrufen großer Mengen unsicherer Inhalte bietet, ohne zu viele falsche Vorhersagen über sichere Inhalte zu treffen. Ihre Plattform kann jedoch andere Geschäftsanforderungen haben, daher sollten Sie diesen Konfidenzschwellenwert nach Bedarf anpassen. Du kannst den ... benutzen MinConfidence Parameter in Ihren API-Anforderungen, um die Erkennung von Inhalten (Rückruf) und die Genauigkeit der Erkennung (Präzision) auszugleichen. Wenn Sie reduzieren MinConfidence, erkennen Sie wahrscheinlich die meisten unangemessenen Inhalte, greifen aber wahrscheinlich auch Inhalte auf, die nicht wirklich unangemessen sind. Wenn Sie erhöhen MinConfidence Sie werden wahrscheinlich sicherstellen, dass alle Ihre erkannten Inhalte wirklich unangemessen sind, aber einige Inhalte werden möglicherweise nicht markiert. Wir schlagen vor, mit ein paar zu experimentieren MinConfidence Werte in Ihrem Datensatz und wählen Sie quantitativ den besten Wert für Ihre Datendomäne aus.

Führen Sie als Nächstes jedes Beispiel (Bild oder Video) Ihres Testsets über die Amazon Rekognition-Moderations-API (DetectModerationLabels).

Messen Sie die Modellgenauigkeit auf Bildern

Sie können die Genauigkeit eines Modells bewerten, indem Sie von Menschen erstellte Ground-Truth-Anmerkungen mit den Modellvorhersagen vergleichen. Sie wiederholen diesen Vergleich für jedes Bild unabhängig voneinander und aggregieren dann über das gesamte Testset:

- Ergebnisse pro Bild – Als Paar wird eine Modellvorhersage definiert

{label_name, confidence_score}(wobei der Konfidenzwert >= der zuvor ausgewählte Schwellenwert ist). Für jedes Bild gilt eine Vorhersage als korrekt, wenn sie mit der Grundwahrheit (GT) übereinstimmt. Eine Vorhersage ist eine der folgenden Optionen:- Richtig positiv (TP): Sowohl Vorhersage als auch GT sind „unsicher“

- Richtig negativ (TN): sowohl Vorhersage als auch GT sind „sicher“

- falsche Positive (FP): die Vorhersage sagt „unsicher“, aber der GT ist „sicher“

- Falsch negativ (FN): Die Vorhersage ist „sicher“, aber der GT ist „unsicher“

- Aggregierte Ergebnisse über alle Bilder – Als Nächstes können Sie diese Vorhersagen zu Ergebnissen auf Datensatzebene aggregieren:

- Falsch-Positiv-Rate (FPR) – Dies ist der Prozentsatz der Bilder im Testsatz, die vom Modell fälschlicherweise als unsichere Inhalte enthalten gekennzeichnet wurden: (FP): FP / (TN+FP).

- Falsch-Negativ-Rate (FNR) – Dies ist der Prozentsatz unsicherer Bilder in der Testmenge, die vom Modell übersehen werden: (FN): FN / (FN+TP).

- Echt-Positiv-Rate (TPR) – Auch Recall genannt, berechnet den Prozentsatz unsicherer Inhalte (Ground Truth), die vom Modell korrekt entdeckt oder vorhergesagt werden: TP / (TP + FN) = 1 – FNR.

- Präzision – Berechnet den Prozentsatz der korrekten Vorhersagen (unsicherer Inhalt) in Bezug auf die Gesamtzahl der getroffenen Vorhersagen: TP / (TP+FP).

Sehen wir uns ein Beispiel an. Nehmen wir an, Ihr Testsatz enthält 10,000 Bilder: 9,950 sichere und 50 unsichere. Das Modell sagt korrekterweise 9,800 von 9,950 Bildern als sicher und 45 von 50 als unsicher voraus:

- TP = 45

- TN = 9800

- FP = 9950 - 9800 = 150

- FN = 50 - 45 = 5

- RPF = 150 / (9950 + 150) = 0.015 = 1.5 %

- FNR = 5 / (5 + 45) = 0.1 = 10 %

- TPR/Rückruf = 45 / (45 + 5) = 0.9 = 90 %

- Präzision = 45 / (45 + 150) = 0.23 = 23 %

Messen Sie die Modellgenauigkeit auf Videos

Wenn Sie die Leistung von Videos bewerten möchten, sind einige zusätzliche Schritte erforderlich:

- Probieren Sie eine Teilmenge von Frames aus jedem Video aus. Wir empfehlen eine gleichmäßige Abtastung mit einer Rate von 0.3–1 Bildern pro Sekunde (fps). Wenn ein Video beispielsweise mit 24 fps codiert ist und Sie alle 3 Sekunden einen Frame (0.3 fps) abtasten möchten, müssen Sie alle 72 Frames einen auswählen.

- Führen Sie diese abgetasteten Frames durch die Inhaltsmoderation von Amazon Rekognition aus. Sie können entweder unsere Video-API verwenden, die bereits Frames für Sie abtastet (mit einer Rate von 3 fps), oder die Bild-API verwenden, in diesem Fall möchten Sie weniger abtasten. Aufgrund der Redundanz von Informationen in Videos (aufeinanderfolgende Frames sind sehr ähnlich) empfehlen wir letztere Option.

- Berechnen Sie die Ergebnisse pro Frame wie im vorherigen Abschnitt (Ergebnisse pro Bild) erläutert.

- Aggregierte Ergebnisse über das gesamte Testset. Hier haben Sie zwei Möglichkeiten, je nachdem, welche Art von Ergebnis für Ihr Unternehmen wichtig ist:

- Ergebnisse auf Frame-Ebene – Dies betrachtet alle abgetasteten Frames als unabhängige Bilder und aggregiert die Ergebnisse genau wie zuvor für Bilder erklärt (FPR, FNR, Recall, Precision). Wenn einige Videos erheblich länger sind als andere, tragen sie mehr Frames zur Gesamtzahl bei, wodurch der Vergleich unausgewogen wird. In diesem Fall empfehlen wir, die anfängliche Sampling-Strategie auf eine feste Anzahl von Frames pro Video zu ändern. Beispielsweise könnten Sie einheitlich 50–100 Frames pro Video abtasten (vorausgesetzt, die Videos sind mindestens 2–3 Minuten lang).

- Ergebnisse auf Videoebene – Für einige Anwendungsfälle spielt es keine Rolle, ob das Modell in der Lage ist, 50 % oder 99 % der Frames in einem Video korrekt vorherzusagen. Selbst eine einzige falsche unsichere Vorhersage auf einem einzelnen Frame könnte eine nachgelagerte menschliche Bewertung auslösen, und nur Videos mit 100 % korrekten Vorhersagen werden wirklich als korrekt betrachtet. Wenn dies Ihr Anwendungsfall ist, empfehlen wir Ihnen, FPR/FNR/TPR über die Frames jedes Videos zu berechnen und das Video wie folgt zu betrachten:

| Video-ID | Genauigkeit | Kategorisierung pro Video |

| Über alle Frames der Video-ID aggregierte Ergebnisse |

Gesamt-FP = 0 Gesamt-FN = 0 |

Perfekte Vorhersagen |

| . | Gesamt-FP > 0 | Falsch positiv (FP) |

| . | Gesamt-FN > 0 | Falsch negativ (FN) |

Nachdem Sie diese für jedes Video unabhängig berechnet haben, können Sie alle Metriken berechnen, die wir zuvor eingeführt haben:

- Der Prozentsatz der Videos, die fälschlicherweise gemeldet (FP) oder verpasst (FN) wurden

- Präzision und Rückruf

Messen Sie die Leistung an den Zielen

Schließlich müssen Sie diese Ergebnisse im Kontext Ihrer Ziele und Fähigkeiten interpretieren.

Berücksichtigen Sie zunächst Ihre geschäftlichen Anforderungen in Bezug auf Folgendes:

- Datum – Erfahren Sie mehr über Ihre Daten (Tagesvolumen, Art der Daten usw.) und die Verteilung Ihrer unsicheren vs. sicheren Inhalte. Ist es beispielsweise ausgewogen (50/50), schief (10/90) oder sehr schief (1/99, was bedeutet, dass nur 1 % unsicher ist)? Das Verständnis einer solchen Verteilung kann Ihnen helfen, Ihre tatsächlichen Metrikziele zu definieren. Beispielsweise ist die Anzahl sicherer Inhalte oft um eine Größenordnung größer als unsichere Inhalte (sehr verzerrt), was dies fast zu einem Problem der Anomalieerkennung macht. In diesem Szenario kann die Anzahl falsch positiver Ergebnisse die Anzahl richtig positiver Ergebnisse übersteigen, und Sie können Ihre Dateninformationen (Verteilungsschiefe, Datenvolumen usw.) verwenden, um zu entscheiden, mit welcher FPR Sie arbeiten können.

- Metrische Ziele – Was sind die kritischsten Aspekte Ihres Unternehmens? Das Senken des FPR geht oft auf Kosten eines höheren FNR (und umgekehrt) und es ist wichtig, das richtige Gleichgewicht zu finden, das für Sie funktioniert. Wenn Sie keine unsicheren Inhalte übersehen können, möchten Sie wahrscheinlich eine FNR von fast 0 % (100 % Recall). Dies führt jedoch zu den meisten Fehlalarmen, und Sie müssen basierend auf Ihrer Post-Prognose-Pipeline entscheiden, mit welcher (maximalen) Ziel-FPR Sie arbeiten können. Möglicherweise möchten Sie ein gewisses Maß an falsch negativen Ergebnissen zulassen, um ein besseres Gleichgewicht zu finden und Ihren FPR zu senken: Wenn Sie beispielsweise einen FNR von 5 % anstelle von 0 % akzeptieren, könnte der FPR von 2 % auf 0.5 % reduziert werden, was die Anzahl erheblich verringert von gekennzeichneten Inhalten.

Fragen Sie sich als Nächstes, welche Mechanismen Sie verwenden werden, um die gekennzeichneten Bilder zu analysieren. Auch wenn die APIs möglicherweise keine 0 % FPR und FNR bieten, können sie dennoch enorme Einsparungen und Skalierbarkeit bringen (wenn Sie beispielsweise nur 3 % Ihrer Bilder kennzeichnen, haben Sie bereits 97 % Ihres Inhalts herausgefiltert). Wenn Sie die API mit einigen nachgelagerten Mechanismen koppeln, wie z. B. einer menschlichen Belegschaft, die die gekennzeichneten Inhalte überprüft, können Sie Ihre Ziele leicht erreichen (z. B. 0.5 % gekennzeichnete Inhalte). Beachten Sie, dass diese Paarung erheblich billiger ist, als 100 % Ihrer Inhalte einer menschlichen Überprüfung unterziehen zu müssen.

Wenn Sie sich für Ihre Downstream-Mechanismen entschieden haben, empfehlen wir Ihnen, den Durchsatz zu bewerten, den Sie unterstützen können. Wenn Sie beispielsweise eine Belegschaft haben, die nur 2 % Ihrer täglichen Inhalte verifizieren kann, dann ist Ihr Zielziel unserer Inhaltsmoderations-API eine Flag-Rate (FPR+TPR) von 2 %.

Wenn es zu schwierig oder zu teuer ist, Ground-Truth-Anmerkungen zu erhalten (z. B. wenn Ihr Datenvolumen zu groß ist), empfehlen wir, die kleine Anzahl von Bildern, die von der API gekennzeichnet werden, mit Anmerkungen zu versehen. Obwohl dies keine FNR-Auswertungen zulässt (weil Ihre Daten keine falsch negativen Ergebnisse enthalten), können Sie dennoch TPR und FPR messen.

Im folgenden Abschnitt stellen wir eine Lösung für die Bewertung der Bildmoderation vor. Sie können einen ähnlichen Ansatz für die Bewertung der Videomoderation wählen.

Lösungsüberblick

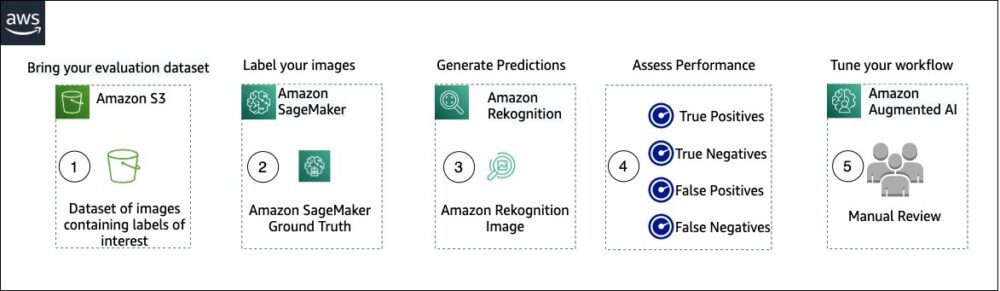

Das folgende Diagramm veranschaulicht die verschiedenen AWS-Services, die Sie verwenden können, um die Leistung der Inhaltsmoderation von Amazon Rekognition für Ihren Testdatensatz zu bewerten.

Die Bewertung der Inhaltsmoderation umfasst die folgenden Schritte:

- Laden Sie Ihren Bewertungsdatensatz in hoch Amazon Simple Storage-Service (Amazon S3).

- Verwenden Sie Ground Truth, um Ground Truth-Moderationslabels zuzuweisen.

- Generieren Sie die vorhergesagten Moderationsbezeichnungen mithilfe der vorab trainierten Moderations-API von Amazon Rekognition unter Verwendung einiger Schwellenwerte. (Beispielsweise 70 %, 75 % und 80 %).

- Bewerten Sie die Leistung für jeden Schwellenwert, indem Sie richtig positive, richtig negative, falsch positive und falsch negative Ergebnisse berechnen. Bestimmen Sie den optimalen Schwellwert für Ihren Anwendungsfall.

- Optional können Sie die Größe der Belegschaft basierend auf True und False Positives anpassen und verwenden Amazon Augmented AI (Amazon A2I), um automatisch alle markierten Inhalte zur manuellen Überprüfung an Ihre zuständigen Mitarbeiter zu senden.

Die folgenden Abschnitte enthalten die Codeausschnitte für die Schritte 1, 2 und 3. Den vollständigen End-to-End-Quellcode finden Sie im bereitgestellten Jupyter Notizbuch.

Voraussetzungen:

Führen Sie die folgenden Schritte aus, um das Jupyter-Notizbuch einzurichten, bevor Sie beginnen:

- Erstellen Sie eine Notebook-Instanz in Amazon Sage Maker.

- Wenn das Notebook aktiv ist, wählen Sie Öffne Jupyter.

- Wählen Sie im Jupyter-Dashboard die Option Neu, und wähle Terminal.

- Geben Sie im Terminal den folgenden Code ein:

- Öffnen Sie das Notizbuch für diesen Beitrag:

content-moderation-evaluation/Evaluating-Amazon-Rekognition-Content-Moderation-Service.ipynb. - Laden Sie Ihren Bewertungsdatensatz auf hoch Amazon Simple Storage-Service (Amazon S3).

Wir werden nun die Schritte 2 bis 4 im Jupyter-Notebook durchgehen.

Verwenden Sie Ground Truth, um Moderationsetiketten zuzuweisen

Führen Sie die folgenden Schritte aus, um Labels in Ground Truth zuzuweisen:

- Erstellen Sie eine Manifest-Eingabedatei für Ihren Ground Truth-Job und laden Sie ihn auf Amazon S3 hoch.

- Erstellen Sie die Labeling-Konfiguration, die alle Moderationslabels enthält, die für den Ground-Truth-Labeling-Job benötigt werden. Um das Limit für die Anzahl der Label-Kategorien zu überprüfen, die Sie verwenden können, beziehen Sie sich auf Quoten für Label-Kategorien. Im folgenden Code-Snippet verwenden wir fünf Labels (siehe hierarchische Taxonomie, die in Amazon Rekognition verwendet wird für weitere Details) plus ein Etikett (

Safe_Content), die Inhalte als sicher markiert: - Erstellen Sie eine benutzerdefinierte Vorlage für Arbeitsaufgaben, um den Mitarbeitern von Ground Truth Etikettierungsanweisungen bereitzustellen, und laden Sie sie auf Amazon S3 hoch.

Der Ground-Truth-Label-Job ist als Aufgabe zur Bildklassifizierung (Multi-Label) definiert. Anweisungen zum Anpassen der Anweisungsvorlage finden Sie im Quellcode. - Entscheiden Sie, welche Arbeitskräfte Sie einsetzen möchten, um den Job „Ground Truth“ abzuschließen. Sie haben zwei Möglichkeiten (Einzelheiten finden Sie im Quellcode):

- Verwenden private Arbeitskräfte in Ihrer eigenen Organisation, um den Bewertungsdatensatz zu kennzeichnen.

- Verwenden öffentliche Arbeitskräfte um den Auswertungsdatensatz zu beschriften.

- Erstellen und übermitteln Sie einen Ground Truth-Kennzeichnungsauftrag. Sie können auch den folgenden Code anpassen, um die zu konfigurieren Etikettierauftragsparameter um Ihre spezifischen Geschäftsanforderungen zu erfüllen. Vollständige Anweisungen zum Erstellen und Konfigurieren des Ground Truth-Jobs finden Sie im Quellcode.

Nachdem der Job gesendet wurde, sollten Sie eine Ausgabe ähnlich der folgenden sehen:

Warten Sie, bis der Beschriftungsauftrag für das Bewertungsdataset erfolgreich abgeschlossen wurde, und fahren Sie dann mit dem nächsten Schritt fort.

Verwenden Sie die Moderations-API von Amazon Rekognition, um vorhergesagte Moderationslabels zu generieren.

Das folgende Code-Snippet zeigt, wie Sie Amazon Rekognition verwenden Moderations-API So erstellen Sie Moderationslabels:

Beurteilen Sie die Leistung

Sie haben zuerst Ground-Truth-Moderationslabels aus den Ergebnissen des Ground-Truth-Labeling-Auftrags für das Bewertungs-Dataset abgerufen und dann die Amazon Rekognition-Moderations-API ausgeführt, um vorhergesagte Moderationslabels für dasselbe Dataset zu erhalten. Da es sich um ein binäres Klassifizierungsproblem handelt (sicherer vs. unsicherer Inhalt), berechnen wir die folgenden Metriken (unter der Annahme, dass unsicherer Inhalt positiv ist):

Wir berechnen auch die entsprechenden Bewertungskennzahlen:

Das folgende Code-Snippet zeigt, wie diese Metriken berechnet werden:

Zusammenfassung

In diesem Beitrag werden die Schlüsselelemente erörtert, die zur Bewertung des Leistungsaspekts Ihres Inhaltsmoderationsdienstes in Bezug auf verschiedene Genauigkeitsmetriken erforderlich sind. Genauigkeit ist jedoch nur eine der vielen Dimensionen, die Sie bei der Auswahl eines bestimmten Inhaltsmoderationsdienstes bewerten müssen. Es ist wichtig, dass Sie andere Parameter einbeziehen, wie z. B. den gesamten Funktionsumfang des Dienstes, Benutzerfreundlichkeit, vorhandene Integrationen, Datenschutz und Sicherheit, Anpassungsoptionen, Auswirkungen auf die Skalierbarkeit, Kundenservice und Preise. Weitere Informationen zur Inhaltsmoderation in Amazon Rekognition finden Sie unter Moderation von Amazon Rekognition-Inhalten.

Über die Autoren

Amit Gupta ist Senior AI Services Solutions Architect bei AWS. Er setzt sich leidenschaftlich dafür ein, Kunden mit gut durchdachten Lösungen für maschinelles Lernen in großem Umfang zu unterstützen.

Amit Gupta ist Senior AI Services Solutions Architect bei AWS. Er setzt sich leidenschaftlich dafür ein, Kunden mit gut durchdachten Lösungen für maschinelles Lernen in großem Umfang zu unterstützen.

David Modolo ist Applied Science Manager bei AWS AI Labs. Er hat an der University of Edinburgh (UK) in Computer Vision promoviert und entwickelt leidenschaftlich neue wissenschaftliche Lösungen für reale Kundenprobleme. Außerhalb der Arbeit reist er gerne und treibt jede Art von Sport, insbesondere Fußball.

David Modolo ist Applied Science Manager bei AWS AI Labs. Er hat an der University of Edinburgh (UK) in Computer Vision promoviert und entwickelt leidenschaftlich neue wissenschaftliche Lösungen für reale Kundenprobleme. Außerhalb der Arbeit reist er gerne und treibt jede Art von Sport, insbesondere Fußball.

Jian Wu ist Senior Enterprise Solutions Architect bei AWS. Er ist seit 6 Jahren bei AWS und arbeitet mit Kunden aller Größen zusammen. Er ist leidenschaftlich daran interessiert, Kunden dabei zu helfen, Innovationen durch die Einführung von Cloud und KI/ML schneller voranzutreiben. Bevor er zu AWS kam, verbrachte Jian mehr als 10 Jahre damit, sich auf Softwareentwicklung, Systemimplementierung und Infrastrukturmanagement zu konzentrieren. Neben der Arbeit ist er gerne aktiv und verbringt Zeit mit seiner Familie.

Jian Wu ist Senior Enterprise Solutions Architect bei AWS. Er ist seit 6 Jahren bei AWS und arbeitet mit Kunden aller Größen zusammen. Er ist leidenschaftlich daran interessiert, Kunden dabei zu helfen, Innovationen durch die Einführung von Cloud und KI/ML schneller voranzutreiben. Bevor er zu AWS kam, verbrachte Jian mehr als 10 Jahre damit, sich auf Softwareentwicklung, Systemimplementierung und Infrastrukturmanagement zu konzentrieren. Neben der Arbeit ist er gerne aktiv und verbringt Zeit mit seiner Familie.

- Fortgeschritten (300)

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon-Anerkennung

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet