Dieser Blogbeitrag wurde gemeinsam mit Hwalsuk Lee bei Upstage verfasst.

Heute freuen wir uns, Ihnen mitteilen zu können, dass die Solar Das von Upstage entwickelte Fundamentmodell ist jetzt für Kunden verfügbar Amazon SageMaker-JumpStart. Solar ist ein großes Sprachmodell (LLM), mit dem es zu 100 % vorab trainiert wurde Amazon Sage Maker das übertrifft und seine kompakte Größe und leistungsstarken Erfolgsbilanz nutzt, um sich auf zielgerichtete Schulungen zu spezialisieren und es so vielseitig für Sprachen, Domänen und Aufgaben zu machen.

Sie können jetzt die Solar-Mini-Chat machen Solar Mini Chat – Quant vorab trainierte Modelle in SageMaker JumpStart. SageMaker JumpStart ist der Hub für maschinelles Lernen (ML) von SageMaker, der zusätzlich zu integrierten Algorithmen Zugriff auf Basismodelle bietet, um Ihnen den schnellen Einstieg in ML zu erleichtern.

In diesem Beitrag erfahren Sie, wie Sie das Solarmodell über SageMaker JumpStart entdecken und bereitstellen.

Was ist das Solarmodell?

Solar ist ein kompaktes und leistungsstarkes Modell für Englisch und Koreanisch. Es ist speziell für Multi-Turn-Chat-Zwecke optimiert und zeigt eine verbesserte Leistung bei einer Vielzahl von Aufgaben zur Verarbeitung natürlicher Sprache.

Das Solar Mini Chat-Modell basiert auf Solar 10.7B, mit einer 32-Schicht Lama 2 Struktur und initialisiert mit vorab trainierten Gewichten von Mistral 7B kompatibel mit der Llama 2-Architektur. Durch diese Feinabstimmung ist es in der Lage, längere Gespräche effektiver zu bewältigen, wodurch es sich besonders gut für interaktive Anwendungen eignet. Es verwendet eine Skalierungsmethode namens Tiefenskalierung (DUS), das aus Tiefenskalierung und fortlaufendem Vortraining besteht. DUS ermöglicht eine viel einfachere und effizientere Vergrößerung kleinerer Modelle als andere Skalierungsmethoden wie z Mischung aus Experten (MoE).

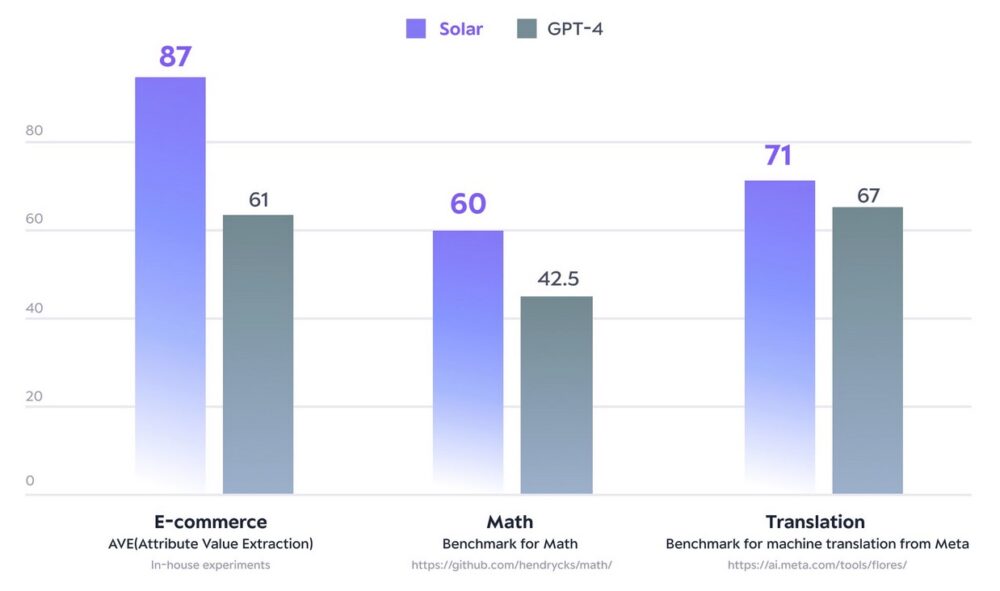

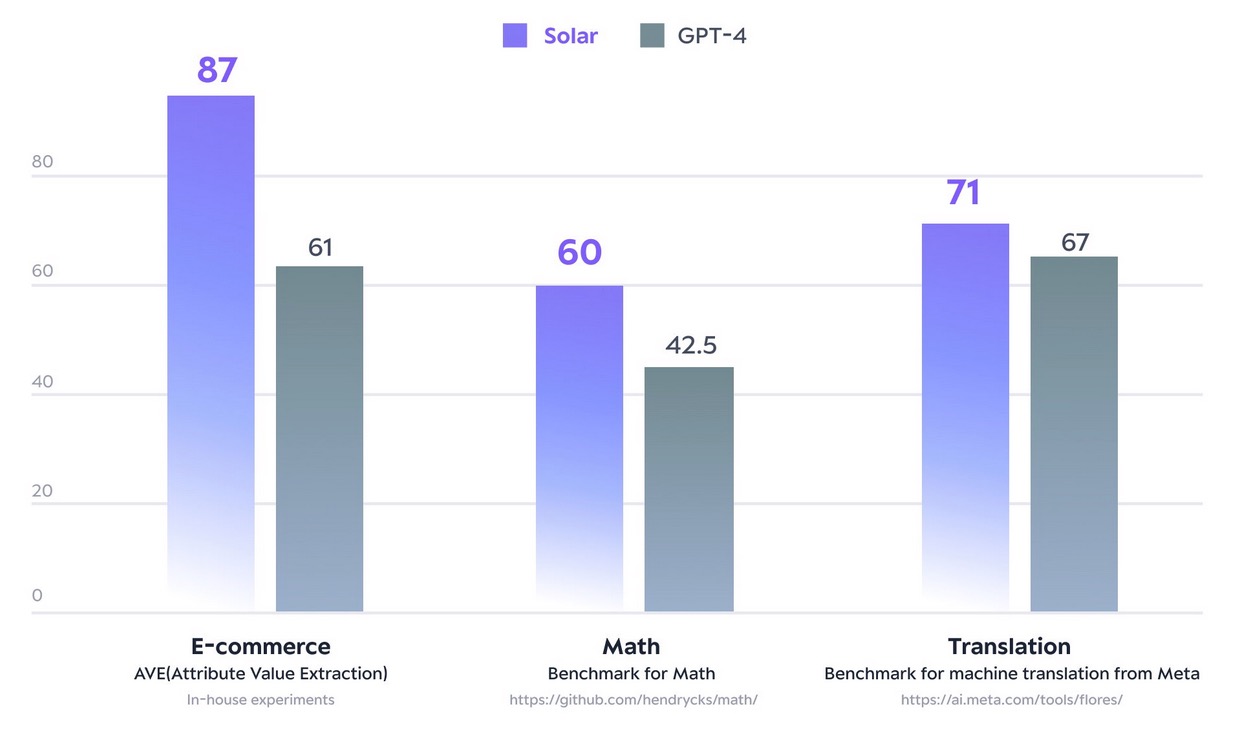

Im Dezember 2023 sorgte das Modell Solar 10.7B für Aufsehen, indem es den Höhepunkt erreichte Öffnen Sie die LLM-Bestenliste von Hugging Face. Mit deutlich weniger Parametern liefert Solar 10.7B vergleichbare Reaktionen wie GPT-3.5, ist aber 2.5-mal schneller. Solar 10.7B liegt nicht nur an der Spitze der Open LLM-Bestenliste, sondern übertrifft auch GPT-4 mit speziell trainierten Modellen für bestimmte Bereiche und Aufgaben.

Die folgende Abbildung veranschaulicht einige dieser Kennzahlen:

Quelle: https://www.upstage.ai/solar-llm

Mit SageMaker JumpStart können Sie auf Solar 10.7B basierende vorab trainierte Modelle bereitstellen: Solar Mini Chat und eine quantisierte Version von Solar Mini Chat, optimiert für Chat-Anwendungen in Englisch und Koreanisch. Das Solar Mini Chat-Modell bietet ein fortgeschrittenes Verständnis der koreanischen Sprachnuancen, was die Benutzerinteraktionen in Chat-Umgebungen erheblich verbessert. Es bietet präzise Antworten auf Benutzereingaben und sorgt so für eine klarere Kommunikation und eine effizientere Problemlösung in englischen und koreanischen Chat-Anwendungen.

Beginnen Sie mit Solarmodellen in SageMaker JumpStart

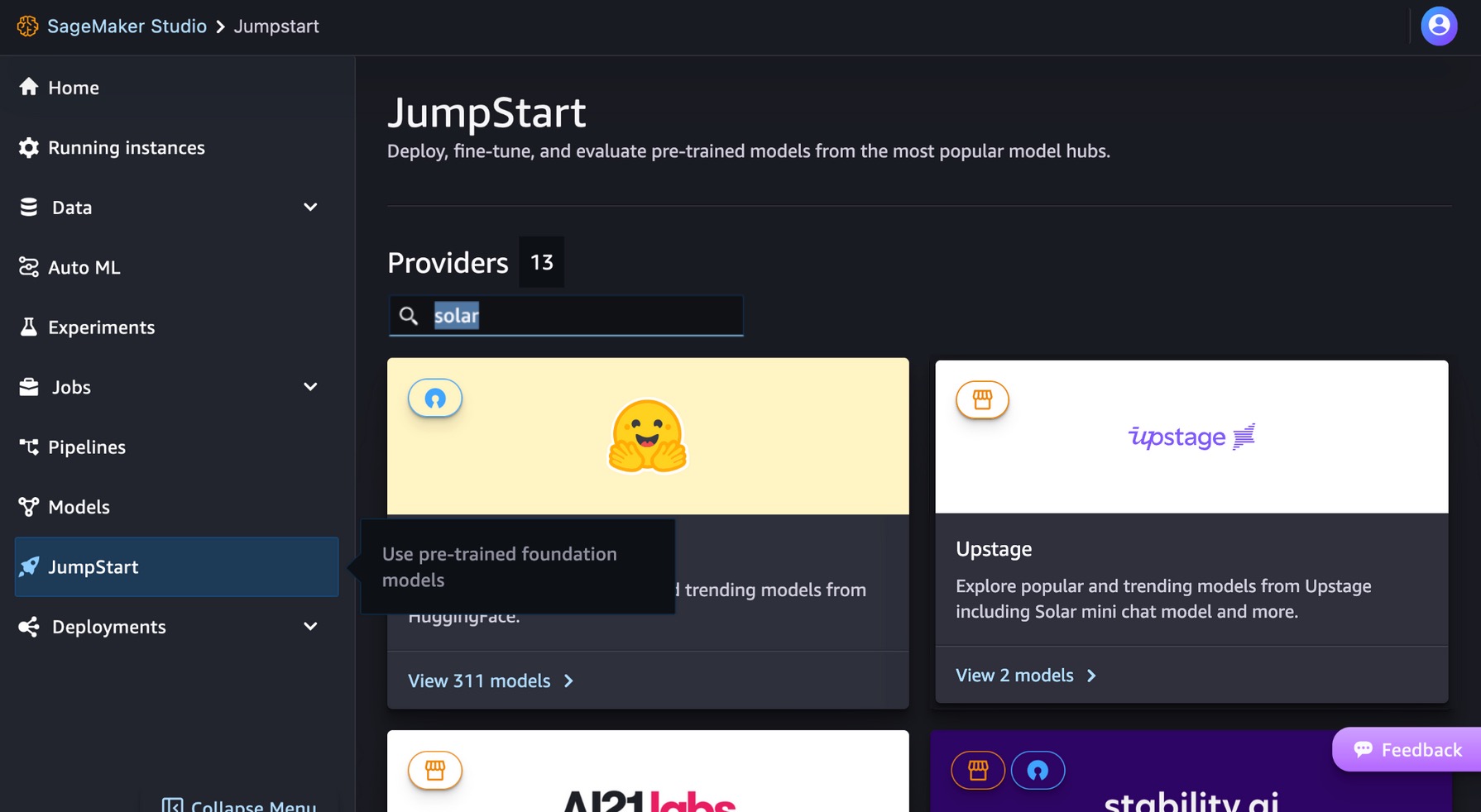

Um mit Solarmodellen zu beginnen, können Sie SageMaker JumpStart verwenden, einen vollständig verwalteten ML-Hub-Dienst, um vorgefertigte ML-Modelle in einer produktionsbereiten gehosteten Umgebung bereitzustellen. Sie können über SageMaker JumpStart in auf Solarmodelle zugreifen Amazon SageMaker-Studio, eine webbasierte integrierte Entwicklungsumgebung (IDE), in der Sie auf speziell entwickelte Tools zugreifen können, um alle ML-Entwicklungsschritte durchzuführen, von der Datenvorbereitung bis zum Erstellen, Trainieren und Bereitstellen Ihrer ML-Modelle.

Wählen Sie auf der SageMaker Studio-Konsole Starthilfe im Navigationsbereich. Sie können „Solar“ in die Suchleiste eingeben, um die Solarmodelle von Upstage zu finden.

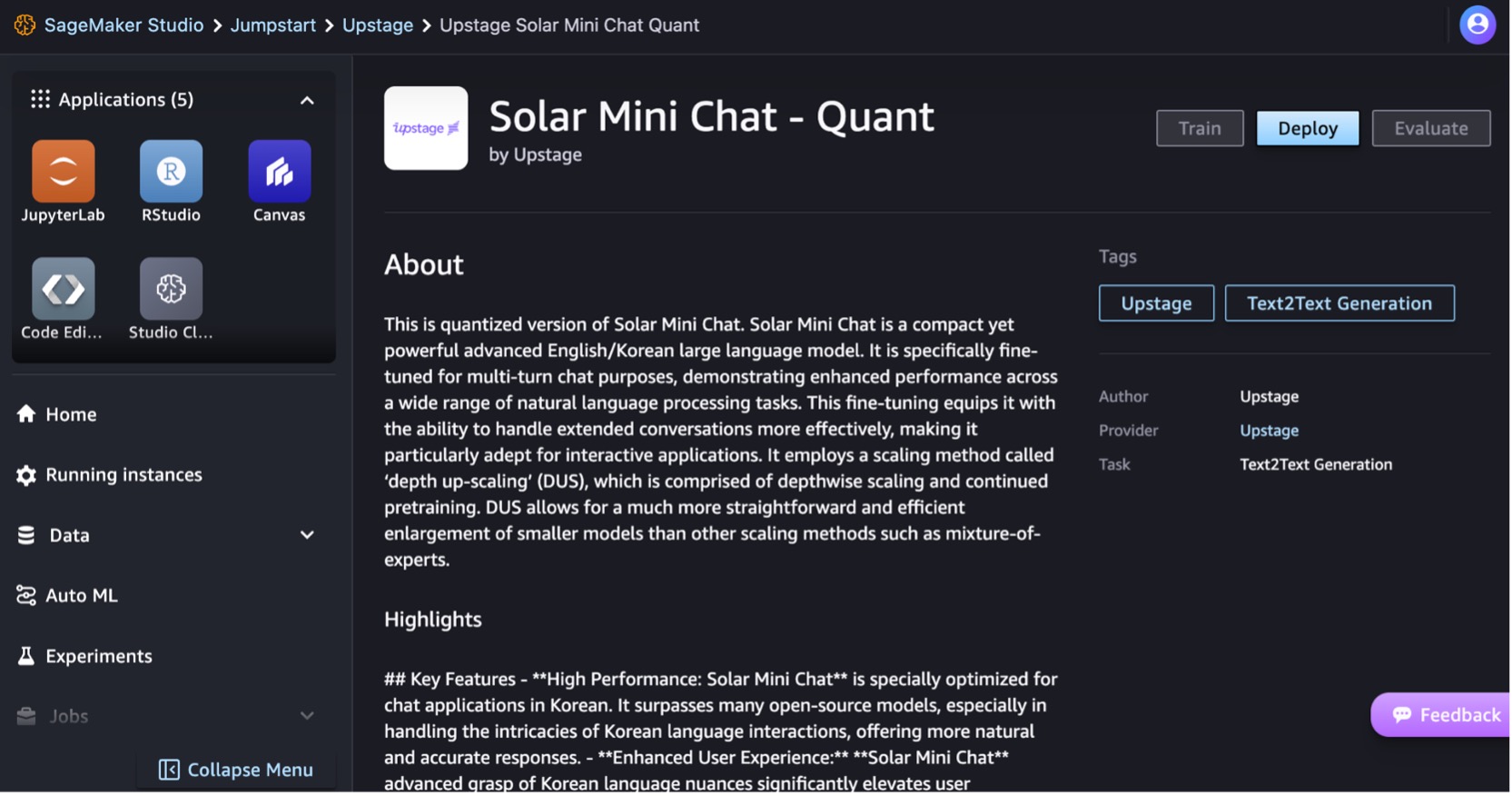

Lassen Sie uns das Solar Mini Chat – Quant-Modell einsetzen. Wählen Sie die Modellkarte aus, um Details zum Modell anzuzeigen, z. B. die Lizenz, die zum Training verwendeten Daten und die Verwendung des Modells. Sie finden auch eine Deploy Option, die Sie zu einer Zielseite führt, auf der Sie die Inferenz mit einer Beispielnutzlast testen können.

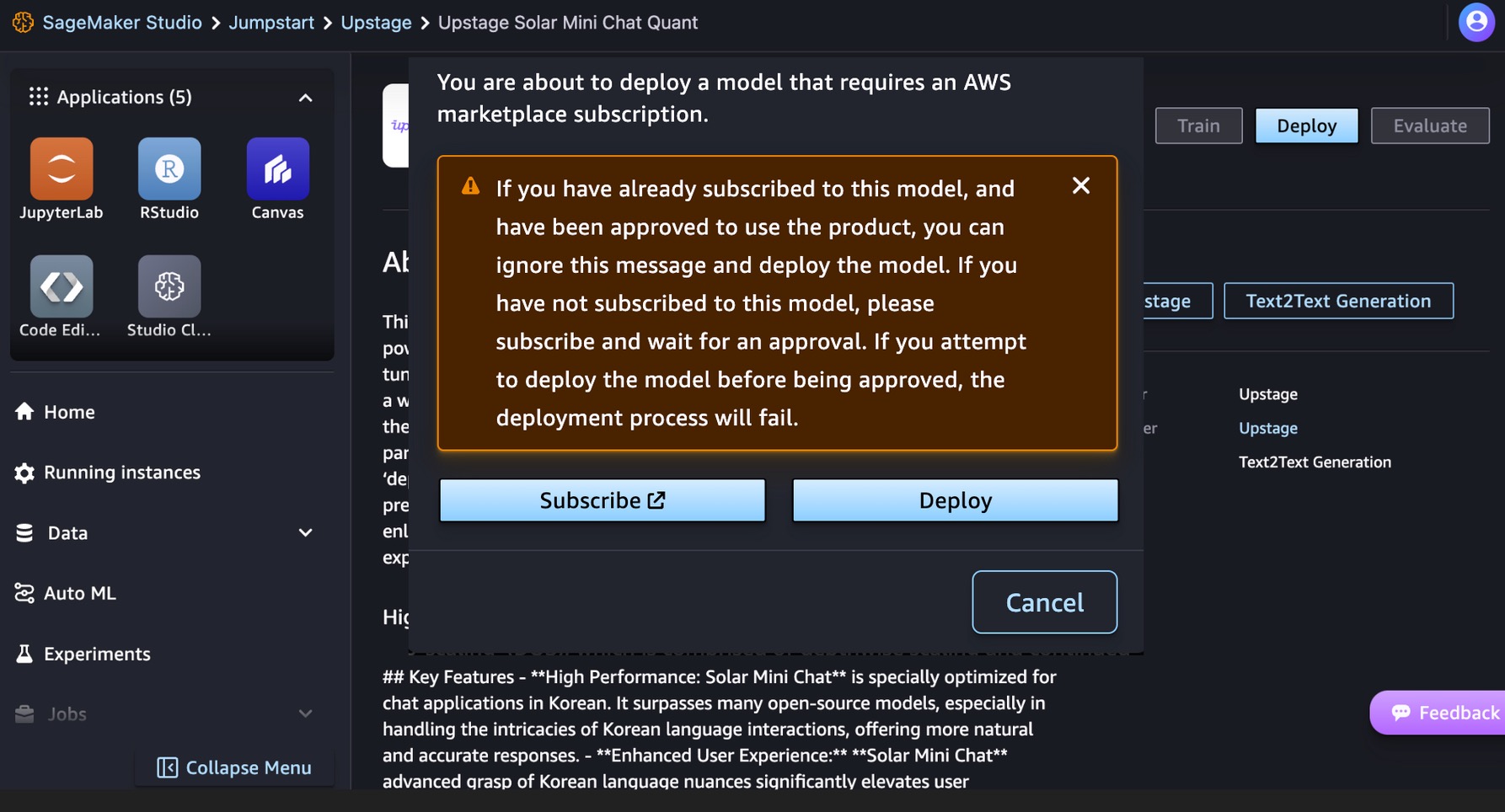

Dieses Modell erfordert eine AWS-Marktplatz Abonnement. Wenn Sie dieses Modell bereits abonniert haben und die Genehmigung zur Nutzung des Produkts erhalten haben, können Sie das Modell direkt bereitstellen.

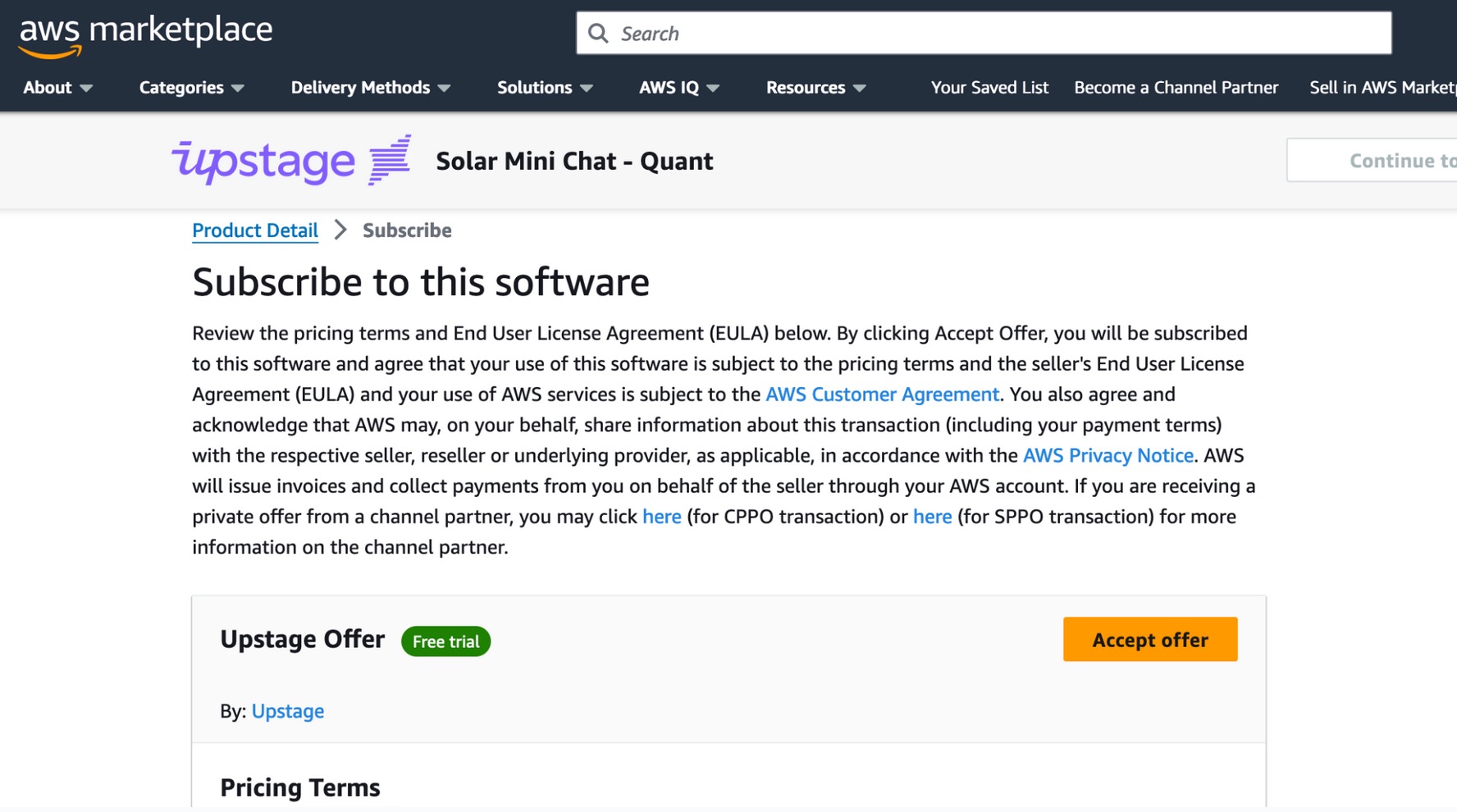

Wenn Sie dieses Modell nicht abonniert haben, wählen Sie Abonnieren, gehen Sie zum AWS Marketplace, lesen Sie die Preisbedingungen und die Endbenutzer-Lizenzvereinbarung (EULA) und wählen Sie Akzeptiere Angebot.

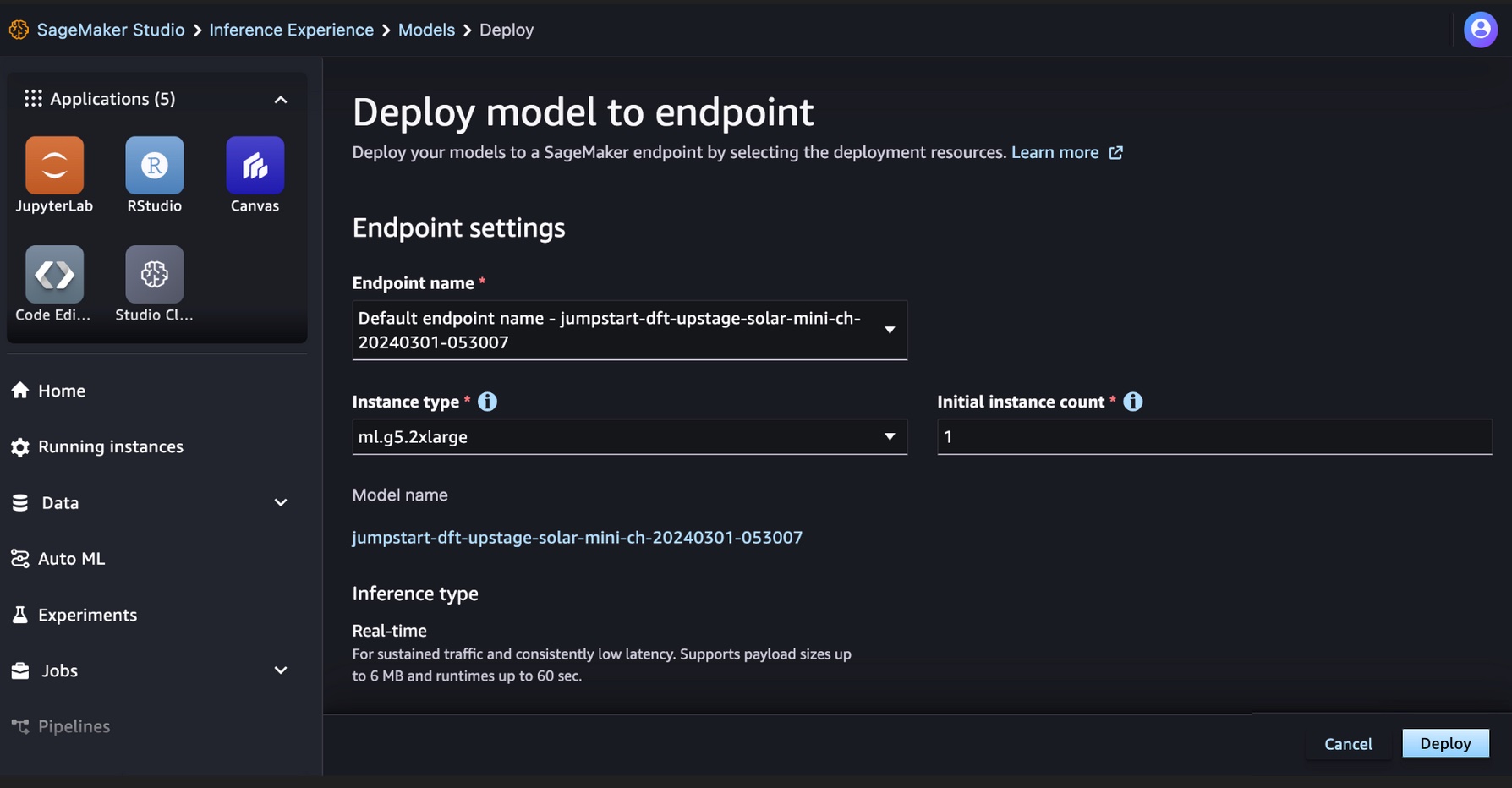

Nachdem Sie das Modell abonniert haben, können Sie Ihr Modell auf einem SageMaker-Endpunkt bereitstellen, indem Sie die Bereitstellungsressourcen auswählen, z. B. den Instanztyp und die Anzahl der anfänglichen Instanzen. Wählen Deploy und warten Sie, bis ein Endpunkt für die Modellinferenz erstellt wird. Sie können eine auswählen ml.g5.2xlarge beispielsweise als günstigere Option für die Schlussfolgerung mit dem Solarmodell.

Wenn Ihr SageMaker-Endpunkt erfolgreich erstellt wurde, können Sie ihn in den verschiedenen SageMaker-Anwendungsumgebungen testen.

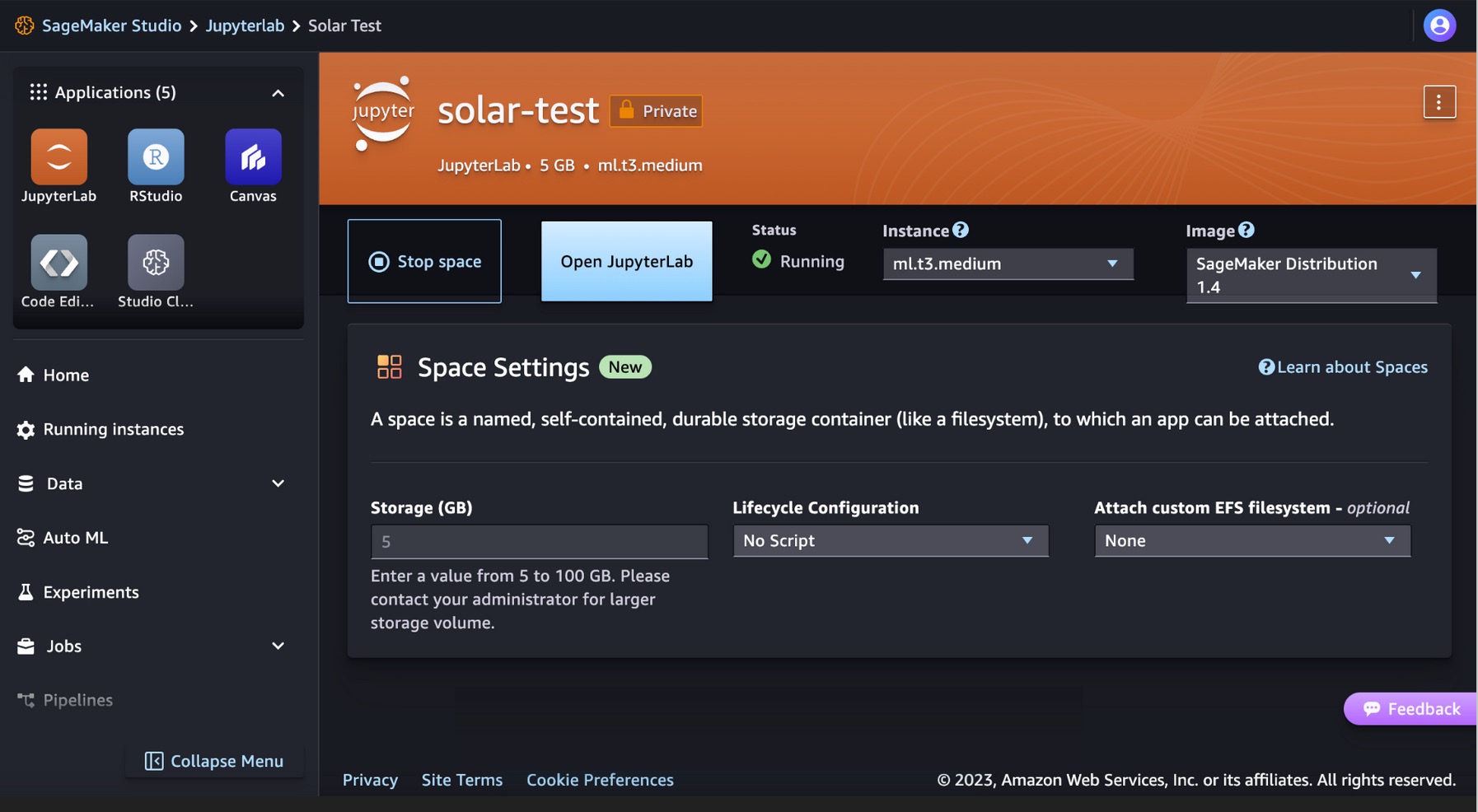

Führen Sie Ihren Code für Solarmodelle in SageMaker Studio JupyterLab aus

SageMaker Studio unterstützt verschiedene Anwendungsentwicklungsumgebungen, darunter JupyterLab, eine Reihe von Funktionen, die das vollständig verwaltete Notebook-Angebot erweitern. Es umfasst Kernel, die in Sekundenschnelle starten, eine vorkonfigurierte Laufzeit mit populärer Datenwissenschaft, ML-Frameworks und leistungsstarken privaten Blockspeicher. Weitere Informationen finden Sie unter SageMaker JupyterLab.

Erstellen Sie in SageMaker Studio einen JupyterLab-Bereich, der die Speicher- und Rechenressourcen verwaltet, die zum Ausführen der JupyterLab-Anwendung erforderlich sind.

Sie finden den Code, der die Bereitstellung von Solarmodellen zeigt, auf SageMaker JumpStart und ein Beispiel für die Verwendung des bereitgestellten Modells im GitHub Repo. Sie können das Modell jetzt mit SageMaker JumpStart bereitstellen. Der folgende Code verwendet die Standardinstanz ml.g5.2xlarge für den Solar Mini Chat – Quant-Modellinferenzendpunkt.

Solarmodelle unterstützen eine Anforderungs-/Antwortnutzlast, die mit dem Chat-Abschlussendpunkt von OpenAI kompatibel ist. Sie können Single-Turn- oder Multi-Turn-Chat-Beispiele mit Python testen.

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print resultSie haben erfolgreich eine Echtzeitinferenz mit dem Solar Mini Chat-Modell durchgeführt.

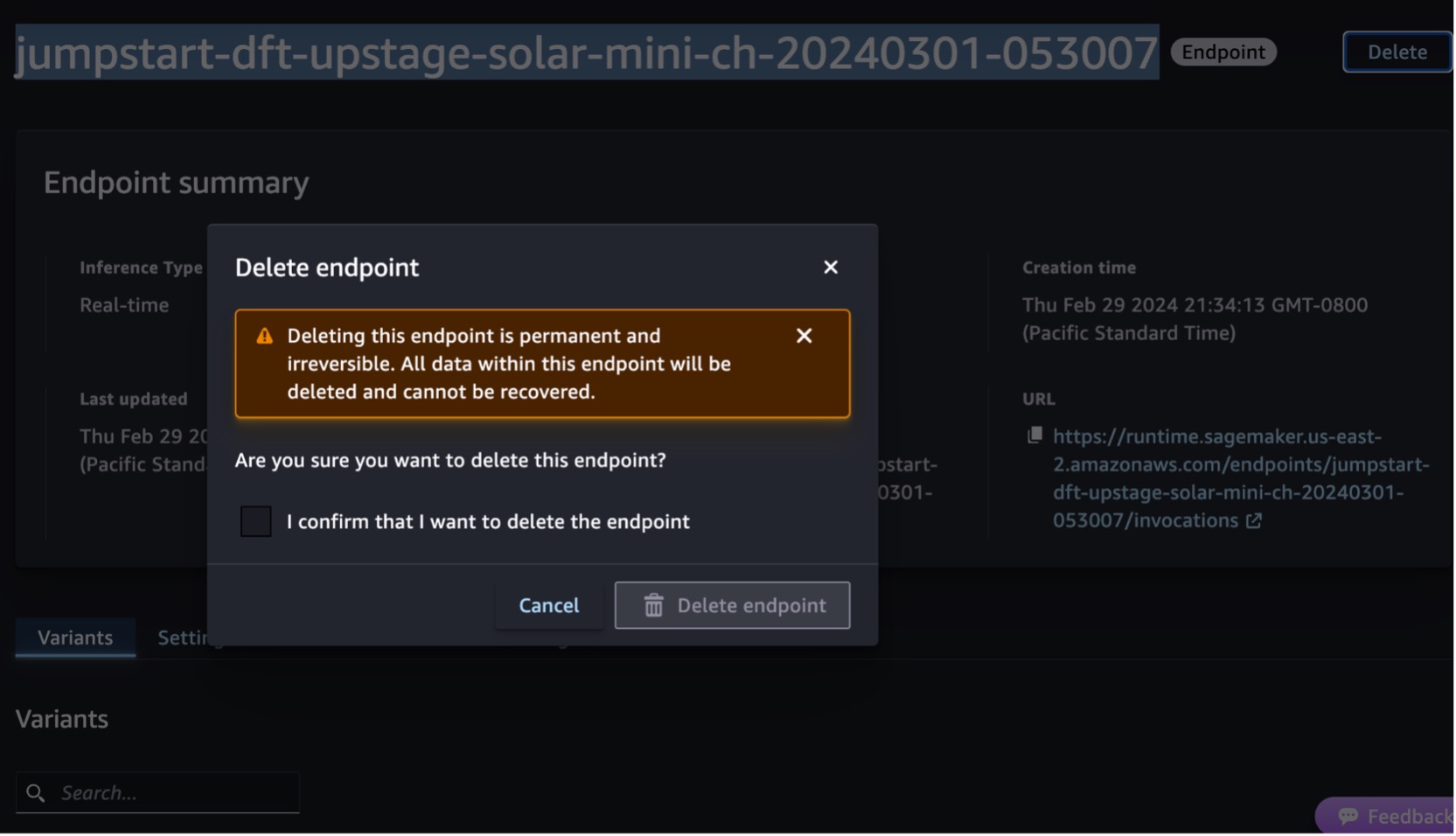

Aufräumen

Nachdem Sie den Endpunkt getestet haben, löschen Sie den SageMaker-Inferenzendpunkt und das Modell, um zu vermeiden, dass Gebühren anfallen.

Sie können auch den folgenden Code ausführen, um den Endpunkt und Modus im Notebook von SageMaker Studio JupyterLab zu löschen:

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()Für weitere Informationen, siehe Endpunkte und Ressourcen löschen. Darüber hinaus können Sie Fahren Sie die SageMaker Studio-Ressourcen herunter die nicht mehr benötigt werden.

Zusammenfassung

In diesem Beitrag haben wir Ihnen gezeigt, wie Sie mit den Solarmodellen von Upstage in SageMaker Studio beginnen und das Modell für Inferenzen bereitstellen. Wir haben Ihnen auch gezeigt, wie Sie Ihren Python-Beispielcode auf SageMaker Studio JupyterLab ausführen können.

Da Solarmodelle bereits vorab trainiert sind, können sie dazu beitragen, die Schulungs- und Infrastrukturkosten zu senken und eine individuelle Anpassung Ihrer generativen KI-Anwendungen zu ermöglichen.

Probieren Sie es aus SageMaker JumpStart-Konsole or SageMaker Studio-Konsole! Sie können sich auch das folgende Video ansehen: Probieren Sie „Solar“ mit Amazon SageMaker aus.

Diese Anleitung dient nur zu Informationszwecken. Sie sollten dennoch Ihre eigene unabhängige Bewertung durchführen und Maßnahmen ergreifen, um sicherzustellen, dass Sie Ihre eigenen spezifischen Qualitätskontrollpraktiken und -standards sowie die lokalen Regeln, Gesetze, Vorschriften, Lizenzen und Nutzungsbedingungen einhalten, die für Sie, Ihre Inhalte usw. gelten. und das in dieser Anleitung genannte Drittanbietermodell. AWS hat keine Kontrolle oder Autorität über das in dieser Anleitung genannte Drittanbietermodell und gibt keine Zusicherungen oder Gewährleistungen dafür, dass das Drittanbietermodell sicher, virenfrei, betriebsbereit oder mit Ihrer Produktionsumgebung und Ihren Standards kompatibel ist. AWS gibt keine Zusicherungen, Gewährleistungen oder Garantien dafür, dass die Informationen in dieser Anleitung zu einem bestimmten Ergebnis oder Ergebnis führen werden.

Über die Autoren

Channy Yun ist Principal Developer Advocate bei AWS und unterstützt Entwickler mit Leidenschaft beim Aufbau moderner Anwendungen auf den neuesten AWS-Services. Er ist im Herzen ein pragmatischer Entwickler und Blogger und liebt das gemeinschaftliche Lernen und den Austausch von Technologie.

Channy Yun ist Principal Developer Advocate bei AWS und unterstützt Entwickler mit Leidenschaft beim Aufbau moderner Anwendungen auf den neuesten AWS-Services. Er ist im Herzen ein pragmatischer Entwickler und Blogger und liebt das gemeinschaftliche Lernen und den Austausch von Technologie.

Hwalsuk Lee ist Chief Technology Officer (CTO) bei Upstage. Er hat als KI-Forscher für Samsung Techwin, NCSOFT und Naver gearbeitet. Er promoviert in Computer- und Elektrotechnik am Korea Advanced Institute of Science and Technology (KAIST).

Hwalsuk Lee ist Chief Technology Officer (CTO) bei Upstage. Er hat als KI-Forscher für Samsung Techwin, NCSOFT und Naver gearbeitet. Er promoviert in Computer- und Elektrotechnik am Korea Advanced Institute of Science and Technology (KAIST).

Brandon Lee ist Senior Solutions Architect bei AWS und unterstützt hauptsächlich große Kunden im Bereich Bildungstechnologie im öffentlichen Sektor. Er verfügt über mehr als 20 Jahre Erfahrung in der Leitung der Anwendungsentwicklung bei globalen Unternehmen und Großkonzernen.

Brandon Lee ist Senior Solutions Architect bei AWS und unterstützt hauptsächlich große Kunden im Bereich Bildungstechnologie im öffentlichen Sektor. Er verfügt über mehr als 20 Jahre Erfahrung in der Leitung der Anwendungsentwicklung bei globalen Unternehmen und Großkonzernen.

- SEO-gestützte Content- und PR-Distribution. Holen Sie sich noch heute Verstärkung.

- PlatoData.Network Vertikale generative KI. Motiviere dich selbst. Hier zugreifen.

- PlatoAiStream. Web3-Intelligenz. Wissen verstärkt. Hier zugreifen.

- PlatoESG. Kohlenstoff, CleanTech, Energie, Umwelt, Solar, Abfallwirtschaft. Hier zugreifen.

- PlatoHealth. Informationen zu Biotechnologie und klinischen Studien. Hier zugreifen.

- Quelle: https://aws.amazon.com/blogs/machine-learning/solar-models-from-upstage-are-now-available-in-amazon-sagemaker-jumpstart/

- :hast

- :Ist

- :nicht

- :Wo

- 10

- 120

- 152

- 20

- 20 Jahre

- 2023

- 7

- 990

- a

- Fähigkeit

- Über uns

- Akzeptieren

- Zugang

- über

- Zusatz

- zusätzlich

- geschickt

- advanced

- Anwalt

- Zustimmung

- AI

- Algorithmen

- Alle

- erlaubt

- entlang

- bereits

- ebenfalls

- Amazon

- Amazon Sage Maker

- Amazon SageMaker-JumpStart

- Amazon Web Services

- an

- machen

- und Infrastruktur

- Bekannt geben

- jedem

- Anwendung

- Anwendungsentwicklung

- Anwendungen

- Jetzt bewerben

- genehmigt

- Architektur

- SIND

- AS

- Bewertung

- Assistentin

- At

- vermehren

- Autorität

- verfügbar

- vermeiden

- AWS

- AWS-Marktplatz

- Bar

- basierend

- BE

- war

- Blockieren

- Blog

- Körper

- Brandon

- bauen

- Building

- eingebaut

- aber

- by

- namens

- CAN

- Fähigkeiten

- Karte

- sicher

- Gebühren

- Chat

- billiger

- Chef

- Chief Technology Officer

- Auswählen

- klarer

- Code

- Kommunikation

- Von der Gemeinschaft angetrieben

- kompakt

- Unternehmen

- vergleichbar

- kompatibel

- Abschluss

- entsprechen

- Bestehend

- Berechnen

- Computer

- Konsul (Console)

- Inhalt

- weiter

- Smartgeräte App

- Gespräche

- Konzerne

- Kosten

- zählen

- erstellen

- erstellt

- CTO

- Kunden

- Anpassung

- technische Daten

- Datenwissenschaft

- Dezember

- Standard

- liefert

- demonstrieren

- einsetzen

- Einsatz

- Bereitstellen

- Einsatz

- Details

- entwickelt

- Entwickler:in / Unternehmen

- Entwickler

- Entwicklung

- Direkt

- entdeckt,

- die

- Domains

- nach unten

- Bildungs-

- effektiv

- effizient

- erhebt

- beschäftigt

- ermöglichen

- Ende

- Endpunkt

- Entwicklung

- Englisch

- verbesserte

- gewährleisten

- Gewährleistung

- Enter

- Arbeitsumfeld

- Umgebungen

- Beispiel

- Beispiele

- aufgeregt

- ERFAHRUNGEN

- verlängert

- Gesicht

- beschleunigt

- Weniger

- Abbildung

- Finden Sie

- Folgende

- Aussichten für

- Foundation

- Gerüste

- für

- voll

- Funktion

- generativ

- Generative KI

- bekommen

- Global

- Go

- Griff

- Garantien

- die Vermittlung von Kompetenzen,

- Griff

- Haben

- he

- Herz

- Hilfe

- hilfreich

- Unternehmen

- hilft

- hier

- Hohe Leistungsfähigkeit

- seine

- gehostet

- Ultraschall

- Hilfe

- HTML

- HTTPS

- Nabe

- if

- zeigt

- in

- Dazu gehören

- Einschließlich

- unabhängig

- Information

- Informational

- Infrastruktur

- Anfangs-

- Varianten des Eingangssignals:

- Eingänge

- Instanz

- Institut

- integriert

- Interaktionen

- interaktive

- in

- IT

- SEINE

- jpg

- JSON

- Korea

- Koreanisch

- Landung

- Sprache

- Sprachen

- grosse

- neueste

- Gesetze

- Leaderboard

- führenden

- lernen

- Lee

- Lizenz

- Lizenzen

- Listen

- Lama

- LLM

- aus einer regionalen

- länger

- liebt

- senken

- Maschine

- Maschinelles Lernen

- gemacht

- um

- Making

- verwaltet

- Managed

- Marktplatz

- Maßnahmen

- Merge

- Nachrichten

- Meta

- Methode

- Methoden

- Metrik

- ML

- Model

- Modell

- für

- modern

- mehr

- effizienter

- viel

- Natürliche

- Verarbeitung natürlicher Sprache

- Naver

- Navigation

- erforderlich

- nicht

- vor allem

- Notizbuch

- jetzt an

- Abschattung

- of

- bieten

- bieten

- Offizier

- on

- einzige

- XNUMXh geöffnet

- Betriebs-

- optimiert

- Option

- or

- Andere

- Ergebnis

- Übertrifft

- übrig

- besitzen

- Seite

- Brot

- Parameter

- besondere

- besonders

- leidenschaftlich

- Ausführen

- Leistung

- durchgeführt

- phd

- für Ihre privaten Foto

- Höhepunkt

- Plato

- Datenintelligenz von Plato

- PlatoData

- Beliebt

- Post

- größte treibende

- Praktiken

- pragmatisch

- präzise

- Vorbereitung

- gebühr

- in erster Linie

- Principal

- privat

- Aufgabenstellung:

- Verarbeitung

- Produkt

- Produktion

- die

- bietet

- Öffentlichkeit

- Zwecke

- Python

- Qualität

- Quant

- schnell

- Angebot

- Erreichen

- echt

- Echtzeit

- Aufzeichnungen

- referenziert

- Vorschriften

- falls angefordert

- erfordert

- Forscher

- Auflösung

- Downloads

- Antwort

- Antworten

- Folge

- Rückkehr

- Überprüfen

- Rollen

- Ohne eine erfahrene Medienplanung zur Festlegung von Regeln und Strategien beschleunigt der programmatische Medieneinkauf einfach die Rate der verschwenderischen Ausgaben.

- Führen Sie

- Laufzeit

- sagemaker

- SageMaker-Inferenz

- Sample

- Samsung

- Skalierung

- Wissenschaft

- Wissenschaft und Technologie

- Skript

- Suche

- Sekunden

- Bibliotheken

- Verbindung

- sehen

- wählen

- Auswahl

- Senior

- Dienstleistungen

- kompensieren

- ,,teilen"

- sollte

- zeigte

- zeigt

- bedeutend

- Größe

- kleinere

- Solar-

- Lösungen

- einige

- Raumfahrt

- spezialisieren

- spezifisch

- speziell

- Normen

- Anfang

- begonnen

- Shritte

- Immer noch

- Lagerung

- einfach

- Struktur

- Studio Adressen

- Abonnieren

- Abonnement

- Erfolgreich

- so

- Support

- Unterstützt

- sicher

- System

- Nehmen

- nimmt

- und Aufgaben

- Technologie

- AGB

- Test

- getestet

- als

- zur Verbesserung der Gesundheitsgerechtigkeit

- Das

- Diese

- vom Nutzer definierten

- basierte Online-to-Offline-Werbezuordnungen von anderen gab.

- fehlen uns die Worte.

- Durch

- Zeit

- mal

- zu

- Werkzeuge

- verfolgen sind

- Training

- Ausbildung

- XNUMX

- tippe

- -

- benutzt

- Mitglied

- verwendet

- Verwendung von

- verschiedene

- vielseitig

- Version

- Video

- Anzeigen

- warten

- Spaziergang

- Gewährleistungen

- Ansehen

- Wellen

- we

- Netz

- Web-Services

- Webbasiert

- welche

- breit

- Große Auswahl

- werden wir

- mit

- .

- gearbeitet

- Jahr

- Du

- Ihr

- Youtube

- Zephyrnet