Die optische Zeichenerkennung (OCR) ist die Aufgabe, gedruckten oder handgeschriebenen Text in maschinell kodierten Text umzuwandeln. OCR wurde in verschiedenen Szenarien, wie z. B. Dokumentenelektronisierung und Identitätsauthentifizierung, weit verbreitet. Da OCR den manuellen Aufwand zum Registrieren wichtiger Informationen erheblich reduzieren und als Einstiegsschritt zum Verständnis großer Dokumentenmengen dienen kann, spielt ein genaues OCR-System im Zeitalter der digitalen Transformation eine entscheidende Rolle.

Die Open-Source-Community und Forscher konzentrieren sich darauf, die OCR-Genauigkeit, Benutzerfreundlichkeit, Integration mit vortrainierten Modellen, Erweiterung und Flexibilität zu verbessern. Unter vielen vorgeschlagenen Frameworks hat PaddleOCR in letzter Zeit zunehmend an Aufmerksamkeit gewonnen. Der vorgeschlagene Rahmen konzentriert sich darauf, eine hohe Genauigkeit zu erreichen und gleichzeitig die Recheneffizienz auszugleichen. Darüber hinaus machen die vortrainierten Modelle für Chinesisch und Englisch es auf dem chinesischsprachigen Markt beliebt. Siehe die PaddleOCR GitHub-Repository für weitere Informationen an.

Bei AWS haben wir auch integrierte KI-Services vorgeschlagen, die ohne Fachwissen im Bereich maschinelles Lernen (ML) einsatzbereit sind. Um Text und strukturierte Daten wie Tabellen und Formulare aus Dokumenten zu extrahieren, können Sie verwenden Amazontext. Es verwendet ML-Techniken, um jede Art von Dokument zu lesen und zu verarbeiten und Text, Handschrift, Tabellen und andere Daten ohne manuellen Aufwand genau zu extrahieren.

Für Datenwissenschaftler, die die Flexibilität wünschen, ein Open-Source-Framework zur Entwicklung ihres eigenen OCR-Modells zu verwenden, bieten wir auch den vollständig verwalteten ML-Service an Amazon Sage Maker. SageMaker ermöglicht es Ihnen, MLOps Best Practices während des gesamten ML-Lebenszyklus zu implementieren, und stellt Vorlagen und Toolsets bereit, um das undifferenzierte schwere Heben zu reduzieren, um ML-Projekte in die Produktion zu bringen.

In diesem Beitrag konzentrieren wir uns auf die Entwicklung benutzerdefinierter Modelle innerhalb des PaddleOCR-Frameworks auf SageMaker. Wir gehen durch den ML-Entwicklungslebenszyklus, um zu veranschaulichen, wie SageMaker Ihnen helfen kann, ein Modell zu erstellen und zu trainieren und das Modell schließlich als Webdienst bereitzustellen. Obwohl wir diese Lösung mit PaddleOCR veranschaulichen, gilt die allgemeine Anleitung für beliebige Frameworks, die auf SageMaker verwendet werden sollen. Begleitend zu diesem Beitrag stellen wir auch Beispielcode in der GitHub-Repository.

PaddleOCR-Framework

Als weit verbreitetes OCR-Framework enthält PaddleOCR Rich-Text-Erkennung, Texterkennung und End-to-End-Algorithmen. Es wählt Differentiable Binarization (DB) und Convolutional Recurrent Neural Network (CRNN) als grundlegende Erkennungs- und Erkennungsmodelle und schlägt eine Reihe von Modellen mit dem Namen PP-OCR für industrielle Anwendungen nach einer Reihe von Optimierungsstrategien vor.

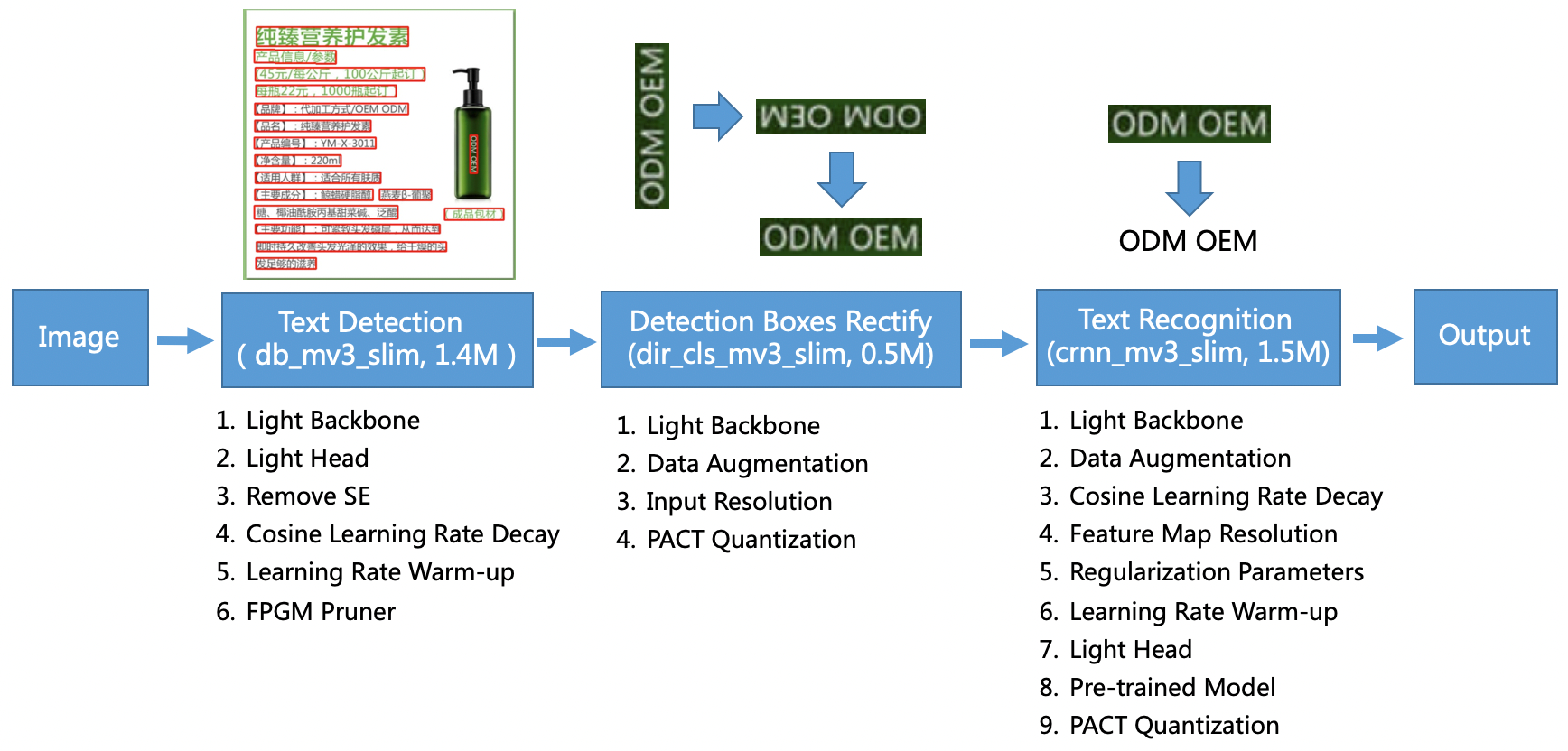

Das PP-OCR-Modell zielt auf allgemeine Szenarien ab und bildet eine Modellbibliothek verschiedener Sprachen. Es besteht aus drei Teilen: Texterkennung, Box-Erkennung und -Korrektur und Texterkennung, dargestellt in der folgenden Abbildung auf PaddleOCR offizielles GitHub-Repository. Sie können auch auf die Forschungsarbeit verweisen PP-OCR: Ein praktisches, ultraleichtes OCR-System um mehr zu erfahren.

Genauer gesagt besteht PaddleOCR aus drei aufeinanderfolgenden Aufgaben:

- Texterkennung – Der Zweck der Texterkennung besteht darin, den Textbereich im Bild zu lokalisieren. Solche Aufgaben können auf einem einfachen Segmentierungsnetzwerk basieren.

- Box-Erkennung und -Behebung – Jedes Textfeld muss für die spätere Texterkennung in ein horizontales Rechteck umgewandelt werden. Dazu schlägt PaddleOCR vor, einen Textrichtungsklassifikator (Bildklassifizierungsaufgabe) zu trainieren, um die Textrichtung zu bestimmen.

- Texterkennung – Nachdem das Textfeld erkannt wurde, führt das Texterkennungsmodell eine Inferenz für jedes Textfeld durch und gibt die Ergebnisse entsprechend der Position des Textfelds aus. PaddleOCR übernimmt die weit verbreitete Methode CRNN.

PaddleOCR bietet hochwertige vortrainierte Modelle, die mit kommerziellen Effekten vergleichbar sind. Sie können entweder das vortrainierte Modell für ein Erkennungsmodell, einen Richtungsklassifikator oder ein Erkennungsmodell verwenden, oder Sie können jedes einzelne Modell für Ihren Anwendungsfall optimieren und neu trainieren. Um die Effizienz und Effektivität bei der Erkennung von traditionellem Chinesisch und Englisch zu steigern, veranschaulichen wir, wie Sie das Texterkennungsmodell optimieren können. Das von uns gewählte vortrainierte Modell ist ch_ppocr_mobile_v2.0_rec_train, ein leichtes Modell, das Chinesisch, Englisch und Zahlenerkennung unterstützt. Das Folgende ist ein Beispiel für ein Inferenzergebnis unter Verwendung eines Personalausweises aus Hongkong.

In den folgenden Abschnitten gehen wir durch die Feinabstimmung des vortrainierten Modells mit SageMaker.

Best Practices für MLOps mit SageMaker

SageMaker ist ein vollständig verwalteter ML-Dienst. Mit SageMaker können Data Scientists und Entwickler schnell und einfach ML-Modelle erstellen und trainieren und diese dann direkt in einer produktionsbereiten verwalteten Umgebung bereitstellen.

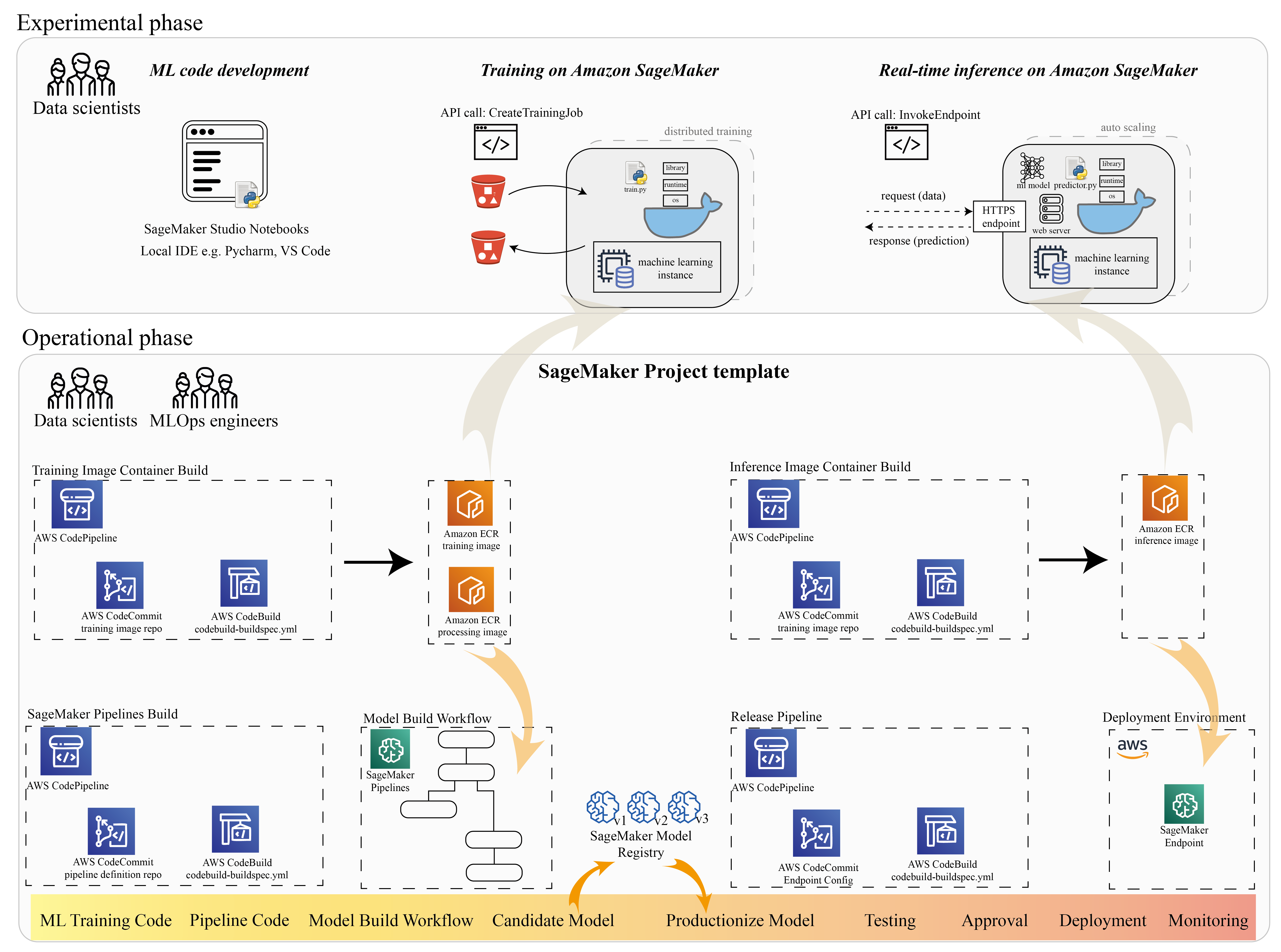

Viele Data Scientists verwenden SageMaker, um den ML-Lebenszyklus zu beschleunigen. In diesem Abschnitt veranschaulichen wir, wie SageMaker Ihnen vom Experimentieren bis zur Produktionsreife von ML helfen kann. Befolgen Sie die Standardschritte eines ML-Projekts, von der experimentellen Formulierung (Codeentwicklung und Experimente) bis zur operativen Formulierung (Automatisierung des Modellerstellungs-Workflows und der Bereitstellungspipelines), kann SageMaker die Effizienz in den folgenden Schritten steigern:

- Untersuchen Sie die Daten und erstellen Sie den ML-Code mit Amazon SageMaker-Studio Notizbücher

- Trainieren und tunen Sie das Modell mit einem SageMaker-Trainingsjob.

- Stellen Sie das Modell mit einem SageMaker-Endpunkt für die Modellbereitstellung bereit.

- Orchestrieren Sie den Workflow mit Amazon SageMaker-Pipelines.

Das folgende Diagramm veranschaulicht diese Architektur und diesen Workflow.

Es ist wichtig zu beachten, dass Sie SageMaker modular verwenden können. Beispielsweise können Sie Ihren Code mit einer lokalen integrierten Entwicklungsumgebung (IDE) erstellen und Ihr Modell auf SageMaker trainieren und bereitstellen, oder Sie können Ihr Modell in Ihren eigenen Cluster-Rechenquellen entwickeln und trainieren und eine SageMaker-Pipeline für die Workflow-Orchestrierung und verwenden Bereitstellung auf einem SageMaker-Endpunkt. Das bedeutet, dass SageMaker eine offene Plattform bietet, die Sie an Ihre eigenen Anforderungen anpassen können.

Siehe den Code in unserer GitHub-Repository und README, um die Codestruktur zu verstehen.

Stellen Sie ein SageMaker-Projekt bereit

Sie können verwenden Amazon SageMaker-Projekte um deine Reise zu beginnen. Mit einem SageMaker-Projekt können Sie die Versionen für Ihre Git-Repositories verwalten, sodass Sie teamübergreifend effizienter zusammenarbeiten, Codekonsistenz sicherstellen und Continuous Integration und Continuous Delivery (CI/CD) ermöglichen können. Obwohl Notebooks für die Modellerstellung und Experimente hilfreich sind, benötigen Sie, wenn ein Team aus Data Scientists und ML-Ingenieuren an einem ML-Problem arbeitet, eine besser skalierbare Methode, um die Codekonsistenz zu wahren und eine strengere Versionskontrolle zu haben.

SageMaker-Projekte erstellen eine vorkonfigurierte MLOps-Vorlage, die die wesentlichen Komponenten zur Vereinfachung der PaddleOCR-Integration enthält:

- Ein Code-Repository zum Erstellen benutzerdefinierter Container-Images für Verarbeitung, Training und Inferenz, integriert in CI/CD-Tools. Dies ermöglicht es uns, unser benutzerdefiniertes Docker-Image zu konfigurieren und zu pushen Amazon Elastic Container-Registrierung (Amazon ECR) einsatzbereit sein.

- Eine SageMaker-Pipeline, die Schritte für die Datenvorbereitung, das Training, die Modellbewertung und die Modellregistrierung definiert. Dies bereitet uns darauf vor, MLOps bereit zu sein, wenn das ML-Projekt in Produktion geht.

- Andere nützliche Ressourcen, wie z. B. ein Git-Repository für die Codeversionskontrolle, eine Modellgruppe, die Modellversionen enthält, einen Codeänderungsauslöser für die Modellerstellungspipeline und einen ereignisbasierten Auslöser für die Modellbereitstellungspipeline.

Sie können SageMaker-Seed-Code verwenden, um Standard-SageMaker-Projekte oder eine bestimmte Vorlage zu erstellen, die Ihre Organisation für Teammitglieder erstellt hat. In diesem Beitrag verwenden wir den Standard MLOps-Vorlage für die Imageerstellung, Modellerstellung und Modellbereitstellung. Weitere Informationen zum Erstellen eines Projekts in Studio finden Sie unter Erstellen Sie ein MLOps-Projekt mit Amazon SageMaker Studio.

Untersuchen Sie Daten und erstellen Sie ML-Code mit SageMaker Studio Notebooks

SageMaker Studio-Notebooks sind kollaborative Notebooks, die Sie schnell starten können, da Sie keine Compute-Instanzen und keinen Dateispeicher im Voraus einrichten müssen. Viele Data Scientists ziehen es vor, diese webbasierte IDE zu verwenden, um den ML-Code zu entwickeln, die Bibliotheks-API schnell zu debuggen und die Dinge mit einer kleinen Datenprobe zum Laufen zu bringen, um das Trainingsskript zu validieren.

In Studio-Notebooks können Sie eine vorgefertigte Umgebung für gängige Frameworks wie TensorFlow, PyTorch, Pandas und Scikit-Learn verwenden. Sie können die Abhängigkeiten zum vorgefertigten Kernel installieren oder Ihr eigenes persistentes Kernel-Image erstellen. Weitere Informationen finden Sie unter Installieren Sie externe Bibliotheken und Kernel in Amazon SageMaker Studio. Studio-Notebooks bieten auch eine Python-Umgebung zum Auslösen von SageMaker-Schulungsaufträgen, -Bereitstellungen oder anderen AWS-Services. In den folgenden Abschnitten veranschaulichen wir, wie Sie Studio-Notebooks als Umgebung zum Auslösen von Schulungs- und Bereitstellungsaufträgen verwenden.

SageMaker bietet eine leistungsstarke IDE; Es ist eine offene ML-Plattform, auf der Data Scientists die Flexibilität haben, ihre bevorzugte Entwicklungsumgebung zu verwenden. Für Data Scientists, die eine lokale IDE wie PyCharm oder Visual Studio Code bevorzugen, können Sie die lokale Python-Umgebung verwenden, um Ihren ML-Code zu entwickeln, und SageMaker für das Training in einer verwalteten, skalierbaren Umgebung verwenden. Weitere Informationen finden Sie unter Führen Sie Ihren TensorFlow-Job auf Amazon SageMaker mit einer PyCharm-IDE aus. Nachdem Sie ein solides Modell haben, können Sie die Best Practices für MLOps mit SageMaker übernehmen.

Derzeit bietet SageMaker auch SageMaker-Notebook-Instanzen als unsere Legacy-Lösung für die Jupyter Notebook-Umgebung. Sie haben die Flexibilität, den Docker-Build-Befehl auszuführen und Verwenden Sie den lokalen Modus von SageMaker, um auf Ihrer Notebook-Instance zu trainieren. Wir bieten auch Beispielcode für PaddleOCR in unserem Code-Repository an: ./train_and_deploy/notebook.ipynb.

Erstellen Sie ein benutzerdefiniertes Image mit einer SageMaker-Projektvorlage

SageMaker macht umfassenden Gebrauch von Docker-Containern für Build- und Laufzeitaufgaben. Mit SageMaker können Sie ganz einfach Ihren eigenen Container betreiben. Weitere technische Details finden Sie unter Verwenden Sie Ihre eigenen Trainingsalgorithmen.

Als Datenwissenschaftler ist das Erstellen eines Containers jedoch möglicherweise nicht einfach. SageMaker-Projekte bieten Ihnen eine einfache Möglichkeit, benutzerdefinierte Abhängigkeiten über eine Image-Erstellungs-CI/CD-Pipeline zu verwalten. Wenn Sie ein SageMaker-Projekt verwenden, können Sie mit Ihrem benutzerdefinierten Container-Dockerfile Aktualisierungen am Trainings-Image vornehmen. Eine Schritt-für-Schritt-Anleitung finden Sie unter Erstellen Sie Amazon SageMaker-Projekte mit Image-Building-CI/CD-Pipelines. Mit der in der Vorlage bereitgestellten Struktur können Sie den bereitgestellten Code in diesem Repository ändern, um einen PaddleOCR-Trainingscontainer zu erstellen.

In diesem Beitrag zeigen wir, wie einfach es ist, ein benutzerdefiniertes Image für die Verarbeitung, das Training und die Inferenz zu erstellen. Das GitHub-Repo enthält drei Ordner:

Diese Projekte folgen einer ähnlichen Struktur. Nehmen Sie das Trainingscontainer-Image als Beispiel; das image-build-train/ Das Repository enthält die folgenden Dateien:

- Die Datei codebuild-buildspec.yml, die zum Konfigurieren verwendet wird AWS CodeBuild damit das Image erstellt und an Amazon ECR übertragen werden kann.

- Das für den Docker-Build verwendete Dockerfile, das alle Abhängigkeiten und den Trainingscode enthält.

- Der train.py-Einstiegspunkt für das Trainingsskript mit allen Hyperparametern (z. B. Lernrate und Stapelgröße), die als Argument konfiguriert werden können. Diese Argumente werden angegeben, wenn Sie den Trainingsjob starten.

- Die Abhängigkeiten.

Wenn Sie den Code in das entsprechende Repository pushen, wird er ausgelöst AWS CodePipeline einen Schulungscontainer für Sie zu bauen. Das benutzerdefinierte Container-Image wird in einem Amazon ECR-Repository gespeichert, wie in der vorherigen Abbildung dargestellt. Ein ähnliches Verfahren wird zum Erzeugen des Inferenzbildes angewendet.

Trainieren Sie das Modell mit dem SageMaker-Trainings-SDK

Nachdem Ihr Algorithmuscode validiert und in einen Container gepackt wurde, können Sie einen SageMaker-Trainingsauftrag verwenden, um eine verwaltete Umgebung zum Trainieren des Modells bereitzustellen. Diese Umgebung ist ephemer, was bedeutet, dass Sie separate, sichere Rechenressourcen (z. B. GPU) oder eine verteilte Umgebung mit mehreren GPUs haben können, um Ihren Code auszuführen. Wenn das Training abgeschlossen ist, speichert SageMaker die resultierenden Modellartefakte in einer Amazon Simple Storage-Service (Amazon S3) Speicherort, den Sie angeben. Alle Protokolldaten und Metadaten bleiben auf der AWS-Managementkonsole, Studio und Amazon CloudWatch.

Der Ausbildungsauftrag enthält mehrere wichtige Informationen:

- Die URL des S3-Buckets, in dem Sie die Trainingsdaten gespeichert haben

- Die URL des S3-Buckets, in dem Sie die Ausgabe des Jobs speichern möchten

- Die verwalteten Rechenressourcen, die SageMaker für das Modelltraining verwenden soll

- Der Amazon ECR-Pfad, in dem der Trainingscontainer gespeichert ist

Weitere Informationen zu Ausbildungsberufen finden Sie unter Modelle trainieren. Den Beispielcode für den Trainingsjob finden Sie unter experimente-train-notebook.ipynb.

SageMaker macht die Hyperparameter in a CreateTrainingJob Anfrage verfügbar im Docker-Container in der /opt/ml/input/config/hyperparameters.json Datei.

Wir verwenden den benutzerdefinierten Trainingscontainer als Einstiegspunkt und spezifizieren eine GPU-Umgebung für die Infrastruktur. Alle relevanten Hyperparameter sind als Parameter detailliert aufgeführt, was es uns ermöglicht, jede einzelne Jobkonfiguration zu verfolgen und mit der Versuchsverfolgung zu vergleichen.

Da der Data-Science-Prozess sehr forschungsorientiert ist, ist es üblich, dass mehrere Experimente parallel laufen. Dies erfordert einen Ansatz, der all die verschiedenen Experimente, verschiedenen Algorithmen und potenziell verschiedenen Datensätze und Hyperparameter verfolgt, die versucht wurden. Mit Amazon SageMaker Experiments können Sie Ihre ML-Experimente organisieren, verfolgen, vergleichen und auswerten. Auch das demonstrieren wir in experimente-train-notebook.ipynb. Weitere Einzelheiten finden Sie unter Verwalten Sie maschinelles Lernen mit Amazon SageMaker-Experimenten.

Stellen Sie das Modell für die Modellbereitstellung bereit

Bei der Bereitstellung, insbesondere bei der Bereitstellung von Echtzeitmodellen, fällt es vielen Datenwissenschaftlern möglicherweise schwer, auf die Hilfe von Betriebsteams zu verzichten. SageMaker vereinfacht die Bereitstellung Ihres trainierten Modells in der Produktion mit dem SageMaker Python-SDK. Sie können Ihr Modell für SageMaker-Hosting-Services bereitstellen und erhalten einen Endpunkt, den Sie für Echtzeit-Inferenzen verwenden können.

In vielen Organisationen sind Data Scientists möglicherweise nicht für die Wartung der Endpunktinfrastruktur verantwortlich. Das Testen Ihres Modells als Endpunkt und die Gewährleistung des korrekten Vorhersageverhaltens liegt jedoch in der Tat in der Verantwortung von Data Scientists. Daher hat SageMaker die Aufgaben für die Bereitstellung vereinfacht, indem eine Reihe von Tools und SDKs dafür hinzugefügt wurden.

Für den Anwendungsfall in der Post möchten wir interaktive Echtzeitfunktionen mit geringer Latenz haben. Echtzeit-Inferenz ist ideal für diese Inferenzarbeitslast. Es gibt jedoch viele Optionen, die sich an jede spezifische Anforderung anpassen. Weitere Informationen finden Sie unter Modelle für Inferenz bereitstellen.

Um das benutzerdefinierte Image bereitzustellen, können Data Scientists das SageMaker SDK verwenden, das unter dargestellt ist

experimente-deploy-notebook.ipynb.

Im create_model Anfrage enthält die Containerdefinition die ModelDataUrl -Parameter, der den Amazon S3-Speicherort angibt, an dem Modellartefakte gespeichert werden. SageMaker verwendet diese Informationen, um zu bestimmen, woher die Modellartefakte kopiert werden sollen. Es kopiert die Artefakte in die /opt/ml/model Verzeichnis zur Verwendung durch Ihren Inferenzcode. Das serve und predictor.py ist der Einstiegspunkt für die Bereitstellung mit dem Modellartefakt, das geladen wird, wenn Sie die Bereitstellung starten. Weitere Informationen finden Sie unter Verwenden Sie Ihren eigenen Inferenzcode mit Hosting-Diensten.

Orchestrieren Sie Ihren Workflow mit SageMaker Pipelines

Der letzte Schritt besteht darin, Ihren Code als End-to-End-ML-Workflows zu verpacken und Best Practices für MLOps anzuwenden. In SageMaker wird die Arbeitslast für die Modellerstellung, ein gerichteter azyklischer Graph (DAG), von SageMaker-Pipelines verwaltet. Pipelines ist ein vollständig verwalteter Dienst, der Orchestrierung und Datenherkunftsverfolgung unterstützt. Da Pipelines in das SageMaker-Python-SDK integriert ist, können Sie Ihre Pipelines außerdem programmgesteuert mithilfe einer Python-Schnittstelle auf hoher Ebene erstellen, die wir zuvor während des Trainingsschritts verwendet haben.

Wir stellen ein Beispiel für Pipeline-Code bereit, um die Implementierung unter zu veranschaulichen Pipeline.py.

Die Pipeline umfasst einen Vorverarbeitungsschritt für die Datensatzgenerierung, einen Trainingsschritt, einen Bedingungsschritt und einen Modellregistrierungsschritt. Am Ende jedes Pipeline-Laufs möchten Data Scientists ihr Modell möglicherweise für Versionskontrollen registrieren und das Modell mit der besten Leistung bereitstellen. Die SageMaker-Modellregistrierung bietet einen zentralen Ort, um Modellversionen zu verwalten, Modelle zu katalogisieren und eine automatisierte Modellbereitstellung mit dem Genehmigungsstatus eines bestimmten Modells auszulösen. Weitere Einzelheiten finden Sie unter Registrieren und Bereitstellen von Modellen mit der Modellregistrierung.

In einem ML-System trägt die automatisierte Workflow-Orchestrierung dazu bei, eine Verschlechterung der Modellleistung, mit anderen Worten, eine Modelldrift, zu verhindern. Durch die frühzeitige und proaktive Erkennung von Datenabweichungen können Sie Korrekturmaßnahmen ergreifen, z. B. Modelle neu trainieren. Sie können die SageMaker-Pipeline auslösen, um eine neue Version des Modells neu zu trainieren, nachdem Abweichungen erkannt wurden. Der Auslöser einer Pipeline kann auch bestimmt werden durch Amazon SageMaker-Modellmonitor, das die Qualität der Modelle in der Produktion kontinuierlich überwacht. Mit der Datenerfassungsfunktion zum Aufzeichnen von Informationen unterstützt Model Monitor die Überwachung der Daten- und Modellqualität, Bias und Driftüberwachung der Merkmalszuordnung. Weitere Einzelheiten finden Sie unter Überwachen Sie Modelle auf Daten- und Modellqualität, Verzerrung und Erklärbarkeit.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie das Framework PaddleOCR auf SageMaker für OCR-Aufgaben ausgeführt wird. Um Data Scientists den Einstieg in SageMaker zu erleichtern, haben wir den ML-Entwicklungslebenszyklus durchlaufen, vom Erstellen von Algorithmen über das Training bis hin zum Hosten des Modells als Webdienst für Echtzeit-Inferenz. Sie können den von uns bereitgestellten Vorlagencode verwenden, um ein beliebiges Framework auf die SageMaker-Plattform zu migrieren. Probieren Sie es für Ihr ML-Projekt aus und teilen Sie uns Ihre Erfolgsgeschichten mit.

Über die Autoren

Junyi (Jackie) LIU ist Senior Applied Scientist bei AWS. Sie verfügt über langjährige Berufserfahrung im Bereich Machine Learning. Sie verfügt über reichhaltige praktische Erfahrung in der Entwicklung und Implementierung von Lösungen im Aufbau von Machine-Learning-Modellen im Bereich Lieferketten-Vorhersagealgorithmen, Werbeempfehlungssysteme, OCR- und NLP-Bereich.

Junyi (Jackie) LIU ist Senior Applied Scientist bei AWS. Sie verfügt über langjährige Berufserfahrung im Bereich Machine Learning. Sie verfügt über reichhaltige praktische Erfahrung in der Entwicklung und Implementierung von Lösungen im Aufbau von Machine-Learning-Modellen im Bereich Lieferketten-Vorhersagealgorithmen, Werbeempfehlungssysteme, OCR- und NLP-Bereich.

Yanwei Cui, PhD, ist Lösungsarchitekt für Machine Learning bei AWS. Er begann mit der Forschung zu maschinellem Lernen am IRISA (Research Institute of Computer Science and Random Systems) und verfügt über mehrere Jahre Erfahrung in der Entwicklung von industriellen Anwendungen mit künstlicher Intelligenz in den Bereichen Computer Vision, Verarbeitung natürlicher Sprache und Vorhersage des Online-Benutzerverhaltens. Bei AWS teilt er die Domänenexpertise und hilft Kunden, Geschäftspotenziale zu erschließen und mit maschinellem Lernen in großem Maßstab umsetzbare Ergebnisse zu erzielen. Außerhalb der Arbeit liest und reist er gerne.

Yanwei Cui, PhD, ist Lösungsarchitekt für Machine Learning bei AWS. Er begann mit der Forschung zu maschinellem Lernen am IRISA (Research Institute of Computer Science and Random Systems) und verfügt über mehrere Jahre Erfahrung in der Entwicklung von industriellen Anwendungen mit künstlicher Intelligenz in den Bereichen Computer Vision, Verarbeitung natürlicher Sprache und Vorhersage des Online-Benutzerverhaltens. Bei AWS teilt er die Domänenexpertise und hilft Kunden, Geschäftspotenziale zu erschließen und mit maschinellem Lernen in großem Maßstab umsetzbare Ergebnisse zu erzielen. Außerhalb der Arbeit liest und reist er gerne.

Yi-An CHEN ist Softwareentwicklerin bei Amazon Lab 126. Sie verfügt über mehr als 10 Jahre Erfahrung in der Entwicklung von Produkten, die auf maschinellem Lernen in verschiedenen Disziplinen basieren, darunter Personalisierung, Verarbeitung natürlicher Sprache und Computer Vision. Außerhalb der Arbeit macht sie gerne langes Laufen und Radfahren.

Yi-An CHEN ist Softwareentwicklerin bei Amazon Lab 126. Sie verfügt über mehr als 10 Jahre Erfahrung in der Entwicklung von Produkten, die auf maschinellem Lernen in verschiedenen Disziplinen basieren, darunter Personalisierung, Verarbeitung natürlicher Sprache und Computer Vision. Außerhalb der Arbeit macht sie gerne langes Laufen und Radfahren.

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon Sage Maker

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet