„Intelligente Dokumentenverarbeitungslösungen (IDP) extrahieren Daten, um die Automatisierung von sich wiederholenden Dokumentenverarbeitungsaufgaben mit hohem Volumen sowie für Analysen und Einblicke zu unterstützen. IDP verwendet natürliche Sprachtechnologien und Computer Vision, um Daten aus strukturierten und unstrukturierten Inhalten, insbesondere aus Dokumenten, zu extrahieren, um die Automatisierung und Erweiterung zu unterstützen.“ - Gärtner

Das Ziel der intelligenten Dokumentenverarbeitung (IDP) von Amazon ist es, die Verarbeitung großer Dokumentenmengen mithilfe von maschinellem Lernen (ML) zu automatisieren, um die Produktivität zu steigern, die mit menschlicher Arbeit verbundenen Kosten zu senken und ein nahtloses Benutzererlebnis zu bieten. Kunden verbringen viel Zeit und Mühe damit, Dokumente zu identifizieren und kritische Informationen daraus für verschiedene Anwendungsfälle zu extrahieren. Heute, Amazon verstehen unterstützt die Klassifizierung für Klartextdokumente, was erfordert, dass Sie Dokumente in halbstrukturierten Formaten (gescanntes, digitales PDF oder Bilder wie PNG, JPG, TIFF) vorverarbeiten und dann die Klartextausgabe verwenden, um Inferenzen mit Ihrem auszuführen benutzerdefinierte Klassifizierung Modell. Ebenso z benutzerdefinierte Entitätserkennung In Echtzeit ist für halbstrukturierte Dokumente wie PDF- und Bilddateien eine Vorverarbeitung zum Extrahieren von Text erforderlich. Dieser zweistufige Prozess führt zu Komplexitäten in den Dokumentenverarbeitungs-Workflows.

Letztes Jahr haben wir angekündigte Unterstützung für native Dokumentformate mit benutzerdefinierter Named Entity Recognition (NER) asynchrone Jobs. Wir freuen uns, heute die Ein-Schritt-Dokumentklassifizierung und Echtzeitanalyse für NER für halbstrukturierte Dokumente in nativen Formaten (PDF, TIFF, JPG, PNG) mit Amazon Comprehend ankündigen zu können. Insbesondere kündigen wir die folgenden Funktionen an:

- Unterstützung für Dokumente in nativen Formaten für benutzerdefinierte Klassifizierungs-Echtzeitanalysen und asynchrone Jobs

- Unterstützung für Dokumente in nativen Formaten für benutzerdefinierte Entitätserkennungs-Echtzeitanalysen

Mit dieser neuen Version unterstützt die benutzerdefinierte Klassifizierung und benutzerdefinierte Entitätserkennung (NER) von Amazon Comprehend Dokumente in Formaten wie PDF, TIFF, PNG und JPEG direkt, ohne dass UTF8-codierter Klartext daraus extrahiert werden muss. Die folgende Abbildung vergleicht den bisherigen Prozess mit dem neuen Vorgehen und Support.

Diese Funktion vereinfacht die Arbeitsabläufe bei der Dokumentenverarbeitung, indem alle Vorverarbeitungsschritte entfallen, die zum Extrahieren von Klartext aus Dokumenten erforderlich sind, und die für die Verarbeitung erforderliche Gesamtzeit verkürzt wird.

In diesem Beitrag diskutieren wir ein allgemeines IDP-Workflow-Lösungsdesign, einige Branchenanwendungsfälle, die neuen Funktionen von Amazon Comprehend und deren Verwendung.

Lösungsübersicht

Beginnen wir mit der Untersuchung eines häufigen Anwendungsfalls in der Versicherungsbranche. Ein typischer Versicherungsanspruchsprozess umfasst ein Anspruchspaket, das mehrere Dokumente enthalten kann. Wenn ein Versicherungsanspruch eingereicht wird, umfasst dieser Dokumente wie Versicherungsantragsformulare, Vorfallberichte, Ausweisdokumente und Anspruchsdokumente Dritter. Das Dokumentenvolumen zur Bearbeitung und Beurteilung eines Versicherungsanspruchs kann je nach Art des Anspruchs und den beteiligten Geschäftsprozessen Hunderte oder sogar Tausende von Seiten umfassen. Vertreter und Richter von Versicherungsansprüchen verbringen in der Regel Hunderte von Stunden damit, Informationen aus Hunderten oder sogar Tausenden von Schadensmeldungen manuell zu sichten, zu sortieren und zu extrahieren.

Ähnlich wie in der Versicherungsbranche verarbeitet auch die Zahlungsbranche große Mengen halbstrukturierter Dokumente für grenzüberschreitende Zahlungsvereinbarungen, Rechnungen und Devisenauszüge. Geschäftsanwender verbringen den größten Teil ihrer Zeit mit manuellen Aktivitäten wie dem Identifizieren, Organisieren, Validieren, Extrahieren und Weitergeben erforderlicher Informationen an nachgelagerte Anwendungen. Dieser manuelle Prozess ist mühsam, repetitiv, fehleranfällig, teuer und schwer zu skalieren. Andere Branchen, die vor ähnlichen Herausforderungen stehen, sind Hypotheken- und Kreditvergabe, Gesundheitswesen und Biowissenschaften, Recht, Buchhaltung und Steuerverwaltung. Für Unternehmen ist es äußerst wichtig, solch große Mengen an Dokumenten zeitnah mit einem hohen Maß an Genauigkeit und geringem manuellen Aufwand zu verarbeiten.

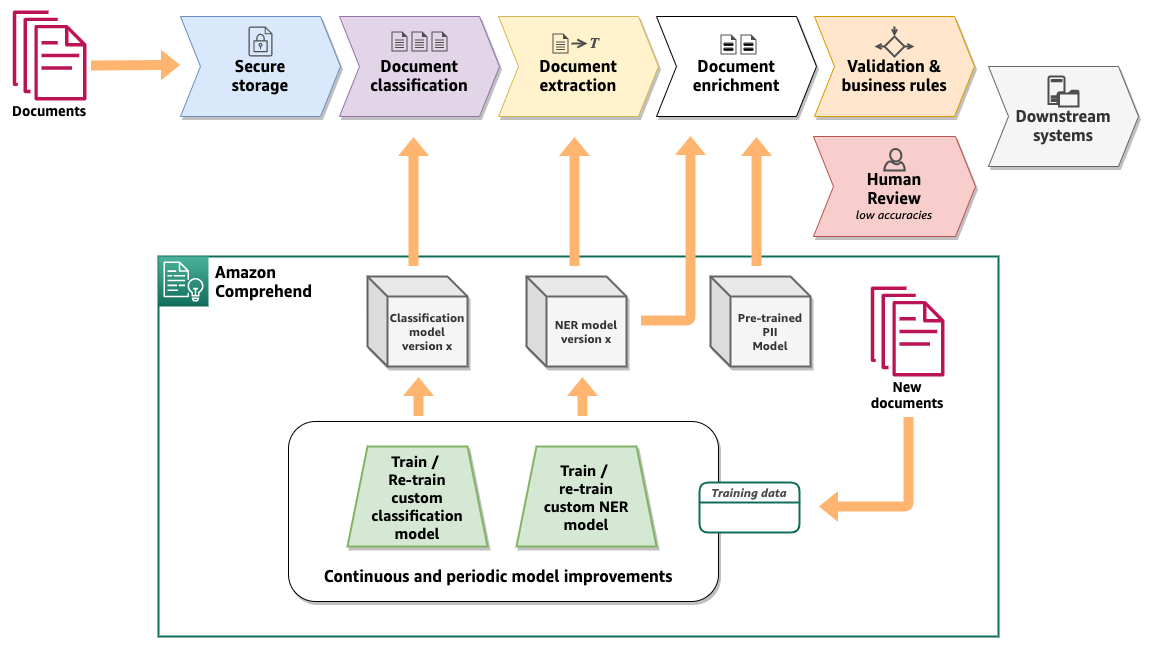

Amazon Comprehend bietet Schlüsselfunktionen, um die Dokumentenklassifizierung und Informationsextraktion aus einer großen Menge von Dokumenten mit hoher Genauigkeit auf skalierbare und kostengünstige Weise zu automatisieren. Das folgende Diagramm zeigt einen logischen IDP-Workflow mit Amazon Comprehend. Der Kern des Workflows besteht aus der Dokumentenklassifizierung und Informationsextraktion unter Verwendung von NER mit benutzerdefinierten Modellen von Amazon Comprehend. Das Diagramm zeigt auch, wie die benutzerdefinierten Modelle kontinuierlich verbessert werden können, um bei der Weiterentwicklung von Dokumenten und Geschäftsprozessen eine höhere Genauigkeit zu erzielen.

Benutzerdefinierte Dokumentenklassifizierung

Mit der benutzerdefinierten Klassifizierung von Amazon Comprehend können Sie Ihre Dokumente in vordefinierten Kategorien (Klassen) organisieren. Auf hoher Ebene sind die folgenden Schritte zum Einrichten eines benutzerdefinierten Dokumentklassifizierers und zum Durchführen der Dokumentklassifizierung aufgeführt:

- Bereiten Sie Trainingsdaten vor, um einen benutzerdefinierten Dokumentklassifikator zu trainieren.

- Trainieren Sie einen Kundendokumentklassifizierer mit den Trainingsdaten.

- Stellen Sie nach dem Trainieren des Modells optional einen Echtzeit-Endpunkt bereit.

- Führen Sie die Dokumentenklassifizierung entweder mit einem asynchronen Job oder in Echtzeit über den Endpunkt durch.

Die Schritte 1 und 2 werden typischerweise zu Beginn eines IDP-Projekts durchgeführt, nachdem die für den Geschäftsprozess relevanten Dokumentenklassen identifiziert wurden. Ein benutzerdefiniertes Klassifizierungsmodell kann dann regelmäßig neu trainiert werden, um die Genauigkeit zu verbessern und neue Dokumentklassen einzuführen. Sie können ein benutzerdefiniertes Klassifizierungsmodell entweder in trainieren Mehrklassenmodus or Multi-Label-Modus. Das Training kann für jede auf zwei Arten durchgeführt werden: mithilfe einer CSV-Datei oder mithilfe einer erweiterten Manifestdatei. Beziehen auf Trainingsdaten vorbereiten Weitere Informationen zum Trainieren eines benutzerdefinierten Klassifizierungsmodells finden Sie hier. Nachdem ein benutzerdefiniertes Klassifizierungsmodell trainiert wurde, kann ein Dokument entweder mit klassifiziert werden Echtzeitanalyse oder asynchroner Job. Echtzeitanalyse erfordert eine Endpunkt bereitgestellt werden mit dem trainierten Modell und eignet sich je nach Anwendungsfall am besten für kleine Dokumente. Für eine große Anzahl von Dokumenten ist ein asynchroner Klassifizierungsjob am besten geeignet.

Trainieren Sie ein benutzerdefiniertes Dokumentklassifizierungsmodell

Um die neue Funktion zu demonstrieren, haben wir ein benutzerdefiniertes Klassifizierungsmodell im Multi-Label-Modus trainiert, das Versicherungsdokumente in eine von sieben verschiedenen Klassen klassifizieren kann. Die Klassen sind INSURANCE_ID, PASSPORT, LICENSE, INVOICE_RECEIPT, MEDICAL_TRANSCRIPTION, DISCHARGE_SUMMARY und CMS1500. Wir möchten Beispieldokumente im nativen PDF-, PNG- und JPEG-Format klassifizieren, die in einem gespeichert sind Amazon Simple Storage-Service (Amazon S3)-Bucket unter Verwendung des Klassifizierungsmodells. Führen Sie die folgenden Schritte aus, um einen asynchronen Klassifizierungsjob zu starten:

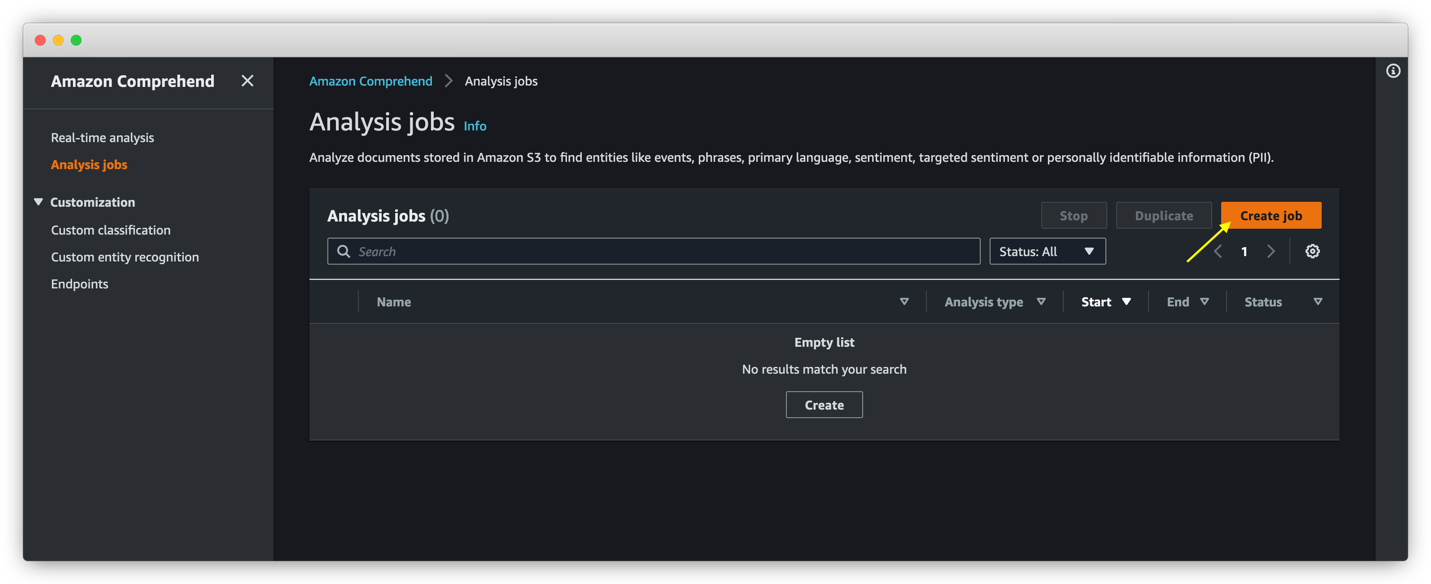

- Wählen Sie in der Amazon Comprehend-Konsole aus Analysejobs im Navigationsbereich.

- Auswählen

Job erstellen.

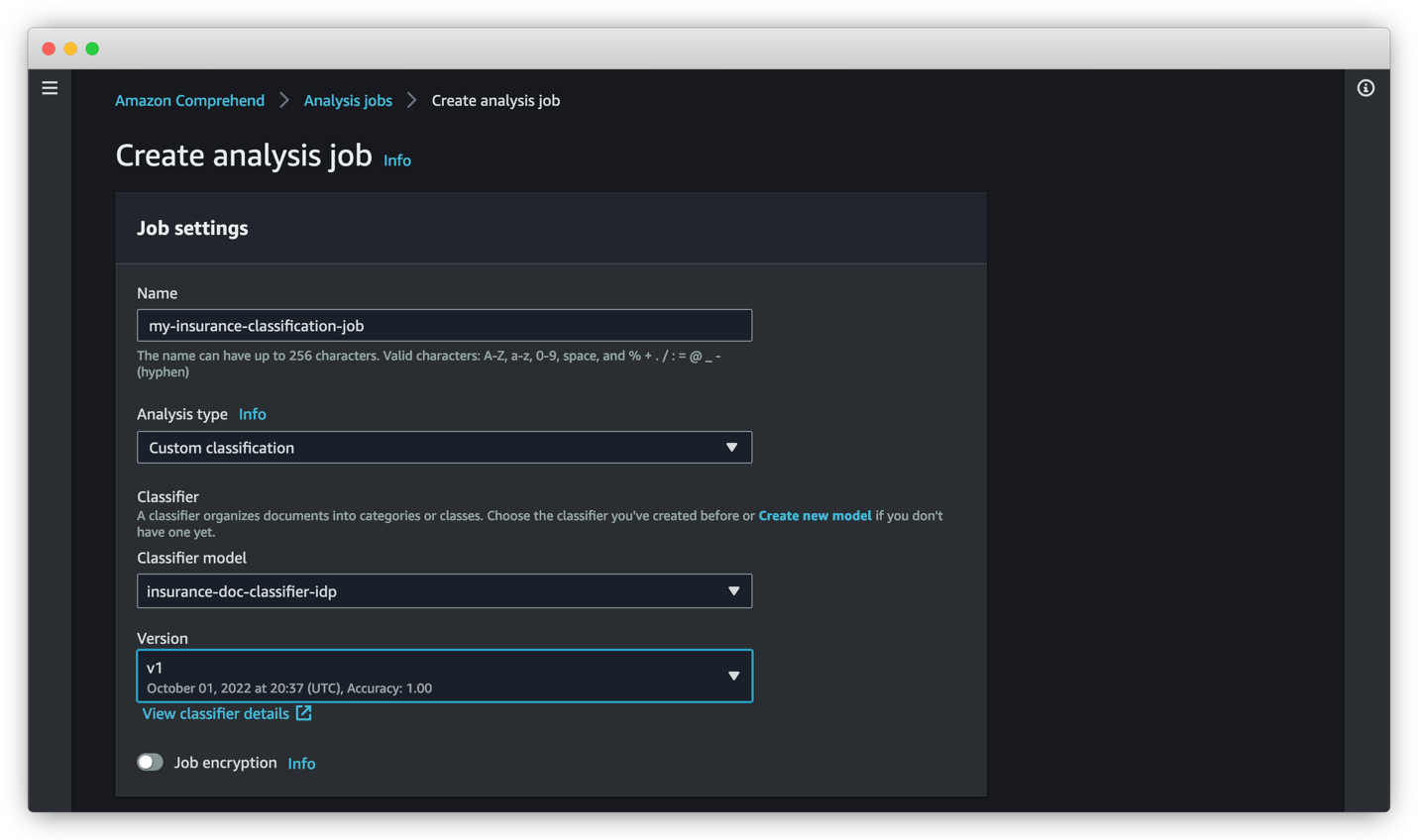

- Aussichten für Name und Vorname, geben Sie einen Namen für Ihren Klassifizierungsjob ein.

- Aussichten für Analysetypwählen Benutzerdefinierte Klassifizierung.

- Aussichten für Classifier-Modell, wählen Sie das geeignete trainierte Klassifizierungsmodell aus.

- Aussichten für Version, wählen Sie die passende Modellvariante aus.

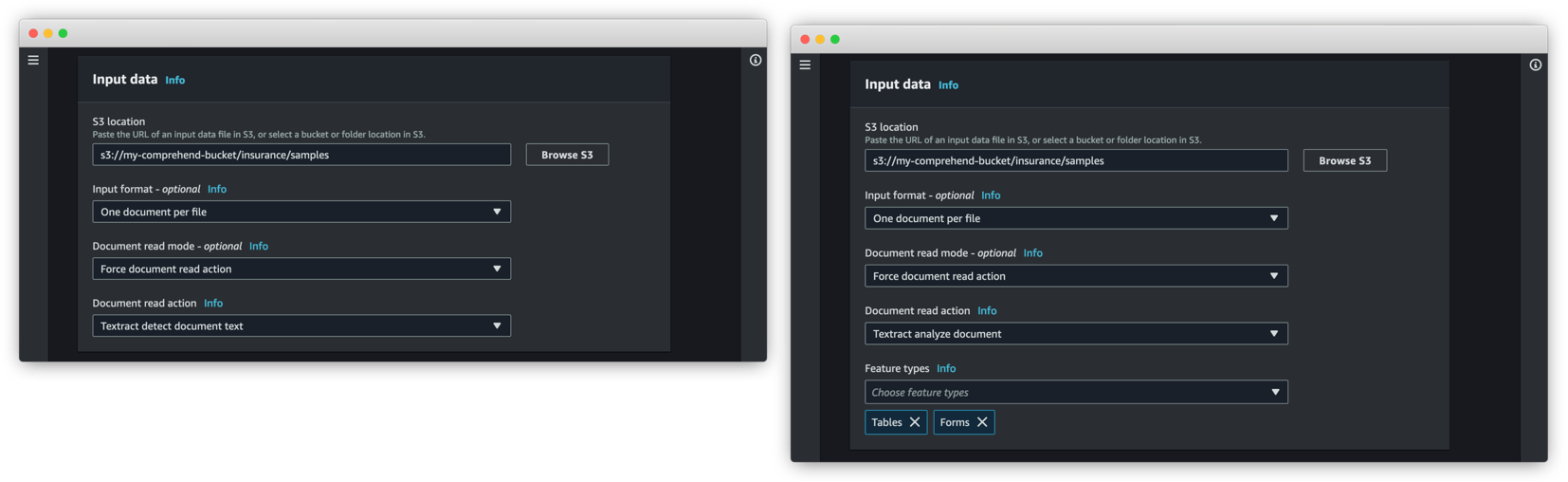

Im Eingabedaten Abschnitt geben wir den Ort an, an dem unsere Dokumente gespeichert sind.

- Aussichten für Eingabeformat, wählen Ein Dokument pro Datei.

- Aussichten für Dokumentlesemoduswählen Aktion zum Lesen des Dokuments erzwingen.

- Aussichten für Aktion zum Lesen des Dokuments, wählen Textract erkennt Dokumenttext.

Dadurch kann Amazon Comprehend die verwenden Amazontext DokumentText erkennen API zum Lesen der Dokumente vor dem Ausführen der Klassifizierung. Das DetectDocumentText Die API ist hilfreich beim Extrahieren von Textzeilen und Textwörtern aus den Dokumenten. Sie können auch wählen Textract Analysedokument für Aktion zum Lesen des Dokuments, in diesem Fall verwendet Amazon Comprehend den Amazon Textract Dokument analysieren API zum Lesen der Dokumente. Mit dem AnalyzeDocument API, können Sie extrahieren Tische, Online Formulare, oder beides. Das Dokumentlesemodus Option ermöglicht es Amazon Comprehend, den Text aus Dokumenten hinter den Kulissen zu extrahieren, was dazu beiträgt, den zusätzlichen Schritt des Extrahierens von Text aus dem Dokument zu reduzieren, der in unserem Dokumentenverarbeitungs-Workflow erforderlich ist.

Der benutzerdefinierte Amazon Comprehend-Klassifikator kann auch unformatierte JSON-Antworten verarbeiten, die von generiert wurden DetectDocumentText und AnalyzeDocument APIs, ohne Modifikation oder Vorverarbeitung. Dies ist nützlich für bestehende Workflows, bei denen Amazon Textract bereits am Extrahieren von Text aus den Dokumenten beteiligt ist. In diesem Fall kann die JSON-Ausgabe von Amazon Textract direkt in die Dokumentenklassifizierungs-APIs von Amazon Comprehend eingespeist werden.

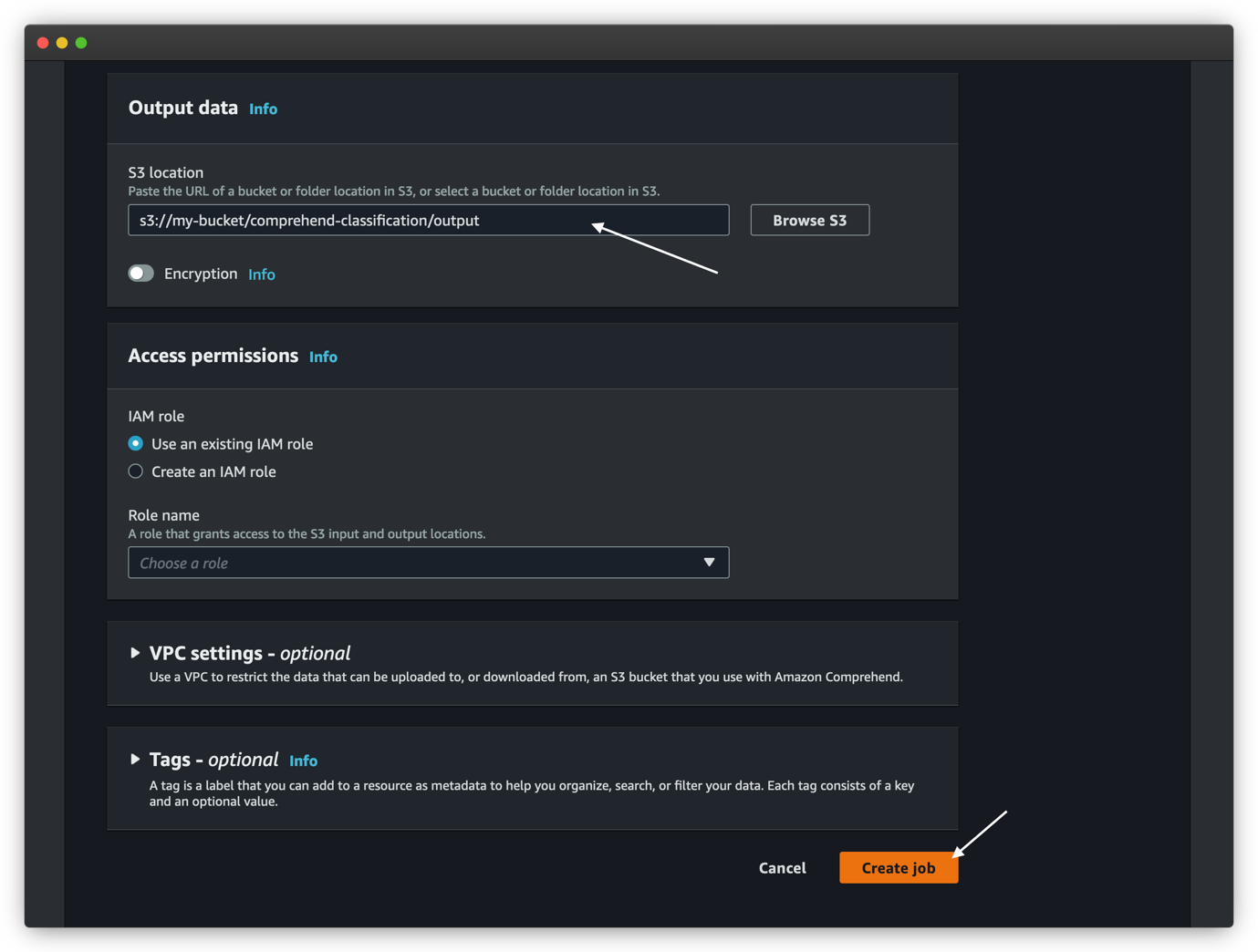

- Im Ausgabedaten Abschnitt, für S3 Standort, geben Sie einen Amazon S3-Speicherort an, an den der asynchrone Job die Ergebnisse der Inferenz schreiben soll.

- Belassen Sie die restlichen Optionen als Standard.

- Auswählen

Job erstellen um die Arbeit zu starten.

Sie können den Status des Auftrags auf der anzeigen Analysejobs

Wenn der Job abgeschlossen ist, können wir die Ausgabe des Analysejobs anzeigen, die an dem Amazon S3-Speicherort gespeichert ist, der während der Jobkonfiguration angegeben wurde. Die Klassifizierungsausgabe für unser einseitiges PDF-Beispiel-CMS1500-Dokument lautet wie folgt. Die Ausgabe ist eine Datei im JSON-Zeilenformat, die formatiert wurde, um die Lesbarkeit zu verbessern.

Das vorhergehende Beispiel ist ein einseitiges PDF-Dokument; Die benutzerdefinierte Klassifizierung kann jedoch auch mehrseitige PDF-Dokumente verarbeiten. Bei mehrseitigen Dokumenten enthält die Ausgabe mehrere JSON-Zeilen, wobei jede Zeile das Klassifizierungsergebnis jeder Seite in einem Dokument darstellt. Das Folgende ist ein Beispiel für eine mehrseitige Klassifizierungsausgabe:

Benutzerdefinierte Entitätserkennung

Mit einer benutzerdefinierten Entitätserkennung von Amazon Comprehend können Sie Dokumente analysieren und Entitäten wie Produktcodes oder geschäftsspezifische Entitäten extrahieren, die Ihren speziellen Anforderungen entsprechen. Auf hoher Ebene sind die folgenden Schritte zum Einrichten einer benutzerdefinierten Entitätserkennung und zum Durchführen der Entitätserkennung:

- Bereiten Sie Trainingsdaten vor, um eine benutzerdefinierte Entitätserkennung zu trainieren.

- Trainieren Sie eine benutzerdefinierte Entitätserkennung mit den Trainingsdaten.

- Stellen Sie nach dem Trainieren des Modells optional einen Echtzeit-Endpunkt bereit.

- Führen Sie die Entitätserkennung entweder mit einem asynchronen Job oder in Echtzeit über den Endpunkt durch.

Ein benutzerdefiniertes Entitätserkennungsmodell kann regelmäßig neu trainiert werden, um die Genauigkeit zu verbessern und neue Entitätstypen einzuführen. Sie können mit beiden ein benutzerdefiniertes Entitätserkennungsmodell trainieren Entitätslisten or Anmerkungen. In beiden Fällen lernt Amazon Comprehend etwas über die Art der Dokumente und den Kontext, in dem die Entitäten vorkommen, um ein Entitätserkennungsmodell zu erstellen, das verallgemeinert werden kann, um neue Entitäten zu erkennen. Beziehen auf Trainingsdaten vorbereiten um mehr über das Vorbereiten von Trainingsdaten für die benutzerdefinierte Entitätserkennung zu erfahren.

Nachdem ein benutzerdefiniertes Entitätserkennungsmodell trainiert wurde, kann die Entitätserkennung entweder mit erfolgen Echtzeitanalyse oder asynchroner Job. Echtzeitanalyse erfordert eine Endpunkt bereitgestellt werden mit dem trainierten Modell und eignet sich je nach Anwendungsfall am besten für kleine Dokumente. Für eine große Anzahl von Dokumenten ist ein asynchroner Klassifizierungsjob am besten geeignet.

Trainieren Sie ein benutzerdefiniertes Entitätserkennungsmodell

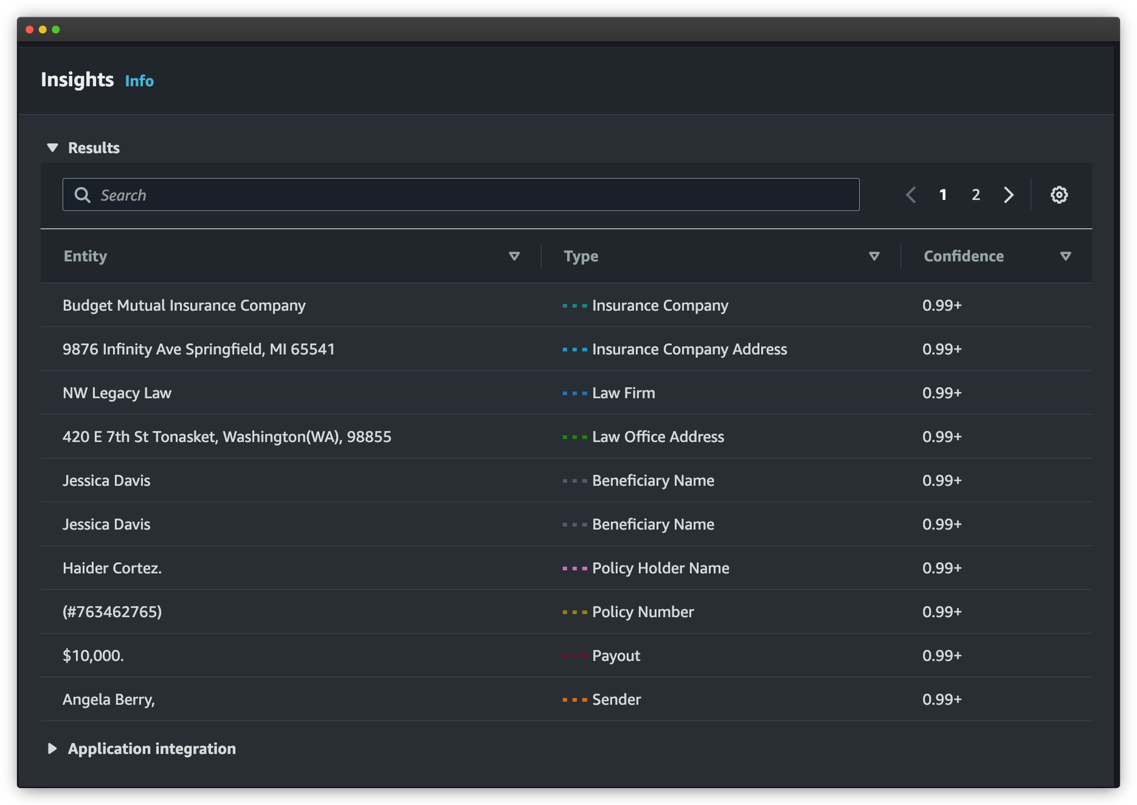

Um die Entitätserkennung in Echtzeit zu demonstrieren, haben wir ein benutzerdefiniertes Entitätserkennungsmodell mit Versicherungsdokumenten und erweiterten Manifestdateien unter Verwendung benutzerdefinierter Anmerkungen trainiert und den Endpunkt mithilfe des trainierten Modells bereitgestellt. Die Entitätstypen sind Law Firm, Law Office Address, Insurance Company, Insurance Company Address, Policy Holder Name, Beneficiary Name, Policy Number, Payout, Required Action und Sender. Wir möchten Entitäten aus Beispieldokumenten im nativen PDF-, PNG- und JPEG-Format, die in einem S3-Bucket gespeichert sind, mithilfe des Erkennungsmodells erkennen.

Beachten Sie, dass Sie ein benutzerdefiniertes Entitätserkennungsmodell verwenden können, das mit PDF-Dokumenten trainiert wird, um benutzerdefinierte Entitäten aus PDF-, TIFF-, Bild-, Word- und Nur-Text-Dokumenten zu extrahieren. Wenn Ihr Modell mithilfe von Textdokumenten und einer Entitätsliste trainiert wird, können Sie zum Extrahieren der Entitäten nur reine Textdokumente verwenden.

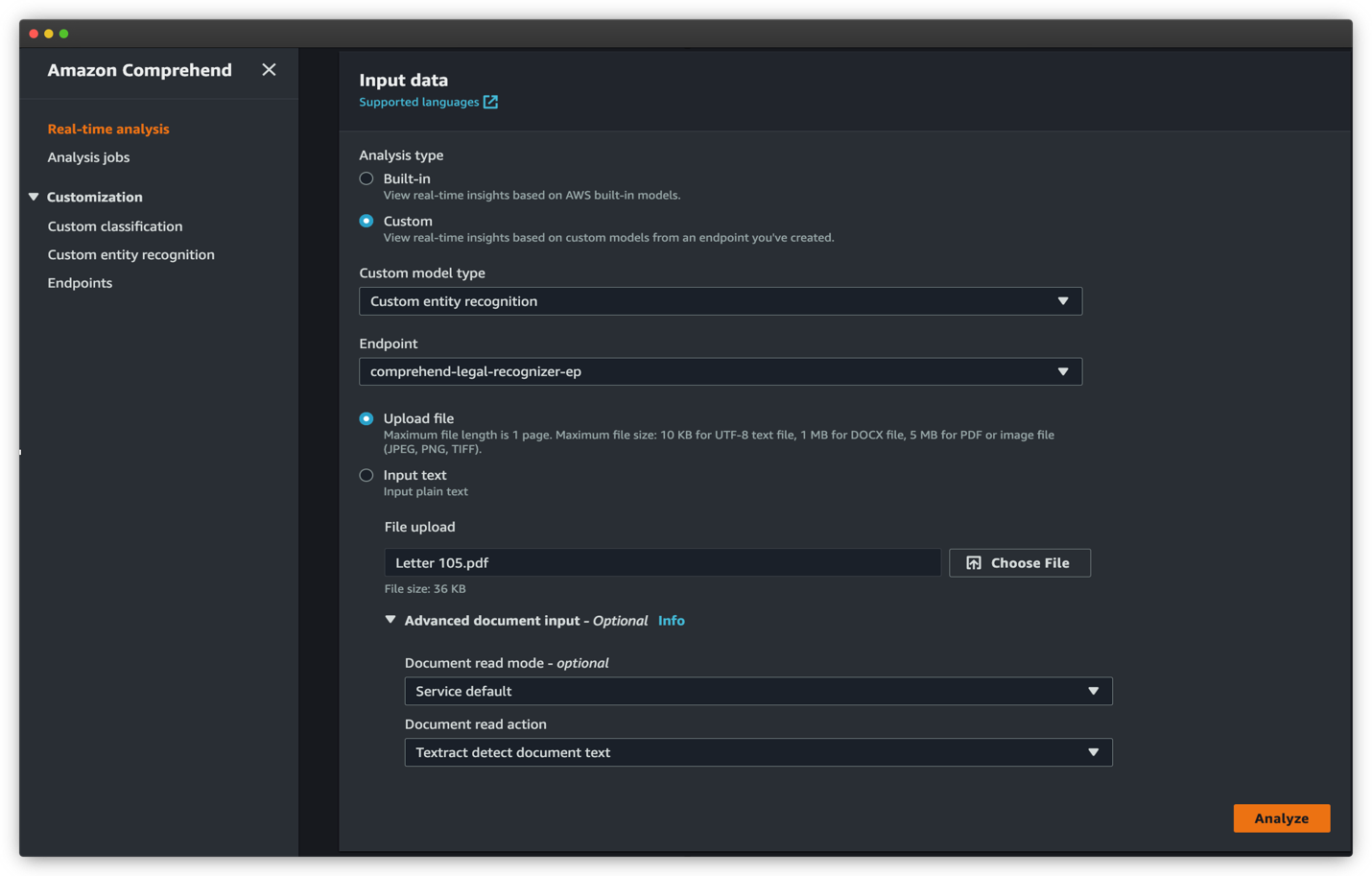

Wir müssen Entitäten aus einem Beispieldokument in einem beliebigen nativen PDF-, PNG- und JPEG-Format mithilfe des Erkennungsmodells erkennen. Führen Sie die folgenden Schritte aus, um einen synchronen Entitätserkennungsjob zu starten:

- Wählen Sie in der Amazon Comprehend-Konsole aus Echtzeitanalyse im Navigationsbereich.

- Der AnalysetypWählen Maßgeschneidert.

- Aussichten für Benutzerdefinierte Entitätserkennung, wählen Sie den benutzerdefinierten Modelltyp aus.

- Aussichten für Endpunkt, wählen Sie den Echtzeitendpunkt aus, den Sie für Ihr Entitätserkennungsmodell erstellt haben.

- Auswählen Datei hochladen und wählen Sie Wählen Sie Datei um die PDF- oder Bilddatei für die Inferenz hochzuladen.

- Erweitern Sie die Erweiterte Dokumenteingabe Abschnitt und für Dokumentlesemodus, wählen Dienstvorgabe.

- Aussichten für Aktion zum Lesen des Dokuments, wählen Textract erkennt Dokumenttext.

- Auswählen

Analysieren um das Dokument in Echtzeit zu analysieren.

Die anerkannten Einrichtungen sind in der aufgeführt Blog Sektion. Jede Entität enthält den Entitätswert (den Text), den von Ihnen während des Schulungsprozesses definierten Entitätstyp und die entsprechende Vertrauensbewertung.

Weitere Details und eine vollständige exemplarische Vorgehensweise zum Trainieren eines benutzerdefinierten Entitätserkennungsmodells und dessen Verwendung zum Durchführen asynchroner Inferenzen mithilfe von asynchronen Analyseaufträgen finden Sie unter Extrahieren Sie mit Amazon Comprehend benutzerdefinierte Entitäten aus Dokumenten in ihrem nativen Format.

Zusammenfassung

In diesem Beitrag wurde gezeigt, wie Sie mit Amazon Comprehend halbstrukturierte Dokumente in ihrem nativen Format klassifizieren und kategorisieren und daraus geschäftsspezifische Entitäten erkennen können. Sie können Echtzeit-APIs für Anwendungsfälle mit geringer Latenz oder asynchrone Analysejobs für die Massenverarbeitung von Dokumenten verwenden.

Als nächsten Schritt empfehlen wir Ihnen, Amazon Comprehend zu besuchen GitHub-Repository für vollständige Codebeispiele, um diese neuen Funktionen auszuprobieren. Sie können auch die besuchen Amazon Comprehend-Entwicklerhandbuch und Amazon Comprehend-Entwicklerressourcen für Videos, Tutorials, Blogs und mehr.

Über die Autoren

Wrick Talukdar ist Senior Architect im Amazon Comprehend Service Team. Er arbeitet mit AWS-Kunden zusammen, um ihnen dabei zu helfen, maschinelles Lernen in großem Umfang einzuführen. Außerhalb der Arbeit liest und fotografiert er gerne.

Wrick Talukdar ist Senior Architect im Amazon Comprehend Service Team. Er arbeitet mit AWS-Kunden zusammen, um ihnen dabei zu helfen, maschinelles Lernen in großem Umfang einzuführen. Außerhalb der Arbeit liest und fotografiert er gerne.

Anjan Biswas ist Senior AI Services Solutions Architect mit den Schwerpunkten AI/ML und Data Analytics. Anjan ist Teil des weltweiten Teams für KI-Services und arbeitet mit Kunden zusammen, um ihnen dabei zu helfen, Geschäftsprobleme mit KI und ML zu verstehen und Lösungen für diese zu entwickeln. Anjan verfügt über mehr als 14 Jahre Erfahrung in der Arbeit mit globalen Lieferketten-, Fertigungs- und Einzelhandelsorganisationen und hilft Kunden aktiv beim Einstieg und bei der Skalierung von AWS-KI-Services.

Anjan Biswas ist Senior AI Services Solutions Architect mit den Schwerpunkten AI/ML und Data Analytics. Anjan ist Teil des weltweiten Teams für KI-Services und arbeitet mit Kunden zusammen, um ihnen dabei zu helfen, Geschäftsprobleme mit KI und ML zu verstehen und Lösungen für diese zu entwickeln. Anjan verfügt über mehr als 14 Jahre Erfahrung in der Arbeit mit globalen Lieferketten-, Fertigungs- und Einzelhandelsorganisationen und hilft Kunden aktiv beim Einstieg und bei der Skalierung von AWS-KI-Services.

Godwin Sahayaraj Vincent ist ein Enterprise Solutions Architect bei AWS, der sich leidenschaftlich für maschinelles Lernen einsetzt und Kunden beim Entwerfen, Bereitstellen und Verwalten ihrer AWS-Workloads und -Architekturen berät. In seiner Freizeit spielt er gerne Cricket mit seinen Freunden und Tennis mit seinen drei Kindern.

Godwin Sahayaraj Vincent ist ein Enterprise Solutions Architect bei AWS, der sich leidenschaftlich für maschinelles Lernen einsetzt und Kunden beim Entwerfen, Bereitstellen und Verwalten ihrer AWS-Workloads und -Architekturen berät. In seiner Freizeit spielt er gerne Cricket mit seinen Freunden und Tennis mit seinen drei Kindern.

- Fortgeschritten (300)

- AI

- Kunst

- KI-Kunstgenerator

- KI-Roboter

- Amazon verstehen

- künstliche Intelligenz

- Zertifizierung für künstliche Intelligenz

- Künstliche Intelligenz im Bankwesen

- Roboter mit künstlicher Intelligenz

- Roboter mit künstlicher Intelligenz

- Software für künstliche Intelligenz

- AWS Maschinelles Lernen

- Blockchain

- Blockchain-Konferenz ai

- Einfallsreichtum

- dialogorientierte künstliche Intelligenz

- Krypto-Konferenz ai

- Dalls

- tiefe Lernen

- Google Ai

- Maschinelles Lernen

- Plato

- platon ai

- Datenintelligenz von Plato

- Plato-Spiel

- PlatoData

- Platogaming

- Skala ai

- Syntax

- Zephyrnet