Schon mal gesehen, wie ein Gazellenbaby laufen lernt? Ein Kitz, das im Grunde ein langbeiniger Säugetiervater ist, rappelt sich auf, fällt, steht und fällt wieder. Schließlich steht es lange genug, um mit seinen zahnstocherähnlichen Beinen in eine Reihe von Beinahe-Stürzen zu schlagen … ähm, Schritte. Erstaunlicherweise hüpft das Kitz wenige Minuten nach dieser liebenswerten Vorstellung herum wie ein alter Profi.

Nun, jetzt haben wir eine Roboterversion dieser klassischen Serengeti-Szene.

Das Kitz ist in diesem Fall ein Roboterhund an der University of California, Berkeley. Und es ist auch ein überraschend schneller Lerner (im Vergleich zum Rest der Roboterart). Der Roboter ist auch deshalb etwas Besonderes, weil er im Gegensatz zu anderen auffälligeren Robotern, die Sie vielleicht online gesehen haben, künstliche Intelligenz verwendet, um sich selbst das Laufen beizubringen.

Beginnend auf dem Rücken, mit wedelnden Beinen, lernt der Roboter in einer Stunde, sich umzudrehen, aufzustehen und zu gehen. Weitere zehn Minuten Belästigung mit einer Rolle Pappe reichen aus, um ihm beizubringen, wie er widerstehen und sich davon erholen kann, wenn er von seinen Haltern herumgeschubst wird.

Es ist nicht das erste Mal Ein Roboter hat mithilfe künstlicher Intelligenz das Laufen gelernt. Aber während frühere Roboter die Fähigkeit durch Versuch und Irrtum über unzählige Iterationen in Simulationen erlernten, lernte der Berkeley-Bot vollständig in der realen Welt.

[Eingebetteten Inhalt]

In einer Papier veröffentlicht Auf dem arXiv-Preprint-Server sagen die Forscher – Danijar Hafner, Alejandro Escontrela und Philipp Wu –, dass es nicht einfach ist, in der Simulation gelernte Algorithmen auf die reale Welt zu übertragen. Kleine Details und Unterschiede zwischen der realen Welt und der Simulation können junge Roboter zum Stolpern bringen. Andererseits ist das Training von Algorithmen in der realen Welt unpraktisch: Es würde zu viel Zeit und Verschleiß in Anspruch nehmen.

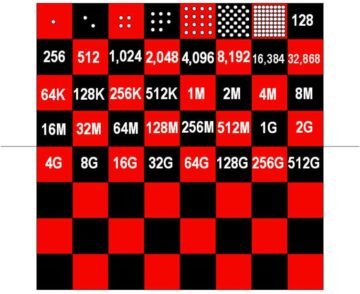

Vor vier Jahren zeigte OpenAI beispielsweise eine KI-fähige Roboterhand, die einen Würfel manipulieren konnte. Der Steuerungsalgorithmus Dactyl benötigte etwa 100 Jahre Erfahrung in einer Simulation, die von 6,144 CPUs und 8 Nvidia V100-GPUs angetrieben wurde, um diese relativ einfache Aufgabe zu erfüllen. Die Dinge haben sich seitdem weiterentwickelt, aber das Problem bleibt weitgehend bestehen. Reine Reinforcement-Learning-Algorithmen brauchen zu viel Trial-and-Error, um Fähigkeiten zu erlernen, um sie in der realen Welt zu trainieren. Einfach gesagt, der Lernprozess würde Forscher brechen und Roboter, bevor Sie sinnvolle Fortschritte erzielen.

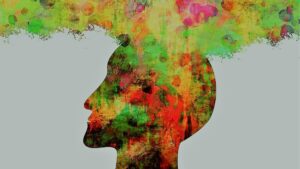

Das Berkeley-Team wollte dieses Problem mit einem Algorithmus namens Dreamer lösen. Konstruieren eines sogenannten „Weltmodell“, kann Dreamer die Wahrscheinlichkeit prognostizieren, dass eine zukünftige Aktion ihr Ziel erreichen wird. Mit zunehmender Erfahrung verbessert sich die Genauigkeit seiner Projektionen. Indem weniger erfolgreiche Aktionen im Voraus herausgefiltert werden, ermöglicht das Weltmodell dem Roboter, effizienter herauszufinden, was funktioniert.

„Das Lernen von Weltmodellen aus vergangenen Erfahrungen ermöglicht es Robotern, sich die zukünftigen Ergebnisse potenzieller Handlungen vorzustellen, wodurch die Menge an Versuch und Irrtum in der realen Umgebung reduziert wird, die erforderlich ist, um erfolgreiche Verhaltensweisen zu lernen“, schreiben die Forscher. „Durch die Vorhersage zukünftiger Ergebnisse ermöglichen Weltmodelle Planung und Verhaltenslernen bei nur geringen Mengen an realer Interaktion.“

Mit anderen Worten, ein Weltmodell kann das Äquivalent einer jahrelangen Trainingszeit in einer Simulation auf nicht mehr als eine unangenehme Stunde in der realen Welt reduzieren.

Der Ansatz kann auch eine breitere Relevanz als Roboterhunde haben. Das Team wendete Dreamer auch auf einen Pick-and-Place-Roboterarm und einen Roboter mit Rädern an. In beiden Fällen stellten sie fest, dass Dreamer es ihren Robotern ermöglichte, relevante Fähigkeiten effizient zu erlernen, ohne dass Sim-Zeit erforderlich war. Ehrgeizigere zukünftige Anwendungen könnten umfassen selbstfahrenden Autos.

Natürlich gibt es noch Herausforderungen zu bewältigen. Obwohl Reinforcement Learning einige der komplizierten Handcodierungen hinter den fortschrittlichsten Robotern von heute automatisiert, müssen Ingenieure immer noch die Ziele eines Roboters und den Erfolg definieren – eine Übung, die sowohl zeitaufwändig als auch für reale Umgebungen ergebnisoffen ist. Auch wenn der Roboter die Experimente des Teams hier überlebt hat, kann sich ein längeres Training für fortgeschrittenere Fähigkeiten als zu viel für zukünftige Bots erweisen, um ohne Schaden zu überleben. Die Forscher sagen, dass es fruchtbar sein könnte, Simulatortraining mit schnellem Lernen in der realen Welt zu kombinieren.

Dennoch bringen die Ergebnisse die KI in der Robotik einen weiteren Schritt voran. Dreamer bekräftigt die Argumentation, dass „bestärkendes Lernen ein Eckpfeiler in der Zukunft der Robotersteuerung sein wird“, Jonathan Hurst, Professor für Robotik an der Oregon State University sagte MIT Technology Review.

Bild-Kredit: Danijar Hafner / YouTube