Daten fördern maschinelles Lernen (ML); Die Qualität der Daten hat einen direkten Einfluss auf die Qualität von ML-Modellen. Daher sind die Verbesserung der Datenqualität und der Einsatz der richtigen Feature-Engineering-Techniken entscheidend für die Erstellung genauer ML-Modelle. ML-Praktiker iterieren oft mühsam über Feature Engineering, die Auswahl von Algorithmen und andere Aspekte von ML auf der Suche nach optimalen Modellen, die sich gut auf reale Daten verallgemeinern lassen und die gewünschten Ergebnisse liefern. Da Geschwindigkeit bei der Geschäftsabwicklung unverhältnismäßig wichtig ist, kann dieser äußerst langwierige und iterative Prozess zu Projektverzögerungen und entgangenen Geschäftsmöglichkeiten führen.

Amazon SageMaker Data Wrangler reduziert die Zeit zum Sammeln und Vorbereiten von Daten für ML von Wochen auf Minuten und Amazon SageMaker-Autopilot erstellt, trainiert und optimiert automatisch die besten ML-Modelle basierend auf Ihren Daten. Mit Autopilot behalten Sie weiterhin die volle Kontrolle und Sichtbarkeit Ihrer Daten und Ihres Modells. Beide Dienste wurden speziell entwickelt, um ML-Praktiker produktiver zu machen und die Time-to-Value zu verkürzen.

Data Wrangler bietet jetzt ein einheitliches Erlebnis, mit dem Sie Daten vorbereiten und ein ML-Modell nahtlos in Autopilot trainieren können. Mit dieser neu eingeführten Funktion können Sie jetzt Ihre Daten in Data Wrangler vorbereiten und Autopilot-Experimente einfach direkt von der Benutzeroberfläche (UI) von Data Wrangler starten. Mit nur wenigen Klicks können Sie ML-Modelle automatisch erstellen, trainieren und optimieren, wodurch es einfacher wird, modernste Feature-Engineering-Techniken einzusetzen, hochwertige ML-Modelle zu trainieren und schneller Erkenntnisse aus Ihren Daten zu gewinnen.

In diesem Beitrag erörtern wir, wie Sie diese neue integrierte Erfahrung in Data Wrangler nutzen können, um Datensätze zu analysieren und auf einfache Weise hochwertige ML-Modelle in Autopilot zu erstellen.

Datensatzübersicht

Pima-Indianer sind eine indigene Gruppe, die in Mexiko und Arizona, USA, leben. Studien zeigen Pima-Indianer als Hochrisiko-Bevölkerungsgruppe für Diabetes mellitus. Die Vorhersage der Wahrscheinlichkeit des Risikos und der Anfälligkeit einer Person für eine chronische Krankheit wie Diabetes ist eine wichtige Aufgabe bei der Verbesserung der Gesundheit und des Wohlbefindens dieser oft unterrepräsentierten Minderheit.

Wir nutzen die Pima Indian Diabetes öffentlicher Datensatz um die Anfälligkeit einer Person für Diabetes vorherzusagen. Wir konzentrieren uns auf die neue Integration zwischen Data Wrangler und Autopilot, um Daten vorzubereiten und automatisch ein ML-Modell zu erstellen, ohne eine einzige Codezeile zu schreiben.

Der Datensatz enthält Informationen über indische Pima-Frauen ab 21 Jahren und enthält mehrere (unabhängige) medizinische Prädiktorvariablen und eine (abhängige) Zielvariable, das Ergebnis. Das folgende Diagramm beschreibt die Spalten in unserem Datensatz.

| Kolonne Name und Vorname | Beschreibung |

| Schwangerschaften | Die Anzahl der Schwangerschaften |

| Glucose | Plasmaglukosekonzentration in einem oralen Glukosetoleranztest innerhalb von 2 Stunden |

| Blutdruck | Diastolischer Blutdruck (mm Hg) |

| Hautdicke | Dicke der Trizepshautfalte (mm) |

| Insulin | 2-Stunden-Seruminsulin (mu U/ml) |

| BMI | Body-Mass-Index (Gewicht in kg/(Größe in m)^2) |

| DiabetesStammbaum | Diabetes-Stammbaumfunktion |

| Alter | Alter in Jahren |

| Ergebnis | Die Zielvariable |

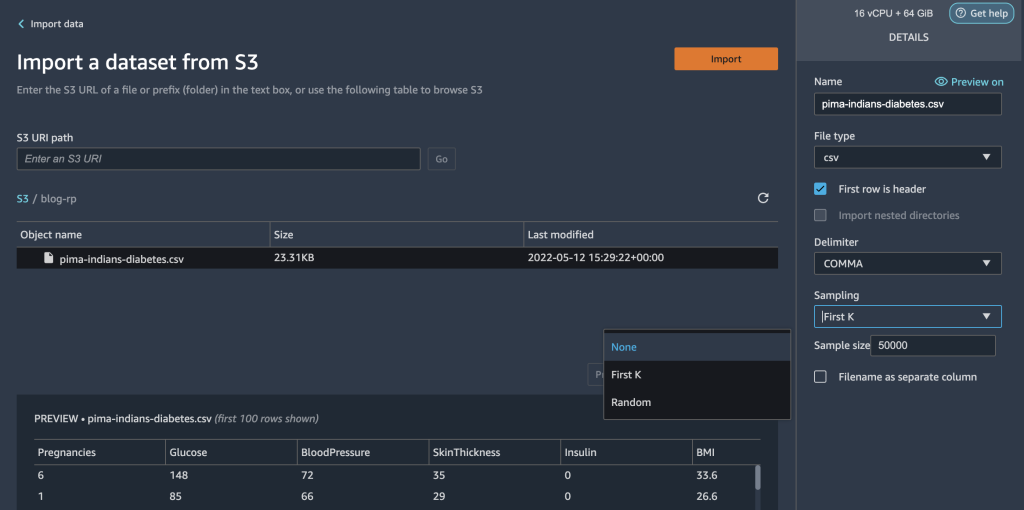

Der Datensatz enthält 768 Datensätze mit insgesamt 9 Merkmalen. Wir speichern diesen Datensatz in Amazon Simple Storage Bucket (Amazon S3) als CSV-Datei und importieren Sie die CSV dann direkt in einen Data Wrangler-Flow von Amazon S3.

Lösungsüberblick

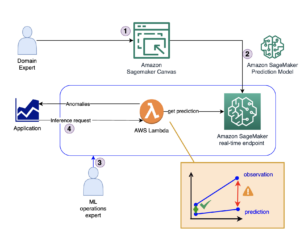

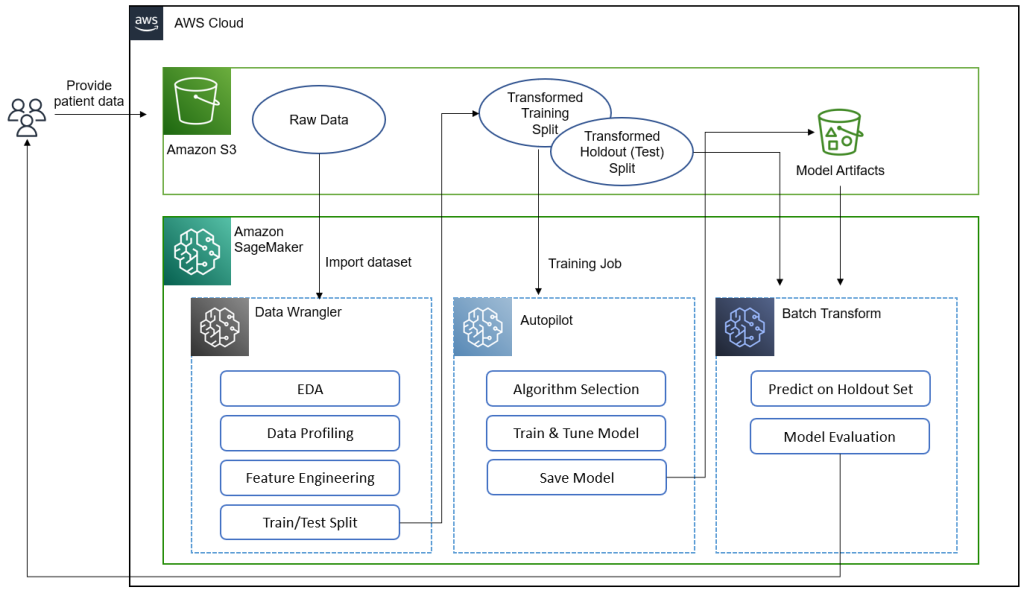

Das folgende Diagramm fasst zusammen, was wir in diesem Beitrag erreichen.[KT1]

Datenwissenschaftler, Ärzte und andere medizinische Experten stellen Patientendaten mit Informationen zu Glukosewerten, Blutdruck, Body-Mass-Index und anderen Merkmalen zur Verfügung, die zur Vorhersage der Wahrscheinlichkeit, an Diabetes zu erkranken, verwendet werden. Mit dem Datensatz in Amazon S3 importieren wir den Datensatz in Data Wrangler, um eine explorative Datenanalyse (EDA), Datenprofilerstellung, Feature-Engineering und die Aufteilung des Datensatzes in Train und Test für die Modellerstellung und -bewertung durchzuführen.

Wir verwenden dann die neue Feature-Integration von Autopilot, um schnell ein Modell direkt aus der Data Wrangler-Schnittstelle zu erstellen. Wir wählen das beste Autopilot-Modell basierend auf dem Modell mit dem höchsten F-Beta-Score aus. Nachdem Autopilot das beste Modell gefunden hat, führen wir a SageMaker-Batch-Transformation Job auf dem Test (Holdout)-Set mit den Modellartefakten des besten Modells zur Bewertung.

Medizinische Experten können dem validierten Modell neue Daten zur Verfügung stellen, um eine Vorhersage zu erhalten, ob ein Patient wahrscheinlich an Diabetes erkrankt sein wird. Mit diesen Erkenntnissen können medizinische Experten frühzeitig mit der Behandlung beginnen, um die Gesundheit und das Wohlbefinden gefährdeter Bevölkerungsgruppen zu verbessern. Medizinische Experten können die Vorhersage eines Modells auch erklären, indem sie auf die Details des Modells in Autopilot verweisen, da sie einen vollständigen Einblick in die Erklärbarkeit, Leistung und Artefakte des Modells haben. Diese Sichtbarkeit zusätzlich zur Validierung des Modells aus dem Testset gibt medizinischen Experten mehr Vertrauen in die Vorhersagefähigkeit des Modells.

Wir führen Sie durch die folgenden allgemeinen Schritte.

- Importieren Sie den Datensatz aus Amazon S3.

- Führen Sie EDA und Datenprofilerstellung mit Data Wrangler durch.

- Führen Sie Feature-Engineering durch, um Ausreißer und fehlende Werte zu behandeln.

- Teilen Sie Daten in Trainings- und Testsätze auf.

- Trainieren und bauen Sie ein Modell mit Autopilot.

- Testen Sie das Modell an einem Holdout-Muster mit einem SageMaker-Notebook.

- Analysieren Sie die Validierungs- und Testsatzleistung.

Voraussetzungen:

Führen Sie die folgenden erforderlichen Schritte aus:

- Laden Sie den Datensatz hoch zu einem S3-Bucket Ihrer Wahl.

- Stellen Sie sicher, dass Sie über die erforderlichen Berechtigungen verfügen. Weitere Informationen finden Sie unter Erste Schritte mit Data Wrangler.

- Richten Sie eine SageMaker-Domäne ein, die für die Verwendung von Data Wrangler konfiguriert ist. Anweisungen finden Sie unter Integrieren in die Amazon SageMaker-Domäne.

Importieren Sie Ihren Datensatz mit Data Wrangler

Sie können einen Data Wrangler-Datenfluss in Ihre ML-Workflows integrieren, um die Datenvorverarbeitung und das Feature-Engineering mit wenig bis gar keiner Codierung zu vereinfachen und zu optimieren. Führen Sie die folgenden Schritte aus:

- Erstelle eine neue Data Wrangler-Fluss.

Wenn Sie Data Wrangler zum ersten Mal öffnen, müssen Sie möglicherweise einige Minuten warten, bis es bereit ist.

- Wählen Sie den in Amazon S3 gespeicherten Datensatz und importieren Sie ihn in Data Wrangler.

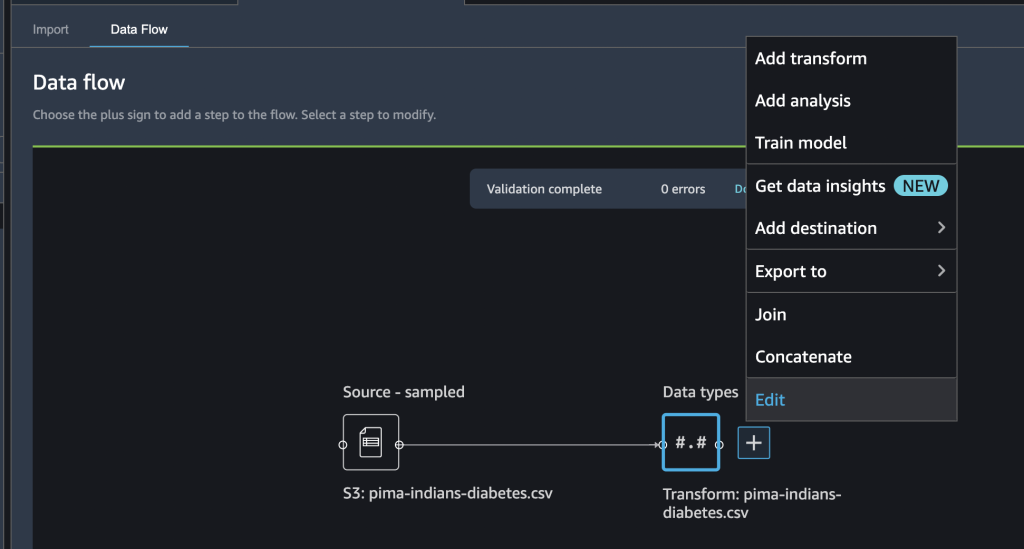

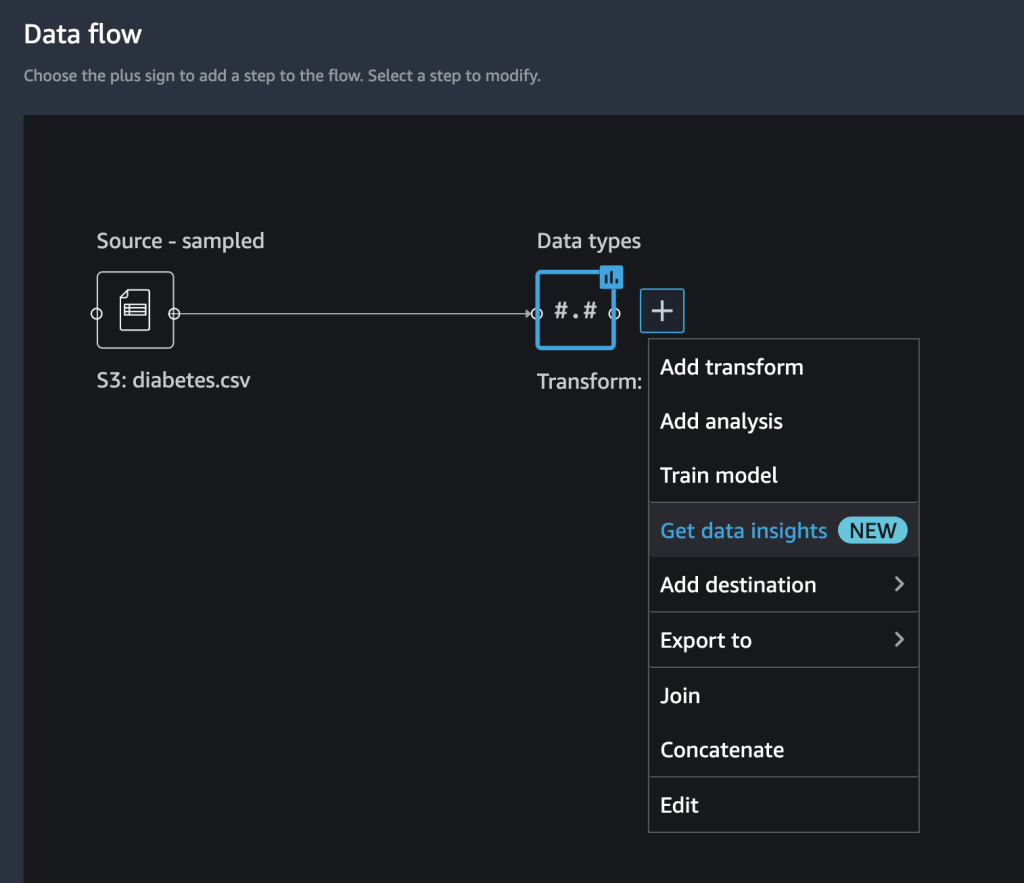

Nachdem Sie das Dataset importiert haben, sollten Sie die Anfänge eines Datenflusses in der Benutzeroberfläche von Data Wrangler sehen. Sie haben jetzt ein Flussdiagramm.

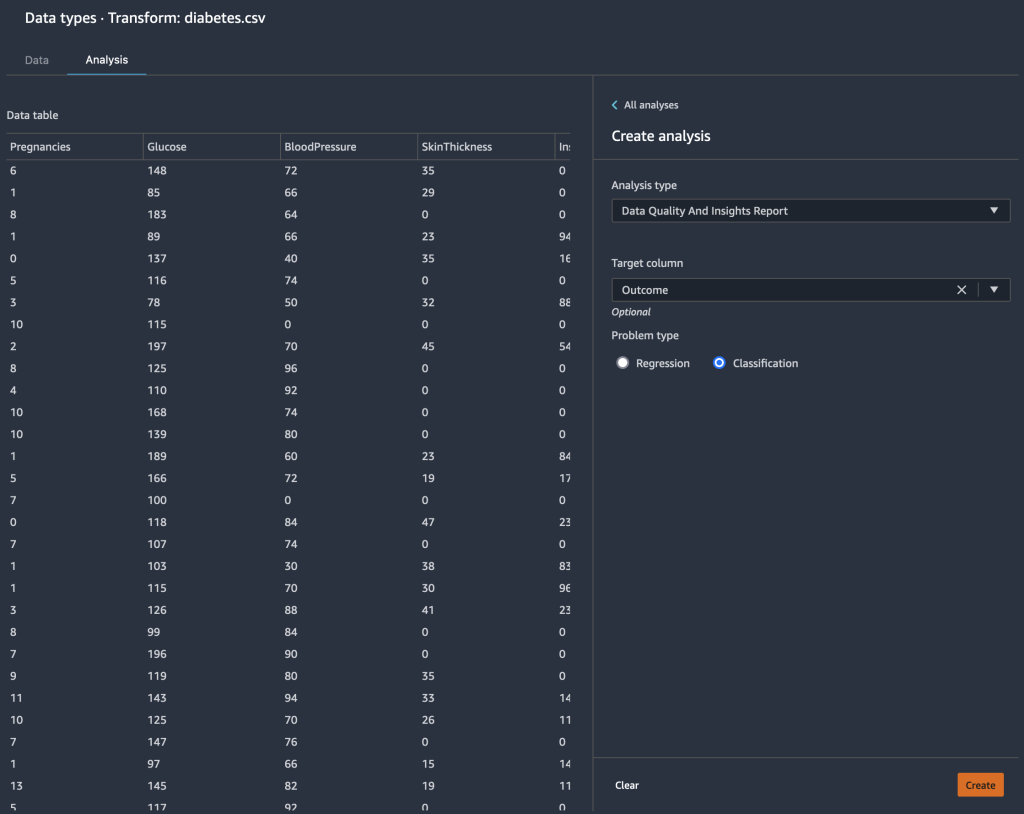

- Wählen Sie das Pluszeichen neben Datentypen und wählen Sie Bearbeiten um zu bestätigen, dass Data Wrangler automatisch die richtigen Datentypen für Ihre Datenspalten abgeleitet hat.

Wenn die Datentypen nicht korrekt sind, können Sie sie einfach über die Benutzeroberfläche ändern. Wenn mehrere Datenquellen vorhanden sind, können Sie sie verbinden oder verketten.

Wir können jetzt eine Analyse erstellen und Transformationen hinzufügen.

Führen Sie explorative Datenanalysen mit dem Data-Insights-Bericht durch

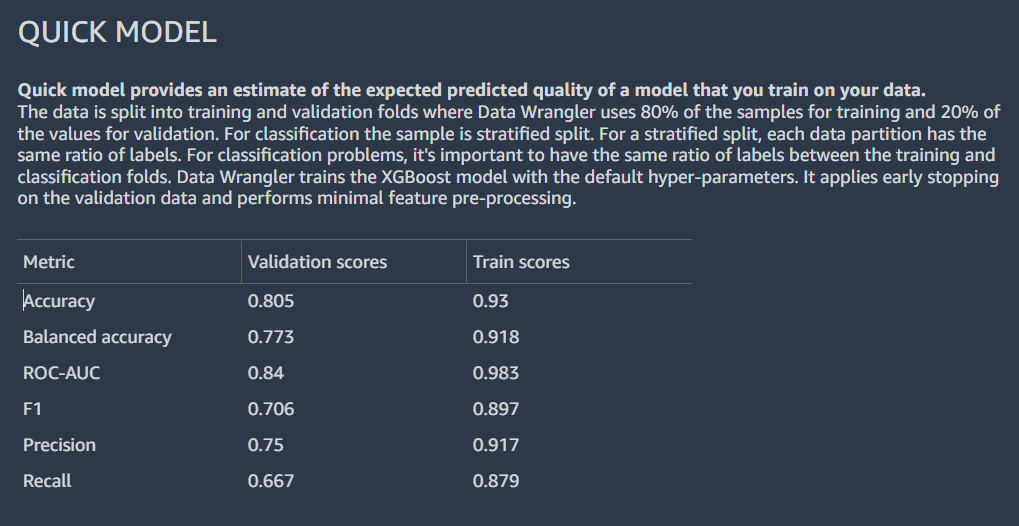

Die explorative Datenanalyse ist ein wichtiger Bestandteil des ML-Workflows. Wir können den neuen Data Insights-Bericht von Data Wrangler verwenden, um das Profil und die Verteilung unserer Daten besser zu verstehen. Der Bericht enthält zusammenfassende Statistiken, Datenqualitätswarnungen, Einblicke in Zielspalten, ein Schnellmodell und Informationen zu anomalen und doppelten Zeilen.

- Wählen Sie das Pluszeichen neben Datentypen und wählen Sie Erhalten Sie Dateneinblicke.

- Aussichten für Target Überblick, wählen Ergebnis.

- Aussichten für Problemtyp, und (optional) auswählen Klassifikation.

- Auswählen Erstellen.

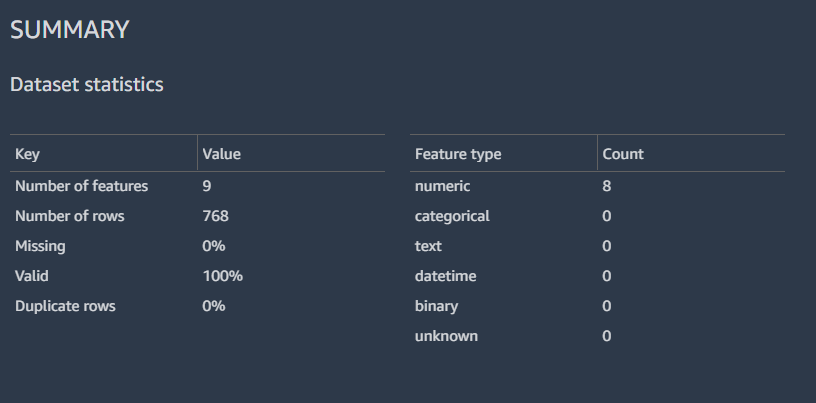

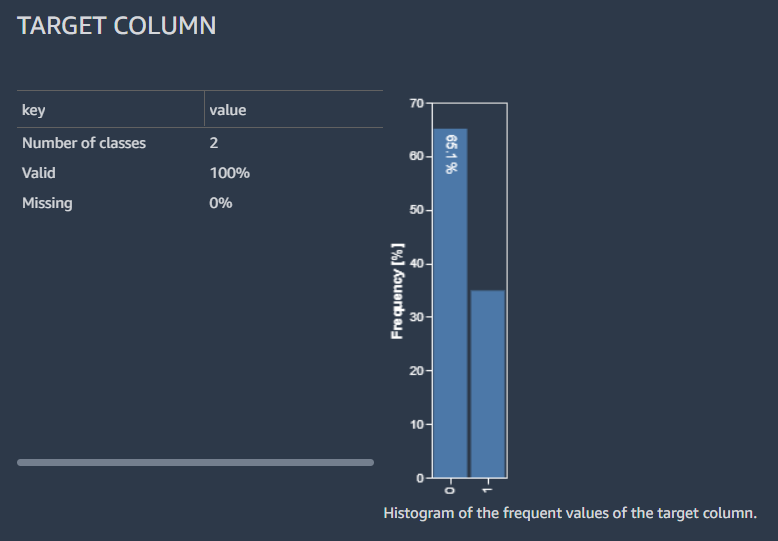

Die Ergebnisse zeigen zusammenfassende Daten mit den Datensatzstatistiken.

Wir können auch die Verteilung der beschrifteten Zeilen mit einem Histogramm, einer Schätzung der erwarteten vorhergesagten Qualität des Modells mit der Schnellmodellfunktion und einer Funktionszusammenfassungstabelle anzeigen.

Wir gehen nicht auf die Details der Analyse des Data-Insights-Berichts ein; beziehen auf Beschleunigen Sie die Datenvorbereitung mit Datenqualität und Erkenntnissen in Amazon SageMaker Data Wrangler für weitere Einzelheiten darüber, wie Sie den Data-Insights-Bericht verwenden können, um Ihre Datenvorbereitungsschritte zu beschleunigen.

Feature-Engineering durchführen

Nachdem wir die Verteilung unserer Eingabespalten auf hoher Ebene profiliert und analysiert haben, könnte die erste Überlegung zur Verbesserung der Qualität unserer Daten darin bestehen, fehlende Werte zu behandeln.

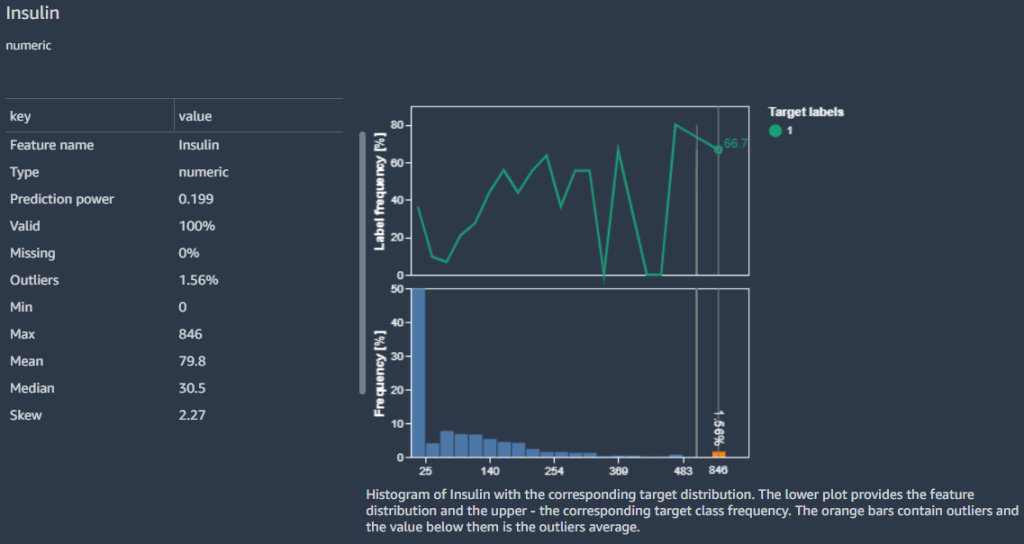

Zum Beispiel wissen wir, dass Nullen (0) für die Insulin Spalte stellen fehlende Werte dar. Wir könnten der Empfehlung folgen, die Nullen durch zu ersetzen NaN. Aber bei näherer Betrachtung stellen wir fest, dass der Mindestwert für andere Spalten wie z. B. 0 ist Glucose, BloodPressure, SkinThickness und BMI. Wir brauchen eine Möglichkeit, mit fehlenden Werten umzugehen, müssen aber empfindlich auf Spalten mit Nullen als gültige Daten reagieren. Mal sehen, wie wir das beheben können.

Im Funktion Details Abschnitt hebt der Bericht a Verschleierter fehlender Wert Warnung für die Funktion Insulin.

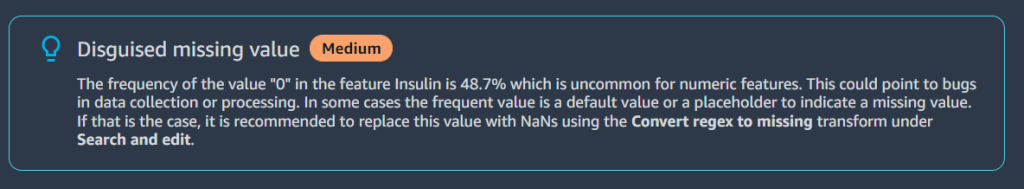

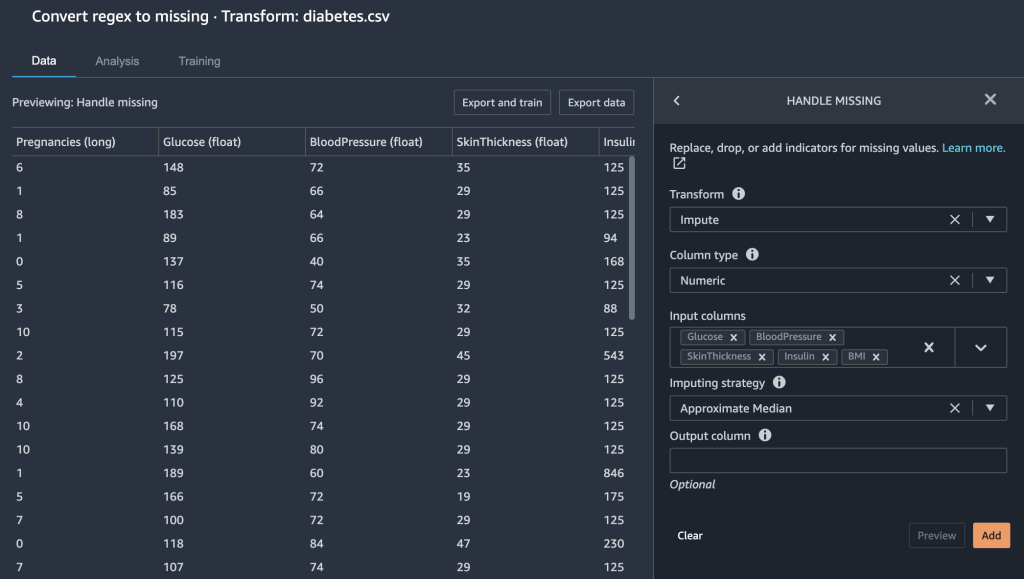

Denn Nullen in der Insulin Spalte fehlen tatsächlich Daten, wir verwenden die Regex in fehlen umwandeln to transform, um Nullwerte in leere (fehlende Werte) umzuwandeln.

- Wählen Sie das Pluszeichen neben Datum Typen und wählen Sie Speichern transformieren.

- Auswählen Suchen und bearbeiten.

- Aussichten für Transformieren, wählen Regex in fehlen umwandeln to.

- Aussichten für zufuhr Spalten, wählen Sie die Spalten aus

Insulin,Glucose,BloodPressure,SkinThicknessundBMI. - Aussichten für Schnittmuster, eingeben

0. - Auswählen Vorspann und Speichern um diesen Schritt zu speichern.

Die 0 Einträge unter Insulin, Glucose, BloodPressure, SkinThickness und BMI fehlen nun Werte.

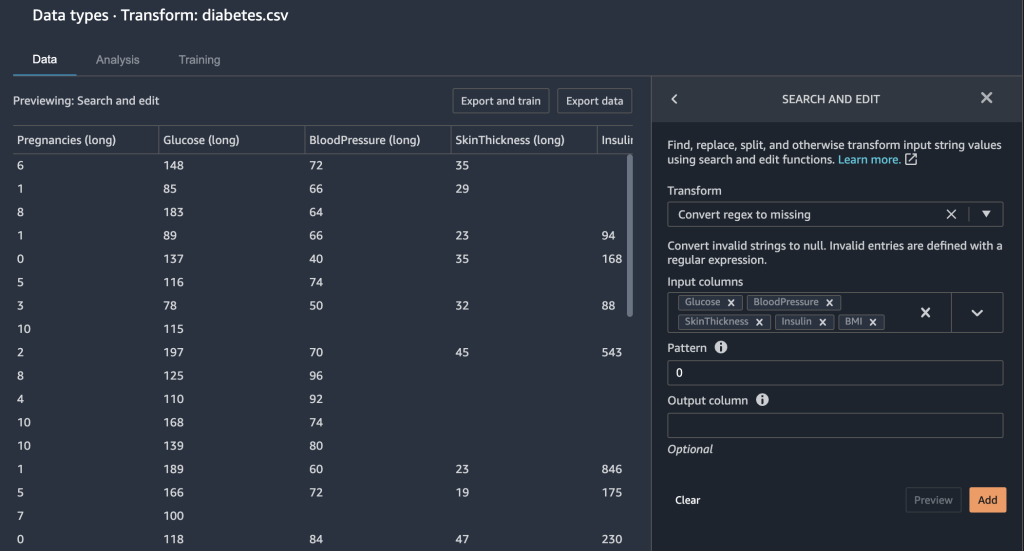

Data Wrangler bietet Ihnen einige weitere Optionen, um fehlende Werte zu korrigieren.

- Wir behandeln fehlende Werte, indem wir den ungefähren Median für die imputieren

GlucoseSpalte.

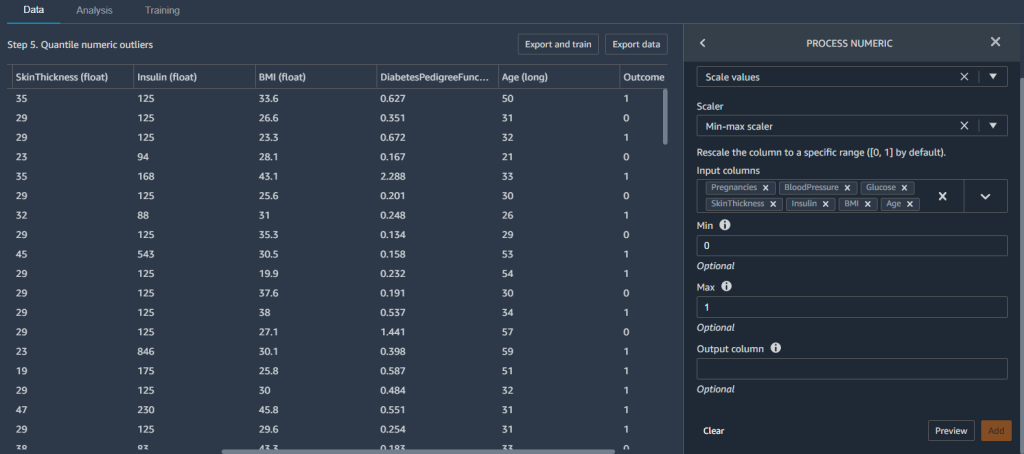

Wir möchten auch sicherstellen, dass unsere Funktionen im gleichen Umfang sind. Wir möchten einem bestimmten Merkmal nicht versehentlich mehr Gewicht geben, nur weil es einen größeren numerischen Bereich enthält. Dazu normalisieren wir unsere Features.

- Hinzufügen eines neuen Prozess numerisch verwandeln und wählen Werte skalieren.

- Aussichten für Scaler, wählen Min-Max-Skalierer.

- Aussichten für Eingabespalten, wählen Sie die Spalten aus

Pregnancies,BloodPressure,Glucose,SkinThickness,Insulin,BMIundAge. - Sept Min. zu

0und Max zu1.

Dadurch wird sichergestellt, dass unsere Merkmale zwischen den Werten liegen 0 und 1.

Nachdem wir nun einige Funktionen erstellt haben, teilen wir unser Dataset in Training und Test auf, bevor wir ein Modell erstellen.

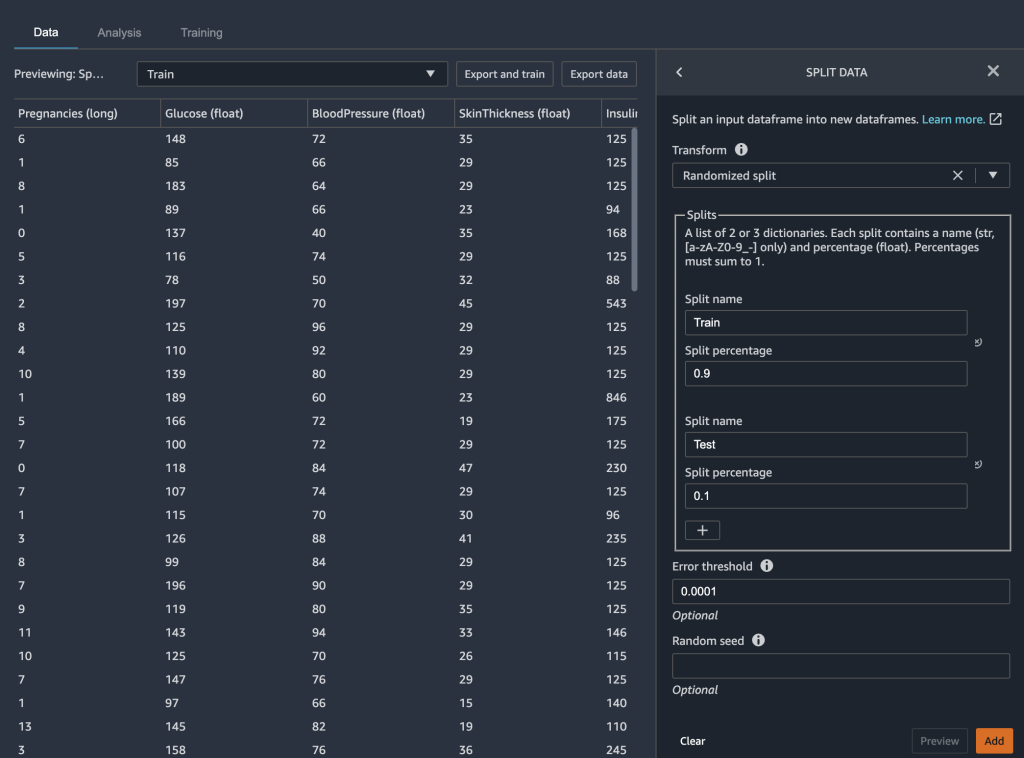

Teilen Sie die Daten in Training und Test auf

In der Modellerstellungsphase Ihres ML-Workflows testen Sie die Wirksamkeit Ihres Modells, indem Sie Stapelvorhersagen ausführen. Sie können einen Test- oder Holdout-Datensatz zur Auswertung beiseite legen, um zu sehen, wie Ihr Modell funktioniert, indem Sie die Vorhersagen mit der Grundwahrheit vergleichen. Im Allgemeinen, wenn mehr Vorhersagen des Modells mit den übereinstimmen true Labels können wir feststellen, dass das Modell gut funktioniert.

Wir verwenden Data Wrangler, um unseren Datensatz zum Testen aufzuteilen. Wir behalten 90 % unseres Datensatzes für das Training, da wir einen relativ kleinen Datensatz haben. Die restlichen 10 % unseres Datensatzes dienen als Testdatensatz. Wir verwenden diesen Datensatz, um das Autopilot-Modell später in diesem Beitrag zu validieren.

Wir teilen unsere Daten auf, indem wir die auswählen Daten aufteilen transformieren und wählen Randomisierte Aufteilung als Methode. Wir bezeichnen 0.9 als Aufteilungsprozentsatz für das Training und 0.1 für das Testen.

Nachdem die Datentransformation und die technischen Schritte abgeschlossen sind, können wir jetzt ein Modell trainieren.

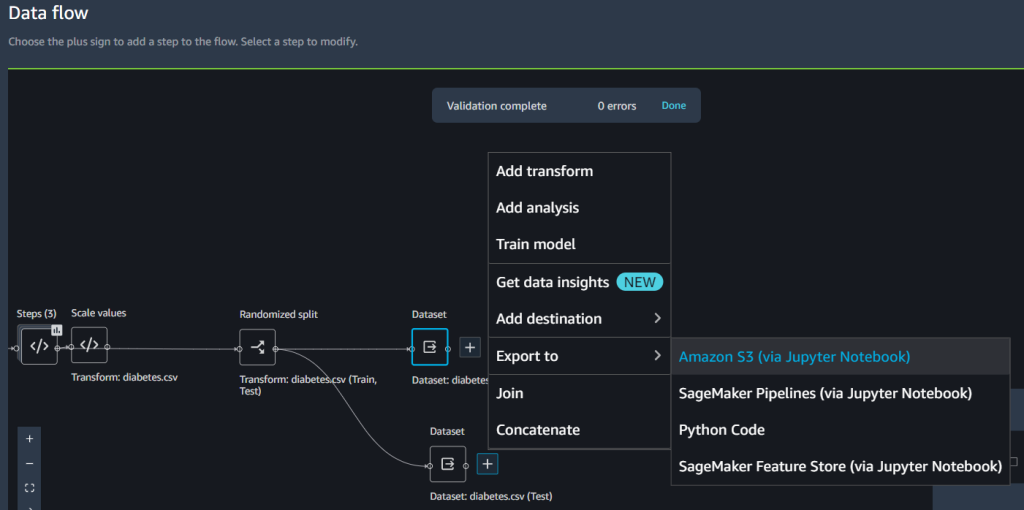

Trainieren und validieren Sie das Modell

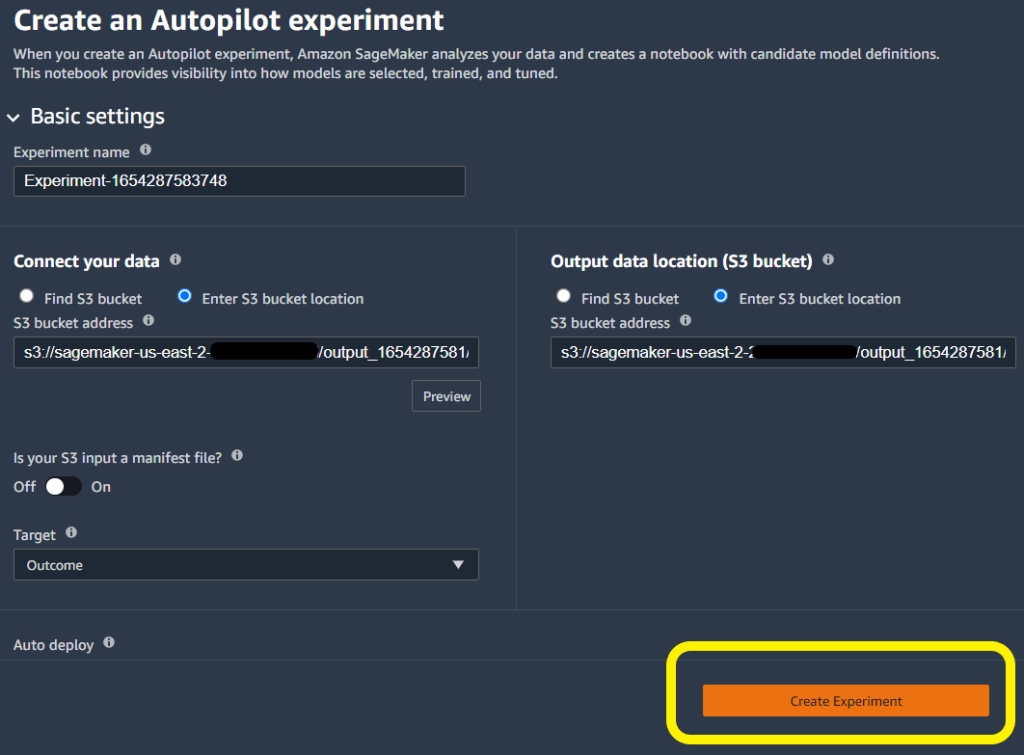

Wir können die neue Data Wrangler-Integration mit Autopilot verwenden, um ein Modell direkt über die Datenfluss-Benutzeroberfläche von Data Wrangler zu trainieren.

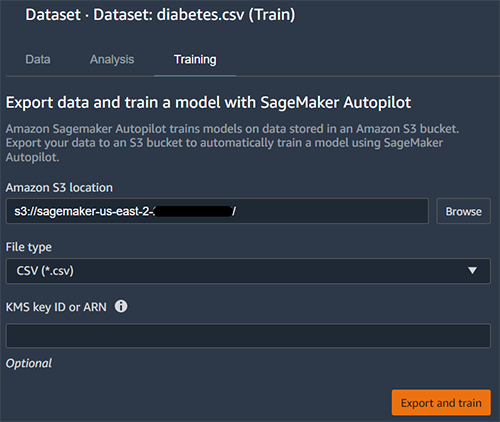

- Wählen Sie das Pluszeichen neben Datensatz und wählen Sie Zugmodell.

- Aussichten für Amazon S3-Standort, geben Sie den Amazon S3-Speicherort an, an den SageMaker Ihre Daten exportiert.

Autopilot verwendet diesen Speicherort, um ein Modell automatisch zu trainieren, wodurch Sie Zeit sparen, indem Sie den Ausgabespeicherort des Data Wrangler-Flusses definieren und dann den Eingabespeicherort der Autopilot-Trainingsdaten definieren müssen. Dies sorgt für ein nahtloseres Erlebnis.

- Auswählen Exportieren und trainieren um den Modellbau mit Autopilot zu initiieren.

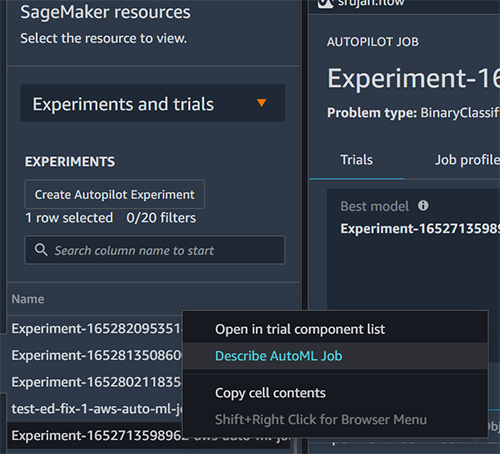

Autopilot wählt automatisch die Eingabe- und Ausgabeorte für Trainingsdaten aus. Sie müssen nur die Zielspalte angeben und klicken Experiment erstellen um Ihr Modell zu trainieren.

Testen Sie das Modell an einer Holdout-Stichprobe

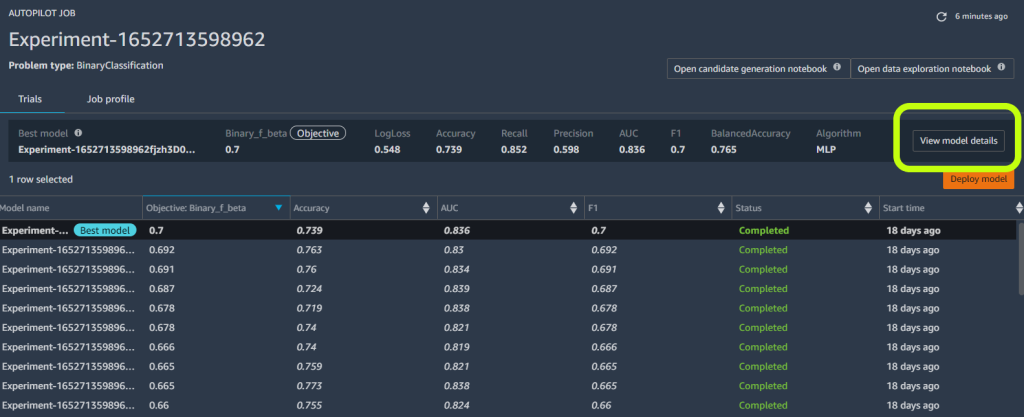

Wenn Autopilot das Experiment abgeschlossen hat, können wir die Trainingsergebnisse anzeigen und das beste Modell untersuchen.

- Auswählen Modelldetails anzeigen für Ihr gewünschtes Modell, dann wählen Sie das aus Leistung Registerkarte auf der Modelldetailseite.

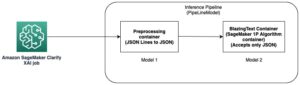

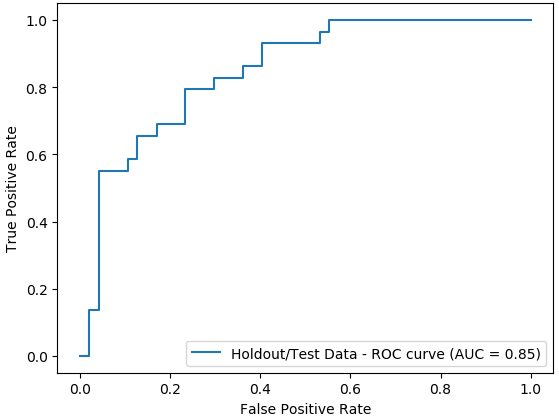

Das Leistung Registerkarte zeigt mehrere Modellmessungstests an, einschließlich einer Verwirrungsmatrix, der Fläche unter der Präzisions-/Recall-Kurve (AUCPR) und der Fläche unter der Receiver Operating Characteristic Curve (ROC). Diese veranschaulichen die Gesamtvalidierungsleistung des Modells, aber sie sagen uns nicht, ob das Modell gut verallgemeinern wird. Wir müssen noch Auswertungen auf unsichtbaren Testdaten durchführen, um zu sehen, wie genau das Modell vorhersagt, ob eine Person Diabetes haben wird.

Um sicherzustellen, dass sich das Modell gut genug verallgemeinern lässt, legen wir die Teststichprobe für unabhängige Stichproben beiseite. Wir können dies in der Flow-Benutzeroberfläche von Data Wrangler tun.

- Wählen Sie das Pluszeichen neben Datensatz, wählen Exportieren nach, und wähle Amazon S3.

- Geben Sie einen Amazon S3-Pfad an.

Wir verweisen auf diesen Pfad, wenn wir im nächsten Abschnitt die Batch-Inferenz zur Validierung ausführen.

- Erstellen Sie ein neues SageMaker-Notebook, um Batch-Inferenzen für die Holdout-Stichprobe durchzuführen und die Testleistung zu bewerten. Siehe Folgendes GitHub Repo für eine Beispiel Notizbuch Batch-Inferenz zur Validierung auszuführen.

Analysieren Sie die Validierungs- und Testsatzleistung

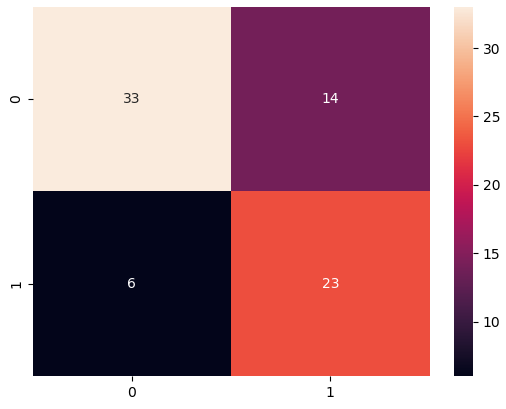

Wenn die Stapeltransformation abgeschlossen ist, erstellen wir eine Konfusionsmatrix, um die tatsächlichen und vorhergesagten Ergebnisse des Holdout-Datensatzes zu vergleichen.

Wir sehen 23 echte Positive und 33 echte Negative aus unseren Ergebnissen. In unserem Fall beziehen sich echte Positive auf das Modell, das korrekt vorhersagt, dass eine Person Diabetes hat. Im Gegensatz dazu beziehen sich echte Negative auf das Modell, das korrekt vorhersagt, dass eine Person keinen Diabetes hat.

In unserem Fall sind Precision und Recall wichtige Metriken. Präzision misst im Wesentlichen alle Personen, bei denen vorhergesagt wird, dass sie Diabetes haben. Wie viele haben wirklich Diabetes? Im Gegensatz dazu hilft der Rückruf dabei, alle Personen zu messen, die tatsächlich an Diabetes leiden. Bei wie vielen wurde vorhergesagt, dass sie an Diabetes leiden? Beispielsweise möchten Sie möglicherweise ein Modell mit hoher Präzision verwenden, weil Sie so viele Personen wie möglich behandeln möchten, insbesondere wenn die erste Behandlungsstufe keine Wirkung auf Personen ohne Diabetes hat (dies sind falsch positive Ergebnisse – diejenigen, die als Diabetiker gekennzeichnet sind). obwohl sie es tatsächlich nicht tun).

Wir zeichnen auch die Fläche unter dem Diagramm der ROC-Kurve (AUC) auf, um die Ergebnisse zu bewerten. Je höher die AUC, desto besser kann das Modell zwischen Klassen unterscheiden, was in unserem Fall die Leistung des Modells bei der Unterscheidung von Patienten mit und ohne Diabetes ist.

Zusammenfassung

In diesem Beitrag haben wir gezeigt, wie Sie Ihre Datenverarbeitung mit Engineering und Modellerstellung mit Data Wrangler und Autopilot integrieren können. Wir haben hervorgehoben, wie Sie ein Modell mit Autopilot direkt von der Benutzeroberfläche von Data Wrangler aus trainieren und optimieren können. Mit dieser Integrationsfunktion können wir nach Abschluss der Funktionsentwicklung schnell ein Modell erstellen, ohne Code schreiben zu müssen. Dann haben wir auf das beste Modell von Autopilot verwiesen, um Batchvorhersagen mithilfe der AutoML-Klasse mit dem SageMaker Python SDK auszuführen.

Low-Code- und AutoML-Lösungen wie Data Wrangler und Autopilot machen fundierte Codierungskenntnisse überflüssig, um robuste ML-Modelle zu erstellen. Beginnen Sie mit der Verwendung von Data Wrangler erfahren Sie heute, wie einfach es ist, ML-Modelle mit zu erstellen SageMaker-Autopilot.

Über die Autoren

Peter Chung ist Solutions Architect für AWS und hilft Kunden mit Leidenschaft dabei, Erkenntnisse aus ihren Daten zu gewinnen. Er hat Lösungen entwickelt, die Unternehmen dabei helfen, datengesteuerte Entscheidungen sowohl im öffentlichen als auch im privaten Sektor zu treffen. Er besitzt alle AWS-Zertifizierungen sowie zwei GCP-Zertifizierungen. Er genießt Kaffee, kocht, bleibt aktiv und verbringt Zeit mit seiner Familie.

Peter Chung ist Solutions Architect für AWS und hilft Kunden mit Leidenschaft dabei, Erkenntnisse aus ihren Daten zu gewinnen. Er hat Lösungen entwickelt, die Unternehmen dabei helfen, datengesteuerte Entscheidungen sowohl im öffentlichen als auch im privaten Sektor zu treffen. Er besitzt alle AWS-Zertifizierungen sowie zwei GCP-Zertifizierungen. Er genießt Kaffee, kocht, bleibt aktiv und verbringt Zeit mit seiner Familie.

Pradeep Reddy ist Senior Product Manager im SageMaker Low/No Code ML-Team, zu dem SageMaker Autopilot und SageMaker Automatic Model Tuner gehören. Außerhalb der Arbeit liest Pradeep gerne, läuft und macht mit handtellergroßen Computern wie Himbeer-Pi und anderen Heimautomatisierungstechnologien herum.

Pradeep Reddy ist Senior Product Manager im SageMaker Low/No Code ML-Team, zu dem SageMaker Autopilot und SageMaker Automatic Model Tuner gehören. Außerhalb der Arbeit liest Pradeep gerne, läuft und macht mit handtellergroßen Computern wie Himbeer-Pi und anderen Heimautomatisierungstechnologien herum.

Arunprasath Shankar ist ein auf AWS spezialisierter Lösungsarchitekt für künstliche Intelligenz und maschinelles Lernen (AI / ML), der globalen Kunden hilft, ihre KI-Lösungen effektiv und effizient in der Cloud zu skalieren. In seiner Freizeit sieht Arun gerne Science-Fiction-Filme und hört klassische Musik.

Arunprasath Shankar ist ein auf AWS spezialisierter Lösungsarchitekt für künstliche Intelligenz und maschinelles Lernen (AI / ML), der globalen Kunden hilft, ihre KI-Lösungen effektiv und effizient in der Cloud zu skalieren. In seiner Freizeit sieht Arun gerne Science-Fiction-Filme und hört klassische Musik.

Srujan Gopu ist Senior Frontend Engineer in SageMaker Low Code/No Code ML und unterstützt Kunden von Autopilot- und Canvas-Produkten. Wenn er nicht programmiert, geht Srujan gerne mit seinem Hund Max laufen, hört sich Hörbücher an und entwickelt VR-Spiele.

Srujan Gopu ist Senior Frontend Engineer in SageMaker Low Code/No Code ML und unterstützt Kunden von Autopilot- und Canvas-Produkten. Wenn er nicht programmiert, geht Srujan gerne mit seinem Hund Max laufen, hört sich Hörbücher an und entwickelt VR-Spiele.

- Coinsmart. Europas beste Bitcoin- und Krypto-Börse.

- Platoblockkette. Web3-Metaverse-Intelligenz. Wissen verstärkt. DEN FREIEN ZUGANG.

- CryptoHawk. Altcoin-Radar. Kostenlose Testphase.

- Quelle: https://aws.amazon.com/blogs/machine-learning/unified-data-preparation-and-model-training-with-amazon-sagemaker-data-wrangler-and-amazon-sagemaker-autopilot/

- "

- 100

- 7

- 9

- a

- Fähigkeit

- Über uns

- beschleunigen

- genau

- aktiv

- Zusatz

- Zusätzliche

- AI

- Algorithmen

- Alle

- Amazon

- Analyse

- analysieren

- Bereich

- Arizona

- künstlich

- künstliche Intelligenz

- Künstliche Intelligenz und maschinelles Lernen

- Audio-

- automatische

- Im Prinzip so, wie Sie es von Google Maps kennen.

- Automation

- AWS

- weil

- Bevor

- BESTE

- zwischen

- Blut

- Körper

- Bücher

- bauen

- Building

- baut

- Geschäft

- Leinwand

- Häuser

- sicher

- Wahl

- Auswählen

- Klasse

- Unterricht

- näher

- Cloud

- Code

- Programmierung

- Kaffee

- Kolonne

- abschließen

- Abschluss

- Computer

- Konzentration

- Vertrauen

- Verwirrung

- Berücksichtigung

- enthält

- Smartgeräte App

- könnte

- erstellen

- erstellt

- Erstellen

- kritischem

- Kurve

- Kunden

- technische Daten

- Datenanalyse

- Datenverarbeitung

- Entscheidungen

- tief

- Verzögerungen

- weisen nach, dass

- abhängig

- Detail

- Details

- Bestimmen

- Entwicklung

- Direkt

- Direkt

- diskutieren

- Displays

- Verteilung

- Ärzte

- Domain

- Früh

- leicht

- bewirken

- effektiv

- effizient

- ermöglichen

- Ingenieur

- Entwicklung

- Enter

- insbesondere

- im Wesentlichen

- schätzen

- bewerten

- Auswertung

- Beispiel

- erwartet

- ERFAHRUNGEN

- Experiment

- Experten

- ERKUNDEN

- Familie

- beschleunigt

- Merkmal

- Eigenschaften

- Einzigartige

- findet

- Vorname

- erstes Mal

- Fixieren

- Fluss

- Setzen Sie mit Achtsamkeit

- folgen

- Folgende

- für

- voller

- Spiel

- allgemein

- Global

- gehen

- mehr

- Gruppe an

- Griff

- mit

- Gesundheit

- Höhe

- Hilfe

- Unternehmen

- hilft

- High

- hochwertige

- hohes Risiko

- höher

- Besondere

- hält

- Startseite

- Home Automation

- Ultraschall

- Hilfe

- HTTPS

- Krankheit

- Impact der HXNUMXO Observatorien

- wichtig

- zu unterstützen,

- Verbesserung

- Dazu gehören

- Einschließlich

- unabhängig

- Index

- Krankengymnastik

- Einzelpersonen

- Information

- Varianten des Eingangssignals:

- Einblicke

- integrieren

- integriert

- Integration

- Intelligenz

- Schnittstelle

- IT

- Job

- join

- Wissen

- Wissen

- Etiketten

- größer

- starten

- ins Leben gerufen

- führen

- lernen

- Niveau

- Cholesterinspiegel

- wahrscheinlich

- Line

- Hören

- wenig

- leben

- Standorte

- Standorte

- Maschine

- Maschinelles Lernen

- halten

- um

- MACHT

- Making

- Manager

- Spiel

- Matrix

- Angelegenheiten

- messen

- Maßnahmen

- sowie medizinische

- Metrik

- México

- Minimum

- Minderheit

- ML

- Modell

- für

- mehr

- Filme

- mehrere

- Musik

- notwendig,

- weiter

- NIH

- Notizbuch

- Anzahl

- Eröffnung

- die

- Entwicklungsmöglichkeiten

- Optionen

- Organisationen

- Andere

- Gesamt-

- Teil

- leidenschaftlich

- Prozentsatz

- Leistung

- Durchführung

- Phase

- Bevölkerung

- Pradeep

- vorhersagen

- Prognose

- Prognosen

- Danach

- Gegenwart

- Druck

- privat

- Prozessdefinierung

- Verarbeitung

- Produkt

- Produkte

- Profil

- Profiling

- Projekt

- die

- bietet

- Öffentlichkeit

- Qualität

- Direkt

- schnell

- wirft

- Angebot

- Lesebrillen

- Aufzeichnungen

- verbleibenden

- berichten

- vertreten

- Die Ergebnisse

- Risiko

- Führen Sie

- Laufen

- gleich

- Einsparung

- Skalieren

- Wissenschaftler

- Sdk

- nahtlos

- nahtlos

- Suche

- Sektoren

- Leistungen

- kompensieren

- mehrere

- Schild

- Einfacher

- Single

- Haut

- klein

- So

- Lösungen

- einige

- Spezialist

- Geschwindigkeit

- Ausgabe

- gespalten

- Stufe

- Anfang

- begonnen

- State-of-the-art

- Statistiken

- Immer noch

- Lagerung

- speichern

- rationalisieren

- Target

- Team

- Tech

- Techniken

- Test

- Testen

- Tests

- Das

- deswegen

- Durch

- Zeit

- mal

- heute

- Toleranz

- Ausbildung

- schult Ehrenamtliche

- Transformieren

- Transformation

- Transformationen

- behandeln

- Behandlungen

- Typen

- ui

- aufdecken

- für

- Verständnis

- us

- -

- validiert

- Bestätigung

- Wert

- Anzeigen

- Sichtbarkeit

- vr

- Verwundbar

- warten

- Was

- WHO

- .

- ohne

- Arbeiten

- Workflows

- Schreiben

- Jahr

- Ihr

- Null