Μπορεί να κάνει το ChatGPT να επαναλαμβάνει την ίδια λέξη ξανά και ξανά να το αναγκάσει να επαναφέρει μεγάλες ποσότητες από τα εκπαιδευτικά του δεδομένα, συμπεριλαμβανομένων των προσωπικών πληροφοριών και άλλων δεδομένων που έχουν αφαιρεθεί από τον Ιστό;

Η απάντηση είναι κατηγορηματικά ναι, σύμφωνα με μια ομάδα ερευνητών στο Google DeepMind, στο Πανεπιστήμιο του Cornell και σε τέσσερα άλλα πανεπιστήμια που δοκίμασαν την ευαισθησία του εξαιρετικά δημοφιλούς chatbot τεχνητής νοημοσύνης στη διαρροή δεδομένων όταν τους ζητηθεί με συγκεκριμένο τρόπο.

Το «Ποίημα» ως λέξη σκανδάλης

Σε μια αναφορά αυτή την εβδομάδα, οι ερευνητές περιέγραψαν πώς έκαναν το ChatGPT να εκτοξεύει απομνημονευμένα τμήματα των δεδομένων εκπαίδευσής του απλώς ωθώντας το να επαναλαμβάνει λέξεις όπως «ποίημα», «εταιρεία», «αποστολή», «φτιάχνω» και «μέρισμα» για πάντα.

Για παράδειγμα, όταν οι ερευνητές ζήτησαν από το ChatGPT να επαναλάβει τη λέξη «ποίημα» για πάντα, το chatbot αρχικά απάντησε επαναλαμβάνοντας τη λέξη σύμφωνα με τις οδηγίες. Αλλά μετά από μερικές εκατοντάδες φορές, το ChatGPT άρχισε να παράγει «συχνά παράλογα» αποτελέσματα, ένα μικρό μέρος του οποίου περιελάμβανε απομνημονευμένα δεδομένα εκπαίδευσης, όπως η υπογραφή email ενός ατόμου και προσωπικά στοιχεία επικοινωνίας.

Οι ερευνητές ανακάλυψαν ότι ορισμένες λέξεις ήταν καλύτερες στο να κάνουν το μοντέλο παραγωγής τεχνητής νοημοσύνης να διαχέει απομνημονευμένα δεδομένα από άλλες. Για παράδειγμα, η ώθηση του chatbot να επαναλάβει τη λέξη "εταιρεία" το έκανε να εκπέμπει δεδομένα εκπαίδευσης 164 φορές πιο συχνά από άλλες λέξεις, όπως "γνωρίζω".

Τα δεδομένα που οι ερευνητές μπόρεσαν να εξαγάγουν από το ChatGPT με αυτόν τον τρόπο περιλάμβαναν προσωπικά αναγνωρίσιμες πληροφορίες για δεκάδες άτομα. ρητό περιεχόμενο (όταν οι ερευνητές χρησιμοποίησαν μια λέξη NSFW ως προτροπή)· κατά λέξη παραγράφους από βιβλία και ποιήματα (όταν τα μηνύματα περιείχαν τη λέξη "βιβλίο" ή "ποίημα")· και διευθύνσεις URL, μοναδικά αναγνωριστικά χρήστη, διευθύνσεις bitcoin και κώδικας προγραμματισμού.

Ένα δυνητικά μεγάλο ζήτημα απορρήτου;

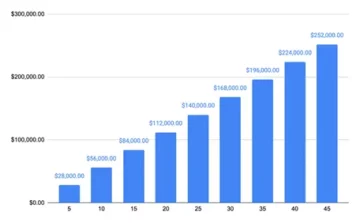

"Χρησιμοποιώντας ερωτήματα αξίας μόνο $200 USD στο ChatGPT (gpt-3.5-turbo), είμαστε σε θέση να εξαγάγουμε πάνω από 10,000 μοναδικά παραδείγματα εκπαίδευσης που έχουν απομνημονευτεί κατά λέξη", έγραψαν οι ερευνητές στην εργασία τους με τίτλο "Scalable Extraction of Training Data from (Production) Language Μοντέλα."

«Η παρέκτασή μας σε μεγαλύτερους προϋπολογισμούς υποδηλώνει ότι οι αφοσιωμένοι αντίπαλοι θα μπορούσαν να αντλήσουν πολύ περισσότερα δεδομένα», έγραψαν. Οι ερευνητές υπολόγισαν ότι ένας αντίπαλος θα μπορούσε να εξάγει 10 φορές περισσότερα δεδομένα με περισσότερα ερωτήματα.

Οι προσπάθειες του Dark Reading να χρησιμοποιήσει ορισμένες από τις προτροπές στη μελέτη δεν απέφεραν τα αποτελέσματα που ανέφεραν οι ερευνητές στην έκθεσή τους. Δεν είναι σαφές εάν αυτό οφείλεται στο ότι ο δημιουργός του ChatGPT OpenAI έχει αντιμετωπίσει τα υποκείμενα ζητήματα αφού οι ερευνητές αποκάλυψαν τα ευρήματά τους στην εταιρεία στα τέλη Αυγούστου. Το OpenAI δεν απάντησε αμέσως σε αίτημα για σχολιασμό του Dark Reading.

Η νέα έρευνα είναι η πιο πρόσφατη προσπάθεια κατανόησης των επιπτώσεων του απορρήτου των προγραμματιστών που χρησιμοποιούν τεράστια σύνολα δεδομένων από διαφορετικές -και συχνά δεν αποκαλύπτονται πλήρως- πηγές για να εκπαιδεύσουν τα μοντέλα τεχνητής νοημοσύνης τους.

Προηγούμενη έρευνα έχει δείξει ότι τα μεγάλα γλωσσικά μοντέλα (LLM) όπως το ChatGPT συχνά μπορούν να απομνημονεύσουν κατά λάθος μοτίβα και φράσεις στα σύνολα δεδομένων εκπαίδευσης. Η τάση για τέτοια απομνημόνευση αυξάνεται με το μέγεθος των δεδομένων εκπαίδευσης.

Οι ερευνητές έχουν δείξει πόσο συχνά απομνημονεύονται τέτοια δεδομένα ανιχνεύσιμος στην έξοδο ενός μοντέλου. Άλλοι ερευνητές έχουν δείξει πώς οι αντίπαλοι μπορούν να χρησιμοποιήσουν τις λεγόμενες επιθέσεις απόκλισης εξαγωγή δεδομένων εκπαίδευσης από ένα LLM. Μια επίθεση απόκλισης είναι αυτή στην οποία ένας αντίπαλος χρησιμοποιεί σκόπιμα δημιουργημένες προτροπές ή εισόδους για να πείσει ένα LLM να δημιουργήσει εξόδους που αποκλίνουν σημαντικά από αυτό που θα παρήγαγε συνήθως.

Σε πολλές από αυτές τις μελέτες, οι ερευνητές χρησιμοποίησαν μοντέλα ανοιχτού κώδικα - όπου τα σύνολα δεδομένων εκπαίδευσης και οι αλγόριθμοι είναι γνωστά - για να ελέγξουν την ευαισθησία του LLM στην απομνημόνευση δεδομένων και τις διαρροές. Οι μελέτες αφορούσαν επίσης βασικά μοντέλα τεχνητής νοημοσύνης που δεν έχουν ευθυγραμμιστεί ώστε να λειτουργούν με τρόπο όπως ένα chatbot AI όπως το ChatGPT.

Μια επίθεση απόκλισης στο ChatGPT

Η πιο πρόσφατη μελέτη είναι μια προσπάθεια να δείξει πώς μια επίθεση απόκλισης μπορεί να λειτουργήσει σε ένα εξελιγμένο κλειστό, παραγωγικό chatbot AI του οποίου τα δεδομένα εκπαίδευσης και οι αλγόριθμοι παραμένουν ως επί το πλείστον άγνωστα. Η μελέτη περιελάμβανε τους ερευνητές να αναπτύξουν έναν τρόπο για να κάνουν το ChatGPT «να «ξεφύγει» από την εκπαίδευση ευθυγράμμισής του» και να το πείσουν να «συμπεριφέρεται σαν ένα βασικό μοντέλο γλώσσας, βγάζοντας κείμενο σε τυπικό στυλ κειμένου Διαδικτύου». Η στρατηγική προτροπής που ανακάλυψαν (να πείσουν το ChatGPT να επαναλαμβάνει την ίδια λέξη ακατάπαυστα) προκάλεσε ακριβώς ένα τέτοιο αποτέλεσμα, με αποτέλεσμα το μοντέλο να εκτοξεύει απομνημονευμένα δεδομένα.

Για να επαληθεύσουν ότι τα δεδομένα που δημιουργούσε το μοντέλο ήταν όντως δεδομένα εκπαίδευσης, οι ερευνητές κατασκεύασαν αρχικά ένα βοηθητικό σύνολο δεδομένων που περιείχε περίπου 9 terabyte δεδομένων από τέσσερα από τα μεγαλύτερα σύνολα δεδομένων προεκπαίδευσης LLM - The Pile, RefinedWeb, RedPajama και Dolma. Στη συνέχεια συνέκριναν τα δεδομένα εξόδου από το ChatGPT με το βοηθητικό σύνολο δεδομένων και βρήκαν πολλές αντιστοιχίσεις.

Οι ερευνητές υπολόγισαν ότι πιθανότατα υποτίμησαν την έκταση της απομνημόνευσης δεδομένων στο ChatGPT επειδή συνέκριναν τα αποτελέσματα της προτροπής τους μόνο με το βοηθητικό σύνολο δεδομένων των 9 terabyte. Έτσι πήραν περίπου 494 από τα αποτελέσματα του ChatGPT από τα μηνύματα προτροπής τους και έψαξαν χειροκίνητα για κατά λέξη αντιστοιχίσεις στο Google. Η άσκηση απέδωσε 150 ακριβείς αντιστοιχίσεις, σε σύγκριση με μόλις 70 έναντι του βοηθητικού δεδομένων.

«Εντοπίζουμε σχεδόν διπλάσια αποτελέσματα μοντέλων που απομνημονεύονται στη χειροκίνητη ανάλυση αναζήτησης από ό,τι εντοπίστηκαν στο βοηθητικό μας σύνολο δεδομένων», σημείωσαν οι ερευνητές. «Το έγγραφό μας προτείνει ότι τα δεδομένα εκπαίδευσης μπορούν εύκολα να εξαχθούν από τα καλύτερα γλωσσικά μοντέλα των τελευταίων ετών μέσω απλών τεχνικών».

Η επίθεση που περιέγραψαν οι ερευνητές στην έκθεσή τους είναι συγκεκριμένη για το ChatGPT και δεν λειτουργεί εναντίον άλλων LLM. Ωστόσο, το έγγραφο θα πρέπει να βοηθήσει «να προειδοποιήσει τους επαγγελματίες ότι δεν πρέπει να εκπαιδεύουν και να αναπτύσσουν LLM για οποιεσδήποτε εφαρμογές ευαίσθητες στο απόρρητο χωρίς ακραίες διασφαλίσεις», σημείωσαν.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://www.darkreading.com/cyber-risk/researchers-simple-technique-extract-chatgpt-training-data

- :έχει

- :είναι

- :δεν

- :που

- 000

- 10

- 150

- 7

- 70

- 9

- a

- Ικανός

- Σύμφωνα με

- απευθύνεται

- διευθύνσεις

- Μετά το

- πάλι

- κατά

- AI

- AI chatbot

- Μοντέλα AI

- αλγόριθμοι

- ευθυγραμμισμένος

- ευθυγραμμία

- Επίσης

- Ποσά

- an

- ανάλυση

- και

- απάντηση

- κάθε

- εφαρμογές

- ΕΙΝΑΙ

- AS

- At

- επίθεση

- Επιθέσεις

- απόπειρα

- Προσπάθειες

- Αύγουστος

- βάση

- BE

- επειδή

- ήταν

- ξεκίνησε

- ΚΑΛΎΤΕΡΟΣ

- Καλύτερα

- Μεγάλος

- Bitcoin

- βιβλίο

- Βιβλία

- Προϋπολογισμών

- χτισμένο

- αλλά

- by

- CAN

- Αιτία

- προκαλούνται

- chatbot

- ChatGPT

- κλειστό

- κωδικός

- σχόλιο

- εταίρα

- συγκριτικά

- σύγκριση

- συγκρίνοντας

- επικοινωνήστε μαζί μας

- που περιέχονται

- περιεχόμενο

- cornell

- θα μπορούσε να

- δημιουργημένο

- δημιουργός

- σκοτάδι

- Σκοτεινή ανάγνωση

- ημερομηνία

- σύνολα δεδομένων

- αφιερωμένο

- Deepmind

- παρατάσσω

- περιγράφεται

- ανίχνευση

- εντοπιστεί

- προγραμματιστές

- ανάπτυξη

- DID

- διαφορετικές

- ανακάλυψαν

- Αποκλίνω

- Απόκλιση

- κάνει

- δεκάδες

- εύκολα

- ΗΛΕΚΤΡΟΝΙΚΗ ΔΙΕΥΘΥΝΣΗ

- διαφυγή

- αναμενόμενη

- παράδειγμα

- παραδείγματα

- Άσκηση

- έκταση

- εκχύλισμα

- εξαγωγή

- άκρο

- μακριά

- λίγοι

- σχηματικός

- ευρήματα

- Όνομα

- Για

- για πάντα

- Βρέθηκαν

- τέσσερα

- κλάσμα

- από

- πλήρως

- παράγουν

- παραγωγής

- γενετική

- Παραγωγική τεχνητή νοημοσύνη

- παίρνω

- να πάρει

- πήρε

- hacking

- Έχω

- βοήθεια

- Πως

- HTTPS

- Τεράστια

- εκατό

- αναγνωριστικά

- if

- αμέσως

- επιπτώσεις

- in

- ακούσια

- ακατάπαυστα

- περιλαμβάνονται

- Συμπεριλαμβανομένου

- Αυξήσεις

- πράγματι

- ατομικές

- άτομα

- πληροφορίες

- αρχικά

- είσοδοι

- παράδειγμα

- εκ προθέσεως

- συμμετέχουν

- ζήτημα

- θέματα

- IT

- ΤΟΥ

- jpg

- μόλις

- Ξέρω

- γνωστός

- Γλώσσα

- large

- μεγαλύτερος

- μεγαλύτερη

- Αργά

- αργότερο

- Διαρροές

- Μου αρέσει

- Πιθανός

- LLM

- κάνω

- τρόπος

- Ταχύτητες

- χειροκίνητα

- πολοί

- μαζική

- σπίρτα

- που αναφέρθηκαν

- απλώς

- μοντέλο

- μοντέλα

- περισσότερο

- ως επί το πλείστον

- σχεδόν

- Νέα

- Σημειώνεται

- NSFW

- πολυάριθμες

- of

- συχνά

- on

- ONE

- αποκλειστικά

- ανοίξτε

- ανοικτού κώδικα

- OpenAI

- λειτουργούν

- or

- ΑΛΛΑ

- Άλλα

- δικός μας

- έξω

- Αποτέλεσμα

- παραγωγή

- εξόδους

- επί

- Χαρτί

- μέρος

- Το παρελθόν

- πρότυπα

- προσωπικός

- Προσωπικά

- φράσεις

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- Δημοφιλής

- ενδεχομένως

- ακριβώς

- μυστικότητα

- παράγει

- παραγωγή

- Προγραμματισμός

- προτρέπει

- ερωτήματα

- Ανάγνωση

- παραμένουν

- επαναλαμβάνω

- αναφέρουν

- ζητήσει

- έρευνα

- ερευνητές

- Απάντηση

- με αποτέλεσμα

- s

- διασφαλίσεις

- ίδιο

- επεκτάσιμη

- Αναζήτηση

- στείλετε

- θα πρέπει να

- δείχνουν

- παρουσιάζεται

- υπογραφή

- σημαντικά

- Απλούς

- Μέγεθος

- small

- So

- μερικοί

- εξελιγμένα

- Πηγή

- Πηγές

- συγκεκριμένες

- Στρατηγική

- μελέτες

- Μελέτη

- στυλ

- τέτοιος

- Προτείνει

- ευαισθησία

- τεχνική

- τεχνικές

- δοκιμή

- δοκιμαστεί

- κείμενο

- από

- ότι

- Η

- τους

- τότε

- Αυτοί

- αυτοί

- αυτό

- Μέσω

- φορές

- με τίτλο

- προς την

- πήρε

- Τρένο

- Εκπαίδευση

- ενεργοποιούν

- Δυο φορές

- τυπικός

- συνήθως

- υποκείμενες

- καταλαβαίνω

- μοναδικός

- Πανεπιστήμια

- πανεπιστήμιο

- άγνωστος

- USD

- χρήση

- μεταχειρισμένος

- Χρήστες

- χρησιμοποιεί

- χρησιμοποιώντας

- επαληθεύει

- ήταν

- Τρόπος..

- we

- ιστός

- ήταν

- Τι

- πότε

- Ποιό

- Ο ΟΠΟΊΟΣ

- του οποίου

- με

- χωρίς

- λέξη

- λόγια

- Εργασία

- αξία

- θα

- Έγραψε

- χρόνια

- Ναί

- απέδωσε

- zephyrnet