Καθώς περισσότεροι οργανισμοί υιοθετούν τεχνολογίες τεχνητής νοημοσύνης που δημιουργούνται — για να δημιουργήσουν θέσεις, να συμπληρώσουν αιτήσεις επιχορήγησης και να γράψουν κωδικός λέβητα — οι ομάδες ασφαλείας συνειδητοποιούν την ανάγκη να απαντήσουν σε μια νέα ερώτηση: Πώς προστατεύετε τα εργαλεία τεχνητής νοημοσύνης;

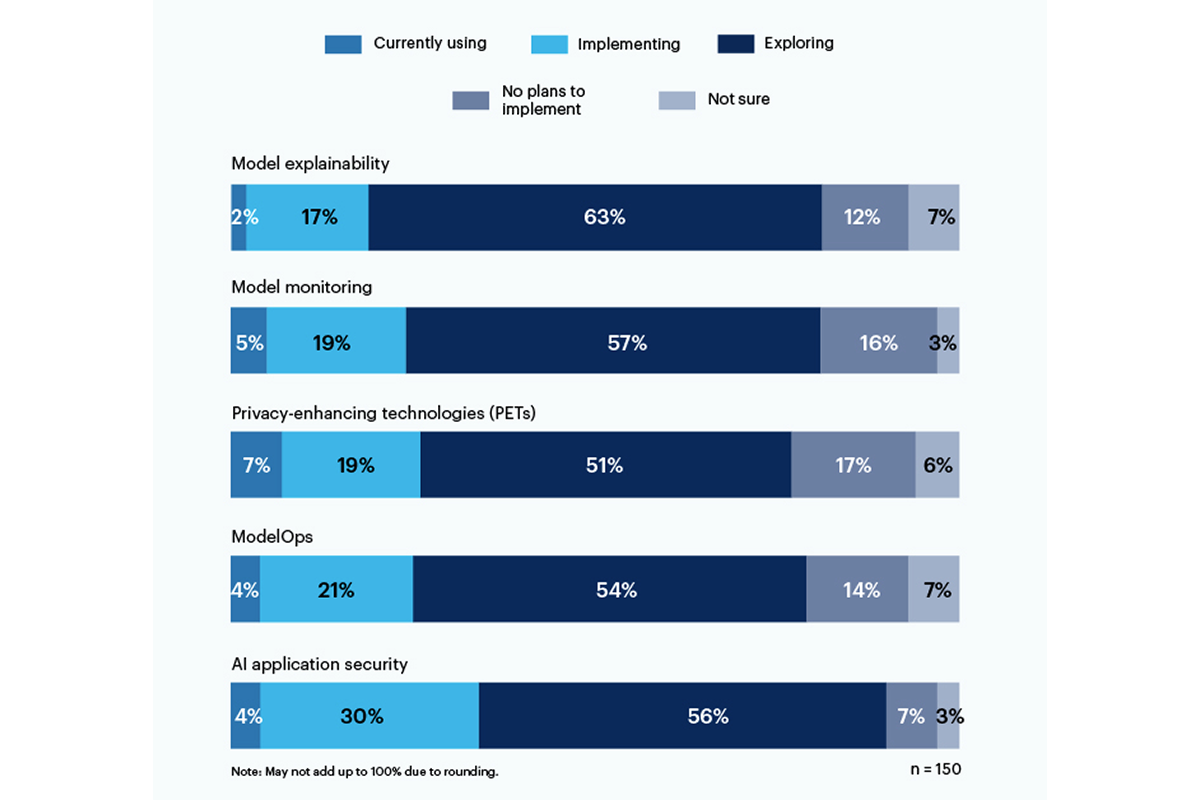

Το ένα τρίτο των ερωτηθέντων σε μια πρόσφατη έρευνα από τη Gartner ανέφερε είτε χρήση ή εφαρμογή εργαλείων ασφαλείας εφαρμογών που βασίζονται σε AI για την αντιμετώπιση των κινδύνων που εγκυμονεί η χρήση γενετικής τεχνητής νοημοσύνης στον οργανισμό τους.

Οι τεχνολογίες ενίσχυσης της ιδιωτικής ζωής (PETs) έδειξαν τη μεγαλύτερη τρέχουσα χρήση, στο 7% των ερωτηθέντων, με ένα σταθερό 19% των εταιρειών που το εφαρμόζουν. αυτή η κατηγορία περιλαμβάνει τρόπους προστασίας των προσωπικών δεδομένων, όπως π.χ ομομορφική κρυπτογράφηση, Συνθετικά δεδομένα που δημιουργούνται από AI, ασφαλής πολυμερής υπολογισμός, ομοσπονδιακή μάθηση, να διαφορετική ιδιωτικότητα. Ωστόσο, ένα σταθερό 17% δεν έχει σχέδια να ωθήσει τα PET στο περιβάλλον τους.

Μόνο το 19% χρησιμοποιεί ή εφαρμόζει εργαλεία για την επεξήγηση του μοντέλου, αλλά υπάρχει σημαντικό ενδιαφέρον (56%) μεταξύ των ερωτηθέντων για την εξερεύνηση και κατανόηση αυτών των εργαλείων για την αντιμετώπιση του παραγωγικού κινδύνου AI. Η επεξήγηση, η παρακολούθηση μοντέλων και τα εργαλεία ασφαλείας εφαρμογών τεχνητής νοημοσύνης μπορούν όλα να χρησιμοποιηθούν σε μοντέλα ανοιχτού κώδικα ή ιδιόκτητα για την επίτευξη αξιοπιστίας και αξιοπιστίας που χρειάζονται οι εταιρικοί χρήστες, σύμφωνα με την Gartner.

Οι κίνδυνοι για τους οποίους ανησυχούν περισσότερο οι ερωτηθέντες περιλαμβάνουν λανθασμένα ή μεροληπτικά αποτελέσματα (58%) και τρωτά σημεία ή μυστικά που διέρρευσαν σε κώδικα που δημιουργείται από AI (57%). Είναι σημαντικό ότι το 43% ανέφερε πιθανά ζητήματα πνευματικών δικαιωμάτων ή αδειοδότησης που προκύπτουν από περιεχόμενο που δημιουργείται από AI ως κορυφαίους κινδύνους για τον οργανισμό τους.

«Δεν υπάρχει ακόμη διαφάνεια σχετικά με τα μοντέλα δεδομένων στα οποία εκπαιδεύονται, επομένως ο κίνδυνος που σχετίζεται με την προκατάληψη και το απόρρητο είναι πολύ δύσκολο να κατανοηθεί και να εκτιμηθεί», έγραψε στέλεχος της C-suite απαντώντας στην έρευνα της Gartner.

Τον Ιούνιο, το Εθνικό Ινστιτούτο Προτύπων και Τεχνολογίας (NIST) δημιούργησε μια δημόσια ομάδα εργασίας για να βοηθήσει στην αντιμετώπιση αυτού του ζητήματος, με βάση το Πλαίσιο Διαχείρισης Κινδύνων AI από τον Ιανουάριο. Όπως δείχνουν τα στοιχεία της Gartner, οι εταιρείες δεν περιμένουν για τις οδηγίες NIST.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://www.darkreading.com/tech-talks/companies-rely-multiple-methods-secure-generative-ai

- :είναι

- :δεν

- 7

- a

- ΠΛΗΡΟΦΟΡΙΕΣ

- Σύμφωνα με

- Κατορθώνω

- διεύθυνση

- ενστερνίζομαι

- AI

- Όλα

- μεταξύ των

- και

- Εφαρμογή

- ασφάλεια εφαρμογών

- εφαρμογές

- ΕΙΝΑΙ

- AS

- συσχετισμένη

- At

- βασίζονται

- BE

- προκατάληψη

- μεροληπτική

- αλλά

- by

- C-σουίτα

- CAN

- κατηγορία

- παραπομπή

- κωδικός

- Εταιρείες

- πλήρης

- ενδιαφερόμενος

- περιεχόμενο

- πνευματική ιδιοκτησία

- σκάφος

- Ρεύμα

- ημερομηνία

- δύσκολος

- οδηγιών

- do

- είτε

- Εταιρεία

- Περιβάλλον

- εκτίμηση

- εκτελεστικός

- Εξερευνώντας

- Για

- Πλαίσιο

- από

- Gartner

- γενετική

- Παραγωγική τεχνητή νοημοσύνη

- χορηγεί

- μεγαλύτερη

- Έχω

- βοήθεια

- Πως

- Ωστόσο

- HTTPS

- εκτελεστικών

- in

- περιλαμβάνουν

- περιλαμβάνει

- Ινστιτούτο

- τόκος

- θέματα

- IT

- ΤΟΥ

- Ιανουάριος

- Ιούνιος

- ξεκίνησε

- αδειοδότηση

- διαχείριση

- μέθοδοι

- μοντέλο

- μοντέλα

- παρακολούθηση

- περισσότερο

- πλέον

- πολλαπλούς

- εθνικός

- Ανάγκη

- Νέα

- nist

- Όχι.

- of

- on

- ανοίξτε

- ανοικτού κώδικα

- or

- επιχειρήσεις

- οργανώσεις

- προσωπικός

- προσωπικά δεδομένα

- Κατοικίδια

- γήπεδα

- φώναξε

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- θέτει

- δυναμικού

- μυστικότητα

- ιδιόκτητο

- προστασία

- δημόσιο

- ερώτηση

- συνειδητοποιώντας

- πρόσφατος

- αξιοπιστία

- βασίζονται

- αναφέρθηκαν

- ερωτηθέντες

- απάντησης

- Κίνδυνος

- διαχείριση των κινδύνων

- κινδύνους

- μυστικά

- προστατευμένο περιβάλλον

- ασφάλεια

- έδειξε

- Δείχνει

- σημαντικός

- σημαντικά

- So

- στέρεο

- Πηγή

- πρότυπα

- Ακόμη

- τέτοιος

- Έρευνες

- συνθετικός

- ομάδες

- Τεχνολογίες

- Τεχνολογία

- ότι

- Η

- τους

- Εκεί.

- Αυτοί

- αυτό

- προς την

- εργαλεία

- κορυφή

- Εκπαίδευση

- Διαφάνεια

- αξιοπιστία

- καταλαβαίνω

- κατανόηση

- χρήση

- μεταχειρισμένος

- Χρήστες

- χρησιμοποιώντας

- πολύ

- Θέματα ευπάθειας

- τρόπους

- με

- εργαζόμενος

- γράφω

- Έγραψε

- Εσείς

- zephyrnet