Η βιομηχανία των βιντεοπαιχνιδιών έχει εκτιμώμενη βάση χρηστών που ξεπερνά τα 3 δισεκατομμύρια παγκοσμίως1. Αποτελείται από τεράστιες ποσότητες παικτών που ουσιαστικά αλληλεπιδρούν μεταξύ τους κάθε μέρα. Δυστυχώς, όπως και στον πραγματικό κόσμο, δεν επικοινωνούν όλοι οι παίκτες κατάλληλα και με σεβασμό. Σε μια προσπάθεια να δημιουργήσει και να διατηρήσει ένα κοινωνικά υπεύθυνο περιβάλλον παιχνιδιού, ζητήθηκε από την AWS Professional Services να δημιουργήσει έναν μηχανισμό που ανιχνεύει ακατάλληλη γλώσσα (τοξική ομιλία) στις αλληλεπιδράσεις των παικτών διαδικτυακών παιχνιδιών. Το συνολικό επιχειρηματικό αποτέλεσμα ήταν να βελτιωθούν οι λειτουργίες του οργανισμού αυτοματοποιώντας μια υπάρχουσα μη αυτόματη διαδικασία και να βελτιώσει την εμπειρία του χρήστη αυξάνοντας την ταχύτητα και την ποιότητα στον εντοπισμό ακατάλληλων αλληλεπιδράσεων μεταξύ των παικτών, προωθώντας τελικά ένα καθαρότερο και πιο υγιεινό περιβάλλον παιχνιδιού.

Ο πελάτης ζήτησε να δημιουργήσει έναν ανιχνευτή αγγλικής γλώσσας που ταξινομεί αποσπάσματα φωνής και κειμένου στις δικές τους κατηγορίες τοξικών γλωσσών που καθορίζονται κατά παραγγελία. Ήθελαν πρώτα να προσδιορίσουν εάν το συγκεκριμένο γλωσσικό απόσπασμα είναι τοξικό και στη συνέχεια να ταξινομήσουν το απόσπασμα σε μια συγκεκριμένη κατηγορία τοξικότητας που καθορίζεται από τον πελάτη, όπως βωμολοχίες ή υβριστική γλώσσα.

Η AWS ProServe έλυσε αυτήν την περίπτωση χρήσης μέσω μιας κοινής προσπάθειας μεταξύ του Generative AI Innovation Center (GAIIC) και της ProServe ML Delivery Team (MLDT). Το AWS GAIIC είναι ένας όμιλος εντός του AWS ProServe που συνδυάζει πελάτες με ειδικούς για την ανάπτυξη λύσεων τεχνητής νοημοσύνης για ένα ευρύ φάσμα περιπτώσεων επαγγελματικής χρήσης χρησιμοποιώντας δομές απόδειξης ιδέας (PoC). Στη συνέχεια, το AWS ProServe MLDT παίρνει το PoC μέσω της παραγωγής κλιμακώνοντας, σκληρύνοντας και ενσωματώνοντας τη λύση για τον πελάτη.

Αυτή η περίπτωση χρήσης πελατών θα παρουσιαστεί σε δύο ξεχωριστές αναρτήσεις. Αυτή η ανάρτηση (Μέρος 1) χρησιμεύει ως μια βαθιά κατάδυση στην επιστημονική μεθοδολογία. Θα εξηγήσει τη διαδικασία σκέψης και τον πειραματισμό πίσω από τη λύση, συμπεριλαμβανομένης της διαδικασίας εκπαίδευσης και ανάπτυξης του μοντέλου. Το Μέρος 2 θα εμβαθύνει στη λύση παραγωγής, εξηγώντας τις αποφάσεις σχεδιασμού, τη ροή δεδομένων και την απεικόνιση της αρχιτεκτονικής εκπαίδευσης και ανάπτυξης του μοντέλου.

Αυτή η ανάρτηση καλύπτει τα ακόλουθα θέματα:

- Οι προκλήσεις που έπρεπε να λύσει το AWS ProServe για αυτήν την περίπτωση χρήσης

- Ιστορικό πλαίσιο σχετικά με τα μεγάλα γλωσσικά μοντέλα (LLM) και γιατί αυτή η τεχνολογία ταιριάζει απόλυτα σε αυτήν την περίπτωση χρήσης

- Η λύση PoC της AWS GAIIC και AWS ProServe MLDT από την προοπτική της επιστήμης δεδομένων και της μηχανικής μάθησης (ML)

Πρόκληση δεδομένων

Η κύρια πρόκληση που αντιμετώπισε η AWS ProServe με την εκπαίδευση ενός ταξινομητή τοξικών γλωσσών ήταν να αποκτήσει αρκετά δεδομένα με ετικέτα από τον πελάτη για να εκπαιδεύσει ένα ακριβές μοντέλο από την αρχή. Η AWS έλαβε περίπου 100 δείγματα επισημασμένων δεδομένων από τον πελάτη, τα οποία είναι πολύ λιγότερα από τα 1,000 δείγματα που συνιστώνται για την τελειοποίηση ενός LLM στην κοινότητα της επιστήμης δεδομένων.

Ως πρόσθετη εγγενής πρόκληση, οι ταξινομητές επεξεργασίας φυσικής γλώσσας (NLP) είναι ιστορικά γνωστό ότι είναι πολύ δαπανηροί στην εκπαίδευση και απαιτούν ένα μεγάλο σύνολο λεξιλογίου, γνωστό ως σώμα, για την παραγωγή ακριβών προβλέψεων. Μια αυστηρή και αποτελεσματική λύση NLP, εάν παρείχε επαρκή όγκο δεδομένων με ετικέτα, θα ήταν η εκπαίδευση ενός μοντέλου προσαρμοσμένης γλώσσας χρησιμοποιώντας τα δεδομένα με ετικέτα του πελάτη. Το μοντέλο θα εκπαιδευόταν αποκλειστικά με το λεξιλόγιο των παιχνιδιών των παικτών, καθιστώντας το προσαρμοσμένο στη γλώσσα που παρατηρείται στα παιχνίδια. Ο πελάτης είχε περιορισμούς κόστους και χρόνου που έκαναν αυτή τη λύση μη βιώσιμη. Το AWS ProServe αναγκάστηκε να βρει μια λύση για να εκπαιδεύσει έναν ακριβή ταξινομητή γλωσσικής τοξικότητας με ένα σχετικά μικρό σύνολο δεδομένων με ετικέτα. Η λύση βρισκόταν σε αυτό που είναι γνωστό ως μεταφορά της μάθησης.

Η ιδέα πίσω από τη μεταφορά μάθησης είναι να χρησιμοποιήσουμε τη γνώση ενός προεκπαιδευμένου μοντέλου και να την εφαρμόσουμε σε ένα διαφορετικό αλλά σχετικά παρόμοιο πρόβλημα. Για παράδειγμα, εάν ένας ταξινομητής εικόνων είχε εκπαιδευτεί να προβλέπει εάν μια εικόνα περιέχει γάτα, θα μπορούσατε να χρησιμοποιήσετε τη γνώση που απέκτησε το μοντέλο κατά την εκπαίδευσή του για να αναγνωρίσει άλλα ζώα όπως οι τίγρεις. Για αυτήν την περίπτωση χρήσης γλώσσας, το AWS ProServe χρειαζόταν να βρει έναν προηγουμένως εκπαιδευμένο ταξινομητή γλώσσας που να ήταν εκπαιδευμένος να ανιχνεύει τοξική γλώσσα και να τον ρυθμίζει με ακρίβεια χρησιμοποιώντας τα δεδομένα με ετικέτα του πελάτη.

Η λύση ήταν να βρεθεί και να τελειοποιηθεί ένα LLM για την ταξινόμηση της τοξικής γλώσσας. Τα LLM είναι νευρωνικά δίκτυα που έχουν εκπαιδευτεί χρησιμοποιώντας έναν τεράστιο αριθμό παραμέτρων, συνήθως της τάξης των δισεκατομμυρίων, χρησιμοποιώντας δεδομένα χωρίς ετικέτα. Πριν προχωρήσετε στη λύση AWS, η ακόλουθη ενότητα παρέχει μια επισκόπηση του ιστορικού των LLM και των ιστορικών περιπτώσεων χρήσης τους.

Αξιοποιώντας τη δύναμη των LLM

Τα LLM έχουν γίνει πρόσφατα το επίκεντρο για τις επιχειρήσεις που αναζητούν νέες εφαρμογές ML, από τότε που το ChatGPT αιχμαλώτισε το κοινό, καθώς είναι η ταχύτερα αναπτυσσόμενη εφαρμογή καταναλωτών στην ιστορία2, φτάνοντας τους 100 εκατομμύρια ενεργούς χρήστες έως τον Ιανουάριο του 2023, μόλις 2 μήνες μετά την κυκλοφορία του. Ωστόσο, τα LLM δεν είναι μια νέα τεχνολογία στον χώρο του ML. Έχουν χρησιμοποιηθεί εκτενώς για την εκτέλεση εργασιών NLP, όπως η ανάλυση συναισθήματος, η σύνοψη κειμένων, η εξαγωγή λέξεων-κλειδιών, η μετάφραση ομιλίας και η ταξινόμηση κειμένου.

Λόγω της διαδοχικής φύσης του κειμένου, τα επαναλαμβανόμενα νευρωνικά δίκτυα (RNN) ήταν η τελευταία λέξη της τεχνολογίας για τη μοντελοποίηση NLP. Συγκεκριμένα, το κωδικοποιητής-αποκωδικοποιητής Η αρχιτεκτονική δικτύου διαμορφώθηκε επειδή δημιούργησε μια δομή RNN ικανή να λάβει μια είσοδο αυθαίρετου μήκους και να δημιουργήσει μια έξοδο αυθαίρετου μήκους. Αυτό ήταν ιδανικό για εργασίες NLP όπως η μετάφραση, όπου μια φράση εξόδου μιας γλώσσας μπορούσε να προβλεφθεί από μια φράση εισόδου μιας άλλης γλώσσας, συνήθως με διαφορετικό αριθμό λέξεων μεταξύ της εισόδου και της εξόδου. Η αρχιτεκτονική του μετασχηματιστή3 (Vaswani, 2017) ήταν μια σημαντική βελτίωση στον κωδικοποιητή-αποκωδικοποιητή. εισήγαγε την έννοια του αυτο-προσοχή, που επέτρεψε στο μοντέλο να εστιάσει την προσοχή του σε διαφορετικές λέξεις στις φράσεις εισόδου και εξόδου. Σε έναν τυπικό κωδικοποιητή-αποκωδικοποιητή, κάθε λέξη ερμηνεύεται από το μοντέλο με τον ίδιο τρόπο. Καθώς το μοντέλο επεξεργάζεται διαδοχικά κάθε λέξη σε μια φράση εισαγωγής, οι σημασιολογικές πληροφορίες στην αρχή μπορεί να χαθούν στο τέλος της φράσης. Ο μηχανισμός αυτοπροσοχής το άλλαξε προσθέτοντας ένα επίπεδο προσοχής τόσο στον κωδικοποιητή όσο και στο μπλοκ αποκωδικοποιητή, έτσι ώστε το μοντέλο να μπορεί να βάζει διαφορετικές σταθμίσεις σε ορισμένες λέξεις από τη φράση εισόδου όταν δημιουργεί μια συγκεκριμένη λέξη στη φράση εξόδου. Έτσι γεννήθηκε η βάση του μοντέλου μετασχηματιστή.

Η αρχιτεκτονική του μετασχηματιστή ήταν το θεμέλιο για δύο από τα πιο γνωστά και δημοφιλή LLM που χρησιμοποιούνται σήμερα, τις Αμφίδρομες Αναπαραστάσεις Κωδικοποιητή από τους Μετασχηματιστές (BERT)4 (Radford, 2018) και το Generative Pretrained Transformer (GPT)5 (Devlin 2018). Οι μεταγενέστερες εκδόσεις του μοντέλου GPT, δηλαδή οι GPT3 και GPT4, είναι ο κινητήρας που τροφοδοτεί την εφαρμογή ChatGPT. Το τελευταίο κομμάτι της συνταγής που κάνει τα LLM τόσο ισχυρά είναι η ικανότητα απόσταξης πληροφοριών από τεράστια σώματα κειμένου χωρίς εκτεταμένη επισήμανση ή προεπεξεργασία μέσω μιας διαδικασίας που ονομάζεται ULMFiT. Αυτή η μέθοδος έχει μια προεκπαιδευτική φάση όπου μπορεί να συγκεντρωθεί το γενικό κείμενο και το μοντέλο εκπαιδεύεται στο έργο της πρόβλεψης της επόμενης λέξης με βάση τις προηγούμενες λέξεις. Το πλεονέκτημα εδώ είναι ότι κάθε κείμενο εισαγωγής που χρησιμοποιείται για εκπαίδευση είναι εγγενώς προσημασμένο με βάση τη σειρά του κειμένου. Τα LLM είναι πραγματικά ικανά να μάθουν από δεδομένα κλίμακας Διαδικτύου. Για παράδειγμα, το αρχικό μοντέλο BERT ήταν προεκπαιδευμένο στο BookCorpus και σε ολόκληρα σύνολα δεδομένων κειμένου της Αγγλικής Wikipedia.

Αυτό το νέο παράδειγμα μοντελοποίησης οδήγησε σε δύο νέες έννοιες: τα θεμελιώδη μοντέλα (FMs) και το Generative AI. Σε αντίθεση με την εκπαίδευση ενός μοντέλου από την αρχή με δεδομένα για συγκεκριμένες εργασίες, η οποία είναι η συνήθης περίπτωση για την κλασική εποπτευόμενη μάθηση, τα LLM είναι προεκπαιδευμένα για να εξάγουν γενικές γνώσεις από ένα ευρύ σύνολο δεδομένων κειμένου πριν προσαρμοστούν σε συγκεκριμένες εργασίες ή τομείς με πολύ μικρότερο σύνολο δεδομένων (συνήθως της τάξης των εκατοντάδων δειγμάτων). Η νέα ροή εργασίας ML ξεκινά τώρα με ένα προεκπαιδευμένο μοντέλο που ονομάζεται μοντέλο θεμελίωσης. Είναι σημαντικό να βασιστείτε στη σωστή βάση και υπάρχει ένας αυξανόμενος αριθμός επιλογών, όπως η νέα Amazon Titan FMs, που θα κυκλοφορήσει από την AWS ως μέρος του Θεμέλιο του Αμαζονίου. Αυτά τα νέα μοντέλα θεωρούνται επίσης παραγωγικά επειδή τα αποτελέσματα τους είναι ερμηνεύσιμα από τον άνθρωπο και στον ίδιο τύπο δεδομένων με τα δεδομένα εισόδου. Ενώ τα προηγούμενα μοντέλα ML ήταν περιγραφικά, όπως η ταξινόμηση εικόνων γατών έναντι σκύλων, τα LLM είναι παραγωγικά επειδή η έξοδος τους είναι το επόμενο σύνολο λέξεων που βασίζονται σε λέξεις εισόδου. Αυτό τους επιτρέπει να τροφοδοτούν διαδραστικές εφαρμογές όπως το ChatGPT που μπορούν να είναι εκφραστικές στο περιεχόμενο που δημιουργούν.

Το Hugging Face συνεργάστηκε με την AWS για τον εκδημοκρατισμό των FM και την εύκολη πρόσβαση και κατασκευή τους. Το Hugging Face έχει δημιουργήσει ένα Transformers API που ενοποιεί περισσότερες από 50 διαφορετικές αρχιτεκτονικές μετασχηματιστών σε διαφορετικά πλαίσια ML, συμπεριλαμβανομένης της πρόσβασης σε προεκπαιδευμένα βάρη μοντέλων στα Μοντέλο Hub, το οποίο έχει αυξηθεί σε πάνω από 200,000 μοντέλα από τη σύνταξη αυτής της ανάρτησης. Στις επόμενες ενότητες, διερευνούμε την απόδειξη της ιδέας, τη λύση και τα FM που δοκιμάστηκαν και επιλέχθηκαν ως βάση για την επίλυση αυτής της περίπτωσης χρήσης τοξικής ταξινόμησης ομιλίας για τον πελάτη.

AWS GAIIC απόδειξη της ιδέας

Η AWS GAIIC επέλεξε να πειραματιστεί με μοντέλα θεμελίωσης LLM με την αρχιτεκτονική BERT για να τελειοποιήσει έναν τοξικό ταξινομητή γλώσσας. Δοκιμάστηκαν συνολικά τρία μοντέλα από το κέντρο μοντέλων της Hugging Face:

Και οι τρεις αρχιτεκτονικές μοντέλων βασίζονται στο BERTweet αρχιτεκτονική. Το BERTweet εκπαιδεύεται με βάση το ΡοΜΠΕΡΤΑ προεκπαιδευτική διαδικασία. Η διαδικασία προεκπαίδευσης RoBERTa είναι αποτέλεσμα μιας μελέτης αναπαραγωγής της προ-προπόνησης BERT που αξιολόγησε τα αποτελέσματα του συντονισμού υπερπαραμέτρων και του μεγέθους του συνόλου εκπαίδευσης για τη βελτίωση της συνταγής για την εκπαίδευση μοντέλων BERT6 (Liu 2019). Το πείραμα προσπάθησε να βρει μια μέθοδο προεκπαίδευσης που βελτίωσε τα αποτελέσματα απόδοσης του BERT χωρίς να αλλάξει την υποκείμενη αρχιτεκτονική. Το συμπέρασμα της μελέτης διαπίστωσε ότι οι ακόλουθες τροποποιήσεις πριν από την προπόνηση βελτίωσαν σημαντικά την απόδοση του BERT:

- Εκπαίδευση του μοντέλου με μεγαλύτερες παρτίδες σε περισσότερα δεδομένα

- Κατάργηση του στόχου πρόβλεψης επόμενης πρότασης

- Προπόνηση σε μεγαλύτερες ακολουθίες

- Δυναμική αλλαγή του μοτίβου κάλυψης που εφαρμόζεται στα δεδομένα εκπαίδευσης

Το μοντέλο βάσης bertweet χρησιμοποιεί την προηγούμενη διαδικασία προεκπαίδευσης από τη μελέτη RoBERTa για να προεκπαιδεύσει την αρχική αρχιτεκτονική BERT χρησιμοποιώντας 850 εκατομμύρια αγγλικά tweets. Είναι το πρώτο δημόσιο μοντέλο γλώσσας μεγάλης κλίμακας προεκπαιδευμένο για αγγλικά tweets.

Τα προεκπαιδευμένα FM που χρησιμοποιούν tweets θεωρήθηκε ότι ταιριάζουν στην περίπτωση χρήσης για δύο βασικούς θεωρητικούς λόγους:

- Το μήκος ενός tweet μοιάζει πολύ με το μήκος μιας ακατάλληλης ή τοξικής φράσης που βρίσκεται σε διαδικτυακές συνομιλίες παιχνιδιών

- Τα tweets προέρχονται από έναν πληθυσμό με μεγάλη ποικιλία διαφορετικών χρηστών, παρόμοια με αυτή του πληθυσμού που βρίσκεται στις πλατφόρμες παιχνιδιών

Η AWS αποφάσισε πρώτα να τελειοποιήσει το BERTweet με τα δεδομένα με ετικέτα του πελάτη για να πάρει μια γραμμή βάσης. Στη συνέχεια, επέλεξε να βελτιστοποιήσει δύο άλλα FM σε bertweet-base-offensive και bertweet-base-hate που είχαν προεκπαιδευτεί περαιτέρω ειδικά σε πιο σχετικά τοξικά tweets για να επιτύχουν δυνητικά υψηλότερη ακρίβεια. Το μοντέλο bertweet-base-ofensive χρησιμοποιεί το βασικό BertTweet FM και είναι περαιτέρω προεκπαιδευμένο σε 14,100 σχολιασμένα tweets που θεωρήθηκαν προσβλητικά7 (Zampieri 2019). Το μοντέλο bertweet-base-hate χρησιμοποιεί επίσης το βασικό BertTweet FM, αλλά είναι περαιτέρω προεκπαιδευμένο σε 19,600 tweets που θεωρήθηκαν ως ρητορική μίσους8 (Βασίλης 2019).

Για να βελτιώσει περαιτέρω την απόδοση του μοντέλου PoC, η AWS GAIIC έλαβε δύο σχεδιαστικές αποφάσεις:

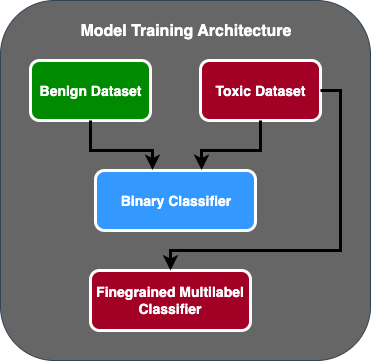

- Δημιουργήθηκε μια ροή πρόβλεψης δύο σταδίων όπου το πρώτο μοντέλο λειτουργεί ως δυαδικός ταξινομητής που ταξινομεί εάν ένα κομμάτι κειμένου είναι τοξικό ή όχι. Το δεύτερο μοντέλο είναι ένα λεπτόκοκκο μοντέλο που ταξινομεί το κείμενο με βάση τους καθορισμένους τύπους τοξικών από τον πελάτη. Μόνο αν το πρώτο μοντέλο προβλέπει το κείμενο ως τοξικό, περνά στο δεύτερο μοντέλο.

- Αύξησε τα δεδομένα εκπαίδευσης και πρόσθεσε ένα υποσύνολο ενός συνόλου δεδομένων τοξικών κειμένων με ετικέτα τρίτου μέρους από έναν δημόσιο διαγωνισμό Kaggle (Τοξικότητα παζλ) στα αρχικά 100 δείγματα που ελήφθησαν από τον πελάτη. Χαρτογράφησαν τις ετικέτες Jigsaw στις σχετικές ετικέτες τοξικότητας που καθορίζονται από τον πελάτη και έκαναν έναν διαχωρισμό 80% ως δεδομένα εκπαίδευσης και 20% διαχωρισμό ως δεδομένα δοκιμής για να επικυρώσουν το μοντέλο.

Χρησιμοποιείται AWS GAIIC Amazon Sage Maker σημειωματάρια για να εκτελέσουν τα πειράματά τους λεπτομέρειας και διαπίστωσαν ότι το μοντέλο bertweet-base-ofensive πέτυχε τις καλύτερες βαθμολογίες στο σύνολο επικύρωσης. Ο παρακάτω πίνακας συνοψίζει τις παρατηρούμενες μετρικές βαθμολογίες.

| Μοντέλο | Ακρίβεια | Ανάκληση | F1 | AUC |

| Binary | . 92 | . 90 | . 91 | . 92 |

| Λεπτόκοκκος | . 81 | . 80 | . 81 | . 89 |

Από αυτό το σημείο, η GAIIC παρέδωσε το PoC στην Ομάδα Παράδοσης AWS ProServe ML για την παραγωγή του PoC.

Λύση Ομάδας Παράδοσης AWS ProServe ML

Για την παραγωγή της αρχιτεκτονικής του μοντέλου, η Ομάδα Παράδοσης AWS ProServe ML (MLDT) κλήθηκε από τον πελάτη να δημιουργήσει μια λύση που να είναι επεκτάσιμη και εύκολη στη συντήρηση. Υπήρχαν μερικές προκλήσεις συντήρησης μιας προσέγγισης μοντέλου δύο σταδίων:

- Τα μοντέλα θα απαιτούσαν διπλάσια παρακολούθηση του μοντέλου, γεγονός που καθιστά ασυνεπή τον χρόνο επανεκπαίδευσης. Μπορεί να υπάρχουν φορές που το ένα μοντέλο θα πρέπει να επανεκπαιδεύεται συχνότερα από το άλλο.

- Αυξημένο κόστος λειτουργίας δύο μοντέλων σε αντίθεση με ένα.

- Η ταχύτητα εξαγωγής συμπερασμάτων επιβραδύνεται επειδή η εξαγωγή συμπερασμάτων διέρχεται από δύο μοντέλα.

Για να αντιμετωπίσει αυτές τις προκλήσεις, το AWS ProServe MLDT έπρεπε να βρει πώς να μετατρέψει την αρχιτεκτονική μοντέλων δύο σταδίων σε μια ενιαία αρχιτεκτονική μοντέλου, ενώ θα μπορούσε να διατηρήσει την ακρίβεια της αρχιτεκτονικής δύο σταδίων.

Η λύση ήταν να ζητηθεί πρώτα από τον πελάτη περισσότερα δεδομένα εκπαίδευσης και, στη συνέχεια, να βελτιστοποιηθεί το μοντέλο bertweet-base-ofensive σε όλες τις ετικέτες, συμπεριλαμβανομένων των μη τοξικών δειγμάτων, σε ένα μοντέλο. Η ιδέα ήταν ότι η λεπτομέρεια ενός μοντέλου με περισσότερα δεδομένα θα είχε παρόμοια αποτελέσματα με τη λεπτομερή ρύθμιση μιας αρχιτεκτονικής μοντέλου δύο σταδίων με λιγότερα δεδομένα. Για να τελειοποιήσει την αρχιτεκτονική του μοντέλου δύο σταδίων, το AWS ProServe MLDT ενημέρωσε την προεκπαιδευμένη κεφαλή ταξινόμησης πολλαπλών ετικετών του μοντέλου για να συμπεριλάβει έναν επιπλέον κόμβο που αντιπροσωπεύει τη μη τοξική κατηγορία.

Το παρακάτω είναι ένα δείγμα κώδικα του τρόπου με τον οποίο θα βελτιστοποιήσετε ένα προεκπαιδευμένο μοντέλο από τον κόμβο μοντέλων Hugging Face χρησιμοποιώντας την πλατφόρμα μετασχηματιστών τους και να τροποποιήσετε την κεφαλή ταξινόμησης πολλαπλών ετικετών του μοντέλου για να προβλέψετε τον επιθυμητό αριθμό κλάσεων. Το AWS ProServe MLDT χρησιμοποίησε αυτό το προσχέδιο ως βάση για τη λεπτομέρεια. Προϋποθέτει ότι έχετε έτοιμα τα δεδομένα αμαξοστοιχίας και τα δεδομένα επικύρωσης και στη σωστή μορφή εισαγωγής.

Αρχικά, εισάγονται λειτουργικές μονάδες Python καθώς και το επιθυμητό προεκπαιδευμένο μοντέλο από τον κόμβο μοντέλου Hugging Face:

Το προεκπαιδευμένο μοντέλο στη συνέχεια φορτώνεται και προετοιμάζεται για λεπτομέρεια. Αυτό είναι το βήμα όπου ορίζεται ο αριθμός των τοξικών κατηγοριών και όλες οι παράμετροι του μοντέλου:

Η τελειοποίηση του μοντέλου ξεκινά με την εισαγωγή διαδρομών στα σύνολα δεδομένων εκπαίδευσης και επικύρωσης:

Το AWS ProServe MLDT έλαβε περίπου 5,000 περισσότερα επισημασμένα δείγματα δεδομένων, 3,000 μη τοξικά και 2,000 τοξικά, και βελτίωσε και τα τρία μοντέλα βάσης bertweet, συνδυάζοντας όλες τις ετικέτες σε ένα μοντέλο. Χρησιμοποίησαν αυτά τα δεδομένα επιπλέον των 5,000 δειγμάτων από το PoC για να τελειοποιήσουν τα νέα μοντέλα ενός σταδίου χρησιμοποιώντας την ίδια μέθοδο 80% σετ τρένων, 20% σετ δοκιμής. Ο παρακάτω πίνακας δείχνει ότι οι βαθμολογίες απόδοσης ήταν συγκρίσιμες με αυτές του μοντέλου δύο σταδίων.

| Μοντέλο | Ακρίβεια | Ανάκληση | F1 | AUC |

| bertweet-base (1-Στάδιο) | . 76 | . 72 | . 74 | . 83 |

| bertweet-base-hate (1-Stage) | . 85 | . 82 | . 84 | . 87 |

| bertweet-base-offensive (1-Stage) | . 88 | . 83 | . 86 | . 89 |

| bertweet-base-offensive (2-Stage) | . 91 | . 90 | . 90 | . 92 |

Η προσέγγιση του μοντέλου ενός σταδίου παρέδωσε τις βελτιώσεις κόστους και συντήρησης ενώ μείωσε την ακρίβεια μόνο κατά 3%. Μετά τη στάθμιση των αντισταθμίσεων, ο πελάτης επέλεξε το AWS ProServe MLDT για την παραγωγή του μοντέλου ενός σταδίου.

Βελτιώνοντας ένα μοντέλο με περισσότερα δεδομένα με ετικέτα, το AWS ProServe MLDT μπόρεσε να προσφέρει μια λύση που πληρούσε το όριο ακρίβειας του μοντέλου του πελάτη, καθώς και να ικανοποιήσει το αίτημά του για ευκολία συντήρησης, μειώνοντας παράλληλα το κόστος και αυξάνοντας την στιβαρότητα.

Συμπέρασμα

Ένας μεγάλος πελάτης παιχνιδιών αναζητούσε έναν τρόπο να ανιχνεύσει τοξική γλώσσα στα κανάλια επικοινωνίας του για να προωθήσει ένα κοινωνικά υπεύθυνο περιβάλλον παιχνιδιού. Το AWS GAIIC δημιούργησε ένα PoC ενός ανιχνευτή τοξικής γλώσσας ρυθμίζοντας ένα LLM για να ανιχνεύει τοξική γλώσσα. Στη συνέχεια, το AWS ProServe MLDT ενημέρωσε τη ροή εκπαίδευσης του μοντέλου από μια προσέγγιση δύο σταδίων σε μια προσέγγιση ενός σταδίου και παρήγαγε το LLM για τον πελάτη που θα χρησιμοποιηθεί σε κλίμακα.

Σε αυτήν την ανάρτηση, το AWS επιδεικνύει την αποτελεσματικότητα και την πρακτικότητα της τελειοποίησης ενός LLM για την επίλυση αυτής της περίπτωσης χρήσης πελατών, μοιράζεται το πλαίσιο της ιστορίας των μοντέλων θεμελίωσης και των LLM και εισάγει τη ροή εργασίας μεταξύ του Κέντρου Καινοτομίας AWS Generative AI και του AWS ProServe ML Ομάδα παράδοσης. Στην επόμενη ανάρτηση αυτής της σειράς, θα βουτήξουμε βαθύτερα στο πώς το AWS ProServe MLDT παρήγαγε το προκύπτον μοντέλο ενός σταδίου χρησιμοποιώντας το SageMaker.

Εάν ενδιαφέρεστε να εργαστείτε με το AWS για τη δημιουργία μιας Generative AI λύσης, απευθυνθείτε στο GAIIC. Θα αξιολογήσουν την περίπτωση χρήσης σας, θα δημιουργήσουν μια απόδειξη ιδέας που βασίζεται σε Generative-AI και θα έχουν επιλογές να επεκτείνουν τη συνεργασία με το AWS για να εφαρμόσουν το PoC που προκύπτει στην παραγωγή.

αναφορές

- Δημογραφικά στοιχεία παίκτη: Στοιχεία και στατιστικά στοιχεία για το πιο δημοφιλές χόμπι στον κόσμο

- Το ChatGPT σημειώνει ρεκόρ για την ταχύτερα αναπτυσσόμενη βάση χρηστών – σημείωση αναλυτών

- Vaswani et al., "Attention is All You Need"

- Radford et al., «Βελτίωση της γλωσσικής κατανόησης μέσω της γενετικής προεκπαίδευσης»

- Devlin et al., «BERT: Προεκπαίδευση των Deep Bidirectional Transformers for Language Understanding»

- Yinhan Liu et al., «RoBERTa: A Robustly Optimized BERT Pretraining Approach»

- Marcos Zampieri et al., «SemEval-2019 Task 6: Identifying and Category Offisive Language in Social Media (OffensEval)»

- Valerio Basile et al., «SemEval-2019 Task 5: Πολύγλωσσος εντοπισμός της ρητορικής μίσους κατά των μεταναστών και των γυναικών στο Twitter»

Σχετικά με τους συγγραφείς

Τζέιμς Ποκουίζ είναι Επιστήμονας Δεδομένων με AWS Professional Services που εδρεύει στην Κομητεία Όραντζ της Καλιφόρνια. Έχει πτυχίο στην Επιστήμη Υπολογιστών από το Πανεπιστήμιο της Καλιφόρνια, στο Irvine και έχει πολλά χρόνια εμπειρίας στον τομέα των δεδομένων έχοντας παίξει πολλούς διαφορετικούς ρόλους. Σήμερα εργάζεται στην εφαρμογή και την ανάπτυξη κλιμακούμενων λύσεων ML για την επίτευξη επιχειρηματικών αποτελεσμάτων για πελάτες AWS.

Τζέιμς Ποκουίζ είναι Επιστήμονας Δεδομένων με AWS Professional Services που εδρεύει στην Κομητεία Όραντζ της Καλιφόρνια. Έχει πτυχίο στην Επιστήμη Υπολογιστών από το Πανεπιστήμιο της Καλιφόρνια, στο Irvine και έχει πολλά χρόνια εμπειρίας στον τομέα των δεδομένων έχοντας παίξει πολλούς διαφορετικούς ρόλους. Σήμερα εργάζεται στην εφαρμογή και την ανάπτυξη κλιμακούμενων λύσεων ML για την επίτευξη επιχειρηματικών αποτελεσμάτων για πελάτες AWS.

Χαν Μαν είναι Ανώτερος Διευθυντής Επιστήμης Δεδομένων & Μηχανικής Μάθησης με AWS Professional Services με έδρα το Σαν Ντιέγκο, Καλιφόρνια. Έχει διδακτορικό στη Μηχανική από το Πανεπιστήμιο Northwestern και έχει αρκετά χρόνια εμπειρίας ως σύμβουλος διαχείρισης που συμβουλεύει πελάτες στον τομέα της μεταποίησης, των χρηματοοικονομικών υπηρεσιών και της ενέργειας. Σήμερα, εργάζεται με πάθος με βασικούς πελάτες από διάφορους κλάδους της βιομηχανίας για την ανάπτυξη και εφαρμογή λύσεων ML και GenAI στο AWS.

Χαν Μαν είναι Ανώτερος Διευθυντής Επιστήμης Δεδομένων & Μηχανικής Μάθησης με AWS Professional Services με έδρα το Σαν Ντιέγκο, Καλιφόρνια. Έχει διδακτορικό στη Μηχανική από το Πανεπιστήμιο Northwestern και έχει αρκετά χρόνια εμπειρίας ως σύμβουλος διαχείρισης που συμβουλεύει πελάτες στον τομέα της μεταποίησης, των χρηματοοικονομικών υπηρεσιών και της ενέργειας. Σήμερα, εργάζεται με πάθος με βασικούς πελάτες από διάφορους κλάδους της βιομηχανίας για την ανάπτυξη και εφαρμογή λύσεων ML και GenAI στο AWS.

Safa Tinaztepe είναι ένας πλήρης επιστήμονας δεδομένων με τις AWS Professional Services. Έχει πτυχίο στην επιστήμη των υπολογιστών από το Πανεπιστήμιο Emory και έχει ενδιαφέροντα για MLOps, κατανεμημένα συστήματα και web3.

Safa Tinaztepe είναι ένας πλήρης επιστήμονας δεδομένων με τις AWS Professional Services. Έχει πτυχίο στην επιστήμη των υπολογιστών από το Πανεπιστήμιο Emory και έχει ενδιαφέροντα για MLOps, κατανεμημένα συστήματα και web3.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Αυτοκίνητο / EVs, Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- BlockOffsets. Εκσυγχρονισμός της περιβαλλοντικής αντιστάθμισης ιδιοκτησίας. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/aws-performs-fine-tuning-on-a-large-language-model-llm-to-classify-toxic-speech-for-a-large-gaming-company/

- :έχει

- :είναι

- :δεν

- :που

- 000

- 1

- 100

- 14

- 16

- 19

- 200

- 2017

- 2018

- 2019

- 2023

- 50

- 7

- a

- ικανότητα

- Ικανός

- ΠΛΗΡΟΦΟΡΙΕΣ

- πρόσβαση

- ακρίβεια

- ακριβής

- Κατορθώνω

- επιτευχθεί

- ενεργός

- πράξεις

- προστιθέμενη

- προσθήκη

- Επιπλέον

- διεύθυνση

- συμβουλεύοντας

- Μετά το

- κατά

- AI

- AL

- Όλα

- επιτρέπεται

- επιτρέπει

- Επίσης

- Amazon

- Amazon υπηρεσίες Web

- ποσό

- Ποσά

- an

- αναλυτής

- αναλύοντας

- και

- αγελάδων

- Άλλος

- κάθε

- Εφαρμογή

- εφαρμογές

- εφαρμοσμένος

- Εφαρμογή

- πλησιάζω

- κατάλληλα

- περίπου

- αρχιτεκτονική

- ΕΙΝΑΙ

- επιχειρήματα

- Τέχνη

- AS

- εκτιμώ

- συσχετισμένη

- υποθέτει

- At

- προσοχή

- αυτοματοποίηση

- AWS

- Επαγγελματικές υπηρεσίες AWS

- βάση

- βασίζονται

- Baseline

- βάση

- BE

- επειδή

- γίνονται

- ήταν

- πριν

- Αρχή

- πίσω

- είναι

- παρακάτω

- όφελος

- ΚΑΛΎΤΕΡΟΣ

- μεταξύ

- μεγαλύτερος

- Δισεκατομμύριο

- δισεκατομμύρια

- Αποκλεισμός

- γεννημένος

- και οι δύο

- επανάσταση

- ευρύς

- χτίζω

- Χτίζει

- επιχείρηση

- επιχειρήσεις

- αλλά

- by

- CA

- Καλιφόρνια

- που ονομάζεται

- CAN

- ικανός

- συλλαμβάνονται

- περίπτωση

- περιπτώσεις

- CAT

- κατηγορίες

- κατηγοριοποιώντας

- κατηγορία

- Γάτες

- Κέντρο

- ορισμένες

- πρόκληση

- προκλήσεις

- άλλαξε

- αλλαγή

- κανάλια

- ChatGPT

- επέλεξε

- επιλέγονται

- τάξη

- τάξεις

- ταξινόμηση

- Ταξινόμηση

- πελάτες

- κωδικός

- συνεργασία

- συνδυάζοντας

- Ελάτε

- έρχεται

- επικοινωνούν

- Επικοινωνία

- κοινότητα

- εταίρα

- συγκρίσιμος

- ανταγωνισμός

- υπολογιστή

- Πληροφορική

- έννοια

- έννοιες

- συμπέρασμα

- θεωρούνται

- αποτελείται

- περιορισμούς

- σύμβουλος

- καταναλωτής

- Περιέχει

- περιεχόμενο

- συμφραζόμενα

- διορθώσει

- Κόστος

- δαπανηρός

- Δικαστικά έξοδα

- θα μπορούσε να

- Κομητεία

- Καλύμματα

- δημιουργία

- δημιουργήθηκε

- έθιμο

- πελάτης

- Πελάτες

- ημερομηνία

- επιστημονικά δεδομένα

- επιστήμονας δεδομένων

- σύνολα δεδομένων

- ημέρα

- αποφάσισε

- αποφάσεις

- θεωρείται

- βαθύς

- βαθιά κατάδυση

- βαθύτερη

- ορίζεται

- ορίζεται

- παραδώσει

- παραδίδεται

- διανομή

- σκάβω

- εκδημοκρατίζω

- Δημογραφικά στοιχεία

- καταδεικνύει

- ανάπτυξη

- ανάπτυξη

- Υπηρεσίες

- επιθυμητή

- ανίχνευση

- Ανίχνευση

- Προσδιορίστε

- ανάπτυξη

- Ανάπτυξη

- DID

- Ντιέγκο

- διαφορετικές

- διαφέρουν

- διανέμονται

- κατανεμημένα συστήματα

- κάνει

- τομέα

- domains

- διπλασιαστεί

- μεταγλωττισμένο

- κατά την διάρκεια

- Ε & Τ

- κάθε

- ευκολία

- εύκολος

- Αποτελεσματικός

- αποτελεσματικότητα

- αποτελέσματα

- προσπάθεια

- τέλος

- ενέργεια

- Κινητήρας

- Μηχανική

- Αγγλικά

- ενίσχυση

- αρκετά

- εισάγετε

- Ολόκληρος

- Περιβάλλον

- εποχή

- αναμενόμενη

- αξιολόγηση

- ΠΑΝΤΑ

- Κάθε

- παράδειγμα

- υφιστάμενα

- εμπειρία

- πείραμα

- πειράματα

- εμπειρογνώμονες

- Εξηγήστε

- εξηγώντας

- διερευνήσει

- εκφραστικός

- επεκτείνουν

- εκτενής

- εκτεταμένα

- επιπλέον

- εκχύλισμα

- Πρόσωπο

- αντιμετωπίζουν

- γεγονότα

- Μόδα

- ταχύτερα

- ταχύτερα αναπτυσσόμενη

- λίγοι

- Εικόνα

- τελικός

- οικονομικός

- των χρηματοπιστωτικών υπηρεσιών

- Εύρεση

- Όνομα

- ταιριάζουν

- ροή

- Συγκέντρωση

- Εξής

- Για

- μορφή

- Βρέθηκαν

- Θεμέλιο

- πλαισίων

- από

- περαιτέρω

- κέρδισε

- παιχνίδι

- Games

- τυχερών παιχνιδιών

- Βιομηχανία τυχερών παιχνιδιών

- συγκεντρώθηκαν

- General

- παράγουν

- παραγωγής

- γενετική

- Παραγωγική τεχνητή νοημοσύνη

- παίρνω

- δεδομένου

- πηγαίνει

- μετάβαση

- Group

- Μεγαλώνοντας

- καλλιεργούνται

- είχε

- Έχω

- που έχει

- he

- κεφάλι

- υγιέστερο

- εδώ

- υψηλότερο

- ιστορικών

- ιστορικά

- ιστορία

- Πως

- Πώς να

- Ωστόσο

- HTTPS

- Hub

- ανθρώπινος

- Εκατοντάδες

- Ρύθμιση υπερπαραμέτρων

- ιδέα

- ιδανικό

- identiques

- προσδιορισμό

- if

- εικόνα

- εικόνες

- Μετανάστες

- εφαρμογή

- εκτελεστικών

- εισαγωγή

- σημαντικό

- εισαγωγές

- βελτίωση

- βελτιωθεί

- βελτίωση

- βελτιώσεις

- in

- περιλαμβάνουν

- Συμπεριλαμβανομένου

- αύξηση

- βιομηχανία

- πληροφορίες

- συμφυής

- εκ φύσεως

- Καινοτομία

- εισαγωγή

- Ενσωμάτωση

- αλληλεπιδρώντας

- αλληλεπιδράσεις

- διαδραστικό

- ενδιαφερόμενος

- συμφέροντα

- σε

- εισήγαγε

- Εισάγει

- IT

- ΤΟΥ

- Ιανουάριος

- παζλ

- άρθρωση

- μόλις

- Κλειδί

- λέξεις-κλειδιά

- γνώση

- γνωστός

- τιτλοφόρηση

- Ετικέτες

- Γλώσσα

- large

- μεγάλης κλίμακας

- αργότερα

- λαϊκός

- στρώμα

- μάθηση

- Μήκος

- μείον

- Μου αρέσει

- LLM

- φορτίο

- πλέον

- κοιτάζοντας

- έχασε

- Παρτίδα

- Μείωση

- μηχανή

- μάθηση μηχανής

- που

- Κυρίως

- διατηρήσουν

- συντήρηση

- κάνω

- ΚΑΝΕΙ

- Κατασκευή

- άνδρας

- διαχείριση

- διευθυντής

- Ταχύτητες

- κατασκευής

- πολοί

- μαζική

- Ενδέχεται..

- μηχανισμός

- Εικόνες / Βίντεο

- πληρούνται

- μέθοδος

- Μεθοδολογία

- μετρικός

- εκατομμύριο

- ML

- MLOps

- μοντέλο

- μοντελοποίηση

- μοντέλα

- τροποποιήσεις

- ενότητες

- παρακολούθηση

- μήνες

- περισσότερο

- πλέον

- Δημοφιλέστερα

- πολύ

- και συγκεκριμένα

- Φυσικό

- Επεξεργασία φυσικής γλώσσας

- Φύση

- που απαιτούνται

- δίκτυο

- δίκτυα

- νευρωνικά δίκτυα

- Νέα

- επόμενη

- nlp

- κόμβος

- τώρα

- αριθμός

- αριθμοί

- την απόκτηση

- of

- off

- προσβλητικός

- συχνά

- on

- ONE

- διαδικτυακά (online)

- online gaming

- αποκλειστικά

- λειτουργίες

- αντίθετος

- βελτιστοποιημένη

- Επιλογές

- or

- Πορτοκαλί

- τάξη

- πρωτότυπο

- ΑΛΛΑ

- έξω

- Αποτέλεσμα

- αποτελέσματα

- παραγωγή

- επί

- φόρμες

- επισκόπηση

- δική

- ζεύγη

- παράδειγμα

- παράμετρος

- παράμετροι

- μέρος

- συνεργάστηκε

- πέρασε

- Το παρελθόν

- πρότυπο

- τέλειος

- Εκτελέστε

- επίδοση

- εκτελεί

- φάση

- phd

- φράσεις

- κομμάτι

- πλατφόρμες

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- έπαιξε

- παίχτης

- παίκτες

- σας παρακαλούμε

- PoC

- Σημείο

- Δημοφιλής

- πληθυσμός

- Θέση

- Δημοσιεύσεις

- ενδεχομένως

- δύναμη

- ισχυρός

- αρμοδιότητες

- Ακρίβεια

- προβλέψει

- προβλεπόμενη

- προβλέποντας

- πρόβλεψη

- Προβλέψεις

- Προβλέπει

- προηγούμενος

- προηγουμένως

- Πρόβλημα

- διαδικασία

- διαδικασια μας

- Διεργασίες

- μεταποίηση

- παράγει

- παραγωγή

- ΒΛΑΣΦΗΜΙΑ

- επαγγελματίας

- email marketing

- την προώθηση της

- απόδειξη

- απόδειξη της έννοιας

- παρέχεται

- παρέχει

- δημόσιο

- βάζω

- Python

- ποιότητα

- σειρά

- φθάσουν

- φθάνοντας

- έτοιμος

- πραγματικός

- πραγματικό κόσμο

- λόγους

- έλαβε

- πρόσφατα

- συνταγή

- αναγνωρίζω

- συνιστάται

- ρεκόρ

- σχετικά

- απελευθερώνουν

- κυκλοφόρησε

- αναπαραγωγή

- εκπροσωπώ

- απαιτούν

- υπεύθυνος

- υπεύθυνο Παιχνίδι

- αποτέλεσμα

- με αποτέλεσμα

- Αποτελέσματα

- Reuters

- δεξιά

- αυστηρός

- Αύξηση

- ευρωστία

- ρόλους

- τρέξιμο

- τρέξιμο

- σοφός

- ίδιο

- Σαν

- Σαν Ντιέγκο

- επεκτάσιμη

- Κλίμακα

- απολέπιση

- Επιστήμη

- επιστημονικός

- Επιστήμονας

- μηδέν

- Δεύτερος

- Τμήμα

- τμήματα

- αρχαιότερος

- ποινή

- συναίσθημα

- ξεχωριστό

- Ακολουθία

- Σειρές

- εξυπηρετεί

- Υπηρεσίες

- σειρά

- Σέτς

- διάφοροι

- Μερίδια

- παρουσιάστηκε

- Δείχνει

- παρόμοιες

- αφού

- ενιαίας

- Μέγεθος

- επιβραδύνει

- small

- μικρότερος

- So

- Μ.Κ.Δ

- social media

- κοινωνικά

- μόνο

- λύση

- Λύσεις

- SOLVE

- Επίλυση

- μερικοί

- επιδιώξει

- Χώρος

- συγκεκριμένες

- ειδικά

- ομιλία

- ταχύτητα

- διαίρεση

- ξεκινά

- Κατάσταση

- stats

- Βήμα

- Ακόμη

- δομή

- Μελέτη

- ουσιαστικά

- τέτοιος

- επαρκής

- συστήματα

- τραπέζι

- επειξειργασμένος από ραπτήν

- παίρνει

- λήψη

- Έργο

- εργασίες

- Τεχνολογία

- δοκιμή

- δοκιμαστεί

- από

- ότι

- Η

- Το κράτος

- τους

- Τους

- τότε

- θεωρητικός

- Εκεί.

- Αυτοί

- αυτοί

- αυτό

- σκέψη

- τρία

- κατώφλι

- Μέσω

- Ετσι

- ώρα

- φορές

- συγχρονισμός

- Τιτάν

- προς την

- σήμερα

- Θέματα

- Σύνολο

- Τρένο

- εκπαιδευμένο

- Εκπαίδευση

- μεταφορά

- μετασχηματιστής

- μετασχηματιστές

- Μετάφραση

- όντως

- ΣΤΡΟΦΗ

- τιτίβισμα

- tweets

- δύο

- τύπος

- τύποι

- τυπικός

- συνήθως

- τελικά

- υποκείμενες

- κατανόηση

- Δυστυχώς

- πανεπιστήμιο

- Πανεπιστήμιο της Καλιφόρνια

- ενημερώθηκε

- χρήση

- περίπτωση χρήσης

- μεταχειρισμένος

- Χρήστες

- Η εμπειρία χρήστη

- Χρήστες

- χρησιμοποιεί

- χρησιμοποιώντας

- ΕΠΙΚΥΡΩΝΩ

- επικύρωση

- ποικιλία

- Σταθερή

- εκδόσεις

- κατακόρυφα

- πολύ

- μέσω

- Βίντεο

- βίντεο τυχερών παιχνιδιών

- πρακτικώς

- Φωνή

- vs

- θέλω

- ήθελε

- ήταν

- Τρόπος..

- we

- ιστός

- διαδικτυακές υπηρεσίες

- Web3

- ζύγισμα

- ΛΟΙΠΌΝ

- πολύ γνωστό

- ήταν

- πότε

- αν

- Ποιό

- ενώ

- WHY

- ευρύς

- Ευρύ φάσμα

- Wikipedia

- θα

- με

- εντός

- χωρίς

- Γυναίκες

- λέξη

- λόγια

- ροής εργασίας

- εργαζόμενος

- λειτουργεί

- κόσμος

- θα

- γραφή

- χρόνια

- Εσείς

- Σας

- zephyrnet