Την περασμένη εβδομάδα, Ινστιτούτο Τεχνολογικής Καινοτομίας (TII) ξεκίνησε TII Falcon LLM, ένα θεμελιώδες μοντέλο μεγάλης γλώσσας ανοιχτού κώδικα (LLM). Εκπαιδεύτηκε σε 1 τρισεκατομμύριο μάρκες με Amazon Sage Maker, το Falcon μπορεί να υπερηφανεύεται για την κορυφαία απόδοση (#1 στο Κορυφαίος πίνακας Hugging Face τη στιγμή της γραφής) ενώ είναι σχετικά ελαφρύ και λιγότερο δαπανηρό για φιλοξενία από άλλα LLM όπως το llama-65B. Σε αυτήν την ανάρτηση, δείχνουμε πώς να αναπτύξετε το Falcon για εφαρμογές όπως η κατανόηση γλώσσας και η αυτοματοποιημένη βοήθεια γραφής χρησιμοποιώντας μεγάλα δοχεία εκμάθησης συμπερασμάτων μοντέλων στο SageMaker.

Το Falcon προσγειώθηκε στο SageMaker

Το TII είναι ο οργανισμός εφαρμοσμένης έρευνας εντός του Άμπου Ντάμπι Συμβούλιο Προηγμένης Τεχνολογίας; Η ομάδα επιστημόνων, ερευνητών και μηχανικών της είναι αφιερωμένη στην ανακάλυψη μετασχηματιστικών τεχνολογιών και στην ανάπτυξη επιστημονικών ανακαλύψεων που θα αποδείξουν το μέλλον της κοινωνίας μας. Νωρίτερα αυτό το έτος, η TII ξεκίνησε να εκπαιδεύει ένα υπερσύγχρονο, ανοιχτού κώδικα LLM και χρησιμοποίησε την υποδομή, τα εργαλεία και την τεχνογνωσία του SageMaker για να ολοκληρώσει τη δουλειά (για να μάθει περισσότερα για το πώς εκπαιδεύτηκε αυτό το μοντέλο στο SageMaker , αναφέρομαι σε Το Technology Innovation Institute εκπαιδεύει το υπερσύγχρονο μοντέλο βάσης Falcon LLM 40B στο Amazon SageMaker). Το αποτέλεσμα αυτής της προσπάθειας είναι TII Falcon LLM.

Εκπαιδευμένο σε 1 τρισεκατομμύριο μάρκες, το Falcon μπορεί να υπερηφανεύεται για κορυφαίες επιδόσεις έναντι του Εξάρτημα αξιολόγησης μοντέλου γλώσσας AI Eleuther και αυτή τη στιγμή είναι #1 στο Κορυφαίος πίνακας Hugging Face για την ακρίβεια. Το μοντέλο είναι διαθέσιμο σε δύο διαφορετικά μεγέθη—Falcon-40B και Falcon-7B—και μπορεί να χρησιμοποιηθεί για κορυφαίες επιδόσεις σε εφαρμογές όπως η κατανόηση γλώσσας, οι εμπειρίες συνομιλίας και η αυτοματοποιημένη βοήθεια γραφής. Αυτή η ανάρτηση θα σας βοηθήσει να ξεκινήσετε με την ανάπτυξη του Falcon στο SageMaker για συμπεράσματα υψηλής ακρίβειας σε αυτούς τους τύπους τομέων.

Τα μεγάλα DLC συμπερασμάτων SageMaker απλοποιούν τη φιλοξενία LLM

Η φιλοξενία LLM όπως το Falcon-40B και το Falcon-7B μπορεί να είναι προκλητική. Τα μεγαλύτερα μοντέλα είναι συχνά πιο ακριβή επειδή περιλαμβάνουν δισεκατομμύρια παραμέτρους, αλλά το μέγεθός τους μπορεί επίσης να έχει ως αποτέλεσμα πιο αργό λανθάνοντα χρόνο συμπερασμάτων ή χειρότερη απόδοση. Η φιλοξενία ενός LLM μπορεί να απαιτεί περισσότερη μνήμη GPU και βελτιστοποιημένους πυρήνες για την επίτευξη αποδεκτών επιδόσεων. Για να περιπλέκονται ακόμη περισσότερο τα πράγματα, αν και μικρότερα μοντέλα όπως το Falcon-7B μπορούν γενικά να χωρέσουν σε μια ενιαία GPU, όπως μια παρουσία NVIDIA A10G που τροφοδοτεί τύπους παρουσίας AWS G5, τα μεγαλύτερα μοντέλα όπως το Falcon-40B δεν μπορούν. Όταν συμβεί αυτό, πρέπει να χρησιμοποιηθούν στρατηγικές όπως ο παραλληλισμός τανυστών για να τεμαχιστεί αυτό το μεγαλύτερο μοντέλο σε πολλά κομμάτια και να αξιοποιηθεί η μνήμη πολλών GPU. Οι λύσεις φιλοξενίας παλαιού τύπου που χρησιμοποιούνται για μικρότερα μοντέλα συνήθως δεν προσφέρουν αυτόν τον τύπο λειτουργικότητας, αυξάνοντας τη δυσκολία.

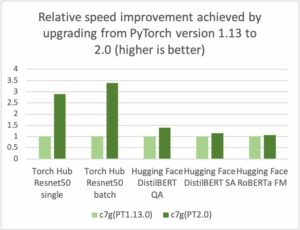

Τα δοχεία βαθιάς εκμάθησης (DLC) με μεγάλο μοντέλο συμπερασμάτων SageMaker (LMI) μπορούν να βοηθήσουν. Τα LMI DLC είναι μια ολοκληρωμένη λύση από άκρο σε άκρο για τη φιλοξενία LLM όπως το Falcon-40B. Στο μπροστινό μέρος, περιλαμβάνουν έναν διακομιστή μοντέλων υψηλής απόδοσης (DJL Serving) που έχει σχεδιαστεί για εξαγωγή συμπερασμάτων μεγάλων μοντέλων με χαρακτηριστικά όπως ροή διακριτικών και αυτόματη αναπαραγωγή μοντέλων σε μια παρουσία για αύξηση της απόδοσης. Στο backend, τα LMI DLC περιλαμβάνουν επίσης πολλούς παράλληλους κινητήρες μοντέλων υψηλής απόδοσης, όπως το DeepSpeed και το FasterTransformer, που μπορούν να θρυμματίσουν και να διαχειριστούν παραμέτρους μοντέλου σε πολλές GPU. Αυτοί οι κινητήρες περιλαμβάνουν επίσης βελτιστοποιημένους πυρήνες για δημοφιλή μοντέλα μετασχηματιστών, οι οποίοι μπορούν να επιταχύνουν την εξαγωγή συμπερασμάτων έως και τρεις φορές πιο γρήγορα. Με τα LMI DLC, χρειάζεται απλώς να δημιουργήσετε ένα αρχείο διαμόρφωσης για να ξεκινήσετε με τη φιλοξενία LLM στο SageMaker. Για να μάθετε περισσότερα σχετικά με τα DLC SageMaker LMI, ανατρέξτε στο Παραλληλισμός μοντέλου και συμπέρασμα μεγάλου μοντέλου και το κομμάτι λίστα διαθέσιμων εικόνων. Μπορείτε επίσης να δείτε την προηγούμενη ανάρτησή μας σχετικά με τη φιλοξενία Bloom-175B στο SageMaker χρησιμοποιώντας LMI DLC.

Επισκόπηση λύσεων

Αυτή η ανάρτηση σας καθοδηγεί στον τρόπο φιλοξενίας του Falcon-40B χρησιμοποιώντας το DeepSpeed στο SageMaker χρησιμοποιώντας LMI DLC. Το Falcon-40B απαιτεί τη χρήση πολλαπλών GPU A10, ενώ το Falcon-7B απαιτεί μόνο μία GPU. Ετοιμάσαμε επίσης παραδείγματα που μπορείτε να αναφέρετε στον κεντρικό υπολογιστή Falcon-40B και Falcon-7B χρησιμοποιώντας τόσο το DeepSpeed όσο και το Accelerate. Μπορείτε να βρείτε τα παραδείγματα κώδικα μας στο GitHub.

Αυτό το παράδειγμα μπορεί να εκτελεστεί σε περιπτώσεις φορητών υπολογιστών SageMaker ή Στούντιο Amazon SageMaker τετράδια. Για τη φιλοξενία Falcon-40B με χρήση LMI και DeepSpeed, πρέπει να χρησιμοποιήσουμε μια παρουσία ml.g5.24xlarge. Αυτές οι περιπτώσεις παρέχουν 4x NVIDIA A10G GPU, οι οποίες υποστηρίζουν 96 GiB μνήμης GPU. Επιπλέον, ο κεντρικός υπολογιστής παρέχει 96 vCPU και 384 GiB μνήμης κεντρικού υπολογιστή. Το κοντέινερ LMI θα βοηθήσει στην αντιμετώπιση μεγάλου μέρους της αδιαφοροποίητης ανύψωσης βαρέων βαρών που σχετίζεται με τη φιλοξενία LLM, συμπεριλαμβανομένης της λήψης του μοντέλου και της κατάτμησης του τεχνουργήματος του μοντέλου, έτσι ώστε οι παράμετροί του να μπορούν να κατανεμηθούν σε πολλές GPU.

Τα ποσοστά για παρουσίες μηχανικής εκμάθησης (ML) του SageMaker μπορεί να διαφέρουν μεταξύ των λογαριασμών. Εάν λάβετε ένα σφάλμα που υποδεικνύει ότι έχετε υπερβεί το όριο σας για παρουσίες g5.24xlarge ενώ ακολουθείτε αυτήν την ανάρτηση, μπορείτε να αυξήσετε το όριο μέσω του Κονσόλα Service Quotas.

Περίληψη σημειωματάριων

Αρχικά, ξεκινάμε εγκαθιστώντας και εισάγοντας τις απαραίτητες εξαρτήσεις για το παράδειγμά μας. Χρησιμοποιούμε το Boto3 SDK καθώς και το SageMaker SDK. Σημειώστε ότι χρησιμοποιούμε Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3) για να αποθηκεύσουμε τα τεχνουργήματα μοντέλων που χρειαζόμαστε για χρήση του SageMaker και του LMI, επομένως ρυθμίσαμε μια μεταβλητή προθέματος S3 ανάλογα. Δείτε τον παρακάτω κώδικα:

Στη συνέχεια, δημιουργούμε έναν τοπικό φάκελο για τον χώρο εργασίας μας για να αποθηκεύουμε τα τεχνουργήματα του μοντέλου:

Αρχικά δημιουργούμε ένα serving.properties αρχείο ρυθμίσεων στον τοπικό κατάλογο που δημιουργήσαμε. Αυτό serving.properties Το αρχείο υποδεικνύει στο κοντέινερ LMI και στη βιβλιοθήκη εξυπηρέτησης DJL στο μπροστινό μέρος ποιο μοντέλο βελτιστοποίησης παραλληλισμού και συμπερασμάτων θέλουμε να χρησιμοποιήσουμε. Μπορείτε να βρείτε τις επιλογές διαμόρφωσης για DeepSpeed και Hugging Face Accelerate μέσα Διαμορφώσεις και ρυθμίσεις. Εδώ, σημειώστε ότι ορίσαμε το option.model_id παράμετρος για να ορίσετε από ποιο μοντέλο Hugging Face να τραβήξετε. Το SageMaker κάνει την εργασία με μοντέλα Hugging Face απλή και αυτή η μία σειρά είναι ό,τι χρειάζεστε. Επιπλέον, θέσαμε option.tensor_parallel_degree σε τιμή 4 επειδή έχουμε τέσσερις GPU στην παρουσία μας ml.g5.24xlarge. Αυτή η παράμετρος καθορίζει πόσες κατατμήσεις του μοντέλου θα δημιουργηθούν και θα διανεμηθούν. Λάβετε υπόψη ότι αν είχαμε χρησιμοποιήσει μια μεγαλύτερη παρουσία με οκτώ GPU, όπως ml.g5.48xlarge, και παρόλα αυτά ορίζαμε την τιμή 4, τότε το LMI θα δημιουργούσε αυτόματα δύο αντίγραφα του μοντέλου (δύο αντίγραφα κατανεμημένα σε τέσσερις GPU η καθεμία). Δείτε τον παρακάτω κώδικα:

Μπορείτε επίσης να ανταλλάξετε tiiuae/falcon-40b με tiiuae/falcon-40b-instruct αν ταιριάζει καλύτερα στις ανάγκες σας.

Περιλαμβάνουμε επίσης α requirements.txt αρχείο που μπορείτε να καθορίσετε για να εγκαταστήσετε τα πακέτα που χρειάζεστε:

Το τελευταίο πράγμα που χρειαζόμαστε είναι το model.py αρχείο που θα χρησιμοποιηθεί με το μοντέλο σας:

Αυτό είναι! Σε αυτό το σημείο, έχουμε δημιουργήσει όλα τα τεχνουργήματα που θα χρειαστείτε, αναπτύξτε το Falcon-40B με το DeepSpeed! Συσκευάζουμε τον κατάλογο σε ένα αρχείο *.tar.gz και τον ανεβάζουμε στο Amazon S3. Σημειώστε ότι το πραγματικό μοντέλο δεν έχει γίνει λήψη ή συσκευασία σε αυτό το αρχείο. Το κοντέινερ LMI θα κατεβάσει το μοντέλο για εσάς απευθείας από το Hugging Face. Έχετε επίσης την επιλογή να στοχεύσετε έναν κάδο S3 εάν θέλετε το δικό σας αντίγραφο του μοντέλου σε μια τοποθεσία που θα είναι πιο αποδοτική για λήψη. Το LMI περιλαμβάνει επίσης βελτιστοποίηση για λήψη από το Amazon S3 με υψηλή απόδοση. Δείτε τον παρακάτω κώδικα:

Το μόνο που μένει να κάνουμε σε αυτό το σημείο είναι να ορίσουμε το κοντέινερ που θέλουμε να χρησιμοποιήσουμε και να δημιουργήσουμε ένα αντικείμενο μοντέλου:

Στη συνέχεια, δημιουργούμε μια διαμόρφωση τερματικού σημείου και δημιουργούμε το τελικό σημείο:

Στοιχεία διαμόρφωσης που πρέπει να έχετε υπόψη σας για επιτυχημένη φιλοξενία

Ένα σημαντικό στοιχείο για τη φιλοξενία μεγάλων μοντέλων είναι η διασφάλιση ότι υπάρχει επαρκής χρόνος για λήψη μοντέλου από το Hugging Face. Στις δοκιμές μας, το Falcon-40B χρειάστηκε περίπου 90 λεπτά για να κατεβάσει στο στιγμιότυπο. Ένα βασικό σύνολο διαμορφώσεων που επιτρέπει αυτό είναι ContainerStartupHealthCheckTimeoutInSeconds και ModelDataDownloadTimeoutInSeconds. Βεβαιωθείτε ότι η διαμόρφωση τελικού σημείου του SageMaker έχει τιμή 3600 για καθένα από αυτά. Επιπλέον, είναι πολύ πιο εύκολο να κάνετε λήψη από το Amazon S3 αντί του αρχικού μοντέλου ζωολογικού κήπου χρησιμοποιώντας τα δοχεία LMI που είναι ειδικά σχεδιασμένα για LLMS που χρησιμοποιούν το βοηθητικό πρόγραμμα S5cmd, το οποίο μειώνει τον χρόνο λήψης του μοντέλου σε περίπου 10 λεπτά.

Μπορείτε να παρακολουθήσετε την κατάσταση του τελικού σημείου καλώντας DescribeEndpoint, που θα σας πει πότε όλα έχουν ολοκληρωθεί. Το τελικό σημείο σας είναι πλέον έτοιμο να απαντήσει σε αιτήματα συμπερασμάτων! Επειδή το LMI χειρίζεται τη διαμέριση και την ενορχήστρωση του μοντέλου για εσάς, κάθε αίτημα θα υποβληθεί σε επεξεργασία χρησιμοποιώντας και τις 4 GPU που είναι διαθέσιμες στην παρουσία μας ml.g5.12xlarge. Αυτό μας επιτρέπει να φιλοξενούμε LLM και να αυξάνουμε την απόδοση εάν κλιμακώνουμε τους επιταχυντές GPU οριζόντια. Δείτε τον παρακάτω κώδικα:

Εάν τελειώσετε και θέλετε να διαγράψετε τη διαμόρφωση τελικού σημείου, το τελικό σημείο και το αντικείμενο μοντέλου, μπορείτε να εκτελέσετε τις ακόλουθες εντολές:

Αυτός ο κώδικας στον οποίο αναφερθήκαμε σε αυτήν την ανάρτηση βρίσκεται στο πλήρες σημειωματάριο στο GitHub.

Συμπέρασμα

Το SageMaker Hosting και το LMI DLC σας διευκολύνουν να φιλοξενήσετε LLM όπως το Falcon-40B. Αναλαμβάνει την αδιαφοροποίητη βαρύτητα στην ενορχήστρωση του τι απαιτείται για τη φιλοξενία μοντέλων σε πολλές GPU και παρέχει διαμορφώσιμες επιλογές για να ταιριάζουν στις ανάγκες σας. Επιπλέον, η χρήση μοντέλων Hugging Face γίνεται πολύ απλή, με ενσωματωμένη υποστήριξη για αυτά τα μοντέλα.

Σε αυτήν την ανάρτηση, δείξαμε πώς μπορείτε να χρησιμοποιήσετε το SageMaker για να φιλοξενήσετε το μοντέλο Falcon-40B χρησιμοποιώντας το DeepSpeed. Επιπλέον, δώσαμε παραδείγματα στο GitHub να φιλοξενήσει το Falcon-40B χρησιμοποιώντας το Accelerate και τα μικρότερα μοντέλα Falcon-7B. Σας ενθαρρύνουμε να δοκιμάσετε αυτό το SageMaker με το LMI και να αποκτήσετε πρακτικά το δημοσίως διαθέσιμο LLM με τις καλύτερες επιδόσεις μέχρι σήμερα!

Σχετικά με τους συγγραφείς

Τζέιμς Παρκ είναι αρχιτέκτονας λύσεων στο Amazon Web Services. Συνεργάζεται με την Amazon.com για το σχεδιασμό, την κατασκευή και την ανάπτυξη τεχνολογικών λύσεων στο AWS και έχει ιδιαίτερο ενδιαφέρον για την τεχνητή νοημοσύνη και τη μηχανική μάθηση. Στον ελεύθερο χρόνο του απολαμβάνει να αναζητά νέους πολιτισμούς, νέες εμπειρίες και να ενημερώνεται για τις τελευταίες τάσεις της τεχνολογίας. Μπορείτε να τον βρείτε στο LinkedIn.

Τζέιμς Παρκ είναι αρχιτέκτονας λύσεων στο Amazon Web Services. Συνεργάζεται με την Amazon.com για το σχεδιασμό, την κατασκευή και την ανάπτυξη τεχνολογικών λύσεων στο AWS και έχει ιδιαίτερο ενδιαφέρον για την τεχνητή νοημοσύνη και τη μηχανική μάθηση. Στον ελεύθερο χρόνο του απολαμβάνει να αναζητά νέους πολιτισμούς, νέες εμπειρίες και να ενημερώνεται για τις τελευταίες τάσεις της τεχνολογίας. Μπορείτε να τον βρείτε στο LinkedIn.

Abhi Shivaditya είναι Ανώτερος Αρχιτέκτονας Λύσεων στην AWS, συνεργαζόμενος με στρατηγικούς παγκόσμιους επιχειρηματικούς οργανισμούς για να διευκολύνει την υιοθέτηση υπηρεσιών AWS σε τομείς όπως η Τεχνητή Νοημοσύνη, η κατανεμημένη πληροφορική, η δικτύωση και η αποθήκευση. Η εξειδίκευσή του έγκειται στη Deep Learning στους τομείς της Επεξεργασίας Φυσικής Γλώσσας (NLP) και του Computer Vision. Η Abhi βοηθά τους πελάτες να αναπτύξουν αποτελεσματικά μοντέλα μηχανικής εκμάθησης υψηλής απόδοσης εντός του οικοσυστήματος AWS.

Abhi Shivaditya είναι Ανώτερος Αρχιτέκτονας Λύσεων στην AWS, συνεργαζόμενος με στρατηγικούς παγκόσμιους επιχειρηματικούς οργανισμούς για να διευκολύνει την υιοθέτηση υπηρεσιών AWS σε τομείς όπως η Τεχνητή Νοημοσύνη, η κατανεμημένη πληροφορική, η δικτύωση και η αποθήκευση. Η εξειδίκευσή του έγκειται στη Deep Learning στους τομείς της Επεξεργασίας Φυσικής Γλώσσας (NLP) και του Computer Vision. Η Abhi βοηθά τους πελάτες να αναπτύξουν αποτελεσματικά μοντέλα μηχανικής εκμάθησης υψηλής απόδοσης εντός του οικοσυστήματος AWS.

Robert Van Dusen είναι Ανώτερος Διευθυντής Προϊόντων με το Amazon SageMaker. Είναι επικεφαλής της βελτιστοποίησης μοντέλων βαθιάς μάθησης για εφαρμογές όπως η εξαγωγή συμπερασμάτων μεγάλων μοντέλων.

Robert Van Dusen είναι Ανώτερος Διευθυντής Προϊόντων με το Amazon SageMaker. Είναι επικεφαλής της βελτιστοποίησης μοντέλων βαθιάς μάθησης για εφαρμογές όπως η εξαγωγή συμπερασμάτων μεγάλων μοντέλων.

Εβάντρο Φράνκο είναι Αρχιτέκτονας Ειδικών Λύσεων AI/ML που εργάζεται στις Υπηρεσίες Ιστού της Amazon. Βοηθά τους πελάτες του AWS να ξεπεράσουν τις επιχειρηματικές προκλήσεις που σχετίζονται με το AI/ML πέρα από το AWS. Εργάζεται για περισσότερα από 15 χρόνια με την τεχνολογία, από την ανάπτυξη λογισμικού, την υποδομή, χωρίς διακομιστή, μέχρι τη μηχανική μάθηση.

Εβάντρο Φράνκο είναι Αρχιτέκτονας Ειδικών Λύσεων AI/ML που εργάζεται στις Υπηρεσίες Ιστού της Amazon. Βοηθά τους πελάτες του AWS να ξεπεράσουν τις επιχειρηματικές προκλήσεις που σχετίζονται με το AI/ML πέρα από το AWS. Εργάζεται για περισσότερα από 15 χρόνια με την τεχνολογία, από την ανάπτυξη λογισμικού, την υποδομή, χωρίς διακομιστή, μέχρι τη μηχανική μάθηση.

Τσινγκ Λαν είναι Μηχανικός Ανάπτυξης Λογισμικού στην AWS. Έχει εργαστεί σε πολλά προκλητικά προϊόντα στο Amazon, συμπεριλαμβανομένων λύσεων συμπερασμάτων ML υψηλής απόδοσης και συστήματος καταγραφής υψηλής απόδοσης. Η ομάδα του Qing κυκλοφόρησε με επιτυχία το πρώτο μοντέλο δισεκατομμυρίων παραμέτρων στο Amazon Advertising με πολύ χαμηλό λανθάνοντα χρόνο που απαιτείται. Ο Qing έχει εις βάθος γνώση σχετικά με τη βελτιστοποίηση της υποδομής και την επιτάχυνση Deep Learning.

Τσινγκ Λαν είναι Μηχανικός Ανάπτυξης Λογισμικού στην AWS. Έχει εργαστεί σε πολλά προκλητικά προϊόντα στο Amazon, συμπεριλαμβανομένων λύσεων συμπερασμάτων ML υψηλής απόδοσης και συστήματος καταγραφής υψηλής απόδοσης. Η ομάδα του Qing κυκλοφόρησε με επιτυχία το πρώτο μοντέλο δισεκατομμυρίων παραμέτρων στο Amazon Advertising με πολύ χαμηλό λανθάνοντα χρόνο που απαιτείται. Ο Qing έχει εις βάθος γνώση σχετικά με τη βελτιστοποίηση της υποδομής και την επιτάχυνση Deep Learning.

Frank Liu είναι Μηχανικός Λογισμικού για AWS Deep Learning. Επικεντρώνεται στην κατασκευή καινοτόμων εργαλείων βαθιάς μάθησης για μηχανικούς και επιστήμονες λογισμικού. Στον ελεύθερο χρόνο του, απολαμβάνει πεζοπορία με φίλους και συγγενείς.

Frank Liu είναι Μηχανικός Λογισμικού για AWS Deep Learning. Επικεντρώνεται στην κατασκευή καινοτόμων εργαλείων βαθιάς μάθησης για μηχανικούς και επιστήμονες λογισμικού. Στον ελεύθερο χρόνο του, απολαμβάνει πεζοπορία με φίλους και συγγενείς.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- EVM Finance. Ενιαία διεπαφή για αποκεντρωμένη χρηματοδότηση. Πρόσβαση εδώ.

- Quantum Media Group. Ενισχυμένο IR/PR. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Data Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/deploy-falcon-40b-with-large-model-inference-dlcs-on-amazon-sagemaker/

- :έχει

- :είναι

- :δεν

- :που

- $UP

- 1

- 10

- 100

- 13

- 14

- 15 χρόνια

- 15%

- 20

- 22

- 27

- 7

- 8

- 9

- a

- Σχετικα

- επιταχύνουν

- επιταχυντές

- αποδεκτό

- αναλόγως

- Λογαριασμοί

- ακρίβεια

- ακριβής

- Κατορθώνω

- απέναντι

- πραγματικός

- προσθήκη

- Επιπλέον

- Επιπλέον

- διεύθυνση

- Υιοθεσία

- Πλεονέκτημα

- Διαφήμιση

- κατά

- AI

- AI / ML

- Όλα

- επιτρέπουν

- επιτρέπει

- Επίσης

- Αν και

- Amazon

- Amazon Sage Maker

- Amazon υπηρεσίες Web

- Amazon.com

- an

- και

- κάθε

- APIs

- εφαρμογές

- εφαρμοσμένος

- ΕΙΝΑΙ

- περιοχές

- γύρω

- τεχνητός

- τεχνητή νοημοσύνη

- AS

- Βοήθεια

- βοηθάει

- συσχετισμένη

- At

- αυτόματη

- Αυτοματοποιημένη

- Αυτόματο

- αυτομάτως

- διαθέσιμος

- AWS

- Backend

- BE

- επειδή

- γίνεται

- ήταν

- αρχίζουν

- είναι

- Καλύτερα

- μεταξύ

- δισεκατομμύρια

- μπορεί να υπερηφανεύεται

- σώμα

- και οι δύο

- επιτεύγματα

- χτίζω

- Κτίριο

- ενσωματωμένο

- επιχείρηση

- αλλά

- by

- κλήση

- κλήση

- CAN

- δεν μπορώ

- προκλήσεις

- πρόκληση

- έλεγχος

- κωδικός

- COM

- συγκριτικά

- πλήρης

- που περιλαμβάνει

- υπολογιστή

- Computer Vision

- χρήση υπολογιστή

- διαμόρφωση

- εξέταση

- Δοχείο

- Εμπορευματοκιβώτια

- ομιλητικός

- δημιουργία

- δημιουργήθηκε

- Τη στιγμή

- Πελάτες

- περικοπές

- ημερομηνία

- Ημερομηνία

- αφιερωμένο

- βαθύς

- βαθιά μάθηση

- Ορίζει

- αποδεικνύουν

- παρατάσσω

- ανάπτυξη

- Υπηρεσίες

- σχεδιασμένα

- Ανάπτυξη

- DICT

- διαφορετικές

- Δυσκολία

- κατευθείαν

- ανακάλυψη

- διανέμω

- διανέμονται

- κατανεμημένων υπολογιστών

- do

- domains

- γίνεται

- Μην

- κατεβάσετε

- κάθε

- Νωρίτερα

- ευκολότερη

- εύκολος

- οικοσύστημα

- αποτελεσματικά

- προσπάθεια

- ενθαρρύνει

- τέλος

- από άκρη σε άκρη

- Τελικό σημείο

- Κινητήρας

- μηχανικός

- Μηχανικοί

- Κινητήρες

- εξασφαλίζοντας

- Εταιρεία

- σφάλμα

- εκτίμηση

- πάντα

- παράδειγμα

- παραδείγματα

- υπέρβαση

- εκτέλεση

- ακριβά

- Δραστηριοτητες

- εξειδίκευση

- Πρόσωπο

- διευκολύνω

- οικογένεια

- γρηγορότερα

- Χαρακτηριστικά

- Αρχεία

- Εύρεση

- Όνομα

- ταιριάζουν

- εστιάζει

- Εξής

- Για

- Βρέθηκαν

- Θεμέλιο

- τέσσερα

- φίλους

- από

- εμπρός

- εμπρόσθιο άκρο

- λειτουργικότητα

- περαιτέρω

- γενικά

- γεννήτρια

- παίρνω

- Δώστε

- Παγκόσμιο

- Go

- GPU

- GPU

- είχε

- Handles

- hands-on

- συμβαίνει

- Έχω

- he

- βαριά

- βαριά ανύψωση

- βοήθεια

- βοηθά

- εδώ

- Ψηλά

- υψηλή απόδοση

- αυτόν

- του

- Οριζόντια

- οικοδεσπότης

- φιλοξενία

- Σπίτι

- Πως

- Πώς να

- HTML

- http

- HTTPS

- if

- εικόνα

- εισαγωγή

- σημαντικό

- εισαγωγή

- in

- σε βάθος

- περιλαμβάνουν

- περιλαμβάνει

- Συμπεριλαμβανομένου

- Αυξάνουν

- υποδηλώνει

- Υποδομή

- Καινοτομία

- καινοτόμες

- εισαγωγή

- είσοδοι

- εγκαθιστώ

- εγκατάσταση

- παράδειγμα

- αντί

- Ινστιτούτο

- Νοημοσύνη

- αλληλεπιδρώντας

- τόκος

- σε

- IT

- αντικειμένων

- ΤΟΥ

- Δουλειά

- jpg

- json

- Διατήρηση

- Κλειδί

- γνώση

- Γλώσσα

- large

- μεγαλύτερος

- Επίθετο

- Αφάνεια

- αργότερο

- ξεκίνησε

- Οδηγεί

- ΜΑΘΑΊΝΩ

- μάθηση

- αριστερά

- Κληροδότημα

- μείον

- Βιβλιοθήκη

- βρίσκεται

- ζωή

- ανύψωση

- πυγμάχος ελαφρού βάρους

- Μου αρέσει

- LIMIT

- γραμμή

- LLM

- τοπικός

- τοποθεσία

- ξύλευση

- Χαμηλός

- μηχανή

- μάθηση μηχανής

- κάνω

- ΚΑΝΕΙ

- διαχείριση

- διευθυντής

- πολοί

- Μνήμη

- νου

- Λεπτ.

- ML

- μοντέλο

- μοντέλα

- Παρακολούθηση

- περισσότερο

- πολύ

- πολλαπλούς

- πρέπει

- Φυσικό

- Επεξεργασία φυσικής γλώσσας

- απαραίτητος

- Ανάγκη

- ανάγκες

- δικτύωσης

- Νέα

- nlp

- σημειωματάριο

- τώρα

- Nvidia

- αντικείμενο

- of

- προσφορά

- συχνά

- on

- ONE

- αποκλειστικά

- ανοικτού κώδικα

- βελτιστοποίηση

- βελτιστοποιημένη

- Επιλογή

- Επιλογές

- or

- ενορχήστρωση

- επιχειρήσεις

- οργανώσεις

- πρωτότυπο

- OS

- ΑΛΛΑ

- δικός μας

- έξω

- παραγωγή

- Ξεπεράστε

- δική

- πακέτο

- συσκευάζονται

- Packages

- Παράλληλο

- παράμετρος

- παράμετροι

- Ειδικότερα

- μονοπάτι

- επίδοση

- κομμάτια

- αγωγού

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- Σημείο

- Δημοφιλής

- Θέση

- αρμοδιότητες

- Predictor

- έτοιμος

- προηγούμενος

- Επεξεργασμένο

- μεταποίηση

- Προϊόν

- υπεύθυνος προϊόντων

- Προϊόντα

- ιδιότητες

- παρέχουν

- παρέχεται

- παρέχει

- δημοσίως

- σκοπός

- έτοιμος

- λαμβάνω

- περιοχή

- σχετίζεται με

- αναπαραγωγή

- ζητήσει

- απαιτούν

- απαιτείται

- Απαιτεί

- έρευνα

- ερευνητές

- Απάντηση

- αποτέλεσμα

- απόδοση

- Ρόλος

- τρέξιμο

- σοφός

- Κλίμακα

- επιστημονικός

- επιστήμονες

- SDK

- δείτε

- αναζήτηση

- αρχαιότερος

- Χωρίς διακομιστή

- Υπηρεσίες

- εξυπηρετούν

- Συνεδρίαση

- σειρά

- διάφοροι

- έδειξε

- Απλούς

- απλοποίηση

- απλά

- ενιαίας

- Μέγεθος

- μικρότερος

- So

- Κοινωνία

- λογισμικό

- ανάπτυξη λογισμικού

- Μηχανικός Λογισμικού

- λύση

- Λύσεις

- ειδικός

- ειδικώς

- διάδοση

- Εκκίνηση

- ξεκίνησε

- εκκίνηση

- state-of-the-art

- Κατάσταση

- Ακόμη

- χώρος στο δίσκο

- κατάστημα

- ειλικρινής

- Στρατηγική

- στρατηγικές

- ροής

- επιτυχής

- Επιτυχώς

- τέτοιος

- κοστούμι

- υποστήριξη

- ανταλλαγής

- σύστημα

- Πάρτε

- παίρνει

- στόχος

- Τεχνολογίες

- Τεχνολογία

- πει

- δοκιμές

- από

- ότι

- Η

- τους

- τότε

- Εκεί.

- Αυτοί

- αυτοί

- πράγμα

- πράγματα

- αυτό

- φέτος

- τρία

- Μέσω

- διακίνηση

- ώρα

- φορές

- προς την

- ένδειξη

- κουπόνια

- πήρε

- εργαλεία

- κορυφή

- δάδα

- Τρένο

- εκπαιδευμένο

- τρένα

- μεταμορφωτικός

- μετασχηματιστής

- μετασχηματιστές

- Τάσεις

- Τρισεκατομμύριο

- προσπαθώ

- δύο

- τύπος

- τύποι

- συνήθως

- κατανόηση

- Φορτώθηκε

- us

- χρήση

- μεταχειρισμένος

- χρησιμοποιώντας

- χρησιμότητα

- αξία

- πολύ

- όραμα

- θέλω

- ήταν

- we

- ιστός

- διαδικτυακές υπηρεσίες

- εβδομάδα

- ΛΟΙΠΌΝ

- Τι

- Τι είναι

- πότε

- ενώ

- Ποιό

- ενώ

- θα

- με

- εντός

- εργαζόμενος

- λειτουργεί

- χειρότερος

- θα

- γραφή

- έτος

- χρόνια

- Εσείς

- Σας

- zephyrnet

- ΖΩΟΛΟΓΙΚΟΣ ΚΗΠΟΣ