Τα μεγάλα γλωσσικά μοντέλα (LLM) μπορούν να χρησιμοποιηθούν για την ανάλυση πολύπλοκων εγγράφων και την παροχή περιλήψεων και απαντήσεων σε ερωτήσεις. Η δημοσίευση Προσαρμογή τομέα Βελτιστοποίηση των μοντέλων θεμελίωσης στο Amazon SageMaker JumpStart στα οικονομικά δεδομένα περιγράφει πώς να τελειοποιήσετε ένα LLM χρησιμοποιώντας το δικό σας σύνολο δεδομένων. Μόλις αποκτήσετε ένα σταθερό LLM, θα θέλετε να εκθέσετε αυτό το LLM σε επαγγελματίες χρήστες για την επεξεργασία νέων εγγράφων, τα οποία θα μπορούσαν να είναι εκατοντάδες σελίδες. Σε αυτήν την ανάρτηση, δείχνουμε πώς να δημιουργήσετε μια διεπαφή χρήστη σε πραγματικό χρόνο για να επιτρέψετε στους επιχειρηματίες να επεξεργάζονται ένα έγγραφο PDF αυθαίρετου μήκους. Μόλις γίνει η επεξεργασία του αρχείου, μπορείτε να συνοψίσετε το έγγραφο ή να κάνετε ερωτήσεις σχετικά με το περιεχόμενο. Το δείγμα λύσης που περιγράφεται σε αυτήν την ανάρτηση είναι διαθέσιμο στο GitHub.

Εργασία με οικονομικά έγγραφα

Οι οικονομικές καταστάσεις όπως οι τριμηνιαίες εκθέσεις κερδών και οι ετήσιες εκθέσεις προς τους μετόχους είναι συχνά δεκάδες ή εκατοντάδες σελίδες. Αυτά τα έγγραφα περιέχουν πολλές γλώσσες, όπως δηλώσεις αποποίησης ευθύνης και νομική γλώσσα. Εάν θέλετε να εξαγάγετε τα βασικά σημεία δεδομένων από ένα από αυτά τα έγγραφα, χρειάζεστε τόσο χρόνο όσο και λίγη εξοικείωση με τη γλώσσα του boilerplate, ώστε να μπορείτε να εντοπίσετε τα ενδιαφέροντα γεγονότα. Και φυσικά, δεν μπορείτε να κάνετε ερωτήσεις σε ένα LLM για ένα έγγραφο που δεν έχει δει ποτέ.

Τα LLM που χρησιμοποιούνται για τη σύνοψη έχουν ένα όριο στον αριθμό των διακριτικών (χαρακτήρων) που διαβιβάζονται στο μοντέλο και, με ορισμένες εξαιρέσεις, αυτά δεν είναι συνήθως περισσότερα από μερικές χιλιάδες μάρκες. Αυτό συνήθως αποκλείει τη δυνατότητα σύνοψης μεγαλύτερων εγγράφων.

Η λύση μας χειρίζεται έγγραφα που υπερβαίνουν το μέγιστο μήκος ακολουθίας διακριτικών ενός LLM και καθιστά αυτό το έγγραφο διαθέσιμο στο LLM για απάντηση ερωτήσεων.

Επισκόπηση λύσεων

Το σχέδιό μας έχει τρία σημαντικά κομμάτια:

- Διαθέτει μια διαδραστική εφαρμογή web για επαγγελματίες χρήστες για να ανεβάζουν και να επεξεργάζονται αρχεία PDF

- Χρησιμοποιεί τη βιβλιοθήκη langchain για να χωρίσει ένα μεγάλο PDF σε πιο διαχειρίσιμα κομμάτια

- Χρησιμοποιεί την τεχνική ανάκτησης επαυξημένης γενιάς για να επιτρέπει στους χρήστες να κάνουν ερωτήσεις σχετικά με νέα δεδομένα που το LLM δεν έχει δει πριν

Όπως φαίνεται στο παρακάτω διάγραμμα, χρησιμοποιούμε μια διεπαφή που υλοποιείται με React JavaScript που φιλοξενείται σε ένα Απλή υπηρεσία αποθήκευσης Amazon (Amazon S3) κουβάς μπροστά Amazon CloudFront. Η εφαρμογή front-end επιτρέπει στους χρήστες να ανεβάζουν έγγραφα PDF στο Amazon S3. Αφού ολοκληρωθεί η μεταφόρτωση, μπορείτε να ενεργοποιήσετε μια εργασία εξαγωγής κειμένου που υποστηρίζεται από Textract Amazon. Ως μέρος της μετα-επεξεργασίας, ένα AWS Lambda Η συνάρτηση εισάγει ειδικούς δείκτες στο κείμενο που υποδεικνύουν τα όρια της σελίδας. Όταν ολοκληρωθεί αυτή η εργασία, μπορείτε να επικαλεστείτε ένα API που συνοψίζει το κείμενο ή απαντά σε ερωτήσεις σχετικά με αυτό.

Επειδή ορισμένα από αυτά τα βήματα μπορεί να διαρκέσουν κάποιο χρόνο, η αρχιτεκτονική χρησιμοποιεί μια αποσυνδεδεμένη ασύγχρονη προσέγγιση. Για παράδειγμα, η κλήση για σύνοψη ενός εγγράφου καλεί μια συνάρτηση Lambda που δημοσιεύει ένα μήνυμα σε ένα Υπηρεσία απλής ουράς Amazon (Amazon SQS) ουρά. Μια άλλη συνάρτηση Lambda λαμβάνει αυτό το μήνυμα και ξεκινά ένα Υπηρεσία ελαστικών εμπορευματοκιβωτίων Amazon (Amazon ECS) AWS Fargate έργο. Η εργασία Fargate καλεί το Amazon Sage Maker τελικό σημείο συμπερασμάτων. Χρησιμοποιούμε μια εργασία Fargate εδώ, επειδή η σύνοψη ενός πολύ μεγάλου PDF μπορεί να πάρει περισσότερο χρόνο και μνήμη από ό,τι έχει διαθέσιμη μια συνάρτηση Lambda. Όταν ολοκληρωθεί η σύνοψη, η εφαρμογή front-end μπορεί να πάρει τα αποτελέσματα από ένα Amazon DynamoDB πίνακα.

Για περίληψη, χρησιμοποιούμε το μοντέλο Summarize του AI21, ένα από τα βασικά μοντέλα που είναι διαθέσιμα μέσω Amazon SageMaker JumpStart. Αν και αυτό το μοντέλο χειρίζεται έγγραφα έως και 10,000 λέξεων (περίπου 40 σελίδες), χρησιμοποιούμε τον διαχωριστή κειμένου της langchain για να βεβαιωθούμε ότι κάθε κλήση περίληψης στο LLM δεν υπερβαίνει τις 10,000 λέξεις. Για τη δημιουργία κειμένου, χρησιμοποιούμε το μοντέλο Cohere's Medium και χρησιμοποιούμε το GPT-J για ενσωματώσεις, και τα δύο μέσω του JumpStart.

Επεξεργασία περίληψης

Όταν χειριζόμαστε μεγαλύτερα έγγραφα, πρέπει να ορίσουμε πώς να χωρίσουμε το έγγραφο σε μικρότερα κομμάτια. Όταν λαμβάνουμε τα αποτελέσματα εξαγωγής κειμένου πίσω από το Amazon Textract, εισάγουμε δείκτες για μεγαλύτερα κομμάτια κειμένου (ένας διαμορφώσιμος αριθμός σελίδων), μεμονωμένες σελίδες και αλλαγές γραμμής. Η Langchain θα χωριστεί με βάση αυτούς τους δείκτες και θα συναρμολογήσει μικρότερα έγγραφα που βρίσκονται κάτω από το όριο διακριτικών. Δείτε τον παρακάτω κώδικα:

Το LLM στην αλυσίδα σύνοψης είναι ένα λεπτό περιτύλιγμα γύρω από το τελικό σημείο του SageMaker:

Ερώτηση απάντηση

Στη μέθοδο ανάκτησης επαυξημένης παραγωγής, πρώτα χωρίζουμε το έγγραφο σε μικρότερα τμήματα. Δημιουργούμε ενσωματώσεις για κάθε τμήμα και τις αποθηκεύουμε στη βάση δεδομένων ανοιχτού κώδικα Chroma vector μέσω της διεπαφής του langchain. Αποθηκεύουμε τη βάση δεδομένων σε ένα Σύστημα αρχείων ελαστικού Amazon (Amazon EFS) σύστημα αρχείων για μελλοντική χρήση. Δείτε τον παρακάτω κώδικα:

Όταν οι ενσωματώσεις είναι έτοιμες, ο χρήστης μπορεί να κάνει μια ερώτηση. Αναζητούμε τη διανυσματική βάση δεδομένων για τα κομμάτια κειμένου που ταιριάζουν περισσότερο με την ερώτηση:

Παίρνουμε το πιο κοντινό κομμάτι που ταιριάζει και το χρησιμοποιούμε ως πλαίσιο για το μοντέλο δημιουργίας κειμένου για να απαντήσουμε στην ερώτηση:

Εμπειρία χρήστη

Αν και τα LLM αντιπροσωπεύουν προηγμένη επιστήμη δεδομένων, οι περισσότερες από τις περιπτώσεις χρήσης για LLMs περιλαμβάνουν τελικά αλληλεπίδραση με μη τεχνικούς χρήστες. Το παράδειγμα εφαρμογής ιστού μας χειρίζεται μια περίπτωση διαδραστικής χρήσης όπου οι επιχειρηματίες μπορούν να ανεβάσουν και να επεξεργαστούν ένα νέο έγγραφο PDF.

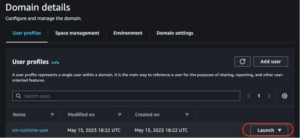

Το παρακάτω διάγραμμα δείχνει τη διεπαφή χρήστη. Ένας χρήστης ξεκινάει ανεβάζοντας ένα PDF. Μετά την αποθήκευση του εγγράφου στο Amazon S3, ο χρήστης μπορεί να ξεκινήσει την εργασία εξαγωγής κειμένου. Όταν αυτό ολοκληρωθεί, ο χρήστης μπορεί να επικαλεστεί την εργασία σύνοψης ή να κάνει ερωτήσεις. Η διεπαφή χρήστη εκθέτει ορισμένες προηγμένες επιλογές, όπως το μέγεθος και την επικάλυψη κομματιού, κάτι που θα ήταν χρήσιμο για προχωρημένους χρήστες που δοκιμάζουν την εφαρμογή σε νέα έγγραφα.

Τα επόμενα βήματα

Τα LLM παρέχουν σημαντικές νέες δυνατότητες ανάκτησης πληροφοριών. Οι επαγγελματίες χρήστες χρειάζονται εύκολη πρόσβαση σε αυτές τις δυνατότητες. Υπάρχουν δύο κατευθύνσεις για μελλοντικές εργασίες που πρέπει να ληφθούν υπόψη:

- Επωφεληθείτε από τα ισχυρά LLM που είναι ήδη διαθέσιμα στα μοντέλα Jumpstart foundation. Με λίγες μόνο γραμμές κώδικα, το δείγμα της εφαρμογής μας θα μπορούσε να αναπτύξει και να χρησιμοποιήσει προηγμένα LLM από το AI21 και το Cohere για σύνοψη και δημιουργία κειμένου.

- Κάντε αυτές τις δυνατότητες προσβάσιμες σε μη τεχνικούς χρήστες. Προϋπόθεση για την επεξεργασία εγγράφων PDF είναι η εξαγωγή κειμένου από το έγγραφο και οι εργασίες σύνοψης ενδέχεται να διαρκέσουν αρκετά λεπτά για να εκτελεστούν. Αυτό απαιτεί μια απλή διεπαφή χρήστη με δυνατότητες ασύγχρονης επεξεργασίας backend, η οποία είναι εύκολο να σχεδιαστεί χρησιμοποιώντας υπηρεσίες εγγενούς στο cloud, όπως το Lambda και το Fargate.

Σημειώνουμε επίσης ότι ένα έγγραφο PDF είναι ημιδομημένη πληροφορία. Σημαντικές ενδείξεις όπως οι επικεφαλίδες ενοτήτων είναι δύσκολο να εντοπιστούν μέσω προγραμματισμού, επειδή βασίζονται σε μεγέθη γραμματοσειράς και άλλους οπτικούς δείκτες. Ο εντοπισμός της υποκείμενης δομής των πληροφοριών βοηθά το LLM να επεξεργάζεται τα δεδομένα με μεγαλύτερη ακρίβεια, τουλάχιστον μέχρι τη στιγμή που τα LLM μπορούν να χειριστούν είσοδο απεριόριστου μήκους.

Συμπέρασμα

Σε αυτήν την ανάρτηση, δείξαμε πώς να δημιουργήσετε μια διαδραστική εφαρμογή Ιστού που επιτρέπει στους επαγγελματίες χρήστες να ανεβάζουν και να επεξεργάζονται έγγραφα PDF για σύνοψη και απάντηση ερωτήσεων. Είδαμε πώς να εκμεταλλευτούμε τα μοντέλα θεμελίωσης Jumpstart για πρόσβαση σε προηγμένα LLM και να χρησιμοποιήσουμε τεχνικές διαχωρισμού κειμένου και ανάκτησης επαυξημένης παραγωγής για να επεξεργαστούμε μεγαλύτερα έγγραφα και να τα κάνουμε διαθέσιμα ως πληροφορίες στο LLM.

Αυτή τη στιγμή, δεν υπάρχει κανένας λόγος να μην διαθέσετε αυτές τις ισχυρές δυνατότητες στους χρήστες σας. Σας ενθαρρύνουμε να αρχίσετε να χρησιμοποιείτε το Μοντέλα θεμελίωσης Jumpstart σήμερα.

Σχετικά με τον Συγγραφέα

Randy DeFauw είναι Senior Principal Solutions Architect στην AWS. Είναι κάτοχος MSEE από το Πανεπιστήμιο του Μίσιγκαν, όπου εργάστηκε στην όραση υπολογιστών για αυτόνομα οχήματα. Είναι επίσης κάτοχος MBA από το Κρατικό Πανεπιστήμιο του Κολοράντο. Ο Randy κατείχε διάφορες θέσεις στον τεχνολογικό χώρο, που κυμαίνονται από τη μηχανική λογισμικού έως τη διαχείριση προϊόντων. Το In εισήλθε στον χώρο των Big Data το 2013 και συνεχίζει να εξερευνά αυτήν την περιοχή. Εργάζεται ενεργά σε έργα στον χώρο της ML και έχει παρουσιάσει σε πολυάριθμα συνέδρια, συμπεριλαμβανομένων των Strata και GlueCon.

Randy DeFauw είναι Senior Principal Solutions Architect στην AWS. Είναι κάτοχος MSEE από το Πανεπιστήμιο του Μίσιγκαν, όπου εργάστηκε στην όραση υπολογιστών για αυτόνομα οχήματα. Είναι επίσης κάτοχος MBA από το Κρατικό Πανεπιστήμιο του Κολοράντο. Ο Randy κατείχε διάφορες θέσεις στον τεχνολογικό χώρο, που κυμαίνονται από τη μηχανική λογισμικού έως τη διαχείριση προϊόντων. Το In εισήλθε στον χώρο των Big Data το 2013 και συνεχίζει να εξερευνά αυτήν την περιοχή. Εργάζεται ενεργά σε έργα στον χώρο της ML και έχει παρουσιάσει σε πολυάριθμα συνέδρια, συμπεριλαμβανομένων των Strata και GlueCon.

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Αυτοκίνητο / EVs, Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- BlockOffsets. Εκσυγχρονισμός της περιβαλλοντικής αντιστάθμισης ιδιοκτησίας. Πρόσβαση εδώ.

- πηγή: https://aws.amazon.com/blogs/machine-learning/use-a-generative-ai-foundation-model-for-summarization-and-question-answering-using-your-own-data/

- :έχει

- :είναι

- :δεν

- :που

- $UP

- 000

- 10

- 100

- 13

- 14

- 15%

- 2013

- 25

- 40

- 500

- 7

- a

- ικανότητα

- Ικανός

- Σχετικα

- σχετικά με αυτό

- πρόσβαση

- προσιτός

- με ακρίβεια

- δραστήρια

- προηγμένες

- Πλεονέκτημα

- Μετά το

- AI

- ήδη

- Επίσης

- Αν και

- Amazon

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Textract Amazon

- Amazon υπηρεσίες Web

- an

- αναλύσει

- και

- ετήσιος

- Άλλος

- απάντηση

- απαντήσεις

- api

- Εφαρμογή

- πλησιάζω

- περίπου

- αρχιτεκτονική

- ΕΙΝΑΙ

- ΠΕΡΙΟΧΗ

- γύρω

- AS

- At

- επαυξημένης

- συγγραφέας

- αυτονόμος

- αυτόνομα οχήματα

- διαθέσιμος

- AWS

- πίσω

- Backend

- βασίζονται

- BE

- επειδή

- Μεγάλος

- Big Data

- και οι δύο

- όρια

- φρένα

- χτίζω

- επιχείρηση

- by

- κλήση

- κλήσεις

- CAN

- δυνατότητες

- περίπτωση

- περιπτώσεις

- αλυσίδα

- χαρακτήρες

- στενά

- κωδικός

- Κολοράντο

- πλήρης

- συγκρότημα

- υπολογιστή

- Computer Vision

- συνέδρια

- Εξετάστε

- κατασκευάσει

- περιέχουν

- Δοχείο

- περιεχόμενο

- συμφραζόμενα

- συνεχίζεται

- Βολικός

- θα μπορούσε να

- Πορεία

- δημιουργία

- ημερομηνία

- σημεία δεδομένων

- επιστημονικά δεδομένα

- βάση δεδομένων

- αποσυνδεδεμένο

- ορίζεται

- αποδεικνύουν

- παρατάσσω

- περιγράφεται

- Υπηρεσίες

- δύσκολος

- έγγραφο

- έγγραφα

- γίνεται

- κάθε

- Κέρδη

- εύκολος

- ενθαρρύνει

- τέλος

- Τελικό σημείο

- Μηχανική

- εισήχθη

- παράδειγμα

- υπερβαίνω

- διερευνήσει

- εκχύλισμα

- γεγονότα

- Εξοικείωση

- λίγοι

- Αρχεία

- οικονομικός

- Όνομα

- Εξής

- Για

- Θεμέλιο

- από

- εμπρός

- εμπρόσθιο άκρο

- λειτουργία

- μελλοντικός

- γενεά

- γενετική

- Παραγωγική τεχνητή νοημοσύνη

- παίρνω

- λαβή

- Handles

- Χειρισμός

- Έχω

- he

- Ήρωας

- βοηθά

- εδώ

- κατέχει

- φιλοξενείται

- Πως

- Πώς να

- http

- HTTPS

- Εκατοντάδες

- προσδιορίσει

- προσδιορισμό

- if

- εφαρμοστεί

- σημαντικό

- in

- Συμπεριλαμβανομένου

- δείκτες

- ατομικές

- πληροφορίες

- εισαγωγή

- Ένθετα

- αλληλεπίδραση

- διαδραστικό

- ενδιαφέρον

- περιβάλλον λειτουργίας

- σε

- επικαλείται

- εμπλέκω

- IT

- το JavaScript

- Δουλειά

- Θέσεις εργασίας

- jpg

- μόλις

- Κλειδί

- Γλώσσα

- large

- μεγαλύτερος

- αργότερα

- ελάχιστα

- Νομικά

- Μήκος

- ας

- Αφήνει

- Βιβλιοθήκη

- Μου αρέσει

- LIMIT

- γραμμή

- γραμμές

- LLM

- φορτωτής

- Μακριά

- πλέον

- Παρτίδα

- κάνω

- ευχείριστος

- διαχείριση

- Ταίριασμα

- ταιριάζουν

- ανώτατο όριο

- Ενδέχεται..

- medium

- Μνήμη

- μήνυμα

- μέθοδος

- Μίσιγκαν

- Λεπτ.

- ML

- μοντέλο

- μοντέλα

- περισσότερο

- πλέον

- Ανάγκη

- ποτέ

- Νέα

- Όχι.

- μη τεχνικό

- Κανονικά

- αριθμός

- πολυάριθμες

- of

- συχνά

- on

- μια φορά

- ONE

- ανοικτού κώδικα

- Επιλογές

- or

- ΑΛΛΑ

- δικός μας

- δική

- σελίδα

- σελίδες

- μέρος

- πέρασε

- επιλέξτε

- Επιλογές

- εικόνα

- κομμάτια

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- Σημείο

- σημεία

- θέσεις

- Θέση

- Δημοσιεύσεις

- τροφοδοτείται

- ισχυρός

- παρουσιάζονται

- Κύριος

- διαδικασια μας

- Επεξεργασμένο

- μεταποίηση

- Προϊόν

- διαχείριση προϊόντων

- έργα

- παρέχουν

- ερώτηση

- Ερωτήσεις

- κυμαίνεται

- Αντίδραση

- έτοιμος

- σε πραγματικό χρόνο

- λόγος

- βασίζονται

- Εκθέσεις

- εκπροσωπώ

- απάντησης

- απαντήσεις

- Αποτελέσματα

- απόδοση

- τρέξιμο

- σοφός

- Αποθήκευση

- πριόνι

- Επιστήμη

- Αναζήτηση

- Τμήμα

- δείτε

- δει

- τμήμα

- τμήματα

- ΕΑΥΤΟΣ

- αρχαιότερος

- Ακολουθία

- Υπηρεσίες

- διάφοροι

- Μέτοχοι

- έδειξε

- παρουσιάζεται

- Δείχνει

- σημαντικός

- Απλούς

- Μέγεθος

- μεγέθη

- μικρότερος

- So

- λογισμικό

- τεχνολογία λογισμικού

- στέρεο

- λύση

- Λύσεις

- μερικοί

- Χώρος

- ειδική

- διαίρεση

- Διαχωρίστε

- Εκκίνηση

- ξεκινά

- Κατάσταση

- δηλώσεις

- Βήματα

- στάση

- χώρος στο δίσκο

- κατάστημα

- αποθηκεύονται

- δομή

- τέτοιος

- συνοψίζω

- ΠΕΡΙΛΗΨΗ

- βέβαιος

- σύστημα

- τραπέζι

- Πάρτε

- Έργο

- τεχνικές

- Τεχνολογία

- δεκάδες

- Δοκιμές

- από

- ότι

- Η

- Τους

- Εκεί.

- Αυτοί

- αυτοί

- αυτό

- εκείνοι

- τρία

- Μέσω

- ώρα

- προς την

- σήμερα

- ένδειξη

- κουπόνια

- ενεργοποιούν

- δύο

- συνήθως

- τελικά

- υπό

- υποκείμενες

- πανεπιστήμιο

- μέχρι

- Ανέβασμα

- χρήση

- περίπτωση χρήσης

- μεταχειρισμένος

- Χρήστες

- Διεπαφής χρήστη

- Χρήστες

- χρησιμοποιεί

- χρησιμοποιώντας

- ποικιλία

- Οχήματα

- πολύ

- μέσω

- όραμα

- θέλω

- we

- ιστός

- Εφαρμογή Web

- διαδικτυακές υπηρεσίες

- πότε

- Ποιό

- Ο ΟΠΟΊΟΣ

- θα

- με

- λόγια

- Εργασία

- εργάστηκαν

- εργαζόμενος

- θα

- Εσείς

- Σας

- zephyrnet