Εισαγωγή

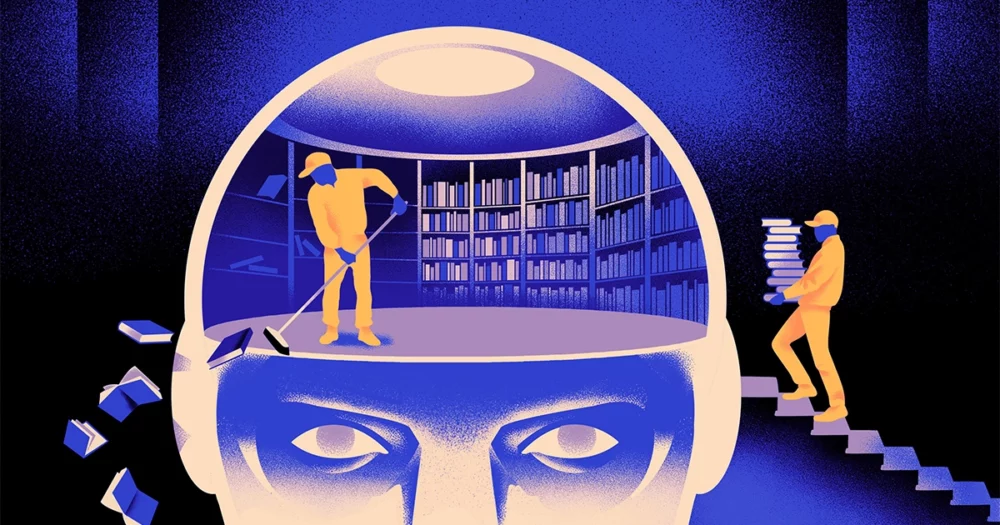

Μια ομάδα επιστημόνων υπολογιστών δημιούργησε ένα πιο ευκίνητος, πιο ευέλικτος τύπος του μοντέλου μηχανικής μάθησης. Το κόλπο: Πρέπει περιοδικά να ξεχνάει αυτά που ξέρει. Και ενώ αυτή η νέα προσέγγιση δεν θα αντικαταστήσει τα τεράστια μοντέλα που βρίσκονται κάτω από τις μεγαλύτερες εφαρμογές, θα μπορούσε να αποκαλύψει περισσότερα για το πώς αυτά τα προγράμματα κατανοούν τη γλώσσα.

Η νέα έρευνα σηματοδοτεί «μια σημαντική πρόοδο στον τομέα», είπε Jea Kwon, μηχανικός AI στο Ινστιτούτο Βασικών Επιστημών στη Νότια Κορέα.

Οι μηχανές γλώσσας AI που χρησιμοποιούνται σήμερα τροφοδοτούνται κυρίως από τεχνητά νευρωνικά δίκτυα. Κάθε «νευρώνας» στο δίκτυο είναι μια μαθηματική συνάρτηση που λαμβάνει σήματα από άλλους τέτοιους νευρώνες, εκτελεί ορισμένους υπολογισμούς και στέλνει σήματα μέσω πολλαπλών στρωμάτων νευρώνων. Αρχικά η ροή των πληροφοριών είναι λίγο πολύ τυχαία, αλλά μέσω της εκπαίδευσης, η ροή πληροφοριών μεταξύ των νευρώνων βελτιώνεται καθώς το δίκτυο προσαρμόζεται στα δεδομένα εκπαίδευσης. Εάν ένας ερευνητής τεχνητής νοημοσύνης θέλει να δημιουργήσει ένα δίγλωσσο μοντέλο, για παράδειγμα, θα εκπαιδεύσει το μοντέλο με ένα μεγάλο σωρό κειμένου και από τις δύο γλώσσες, το οποίο θα προσαρμόζει τις συνδέσεις μεταξύ των νευρώνων με τέτοιο τρόπο ώστε να συσχετίζει το κείμενο σε μία γλώσσα με ισοδύναμο λέξεις στο άλλο.

Αλλά αυτή η διαδικασία εκπαίδευσης απαιτεί μεγάλη υπολογιστική ισχύ. Εάν το μοντέλο δεν λειτουργεί πολύ καλά ή εάν οι ανάγκες του χρήστη αλλάξουν αργότερα, είναι δύσκολο να το προσαρμόσετε. «Ας πούμε ότι έχετε ένα μοντέλο που έχει 100 γλώσσες, αλλά φανταστείτε ότι μια γλώσσα που θέλετε δεν καλύπτεται», είπε Mikel Artetxe, συν-συγγραφέας της νέας έρευνας και ιδρυτής της startup AI Reka. «Θα μπορούσατε να ξεκινήσετε από την αρχή, αλλά δεν είναι το ιδανικό».

Ο Artetxe και οι συνεργάτες του προσπάθησαν να παρακάμψουν αυτούς τους περιορισμούς. Πριν από λίγα χρόνια, ο Artetxe και άλλοι εκπαίδευσαν ένα νευρωνικό δίκτυο σε μία γλώσσα και στη συνέχεια διέγραψαν όσα γνώριζε για τα δομικά στοιχεία των λέξεων, που ονομάζονται tokens. Αυτά αποθηκεύονται στο πρώτο στρώμα του νευρωνικού δικτύου, που ονομάζεται στρώμα ενσωμάτωσης. Άφησαν όλα τα άλλα στρώματα του μοντέλου μόνα τους. Αφού διέγραψαν τα διακριτικά της πρώτης γλώσσας, επανεκπαίδευσαν το μοντέλο στη δεύτερη γλώσσα, η οποία γέμισε το στρώμα ενσωμάτωσης με νέα διακριτικά από αυτήν τη γλώσσα.

Παρόλο που το μοντέλο περιείχε ακατάλληλες πληροφορίες, η επανεκπαίδευση λειτούργησε: Το μοντέλο μπορούσε να μάθει και να επεξεργαστεί τη νέα γλώσσα. Οι ερευνητές υπέθεσαν ότι ενώ το στρώμα ενσωμάτωσης αποθήκευε πληροφορίες συγκεκριμένες για τις λέξεις που χρησιμοποιούνται στη γλώσσα, τα βαθύτερα επίπεδα του δικτύου αποθήκευαν πιο αφηρημένες πληροφορίες σχετικά με τις έννοιες πίσω από τις ανθρώπινες γλώσσες, οι οποίες στη συνέχεια βοήθησαν το μοντέλο να μάθει τη δεύτερη γλώσσα.

«Ζούμε στον ίδιο κόσμο. Αντιλαμβανόμαστε τα ίδια πράγματα με διαφορετικές λέξεις» σε διαφορετικές γλώσσες, είπε Γιχόνγκ Τσεν, ο κύριος συγγραφέας της πρόσφατης εργασίας. «Γι' αυτό έχετε το ίδιο σκεπτικό υψηλού επιπέδου στο μοντέλο. Ένα μήλο είναι κάτι γλυκό και ζουμερό, αντί για μια λέξη».

Εισαγωγή

Ενώ αυτή η προσέγγιση λήθης ήταν ένας αποτελεσματικός τρόπος για να προστεθεί μια νέα γλώσσα σε ένα ήδη εκπαιδευμένο μοντέλο, η επανεκπαίδευση ήταν ακόμα απαιτητική — απαιτούσε πολλά γλωσσικά δεδομένα και επεξεργαστική ισχύ. Ο Τσεν πρότεινε μια προσαρμογή: Αντί να προπονούνται, να διαγράφουν το στρώμα ενσωμάτωσης και μετά να επανεκπαιδεύονται, θα πρέπει περιοδικά να μηδενίζουν το στρώμα ενσωμάτωσης κατά τον αρχικό γύρο της προπόνησης. «Κάνοντας αυτό, ολόκληρο το μοντέλο συνηθίζει την επαναφορά», είπε ο Artetxe. «Αυτό σημαίνει ότι όταν θέλετε να επεκτείνετε το μοντέλο σε άλλη γλώσσα, είναι πιο εύκολο, γιατί αυτό κάνατε».

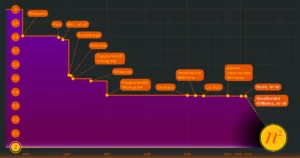

Οι ερευνητές πήραν ένα μοντέλο γλώσσας που χρησιμοποιείται συνήθως με το όνομα Roberta, το εκπαίδευσε χρησιμοποιώντας την τεχνική περιοδικής λήθης και το συνέκρινε με την απόδοση του ίδιου μοντέλου όταν εκπαιδεύτηκε με την τυπική, μη λήθη προσέγγιση. Το μοντέλο που ξεχνούσε τα πήγε ελαφρώς χειρότερα από το συμβατικό, λαμβάνοντας βαθμολογία 85.1 σε σύγκριση με 86.1 σε ένα κοινό μέτρο γλωσσικής ακρίβειας. Στη συνέχεια, επανεκπαίδευσαν τα μοντέλα σε άλλες γλώσσες, χρησιμοποιώντας πολύ μικρότερα σύνολα δεδομένων με μόνο 5 εκατομμύρια μάρκες, αντί για τα 70 δισεκατομμύρια που χρησιμοποίησαν κατά την πρώτη εκπαίδευση. Η ακρίβεια του τυπικού μοντέλου μειώθηκε στο 53.3 κατά μέσο όρο, αλλά το μοντέλο που ξεχνούσε έπεσε μόνο στο 62.7.

Το μοντέλο λήθης ήταν επίσης πολύ καλύτερα εάν η ομάδα επέβαλε υπολογιστικά όρια κατά τη διάρκεια της επανεκπαίδευσης. Όταν οι ερευνητές μείωσαν τη διάρκεια της προπόνησης από 125,000 βήματα σε μόλις 5,000, η ακρίβεια του μοντέλου που ξεχνούσε μειώθηκε στο 57.8, κατά μέσο όρο, ενώ το τυπικό μοντέλο έπεσε στο 37.2, κάτι που δεν είναι καλύτερο από τις τυχαίες εικασίες.

Εισαγωγή

Η ομάδα κατέληξε στο συμπέρασμα ότι η περιοδική λήθη φαίνεται να κάνει το μοντέλο καλύτερο στην εκμάθηση γλωσσών γενικά. «Επειδή [συνεχίζουν] να ξεχνούν και να ξαναμάθουν κατά τη διάρκεια της προπόνησης, η διδασκαλία στο δίκτυο κάτι νέο αργότερα γίνεται ευκολότερο», είπε. Evgenii Nikishin, ερευνητής στο Mila, ένα ερευνητικό κέντρο βαθιάς μάθησης στο Κεμπέκ. Υποδηλώνει ότι όταν τα γλωσσικά μοντέλα κατανοούν μια γλώσσα, το κάνουν σε ένα βαθύτερο επίπεδο από τις έννοιες των μεμονωμένων λέξεων.

Η προσέγγιση είναι παρόμοια με το πώς λειτουργεί ο δικός μας εγκέφαλος. «Η ανθρώπινη μνήμη γενικά δεν είναι πολύ καλή στο να αποθηκεύει με ακρίβεια μεγάλες ποσότητες λεπτομερών πληροφοριών. Αντίθετα, οι άνθρωποι τείνουν να θυμούνται την ουσία των εμπειριών μας, αφαιρώντας και προεκτείνοντας», είπε. Μπέντζαμιν Λέβι, νευροεπιστήμονας στο Πανεπιστήμιο του Σαν Φρανσίσκο. «Η ενεργοποίηση της τεχνητής νοημοσύνης με πιο ανθρώπινες διαδικασίες, όπως η προσαρμοστική λήθη, είναι ένας τρόπος για να αποκτήσουν πιο ευέλικτες επιδόσεις».

Εκτός από το τι θα μπορούσε να πει για το πώς λειτουργεί η κατανόηση, η Artetxe ελπίζει ότι τα πιο ευέλικτα μοντέλα γλώσσας που ξεχνούν θα μπορούσαν επίσης να βοηθήσουν να φέρουμε τις πιο πρόσφατες ανακαλύψεις AI σε περισσότερες γλώσσες. Αν και τα μοντέλα τεχνητής νοημοσύνης είναι καλά στο χειρισμό των ισπανικών και των αγγλικών, δύο γλώσσες με άφθονο εκπαιδευτικό υλικό, τα μοντέλα δεν είναι τόσο καλά με τη μητρική του βασκική, την τοπική γλώσσα που είναι συγκεκριμένη στη βορειοανατολική Ισπανία. «Τα περισσότερα μοντέλα από μεγάλες εταιρείες τεχνολογίας δεν τα καταφέρνουν καλά», είπε. «Η προσαρμογή των υπαρχόντων μοντέλων στα βασκικά είναι ο καλύτερος τρόπος».

Ο Τσεν προσβλέπει επίσης σε έναν κόσμο όπου ανθίζουν περισσότερα λουλούδια τεχνητής νοημοσύνης. «Σκέφτομαι μια κατάσταση όπου ο κόσμος δεν χρειάζεται ένα μεγάλο γλωσσικό μοντέλο. Έχουμε τόσα πολλά», είπε. «Αν υπάρχει ένα εργοστάσιο που κατασκευάζει μοντέλα γλώσσας, χρειάζεστε αυτό το είδος τεχνολογίας. Έχει ένα βασικό μοντέλο που μπορεί να προσαρμοστεί γρήγορα σε νέους τομείς».

- SEO Powered Content & PR Distribution. Ενισχύστε σήμερα.

- PlatoData.Network Vertical Generative Ai. Ενδυναμώστε τον εαυτό σας. Πρόσβαση εδώ.

- PlatoAiStream. Web3 Intelligence. Ενισχύθηκε η γνώση. Πρόσβαση εδώ.

- PlatoESG. Ανθρακας, Cleantech, Ενέργεια, Περιβάλλον, Ηλιακός, Διαχείριση των αποβλήτων. Πρόσβαση εδώ.

- PlatoHealth. Ευφυΐα βιοτεχνολογίας και κλινικών δοκιμών. Πρόσβαση εδώ.

- πηγή: https://www.quantamagazine.org/how-selective-forgetting-can-help-ai-learn-better-20240228/

- :έχει

- :είναι

- :δεν

- :που

- ][Π

- 000

- 1

- 100

- 125

- 7

- 70

- 8

- a

- Σχετικα

- ΠΕΡΙΛΗΨΗ

- ακρίβεια

- με ακρίβεια

- προσαρμόσει

- προσαρμοστική

- προσαρμόζεται

- προσθέτω

- Επιπλέον

- εκ των προτέρων

- Μετά το

- AI

- Μοντέλα AI

- Όλα

- alone

- ήδη

- Επίσης

- Ποσά

- an

- και

- Άλλος

- Apple

- πλησιάζω

- εφαρμογές

- ΕΙΝΑΙ

- AS

- At

- συγγραφέας

- μέσος

- βάση

- βασικός

- επειδή

- γίνεται

- ήταν

- πίσω

- Καλύτερα

- μεταξύ

- Μεγάλος

- μεγάλη τεχνολογία

- Μεγαλύτερη

- Δισεκατομμύριο

- Μπλοκ

- άνθηση

- και οι δύο

- επιτεύγματα

- φέρω

- Κτίριο

- αλλά

- by

- υπολογισμοί

- που ονομάζεται

- CAN

- Κέντρο

- αλλαγή

- Chen

- ματαιώνω

- Συν-Συγγραφέας

- συναδέλφους

- Κοινός

- συνήθως

- Εταιρείες

- σύγκριση

- υπολογιστική

- υπολογιστή

- χρήση υπολογιστή

- υπολογιστική ισχύ

- έννοιες

- Κατέληξε στο συμπέρασμα

- Διασυνδέσεις

- που περιέχονται

- συμβατικός

- θα μπορούσε να

- καλύπτονται

- δημιουργία

- δημιουργήθηκε

- Τομή

- ημερομηνία

- σύνολα δεδομένων

- μειώθηκε

- βαθύς

- βαθιά μάθηση

- βαθύτερη

- απαιτητικές

- λεπτομερής

- DID

- διαφορετικές

- do

- Όχι

- πράξη

- domains

- Μην

- έπεσε

- κατά την διάρκεια

- κάθε

- ευκολότερη

- Αποτελεσματικός

- ενσωμάτωση

- μηχανικός

- Κινητήρες

- Αγγλικά

- Ολόκληρος

- Ισοδύναμος

- παράδειγμα

- υφιστάμενα

- Δραστηριοτητες

- επεκτείνουν

- εργοστάσιο

- λίγοι

- πεδίο

- γεμάτο

- Όνομα

- εύκαμπτος

- ροή

- Για

- Προς τα εμπρός

- ιδρυτής

- Φρανσίσκο

- από

- λειτουργία

- General

- γενικά

- παίρνω

- GitHub

- Go

- καλός

- Χειρισμός

- Σκληρά

- Έχω

- he

- βοήθεια

- βοήθησε

- υψηλού επιπέδου

- του

- ελπίζει

- Πως

- HTTPS

- τεράστιος

- ανθρώπινος

- ανθρώπινο

- Οι άνθρωποι

- ιδανικό

- if

- φαντάζομαι

- επιβάλλονται

- βελτιώνει

- in

- ατομικές

- πληροφορίες

- αρχικός

- αρχικά

- αντί

- Ινστιτούτο

- IT

- μόλις

- Διατήρηση

- Είδος

- ξέρει

- Κορέα

- Γλώσσα

- Γλώσσες

- large

- αργότερα

- αργότερο

- στρώμα

- στρώματα

- οδηγήσει

- ΜΑΘΑΊΝΩ

- μάθηση

- αριστερά

- Μήκος

- μείον

- Επίπεδο

- επίπεδα

- Μου αρέσει

- περιορισμούς

- όρια

- ζω

- τοπικός

- ΦΑΊΝΕΤΑΙ

- Παρτίδα

- μηχανή

- μάθηση μηχανής

- περιοδικό

- κάνω

- Κατασκευή

- πολοί

- υλικά

- μαθηματικός

- σημασίες

- μέσα

- μέτρο

- Μνήμη

- ενδέχεται να

- εκατομμύριο

- μοντέλο

- μοντέλα

- περισσότερο

- ως επί το πλείστον

- πολύ

- πολλαπλούς

- πρέπει

- ντόπιος

- Ανάγκη

- ανάγκες

- δίκτυο

- νευρικός

- νευρικό σύστημα

- Νευρώνες

- Νέα

- Όχι.

- of

- on

- ONE

- αποκλειστικά

- or

- ΑΛΛΑ

- Άλλα

- δικός μας

- επί

- δική

- Χαρτί

- επίδοση

- περιοδικός

- Πλάτων

- Πληροφορία δεδομένων Plato

- Πλάτωνα δεδομένα

- βύθισε

- δύναμη

- τροφοδοτείται

- διαδικασια μας

- Διεργασίες

- μεταποίηση

- Επεξεργαστικη ΙΣΧΥΣ

- Προγράμματα

- Quantamamagazine

- Κεμπέκ

- γρήγορα

- τυχαίος

- μάλλον

- λαμβάνει

- λήψη

- πρόσφατος

- θυμάμαι

- απαιτείται

- έρευνα

- ερευνητής

- ερευνητές

- αποκαλύπτω

- γύρος

- τρέχει

- Είπε

- ίδιο

- Σαν

- Σαν Φρανσίσκο

- λένε

- Επιστήμη

- επιστήμονες

- σκορ

- μηδέν

- Δεύτερος

- φαίνεται

- εκλεκτικός

- αποστέλλει

- Σέτς

- αυτή

- θα πρέπει να

- σήματα

- σημαντικός

- παρόμοιες

- κατάσταση

- μικρότερος

- So

- μερικοί

- κάτι

- Νότος

- Νότια Κορέα

- Ισπανία

- Ισπανικά

- συγκεκριμένες

- πρότυπο

- Εκκίνηση

- εκκίνηση

- Βήματα

- Ακόμη

- αποθηκεύονται

- εναποθήκευση

- τέτοιος

- Προτείνει

- γλυκός

- παίρνει

- Διδασκαλία

- tech

- tech εταιρείες

- τεχνική

- Τεχνολογία

- Τείνουν

- κείμενο

- από

- ότι

- Η

- οι πληροφορίες

- ο κόσμος

- τους

- Τους

- τότε

- Αυτοί

- αυτοί

- πράγματα

- Σκέψη

- αυτό

- αν και?

- Μέσω

- προς την

- σήμερα

- κουπόνια

- πήρε

- Τρένο

- εκπαιδευμένο

- Εκπαίδευση

- τέχνασμα

- Προσπάθησα

- τσιμπιά

- δύο

- καταλαβαίνω

- κατανόηση

- πανεπιστήμιο

- χρήση

- μεταχειρισμένος

- χρησιμοποιώντας

- πολύ

- θέλω

- θέλει

- ήταν

- Τρόπος..

- we

- webp

- ΛΟΙΠΌΝ

- Τι

- πότε

- Ποιό

- ενώ

- WHY

- με

- λέξη

- λόγια

- Εργασία

- εργάστηκαν

- λειτουργεί

- κόσμος

- χειρότερος

- θα

- χρόνια

- Εσείς

- zephyrnet