Google e Intel lanzaron el martes sus propios chips de IA para desafiar a Nvidia a medida que se intensifica la carrera por fabricar semiconductores avanzados para impulsar modelos de IA generativa como ChatGPT o Gemini.

Google lanzó su Cloud TPU v5p e Intel presentó su procesador Gaudi 3 AI. Los chips están diseñados para mejorar el rendimiento en el entrenamiento de sistemas de inteligencia artificial, así como para "ejecutar el software terminado".

Lea también: El terremoto de Taiwán interrumpe un importante centro de chips de IA y amenaza el suministro global

Formar LLM con más velocidad

Google anunció por primera vez su nueva TPU, o unidad de procesamiento de tensores, en diciembre, junto con Gemini. Dijo que el TPU v5p, ahora disponible para los desarrolladores, es su procesador de IA más “potente y escalable” hasta el momento.

La compañía afirma que su chip actualizado puede entrenar grandes modelos de lenguaje (LLM), la tecnología detrás de los chatbots de IA como Gemini y ChatGPT, tres veces más rápido que su predecesor, Google TPU v4. Dijo que el chip AI ofrece un rendimiento 12 veces mayor que la versión anterior.

"Ahora en su quinta generación, estos avances [en las TPU de Google] han ayudado a los clientes a capacitar y ofrecer modelos lingüísticos de vanguardia", dijo el director ejecutivo de Google, Sundar Pichai, en un evento de la empresa en Las Vegas. conforme a los medios de la industria.

[Contenido incrustado]

Si bien el objetivo es desafiar a Nvidia, la empresa estadounidense que suministra hasta el 90% de los chips de IA conocidos como unidades de procesamiento gráfico o GPU, Google demostró que todavía depende de Nvidia.

En el mismo del blog Al anunciar su último TPU, Google dijo que está actualizando su supercomputadora A3, que funciona con NVIDIA H100 Unidades de procesamiento de gráficos. La compañía también reveló que está utilizando la última GPU de Nvidia, la Blackwell, en su hipercomputadora AI.

Google también lanzó Axion, una nueva unidad central de procesamiento (CPU) personalizada para centros de datos construida con la tecnología de la empresa británica Arm. Dijo que Axion, que rivaliza con las CPU de Microsoft, Amazon y Meta, puede manejar diversas tareas, incluidas búsquedas en Google y operaciones de inteligencia artificial.

Según Google, Axion ofrece “un rendimiento un 30 % mejor que las instancias basadas en Arm de uso general más rápidas disponibles en la nube en la actualidad” y “un rendimiento hasta un 50 % mejor y una eficiencia energética hasta un 60 % mejor” que otros Arm de propósito general. papas fritas.

Intel: IA en todas partes

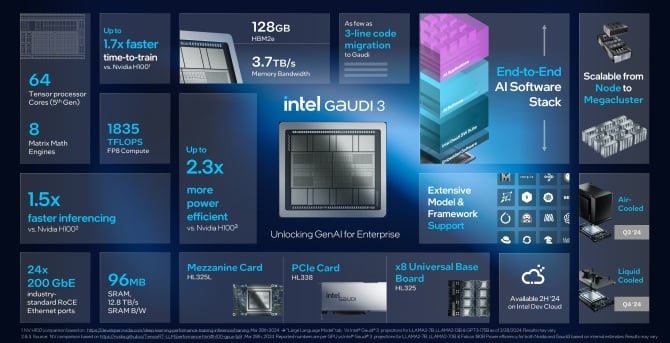

El martes, Intel también anunció el lanzamiento de su nueva versión de su procesador de inteligencia artificial, Gaudi 3. La compañía dice que el chip Gaudi 3 tiene más del doble de eficiencia energética que la GPU H100 de Nvidia y puede ejecutar modelos de IA uno y otro. la mitad de veces más rápido.

"La innovación avanza a un ritmo sin precedentes, todo ello gracias al silicio, y todas las empresas se están convirtiendo rápidamente en empresas de inteligencia artificial", dijo el director ejecutivo de Intel, Pat Gelsinger, en un comunicado. ambiental. “Intel está llevando la IA a todas partes de la empresa, desde la PC hasta el centro de datos y el borde.

🔎

_🔥🔥🔥_

****🤖****— Mundía Brian (@Mundia_Brian_) Abril 9, 2024

Gelsinger no dijo cuánto costaría Gaudí 3, Bloomberg informes, pero dijo que los llamados chips aceleradores de su compañía estarían "muy por debajo" del costo de los chips actuales y futuros de Nvidia. Ofrecerán un coste total de propiedad "extremadamente bueno", añadió.

Intel afirma que su último chip supondrá “un salto significativo” en el entrenamiento e inferencia de IA para las entidades que trabajan en IA generativa. Las empresas que entrenan sistemas de IA necesitan que sean capaces de hacer predicciones en respuesta a preguntas reales, lo que se conoce como inferencia.

Según Intel, Gaudi 3 será más rápido y más eficiente energéticamente que el H100, y todos los modelos de lenguajes grandes entrenados usando la GPU como Meta's Llama o el multilingüe Falcon de Abu Dhabì. Dijo que el chip puede ayudar a entrenar modelos como Stable Diffusion o Whisper de OpenAI, para el reconocimiento de voz.

La compañía dice que en este tipo de capacitaciones, Gaudi 3 es 1.7 veces más rápido y 1.5 veces mejor ejecutando el software. El rendimiento del chip AI es comparable al del nuevo B200 de Nvidia, dijo Intel, sobresaliendo en algunas áreas y rezagado en otras.

Intel dijo que los nuevos chips Gaudi 3 estarían disponibles para los clientes en el tercer trimestre, y empresas como Supermicro, Dell y HP construirán sistemas con el acelerador de IA.

Desafiando a Nvidia

Las empresas que están construyendo sistemas de IA generativa buscan reducir los costos dejando de depender de las GPU de Nvidia, que son costosas.

En 2023, Amazon gastó alrededor de 65 millones de dólares en una sola ejecución de capacitación, según el ingeniero de software James Hamilton. Espera que esa cifra supere pronto los mil millones de dólares.

Hace una semana, OpenAI y Microsoft revelado planea construir un centro de datos de 100 mil millones de dólares para el entrenamiento de IA denominado 'Stargate'. Y en enero, el director ejecutivo de Meta, Mark Zuckerberg, dijo que su empresa planea gastar 9 millones de dólares sólo en GPU de Nvidia.

Todas las principales empresas de tecnología compran chips de Nvidia, pero también han comenzado a construir los suyos propios o a comprarlos a AMD, que introdujo una nueva GPU para centros de datos llamada MI300X el año pasado. AMD planea expandirse y vender más chips de inteligencia artificial para servidores este año.

Los competidores de Google, Microsoft, Meta [ambos clientes de AMD] y Amazon, también han desarrollado sus propios chips de IA. Sin embargo, no será fácil. A principios de este año, Nvidia lanzó sus GPU B100 y B200, sucesoras de la H100, que prometen mejoras de rendimiento. Se espera que los chips comiencen a enviarse más adelante en 2024.

El auge de la IA y el H100 ayudaron a duplicarse Los ingresos de Nvidia y elevar su valoración de mercado a más de 2 billones de dólares, convirtiéndola en una de las empresas más exitosas de Wall Street.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://metanews.com/google-and-intel-launch-own-ai-chips-as-nvidia-rivalry-heats-up/

- :es

- :no

- 1 millones de dólares

- 65 millones de dólares

- $ 9 Mil Millones

- $ UP

- 1

- 12

- 2023

- 2024

- 7

- 800

- 9

- a

- Poder

- acelerador

- Conforme

- a través de

- adicional

- avanzado

- avances

- seguir

- .

- AI

- Modelos AI

- Sistemas de IA

- Entrenamiento de IA

- objetivo

- Todos

- solo

- junto al

- también

- Amazon

- AMD

- an

- y

- anunció

- Anunciando

- somos

- áreas

- ARM

- en torno a

- artificial

- inteligencia artificial

- AS

- At

- Hoy Disponibles

- BE

- cada vez

- detrás de

- entre bastidores

- mejores

- mil millones

- informe de Bloomberg

- auge

- empujón

- ambas

- Brian

- llevar

- Trayendo

- build

- Construir la

- construido

- pero

- comprar

- by

- , que son

- PUEDEN

- Reubicación

- Centros

- central

- ceo

- Reto

- Chatbots

- ChatGPT

- chip

- Papas fritas

- reclamaciones

- Soluciones

- Empresas

- compañía

- De la empresa

- comparable

- competidores

- contenido

- Cost

- Precio

- Current

- personalizado

- Clientes

- corte

- datos

- Data Center

- los centros de datos

- Datacenter

- Diciembre

- entregamos

- entrega

- Dell

- dependiente

- diseñado

- desarrollado

- desarrolladores

- HIZO

- Difusión

- interrumpe

- doble

- DE INSCRIPCIÓN

- doblado

- Más temprano

- de forma sencilla

- Southern Implants

- integrado

- facilita

- ingeniero

- Empresa

- entidades

- Evento

- Cada

- en todas partes

- Expandir

- esperado

- espera

- costoso

- más rápida

- más rápido

- Figura

- Firme

- empresas

- Nombre

- Desde

- futuras

- Ganancias

- Gemini

- General

- propósito general

- generación de AHSS

- generativo

- IA generativa

- Buscar

- va

- Google Cloud

- De Google

- GPU

- GPU

- gráficos

- Hamilton

- encargarse de

- Tienen

- he

- ayuda

- ayudado

- Alta

- su

- Cómo

- Sin embargo

- HTTPS

- Bujes

- in

- Incluye

- energético

- Intel

- Intelligence

- Intensifica

- Introducido

- IT

- SUS

- james

- Enero

- jpg

- solo

- conocido

- idioma

- large

- LAS

- Las Vegas

- Apellido

- El año pasado

- luego

- más reciente

- lanzamiento

- lanzado

- como

- Llama

- mirando

- Lote

- gran

- para lograr

- Realizar

- marca

- Mark Zuckerberg

- Mercado

- max-ancho

- Medios

- Meta

- Microsoft

- millones

- modelos

- más,

- MEJOR DE TU

- mucho más

- ¿ Necesita ayuda

- Nuevo

- ahora

- Nvidia

- of

- LANZAMIENTO

- Viejo

- on

- ONE

- OpenAI

- Operaciones

- or

- Otro

- Otros

- Más de

- EL DESARROLLADOR

- propiedad

- Paz

- PC

- actuación

- jubilación

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- industria

- alimentado

- predecesor

- Predicciones

- tratamiento

- Procesador

- prometedor

- proporciona un

- propósito

- terremoto

- Trimestre

- Preguntas

- con rapidez

- Carrera

- en comunicarse

- Leer

- real

- reconocimiento

- liberado

- confiando

- respuesta

- Revelado

- rivalidad

- rivales

- Ejecutar

- correr

- Said

- mismo

- dice

- Escenas

- Búsquedas

- venta

- Semiconductores

- ayudar

- Servidores

- Envíos

- mostró

- importante

- Silicio

- soltero

- Software

- Ingeniero de Software

- algo

- pronto

- habla

- Reconocimiento de voz

- pasar

- gastado

- estable

- comienzo

- fundó

- Estado

- Sin embargo

- calle

- exitosos

- tal

- Sundar Pichai

- supercomputadora

- suministros

- Todas las funciones a su disposición

- tareas

- tecnología

- Tecnología

- que

- esa

- El

- su

- Les

- sí mismos

- Estas

- ellos

- Código

- así

- este año

- Tres

- rendimiento

- veces

- a

- Total

- Entrenar

- entrenado

- Formación

- en prevencion

- Trillones

- verdadero

- Martes

- Twice

- tipo

- Uk

- unidad

- unidades que

- sin precedentes

- dio a conocer

- actualizado

- us

- usando

- Valuación

- diversos

- VEGAS

- versión

- Pared

- Wall Street

- semana

- WELL

- que

- Susurro

- seguirá

- trabajando

- se

- año

- aún

- Youtube

- zephyrnet

- Zuckerberg