Hoy, nos complace anunciar que los modelos básicos de Llama 2 desarrollados por Meta están disponibles para los clientes a través de JumpStart de Amazon SageMaker. La familia Llama 2 de modelos de lenguaje extenso (LLM) es una colección de modelos de texto generativo pre-entrenados y ajustados que varían en escala de 7 mil millones a 70 mil millones de parámetros. Los LLM ajustados, llamados Llama-2-chat, están optimizados para casos de uso de diálogo. Puede probar fácilmente estos modelos y usarlos con SageMaker JumpStart, que es un centro de aprendizaje automático (ML) que brinda acceso a algoritmos, modelos y soluciones de ML para que pueda comenzar rápidamente con ML.

En esta publicación, explicamos cómo usar los modelos Llama 2 a través de SageMaker JumpStart.

¿Qué es Llama 2?

Llama 2 es un modelo de lenguaje autorregresivo que utiliza una arquitectura de transformador optimizada. Llama 2 está diseñado para uso comercial y de investigación en inglés. Viene en una variedad de tamaños de parámetros: 7 mil millones, 13 mil millones y 70 mil millones, así como variaciones preentrenadas y ajustadas. Según Meta, las versiones ajustadas utilizan ajuste fino supervisado (SFT) y aprendizaje reforzado con retroalimentación humana (RLHF) para alinearse con las preferencias humanas en cuanto a utilidad y seguridad. Llama 2 fue entrenado previamente en 2 billones de tokens de datos de fuentes disponibles públicamente. Los modelos ajustados están destinados a un chat similar al de un asistente, mientras que los modelos previamente entrenados se pueden adaptar para una variedad de tareas de generación de lenguaje natural. Independientemente de la versión del modelo que utilice un desarrollador, el guía de uso responsable de Meta puede ayudar a guiar los ajustes adicionales que pueden ser necesarios para personalizar y optimizar los modelos con las mitigaciones de seguridad adecuadas.

¿Qué es SageMaker JumpStart?

Con SageMaker JumpStart, los profesionales de ML pueden elegir entre una amplia selección de modelos básicos de código abierto. Los profesionales de ML pueden implementar modelos de base para dedicados Amazon SageMaker instancias de un entorno de red aislado y personalice los modelos con SageMaker para el entrenamiento y la implementación de modelos.

Ahora puedes descubrir e implementar Llama 2 con unos pocos clics en Estudio Amazon SageMaker o programáticamente a través de SageMaker Python SDK, lo que le permite derivar el rendimiento del modelo y los controles de MLOps con funciones de SageMaker como Canalizaciones de Amazon SageMaker, Depurador de Amazon SageMakero registros de contenedores. El modelo se implementa en un entorno seguro de AWS y bajo los controles de su VPC, lo que ayuda a garantizar la seguridad de los datos. Los modelos Llama 2 están disponibles hoy en Amazon SageMaker Studio, inicialmente en us-east 1 y us-west 2 regiones.

Descubre modelos

Puede acceder a los modelos básicos a través de SageMaker JumpStart en la interfaz de usuario de SageMaker Studio y SageMaker Python SDK. En esta sección, repasaremos cómo descubrir los modelos en SageMaker Studio.

SageMaker Studio es un entorno de desarrollo integrado (IDE) que proporciona una única interfaz visual basada en web donde puede acceder a herramientas especialmente diseñadas para realizar todos los pasos de desarrollo de ML, desde la preparación de datos hasta la creación, capacitación e implementación de sus modelos de ML. Para obtener más detalles sobre cómo comenzar y configurar SageMaker Studio, consulte Estudio Amazon SageMaker.

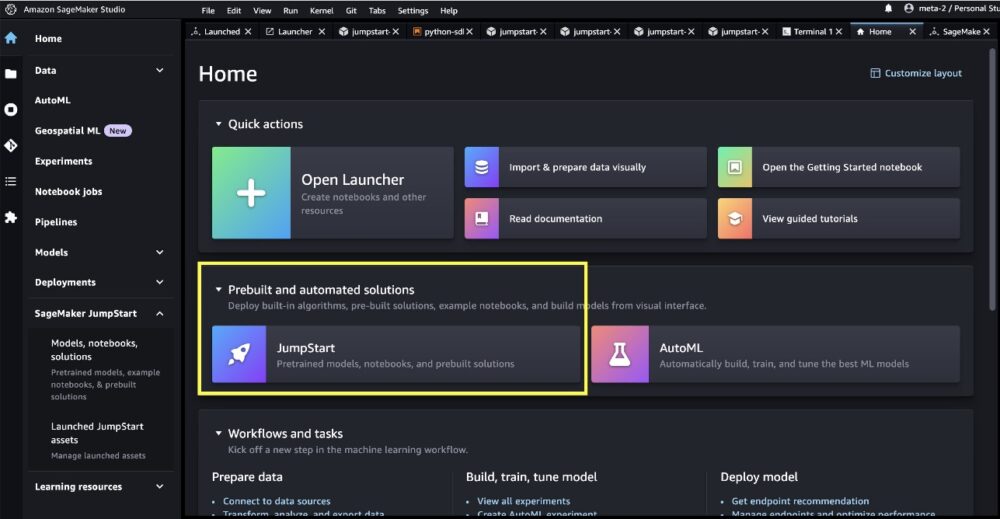

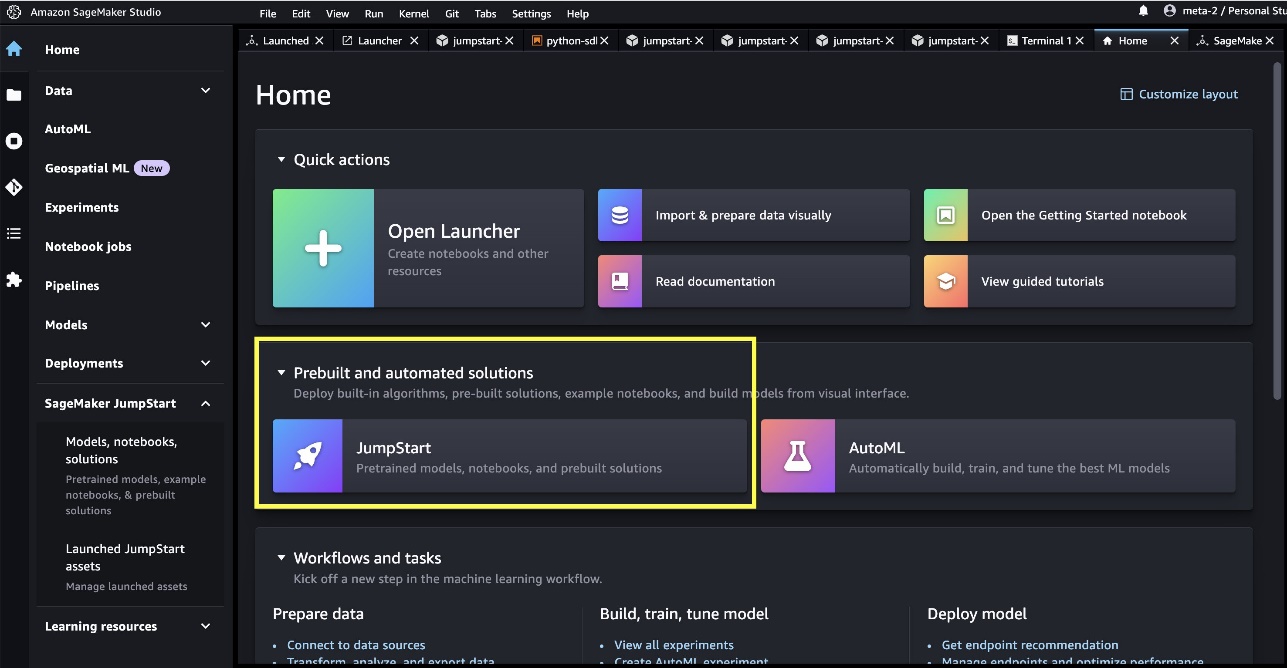

Una vez que esté en SageMaker Studio, puede acceder a SageMaker JumpStart, que contiene modelos preentrenados, cuadernos y soluciones prediseñadas, en Soluciones preconstruidas y automatizadas.

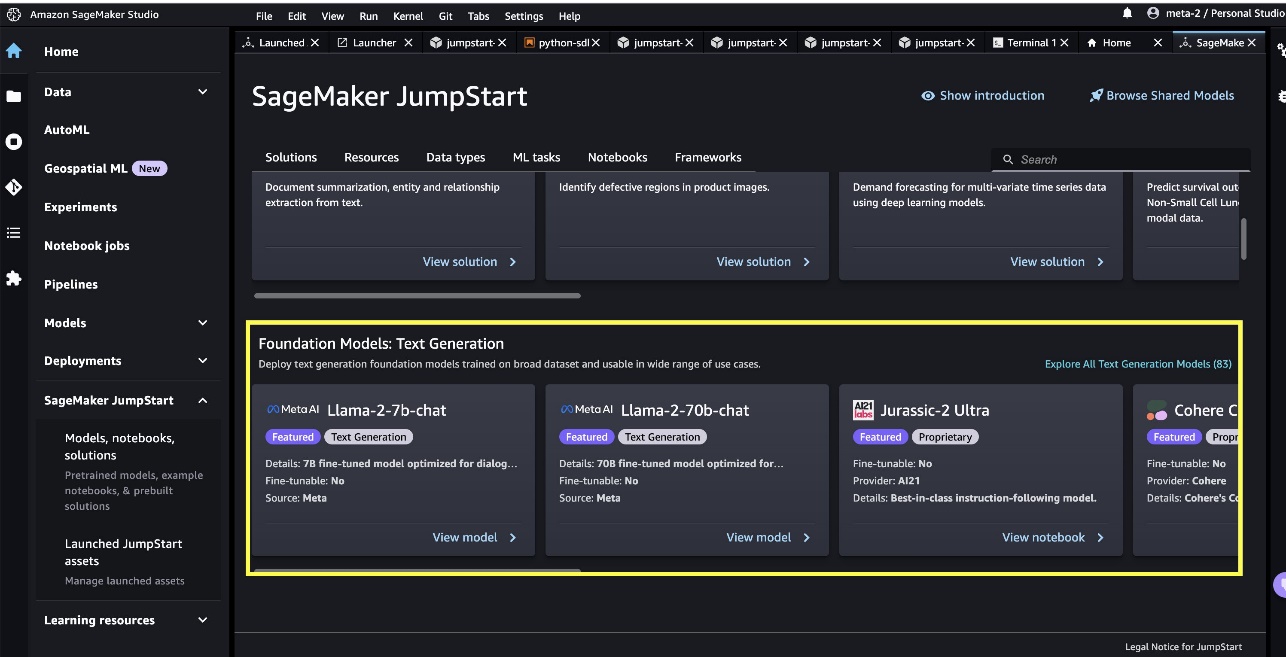

Desde la página de inicio de SageMaker JumpStart, puede buscar soluciones, modelos, cuadernos y otros recursos. Puedes encontrar dos modelos emblemáticos de Llama 2 en el Modelos de cimentación: Generación de texto carrusel. Si no ve los modelos Llama 2, actualice su versión de SageMaker Studio apagando y reiniciando. Para obtener más información acerca de las actualizaciones de versión, consulte Cierre y actualice las aplicaciones de Studio.

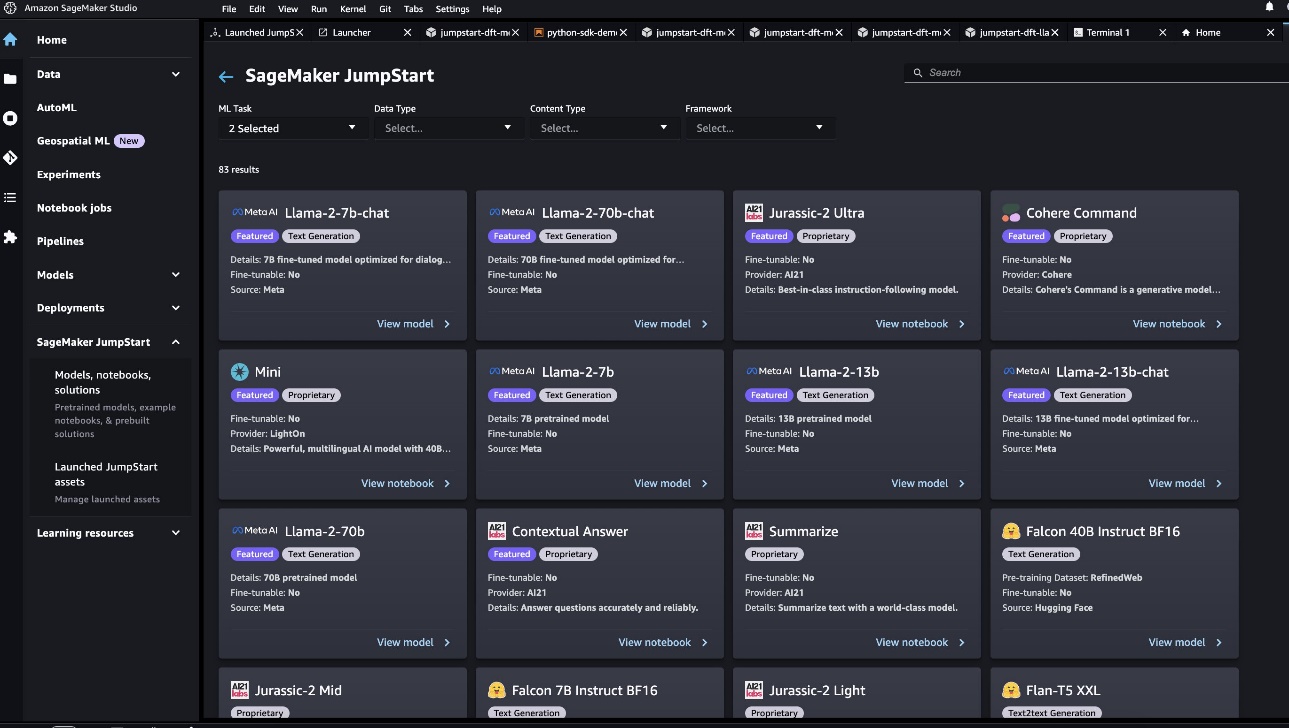

También puede encontrar otras cuatro variantes de modelo eligiendo Explore todos los modelos de generación de texto o buscando llama en el cuadro de búsqueda.

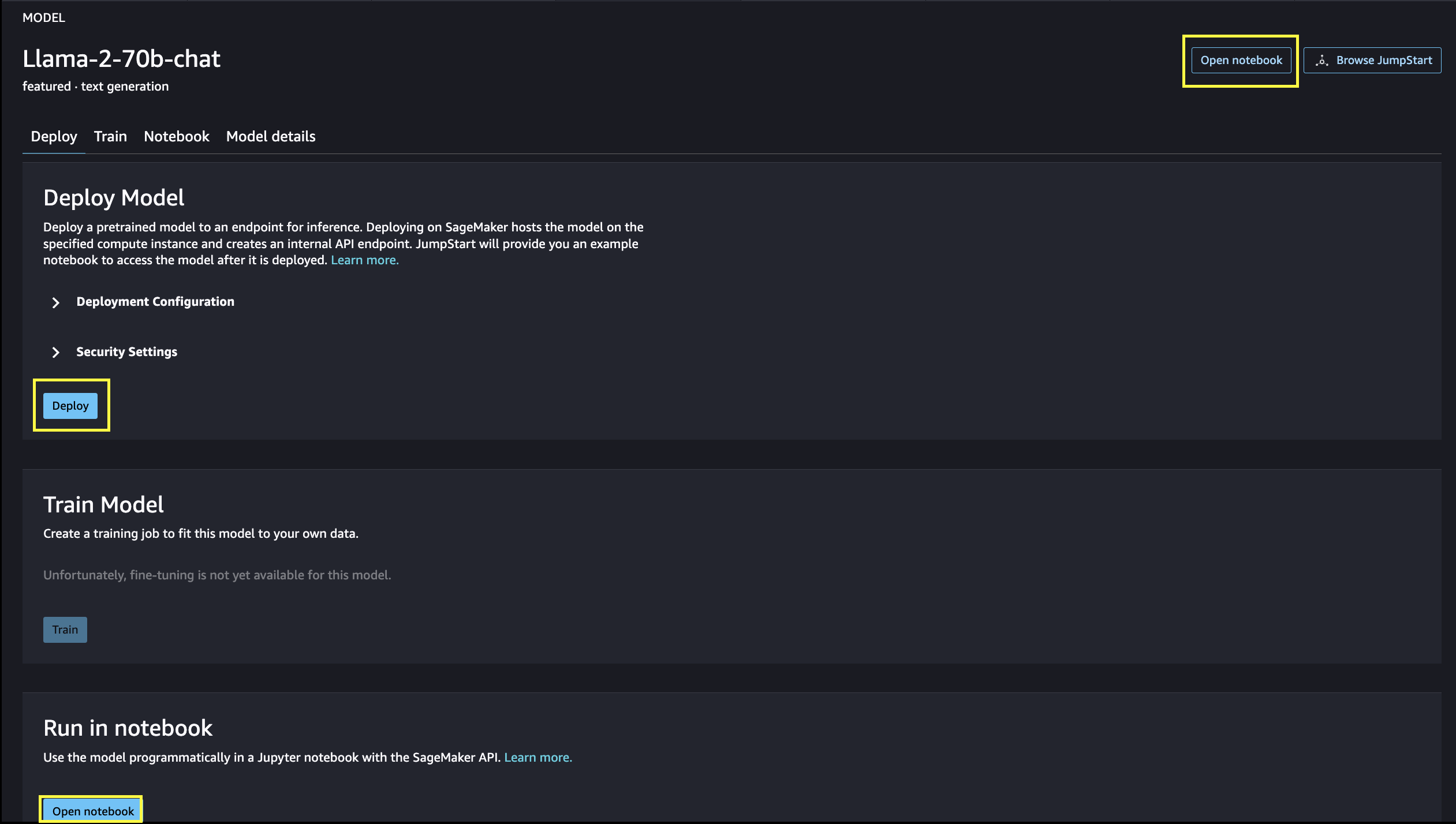

Puede elegir la tarjeta de modelo para ver detalles sobre el modelo, como la licencia, los datos utilizados para entrenar y cómo usarlo. También puedes encontrar dos botones, Despliegue y cuaderno abierto, que le ayudan a utilizar el modelo.

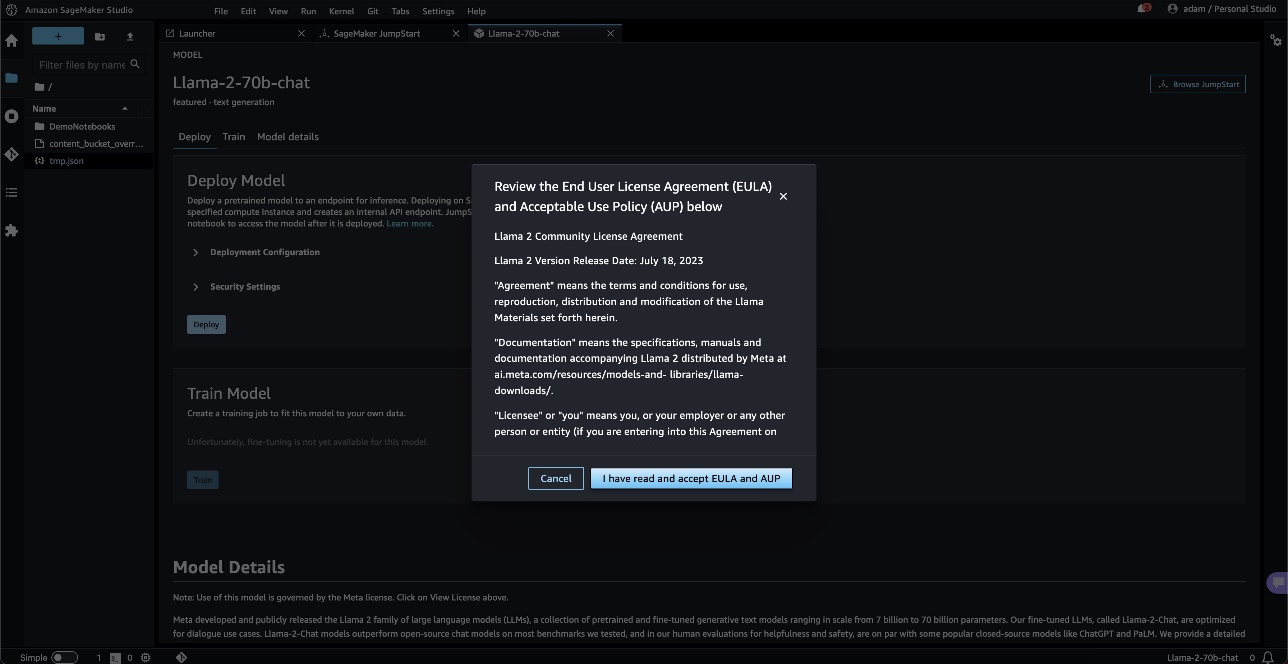

Cuando elige cualquiera de los botones, una ventana emergente mostrará el acuerdo de licencia de usuario final y la política de uso aceptable para que usted lo reconozca.

Al reconocer, continuará con el siguiente paso para usar el modelo.

Implementar un modelo

Cuando tu elijas Despliegue y reconoce los términos, comenzará la implementación del modelo. Alternativamente, puede implementar a través del cuaderno de ejemplo que aparece eligiendo cuaderno abierto. El cuaderno de ejemplo proporciona una guía integral sobre cómo implementar el modelo para la inferencia y la limpieza de recursos.

Para implementar usando una computadora portátil, comenzamos seleccionando un modelo apropiado, especificado por el model_id. Puede implementar cualquiera de los modelos seleccionados en SageMaker con el siguiente código:

Esto implementa el modelo en SageMaker con configuraciones predeterminadas, incluido el tipo de instancia predeterminado y las configuraciones de VPC predeterminadas. Puede cambiar estas configuraciones especificando valores no predeterminados en JumpStartModelo. Una vez implementado, puede ejecutar la inferencia en el extremo implementado a través del predictor de SageMaker:

Los modelos de chat ajustados (Llama-2-7b-chat, Llama-2-13b-chat, Llama-2-70b-chat) aceptan un historial de chat entre el usuario y el asistente de chat, y generan el chat posterior. Los modelos preentrenados (Llama-2-7b, Llama-2-13b, Llama-2-70b) requieren un indicador de cadena y completan el texto en el indicador proporcionado. Ver el siguiente código:

Tenga en cuenta que, de forma predeterminada, accept_eula se establece en falso. Necesitas configurar accept_eula=true para invocar el punto final con éxito. Al hacerlo, acepta el acuerdo de licencia de usuario y la política de uso aceptable como se mencionó anteriormente. Tú también puedes descargar el acuerdo de licencia.

Custom_attributes utilizados para aprobar EULA son pares clave/valor. La clave y el valor están separados por = y los pares están separados por ;. Si el usuario pasa la misma clave más de una vez, el último valor se conserva y se pasa al controlador del script (es decir, en este caso, se usa para la lógica condicional). Por ejemplo, si accept_eula=false; accept_eula=true se pasa al servidor, entonces accept_eula=true se guarda y se pasa al controlador de secuencias de comandos.

Los parámetros de inferencia controlan el proceso de generación de texto en el punto final. El control máximo de tokens nuevos se refiere al tamaño de la salida generada por el modelo. Tenga en cuenta que esto no es lo mismo que el número de palabras porque el vocabulario del modelo no es el mismo que el vocabulario del idioma inglés, y cada token puede no ser una palabra del idioma inglés. La temperatura controla la aleatoriedad en la salida. Una temperatura más alta da como resultado resultados más creativos y alucinados. Todos los parámetros de inferencia son opcionales.

La siguiente tabla enumera todos los modelos de Llama disponibles en SageMaker JumpStart junto con el model_ids, tipos de instancia predeterminados y la cantidad máxima de tokens totales (suma de la cantidad de tokens de entrada y la cantidad de tokens generados) admitidos para cada uno de estos modelos.

| Nombre de Modelo | Modelo ID | Fichas totales máximas | Tipo de instancia predeterminado |

| Llama-2-7b | meta-generación de texto-llama-2-7b | 4096 | ml.g5.2xgrande |

| llama-2-7b-chat | meta-generación-de-texto-llama-2-7b-f | 4096 | ml.g5.2xgrande |

| Llama-2-13b | meta-generación de texto-llama-2-13b | 4096 | ml.g5.12xgrande |

| llama-2-13b-chat | meta-generación-de-texto-llama-2-13b-f | 4096 | ml.g5.12xgrande |

| Llama-2-70b | meta-generación de texto-llama-2-70b | 4096 | ml.g5.48xgrande |

| llama-2-70b-chat | meta-generación-de-texto-llama-2-70b-f | 4096 | ml.g5.48xgrande |

Tenga en cuenta que los extremos de SageMaker tienen un límite de tiempo de espera de 60 s. Por lo tanto, aunque el modelo pueda generar tokens 4096, si la generación de texto demora más de 60 segundos, la solicitud fallará. Para los modelos 7B, 13B y 70B, recomendamos configurar max_new_tokens no más de 1500, 1000 y 500 respectivamente, manteniendo el número total de tokens por debajo de 4K.

Indicaciones de inferencia y ejemplo para Llama-2-70b

Puede usar modelos Llama para completar texto para cualquier parte del texto. A través de la generación de texto, puede realizar una variedad de tareas, como responder preguntas, traducir idiomas, analizar opiniones y muchas más. La carga útil de entrada al punto final se parece al siguiente código:

Los siguientes son algunos ejemplos de indicaciones y el texto generado por el modelo. Todas las salidas se generan con parámetros de inferencia {"max_new_tokens":256, "top_p":0.9, "temperature":0.6}.

En el siguiente ejemplo, mostramos cómo usar modelos Llama con aprendizaje en contexto de pocas tomas, donde proporcionamos muestras de capacitación disponibles para el modelo. Tenga en cuenta que solo hacemos inferencias en el modelo implementado y durante este proceso, los pesos del modelo no cambian.

Indicaciones de inferencia y ejemplo para Llama-2-70b-chat

Con los modelos Llama-2-Chat, que están optimizados para casos de uso de diálogo, la entrada a los puntos finales del modelo de chat es el historial anterior entre el asistente de chat y el usuario. Puede hacer preguntas contextuales a la conversación que ha tenido lugar hasta el momento. También puede proporcionar la configuración del sistema, como personas que definen el comportamiento del asistente de chat. La carga útil de entrada al punto final se parece al siguiente código:

Los siguientes son algunos ejemplos de indicaciones y el texto generado por el modelo. Todas las salidas se generan con los parámetros de inferencia {"max_new_tokens": 512, "top_p": 0.9, "temperature": 0.6}.

En el siguiente ejemplo, el usuario ha tenido una conversación con el asistente sobre sitios turísticos en París. A continuación, el usuario pregunta sobre la primera opción recomendada por el asistente de chat.

En los siguientes ejemplos, establecemos la configuración del sistema:

Limpiar

Una vez que haya terminado de ejecutar el cuaderno, asegúrese de eliminar todos los recursos para que todos los recursos que creó en el proceso se eliminen y se detenga su facturación:

Conclusión

En esta publicación, le mostramos cómo comenzar con los modelos Llama 2 en SageMaker Studio. Con esto, tienes acceso a seis modelos básicos de Llama 2 que contienen miles de millones de parámetros. Debido a que los modelos básicos están preentrenados, también pueden ayudar a reducir los costos de capacitación e infraestructura y permitir la personalización para su caso de uso. Para comenzar con SageMaker JumpStart, visite los siguientes recursos:

Sobre los autores

junio ganó es gerente de producto en SageMaker JumpStart. Se enfoca en hacer que los modelos básicos sean fácilmente detectables y utilizables para ayudar a los clientes a crear aplicaciones de IA generativa. Su experiencia en Amazon también incluye la aplicación de compras móviles y la entrega de última milla.

junio ganó es gerente de producto en SageMaker JumpStart. Se enfoca en hacer que los modelos básicos sean fácilmente detectables y utilizables para ayudar a los clientes a crear aplicaciones de IA generativa. Su experiencia en Amazon también incluye la aplicación de compras móviles y la entrega de última milla.

Dr. Vivek Madan es un científico aplicado del equipo JumpStart de Amazon SageMaker. Obtuvo su doctorado en la Universidad de Illinois en Urbana-Champaign y fue investigador posdoctoral en Georgia Tech. Es un investigador activo en aprendizaje automático y diseño de algoritmos y ha publicado artículos en conferencias EMNLP, ICLR, COLT, FOCS y SODA.

Dr. Vivek Madan es un científico aplicado del equipo JumpStart de Amazon SageMaker. Obtuvo su doctorado en la Universidad de Illinois en Urbana-Champaign y fue investigador posdoctoral en Georgia Tech. Es un investigador activo en aprendizaje automático y diseño de algoritmos y ha publicado artículos en conferencias EMNLP, ICLR, COLT, FOCS y SODA.  Dr.Kyle Ulrich es un científico aplicado del equipo JumpStart de Amazon SageMaker. Sus intereses de investigación incluyen algoritmos escalables de aprendizaje automático, visión artificial, series temporales, no paramétricos bayesianos y procesos gaussianos. Su doctorado es de la Universidad de Duke y ha publicado artículos en NeurIPS, Cell y Neuron.

Dr.Kyle Ulrich es un científico aplicado del equipo JumpStart de Amazon SageMaker. Sus intereses de investigación incluyen algoritmos escalables de aprendizaje automático, visión artificial, series temporales, no paramétricos bayesianos y procesos gaussianos. Su doctorado es de la Universidad de Duke y ha publicado artículos en NeurIPS, Cell y Neuron.  Dr. Ashish Khetan es un científico aplicado sénior de Amazon SageMaker JumpStart y ayuda a desarrollar algoritmos de aprendizaje automático. Obtuvo su doctorado en la Universidad de Illinois Urbana-Champaign. Es un investigador activo en aprendizaje automático e inferencia estadística, y ha publicado muchos artículos en conferencias NeurIPS, ICML, ICLR, JMLR, ACL y EMNLP.

Dr. Ashish Khetan es un científico aplicado sénior de Amazon SageMaker JumpStart y ayuda a desarrollar algoritmos de aprendizaje automático. Obtuvo su doctorado en la Universidad de Illinois Urbana-Champaign. Es un investigador activo en aprendizaje automático e inferencia estadística, y ha publicado muchos artículos en conferencias NeurIPS, ICML, ICLR, JMLR, ACL y EMNLP.  Sundar Ranganatán es el director global de especialistas de GenAI/Frameworks GTM en AWS. Se enfoca en desarrollar la estrategia GTM para modelos de lenguajes grandes, GenAI y cargas de trabajo de ML a gran escala en servicios de AWS como Amazon EC2, EKS, EFA, AWS Batch y Amazon SageMaker. Su experiencia incluye roles de liderazgo en gestión y desarrollo de productos en NetApp, Micron Technology, Qualcomm y Mentor Graphics.

Sundar Ranganatán es el director global de especialistas de GenAI/Frameworks GTM en AWS. Se enfoca en desarrollar la estrategia GTM para modelos de lenguajes grandes, GenAI y cargas de trabajo de ML a gran escala en servicios de AWS como Amazon EC2, EKS, EFA, AWS Batch y Amazon SageMaker. Su experiencia incluye roles de liderazgo en gestión y desarrollo de productos en NetApp, Micron Technology, Qualcomm y Mentor Graphics.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Automoción / vehículos eléctricos, Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- Desplazamientos de bloque. Modernización de la propiedad de compensaciones ambientales. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/llama-2-foundation-models-from-meta-are-now-available-in-amazon-sagemaker-jumpstart/

- :posee

- :es

- :no

- :dónde

- $ UP

- 1

- 10

- 100

- 11

- 13

- 15%

- 17

- 19

- 20

- 30

- 31

- 33

- Grado 360

- 40

- 4k

- 500

- 7

- 70

- 8

- 9

- a

- Poder

- Nuestra Empresa

- Aceptar

- aceptable

- de la máquina

- accesibilidad

- accesible

- Conforme

- reconocer

- a través de

- lector activo

- add

- la adición de

- Adicionales

- dirección

- Después

- de nuevo

- en contra

- Agreement

- AI

- algoritmo

- algoritmos

- alinear

- Todos

- permitir

- a lo largo de

- también

- hacerlo

- am

- Amazon

- Amazon EC2

- Amazon SageMaker

- JumpStart de Amazon SageMaker

- Estudio Amazon SageMaker

- Amazon Web Services

- American

- an

- análisis

- y

- e infraestructura

- Anunciar

- Otra

- https://www.youtube.com/watch?v=xB-eutXNUMXJtA&feature=youtu.be

- cualquier

- nadie

- Aplicación

- aplicaciones

- aplicada

- apreciar

- adecuado

- Arco

- arquitectura

- somos

- Arte

- AS

- ayudar

- Legal

- At

- Atmósfera

- atracciones

- Confirmación de Viaje

- Hoy Disponibles

- AWS

- Banana

- básica

- Batalla

- Bayesiano

- BE

- hermosos

- Beauty

- se convirtió en

- porque

- a las que has recomendado

- esto

- cerveza

- antes

- comportamiento

- Beijing

- CREEMOS

- creído

- MEJOR

- entre

- facturación

- mil millones

- miles de millones

- Negro

- Box

- Descanso

- asombrosos

- general

- build

- Construir la

- construido

- pero

- .

- by

- , que son

- PUEDEN

- capital

- de

- tarjeta

- carrusel

- case

- cases

- CAT

- el cambio

- Chocolate

- Elige

- la elección de

- Ciudad

- clásico

- código

- --

- combinado

- combina

- proviene

- viniendo

- completo

- compañía

- terminación

- computadora

- Visión por computador

- conferencias

- seguros

- Configuración

- considerado

- constante

- construcción

- que no contengo

- Envase

- contiene

- contenido

- contextual

- continue

- continuamente

- control

- controles

- Conveniente

- Conversación

- Precio

- país

- valor

- Protectora

- Para crear

- creado

- Estudio

- cultural

- Cultura

- Vaso

- Clientes

- personalización

- personalizan

- datos

- seguridad de datos

- a dedicados

- "consagración"

- Predeterminado

- definir

- entrega

- desplegar

- desplegado

- Desplegando

- despliegue

- despliega

- Diseño

- diseñado

- deseado

- destino

- destinos

- detalles

- desarrollar

- desarrollado

- Developer

- el desarrollo

- Desarrollo

- Diálogo

- un cambio

- una experiencia diferente

- difícil

- descrubrir

- distintivo

- do

- documentales

- "Hacer"

- hecho

- No

- duplicado

- DE INSCRIPCIÓN

- Duque

- duke university

- durante

- e

- cada una

- Más temprano

- pasan fácilmente

- de forma sencilla

- Edward

- Einstein

- ya sea

- habilitar

- permitiendo

- final

- de extremo a extremo

- Punto final

- Ingeniería

- Inglés

- disfrutando

- suficientes

- garantizar

- Entorno

- equipo

- Éter

- Incluso

- Eventos

- todos

- ejemplo

- ejemplos

- excitado

- experience

- experimento

- experimentos

- expreso

- FALLO

- Fallidos

- feria

- false

- familia

- famoso

- muchos

- hazaña

- destacado

- Caracteristicas

- realimentación

- Pies

- pocos

- films

- final

- Finalmente

- Encuentre

- Nombre

- buque insignia

- Flotador

- Flujos

- se centra

- siguiendo

- adelante

- encontrado

- Fundación

- Digital XNUMXk

- Francia

- Francés

- Desde

- completamente

- promover

- futuras

- General

- generar

- generado

- generación de AHSS

- generativo

- IA generativa

- Georgia

- obtener

- Donar

- vaso

- Buscar

- Go

- va

- gráficos

- maravillosa

- mayor

- innovador

- Crecer

- guía

- guía

- tenido

- Manijas

- pasó

- Ahorrar

- Difícil

- intenso trabajo

- Tienen

- es

- he

- cabeza

- ayuda

- ayudando

- ayuda

- esta página

- hi

- Alta

- más alto

- su

- histórico

- historia

- viviendas

- Cómo

- Como Hacer

- HTML

- HTTPS

- Bujes

- humana

- i

- icónico

- idea

- if

- ii

- Illinois

- Impacto

- importar

- importante

- impresionante

- in

- incluir

- incluye

- Incluye

- Incorporado

- información

- EN LA MINA

- posiblemente

- Las opciones de entrada

- inspirado

- motivarnos

- ejemplo

- instantáneamente

- Instrucciones

- COMPLETAMENTE

- Destinado a

- intereses

- Interfaz

- dentro

- aislado

- IT

- SUS

- jpg

- solo

- acuerdo

- mantenido

- Clave

- Tipo

- Saber

- conocido

- aterrizaje

- marca

- idioma

- large

- Gran escala

- mayor

- Apellido

- Tarde

- lanzamiento

- leyes

- Liderazgo

- APRENDE:

- Aprende y crece

- aprendizaje

- menos

- menos

- Licencia

- Vida

- luz

- como

- LIMITE LAS

- Listas

- literatura

- ll

- Llama

- lógica

- Largo

- largo tiempo

- mirando

- MIRADAS

- amar

- ser querido

- inferior

- máquina

- máquina de aprendizaje

- hecho

- para lograr

- HACE

- Realizar

- Management

- gerente

- muchos

- maravilla

- Materia

- máximas

- Puede..

- sentido

- medir

- Medios

- mediano

- mencionado

- mensaje

- Meta

- micrón

- minuto

- Min

- mezcla

- ML

- MLOps

- Móvil

- modelo

- modelos

- momento

- meses

- más,

- MEJOR DE TU

- Más popular

- movimiento

- película

- mucho más

- museo

- Museos

- Música

- nombre

- Natural

- necesario

- ¿ Necesita ayuda

- del sistema,

- Nuevo

- New York

- Next

- no

- cuaderno

- ahora

- número

- numeroso

- NY

- of

- LANZAMIENTO

- que ofrece

- Ofertas

- Aceite

- on

- una vez

- ONE

- , solamente

- habiertos

- de código abierto

- Optimización

- optimizado

- Optión

- or

- Otro

- Otros

- de otra manera

- nuestros

- salir

- salida

- Más de

- total

- página

- pares

- Papel

- papeles

- parámetro

- parámetros

- París

- parte

- pass

- pasado

- pasa

- pasado

- paz

- Realizar

- actuación

- permanente

- teléfono

- fotografías

- Física

- pieza

- Pizza

- plástico

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- jugado

- política

- ventanas emergentes

- Popular

- Publicación

- postal

- Predictor

- preferencias

- preparación

- presente

- anterior

- en costes

- Producto

- desarrollo de productos

- gestión de producto

- gerente de producto

- Propuestas

- orgullosos

- proporcionar

- previsto

- proporciona un

- proporcionando

- público

- transporte público.

- en público

- publicado

- propósito

- poner

- Python

- Qualcomm

- Preguntas

- Búsqueda

- con rapidez

- Rampas

- aleatoriedad

- distancia

- que van

- ready

- razones

- recepción

- recetas

- recomiendan

- recomendado

- se refiere

- Independientemente

- regiones

- relativo

- relatividad

- repetido

- representar

- solicita

- requiere

- la investigación

- investigador

- Recursos

- respectivamente

- Responder

- RESTO

- resultado

- Resultados

- River

- Función

- También soy miembro del cuerpo docente de World Extreme Medicine (WEM) y embajadora europea de igualdad para The Transformational Travel Council (TTC). En mi tiempo libre, soy una incansable aventurera, escaladora, patrona de día, buceadora y defensora de la igualdad de género en el deporte y la aventura. En XNUMX, fundé Almas Libres, una ONG nacida para involucrar, educar y empoderar a mujeres y niñas a través del deporte urbano, la cultura y la tecnología.

- Ejecutar

- correr

- s

- Safety

- sabio

- sal

- mismo

- escalable

- Escala

- Científico

- los científicos

- Sdk

- MAR

- Buscar

- búsqueda

- Sección

- seguro

- EN LINEA

- ver

- ver

- parecía

- seleccionado

- seleccionar

- selección

- envío

- mayor

- sentimiento

- Serie

- Servicios

- servicio

- set

- pólipo

- Forma

- tiburón

- Compras

- tienes

- Mostrar

- mostró

- Shows

- cerrar

- significado

- importante

- sencillos

- simplemente

- soltero

- página web

- Sitios Web

- SEIS

- Tamaño

- Despacio

- chica

- So

- hasta aquí

- Social

- redes sociales

- Soluciones

- algo

- Fuente

- Fuentes

- especial

- especialistas

- especificado

- velocidad

- es la

- comienzo

- fundó

- Estado

- Zonas

- estadístico

- paso

- pasos

- detenido

- Estrategia

- Cordón

- estructura

- estudio

- Maravillosos

- sujeto

- posterior

- comercial

- Con éxito

- tal

- Soportado

- seguro

- símbolo

- te

- mesa

- ¡Prepárate!

- toma

- tareas

- llaves

- equipo

- tecnología

- Tecnología

- temporal

- términos

- que

- Muchas Gracias

- esa

- La

- La capital

- El futuro de las

- La Fuente

- el mundo

- su

- Les

- teoría

- Ahí.

- Estas

- ellos

- cosas

- pensar

- así

- ¿aunque?

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- Tigre

- equipo

- Series de tiempo

- veces

- Título

- a

- hoy

- juntos

- ficha

- Tokens

- parte superior

- Total

- tower

- Entrenar

- Formación

- transformador

- la traducción

- Traducción

- de transporte

- Trillones

- try

- dos

- tipo

- tipos

- ui

- bajo

- inolvidable para tus asistentes

- único

- universidad

- hasta

- Actualizar

- Actualizaciones

- usable

- utilizan el

- caso de uso

- usado

- Usuario

- usuarios

- usos

- usando

- propuesta de

- Valores

- variedad

- versión

- versiones

- muy

- vía

- Ver

- vistas

- visión

- Visite

- visitantes

- volumen

- deseado

- guerra

- fue

- we

- web

- servicios web

- Basado en la Web

- Página web

- WELL

- Ballena

- ¿

- Que es

- cuando

- mientras

- que

- mientras

- porque

- seguirá

- ventanas

- Palabra

- palabras

- Actividades:

- funciona

- mundo

- de renombre mundial

- envolver

- años

- york

- Usted

- tú

- a ti mismo

- zephyrnet

- Zip