Esta publicación de blog está coescrita con Hwalsuk Lee en Upstage.

Hoy nos complace anunciar que el Solar El modelo de base desarrollado por Upstage ahora está disponible para los clientes que utilizan JumpStart de Amazon SageMaker. Solar es un modelo de lenguaje grande (LLM) 100% pre-entrenado con Amazon SageMaker que supera y utiliza su tamaño compacto y su potente historial para especializarse en capacitación con propósitos específicos, lo que lo hace versátil en todos los idiomas, dominios y tareas.

Ahora puede usar el Minichat solar y Mini Chat Solar – Quant modelos previamente entrenados dentro de SageMaker JumpStart. SageMaker JumpStart es el centro de aprendizaje automático (ML) de SageMaker que brinda acceso a modelos básicos además de algoritmos integrados para ayudarlo a comenzar rápidamente con ML.

En esta publicación, explicamos cómo descubrir e implementar el modelo solar a través de SageMaker JumpStart.

¿Cuál es el modelo Solar?

Solar es un modelo compacto y potente para los idiomas inglés y coreano. Está específicamente optimizado para fines de chat de varios turnos, lo que demuestra un rendimiento mejorado en una amplia gama de tareas de procesamiento del lenguaje natural.

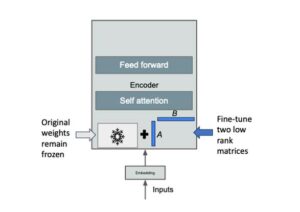

El modelo Solar Mini Chat se basa en Energía solar 10.7 mil millones, con 32 capas llamas 2 estructura, e inicializado con pesos previamente entrenados de Mistral 7B compatible con la arquitectura Llama 2. Este ajuste le otorga la capacidad de manejar conversaciones prolongadas de manera más efectiva, lo que lo hace particularmente apto para aplicaciones interactivas. Emplea un método de escala llamado ampliación de profundidad (DUS), que se compone de escalamiento profundo y entrenamiento previo continuo. DUS permite una ampliación mucho más sencilla y eficiente de modelos más pequeños que otros métodos de escalado como mezcla de expertos (MoE).

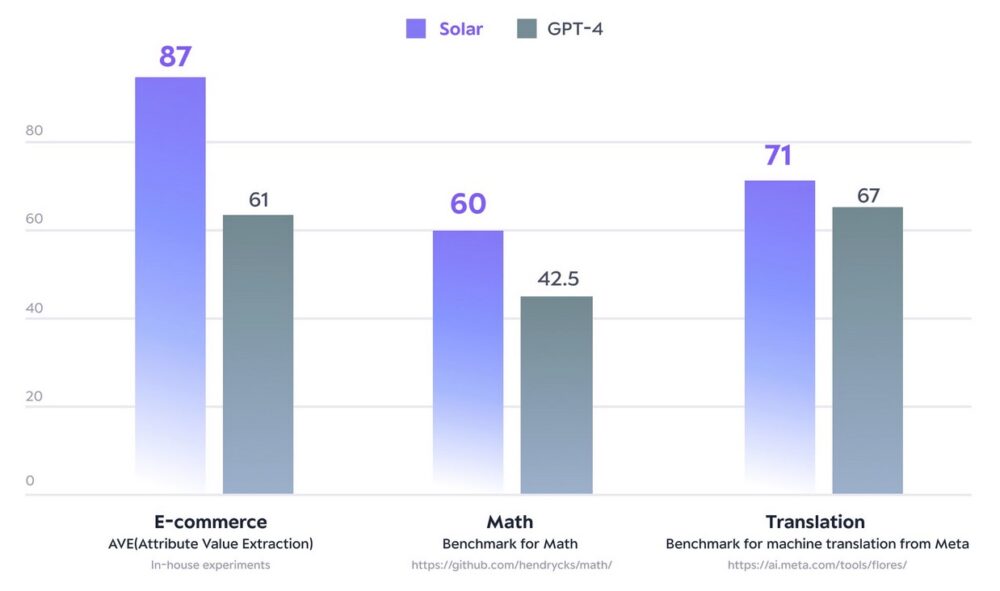

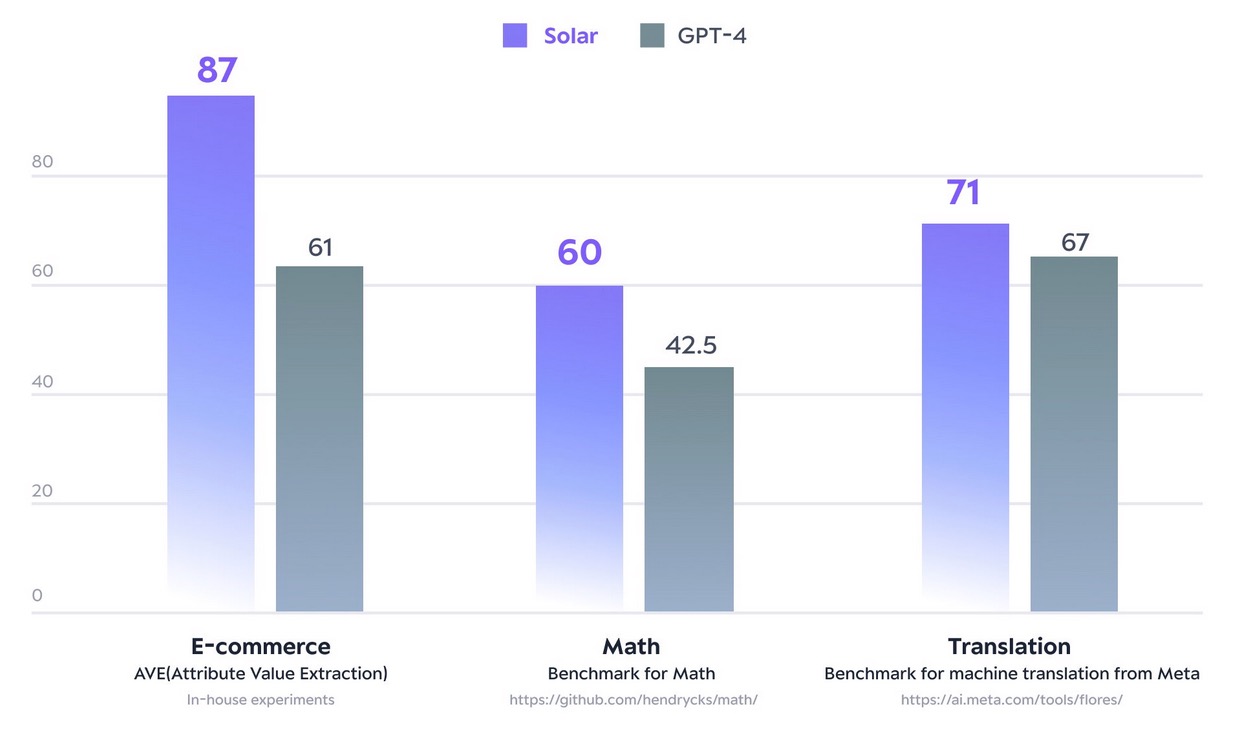

En diciembre de 2023, el modelo Solar 10.7B causó sensación al alcanzar la cima del Tabla de clasificación abierta de LLM de abrazar la cara. Utilizando notablemente menos parámetros, Solar 10.7B ofrece respuestas comparables a GPT-3.5, pero es 2.5 veces más rápido. Además de encabezar la clasificación Open LLM, Solar 10.7B supera a GPT-4 con modelos entrenados específicamente en ciertos dominios y tareas.

La siguiente figura ilustra algunas de estas métricas:

fuente: https://www.upstage.ai/solar-llm

Con SageMaker JumpStart, puede implementar modelos previamente entrenados basados en Solar 10.7B: Solar Mini Chat y una versión cuantificada de Solar Mini Chat, optimizada para aplicaciones de chat en inglés y coreano. El modelo Solar Mini Chat proporciona una comprensión avanzada de los matices del idioma coreano, lo que eleva significativamente las interacciones de los usuarios en entornos de chat. Proporciona respuestas precisas a las entradas de los usuarios, lo que garantiza una comunicación más clara y una resolución de problemas más eficiente en aplicaciones de chat en inglés y coreano.

Comience con los modelos solares en SageMaker JumpStart

Para comenzar con los modelos solares, puede utilizar SageMaker JumpStart, un servicio central de ML totalmente administrado para implementar modelos de ML prediseñados en un entorno alojado listo para producción. Puede acceder a los modelos solares a través de SageMaker JumpStart en Estudio Amazon SageMaker, un entorno de desarrollo integrado (IDE) basado en web donde puede acceder a herramientas diseñadas específicamente para realizar todos los pasos de desarrollo de ML, desde la preparación de datos hasta la creación, el entrenamiento y la implementación de sus modelos de ML.

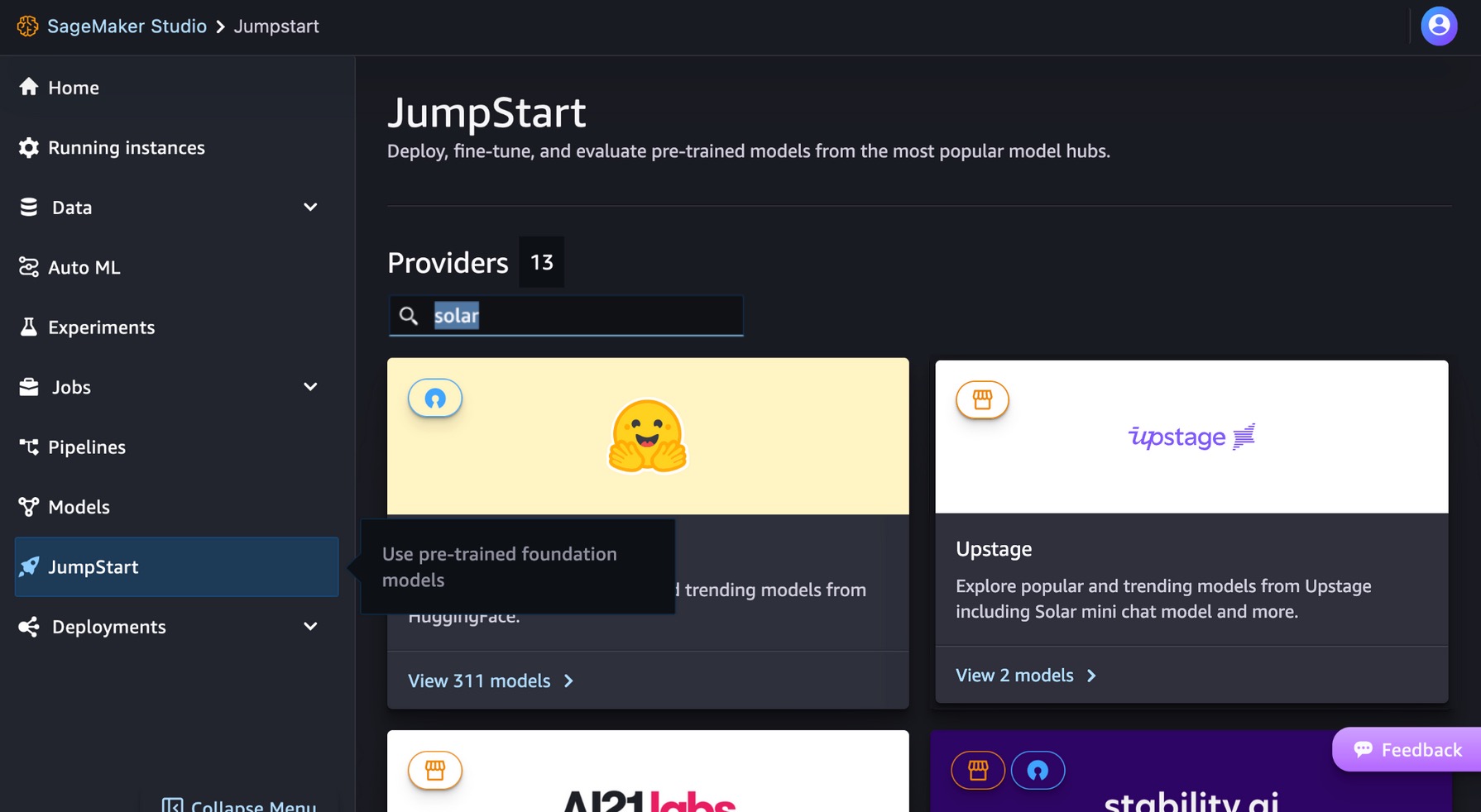

En la consola de SageMaker Studio, elija Buen inicio en el panel de navegación. Puede ingresar "solar" en la barra de búsqueda para encontrar los modelos solares de Upstage.

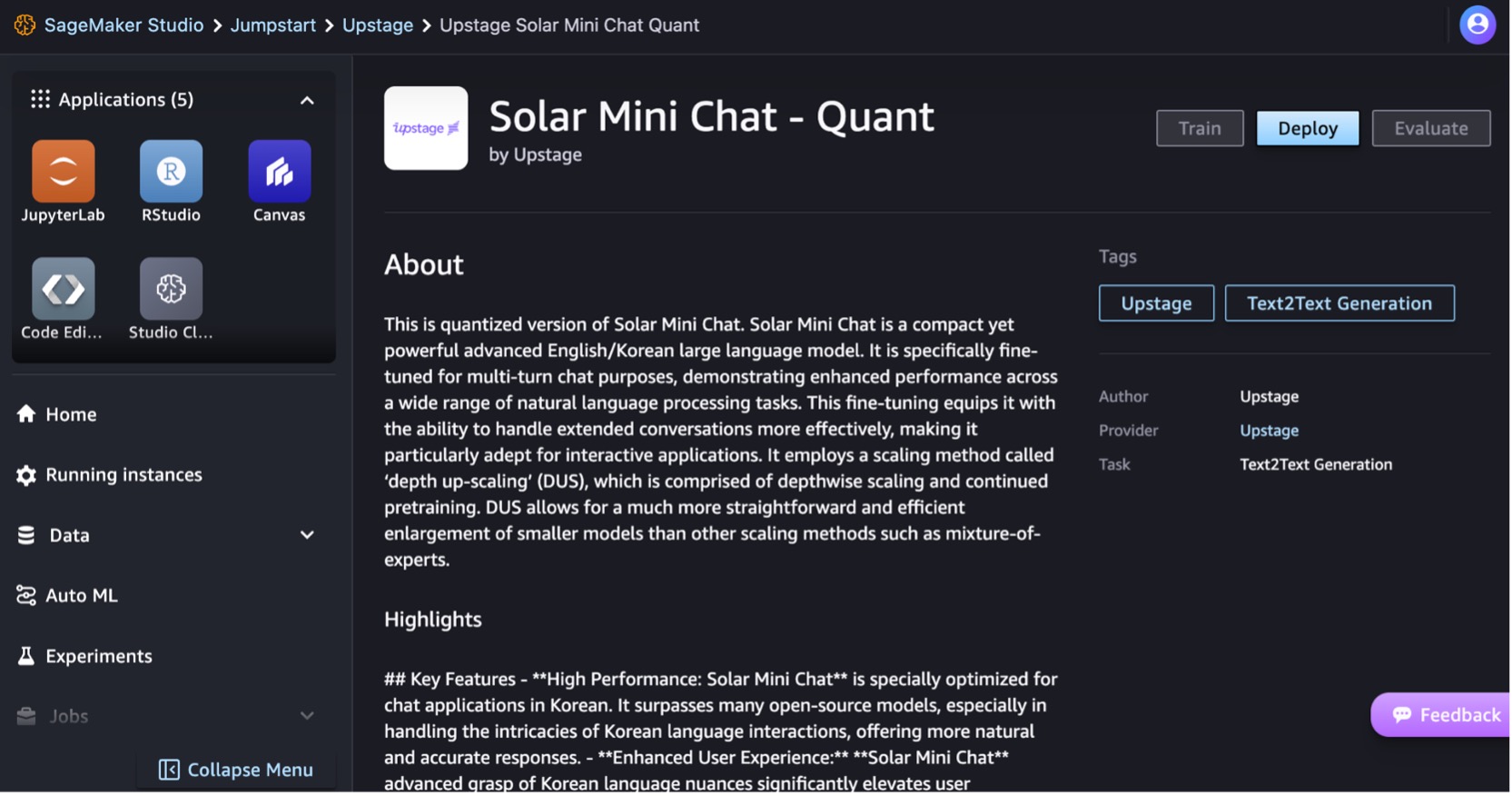

Implementemos el modelo Solar Mini Chat – Quant. Elija la tarjeta del modelo para ver detalles sobre el modelo, como la licencia, los datos utilizados para entrenar y cómo utilizar el modelo. También encontrarás un Despliegue opción, que lo lleva a una página de destino donde puede probar la inferencia con una carga útil de ejemplo.

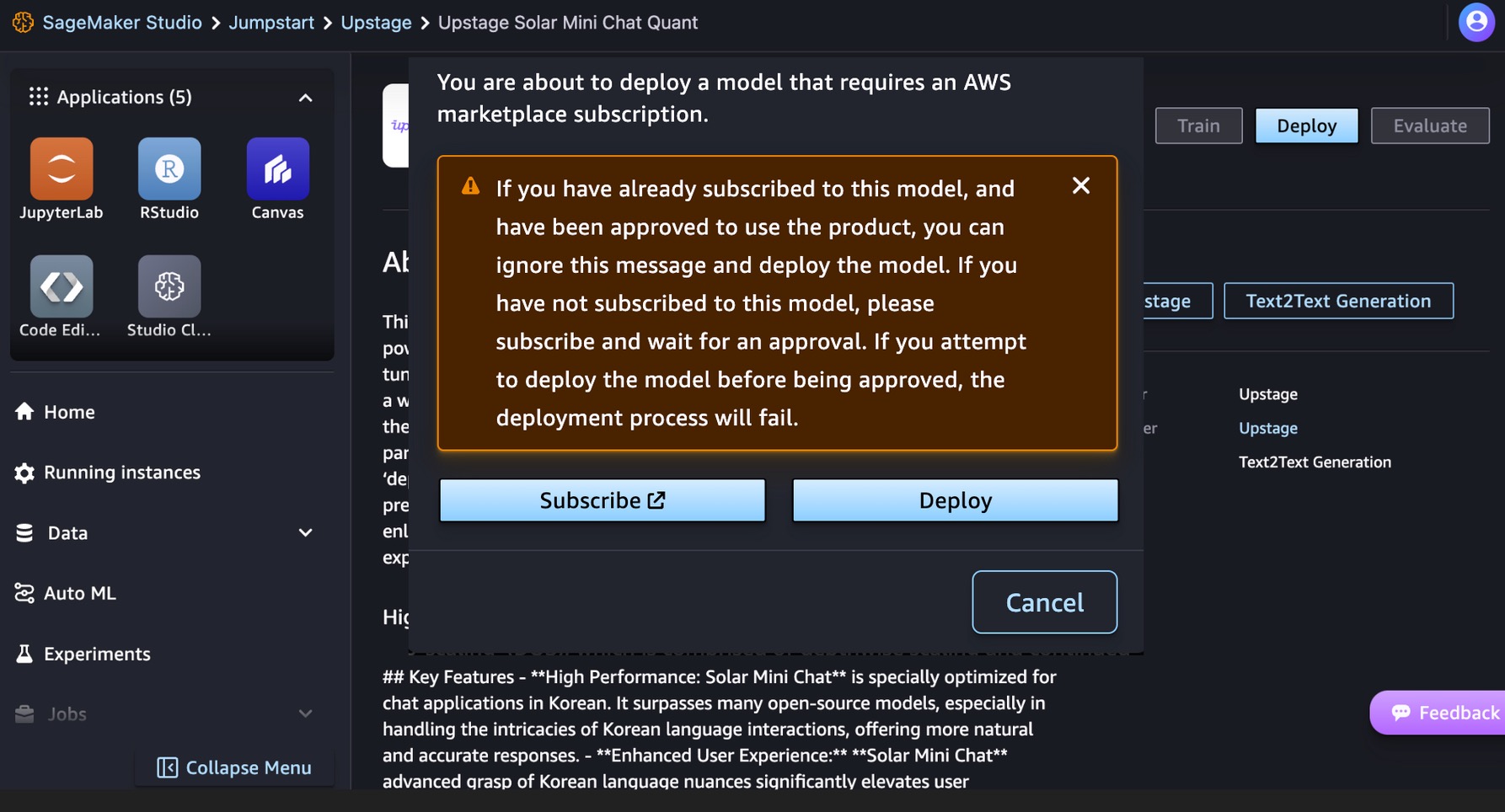

Este modelo requiere un AWS Marketplace suscripción. Si ya se suscribió a este modelo y recibió aprobación para usar el producto, puede implementar el modelo directamente.

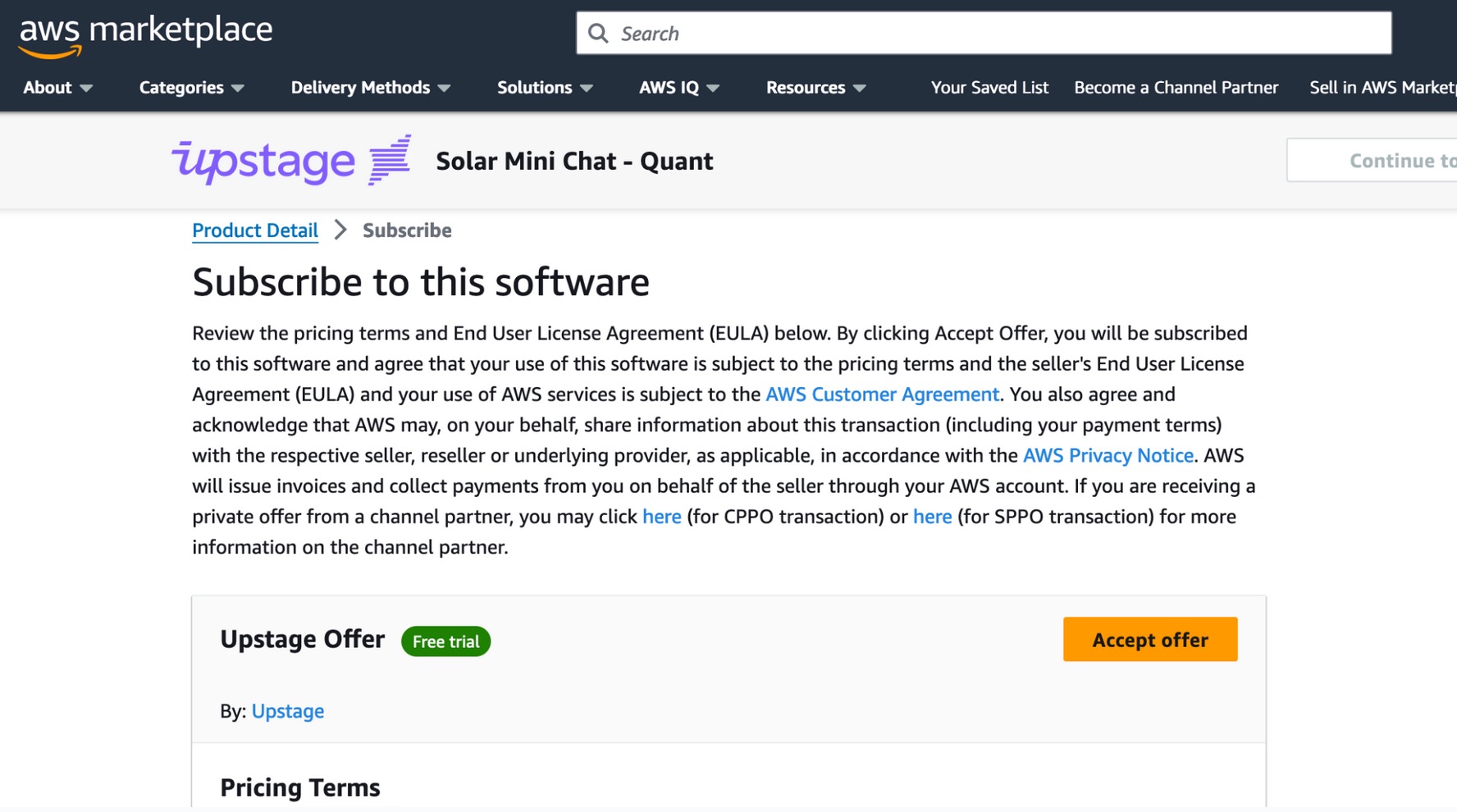

Si no te has suscrito a este modelo, elige Suscríbete, vaya a AWS Marketplace, revise los términos de precios y el Acuerdo de licencia de usuario final (EULA) y elija Aceptar la oferta.

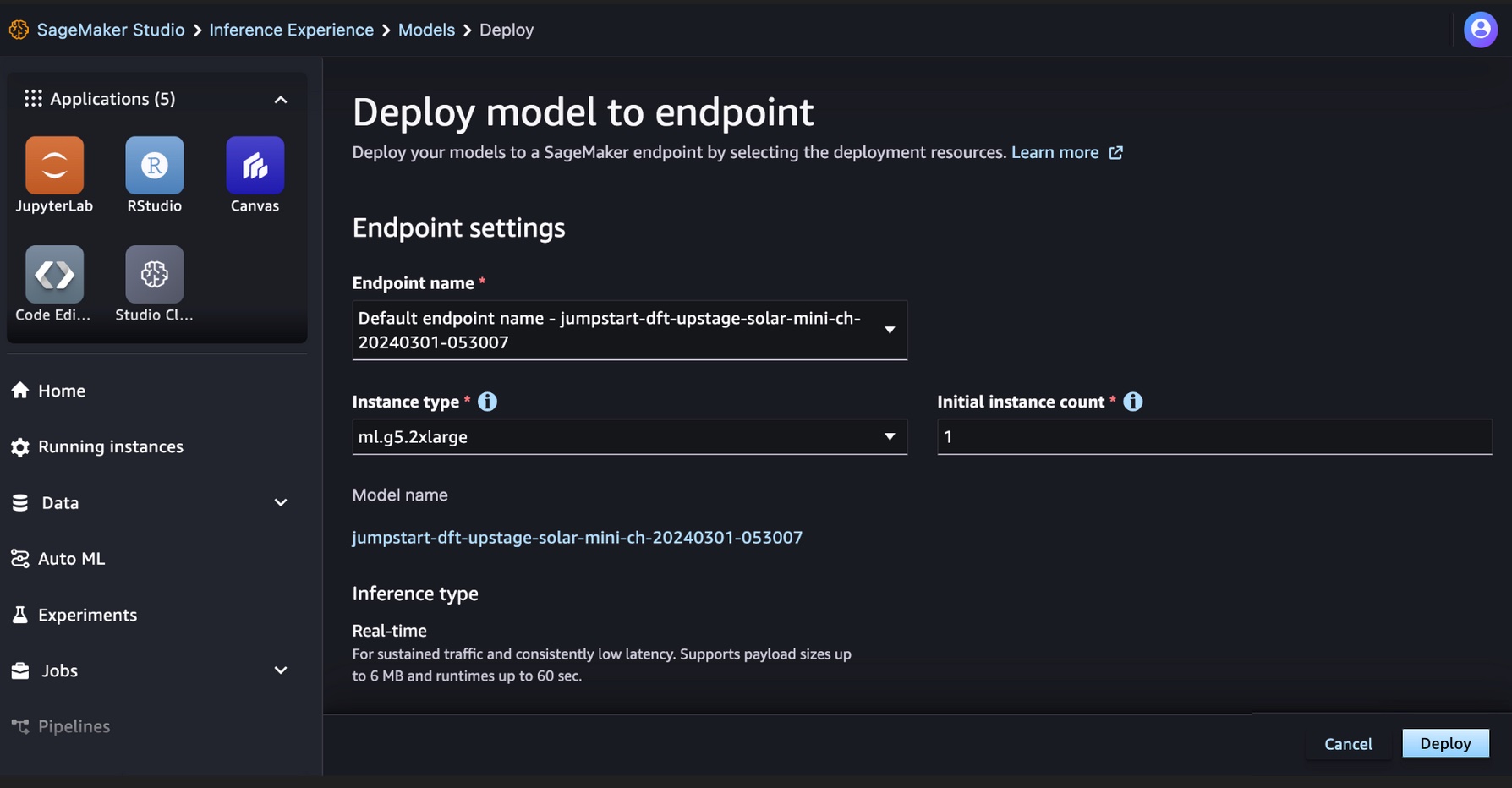

Después de suscribirse al modelo, puede implementar su modelo en un punto final de SageMaker seleccionando los recursos de implementación, como el tipo de instancia y el recuento de instancias inicial. Elegir Despliegue y espere a que se cree un punto final para la inferencia del modelo. Puedes seleccionar un ml.g5.2xlarge Por ejemplo, como una opción más barata para realizar inferencias con el modelo Solar.

Cuando su punto final de SageMaker se haya creado correctamente, podrá probarlo en los distintos entornos de aplicaciones de SageMaker.

Ejecute su código para modelos solares en SageMaker Studio JupyterLab

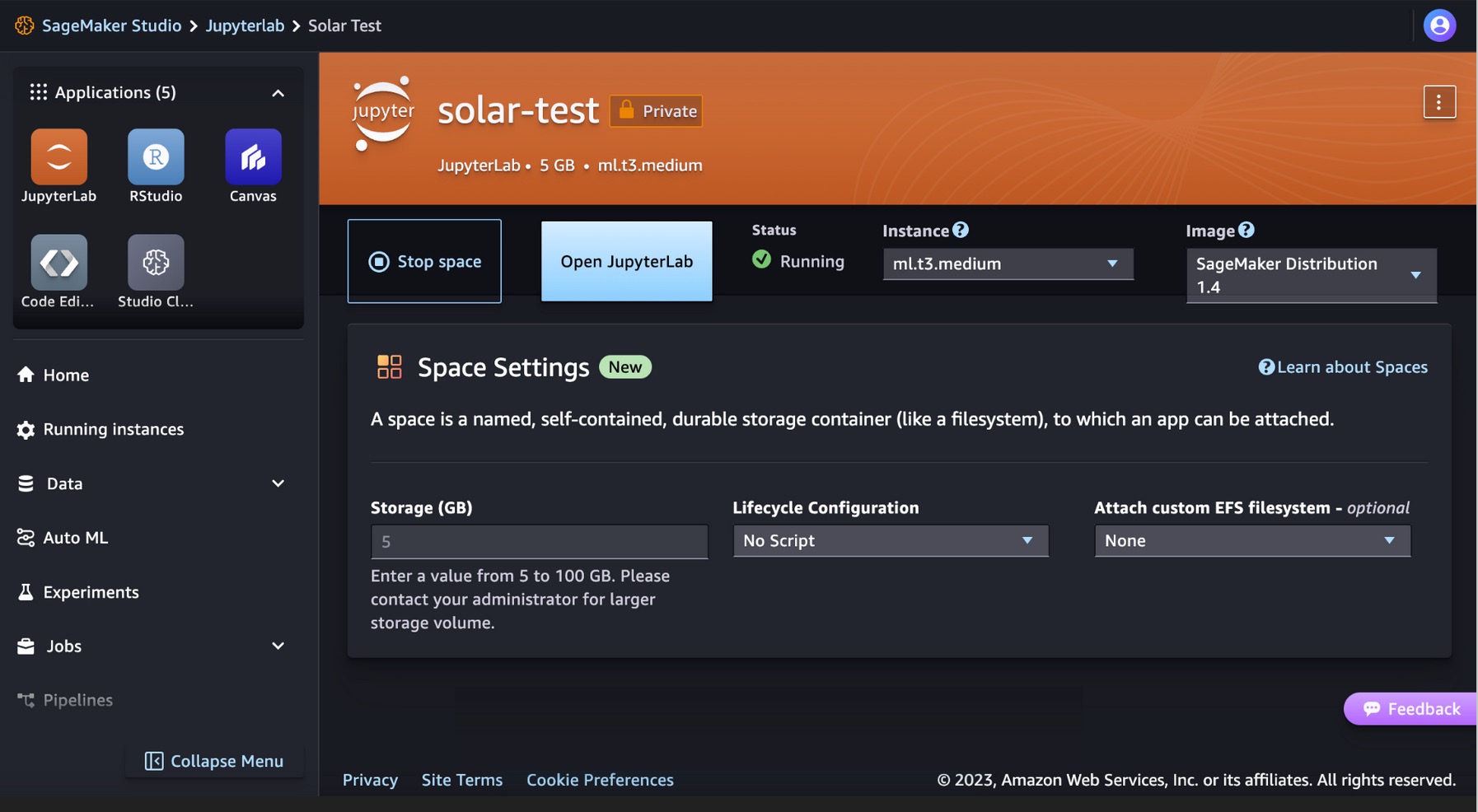

SageMaker Studio admite varios entornos de desarrollo de aplicaciones, incluido JupyterLab, un conjunto de capacidades que aumentan la oferta de portátiles totalmente administrados. Incluye kernels que se inician en segundos, un tiempo de ejecución preconfigurado con ciencia de datos popular, marcos de aprendizaje automático y almacenamiento en bloque privado de alto rendimiento. Para más información, ver SageMaker JupyterLab.

Cree un espacio JupyterLab dentro de SageMaker Studio que administre el almacenamiento y los recursos informáticos necesarios para ejecutar la aplicación JupyterLab.

Puede encontrar el código que muestra la implementación de modelos solares en SageMaker JumpStart y un ejemplo de cómo utilizar el modelo implementado en el Repositorio GitHub. Ahora puede implementar el modelo utilizando SageMaker JumpStart. El siguiente código utiliza la instancia predeterminada ml.g5.2xlarge para el punto final de inferencia del modelo Quant de Solar Mini Chat.

Los modelos solares admiten una carga útil de solicitud/respuesta compatible con el punto final de finalización de Chat de OpenAI. Puede probar ejemplos de chat de un solo turno o de varios turnos con Python.

# Get a SageMaker endpoint

sagemaker_runtime = boto3.client("sagemaker-runtime")

endpoint_name = sagemaker.utils.name_from_base(model_name)

# Multi-turn chat prompt example

input = {

"messages": [

{

"role": "system",

"content": "You are a helpful assistant."

},

{

"role": "user",

"content": "Can you provide a Python script to merge two sorted lists?"

},

{

"role": "assistant",

"content": """Sure, here is a Python script to merge two sorted lists:

```python

def merge_lists(list1, list2):

return sorted(list1 + list2)

```

"""

},

{

"role": "user",

"content": "Can you provide an example of how to use this function?"

}

]

}

# Get response from the model

response = sagemaker_runtime.invoke_endpoint(EndpointName=endpoint_name, ContentType='application/json', Body=json.dumps (input))

result = json.loads(response['Body'].read().decode())

print resultHa realizado con éxito una inferencia en tiempo real con el modelo Solar Mini Chat.

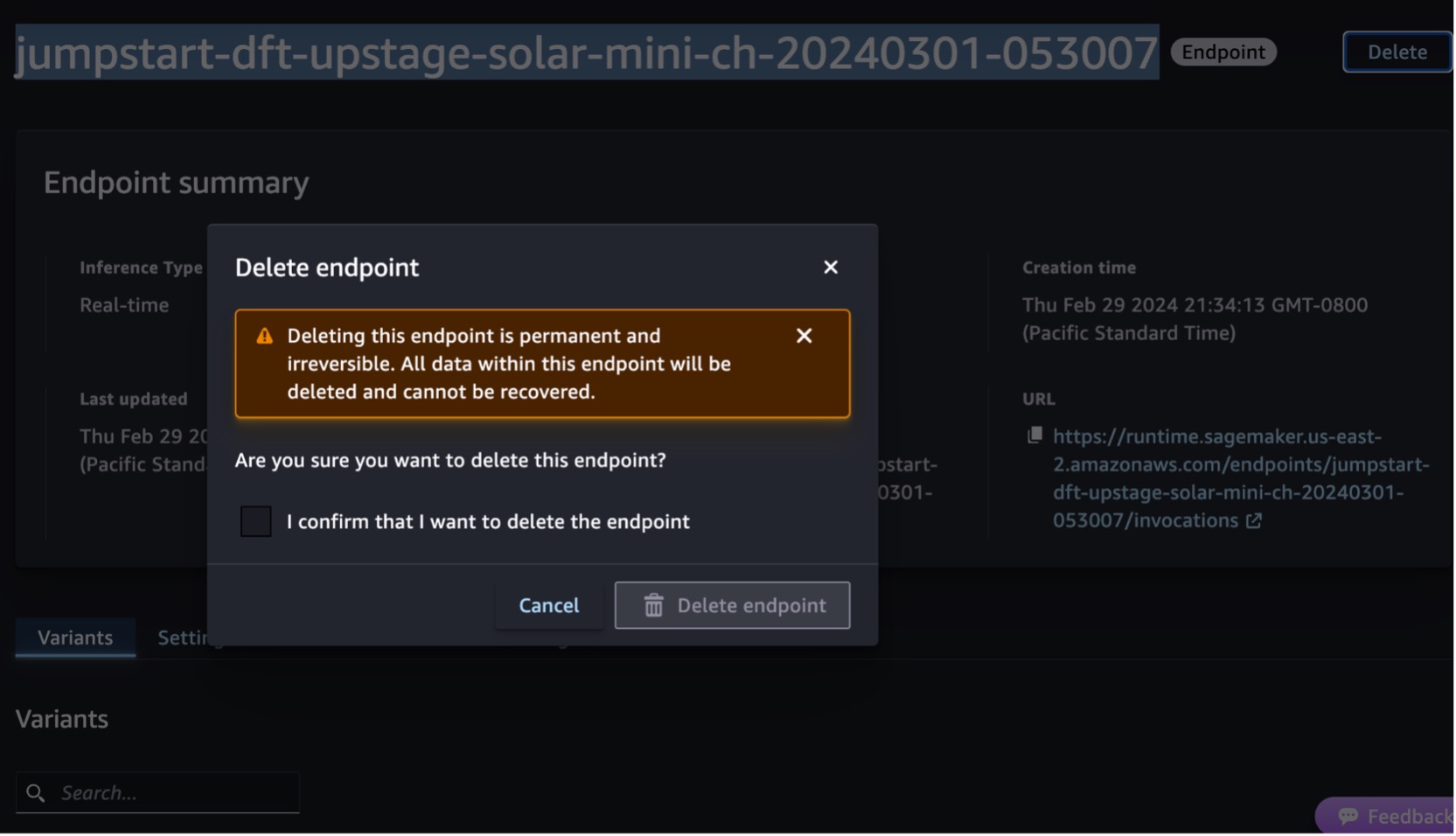

Limpiar

Después de haber probado el punto final, elimine el punto final de inferencia de SageMaker y elimine el modelo para evitar incurrir en cargos.

También puede ejecutar el siguiente código para eliminar el punto final y el modo en el cuaderno de SageMaker Studio JupyterLab:

# Delete the endpoint

model.sagemaker_session.delete_endpoint(endpoint_name)

model.sagemaker_session.delete_endpoint_config(endpoint_name)

# Delete the model

model.delete_model()Para más información, consulte la Eliminar puntos finales y recursos. Además, puede cerrar los recursos de SageMaker Studio que ya no son necesarios.

Conclusión

En esta publicación, le mostramos cómo comenzar con los modelos solares de Upstage en SageMaker Studio e implementar el modelo para inferencia. También le mostramos cómo puede ejecutar su código de muestra de Python en SageMaker Studio JupyterLab.

Dado que los modelos solares ya están previamente entrenados, pueden ayudar a reducir los costos de capacitación e infraestructura y permitir la personalización de sus aplicaciones de IA generativa.

Pruébalo en el Consola SageMaker JumpStart or Consola SageMaker Studio! También puedes ver el siguiente vídeo, Pruebe 'Solar' con Amazon SageMaker.

Esta guía tiene únicamente fines informativos. Aún así, debe realizar su propia evaluación independiente y tomar medidas para garantizar que cumple con sus propias prácticas y estándares de control de calidad específicos, y con las reglas, leyes, regulaciones, licencias y términos de uso locales que se aplican a usted, su contenido, y el modelo de terceros al que se hace referencia en esta guía. AWS no tiene control ni autoridad sobre el modelo de terceros al que se hace referencia en esta guía y no realiza ninguna declaración ni garantía de que el modelo de terceros sea seguro, esté libre de virus, sea operativo o compatible con su entorno y estándares de producción. AWS no realiza ninguna declaración ni garantía de que la información contenida en esta guía produzca un resultado o resultado particular.

Acerca de los autores

channy yun es un defensor principal de desarrolladores en AWS y le apasiona ayudar a los desarrolladores a crear aplicaciones modernas en los últimos servicios de AWS. Es un desarrollador pragmático y bloguero de corazón, y le encanta el aprendizaje impulsado por la comunidad y el intercambio de tecnología.

channy yun es un defensor principal de desarrolladores en AWS y le apasiona ayudar a los desarrolladores a crear aplicaciones modernas en los últimos servicios de AWS. Es un desarrollador pragmático y bloguero de corazón, y le encanta el aprendizaje impulsado por la comunidad y el intercambio de tecnología.

Hwalsuk Lee es director de tecnología (CTO) de Upstage. Ha trabajado para Samsung Techwin, NCSOFT y Naver como investigador de IA. Está cursando su doctorado en Ingeniería Eléctrica y Computación en el Instituto Avanzado de Ciencia y Tecnología de Corea (KAIST).

Hwalsuk Lee es director de tecnología (CTO) de Upstage. Ha trabajado para Samsung Techwin, NCSOFT y Naver como investigador de IA. Está cursando su doctorado en Ingeniería Eléctrica y Computación en el Instituto Avanzado de Ciencia y Tecnología de Corea (KAIST).

Brandon Lee es arquitecto senior de soluciones en AWS y principalmente ayuda a grandes clientes de tecnología educativa en el sector público. Tiene más de 20 años de experiencia liderando el desarrollo de aplicaciones en empresas globales y grandes corporaciones.

Brandon Lee es arquitecto senior de soluciones en AWS y principalmente ayuda a grandes clientes de tecnología educativa en el sector público. Tiene más de 20 años de experiencia liderando el desarrollo de aplicaciones en empresas globales y grandes corporaciones.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/solar-models-from-upstage-are-now-available-in-amazon-sagemaker-jumpstart/

- :posee

- :es

- :no

- :dónde

- 10

- 120

- 152

- 20

- 20 años

- 2023

- 7

- 990

- a

- capacidad

- Nuestra Empresa

- Aceptar

- de la máquina

- a través de

- adición

- Adicionalmente

- adepto

- avanzado

- defensor

- Agreement

- AI

- algoritmos

- Todos

- permite

- a lo largo de

- ya haya utilizado

- también

- Amazon

- Amazon SageMaker

- JumpStart de Amazon SageMaker

- Amazon Web Services

- an

- y

- e infraestructura

- Anunciar

- cualquier

- Aplicación

- Desarrollo de aplicaciones

- aplicaciones

- Aplicá

- aprobado

- arquitectura

- somos

- AS

- evaluación

- Legal

- At

- aumentar

- autoridad

- Hoy Disponibles

- evitar

- AWS

- AWS Marketplace

- de caramelos

- basado

- BE

- esto

- Bloquear

- Blog

- cuerpo

- Brandon

- build

- Construir la

- incorporado

- pero

- by

- , que son

- PUEDEN

- capacidades

- tarjeta

- a ciertos

- cargos

- chat

- más barato

- jefe

- Director de Tecnología

- Elige

- más clara

- código

- Comunicación

- Impulsado por la comunidad

- compacto

- Empresas

- comparable

- compatible

- terminación

- cumplir

- Compuesto

- Calcular

- computadora

- Consola

- contenido

- continuado

- control

- conversaciones

- Corporaciones

- Precio

- contar

- Para crear

- creado

- CTO

- Clientes

- personalización

- datos

- Ciencia de los datos

- Diciembre

- Predeterminado

- entrega

- vas demostrando

- desplegar

- desplegado

- Desplegando

- despliegue

- detalles

- desarrollado

- Developer

- desarrolladores

- Desarrollo

- directamente

- descrubrir

- sí

- dominios

- DE INSCRIPCIÓN

- educativo

- de manera eficaz

- eficiente

- eleva

- emplea

- habilitar

- final

- Punto final

- Ingeniería

- Inglés

- mejorado

- garantizar

- asegurando que

- Participar

- Entorno

- ambientes

- ejemplo

- ejemplos

- excitado

- experience

- extendido

- Cara

- más rápida

- menos

- Figura

- Encuentre

- siguiendo

- Fundación

- marcos

- Desde

- completamente

- función

- generativo

- IA generativa

- obtener

- Buscar

- Go

- agarrar

- garantías

- guía

- encargarse de

- Tienen

- he

- Corazón

- ayuda

- serviciales

- ayudando

- ayuda

- esta página

- Alto rendimiento

- su

- organizado

- Cómo

- Como Hacer

- HTML

- HTTPS

- Bujes

- if

- ilustra

- in

- incluye

- Incluye

- independientes

- información

- Informativo

- EN LA MINA

- inicial

- Las opciones de entrada

- entradas

- ejemplo

- Innovadora

- COMPLETAMENTE

- interacciones

- interactivo

- dentro

- IT

- SUS

- jpg

- json

- Corea

- Coreano

- aterrizaje

- idioma

- Idiomas

- large

- más reciente

- leyes

- clasificación

- líder

- aprendizaje

- Lee

- Licencia

- licencias

- Listas

- Llama

- LLM

- local

- por más tiempo

- ama

- inferior

- máquina

- máquina de aprendizaje

- hecho

- para lograr

- Realizar

- gestionado

- gestiona

- mercado

- medidas

- ir

- la vida

- Meta

- Método

- métodos

- Métrica

- ML

- Moda

- modelo

- modelos

- Moderno

- más,

- más eficiente

- mucho más

- Natural

- Procesamiento natural del lenguaje

- Naver

- Navegación

- no

- notablemente

- cuaderno

- ahora

- matices

- of

- LANZAMIENTO

- que ofrece

- Oficial

- on

- , solamente

- habiertos

- operativos.

- optimizado

- Optión

- or

- Otro

- salir

- Resultado

- Supera

- Más de

- EL DESARROLLADOR

- página

- cristal

- parámetros

- particular

- particularmente

- apasionado

- Realizar

- actuación

- realizado

- Doctor en Filosofía

- pináculo

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Popular

- Publicación

- poderoso

- prácticas

- pragmático

- necesidad

- preparación

- cotización

- las cuales

- Director de la escuela

- Imprimir

- privada

- Problema

- tratamiento

- Producto

- Producción

- proporcionar

- proporciona un

- público

- fines

- Python

- calidad

- Quant

- con rapidez

- distancia

- alcanzando

- real

- en tiempo real

- archivos

- referencia

- reglamentos

- Requisitos

- requiere

- investigador

- Resolución

- Recursos

- respuesta

- respuestas

- resultado

- volvemos

- una estrategia SEO para aparecer en las búsquedas de Google.

- Función

- reglas

- Ejecutar

- tiempo de ejecución

- sabio

- Inferencia de SageMaker

- muestra

- Samsung

- la ampliación

- Ciencia:

- Ciencia y Tecnología

- guión

- Buscar

- segundos

- sector

- seguro

- ver

- selecciona

- seleccionar

- mayor

- de coches

- Servicios

- set

- compartir

- tienes

- mostró

- demostración

- significativamente

- Tamaño

- menores

- solar

- Soluciones

- algo

- Espacio

- especializarse

- soluciones y

- específicamente

- estándares de salud

- comienzo

- fundó

- pasos

- Sin embargo

- STORAGE

- sencillo

- estructura

- estudio

- Suscríbase

- suscripción

- Con éxito

- tal

- SOPORTE

- soportes

- seguro

- te

- ¡Prepárate!

- toma

- tareas

- Tecnología

- términos

- test

- probado

- que

- esa

- La

- Estas

- ellos

- terceros.

- así

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- veces

- a

- seguir

- Entrenar

- Formación

- dos

- tipo

- utilizan el

- usado

- Usuario

- usos

- usando

- diversos

- versátil

- versión

- vía

- Video

- Ver

- esperar

- caminar

- garantías

- Ver ahora

- olas

- we

- web

- servicios web

- Basado en la Web

- que

- amplio

- Amplia gama

- seguirá

- dentro de

- trabajado

- años

- Usted

- tú

- Youtube

- zephyrnet