La ingeniería rápida se ha convertido en una habilidad esencial para cualquiera que trabaje con grandes modelos de lenguaje (LLM) para generar textos relevantes y de alta calidad. Aunque la ingeniería de indicaciones textuales se ha debatido ampliamente, la ingeniería de indicaciones visuales es un campo emergente que requiere atención. Las indicaciones visuales pueden incluir cuadros delimitadores o máscaras que guían los modelos de visión para generar resultados relevantes y precisos. En esta publicación, exploramos los conceptos básicos de la ingeniería de avisos visuales, sus beneficios y cómo se puede utilizar para resolver un caso de uso específico: la segmentación de imágenes para la conducción autónoma.

En los últimos años, el campo de la visión por computadora ha sido testigo de importantes avances en el área de la segmentación de imágenes. Uno de esos avances es el Segmentar cualquier modelo (SAM) por Meta AI, que tiene el potencial de revolucionar la segmentación a nivel de objetos con entrenamiento de pocos o cero disparos. En esta publicación, utilizamos el modelo SAM como modelo de visión básico de ejemplo y exploramos su aplicación al Conjunto de datos BDD100K, un conjunto diverso de datos de conducción autónoma para un aprendizaje multitarea heterogéneo. Al combinar las fortalezas de SAM con los datos enriquecidos proporcionados por BDD100K, mostramos el potencial de la ingeniería visual rápida con diferentes versiones de SAM. Inspirado por el LangChain Marco para modelos de lenguaje, proponemos una cadena visual para realizar indicaciones visuales combinando modelos de detección de objetos con SAM.

Aunque esta publicación se centra en la conducción autónoma, los conceptos discutidos son aplicables ampliamente a dominios que tienen aplicaciones ricas basadas en la visión, como la atención médica y las ciencias biológicas, y los medios y el entretenimiento. Comencemos aprendiendo un poco más sobre lo que hay detrás de un modelo de visión fundamental como SAM. Nosotros usamos Estudio Amazon SageMaker en una instancia ml.g5.16xlarge para esta publicación.

Segmentar cualquier modelo (SAM)

Los modelos básicos son grandes modelos de aprendizaje automático (ML) entrenados con una gran cantidad de datos y pueden solicitarse o ajustarse para casos de uso de tareas específicas. Aquí, exploramos el modelo Segment Anything (SAM), que es un modelo fundamental para la visión, específicamente la segmentación de imágenes. Está previamente entrenado en un conjunto de datos masivo de 11 millones de imágenes y 1.1 mil millones de máscaras, lo que lo convierte en el conjunto de datos de segmentación más grande al momento de escribir este artículo. Este extenso conjunto de datos cubre una amplia gama de objetos y categorías, lo que proporciona a SAM una fuente de datos de entrenamiento diversa y a gran escala.

El modelo SAM está entrenado para comprender objetos y puede generar máscaras de segmentación para cualquier objeto en imágenes o cuadros de video. El modelo permite la ingeniería de indicaciones visuales, lo que le permite proporcionar entradas como texto, puntos, cuadros delimitadores o máscaras para generar etiquetas sin alterar la imagen original. SAM está disponible en tres tamaños: básico (ViT-B, 91 millones de parámetros), grande (ViT-L, 308 millones de parámetros) y enorme (ViT-H, 636 millones de parámetros), para satisfacer diferentes requisitos computacionales y casos de uso.

La motivación principal detrás de SAM es mejorar la segmentación a nivel de objetos con muestras y épocas de entrenamiento mínimas para cualquier objeto de interés. El poder de SAM radica en su capacidad para adaptarse a nuevas distribuciones de imágenes y tareas sin conocimientos previos, característica conocida como transferencia de tiro cero. Esta adaptabilidad se logra a través de su entrenamiento en el amplio conjunto de datos SA-1B, que ha demostrado un impresionante rendimiento de disparo cero, superando muchos resultados anteriores totalmente supervisados.

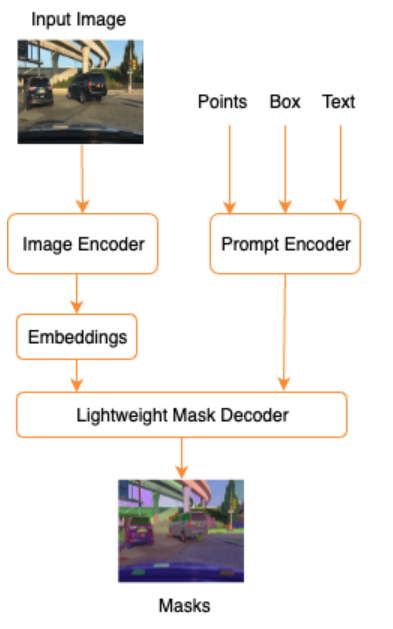

Como se muestra en la siguiente arquitectura para SAM, el proceso de generación de máscaras de segmentación implica tres pasos:

- Un codificador de imágenes produce una incrustación única de la imagen.

- Un codificador de mensajes convierte cualquier mensaje en un vector de incrustación para el mensaje.

- El decodificador liviano combina la información del codificador de imágenes y el codificador de avisos para predecir máscaras de segmentación.

Como ejemplo, podemos proporcionar una entrada con una imagen y un cuadro delimitador alrededor de un objeto de interés en esa imagen (por ejemplo, un automóvil plateado o un carril de conducción) y el modelo SAM produciría máscaras de segmentación para ese objeto.

Ingeniería visual rápida

La ingeniería rápida se refiere a la estructuración de entradas a un modelo que hace que el modelo comprenda la intención y produzca el resultado deseado. Con la ingeniería de indicaciones textuales, puede estructurar el texto de entrada mediante modificaciones como la elección de palabras, el formato, el orden y más para obtener el resultado deseado. La ingeniería de avisos visuales supone que el usuario está trabajando en una modalidad visual (imagen o video) y proporciona entradas. La siguiente es una lista no exhaustiva de posibles formas de proporcionar información al modelo de IA generativa en el dominio visual:

- Punto: un punto de coordenadas singular (x, y) en el plano de la imagen.

- Puntos: múltiples puntos de coordenadas (x, y), no necesariamente relacionados entre sí

- Cuadro delimitador: un conjunto de cuatro valores (x, y, w, h) que definen una región rectangular en el plano de la imagen.

- Contorno: un conjunto de puntos de coordenadas (x, y) en el plano de la imagen que forman una forma cerrada.

- Máscara: una matriz del mismo tamaño que la imagen con una máscara parcial del objeto de interés.

Con las técnicas de ingeniería visual en mente, exploremos cómo se puede aplicar esto al modelo SAM previamente entrenado. Hemos utilizado la versión base del modelo previamente entrenado.

Indicación de disparo cero con el modelo SAM previamente entrenado

Para empezar, exploremos el enfoque de disparo cero. La siguiente es una imagen de muestra del conjunto de datos de entrenamiento tomada desde la cámara frontal de un vehículo.

Podemos obtener máscaras de segmentación para todos los objetos de la imagen sin ninguna indicación visual explícita mediante generando máscaras automáticamente con solo una imagen de entrada. En la siguiente imagen, vemos partes del automóvil, la carretera, la señal de tráfico, las placas, el paso elevado, los pilares, las señales y más segmentados.

Sin embargo, este resultado no es útil de inmediato por los siguientes motivos:

- Los coches no están segmentados en su conjunto, sino por partes. Para la mayoría de los modelos de percepción, por ejemplo, realmente no nos importa que cada uno de los neumáticos tenga máscaras de salida separadas. Esto también es válido cuando se buscan otros objetos de interés conocidos, como carreteras, vegetación, señales, etc.

- Partes de la imagen que son útiles para tareas posteriores, como el área de conducción, están divididas, sin explicación. Por otro lado, las instancias similares se identifican por separado y puede que nos interese agrupar objetos similares (segmentación panóptica versus segmentación de instancias).

Ingeniería visual rápida con el modelo SAM previamente entrenado

Afortunadamente, SAM admite la provisión de indicaciones de entrada y podemos usar puntos, matrices de puntos y cuadros delimitadores como entradas. Con estas instrucciones específicas, esperamos que SAM funcione mejor con segmentaciones centradas en puntos o áreas específicas. Esto se puede comparar con la plantilla de mensajes de idioma."What is a good name for a company that makes {product}?"

donde la entrada junto con esta plantilla de aviso del usuario es la {product}. {product} es una ranura de entrada. En las indicaciones visuales, los cuadros delimitadores, los puntos o las máscaras son las ranuras de entrada.

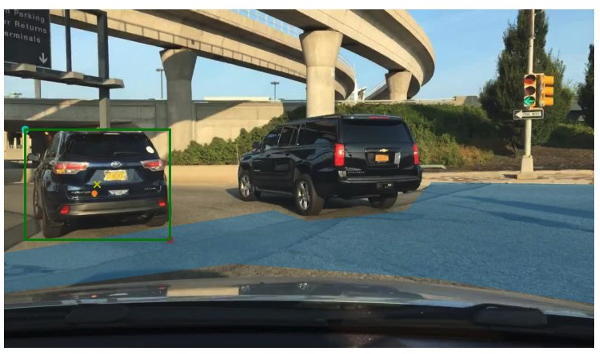

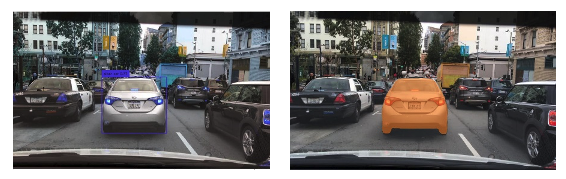

La siguiente imagen proporciona el cuadro delimitador de verdad sobre el terreno original alrededor de los vehículos y el parche del área transitable a partir de datos de verdad sobre el terreno BDD100K. La imagen también muestra un punto de entrada (una X amarilla) en el centro del cuadro delimitador verde al que nos referiremos en las siguientes secciones.

Intentemos generar una máscara para el automóvil de la izquierda con el cuadro delimitador verde como entrada a SAM. Como se muestra en el siguiente ejemplo, el modelo base de SAM realmente no encuentra nada. Esto también se ve en la baja puntuación de segmentación. Cuando observamos las máscaras de segmentación más de cerca, vemos que hay pequeñas regiones devueltas como máscaras (señaladas con flechas rojas) que en realidad no se pueden utilizar para ninguna aplicación posterior.

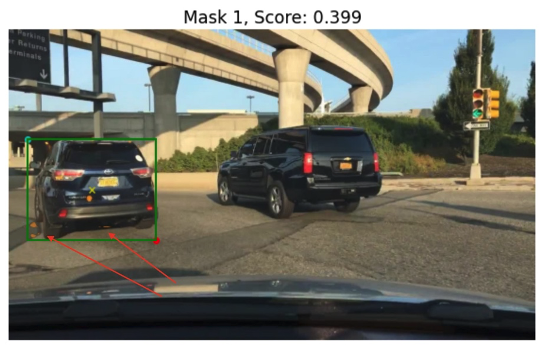

Probemos una combinación de un cuadro delimitador y un punto como mensaje visual de entrada. La cruz amarilla en la imagen anterior es el centro del cuadro delimitador. Proporcionar las coordenadas (x,y) de este punto como mensaje junto con la restricción del cuadro delimitador nos proporciona la siguiente máscara y una puntuación ligeramente más alta. Esto todavía no se puede utilizar de ninguna manera.

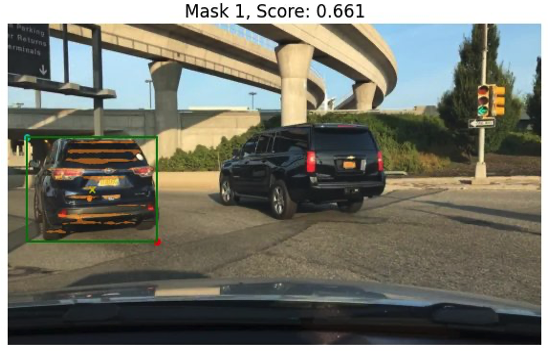

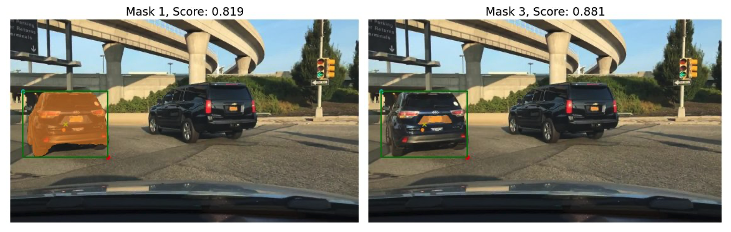

Finalmente, con el modelo base previamente entrenado, podemos proporcionar solo el punto de entrada como mensaje (sin el cuadro delimitador). Las siguientes imágenes muestran dos de las tres máscaras principales que nos parecieron interesantes.

La Máscara 1 segmenta el automóvil completo, mientras que la Máscara 3 segmenta un área que sostiene la matrícula del automóvil cerca de la cruz amarilla (solicitud de entrada). La máscara 1 todavía no es una máscara limpia y ajustada alrededor del automóvil; esto apunta a la calidad del modelo, que podemos suponer aumenta con el tamaño del modelo.

Podemos probar modelos preentrenados más grandes con el mismo mensaje de entrada. Las siguientes imágenes muestran nuestros resultados. Cuando se utiliza el enorme modelo SAM previamente entrenado, la Máscara 3 es el automóvil completo, mientras que las Máscaras 1 y 2 se pueden usar para extraer la matrícula.

La versión grande del modelo SAM también proporciona resultados similares.

El proceso que seguimos aquí es similar a la ingeniería de mensajes manuales para mensajes de texto con los que quizás ya esté familiarizado. Tenga en cuenta que una mejora reciente en el modelo SAM para segmentar cualquier cosa en alta calidad proporciona resultados mucho mejores específicos para objetos y contextos. En nuestro caso, encontramos que las indicaciones de disparo cero con texto y indicaciones visuales (entradas de punto, cuadro y punto y cuadro) no mejoran drásticamente los resultados como vimos anteriormente.

Plantillas de avisos y cadenas visuales

Como podemos ver en los ejemplos anteriores de disparo cero, SAM tiene dificultades para identificar todos los objetos en la escena. Este es un buen ejemplo de dónde podemos aprovechar las plantillas de avisos y las cadenas visuales. Visual Chain está inspirado en el concepto de cadena del popular marco LangChain para aplicaciones de lenguaje. Ayuda a encadenar las fuentes de datos y un LLM para producir el resultado. Por ejemplo, podemos usar una cadena API para llamar a una API e invocar un LLM para responder la pregunta según la respuesta de la API.

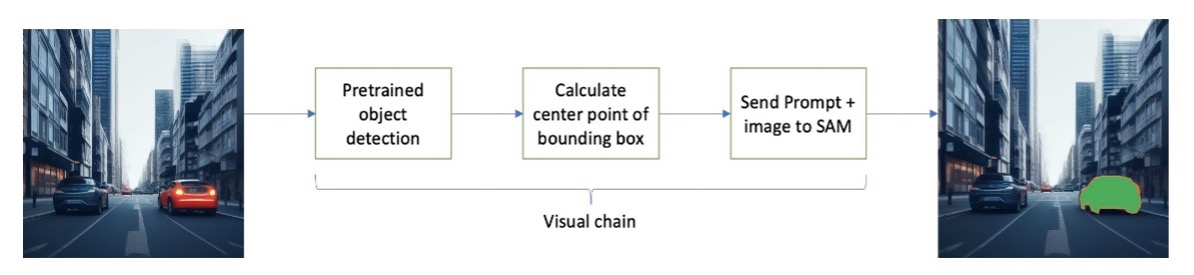

Inspirándonos en LangChain, proponemos una cadena visual secuencial que se parece a la siguiente figura. Usamos una herramienta (como un modelo de detección de objetos previamente entrenado) para obtener cuadros delimitadores iniciales, calculamos el punto en el centro del cuadro delimitador y lo usamos para solicitar al modelo SAM la imagen de entrada.

Por ejemplo, la siguiente imagen muestra las máscaras de segmentación como resultado de ejecutar esta cadena.

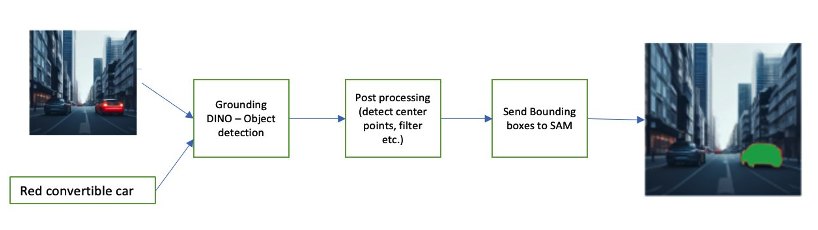

Otro ejemplo de cadena puede implicar una entrada de texto del objeto que el usuario está interesado en identificar. Para implementar esto, construimos una tubería usando DINO a tierra, un modelo de detección de objetos para solicitar la segmentación de SAM.

Grounding DINO es un modelo de detección de objetos de disparo cero que puede realizar la detección de objetos con texto que proporciona nombres de categorías (como "semáforo" o "camión") y expresiones (como "camión amarillo"). Acepta pares de texto e imagen para realizar la detección de objetos. Se basa en una arquitectura transformadora y permite modalidades cruzadas con datos de texto e imágenes. Para obtener más información sobre la conexión a tierra de DINO, consulte Conexión a tierra de DINO: combinación de DINO con entrenamiento previo conectado a tierra para la detección de objetos en conjunto abierto. Esto genera cuadros delimitadores y etiquetas y se puede procesar aún más para generar puntos centrales, filtrar según etiquetas, umbrales y más. Esto se utiliza (cuadros o puntos) como un mensaje a SAM para la segmentación, que genera máscaras.

Los siguientes son algunos ejemplos que muestran el texto de entrada, la salida DINO (cuadros delimitadores) y la salida SAM final (máscaras de segmentación).

Las siguientes imágenes muestran el resultado de "camión amarillo".

Las siguientes imágenes muestran el resultado de “coche plateado”.

La siguiente imagen muestra el resultado de "carril de conducción".

Podemos utilizar este canal para construir una cadena visual. El siguiente fragmento de código explica este concepto:

pipeline = [object_predictor, segment_predictor]

image_chain = ImageChain.from_visual_pipeline(pipeline, image_store, verbose=True)

image_chain.run('All silver cars', image_id='5X3349')Aunque este es un ejemplo simple, este concepto se puede ampliar para procesar transmisiones de cámaras en vehículos para realizar seguimiento de objetos, redacción de datos de información de identificación personal (PII) y más. También podemos obtener los cuadros delimitadores de modelos más pequeños o, en algunos casos, utilizando herramientas de visión por computadora estándar. Es bastante sencillo utilizar un modelo previamente entrenado o un servicio como Amazon Rekognition para obtener etiquetas iniciales (visuales) para su mensaje. Al momento de escribir esto, hay más de 70 modelos disponibles en Amazon SageMaker Jumpstart para la detección de objetos, y Reconocimiento de amazonas ya identifica varias categorías útiles de objetos en imágenes, incluidos automóviles, peatones y otros vehículos.

A continuación, analizamos algunos resultados cuantitativos relacionados con el rendimiento de los modelos SAM con un subconjunto de datos BDD100K.

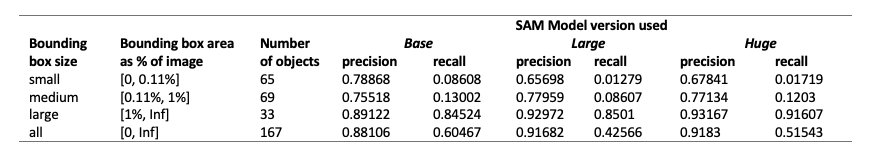

Resultados cuantitativos

Nuestro objetivo es comparar el rendimiento de tres modelos previamente entrenados cuando se les da la misma indicación visual. En este caso, utilizamos el punto central de la ubicación del objeto como entrada visual. Comparamos el rendimiento con respecto a los tamaños de los objetos (en proporción al tamaño de la imagen): pequeño (área <0.11%), mediano (0.11% <área <1%) y grande (área > 1%). Los umbrales del área del cuadro delimitador están definidos por Objetos comunes en contexto (COCO) métricas de evaluación [Lin y otros, 2014].

La evaluación es a nivel de píxel y utilizamos las siguientes métricas de evaluación:

- Precisión = (número de instancias relevantes y recuperadas) / (número total de instancias recuperadas)

- Recuperar = (número de instancias relevantes y recuperadas) / (número total de instancias relevantes)

- Las instancias aquí son cada píxel dentro del cuadro delimitador del objeto de interés.

La siguiente tabla informa el rendimiento de tres versiones diferentes del modelo SAM (base, grande y enorme). Estas versiones tienen tres codificadores diferentes: ViT-B (base), ViT-L (grande), ViT-H (enorme). Los codificadores tienen diferentes recuentos de parámetros, donde el modelo base tiene menos parámetros que los grandes, y lo grande es menos que enorme. Aunque aumentar el número de parámetros muestra un mejor rendimiento con objetos más grandes, esto no ocurre con objetos más pequeños.

Ajuste SAM para su caso de uso

En muchos casos, el uso directo de un modelo SAM previamente entrenado puede no resultar muy útil. Por ejemplo, veamos una escena típica en el tráfico: la siguiente imagen es el resultado del modelo SAM con puntos de aviso muestreados aleatoriamente como entrada a la izquierda y las etiquetas reales de la tarea de segmentación semántica de BDD100K a la derecha. Obviamente son muy diferentes.

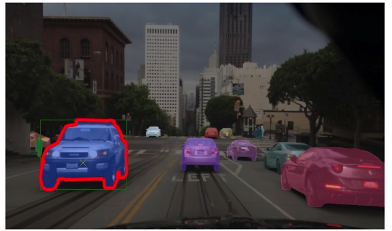

Las pilas de percepción en los AV pueden utilizar fácilmente la segunda imagen, pero no la primera. Por otro lado, hay algunos resultados útiles de la primera imagen que se pueden usar y en los que el modelo no se entrenó explícitamente, por ejemplo, marcas de carril, segmentación de aceras, máscaras de matrículas, etc. Podemos ajustar el modelo SAM para mejorar los resultados de la segmentación. Para realizar este ajuste, creamos un conjunto de datos de entrenamiento utilizando un subconjunto de segmentación de instancias (500 imágenes) del conjunto de datos BDD10K. Este es un subconjunto muy pequeño de imágenes, pero nuestro propósito es demostrar que los modelos de visión fundamentales (muy similares a los LLM) pueden funcionar bien para su caso de uso con una cantidad sorprendentemente pequeña de imágenes. La siguiente imagen muestra la imagen de entrada, la máscara de salida (en azul, con un borde rojo para el automóvil de la izquierda) y posibles mensajes (cuadro delimitador en verde y punto central X en amarillo).

Realizamos ajustes utilizando la biblioteca Hugging Face en Estudio Amazon SageMaker. Usamos la instancia ml.g4dn.xlarge para las pruebas del modelo base SAM y ml.g4dn.2xlarge para las pruebas del modelo enorme SAM. En nuestros experimentos iniciales, observamos que el ajuste fino del modelo base solo con cuadros delimitadores no tuvo éxito. Los modelos ajustados y previamente entrenados no pudieron aprender máscaras de verdad sobre el terreno específicas de los automóviles a partir de los conjuntos de datos originales. Agregar puntos de consulta al ajuste tampoco mejoró la capacitación.

A continuación, podemos intentar ajustar el enorme modelo SAM durante 30 épocas, con un conjunto de datos muy pequeño (500 imágenes). La máscara de verdad del terreno original se parece a la siguiente imagen para el automóvil tipo etiqueta.

Como se muestra en las siguientes imágenes, la versión original previamente entrenada del modelo enorme con un cuadro delimitador específico (en verde) no da resultados, mientras que la versión ajustada da resultados (aún no es preciso, pero se cortó el ajuste). desactivado después de 40 épocas y con un conjunto de datos de entrenamiento muy pequeño de 500 imágenes). El enorme modelo original, previamente entrenado, no pudo predecir máscaras para ninguna de las imágenes que probamos. Como ejemplo de aplicación posterior, el modelo ajustado se puede utilizar en flujos de trabajo de preetiquetado como el que se describe en Módulo de etiquetado automático para sistemas avanzados de asistencia al conductor basados en aprendizaje profundo en AWS.

Conclusión

En esta publicación, analizamos el modelo de visión fundamental conocido como Segment Anything Model (SAM) y su arquitectura. Utilizamos el modelo SAM para analizar las indicaciones visuales y las diversas entradas a la ingeniería de indicaciones visuales. Exploramos cómo funcionan las diferentes indicaciones visuales y sus limitaciones. También describimos cómo las cadenas visuales aumentan el rendimiento al usar un solo mensaje, similar a la API LangChain. A continuación, proporcionamos una evaluación cuantitativa de tres modelos previamente entrenados. Por último, analizamos el modelo SAM perfeccionado y sus resultados en comparación con el modelo base original. El ajuste fino de los modelos básicos ayuda a mejorar el rendimiento del modelo para tareas específicas como la segmentación. Cabe señalar que el modelo SAM, debido a sus requisitos de recursos, limita el uso para casos de uso en tiempo real y la inferencia en el borde en su estado actual. Esperamos que con futuras iteraciones y técnicas mejoradas se reduzcan los requisitos informáticos y se mejore la latencia.

Esperamos que esta publicación lo anime a explorar indicaciones visuales para sus casos de uso. Debido a que ésta es todavía una forma emergente de ingeniería de indicaciones, hay mucho por descubrir en términos de indicaciones visuales, cadenas visuales y rendimiento de estas herramientas. Amazon SageMaker es una plataforma de aprendizaje automático totalmente administrada que permite a los desarrolladores explorar modelos visuales y de lenguaje de gran tamaño y crear aplicaciones de inteligencia artificial generativa. Comience a construir el futuro con AWS hoy.

Sobre los autores

gopi krishnamurthy es arquitecto sénior de soluciones de IA/ML en Amazon Web Services con sede en la ciudad de Nueva York. Trabaja con grandes clientes automotrices como su asesor de confianza para transformar sus cargas de trabajo de aprendizaje automático y migrar a la nube. Sus principales intereses incluyen el aprendizaje profundo y las tecnologías sin servidor. Fuera del trabajo, le gusta pasar tiempo con su familia y explorar una amplia gama de música.

gopi krishnamurthy es arquitecto sénior de soluciones de IA/ML en Amazon Web Services con sede en la ciudad de Nueva York. Trabaja con grandes clientes automotrices como su asesor de confianza para transformar sus cargas de trabajo de aprendizaje automático y migrar a la nube. Sus principales intereses incluyen el aprendizaje profundo y las tecnologías sin servidor. Fuera del trabajo, le gusta pasar tiempo con su familia y explorar una amplia gama de música.

Shreyas Subramanian es un Arquitecto Principal de Soluciones especialista en AI/ML y ayuda a los clientes mediante el uso de Machine Learning para resolver sus desafíos comerciales utilizando la plataforma AWS. Shreyas tiene experiencia en optimización a gran escala y aprendizaje automático, y en el uso de aprendizaje automático y aprendizaje por refuerzo para acelerar las tareas de optimización.

Shreyas Subramanian es un Arquitecto Principal de Soluciones especialista en AI/ML y ayuda a los clientes mediante el uso de Machine Learning para resolver sus desafíos comerciales utilizando la plataforma AWS. Shreyas tiene experiencia en optimización a gran escala y aprendizaje automático, y en el uso de aprendizaje automático y aprendizaje por refuerzo para acelerar las tareas de optimización.

Sujitha Martín es científico aplicado en el Centro de Innovación en IA Generativa (GAIIC). Su experiencia se centra en la creación de soluciones de aprendizaje automático que involucran visión por computadora y procesamiento de lenguaje natural para diversos sectores verticales de la industria. En particular, tiene una amplia experiencia trabajando en conciencia situacional centrada en el ser humano y aprendizaje infundido en conocimiento para sistemas altamente autónomos.

Sujitha Martín es científico aplicado en el Centro de Innovación en IA Generativa (GAIIC). Su experiencia se centra en la creación de soluciones de aprendizaje automático que involucran visión por computadora y procesamiento de lenguaje natural para diversos sectores verticales de la industria. En particular, tiene una amplia experiencia trabajando en conciencia situacional centrada en el ser humano y aprendizaje infundido en conocimiento para sistemas altamente autónomos.

Francisco Calderón es científico de datos en el Centro de Innovación de IA Generativa (GAIIC). Como miembro de GAIIC, ayuda a descubrir el arte de lo posible con los clientes de AWS que utilizan tecnologías de IA generativa. En su tiempo libre, a Francisco le gusta tocar música y guitarra, jugar fútbol con sus hijas y disfrutar del tiempo con su familia.

Francisco Calderón es científico de datos en el Centro de Innovación de IA Generativa (GAIIC). Como miembro de GAIIC, ayuda a descubrir el arte de lo posible con los clientes de AWS que utilizan tecnologías de IA generativa. En su tiempo libre, a Francisco le gusta tocar música y guitarra, jugar fútbol con sus hijas y disfrutar del tiempo con su familia.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/foundational-vision-models-and-visual-prompt-engineering-for-autonomous-driving-applications/

- :posee

- :es

- :no

- :dónde

- $ UP

- 1

- 100

- 11

- 179

- 2014

- 214

- 225

- 30

- 40

- 500

- 7

- 70

- 804

- 91

- 97

- a

- capacidad

- Poder

- Nuestra Empresa

- arriba

- acelerador

- Acepta

- preciso

- alcanzado

- real

- adaptar

- la adición de

- avanzado

- avances

- Ventaja

- tutor

- Después

- AI

- AI / ML

- AL

- Todos

- permite

- a lo largo de

- ya haya utilizado

- también

- Aunque

- Amazon

- Reconocimiento de amazonas

- Amazon SageMaker

- JumpStart de Amazon SageMaker

- Amazon Web Services

- an

- y

- https://www.youtube.com/watch?v=xB-eutXNUMXJtA&feature=youtu.be

- cualquier

- nadie

- cualquier cosa

- abejas

- aplicable

- Aplicación

- aplicaciones

- aplicada

- enfoque

- arquitectura

- somos

- Reservada

- áreas

- en torno a

- Formación

- Arte

- AS

- Ayuda

- asumir

- asume

- At

- automotor

- autónomo

- Hoy Disponibles

- conciencia

- AWS

- fondo

- bases

- basado

- conceptos básicos

- BE

- porque

- a las que has recomendado

- esto

- comenzar

- detrás de

- beneficios

- mejores

- mil millones

- Azul

- frontera

- Box

- cajas

- ruptura

- en general

- build

- constructores

- Construir la

- construido

- pero

- by

- calcular

- llamar al

- cámara

- cámaras

- PUEDEN

- Puede conseguir

- de

- servicios sociales

- carros

- case

- cases

- categoría

- Categoría

- abastecimiento

- Reubicación

- cadena

- cadenas

- retos

- manera?

- Ciudad

- limpia

- Cerrar

- cerrado

- de cerca

- Soluciones

- Coco

- código

- combinación

- combina

- combinar

- Algunos

- compañía

- comparar

- en comparación con

- computational

- Calcular

- computadora

- Visión por computador

- concepto

- conceptos

- contexto

- coordinar

- Core

- Cubiertas

- creado

- Cruz

- Current

- Estado actual

- Clientes

- Corte

- datos

- científico de datos

- conjuntos de datos

- profundo

- deep learning

- definir

- se define

- demostrado

- descrito

- deseado

- Detección

- una experiencia diferente

- dino

- directamente

- descrubrir

- discutir

- discutido

- distribuciones

- diverso

- do

- No

- dominio

- dominios

- No

- drásticamente,

- conductor

- conducción

- dos

- e

- E & T

- cada una

- pasan fácilmente

- Southern Implants

- incrustación

- emergentes

- permite

- permitiendo

- anima

- Ingeniería

- Entretenimiento

- Todo

- épocas

- esencial

- evaluación

- ejemplo

- ejemplos

- expansivo

- esperar

- experience

- experimentos

- Experiencia

- Explica

- explicación

- explícitamente

- explorar

- explorado

- expresiones

- en los detalles

- Amplia experiencia

- extraerlos

- Cara

- bastante

- familiar

- familia

- Feature

- pocos

- campo

- Figura

- filtrar

- final

- Encuentre

- Nombre

- se centra

- enfoque

- siguiendo

- formulario

- Fundación

- Fundacional

- Digital XNUMXk

- Marco conceptual

- Francisco

- Desde

- frontal o trasero

- ser completados

- completamente

- promover

- futuras

- generar

- genera

- la generación de

- generativo

- IA generativa

- obtener

- dado

- da

- candidato

- Verde

- Polo a Tierra

- guía

- mano

- Tienen

- es

- he

- la salud

- ayuda

- aquí

- esta página

- Alta

- alta calidad

- más alto

- altamente

- su

- mantiene

- capucha

- esperanza

- Cómo

- HTML

- HTTPS

- enorme

- no haber aun identificado una solucion para el problema

- identifica

- Identifique

- identificar

- imagen

- imágenes

- inmediatamente

- implementar

- impresionante

- mejorar

- mejorado

- es la mejora continua

- in

- incluir

- Incluye

- aumente

- Los aumentos

- creciente

- energético

- información

- infundido

- inicial

- Innovation

- Las opciones de entrada

- entradas

- inspirado

- ejemplo

- Segmentación de instancia

- Instrucciones

- intención

- intereses

- interesado

- interesante

- intereses

- dentro

- involucrar

- que implica

- IT

- iteraciones

- SUS

- jpg

- solo

- tan siquiera solo una

- especialistas

- conocido

- Label

- Etiquetas

- Lane

- idioma

- large

- Gran escala

- mayores

- mayor

- Finalmente

- Estado latente

- APRENDE:

- aprendizaje

- izquierda

- menos

- Nivel

- Biblioteca

- Licencia

- se encuentra

- Vida

- Ciencias de la vida

- ligero

- como

- Me gusta

- limitaciones

- límites

- lin

- Lista

- pequeño

- LLM

- Ubicación

- Mira

- mirando

- MIRADAS

- Baja

- máquina

- máquina de aprendizaje

- HACE

- Realizar

- gestionado

- manual

- muchos

- casarse

- máscara

- Mascarillas

- masivo

- Puede..

- significa

- Medios

- mediano

- miembro

- Meta

- Métrica

- migrado

- millones

- mente

- mínimo

- ML

- modelo

- modelos

- Modificaciones

- Módulo

- más,

- MEJOR DE TU

- Motivación

- mucho más

- múltiples

- Música

- nombre

- nombres

- Natural

- Procesamiento natural del lenguaje

- necesariamente

- Nuevo

- New York

- Ciudad de Nueva York

- Next

- no

- señaló

- número

- objeto

- Detección de objetos

- objetivo

- objetos

- of

- off

- on

- ONE

- optimización

- or

- reconocida por

- Otro

- "nuestr

- salir

- Resultado

- salida

- salidas

- afuera

- Más de

- pares

- parámetro

- parámetros

- particular

- partes

- Patch

- (PDF)

- percepción

- Realizar

- actuación

- realizado

- Personalmente

- imagen

- .

- industrial

- pixel

- avión

- plataforma

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Jugar

- jugando

- punto

- puntos

- Popular

- posible

- Publicación

- posible

- industria

- predecir

- primario

- Director de la escuela

- Anterior

- Procesado

- tratamiento

- producir

- produce

- proporción

- ofrece

- Demostrar.

- proporcionar

- previsto

- proporciona un

- proporcionando

- propósito

- calidad

- XNUMX% automáticos

- la cantidad

- pregunta

- distancia

- en tiempo real

- realmente

- razones

- reciente

- Rojo

- reducir

- remitir

- se refiere

- región

- regiones

- relacionado

- Informes

- Requisitos

- requiere

- Recurso

- respeto

- respuesta

- resultado

- Resultados

- revolucionar

- Rico

- Derecho

- carretera

- correr

- sabio

- Diana

- mismo

- Sierra

- Escala

- escena

- CIENCIAS

- Científico

- Puntuación

- Segundo

- (secciones)

- ver

- visto

- segmento

- segmentación

- segmentos

- mayor

- separado

- Sin servidor

- de coches

- Servicios

- set

- Varios

- ella

- tienes

- Mostrar

- mostrar

- mostrado

- Shows

- firmar

- importante

- Letreros y Pancartas

- Silver

- similares

- sencillos

- singular

- Tamaño

- tamaños

- habilidad

- espacio

- ranuras

- chica

- menores

- retazo

- So

- Fútbol

- Soluciones

- RESOLVER

- algo

- Fuente

- Fuentes

- especialista

- soluciones y

- específicamente

- pasar

- dividido

- Stacks

- estándar

- comienzo

- Estado

- pasos

- Sin embargo

- sencillo

- fortalezas

- estructura

- estructurando

- Luchas

- exitosos

- tal

- soportes

- incomparable

- Todas las funciones a su disposición

- mesa

- ¡Prepárate!

- toma

- Tarea

- tareas

- técnicas

- Tecnologías

- plantilla

- plantillas

- términos

- probado

- pruebas

- texto

- textual

- que

- esa

- La

- El Área

- Lo esencial

- El futuro de las

- la información

- su

- Ahí.

- Estas

- así

- pensamiento

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- neumáticos

- a

- hoy

- del IRS

- parte superior

- Total

- Seguimiento

- tráfico

- entrenado

- Formación

- Transformar

- transformador

- camión

- verdadero

- de confianza

- verdad

- try

- dos

- tipo

- principiante

- bajo

- entender

- us

- usable

- Uso

- utilizan el

- caso de uso

- casos de uso

- usado

- Usuario

- usando

- Valores

- diversos

- Vasto

- vegetación

- Vehículos

- versión

- versiones

- verticales

- muy

- Video

- visión

- visual

- vs

- W

- fue

- formas

- we

- web

- servicios web

- WELL

- fuimos

- tuvieron

- ¿

- Que es

- cuando

- mientras

- que

- todo

- amplio

- Amplia gama

- extensamente

- seguirá

- dentro de

- sin

- fue testigo de

- palabras

- Actividades:

- flujos de trabajo

- trabajando

- funciona

- se

- la escritura

- X

- años

- york

- Usted

- tú

- zephyrnet