- Sábado, Junio 30, 2014

- Vasilis Vryniotis

- . Sin comentarios

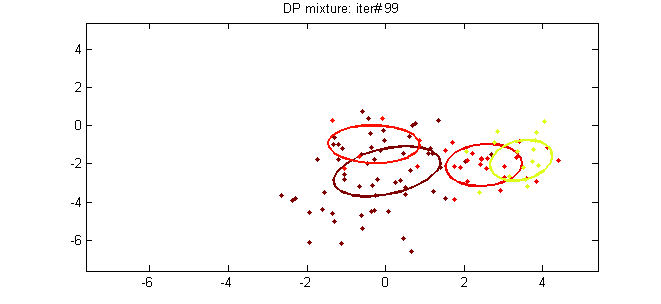

Este artículo es la quinta parte del tutorial sobre Agrupación con DPMM. En las publicaciones anteriores cubrimos en detalle los antecedentes teóricos del método y describimos sus representaciones matemáticas y las formas de construirlo. En esta publicación intentaremos vincular la teoría con la práctica mediante la introducción de dos modelos DPMM: el Modelo de mezcla normal multivariante de Dirichlet que se puede usar para agrupar datos gaussianos y el Modelo de mezcla multinomial de Dirichlet que se usa para agrupar documentos.

Actualización: el marco de aprendizaje automático de Datumbox ahora es de código abierto y gratuito para descargar. Consulte el paquete com.datumbox.framework.machinelearning.clustering para ver la implementación de los modelos de mezcla de procesos de Dirichlet en Java.

1. El modelo de mezcla normal multivariante de Dirichlet

El primer modelo de mezcla de Proceso de Dirichlet que examinaremos es el Modelo de mezcla normal multivariante de Dirichlet que se puede usar para realizar la agrupación en conjuntos de datos continuos. El modelo de mezcla se define de la siguiente manera:

![]()

![]()

![]()

Ecuación 1: Modelo de mezcla normal multivariante de Dirichlet

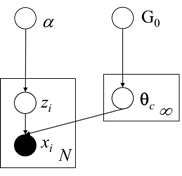

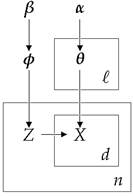

Como podemos ver arriba, el modelo particular supone que la Distribución Generativa es la Distribución Gaussiana Multinomial y utiliza el proceso del Restaurante Chino como antes para las asignaciones de conglomerados. Además para la distribución Base G0 utiliza el Normal-Inverso-Wishart anterior, que es conjugar antes de distribución normal multivariante con media desconocida y matriz de covarianza. A continuación presentamos el modelo gráfico del modelo de mezcla:

Figura 1: Modelo gráfico del modelo de mezcla normal multivariante de Dirichlet

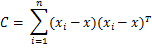

Como discutimos anteriormente, para poder estimar las asignaciones de clúster, usaremos el Muestreo contraído de Gibbs que requiere seleccionar el anteriores conjugados apropiados. Además, tendremos que actualizar los parámetros posteriores dados lo anterior y la evidencia. Abajo vemos el Estimaciones de MAP de los parámetros para uno de los grupos:

![]()

![]()

![]()

![]()

![]()

Ecuación 2: Estimaciones de MAP en parámetros de clúster

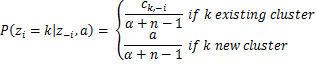

Donde d es la dimensionalidad de nuestros datos y ![]() es la media de la muestra Además, tenemos varios hiperparámetros del Normal-Inverse-Wishart, como el μ0 cual es la media inicial, κ0 es la fracción media que funciona como parámetro de suavizado, ν0 es el grado de libertad que se establece en el número de dimensiones y Ψ0 es el producto de desviación por pares que se establece en la matriz de identidad dxd multiplicada por una constante. De ahora en adelante, todos los hiperparámetros anteriores de G0 será denotado por λ para simplificar la notación. Finalmente al tener todo lo anterior, podemos estimar las probabilidades que requiere el muestreador de Gibbs contraído. La probabilidad de que la observación i pertenezca al grupo k dadas las asignaciones del grupo, el conjunto de datos y todos los hiperparámetros α y λ de DP y G0 se da a continuación:

es la media de la muestra Además, tenemos varios hiperparámetros del Normal-Inverse-Wishart, como el μ0 cual es la media inicial, κ0 es la fracción media que funciona como parámetro de suavizado, ν0 es el grado de libertad que se establece en el número de dimensiones y Ψ0 es el producto de desviación por pares que se establece en la matriz de identidad dxd multiplicada por una constante. De ahora en adelante, todos los hiperparámetros anteriores de G0 será denotado por λ para simplificar la notación. Finalmente al tener todo lo anterior, podemos estimar las probabilidades que requiere el muestreador de Gibbs contraído. La probabilidad de que la observación i pertenezca al grupo k dadas las asignaciones del grupo, el conjunto de datos y todos los hiperparámetros α y λ de DP y G0 se da a continuación:

![]()

![]()

Ecuación 3: Probabilidades utilizadas por Gibbs Sampler para MNMM

Donde zi es la asignación de grupo de observación xi, X1: n es el conjunto de datos completo, z-i es el conjunto de asignaciones de clúster sin el de la ith observación, x-i es el conjunto de datos completo, excluyendo el ith observación, ck,-yo es el número total de observaciones asignadas al grupo k excluyendo el ith observación mientras ![]() y

y ![]() son la media y la matriz de covarianza del grupo k, excluyendo el ith observación.

son la media y la matriz de covarianza del grupo k, excluyendo el ith observación.

2. El modelo de mezcla Dirichlet-Multinomial

El modelo de mezcla Dirichlet-Multinomial se utiliza para realizar análisis de documentos en conglomerados. El modelo particular tiene una jerarquía un poco más complicada ya que modela los temas / categorías de los documentos, las probabilidades de palabras dentro de cada tema, las asignaciones de conglomerados y la distribución generativa de los documentos. Su objetivo es realizar un aprendizaje no supervisado y agrupar una lista de documentos asignándolos a grupos. El modelo de mezcla se define de la siguiente manera:

![]()

![]()

![]()

![]()

Ecuación 4: Modelo de mezcla de Dirichlet-Multinomial

Donde φ modela las probabilidades del tema, zi es un selector de tema, θk son las probabilidades de la palabra en cada grupo y xi, j representa las palabras del documento. Debemos tener en cuenta que esta técnica utiliza el marco de bolsa de palabras que representa los documentos como una colección desordenada de palabras, sin tener en cuenta la gramática y el orden de las palabras. Esta representación simplificada se usa comúnmente en el procesamiento del lenguaje natural y la recuperación de información. A continuación presentamos el modelo gráfico del modelo de mezcla:

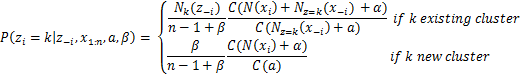

Figura 2: Modelo gráfico del modelo de mezcla de Dirichlet-Multinomial

El modelo particular usa Distribución discreta multinomial para la distribución generativa y distribuciones de Dirichlet para los anteriores. El ℓ es el tamaño de nuestros grupos activos, el n el número total de documentos, el β controla el número esperado de grupos a priori, mientras que el α controla el número de palabras asignadas a cada grupo. Para estimar las probabilidades que requiere el Muestra de Gibbs contraída usamos el siguiente ecuación:

![]()

Ecuación 5: Probabilidades utilizadas por Gibbs Sampler para DMMM

Donde Γ es la función gamma, zi es la asignación de clúster del documento xi, X1: n es el conjunto de datos completo, z-i es el conjunto de asignaciones de clúster sin el de la ith documento, x-i es el conjunto de datos completo, excluyendo el ith documento, Nk(z-i) es el número de observaciones asignadas al grupo k excluyendo ith documento, Nz=k(x-i) es un vector con las sumas de recuentos de cada palabra para todos los documentos asignados al grupo k, excluido ith documento y N (xi) es el vector disperso con los recuentos de cada palabra en el documento xi. Finalmente, como podemos ver arriba, al usar el Sampler de Gibbs contraído con el proceso de restaurante chino, θjk La variable que almacena la probabilidad de la palabra j en el tema k puede integrarse.

- AI

- arte ai

- generador de arte ai

- robot ai

- inteligencia artificial

- certificación de inteligencia artificial

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- Caja de datos

- deep learning

- google ai

- máquina de aprendizaje

- Aprendizaje automático y estadísticas

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- zephyrnet