Inteligencia Artificial (AI) ha creado furor recientemente con su posibilidad de revolucionar la forma en que las personas abordan y resuelven diferentes tareas y problemas complejos. Desde la atención sanitaria hasta las finanzas, la IA y sus modelos de aprendizaje automático asociados han demostrado su potencial para agilizar procesos complejos, mejorar los patrones de toma de decisiones y descubrir conocimientos valiosos.

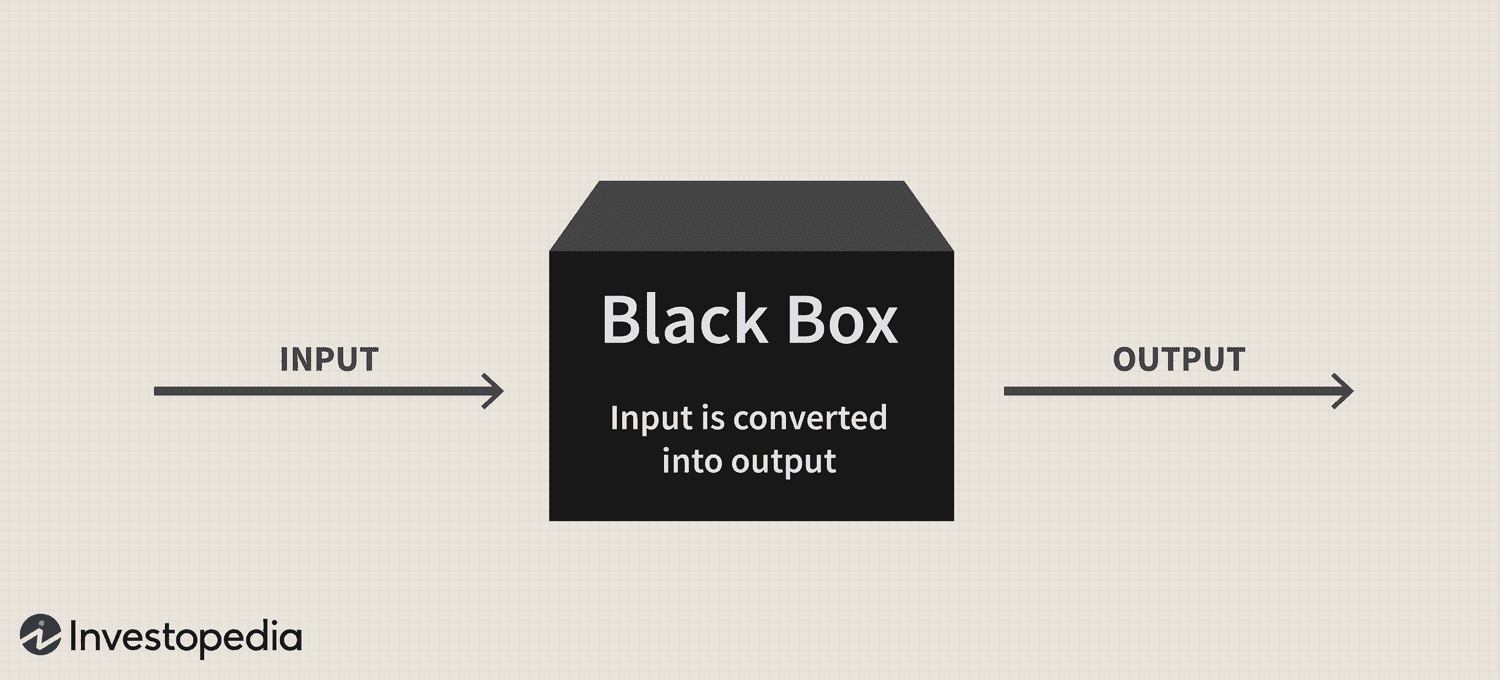

Sin embargo, a pesar del inmenso potencial de la tecnología, un problema persistente de "caja negra" ha seguido presentando un desafío importante para su adopción, lo que genera dudas sobre la transparencia y la interpretabilidad de estos sistemas sofisticados.

En resumen, el problema de la caja negra surge de la dificultad para comprender cómo los sistemas de IA y los modelos de aprendizaje automático procesan datos y generan predicciones o decisiones. Estos modelos a menudo se basan en algoritmos intrincados que no son fácilmente comprensibles para los humanos, lo que lleva a una falta de responsabilidad y confianza.

Por lo tanto, a medida que la IA se integra cada vez más en varios aspectos de nuestras vidas, abordar este problema es crucial para garantizar el uso responsable y ético de esta poderosa tecnología.

La caja negra: una visión general

La metáfora de la “caja negra” se deriva de la noción de que los sistemas de IA y los modelos de aprendizaje automático funcionan de una manera oculta a la comprensión humana, como el contenido de una caja sellada y opaca. Estos sistemas se basan en modelos matemáticos complejos y conjuntos de datos de alta dimensión, que crean relaciones y patrones intrincados que guían sus procesos de toma de decisiones. Sin embargo, estos mecanismos internos no son fácilmente accesibles o comprensibles para los humanos.

En términos prácticos, el problema de la caja negra de la IA es la dificultad de descifrar el razonamiento detrás de las predicciones o decisiones de un sistema de IA. Este problema es particularmente frecuente en los modelos de aprendizaje profundo como las redes neuronales, donde varias capas de nodos interconectados procesan y transforman los datos de manera jerárquica. La complejidad de estos modelos y las transformaciones no lineales que realizan hacen que sea extremadamente difícil rastrear la lógica detrás de sus resultados.

Nikita Brudnov, CEO de BR Group, un tablero de análisis de marketing basado en IA, le dijo a Cointelegraph que la falta de transparencia en la forma en que los modelos de IA llegan a ciertas decisiones y predicciones podría ser problemática en muchos contextos, como el diagnóstico médico, la toma de decisiones financieras y procedimientos legales, lo que impacta significativamente en la adopción continua de la IA.

Magazine: Joe Lubin: La verdad sobre la separación de los fundadores de ETH y 'Crypto Google'

“En los últimos años, se ha prestado mucha atención al desarrollo de técnicas para interpretar y explicar las decisiones tomadas por los modelos de IA, como generar puntajes de importancia de características, visualizar los límites de las decisiones e identificar explicaciones hipotéticas contrafactuales”, dijo, y agregó:

“Sin embargo, estas técnicas aún están en pañales y no hay garantía de que sean efectivas en todos los casos”.

Brudnov cree además que con una mayor descentralización, los reguladores pueden requerir que las decisiones tomadas por los sistemas de IA sean más transparentes y responsables para garantizar su validez ética y equidad general. También sugirió que los consumidores pueden dudar en usar productos y servicios impulsados por IA si no entienden cómo funcionan y su proceso de toma de decisiones.

James Wo, el fundador de DFG, una firma de inversión que invierte activamente en tecnologías relacionadas con la IA, cree que el problema de la caja negra no afectará la adopción en el futuro previsible. Según Wo, a la mayoría de los usuarios no les importa necesariamente cómo funcionan los modelos de IA existentes y están felices de simplemente obtener utilidad de ellos, al menos por ahora.

“A mediano plazo, una vez que la novedad de estas plataformas desaparezca, definitivamente habrá más escepticismo sobre la metodología de la caja negra. Las preguntas también aumentarán a medida que el uso de IA entre en criptografía y Web3, donde hay riesgos financieros y consecuencias a considerar”, admitió.

Impacto en la confianza y la transparencia

Un dominio donde la ausencia de transparencia puede afectar sustancialmente la confianza es el diagnóstico médico impulsado por IA. Por ejemplo, los modelos de IA pueden analizar datos médicos complejos en el cuidado de la salud para generar diagnósticos o recomendaciones de tratamiento. Sin embargo, cuando los médicos y los pacientes no pueden comprender la lógica detrás de estas sugerencias, pueden cuestionar la confiabilidad y validez de estas ideas. Este escepticismo puede conducir aún más a la vacilación en la adopción de soluciones de IA, lo que podría impedir los avances en la atención al paciente y la medicina personalizada.

En el ámbito financiero, los sistemas de IA se pueden emplear para la calificación crediticia, la detección de fraudes y la evaluación de riesgos. Sin embargo, el problema de la caja negra puede crear incertidumbre con respecto a la equidad y precisión de estos puntajes de crédito o el razonamiento detrás de las alertas de fraude, lo que limita la capacidad de la tecnología para digitalizar la industria.

La industria de las criptomonedas también enfrenta las repercusiones del problema de la caja negra. Por ejemplo, los activos digitales y la tecnología blockchain se basan en la descentralización, la apertura y la verificabilidad. Los sistemas de IA que carecen de transparencia e interpretabilidad pueden formar una desconexión entre las expectativas del usuario y la realidad de las soluciones impulsadas por IA en este espacio.

Preocupaciones regulatorias

Desde un punto de vista regulatorio, el problema de la caja negra de la IA presenta desafíos únicos. Para empezar, la opacidad de los procesos de IA puede dificultar cada vez más que los reguladores evalúen el cumplimiento de estos sistemas con las normas y directrices existentes. Además, la falta de transparencia puede complicar la capacidad de los reguladores para desarrollar nuevos marcos que puedan abordar los riesgos y desafíos que plantean las aplicaciones de IA.

Los legisladores pueden tener dificultades para evaluar la imparcialidad, el sesgo y las prácticas de privacidad de datos de los sistemas de IA, y su impacto potencial en los derechos del consumidor y la estabilidad del mercado. Además, sin una comprensión clara de los procesos de toma de decisiones de los sistemas impulsados por IA, los reguladores pueden enfrentar dificultades para identificar vulnerabilidades potenciales y garantizar que se implementen las salvaguardas adecuadas para mitigar los riesgos.

Un avance regulatorio notable con respecto a esta tecnología ha sido la Ley de Inteligencia Artificial de la Unión Europea, que se acerca a formar parte del estatuto del bloque tras alcanzar un acuerdo político provisional el 27 de abril.

En esencia, la Ley de IA tiene como objetivo crear un entorno confiable y responsable para el desarrollo de la IA dentro de la UE. Los legisladores han adoptado un sistema de clasificación que categoriza diferentes tipos de IA por riesgo: inaceptable, alto, limitado y mínimo. Este marco está diseñado para abordar varias preocupaciones relacionadas con el problema de la caja negra de la IA, incluidos los problemas relacionados con la transparencia y la responsabilidad.

La incapacidad de monitorear y regular de manera efectiva los sistemas de IA ya ha tensado las relaciones entre diferentes industrias y organismos reguladores.

A principios del mes pasado, el popular chatbot de IA ChatGPT fue prohibido en Italia durante 29 días, principalmente debido a preocupaciones de privacidad planteadas por la agencia de protección de datos del país por sospechas de violaciones del Reglamento General de Protección de Datos (GDPR) de la UE. Sin embargo, a la plataforma se le permitió reanudar sus servicios el 29 de abril después de que el CEO Sam Altman anunciara que él y su equipo habían tomado medidas específicas para cumplir con las demandas del regulador, incluida la revelación de sus prácticas de procesamiento de datos y la implementación de su sistema de edad. medidas de compuerta.

La regulación inadecuada de los sistemas de IA podría erosionar la confianza pública en las aplicaciones de IA a medida que los usuarios se preocupan cada vez más por los sesgos inherentes, las imprecisiones y las implicaciones éticas.

Abordar el problema de la caja negra

Para abordar el problema de la caja negra de la IA de manera efectiva, es esencial emplear una combinación de enfoques que promuevan la transparencia, la interpretabilidad y la responsabilidad. Dos de estas estrategias complementarias son la IA explicable (XAI) y los modelos de código abierto.

XAI es un área de investigación dedicada a cerrar la brecha entre la complejidad de los sistemas de IA y la necesidad de interpretación humana. XAI se centra en el desarrollo de técnicas y algoritmos que pueden proporcionar explicaciones comprensibles para los humanos para las decisiones impulsadas por la IA, ofreciendo información sobre el razonamiento detrás de estas elecciones.

Los métodos empleados a menudo en XAI incluyen modelos sustitutos, análisis de importancia de características, análisis de sensibilidad y explicaciones independientes del modelo interpretables locales. La implementación de XAI en todas las industrias puede ayudar a las partes interesadas a comprender mejor los procesos impulsados por IA, mejorando la confianza en la tecnología y facilitando el cumplimiento de los requisitos normativos.

Junto con XAI, promover la adopción de modelos de IA de código abierto puede ser una estrategia eficaz para abordar el problema de la caja negra. Los modelos de código abierto otorgan acceso completo a los algoritmos y datos que impulsan los sistemas de IA, lo que permite a los usuarios y desarrolladores examinar y comprender los procesos subyacentes.

Esta mayor transparencia puede ayudar a generar confianza y fomentar la colaboración entre desarrolladores, investigadores y usuarios. Además, el enfoque de código abierto puede crear sistemas de IA más robustos, responsables y efectivos.

El problema de la caja negra en el espacio criptográfico

El problema de la caja negra tiene ramificaciones significativas para varios aspectos del espacio criptográfico, incluidas las estrategias comerciales, las predicciones del mercado, las medidas de seguridad, la tokenización y los contratos inteligentes.

En el ámbito de las estrategias comerciales y las predicciones de mercado, los modelos impulsados por IA están ganando popularidad a medida que los inversores buscan capitalizar el comercio algorítmico. Sin embargo, el problema de la caja negra dificulta la comprensión de los usuarios sobre cómo funcionan estos modelos, lo que dificulta la evaluación de su eficacia y riesgos potenciales. En consecuencia, esta opacidad también puede dar lugar a una confianza injustificada en las decisiones de inversión impulsadas por la IA o hacer que los inversores dependan demasiado de los sistemas automatizados.

La IA desempeñará un papel crucial en la mejora de las medidas de seguridad dentro del ecosistema de la cadena de bloques mediante la detección de transacciones fraudulentas y actividades sospechosas. Sin embargo, el problema de la caja negra complica el proceso de verificación de estas soluciones de seguridad impulsadas por IA. La falta de transparencia en la toma de decisiones puede erosionar la confianza en los sistemas de seguridad, lo que genera inquietudes sobre su capacidad para salvaguardar los activos y la información de los usuarios.

La tokenización y los contratos inteligentes, dos componentes vitales del ecosistema blockchain, también están presenciando una mayor integración de la IA. Sin embargo, el problema de la caja negra puede oscurecer la lógica detrás de los tokens generados por IA o la ejecución de contratos inteligentes.

A medida que la IA revoluciona varias industrias, abordar el problema de la caja negra se vuelve más apremiante. Al fomentar la colaboración entre investigadores, desarrolladores, legisladores y partes interesadas de la industria, se pueden desarrollar soluciones para promover la transparencia, la responsabilidad y la confianza en los sistemas de IA. Por lo tanto, será interesante ver cómo sigue evolucionando este nuevo paradigma tecnológico.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoAiStream. Inteligencia de datos Web3. Conocimiento amplificado. Accede Aquí.

- Acuñando el futuro con Adryenn Ashley. Accede Aquí.

- Compra y Vende Acciones en Empresas PRE-IPO con PREIPO®. Accede Aquí.

- Fuente: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- :posee

- :es

- :no

- :dónde

- 2023

- 27

- a

- capacidad

- Nuestra Empresa

- de la máquina

- accesible

- seguimiento semanal

- cuentas

- la exactitud

- a través de

- Actúe

- activamente

- actividades

- la adición de

- Adicionalmente

- dirección

- direccionamiento

- adoptado

- Adopción

- Adopción

- avances

- afectar

- Después

- Agreement

- AI

- Ley de IA

- Chat de AI

- Alimentado por IA

- paquete de capacitación DWoVH

- Alertas

- algorítmico

- comercio algorítmico

- algoritmos

- Todos

- ya haya utilizado

- también

- entre

- an

- análisis

- Analytics

- analizar

- y

- anunció

- aplicaciones

- enfoque

- enfoques

- adecuado

- Abril

- somos

- Reservada

- en torno a

- artificial

- inteligencia artificial

- AS

- aspectos

- evaluación

- Activos

- asociado

- At

- Confirmación de Viaje

- BE

- a las que has recomendado

- se convierte en

- cada vez

- esto

- detrás de

- cree

- mejores

- entre

- parcialidad

- los prejuicios

- Negro

- blockchain

- ecosistema blockchain

- la tecnología blockchain

- cuerpos

- primer libro

- límites

- Box

- puente

- build

- generar confianza

- construido

- negocios

- by

- PUEDEN

- no puede

- capitalizar

- servicios sociales

- cases

- ceo

- a ciertos

- Reto

- retos

- desafiante

- chatterbot

- ChatGPT

- opciones

- clasificación

- sistema de clasificación

- limpiar

- los médicos

- Cointelegraph

- colaboración

- combinación

- complementario

- integraciones

- complejidad

- compliance

- componentes

- comprender

- preocupado

- Inquietudes

- Consecuencias

- En consecuencia

- Considerar

- consumidor

- Derechos del consumidor

- Clientes

- contenido

- contextos

- continuado

- continúa

- contrato

- contratos

- Core

- podría

- País del

- Para crear

- creado

- crédito

- crucial

- cripto

- Industria criptográfica

- espacio criptográfico

- página de información de sus operaciones

- datos

- privacidad de datos

- proceso de datos

- protección de datos

- conjuntos de datos

- Descentralización

- Koops

- Toma de Decisiones

- decisiones

- a dedicados

- profundo

- deep learning

- que probar definitivamente

- demandas

- demostrado

- diseñado

- A pesar de las

- Detección

- desarrollar

- desarrollado

- desarrolladores

- el desarrollo

- Desarrollo

- una experiencia diferente

- difícil

- dificultades

- Dificultad

- digital

- Acciones digitales

- digitalizar

- do

- dominio

- No

- el lado de la transmisión

- dos

- pasan fácilmente

- ecosistema

- Eficaz

- de manera eficaz

- eficacia

- empleado

- permitiendo

- mejorar

- mejorar

- garantizar

- asegurando que

- Entra en

- Entorno

- esencial

- ETH

- ético

- EU

- Europea

- evaluar

- evoluciona

- ejemplo

- ejecución

- existente

- las expectativas

- explicando

- Cara

- caras

- facilitando

- justicia

- Feature

- financiar

- financiero

- Firme

- se centra

- previsible

- formulario

- Cuidados de acogida

- el fomento de

- fundador

- fundadores

- Marco conceptual

- marcos

- fraude

- detección de fraude

- fraudulento

- Desde

- ser completados

- función

- promover

- Además

- futuras

- ganando

- brecha

- RGPD

- General

- informacion General

- generar

- la generación de

- conceder

- Grupo procesos

- garantizamos

- guía

- orientaciones

- tenido

- Ahorrar

- Tienen

- he

- la salud

- ayuda

- Alta

- obstaculiza

- su

- Cómo

- Sin embargo

- HTTPS

- humana

- Humanos

- identificar

- if

- inmenso

- Impacto

- impactando

- implementación

- implementación

- implicaciones

- importancia

- in

- incapacidad

- incluir

- Incluye

- aumente

- aumentado

- cada vez más

- industrias

- energético

- información

- inherente

- Insights

- COMPLETAMENTE

- integración

- Intelligence

- interconectado

- intereses

- interesante

- dentro

- inversión extranjera

- Inversionistas

- Invierte

- cuestiones

- IT

- Italia

- SUS

- Falta

- Apellido

- legisladores

- ponedoras

- Lead

- líder

- aprendizaje

- menos

- Legal

- procedimientos legales

- como

- Limitada

- Vidas

- local

- lógica

- máquina

- máquina de aprendizaje

- hecho

- para lograr

- Realizar

- manera

- muchos

- Mercado

- predicciones de mercado

- Marketing

- matemático

- Puede..

- medidas

- servicios

- datos médicos

- medicina

- Metodología

- podría

- mínimo

- Mitigar las

- modelos

- Monitorear

- Mes

- más,

- Por otra parte

- MEJOR DE TU

- emocionante

- mucho más

- múltiples

- necesariamente

- ¿ Necesita ayuda

- telecomunicaciones

- redes neuronales

- sin embargo

- Nuevo

- no

- nodos

- notable

- Noción

- novela

- novedad

- ahora

- of

- off

- que ofrece

- a menudo

- on

- una vez

- opaco

- de código abierto

- Apertura

- funcionar

- or

- nuestros

- total

- dinero

- paradigma

- parte

- particularmente

- paciente

- los pacientes

- .

- Personas

- Realizar

- Personalizado

- Colocar

- plataforma

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Jugar

- los responsables políticos

- político

- Popular

- popularidad

- posibilidad

- posible

- la posibilidad

- poderoso

- Metodología

- prácticas

- Predicciones

- presente

- regalos

- frecuente

- las cuales

- política de privacidad

- Problema

- problemas

- Proceso

- en costes

- tratamiento

- Productos

- promover

- Promoción

- Protección

- proporcionar

- provisional

- público

- confianza pública

- pregunta

- Preguntas

- elevado

- elevar

- razón fundamental

- alcanzando

- Realidad

- reino

- reciente

- recientemente

- recomendaciones

- con respecto a

- Regula tu

- Regulación

- reglamentos

- Reguladores

- regulador

- relacionado

- Relaciones

- fiabilidad

- confiar

- repercusiones

- exigir

- Requisitos

- la investigación

- investigadores

- responsable

- resultado

- currículum

- revolucionar

- revoluciona

- derechos

- Riesgo

- evaluación de riesgos

- riesgos

- robusto

- Función

- reglas

- salvaguardias

- Said

- Diana

- Sam Altman

- tanteo

- EN LINEA

- Medidas de Seguridad

- ver

- EL EQUIPO

- Sensibilidad

- Servicios

- Sets

- Mostrar

- importante

- significativamente

- simplemente

- Escepticismo

- inteligente

- contrato inteligente

- Contratos Inteligentes

- Soluciones

- RESOLVER

- sofisticado

- Fuente

- Espacio

- soluciones y

- dividido

- Estabilidad

- las partes interesadas

- stand

- es la

- deriva

- pasos

- Sin embargo

- estrategias

- Estrategia

- aerodinamizar

- Luchar

- tal

- suspicaz

- te

- Todas las funciones a su disposición

- Tandem

- tareas

- equipo

- tecnología

- técnicas

- Tecnologías

- Tecnología

- términos

- esa

- El

- su

- Les

- Ahí.

- Estas

- ellos

- así

- a

- Tokenization

- Tokens

- Trace

- Plataforma de

- Estrategias de negociación

- Transacciones

- Transformar

- transformaciones

- Transparencia

- transparente

- del mismo día

- Confía en

- digno de confianza

- verdad

- dos

- tipos

- Incertidumbre

- descubrir

- subyacente

- entender

- comprensible

- comprensión

- único

- a

- us

- utilizan el

- Usuario

- usuarios

- utilidad

- Valioso

- diversos

- Verificación

- Violaciónes

- vital

- Vulnerabilidades

- fue

- Web3

- cuando

- que

- seguirá

- dentro de

- sin

- presenciando

- wo

- Actividades:

- labores

- años

- zephyrnet