Los algoritmos de inteligencia artificial están diseñados para aprender a trompicones. En lugar de actualizar continuamente su base de conocimientos con nueva información a lo largo del tiempo como lo hacen los humanos, los algoritmos pueden aprender solo durante la fase de entrenamiento. Después de eso, su conocimiento permanece congelado; realizan la tarea para la que fueron entrenados sin poder seguir aprendiendo mientras lo hacen. Para aprender incluso una cosa nueva, los algoritmos deben volver a entrenarse desde cero. Es como si cada vez que conocieras a una nueva persona, la única manera de aprender su nombre fuera reiniciar tu cerebro.

El entrenamiento desde cero puede conducir a un comportamiento conocido como olvido catastrófico, donde una máquina incorpora nuevos conocimientos a costa de olvidar casi todo lo que ya ha aprendido. Esta situación surge debido a la forma en que los algoritmos de IA más poderosos de la actualidad, llamados redes neuronales, aprenden cosas nuevas.

Estos algoritmos se basan libremente en nuestro cerebro, donde el aprendizaje implica cambiar la fuerza de las conexiones entre las neuronas. Pero este proceso se complica. Las conexiones neuronales también representan conocimientos pasados, por lo que cambiarlas demasiado provocará el olvido.

Las redes neuronales biológicas han desarrollado estrategias durante cientos de millones de años para garantizar que la información importante permanezca estable. Pero las redes neuronales artificiales de hoy luchan por lograr un buen equilibrio entre el conocimiento nuevo y el antiguo. Sus conexiones se sobrescriben con demasiada facilidad cuando la red ve nuevos datos, lo que puede resultar en una falla repentina y grave para reconocer la información pasada.

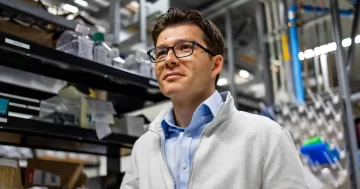

Para ayudar a contrarrestar esto, cristobal canan, un científico informático de 41 años de la Universidad de Rochester, ha ayudado a establecer un nuevo campo de investigación en IA conocido como aprendizaje continuo. Su objetivo es que la IA siga aprendiendo cosas nuevas a partir de flujos continuos de datos, y que lo haga sin olvidar todo lo que vino antes.

Kanan ha estado jugando con la inteligencia artificial casi toda su vida. Cuando era un niño en la zona rural de Oklahoma que solo quería divertirse con las máquinas, enseñó a los bots a jugar los primeros juegos de computadora para varios jugadores. Eso hizo que se preguntara sobre la posibilidad de una inteligencia general artificial, una máquina con la capacidad de pensar como un humano en todos los sentidos. Esto hizo que se interesara en cómo funciona la mente y se especializó en filosofía e informática en la Universidad Estatal de Oklahoma antes de que sus estudios de posgrado lo llevaran a la Universidad de California en San Diego.

Ahora Kanan encuentra inspiración no solo en los videojuegos, sino también en ver a su hija de casi 2 años aprender sobre el mundo, y cada nueva experiencia de aprendizaje se basa en la anterior. Debido a su trabajo y el de otros, el olvido catastrófico ya no es tan catastrófico.

¿Cuánto habló con Kanan sobre las memorias de las máquinas, romper las reglas del entrenamiento de las redes neuronales y si la IA alguna vez logrará un aprendizaje a nivel humano. La entrevista ha sido condensada y editada para mayor claridad.

¿Cómo influye tu formación en filosofía en la forma en que piensas sobre tu trabajo?

Me ha servido mucho como académico. La filosofía te enseña, "¿Cómo haces argumentos razonados" y "¿Cómo analizas los argumentos de los demás?" Eso es mucho de lo que haces en ciencia. Todavía tengo ensayos de aquel entonces sobre las fallas de la prueba de Turing y cosas por el estilo. Y esas cosas en las que todavía pienso mucho.

Mi laboratorio se ha inspirado en la pregunta: Bueno, si no podemos hacer X, ¿cómo vamos a poder hacer Y? Aprendemos con el tiempo, pero las redes neuronales, en general, no. Los entrenas una vez. Es una entidad fija después de eso. Y eso es algo fundamental que tendrías que resolver si quieres hacer inteligencia artificial general algún día. Si no puede aprender sin revolver su cerebro y reiniciar desde cero, realmente no vas a llegar allí, ¿verdad? Esa es una capacidad de requisito previo para mí.

¿Cómo han lidiado los investigadores con el olvido catastrófico hasta ahora?

El método más exitoso, llamado repetición, almacena experiencias pasadas y luego las reproduce durante el entrenamiento con nuevos ejemplos, para que no se pierdan. Está inspirado en la consolidación de la memoria en nuestro cerebro, donde durante el sueño se "reproducen" las codificaciones de alto nivel de las actividades del día a medida que las neuronas se reactivan.

En otras palabras, para los algoritmos, el nuevo aprendizaje no puede erradicar por completo el aprendizaje pasado, ya que estamos mezclando experiencias pasadas almacenadas.

Hay tres estilos para hacer esto. El estilo más común es la "reproducción verídica", donde los investigadores almacenan un subconjunto de las entradas sin procesar, por ejemplo, las imágenes originales para una tarea de reconocimiento de objetos, y luego mezclan esas imágenes almacenadas del pasado con nuevas imágenes para aprender. El segundo enfoque reproduce representaciones comprimidas de las imágenes. Un tercer método mucho menos común es la "reproducción generativa". Aquí, una red neuronal artificial en realidad genera una versión sintética de una experiencia pasada y luego mezcla ese ejemplo sintético con nuevos ejemplos. Mi laboratorio se ha centrado en los dos últimos métodos.

Desafortunadamente, sin embargo, la reproducción no es una solución muy satisfactoria.

¿Por qué no?

Para aprender algo nuevo, la red neuronal tiene que almacenar al menos alguna información sobre cada concepto que aprendió en el pasado. Y desde una perspectiva neurocientífica, la hipótesis es que tú y yo reproducimos una experiencia relativamente reciente, no algo que sucedió en nuestra infancia, para evitar olvidar esa experiencia reciente. Mientras que en la forma en que lo hacemos en redes neuronales profundas, eso no es cierto. No necesariamente tiene que almacenar todo lo que ha visto, pero tiene que almacenar algo sobre cada tarea que aprendió en el pasado para usar la reproducción. Y no está claro qué debería almacenar. Así que la repetición como se hace hoy todavía parece que no ha llegado hasta allí.

Si pudiéramos resolver por completo el olvido catastrófico, ¿significaría eso que la IA podría aprender cosas nuevas continuamente con el tiempo?

No exactamente. Creo que las grandes, grandes, grandes preguntas abiertas en el campo del aprendizaje continuo no están en el olvido catastrófico. Lo que realmente me interesa es: ¿Cómo el aprendizaje pasado hace que el aprendizaje futuro sea más eficiente? ¿Y cómo aprender algo en el futuro corrige los aprendizajes del pasado? Esas son cosas que no mucha gente está midiendo, y creo que hacerlo es una parte fundamental para impulsar el campo porque, en realidad, no se trata solo de olvidar cosas. Se trata de convertirse en un mejor estudiante.

Ahí es donde creo que el campo está perdiendo el bosque por los árboles. Gran parte de la comunidad está planteando el problema de formas que no coinciden ni con preguntas biológicas interesantes ni con aplicaciones de ingeniería interesantes. No podemos hacer que todos hagan el mismo problema de juguetes para siempre. Tienes que decir: ¿Cuál es nuestra tarea de guantelete? ¿Cómo empujamos las cosas hacia adelante?

Entonces, ¿por qué crees que la mayoría de la gente se centra en esos problemas simples?

Solo puedo especular. La mayor parte del trabajo lo realizan los estudiantes que están siguiendo el trabajo anterior. Están copiando la configuración de lo que otros han hecho y muestran algunas mejoras menores en el rendimiento con las mismas medidas. Es más probable que la creación de nuevos algoritmos conduzca a una publicación, incluso si esos algoritmos no nos permiten realmente hacer un progreso significativo en el aprendizaje continuo. Lo que me sorprende es que el mismo tipo de trabajo es producido por grandes empresas que no tienen los mismos incentivos, excepto el trabajo dirigido por becarios.

Además, este trabajo no es trivial. Necesitamos establecer el experimento correcto y la configuración algorítmica para medir si el aprendizaje pasado ayuda al aprendizaje futuro. El gran problema es que no tenemos buenos conjuntos de datos para estudiar el aprendizaje continuo en este momento. Quiero decir, básicamente estamos tomando conjuntos de datos existentes que se utilizan en el aprendizaje automático tradicional y reutilizándolos.

Esencialmente, en el dogma del aprendizaje automático (o al menos cada vez que empiezo a enseñar aprendizaje automático), tenemos un conjunto de entrenamiento, tenemos un conjunto de prueba: entrenamos en el conjunto de entrenamiento, probamos en el conjunto de prueba. El aprendizaje continuo rompe esas reglas. Su conjunto de entrenamiento se convierte en algo que evoluciona a medida que el alumno aprende. Pero todavía estamos limitados a los conjuntos de datos existentes. Tenemos que trabajar en esto. Necesitamos un entorno de aprendizaje continuo realmente bueno en el que podamos realmente esforzarnos.

¿Cómo sería el entorno ideal de aprendizaje continuo?

Es más fácil decirte lo que no es que lo que es. Estuve en un panel en el que identificamos esto como un problema crítico, pero creo que nadie tiene la respuesta de inmediato.

Te puedo decir las propiedades que podría tener. Entonces, por ahora, supongamos que los algoritmos de IA no son agentes encarnados en simulaciones. Entonces, al menos, idealmente, estamos aprendiendo de videos, o algo así, como secuencias de video multimodales, y con suerte haciendo más que una simple clasificación [de imágenes estáticas].

Hay muchas preguntas abiertas al respecto. Estuve en un taller de aprendizaje continuo hace unos años y algunas personas como yo decían: "Tenemos que dejar de usar un conjunto de datos llamado MNIST, es demasiado simple". Y luego alguien dijo: "OK, bueno, hagamos un aprendizaje incremental de [el videojuego basado en estrategia] StarCraft". Y yo también estoy haciendo eso ahora por varias razones, pero tampoco creo que eso realmente llegue a eso. La vida es mucho más rica que aprender a jugar a StarCraft.

¿Cómo ha intentado su laboratorio diseñar algoritmos que puedan seguir aprendiendo con el tiempo?

Con mi antiguo alumno Tyler Hayes, yo fue pionera en una tarea de aprendizaje continuo por razonamiento analógico. Pensamos que sería una buena área para estudiar la idea del aprendizaje por transferencia, donde adquieres habilidades y ahora necesitas usar habilidades más complejas para resolver problemas más complejos. Específicamente, medimos la transferencia hacia atrás: qué tan bien te ayuda en el futuro aprender algo en el pasado, y viceversa. Y encontramos buena evidencia de transferencia, mucho más significativa que para una tarea simple como el reconocimiento de objetos.

Su laboratorio también se enfoca en entrenar algoritmos para aprender continuamente de un ejemplo a la vez, o de conjuntos muy pequeños de ejemplos. ¿Cómo ayuda eso?

Muchas configuraciones de aprendizaje continuo todavía usan lotes muy grandes de ejemplos. Básicamente, le dirán al algoritmo: “Aquí hay 100,000 100,000 cosas; aprendelos. Aquí están las próximas XNUMX cosas; aprendelos." Eso realmente no coincide con lo que yo diría que es la aplicación del mundo real, que es: “Aquí hay algo nuevo; aprenderlo. Aquí hay otra cosa nueva; aprenderlo."

Si queremos que la IA aprenda más como nosotros, ¿deberíamos intentar replicar cómo los humanos aprenden diferentes cosas a diferentes edades, siempre refinando nuestro conocimiento?

Creo que es una vía muy fructífera para avanzar en este campo. La gente me dice que estoy obsesionada con el desarrollo ahora que tengo un hijo, pero puedo ver que mi hija es capaz de aprender de una sola vez, donde me ve hacer algo una vez y puede copiarlo de inmediato. Y los algoritmos de aprendizaje automático no pueden hacer nada de eso hoy.

Eso realmente me abrió los ojos. Tiene que haber mucho más en nuestras cabezas que en nuestras redes neuronales modernas. Es por eso que creo que el campo debe ir hacia esta idea de aprendizaje a lo largo del tiempo, donde los algoritmos se vuelven mejores aprendices al construir sobre la experiencia pasada.

¿Crees que la IA alguna vez realmente aprenderá de la misma manera que lo hacen los humanos?

Creo que lo harán. Definitivamente. Es mucho más prometedor hoy porque hay mucha gente trabajando en el campo. Pero todavía necesitamos más creatividad. Gran parte de la cultura en la comunidad de aprendizaje automático es un enfoque de seguimiento del líder.

Pienso en nosotros como simples máquinas bioquímicas, y eventualmente descubriremos cómo hacer nuestros algoritmos para las arquitecturas correctas que creo que tendrán más de nuestras capacidades que las que tienen hoy. No hay ningún argumento convincente para mí que diga que es imposible.