Introducción

De vez en cuando, una persona puede tomar un concepto abstracto que aparentemente es demasiado vago para un estudio formal y ofrecer una definición formal elegante. Claude Shannon lo hizo con información, y Andrey Kolmogorov lo hizo con aleatoriedad. Durante los últimos años, los investigadores han intentado hacer lo mismo con el concepto de equidad en el aprendizaje automático. Desafortunadamente, esto ha sido más complicado. El concepto no solo es más difícil de definir, sino que también es imposible que una sola definición satisfaga todas las métricas de equidad deseables. Arvind Narayanan, científico informático de la Universidad de Princeton, ha sido fundamental para contextualizar diferentes puntos de vista y ayudar a que este nuevo campo se establezca.

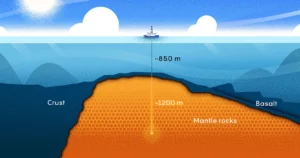

Su carrera abarcó todos los niveles de abstracción, desde la teoría hasta la política, pero el viaje que eventualmente lo llevó a su trabajo actual comenzó en 2006. Ese año, Netflix patrocinó una competencia que otorgaría $ 1 millón a quien mejorara la precisión de su sistema de recomendación por 10%. Netflix proporcionó un conjunto de datos supuestamente anónimos de usuarios y sus calificaciones, y se eliminó la información de identificación personal. Pero Narayanan demostró que con una técnica estadística sofisticada, solo necesita unos pocos puntos de datos para revelar la identidad de un usuario "anónimo" en el conjunto de datos.

Desde entonces, Narayanan se ha centrado en otras áreas donde la teoría se encuentra con la práctica. A través de Proyecto de Transparencia y Responsabilidad Web de Princeton, su equipo descubrió formas subrepticias en las que los sitios web rastrean a los usuarios y extraen datos confidenciales. Su equipo descubrió que un grupo como la Agencia de Seguridad Nacional podría usar datos de navegación web (específicamente, cookies colocadas por terceros) no solo para descubrir la identidad del usuario en el mundo real, sino también para reconstruir entre el 62 % y el 73 % de su historial de navegación. . Demostraron que, para bromear sobre el famoso Neoyorquino dibujos animados — en Internet, los sitios web ahora saben que eres un perro.

En los últimos años, Narayanan se ha centrado específicamente en máquina de aprendizaje — una aplicación de inteligencia artificial que otorga a las máquinas la capacidad de aprender de los datos. Si bien da la bienvenida a los avances en IA, señala cómo tales sistemas pueden fallar incluso con buenas intenciones, y cómo estas tecnologías útiles pueden convertirse en herramientas para justificar la discriminación. Bajo esta luz, los puntos aparentemente inconexos que han definido la trayectoria de investigación de Narayanan forman una especie de constelación.

¿Cuánto habló con Narayanan sobre su trabajo sobre la anonimización, la importancia de la intuición estadística y las muchas trampas de los sistemas de IA. La entrevista ha sido condensada y editada para mayor claridad.

Introducción

¿Siempre quisiste hacer investigación en matemáticas y ciencias?

Crecí muy interesado en ambos, pero principalmente en matemáticas. Era bueno resolviendo acertijos e incluso tuve cierto éxito en la Olimpiada Internacional de Matemáticas. Pero tenía un concepto muy erróneo sobre la diferencia entre la resolución de acertijos y la investigación matemática.

Y desde el principio, centré mi investigación en la criptografía, especialmente en la criptografía teórica, porque todavía trabajaba bajo la ilusión de que era muy bueno en matemáticas. Y luego, el resto de mi carrera ha sido un viaje para darme cuenta de que en realidad no es mi fortaleza en absoluto.

Eso debe haber servido como un buen antecedente para tu trabajo de anonimización.

Tienes razón. Lo que permitió la investigación de la anonimización es la habilidad que llamo intuición estadística. En realidad no es un conocimiento matemático formal. Es poder tener una intuición en tu cabeza como: "Si tomo este conjunto de datos complejos y le aplico esta transformación, ¿cuál es un resultado plausible?"

La intuición a menudo puede estar equivocada, y eso está bien. Pero es importante tener intuición porque puede guiarlo hacia caminos que pueden ser fructíferos.

Introducción

¿Cómo ayudó la intuición estadística con su trabajo en los datos de Netflix?

Había estado tratando de idear un esquema de anonimización para datos de alta dimensión. Falló por completo, pero en el proceso de fallar desarrollé la intuición de que los datos de alta dimensión no pueden anonimizarse de manera efectiva. Por supuesto, Netflix, con su competencia, afirmó haber hecho exactamente eso.

Tenía mi escepticismo natural de las declaraciones de marketing de las empresas, por lo que estaba motivado para demostrar que estaban equivocados. Mi asesor, Vitaly Shmatikov, y yo trabajamos en ello durante algunas intensas semanas. Una vez que nos dimos cuenta de que el trabajo realmente estaba teniendo un impacto, comencé a hacer más.

¿Cuál fue el impacto general? ¿Recibió noticias de Netflix y otras compañías cuyos datos resultaron no ser tan anónimos?

Bueno, un impacto positivo es que estimuló la ciencia de privacidad diferencial. Pero en términos de cómo reaccionaron las empresas, ha habido algunas reacciones diferentes. En muchos casos, las empresas que de otro modo habrían publicado conjuntos de datos ahora ya no lo hacen: están utilizando la privacidad como arma para luchar contra los esfuerzos de transparencia.

Facebook es conocido por hacer esto. Cuando los investigadores van a Facebook y dicen: “Necesitamos acceso a algunos de estos datos para estudiar cómo se propaga la información en la plataforma”, Facebook ahora puede decir: “No, no podemos darle eso. Eso comprometerá la privacidad de nuestros usuarios”.

Una vez escribiste un argumentando que el término "información de identificación personal" puede ser engañoso. ¿Cómo es eso?

Creo que existe una confusión entre los responsables de la formulación de políticas que surge de las dos formas diferentes en que se utiliza el término. Una es información sobre usted que es muy sensible, como su número de seguro social. Otro significado es información que se puede indexar en algunos conjuntos de datos y, por lo tanto, se puede usar para encontrar más información sobre usted.

Estos dos tienen diferentes significados. No tengo problemas con el concepto de PII en el primer sentido. Ciertos datos sobre las personas son muy sensibles y debemos tratarlos con más cuidado. Pero si bien su dirección de correo electrónico no es necesariamente muy confidencial para la mayoría de las personas, sigue siendo un identificador único que puede usarse para encontrarlo en otros conjuntos de datos. Siempre que la combinación de atributos de una persona esté disponible para cualquier otra persona en el mundo, eso es todo lo que necesita para la anonimización.

Introducción

¿Cómo llegaste finalmente a estudiar equidad?

Enseñé un curso de equidad y aprendizaje automático en 2017. Eso me dio una buena idea de los problemas abiertos en el campo. Y junto con eso, di una charla llamada “21 definiciones de equidad y su política.” Expliqué que la proliferación de definiciones técnicas no se debía a razones técnicas, sino a que en el fondo de todo esto hay cuestiones morales genuinas. No hay forma de que pueda tener un solo criterio estadístico que capture todos los deseos normativos, todas las cosas que desea. La charla fue bien recibida, así que esos dos juntos me convencieron de que debía empezar a adentrarme en este tema.

Tu también dio una charla sobre la detección de aceite de serpiente AI, que también fue bien recibido. ¿Cómo se relaciona eso con la equidad en el aprendizaje automático?

Entonces, la motivación para esto fue que claramente hay mucha innovación técnica genuina en la IA, como el programa de texto a imagen. DESDE EL 2 o el programa de ajedrez AlphaZero. Es realmente sorprendente que este progreso haya sido tan rápido. Mucha de esa innovación merece ser celebrada.

El problema surge cuando usamos este término genérico muy amplio e impreciso “IA” para cosas así, así como para aplicaciones más complejas, como los métodos estadísticos para la predicción de riesgos delictivos. En ese contexto, el tipo de tecnología involucrada es muy diferente. Estos son dos tipos de aplicaciones muy diferentes, y los beneficios y daños potenciales también son muy diferentes. Casi no hay conexión entre ellos, por lo que usar el mismo término para ambos es completamente confuso.

Las personas se engañan al pensar que todo este progreso que están viendo con la generación de imágenes en realidad se traduciría en progreso. hacia tareas sociales como predecir el riesgo criminal o predecir qué niños van a abandonar la escuela. Pero ese no es el caso en absoluto. En primer lugar, solo podemos hacerlo un poco mejor que la posibilidad aleatoria de predecir quién podría ser arrestado por un delito. Y esa precisión se logra con clasificadores realmente simples. No está mejorando con el tiempo, y no está mejorando a medida que recopilamos más conjuntos de datos. Entonces, todas estas observaciones contrastan con el uso del aprendizaje profundo para la generación de imágenes, por ejemplo.

¿Cómo distinguiría los diferentes tipos de problemas de aprendizaje automático?

Esta no es una lista exhaustiva, pero hay tres categorías comunes. La primera categoría es la percepción, que incluye tareas como describir el contenido de una imagen. La segunda categoría es lo que llamo "juicio automático", como cuando Facebook quiere usar algoritmos para determinar qué discurso es demasiado tóxico para permanecer en la plataforma. Y el tercero es predecir los resultados sociales futuros entre las personas, ya sea que alguien sea arrestado por un delito o si un niño abandonará la escuela.

En los tres casos, las precisiones alcanzables son muy diferentes, los peligros potenciales de una IA inexacta son muy diferentes y las implicaciones éticas que se derivan son muy diferentes.

Por ejemplo, el reconocimiento facial, en mi clasificación, es un problema de percepción. Mucha gente habla de que el reconocimiento facial es inexacto y, a veces, tiene razón. Pero no creo que eso se deba a que existen límites fundamentales para la precisión del reconocimiento facial. Esa tecnología ha ido mejorando, y va a mejorar. Es precisamente por eso que deberíamos preocuparnos por él desde una perspectiva ética: cuando lo pones en manos de la policía, que podría no rendir cuentas, o estados que no son transparentes sobre su uso.

Introducción

¿Qué hace que los problemas de predicción social sean mucho más difíciles que los problemas de percepción?

Los problemas de percepción tienen un par de características. Uno, no hay ambigüedad sobre si hay un gato en una imagen. Así que tienes la verdad básica. En segundo lugar, tiene datos de entrenamiento esencialmente ilimitados porque puede usar todas las imágenes en la web. Y si eres Google o Facebook, puedes usar todas las imágenes que las personas han subido a tu aplicación. Entonces, esos dos factores, la falta de ambigüedad y la disponibilidad de datos, permiten que los clasificadores funcionen realmente bien.

Eso es diferente de los problemas de predicción, que no tienen esas dos características. Hay una tercera diferencia que debo mencionar, que en cierto sentido es la más importante: las consecuencias morales de poner en práctica estos modelos de predicción son muy diferentes de usar una herramienta de traducción de idiomas en su teléfono o una herramienta de etiquetado de imágenes.

Pero esa no es la misma seriedad que la herramienta utilizada para determinar si alguien debe ser, por ejemplo, detenido antes del juicio. Esos tienen consecuencias para la libertad de las personas. Entonces, la ironía es que el área donde la IA funciona peor, no ha mejorado realmente con el tiempo y es poco probable que mejore en el futuro es el área que tiene todas estas consecuencias increíblemente importantes.

Gran parte de su trabajo ha requerido hablar con expertos fuera de su campo. ¿Cómo es colaborar con otros así?

Las colaboraciones interdisciplinarias han sido algunas de las colaboraciones más agradables. Creo que cualquier colaboración de este tipo tendrá sus momentos frustrantes porque las personas no hablan el mismo idioma.

Mi receta para eso es: cultura, luego lenguaje, luego sustancia. Si no comprende su cultura, como qué tipo de beca valoran, será muy difícil. Lo que es valioso para una persona puede parecer irrelevante para otra. Así que los aspectos culturales tienen que ser navegados primero. Luego, puede comenzar a establecer un lenguaje y un vocabulario comunes y, finalmente, llegar al fondo de la colaboración.

¿Qué tan optimista es sobre si podemos adoptar nuevas tecnologías de manera segura y sabia?

Parte del problema es una brecha de conocimiento. Es posible que los tomadores de decisiones, las agencias gubernamentales, las empresas y otras personas que compran estas herramientas de IA no reconozcan los serios límites de la precisión predictiva.

Pero en última instancia creo que es un problema político. Algunas personas quieren reducir costos, por lo que quieren una herramienta automatizada que elimine puestos de trabajo. Por lo tanto, existe una presión muy fuerte para creer lo que digan estos proveedores sobre sus herramientas predictivas.

Esos son dos problemas diferentes. Las personas como yo tal vez puedan ayudar a abordar la brecha de información. Pero abordar el problema político requiere activismo. Requiere que aprovechemos el proceso democrático. Es bueno ver que hay mucha gente haciendo eso. Y a la larga, creo que podemos hacer retroceder las aplicaciones dañinas y abusivas de la IA. No creo que vaya a cambiar en un instante, sino a través de un largo y extenso proceso de activismo que ya lleva una década o más. Estoy seguro de que continuará por mucho tiempo.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.quantamagazine.org/he-protects-privacy-and-ai-fairness-with-statistics-20230310/

- :es

- ][pag

- 1 millones de dólares

- $ UP

- 2017

- a

- capacidad

- Poder

- Nuestra Empresa

- sobre TI

- RESUMEN

- de la máquina

- seguimiento semanal

- la exactitud

- alcanzado

- ACM

- la columna Acción

- Activismo

- dirección

- direccionamiento

- adoptar

- avances

- Ventaja

- en contra

- agencias

- AI

- algoritmos

- Todos

- ya haya utilizado

- hacerlo

- las increíbles ofertas de

- Ambigüedad

- entre

- y

- Anónimo

- Otra

- nadie

- applicación

- Aplicación

- aplicaciones

- Aplicá

- somos

- Reservada

- áreas

- detenido

- artificial

- inteligencia artificial

- AS

- aspectos

- At

- atributos

- Confirmación de Viaje

- disponibilidad

- Hoy Disponibles

- de premio

- Atrás

- fondo

- BE

- porque

- a las que has recomendado

- Vaca

- comenzó

- "Ser"

- CREEMOS

- beneficios

- mejores

- entre

- general

- Navegador

- Comprar

- by

- llamar al

- , que son

- PUEDEN

- no puede

- capturas

- Carreras

- estudiar cuidadosamente

- case

- cases

- CAT

- categoría

- Categoría

- celebrado

- a ciertos

- oportunidad

- el cambio

- características

- Ajedrez

- afirmó

- transparencia

- clasificación

- con claridad.

- colaboran

- colaboración

- colaboraciones

- recoger

- combinación

- cómo

- Algunos

- Empresas

- competencia

- completamente

- integraciones

- compromiso

- computadora

- concepto

- preocupado

- confuso

- confusión

- conexión

- Consecuencias

- contenido

- contexto

- continue

- contraste

- galletas

- Precio

- podría

- Parejas

- Curso

- Delito

- Abogados de

- criptografía

- cultural

- Cultura

- Current

- Corte

- reducir costos

- peligros

- datos

- puntos de datos

- conjunto de datos

- conjuntos de datos

- década

- tomadores de decisiones

- profundo

- deep learning

- se define

- democrático

- merece

- detenido

- Determinar

- desarrollado

- idear

- HIZO

- un cambio

- una experiencia diferente

- diferentes problemas

- descrubrir

- distinguir

- Perro

- "Hacer"

- No

- Soltar

- Temprano en la

- de manera eficaz

- esfuerzos

- elimina

- agradables

- especialmente

- esencialmente

- establecer

- el establecimiento

- ético

- Incluso

- finalmente

- exactamente

- expertos

- explicado

- extraerlos

- Cara

- Reconocimiento facial

- factores importantes

- FALLO

- Fallidos

- feria

- justicia

- pocos

- campo

- lucha

- Finalmente

- Encuentre

- Nombre

- centrado

- seguir

- formulario

- formal

- encontrado

- Freedom

- Desde

- frustrante

- fundamental

- futuras

- brecha

- generación de AHSS

- obtener

- conseguir

- Donar

- da

- Go

- va

- candidato

- Gobierno

- Polo a Tierra

- Grupo procesos

- guía

- Manos

- En Curso

- Difícil

- perjudicial

- daños

- Tienen

- es

- cabeza

- oír

- Corazón

- ayuda

- ayudando

- historia

- Cómo

- HTTPS

- enorme

- i

- idea

- identificador

- Identidad

- imagen

- imágenes

- Impacto

- implicaciones

- importancia

- importante

- imposible

- mejorar

- mejorado

- la mejora de

- in

- En otra

- incorrecto

- incluye

- increíblemente

- información

- Innovation

- ejemplo

- instantáneo

- instrumental

- Intelligence

- intenciones

- interesado

- Internacional

- Internet

- Entrevista

- involucra

- IT

- SUS

- sí mismo

- Empleo

- Niño

- Niños

- Tipo

- Saber

- especialistas

- conocido

- etiquetado

- Falta

- idioma

- APRENDE:

- aprendizaje

- LED

- luz

- como

- límites

- Lista

- Largo

- largo tiempo

- por más tiempo

- Lote

- máquina

- máquina de aprendizaje

- Máquinas

- HACE

- muchos

- Marketing

- las matemáticas

- matemático

- sentido

- se une a la

- métodos

- Métrica

- podría

- millones

- modelos

- Momentos

- más,

- MEJOR DE TU

- motivado

- Motivación

- Nacional

- seguridad nacional

- Natural

- necesariamente

- ¿ Necesita ayuda

- Netflix

- Nuevo

- número

- of

- LANZAMIENTO

- Aceite

- on

- ONE

- habiertos

- Optimista

- Otro

- Otros

- de otra manera

- Resultado

- afuera

- total

- partes

- pasado

- Personas

- de las personas

- percepción

- Realizar

- quizás

- persona

- Personalmente

- la perspectiva

- teléfono

- piezas

- plataforma

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- plausible

- puntos

- Policía

- política

- los responsables políticos

- político

- positivo

- posible

- precisamente

- predecir

- predicción

- receta

- presión

- las cuales

- política de privacidad

- Problema

- problemas

- Programa

- Progreso

- Demostrar.

- previsto

- público

- Push

- hacer retroceder

- poner

- Poniendo

- Rompecabezas

- Revista Quanta

- Preguntas

- azar

- rápido

- Calificaciones

- reacciones

- mundo real

- realizado

- realización

- razones

- recibido

- reciente

- reconocimiento

- reconocer

- Recomendación

- liberado

- permanecer

- Remoto

- Requisitos

- requiere

- la investigación

- investigador

- investigadores

- RESTO

- género

- Riesgo

- Ejecutar

- de manera segura

- mismo

- esquema

- Escuela

- Ciencia:

- Científico

- Segundo

- EN LINEA

- ver

- sentido

- sensible

- grave

- set

- Sets

- tienes

- sencillos

- soltero

- Escepticismo

- habilidad

- So

- Social

- Resolver

- algo

- Alguien

- sofisticado

- De una Charla a tu equipo

- específicamente

- habla

- Patrocinado

- comienzo

- fundó

- declaraciones

- Zonas

- estadístico

- Sin embargo

- fuerza

- fuerte

- ESTUDIO

- Estudiando

- sustancia

- comercial

- tal

- te

- Todas las funciones a su disposición

- ¡Prepárate!

- escuchar

- hablar

- tareas

- equipo

- Técnico

- Tecnologías

- Tecnología

- términos

- esa

- La

- El Área

- El futuro de las

- la información

- el mundo

- su

- Les

- teorético

- de este modo

- Estas

- cosas

- Ideas

- Código

- tercero

- a fondo

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- a

- juntos

- demasiado

- del IRS

- tema

- hacia

- seguir

- Formación

- trayectoria

- la traducción

- Traducción

- Transparencia

- transparente

- sorpresa

- Convertido

- tipos

- Finalmente, a veces

- paraguas

- bajo

- entender

- único

- universidad

- ilimitado

- subido

- us

- utilizan el

- Usuario

- usuarios

- Valioso

- propuesta de

- vendedores

- vistas

- Camino..

- formas

- web

- webp

- sitios web

- Semanas

- da la bienvenida

- WELL

- ¿

- Que es

- sean

- que

- mientras

- QUIENES

- quien

- Wikipedia

- seguirá

- Actividades:

- trabajado

- funciona

- mundo

- se

- Mal

- año

- años

- Usted

- tú

- Youtube

- zephyrnet