Las GPU son una herramienta poderosa para las cargas de trabajo de aprendizaje automático, aunque no son necesariamente la herramienta adecuada para cada trabajo de IA, según Michael Bronstein, jefe de investigación de aprendizaje gráfico de Twitter.

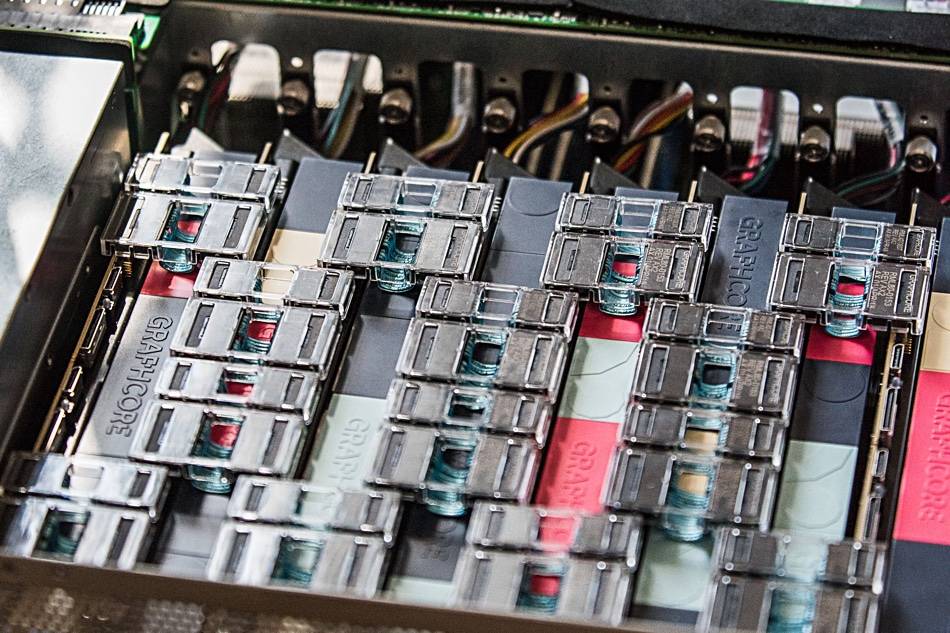

Su equipo mostró recientemente que el hardware de IA de Graphcore ofrecía una "velocidad de orden de magnitud al comparar un solo procesador IPU con una GPU Nvidia A100", en modelos de red gráfica temporal (TGN).

"La elección del hardware para implementar los modelos Graph ML es un problema crucial, aunque a menudo se pasa por alto", dice un articulo conjunto escrito por Bronstein con Emanuele Rossi, investigador de ML en Twitter, y Daniel Justus, investigador de Graphcore.

Las redes neuronales gráficas ofrecen un medio para encontrar orden en sistemas complejos y se usan comúnmente en redes sociales y sistemas de recomendación. Sin embargo, la naturaleza dinámica de estos entornos hace que estos modelos sean particularmente difíciles de entrenar, explicó el trío.

El grupo investigó la viabilidad de las UIP de Graphcore en el manejo de varios modelos TGN. Las pruebas iniciales se realizaron en un modelo TGN pequeño basado en el JODIE Conjunto de datos de Wikipedia que vincula a los usuarios con las ediciones que realizaron en las páginas. El gráfico constaba de 8,227 usuarios y 1,000 artículos para un total de 9,227 nodos. JODIE es un sistema de predicción de código abierto diseñado para dar sentido a las redes de interacción temporal.

La experimentación del trío reveló que los tamaños de lote grandes dieron como resultado una validación y precisión de inferencia degradadas, en comparación con tamaños de lote más pequeños.

“La memoria del nodo y la conectividad del gráfico solo se actualizan después de que se procesa un lote completo”, escribió el trío. "Por lo tanto, los eventos posteriores dentro de un lote pueden basarse en información desactualizada, ya que no conocen los eventos anteriores".

Sin embargo, al usar un tamaño de lote de 10, el grupo pudo lograr una validación y precisión de inferencia óptimas, pero notaron que el rendimiento en la IPU seguía siendo superior al de una GPU, incluso cuando se usaban tamaños de lote grandes.

“Cuando se usa un lado de lote de 10, TGN puede entrenarse en la IPU aproximadamente 11 veces más rápido, e incluso con un tamaño de lote grande de 200, el entrenamiento sigue siendo tres veces más rápido en la IPU”, se lee en la publicación. “A lo largo de todas las operaciones, la IPU maneja lotes pequeños de manera más eficiente”.

El equipo postula que el rápido acceso a la memoria y el alto rendimiento que ofrece el gran caché SRAM en el procesador de Graphcore le dio a la IPU una ventaja.

Esta ventaja de rendimiento también se extendió a los modelos gráficos que excedían la memoria en el procesador de la IPU (cada IPU cuenta con un caché SRAM de 1 GB), lo que requiere el uso de una memoria DRAM más lenta conectada a los chips.

En las pruebas en un modelo gráfico que consta de 261 millones de seguidores entre 15.5 millones de usuarios de Twitter, el uso de DRAM para la memoria del nodo redujo el rendimiento en un factor de dos, descubrió el equipo de Bronstein.

Sin embargo, al inducir varios subgráficos basados en un conjunto de datos sintéticos de 10 veces el tamaño del gráfico de Twitter, el equipo encontró un rendimiento escalado independientemente del tamaño del gráfico. En otras palabras, el impacto en el rendimiento fue el resultado de usar una memoria más lenta y no el resultado del tamaño del modelo.

“Usando esta técnica en la IPU, TGN se puede aplicar a tamaños de gráficos casi arbitrarios, solo limitados por la cantidad de memoria de host disponible mientras se mantiene un rendimiento muy alto durante el entrenamiento y la inferencia”, se lee en el artículo.

El equipo concluyó que la arquitectura IPU de Graphcore muestra una ventaja significativa sobre las GPU en cargas de trabajo en las que el acceso a la memoria y la computación son heterogéneos.

Sin embargo, la conclusión más amplia es que los investigadores de ML deben considerar cuidadosamente su elección de hardware y no deben usar GPU de forma predeterminada.

“La disponibilidad de servicios de computación en la nube que extraen el hardware subyacente genera cierta pereza en este sentido”, escribió el trío. “Esperamos que nuestro estudio llame más la atención sobre este importante tema y allane el camino para futuros algoritmos y arquitecturas de hardware más eficientes para aplicaciones Graph ML”. ®

- AI

- arte ai

- generador de arte ai

- robot ai

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- deep learning

- google ai

- máquina de aprendizaje

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- sintaxis

- El registro

- zephyrnet