El crecimiento y los avances de la IA han sido exponenciales en los últimos años. Informes Statista que para 2024, el mercado global de IA generará unos ingresos asombrosos de alrededor de $3000 mil millones, en comparación con $126 mil millones en 2015. Sin embargo, los líderes tecnológicos ahora nos advierten sobre los diversos riesgos de la IA.

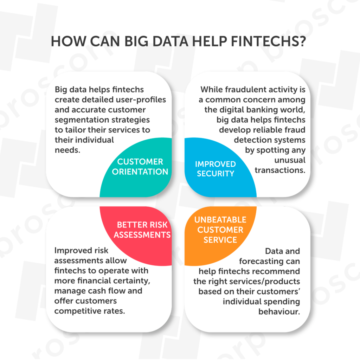

Especialmente, la reciente ola de IA generativa modelos como ChatGPT han introducido nuevas capacidades en varios sectores sensibles a los datos, como atención médica, educación, financiar, etc. Estos desarrollos respaldados por IA son vulnerables debido a muchas deficiencias de IA que los agentes maliciosos pueden exponer.

Analicemos lo que dicen los expertos en IA sobre los desarrollos recientes y destaquemos los riesgos potenciales de la IA. También abordaremos brevemente cómo se pueden gestionar estos riesgos.

Líderes tecnológicos y sus preocupaciones relacionadas con los riesgos de la IA

Geoffrey Hinton

Geoffrey Hinton, un famoso líder tecnológico de IA (y padrino de este campo), que recientemente dejó Google, ha expresó sus preocupaciones sobre el rápido desarrollo de la IA y sus peligros potenciales. Hinton cree que los chatbots de IA pueden volverse "bastante aterradores" si superan la inteligencia humana.

Hinton dice:

“En este momento, lo que estamos viendo son cosas como que GPT-4 eclipsa a una persona en la cantidad de conocimiento general que tiene, y la eclipsa por mucho. En términos de razonamiento, no es tan bueno, pero ya hace un razonamiento simple. Y dada la tasa de progreso, esperamos que las cosas mejoren bastante rápido. Así que tenemos que preocuparnos por eso”.

Además, cree que los "malos actores" pueden usar la IA para "cosas malas", como permitir que los robots tengan sus objetivos secundarios. A pesar de sus preocupaciones, Hinton cree que la IA puede traer beneficios a corto plazo, pero también debemos invertir mucho en la seguridad y el control de la IA.

Elon Musk

La participación de Elon Musk en la IA comenzó con su inversión inicial en Mente profunda en 2010, para co-fundar OpenAI e incorporar IA en los vehículos autónomos de Tesla.

Aunque está entusiasmado con la IA, con frecuencia plantea preocupaciones sobre los riesgos de la IA. Musk dice que los poderosos sistemas de IA pueden ser más peligrosos para la civilización que las armas nucleares. En una entrevista en Fox News en abril de 2023, dijo:

“La IA es más peligrosa que, digamos, el diseño de aeronaves o el mantenimiento de producción mal administrados o la mala producción de automóviles. En el sentido de que tiene el potencial, sin embargo, uno puede considerar pequeña esa probabilidad, pero no es trivial y tiene el potencial de destrucción de la civilización”.

Además, Musk apoya las regulaciones gubernamentales sobre IA para garantizar la seguridad de los riesgos potenciales, aunque "no es tan divertido".

Pause los experimentos gigantes de IA: una carta abierta respaldada por miles de expertos en IA

Future of Life Institute publicó una carta abierta el 22 de marzo de 2023. La carta pide una interrupción temporal de seis meses en Desarrollo de sistemas de IA más avanzado que GPT-4. Los autores expresan su preocupación por el ritmo con el que se están desarrollando los sistemas de IA que plantea graves desafíos socioeconómicos.

Además, la carta establece que los desarrolladores de IA deberían trabajar con los legisladores para documentar los sistemas de gobierno de IA. Hasta junio de 2023, la carta ha sido firmada por más de 31,000 XNUMX desarrolladores, expertos y líderes tecnológicos de IA. Los signatarios notables incluyen a Elon Musk, Steve Wozniak (cofundador de Apple), Emad Mostaque (CEO, Stability AI), Yoshua Bengio (ganador del Premio Turing) y muchos más.

Contraargumentos sobre la detención del desarrollo de la IA

Dos destacados líderes de IA, Andrew Ng y Yann LeCun, se han opuesto a la prohibición de seis meses de desarrollar sistemas avanzados de IA y consideraron la pausa como una mala idea.

Ng dice que aunque la IA tiene algunos riesgos, como el sesgo, la concentración de poder, etc., el valor creado por la IA en campos como la educación, la atención médica y el entrenamiento receptivo es tremendo.

Yann LeCun dice que la investigación y el desarrollo no deben detenerse, aunque los productos de IA que llegan al usuario final pueden regularse.

¿Cuáles son los peligros potenciales y los riesgos inmediatos de la IA?

1. Desplazamiento laboral

Los expertos en IA creen que los sistemas inteligentes de IA pueden reemplazar las tareas cognitivas y creativas. El banco de inversión Goldman Sachs estima que alrededor 300 millones de trabajos será automatizado por IA generativa.

Por lo tanto, debería haber regulaciones sobre el desarrollo de la IA para que no provoque una grave recesión económica. Debería haber programas educativos para mejorar y volver a capacitar a los empleados para hacer frente a este desafío.

2. Sistemas de IA sesgados

Sesgos predominante entre los seres humanos sobre el género, la raza o el color puede permear inadvertidamente los datos utilizados para entrenar los sistemas de IA, lo que posteriormente hace que los sistemas de IA estén sesgados.

Por ejemplo, en el contexto de la contratación laboral, un sistema de IA sesgado puede descartar currículos de personas de orígenes étnicos específicos, creando discriminación en el mercado laboral. En aplicación de la ley, la vigilancia policial predictiva sesgada podría centrarse desproporcionadamente en vecindarios o grupos demográficos específicos.

Por lo tanto, es esencial contar con una estrategia de datos integral que aborde los riesgos de la IA, en particular el sesgo. Los sistemas de IA deben evaluarse y auditarse con frecuencia para mantenerlos justos.

3. Aplicaciones de inteligencia artificial críticas para la seguridad

Los vehículos autónomos, el diagnóstico y tratamiento médico, los sistemas de aviación, el control de centrales nucleares, etc., son ejemplos de aplicaciones de IA críticas para la seguridad. Estos sistemas de IA deben desarrollarse con cautela porque incluso los errores menores podrían tener graves consecuencias para la vida humana o el medio ambiente.

Por ejemplo, el mal funcionamiento del software AI llamado Sistema de aumento de características de maniobra (MCAS) se atribuye en parte al accidente de los dos Boeing 737 MAX, primero en octubre de 2018 y luego en marzo de 2019. Lamentablemente, los dos accidentes causaron la muerte de 346 personas.

¿Cómo podemos superar los riesgos de los sistemas de IA? – Desarrollo responsable de IA y cumplimiento normativo

IA Responsable (RAI) significa desarrollar e implementar sistemas de IA justos, responsables, transparentes y seguros que garanticen la privacidad y cumplan con las regulaciones legales y las normas sociales. La implementación de RAI puede ser compleja dado el amplio y rápido desarrollo de los sistemas de IA.

Sin embargo, las grandes empresas de tecnología han desarrollado marcos RAI, como:

Los laboratorios de IA de todo el mundo pueden inspirarse en estos principios o desarrollar sus propios marcos de IA responsables para crear sistemas de IA confiables.

Cumplimiento normativo de IA

Dado que los datos son un componente integral de los sistemas de IA, las organizaciones y laboratorios basados en IA deben cumplir con las siguientes regulaciones para garantizar la seguridad, privacidad y seguridad de los datos.

-

GDPR (Reglamento general de protección de datos) – un marco de protección de datos de la UE.

-

CCPA (Ley de privacidad del consumidor de California) – un estatuto del estado de California para los derechos de privacidad y protección del consumidor.

-

HIPAA (Ley de responsabilidad y portabilidad de seguros médicos) – una legislación estadounidense que salvaguarda los datos médicos de los pacientes.

-

Ley de IA de la UEy Pautas éticas para una IA confiable – un reglamento de IA de la Comisión Europea.

Hay varias leyes regionales y locales promulgadas por diferentes países para proteger a sus ciudadanos. Las organizaciones que no garanticen el cumplimiento normativo en torno a los datos pueden resultar en severas sanciones. Por ejemplo, GDPR ha establecido una multa de 20 millones de euros o el 4% del beneficio anual por infracciones graves tales como procesamiento de datos ilegal, consentimiento de datos no probado, violación de los derechos de los interesados o transferencia de datos no protegidos a una entidad internacional.

Desarrollo y regulaciones de IA: presente y futuro

Con cada mes que pasa, los avances de la IA están alcanzando alturas sin precedentes. Pero, las regulaciones de IA y los marcos de gobernanza que lo acompañan están rezagados. Deben ser más sólidos y específicos.

Los líderes tecnológicos y los desarrolladores de IA han estado haciendo sonar las alarmas sobre los riesgos de la IA si no se regula adecuadamente. La investigación y el desarrollo en IA pueden aportar aún más valor en muchos sectores, pero está claro que ahora es imperativa una regulación cuidadosa.

Enlace: https://www.unite.ai/tech-leaders-highlighting-the-risks-of-ai-the-urgency-of-robust-ai-regulation/?utm_source=pocket_saves

Fuente: https://www.unite.ai

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- EVM Finanzas. Interfaz unificada para finanzas descentralizadas. Accede Aquí.

- Grupo de medios cuánticos. IR/PR amplificado. Accede Aquí.

- PlatoAiStream. Inteligencia de datos Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.fintechnews.org/tech-leaders-highlighting-the-risks-of-ai-the-urgency-of-robust-ai-regulation/

- :posee

- :es

- :no

- 000

- 2015

- 2018

- 2019

- 2023

- 2024

- 31

- 7

- a

- Nuestra Empresa

- seguimiento semanal

- cuentas

- a través de

- Actúe

- direcciones

- adecuadamente

- avanzado

- avances

- agentes

- AI

- Gobernanza de la IA

- aeronave

- Todos

- Permitir

- ya haya utilizado

- también

- Aunque

- entre

- cantidad

- an

- y

- anual

- Apple

- aplicaciones

- Abril

- somos

- argumentos

- en torno a

- AS

- auditado

- Autorzy

- Confirmación de Viaje

- autónomo

- vehículos autónomos

- aviación

- Respaldados

- antecedentes

- Malo

- Prohibición

- Banca

- BBC

- BE

- porque

- a las que has recomendado

- esto

- comenzó

- "Ser"

- CREEMOS

- cree

- beneficios

- mejores

- parcialidad

- parcial

- Big

- gran tecnología

- mil millones

- Boeing

- brevemente

- llevar

- general

- pero

- by

- CA

- California

- Calls

- PUEDEN

- capacidades

- de

- cuidadoso

- Causa

- cautelosamente

- CDC

- ceo

- Reto

- retos

- características

- Chatbots

- ChatGPT

- Ciudadanos

- Civilization

- limpiar

- Co-founder

- ENTRENAMIENTO

- cognitivo

- Color

- referencia

- Empresas

- en comparación con

- integraciones

- compliance

- cumplir

- componente

- exhaustivo

- concentración

- Inquietudes

- consentimiento

- Consecuencias

- considerado

- consumidor

- privacidad del consumidor

- Protección del consumidor

- contexto

- control

- podría

- países

- Crash

- creado

- Creamos

- Estudio

- peligroso

- peligros

- datos

- proceso de datos

- protección de datos

- seguridad de datos

- estrategia de datos

- acuerdo

- Mente profunda

- capas demográficas

- Desplegando

- Diseño

- A pesar de las

- desarrollar

- desarrollado

- desarrolladores

- el desarrollo

- Desarrollo

- desarrollos

- una experiencia diferente

- discutir

- do

- documento

- documento ai

- sí

- No

- DESCENSO

- dos

- Temprano en la

- EC

- Economic

- recesión económica

- Educación

- educativo

- Elon

- Elon Musk

- personas

- garantizar

- entusiasta

- entidad

- Entorno

- Errores

- esencial

- estima

- etc.

- ética

- EU

- Europa

- Europea

- Comisión Europea

- evaluado

- Incluso

- Cada

- ejemplos

- esperar

- experimentos

- expertos

- los expertos creen

- exponencial

- expreso

- FALLO

- feria

- famoso

- RÁPIDO

- pocos

- campo

- Terrenos

- en fin

- Nombre

- seguir

- siguiendo

- Forbes

- Marco conceptual

- marcos

- frecuentemente

- Desde

- diversión

- promover

- RGPD

- Género

- General

- informacion General

- Reglamento General de Protección de Datos

- generar

- generativo

- IA generativa

- obtener

- gigante

- dado

- Buscar

- globo

- Goldman

- Goldman Sachs

- candidato

- gobierno

- Gobierno

- Grupo

- Crecimiento

- orientaciones

- vacilante

- Tienen

- he

- Salud

- el seguro médico

- la salud

- fuertemente

- alturas

- Destacar

- destacando

- su

- Cómo

- Sin embargo

- HTTPS

- humana

- Inteligencia humana

- IBM

- idea

- if

- inmediata

- INDISPENSABLE

- implementación

- in

- incluir

- incorporando

- individuos

- Inspiración

- ejemplo

- Innovadora

- aseguradora

- un elemento indispensable

- Intelligence

- De Operación

- Internacional

- Entrevista

- dentro

- Introducido

- Invertir

- inversión extranjera

- la participación de

- IT

- SUS

- Trabajos

- jpg

- junio

- Guardar

- especialistas

- labs

- rezagado

- leyes

- líder

- los líderes

- izquierda

- Legal

- Legislación

- carta

- Vida

- como

- local

- Largo

- un mejor mantenimiento.

- para lograr

- Realizar

- gestionado

- muchos

- Marzo

- Mercado

- max

- max-ancho

- Puede..

- significa

- servicios

- datos médicos

- Microsoft

- millones

- menor de edad

- modelos

- Mes

- meses

- más,

- Almizcle

- debe

- ¿ Necesita ayuda

- Nuevo

- notable

- ahora

- nuclear

- La energía nuclear

- octubre

- of

- on

- ONE

- habiertos

- opuesto

- or

- para las fiestas.

- Más de

- Superar

- EL DESARROLLADOR

- Paz

- parte

- particularmente

- Pasando (Paso)

- pasado

- pausa

- Personas

- persona

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- vigilancia

- los responsables políticos

- plantea

- posible

- industria

- poderoso

- presente

- frecuente

- principios

- política de privacidad

- premio

- tratamiento

- Producción

- Productos

- Programas

- Progreso

- destacado

- proteger

- Protección

- publicado

- Carrera

- plantea

- rápido

- Rate

- en comunicarse

- alcanzando

- reciente

- recientemente

- reclutamiento

- Considerar

- regional

- regulados

- Regulación

- reglamentos

- regulador

- Cumplimiento Regulatorio

- relacionado

- relativo

- reemplazar

- la investigación

- la investigación y el desarrollo

- responsable

- sensible

- resultado

- ingresos

- Derecho

- derechos

- riesgos

- los robots

- robusto

- s

- Sachs

- salvaguardias

- Safety

- Said

- dices

- decir

- dice

- Sectores

- seguro

- EN LINEA

- ver

- sentido

- grave

- set

- grave

- a corto plazo

- deficiencias

- tienes

- firmantes

- firmado

- sencillos

- SEIS

- Seis meses

- chica

- So

- societal

- socioeconómico

- Software

- algo

- soluciones y

- Estabilidad

- Estado

- Zonas

- Steve

- Steve Wozniak

- detenido

- Estrategia

- Después

- tal

- soportes

- superar

- te

- Todas las funciones a su disposición

- ¡Prepárate!

- Target

- tareas

- tecnología

- empresas de tecnología

- temporal

- términos

- que

- esa

- La

- su

- Les

- luego

- Ahí.

- Estas

- ellos

- cosas

- así

- a

- contacto

- Formación

- transferir

- transparente

- del mismo día

- tremendo

- de confianza

- digno de confianza

- Turing

- dos

- nosotros

- sin precedentes

- urgencia

- us

- utilizan el

- usado

- propuesta de

- diversos

- Vehículos

- INCUMPLIMIENTO

- Vulnerable

- advertencia

- Trenzado

- Camino..

- we

- Armas

- ¿

- que

- QUIENES

- seguirá

- ganador

- Actividades:

- preocuparse

- años

- Youtube

- zephyrnet