Introducción

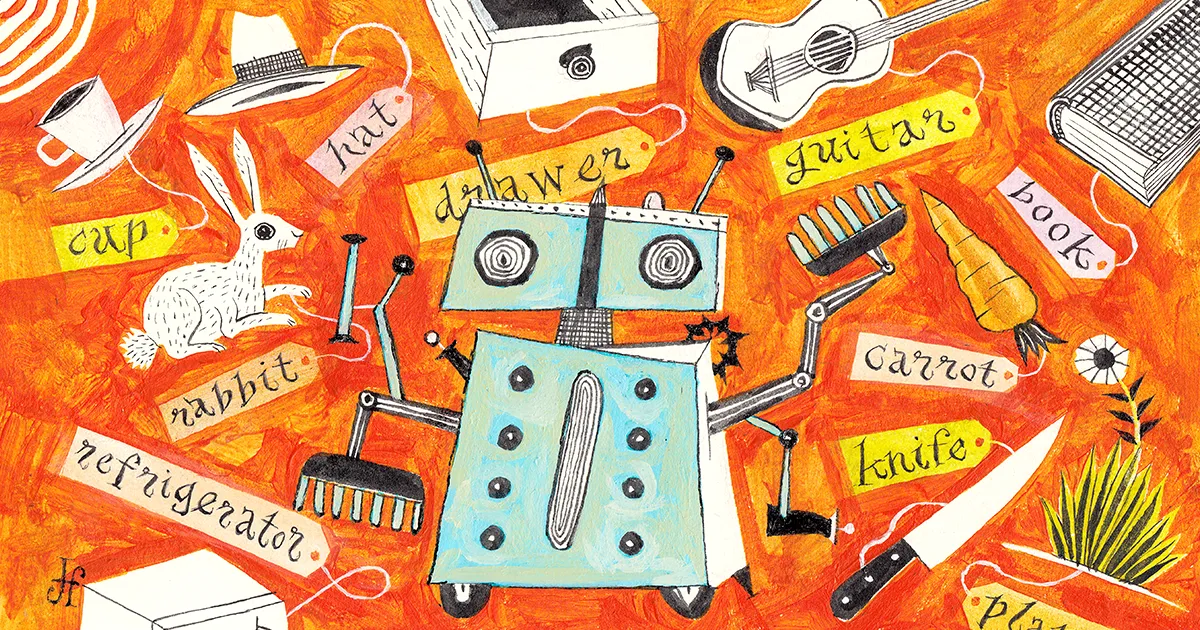

Imagina que tu vecino llama para pedirte un favor: ¿Podrías darle de comer a su conejo unas rodajas de zanahoria? Bastante fácil, pensarías. Puedes imaginar su cocina, incluso si nunca has estado allí: zanahorias en un refrigerador, un cajón con varios cuchillos. Es conocimiento abstracto: no sabes cómo son exactamente las zanahorias y los cuchillos de tu vecino, pero no tomarías una cuchara para un pepino.

Los programas de inteligencia artificial no pueden competir. Lo que le parece una tarea fácil es una tarea enorme para los algoritmos actuales.

Un robot entrenado por IA puede encontrar un cuchillo y una zanahoria específicos escondidos en una cocina familiar, pero en una cocina diferente carecerá de las habilidades abstractas para tener éxito. “No generalizan a nuevos entornos”, dijo Víctor Zhong, un estudiante de posgrado en ciencias de la computación en la Universidad de Washington. La máquina falla porque simplemente hay demasiado que aprender y un espacio demasiado vasto para explorar.

El problema es que estos robots, y los agentes de IA en general, no tienen una base de conceptos sobre la cual construir. No saben qué es realmente un cuchillo o una zanahoria, y mucho menos cómo abrir un cajón, elegir uno y cortar rodajas. Esta limitación se debe en parte al hecho de que muchos sistemas avanzados de IA se entrenan con un método llamado aprendizaje por refuerzo que es esencialmente autoeducación a través de prueba y error. Los agentes de IA capacitados con aprendizaje por refuerzo pueden ejecutar muy bien el trabajo para el que fueron capacitados, en el entorno en el que fueron capacitados para hacerlo. Pero cambie el trabajo o el entorno, y estos sistemas a menudo fallarán.

Para sortear esta limitación, los informáticos han comenzado a enseñar a las máquinas conceptos importantes antes de soltarlas. Es como leer un manual antes de usar un nuevo software: puede intentar explorar sin él, pero aprenderá mucho más rápido con él. “Los humanos aprenden a través de una combinación de hacer y leer”, dijo Karthik Narasimhan, científico informático de la Universidad de Princeton. “Queremos que las máquinas hagan lo mismo”.

Nuevo trabajo de Zhong y otros muestra que preparar un modelo de aprendizaje de esta manera puede potenciar el aprendizaje en entornos simulados, tanto en línea como en el mundo real con robots. Y no solo hace que los algoritmos aprendan más rápido, sino que los guía hacia habilidades que de otro modo nunca aprenderían. Los investigadores quieren que estos agentes se conviertan en generalistas, capaces de aprender cualquier cosa, desde ajedrez hasta compras y limpieza. Y a medida que las demostraciones se vuelven más prácticas, los científicos creen que este enfoque podría incluso cambiar la forma en que los humanos pueden interactuar con los robots.

“Ha sido un gran avance”, dijo Brian Ichter, científico investigador en robótica de Google. “Es bastante inimaginable lo lejos que ha llegado en un año y medio”.

Recompensas escasas

A primera vista, el aprendizaje automático ya ha tenido un éxito notable. La mayoría de los modelos suelen utilizar aprendizaje reforzado, donde los algoritmos aprenden obteniendo recompensas. Comienzan totalmente ignorantes, pero la prueba y el error eventualmente se convierten en prueba y triunfo. Los agentes de aprendizaje por refuerzo pueden dominar fácilmente juegos simples.

Considere el videojuego Snake, donde los jugadores controlan una serpiente que se hace más larga a medida que come manzanas digitales. Desea que su serpiente coma la mayor cantidad de manzanas, permanezca dentro de los límites y evite toparse con su cuerpo cada vez más voluminoso. Tales resultados correctos e incorrectos claros le dan a un agente de máquina bien recompensado una retroalimentación positiva, por lo que suficientes intentos pueden llevarlo de "novato" a puntaje alto.

Pero supongamos que las reglas cambian. Quizás el mismo agente deba jugar en una cuadrícula más grande y en tres dimensiones. Mientras que un jugador humano podría adaptarse rápidamente, la máquina no puede debido a dos debilidades críticas. Primero, el espacio más grande significa que la serpiente tarda más en tropezar con las manzanas, y el aprendizaje se ralentiza exponencialmente cuando las recompensas son escasas. En segundo lugar, la nueva dimensión proporciona una experiencia totalmente nueva, y el aprendizaje por refuerzo lucha por generalizarse a nuevos desafíos.

Zhong dice que no necesitamos aceptar estos obstáculos. "¿Por qué cuando queremos jugar al ajedrez", otro juego que el aprendizaje por refuerzo ha dominado, "entrenamos a un agente de aprendizaje por refuerzo desde cero?" Tales enfoques son ineficientes. El agente deambula sin rumbo fijo hasta que se topa con una buena situación, como un jaque mate, y Zhong dice que se requiere un cuidadoso diseño humano para que el agente sepa lo que significa que una situación sea buena. “¿Por qué tenemos que hacer esto cuando ya tenemos tantos libros sobre cómo jugar al ajedrez?”

En parte, se debe a que las máquinas han tenido problemas para comprender el lenguaje humano y descifrar imágenes en primer lugar. Para que un robot complete tareas basadas en la visión, como encontrar y cortar zanahorias, por ejemplo, debe saber qué es una zanahoria: la imagen de una cosa debe estar "basada" en una comprensión más fundamental de qué es esa cosa. Hasta hace poco, no había una buena manera de hacerlo, pero un auge en la velocidad y la escala del procesamiento de imágenes y lenguaje ha hecho posibles los nuevos éxitos.

Nuevo procesamiento natural del lenguaje Los modelos permiten que las máquinas aprendan esencialmente el significado detrás de las palabras y las oraciones, para fundamentarlas en las cosas del mundo, en lugar de simplemente almacenar un significado simple (y limitado) como un diccionario digital.

La visión por computadora ha visto una explosión digital similar. Alrededor de 2009, ImageNet debutó como una base de datos de imágenes anotadas para la investigación de visión artificial. Hoy alberga más de 14 millones de imágenes de objetos y lugares. Y programas como OpenAI's DE·E genere nuevas imágenes bajo comando que parezcan hechas por humanos, a pesar de no tener una comparación exacta de la cual extraer.

Muestra cómo las máquinas solo ahora tienen acceso a suficientes datos en línea para aprender realmente sobre el mundo, según Ánima Anandkumar, científico informático del Instituto de Tecnología de California y Nvidia. Y es una señal de que pueden aprender de los conceptos como lo hacemos nosotros y usarlos para la generación. “Estamos en un gran momento ahora”, dijo. “Porque una vez que podamos obtener generación, hay mucho más que podemos hacer”.

El sistema de juego

Investigadores como Zhong decidieron que las máquinas ya no tenían que embarcarse en sus exploraciones completamente desinformadas. Armados con modelos de lenguaje sofisticados, los investigadores podrían agregar un paso previo al entrenamiento en el que un programa aprendiera de la información en línea antes de sus pruebas y errores.

Para probar la idea, él y sus colegas compararon el entrenamiento previo con el aprendizaje de refuerzo tradicional en cinco configuraciones diferentes similares a las de un juego donde los agentes de la máquina interpretaban los comandos del lenguaje para resolver problemas. Cada entorno simulado desafió al agente de la máquina de manera única. Uno le pidió al agente que manipulara elementos en una cocina 3D; otro requería leer un texto para aprender una secuencia precisa de acciones para luchar contra los monstruos. Pero el escenario más complicado fue un juego real, el NetHack de 35 años, donde el objetivo es navegar en una mazmorra sofisticada para recuperar un amuleto.

Para las configuraciones simples, el entrenamiento previo automatizado significó simplemente poner a tierra los conceptos importantes: esto es una zanahoria, eso es un monstruo. Para NetHack, el agente se entrenó viendo jugar a los humanos, usando partidas cargadas en Internet por jugadores humanos. Estos juegos ni siquiera tenían que ser tan buenos: el agente solo necesitaba desarrollar la intuición sobre cómo se comportan los humanos. El agente no estaba destinado a convertirse en un experto, solo en un jugador regular. Desarrollaría la intuición observando: ¿qué haría un humano en un escenario dado? El agente decidiría qué movimientos fueron exitosos, formulando su propio palo y zanahoria.

“A través de la capacitación previa, formamos buenos antecedentes sobre cómo asociar las descripciones del lenguaje con las cosas que suceden en el mundo”, dijo Zhong. El agente jugaría mejor desde el principio y aprendería más rápidamente durante el aprendizaje por refuerzo posterior.

Como resultado, el agente pre-entrenado superó al tradicionalmente entrenado. “Obtenemos ganancias en todos los ámbitos en los cinco entornos”, dijo Zhong. Las configuraciones más simples solo mostraron una ligera ventaja, pero en las complicadas mazmorras de NetHack, el agente aprendió muchas veces más rápido y alcanzó un nivel de habilidad que el enfoque clásico no podía. “Es posible que obtenga un rendimiento de 10x porque si no hace esto, simplemente no aprende una buena política”, dijo.

“Estos agentes generalistas son un gran salto de lo que hace el aprendizaje por refuerzo estándar”, dijo Anandkumar.

Su equipo también entrena previamente a los agentes para que aprendan más rápido, logrando un progreso significativo en el videojuego más vendido del mundo, Minecraft. Es conocido como un juego de "caja de arena", lo que significa que brinda a los jugadores un espacio prácticamente infinito en el que interactuar y crear nuevos mundos. Es inútil programar una función de recompensa para miles de tareas individualmente, así que en su lugar, el modelo del equipo ("MineDojo”) construyó su comprensión del juego viendo videos de juego con subtítulos. No hay necesidad de codificar el buen comportamiento.

“Estamos obteniendo funciones de recompensa automatizadas”, dijo Anandkumar. “Este es el primer punto de referencia con miles de tareas y la capacidad de hacer un aprendizaje reforzado con tareas abiertas especificadas a través de indicaciones de texto”.

Más allá de los juegos

Los juegos fueron una excelente manera de mostrar que los modelos de entrenamiento previo podían funcionar, pero aún son mundos simplificados. Entrenar robots para manejar el mundo real, donde las posibilidades son prácticamente infinitas, es mucho más difícil. “Hicimos la pregunta: ¿Hay algo en el medio?” Dijo Narasimhan. Así que decidió hacer algunas compras en línea.

Su equipo creó WebShop. "Es básicamente como un mayordomo de compras", dijo Narasimhan. Los usuarios pueden decir algo como "Dame un zapato Nike que sea blanco y cueste menos de $100, y quiero que las reseñas indiquen que son muy cómodos para los niños pequeños", y el programa busca y compra el zapato.

Al igual que con los juegos de Zhong y Anandkumar, WebShop desarrolló una intuición entrenando con imágenes y texto, esta vez de páginas de Amazon. “Con el tiempo, aprende a comprender el idioma y mapearlo en las acciones que debe realizar en el sitio web”.

A primera vista, un mayordomo de compras puede no parecer tan futurista. Pero mientras que un chatbot de última generación puede conectarlo con la zapatilla deseada, las interacciones como realizar el pedido requieren un conjunto de habilidades completamente diferente. Y a pesar de que los altavoces Alexa o Google Home de su cabecera pueden realizar pedidos, se basan en un software propietario que lleva a cabo tareas predeterminadas. WebShop navega por la web como lo hace la gente: leyendo, escribiendo y haciendo clic.

“Es un paso más hacia la inteligencia general”, dijo Narasimhan.

Introducción

Por supuesto, hacer que los robots interactúen con el mundo real tiene sus propios desafíos. Considere una botella, por ejemplo. Puedes reconocer uno por su apariencia, sabes que está diseñado para almacenar líquidos y sabes cómo manipularlo con las manos. ¿Pueden las máquinas reales convertir palabras e imágenes en una inteligencia compleja de movimiento?

Narasimhan colaboró con Anirudha Majumdar, un especialista en robótica de Princeton, para averiguarlo. Le enseñaron a un brazo robótico a manipular herramientas que nunca antes había visto y lo entrenaron previamente utilizando un lenguaje descriptivo tomado de modelos de lenguaje exitosos. El programa aprendió más rápido y se desempeñó mejor con casi todas las herramientas y acciones, en comparación con los programas que aprenden mediante la exploración tradicional, según dE TRATAMIENTOS publicado en el servidor de preimpresión arxiv.org en junio pasado.

Los ingenieros han creado una biblioteca de comandos aún más complejos en los laboratorios de robótica de Google, también enraizados en la formación previa de creación de contexto. “El mundo de posibilidades que tienes que considerar es enorme”, dijo Karol Hausmann, científico investigador del equipo de robótica de Google. “Así que le pedimos al modelo de lenguaje que lo desglose por nosotros”.

El equipo trabajó con un robot auxiliar móvil, con un brazo de siete articulaciones, al que entrenaron usando habilidades lingüísticas. Para cualquier comando dado, como "ayúdame a limpiar mi bebida derramada", el programa usa un modelo de lenguaje para sugerir acciones de una biblioteca de 700 movimientos entrenados, como "agarrar" una toalla de papel, "recoger" la lata o " tira” la lata. Y Hausman dice que reconoce sus limitaciones con frases como “En realidad no soy capaz de limpiarlo. Pero puedo traerte una esponja. El equipo informó recientemente los resultados de este proyecto, llamado decir puede.

Otra ventaja de empoderar a los robots con modelos de lenguaje es que traducir sinónimos y palabras en otros idiomas se vuelve trivial. Una persona puede decir "girar", mientras que otra dice "rotar", y el robot entiende ambos. “Lo más loco que hemos probado es que también entiende emojis”, dijo fei xia, científico investigador de Google.

Los bots están aprendiendo

SayCan es quizás la demostración más avanzada de aprendizaje basado en lenguaje en robótica hasta la fecha. Y los modelos de lenguaje e imagen mejoran constantemente, creando mejores y más complejas técnicas de pre-entrenamiento.

Pero Xia tiene cuidado de moderar la emoción. “Alguien dijo medio en broma que llegamos al momento del 'robot GPT'”, dijo, refiriéndose a los innovadores modelos de lenguaje que comprenden una amplia gama de comandos humanos. "Todavía no hemos llegado allí, y hay mucho más por explorar".

Por ejemplo, estos modelos pueden proporcionar respuestas incorrectas o realizar acciones erróneas, que los investigadores están tratando de comprender. Los robots tampoco han dominado aún "encarnación”: Mientras que los humanos tienen una intuición física basada en la infancia que pasan jugando con juguetes, los robots aún requieren interacciones del mundo real para desarrollar este tipo de intuición. “Para algunas configuraciones, hay muchas demostraciones sin etiquetar”, dijo Zhong; piense en bases de datos de interacciones de videojuegos como Minecraft y NetHack. Ninguna base de datos puede enseñar rápidamente a los robots el movimiento inteligente.

Aún así, el progreso está ocurriendo rápidamente. Y más investigadores creen que el resultado final será una robótica más inteligente. Narasimhan rastrea esta evolución humano-robot desde las tarjetas perforadas hasta la próxima tecnología. “Teníamos teclados y ratones y luego pantallas táctiles”, dijo. El lenguaje fundamentado es el siguiente. Hablarás con tu computadora para obtener respuestas y diligencias. “Todo este sueño de que los asistentes sean realmente capaces aún no ha sucedido”, dijo. “Pero creo que sucederá muy pronto”.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://www.quantamagazine.org/machines-learn-better-if-we-teach-them-the-basics-20230201/

- 3d

- a

- capacidad

- Nuestra Empresa

- RESUMEN

- Aceptar

- de la máquina

- Conforme

- el logro de

- a través de

- la columna Acción

- acciones

- adaptar

- avanzado

- Agente

- agentes

- AI

- Alexa

- algoritmos

- Todos

- ya haya utilizado

- Amazon

- y

- Otra

- respuestas

- enfoque

- enfoques

- ARM

- armado

- en torno a

- Formación

- Consejos

- Los intentos

- Confirmación de Viaje

- Básicamente

- conceptos básicos

- porque

- a las que has recomendado

- se convierte en

- antes

- detrás de

- "Ser"

- CREEMOS

- más vendido

- mejores

- entre

- Big

- tablero

- cuerpo

- Libros

- auge

- los robots

- límites

- Descanso

- ruptura

- Brian

- llevar

- build

- construido

- Compra

- California

- , que son

- Calls

- Puede conseguir

- capaz

- Tarjetas

- cuidadoso

- Desafiado

- retos

- el cambio

- chatterbot

- Ajedrez

- Elige

- clásico

- Limpieza

- limpiar

- más cerca

- colaborado

- personal

- combinación

- cómo

- cómodo

- en comparación con

- comparación

- competir

- completar

- integraciones

- Complicado

- computadora

- Ciencias de la Computación

- Visión por computador

- conceptos

- Considerar

- constantemente

- control

- podría

- Curso

- Para crear

- creado

- Creamos

- crítico

- Current

- Corte

- innovador

- datos

- Base de datos

- bases de datos

- Fecha

- debutado

- decidido

- Descifrar

- Diseño

- deseado

- A pesar de las

- desarrollar

- desarrollado

- HIZO

- una experiencia diferente

- digital

- Dimensiones

- dimensiones

- No

- "Hacer"

- No

- DE INSCRIPCIÓN

- sueño

- durante

- cada una

- pasan fácilmente

- comer

- Southern Implants

- embarcarse

- empoderamiento

- Sin fin

- suficientes

- Entorno

- ambientes

- error

- Errores

- esencialmente

- Incluso

- finalmente

- NUNCA

- Cada

- evolución

- exactamente

- ejemplo

- Emoción

- ejecutar

- experience

- experto

- exploración

- explorar

- explorado

- exponencialmente

- FALLO

- falla

- familiar

- RÁPIDO

- más rápida

- Favorecer

- realimentación

- lucha

- Encuentre

- la búsqueda de

- encuentra

- Nombre

- formulario

- formulando

- Fundación

- Desde

- función

- funciones

- fundamental

- futurista

- Ganancias

- juego

- Juegos

- General

- inteligencia general

- generar

- generación de AHSS

- obtener

- conseguir

- GitHub

- Donar

- dado

- da

- Mirada

- objetivo

- candidato

- De Google

- graduados

- maravillosa

- Cuadrícula

- Polo a Tierra

- innovador

- crece

- Guías

- A Mitad

- encargarse de

- Manos

- suceder

- pasó

- es

- Alta

- tenencia

- Inicio

- Cómo

- Como Hacer

- HTTPS

- enorme

- humana

- Humanos

- idea

- imagen

- imágenes

- importante

- la mejora de

- in

- En otra

- cada vez más

- Individualmente

- ineficiente

- Infinito

- información

- ejemplo

- Innovadora

- Intelligence

- De Operación

- interactuar

- interacciones

- Internet

- IT

- artículos

- Trabajos

- Saber

- especialistas

- conocido

- labs

- Falta

- idioma

- Idiomas

- mayores

- Apellidos

- APRENDE:

- aprendido

- aprendizaje

- Nivel

- Biblioteca

- la limitación

- limitaciones

- Limitada

- LINK

- por más tiempo

- Mira

- parece

- Lote

- máquina

- máquina de aprendizaje

- Máquinas

- hecho

- para lograr

- manual

- muchos

- mapa

- dominar

- sentido

- significa

- Método

- podría

- millones

- Minecraft

- Móvil

- modelo

- modelos

- momento

- más,

- MEJOR DE TU

- movimiento

- se mueve

- Navegar

- ¿ Necesita ayuda

- Nuevo

- Next

- NIKE

- Nvidia

- objetos

- obstáculos

- ONE

- en línea

- las compras en línea

- habiertos

- solicite

- en pedidos de venta.

- Otro

- Otros

- de otra manera

- Superar

- EL DESARROLLADOR

- Papel

- parte

- Personas

- actuación

- quizás

- persona

- frases

- los libros físicos

- Colocar

- Lugares

- colocación

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- Jugar

- jugador

- players

- jugando

- Por favor

- política

- positivo

- POSIBILIDADES

- posible

- publicado

- Metodología

- prácticamente

- bastante

- Problema

- problemas

- tratamiento

- Programa

- Programas

- Progreso

- proyecto

- propietario

- proporcionar

- proporciona un

- Revista Quanta

- pregunta

- con rapidez

- Conejo

- alcanzado

- Reading

- real

- mundo real

- recientemente

- reconocer

- regular

- reportado

- exigir

- Requisitos

- requiere

- la investigación

- investigadores

- resultado

- Resultados

- Reseñas

- Gana dinero

- Recompensas

- robot

- robótica

- los robots

- reglas

- correr

- Said

- mismo

- Escala

- Ciencia:

- Científico

- los científicos

- mallas

- Segundo

- parece

- Secuencia

- set

- pólipo

- ajustes

- Compras

- Mostrar

- Shows

- firmar

- importante

- similares

- sencillos

- simplificado

- simplemente

- situación

- habilidad

- habilidades

- disminuye

- más inteligente

- Sneaker

- So

- Software

- RESOLVER

- algo

- algo

- sofisticado

- Espacio

- De una Charla a tu equipo

- altavoces

- especificado

- velocidad

- gastado

- estándar

- comienzo

- Estado

- quedarse

- paso

- Sin embargo

- tienda

- Luchas

- Estudiante

- tropiezos

- posterior

- tener éxito

- exitosos

- tal

- Sobrealimentar

- Todas las funciones a su disposición

- ¡Prepárate!

- toma

- Tarea

- tareas

- equipo

- técnicas

- Tecnología

- test

- La

- Lo esencial

- el mundo

- su

- cosa

- cosas

- miles

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- veces

- a

- hoy

- demasiado

- del IRS

- TOTALMENTE

- contacto

- hacia

- tradicional

- tradicionalmente

- Entrenar

- entrenado

- Formación

- juicio

- ensayos

- GIRO

- típicamente

- bajo

- entender

- comprensión

- entiende

- no informado

- universidad

- subido

- us

- utilizan el

- usuarios

- diversos

- Vasto

- Video

- videojuego

- Videos

- virtualmente

- visión

- Washington

- ver

- web

- webp

- Página web

- ¿

- que

- mientras

- complejo de salvador blanco

- todo

- totalmente

- amplio

- seguirá

- limpieza

- dentro de

- sin

- palabras

- Actividades:

- trabajado

- mundo

- mundo

- se

- Mal

- año

- Usted

- tú

- zephyrnet

- Zhong