1LIACS, Universidad de Leiden, Niels Bohrweg 1, 2333 CA Leiden, Países Bajos

2QuSoft, Centrum Wiskunde & Informatica (CWI), Science Park 123, 1098 XG Ámsterdam, Países Bajos

3Instituto de Física, Universidad de Ámsterdam, Science Park 904, 1098 XH Ámsterdam, Países Bajos

4LION, Universidad de Leiden, Niels Bohrweg 2, 2333 CA Leiden, Países Bajos

¿Encuentra este documento interesante o quiere discutirlo? Scite o deje un comentario en SciRate.

Resumen

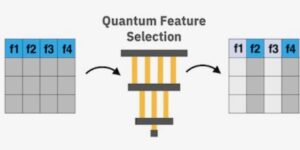

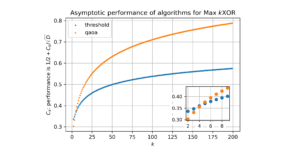

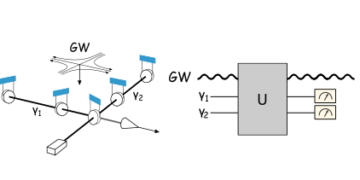

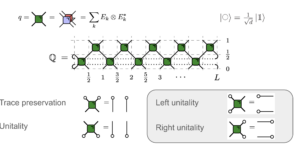

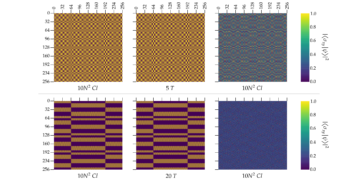

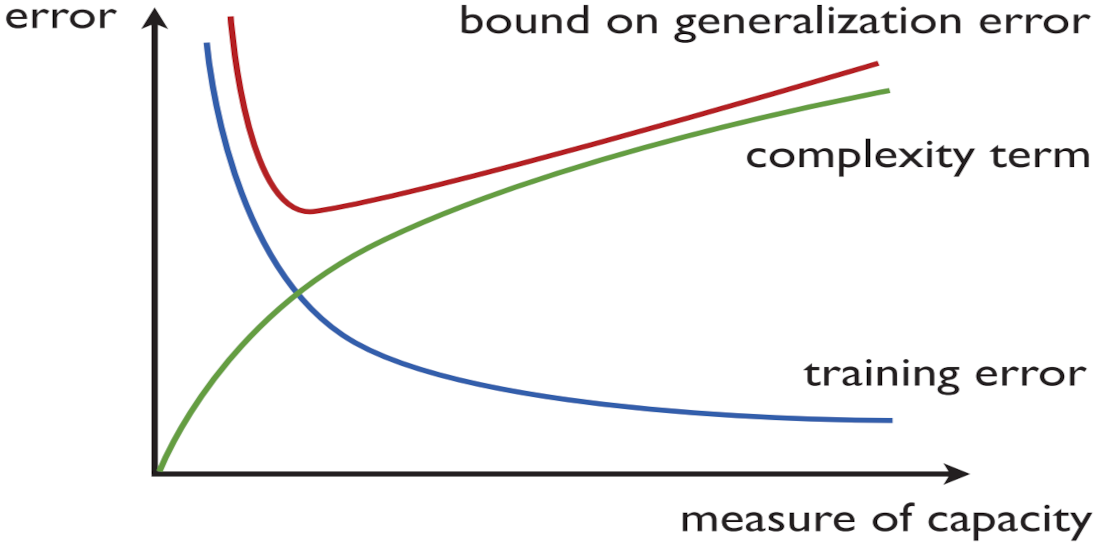

Los modelos de aprendizaje automático cuántico (QML) basados en circuitos cuánticos parametrizados a menudo se destacan como candidatos para la "aplicación asesina" a corto plazo de la computación cuántica. Sin embargo, la comprensión del desempeño empírico y de generalización de estos modelos aún está en pañales. En este artículo, estudiamos cómo equilibrar la precisión del entrenamiento y el rendimiento de la generalización (también llamado minimización del riesgo estructural) para dos modelos QML prominentes introducidos por Havlíček et al. [1], y Schuld y Killoran [2]. En primer lugar, utilizando relaciones con modelos clásicos bien entendidos, demostramos que dos parámetros del modelo, es decir, la dimensión de la suma de las imágenes y la norma de Frobenius de los observables utilizados por el modelo, controlan de cerca la complejidad de los modelos y, por lo tanto, su rendimiento de generalización. . En segundo lugar, utilizando ideas inspiradas en la tomografía de proceso, demostramos que estos parámetros del modelo también controlan de cerca la capacidad de los modelos para capturar correlaciones en conjuntos de ejemplos de entrenamiento. En resumen, nuestros resultados dan lugar a nuevas opciones para la minimización del riesgo estructural para los modelos QML.

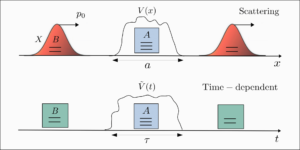

Imagen destacada: ilustración de la minimización del riesgo estructural (fuente: Mohri, Mehryar, Afshin Rostamizadeh y Ameet Talwalkar. Fundamentos del aprendizaje automático. MIT Press, 2018).

► datos BibTeX

► referencias

[ 1 ] Vojtěch Havlíček, Antonio D Córcoles, Kristan Temme, Aram W Harrow, Abhinav Kandala, Jerry M Chow y Jay M Gambetta. “Aprendizaje supervisado con espacios de funciones mejorados cuánticamente”. Naturaleza 567 (2019). arXiv:1804.11326.

https://doi.org/10.1038/s41586-019-0980-2

arXiv: 1804.11326

[ 2 ] María Schuld y Nathan Killoran. “Aprendizaje automático cuántico en espacios característicos de Hilbert”. Cartas de revisión física 122 (2019). arXiv:1803.07128.

https: / / doi.org/ 10.1103 / PhysRevLett.122.040504

arXiv: 1803.07128

[ 3 ] Frank Arute, Kunal Arya, Ryan Babbush, Dave Bacon, Joseph C Bardin, Rami Barends, Rupak Biswas, Sergio Boixo, Fernando GSL Brandao, David A Buell, et al. “Supremacía cuántica utilizando un procesador superconductor programable”. Naturaleza 574 (2019). arXiv:1910.11333.

https://doi.org/10.1038/s41586-019-1666-5

arXiv: 1910.11333

[ 4 ] Juan Preskill. “Computación cuántica en la era NISQ y más allá”. Cuántica 2 (2018). arXiv:1801.00862.

https://doi.org/10.22331/q-2018-08-06-79

arXiv: 1801.00862

[ 5 ] Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio, et al. “Algoritmos cuánticos variacionales”. Nature Reviews Física 3 (2021). arXiv:2012.09265.

https://doi.org/10.1038/s42254-021-00348-9

arXiv: 2012.09265

[ 6 ] Jarrod R McClean, Jonathan Romero, Ryan Babbush y Alán Aspuru-Guzik. “La teoría de los algoritmos cuánticos-clásicos híbridos variacionales”. Nueva Revista de Física 18 (2016). arXiv:1509.04279.

https://doi.org/10.1088/1367-2630/18/2/023023

arXiv: 1509.04279

[ 7 ] Abhinav Kandala, Antonio Mezzacapo, Kristan Temme, Maika Takita, Markus Brink, Jerry M Chow y Jay M Gambetta. “Eigensolver cuántico variacional eficiente en hardware para moléculas pequeñas e imanes cuánticos”. Naturaleza 549 (2017). arXiv:1704.05018.

https: / / doi.org/ 10.1038 / nature23879

arXiv: 1704.05018

[ 8 ] Peter JJ O'Malley, Ryan Babbush, Ian D Kivlichan, Jonathan Romero, Jarrod R McClean, Rami Barends, Julian Kelly, Pedram Roushan, Andrew Tranter, Nan Ding, et al. “Simulación cuántica escalable de energías moleculares”. Revisión física X 6 (2016). arXiv:1512.06860.

https: / / doi.org/ 10.1103 / PhysRevX.6.031007

arXiv: 1512.06860

[ 9 ] Edward Farhi, Jeffrey Goldstone y Sam Gutmann. “Un algoritmo de optimización cuántica aproximada” (2014). arXiv:1411.4028.

arXiv: 1411.4028

[ 10 ] Marcello Benedetti, Erika Lloyd, Stefan Sack y Mattia Fiorentini. “Circuitos cuánticos parametrizados como modelos de aprendizaje automático”. Ciencia y Tecnología Cuántica 4 (2019). arXiv:1906.07682.

https://doi.org/10.1088/2058-9565/ab4eb5

arXiv: 1906.07682

[ 11 ] Barbara M Terhal y David P DiVincenzo. “Computación cuántica adaptativa, circuitos cuánticos de profundidad constante y juegos arthur-merlin”. Información cuántica y computación 4 (2004). arXiv:quant-ph/0205133.

https://doi.org/10.48550/arXiv.quant-ph/0205133

arXiv: quant-ph / 0205133

[ 12 ] Michael J Bremner, Richard Jozsa y Dan J Shepherd. “La simulación clásica de cómputos cuánticos de conmutación implica el colapso de la jerarquía polinomial”. Actas de la Royal Society A: Ciencias Matemáticas, Físicas y de Ingeniería 467 (2011). arXiv:1005.1407.

https: / / doi.org/ 10.1098 / rspa.2010.0301

arXiv: 1005.1407

[ 13 ] Edward Grant, Marcello Benedetti, Shuxiang Cao, Andrew Hallam, Joshua Lockhart, Vid Stojevic, Andrew G Green y Simone Severini. “Clasificadores cuánticos jerárquicos”. npj Información cuántica 4 (2018). arXiv:1804.03680.

https://doi.org/10.1038/s41534-018-0116-9

arXiv: 1804.03680

[ 14 ] Diego Ristè, Marcus P Da Silva, Colm A Ryan, Andrew W Cross, Antonio D Córcoles, John A Smolin, Jay M Gambetta, Jerry M Chow y Blake R Johnson. “Demostración de la ventaja cuántica en el aprendizaje automático”. npj Información cuántica 3 (2017). arXiv:1512.06069.

https://doi.org/10.1038/s41534-017-0017-3

arXiv: 1512.06069

[ 15 ] Mehryar Mohri, Afshin Rostamizadeh y Ameet Talwalkar. “Fundamentos del aprendizaje automático”. Prensa del MIT. (2018).

[ 16 ] Peter L. Bartlett. “La complejidad muestral de la clasificación de patrones con redes neuronales: el tamaño de los pesos es más importante que el tamaño de la red”. Transacciones IEEE sobre teoría de la información 44 (1998).

https: / / doi.org/ 10.1109 / 18.661502

[ 17 ] María Schuld. “Los modelos de aprendizaje automático cuántico supervisados son métodos kernel” (2021). arXiv:2101.11020.

arXiv: 2101.11020

[ 18 ] Matthias C Caro e Ishaun Datta. “Pseudo-dimensión de circuitos cuánticos”. Inteligencia mecánica cuántica 2 (2020). arXiv:2002.01490.

https://doi.org/10.1007/s42484-020-00027-5

arXiv: 2002.01490

[ 19 ] Kaifeng Bu, Dax Enshan Koh, Lu Li, Qingxian Luo y Yaobo Zhang. “Sobre la complejidad estadística de los circuitos cuánticos” (2021). arXiv:2101.06154.

https: / / doi.org/ 10.1103 / PhysRevA.105.062431

arXiv: 2101.06154

[ 20 ] Kaifeng Bu, Dax Enshan Koh, Lu Li, Qingxian Luo y Yaobo Zhang. “Efectos de los recursos cuánticos sobre la complejidad estadística de los circuitos cuánticos” (2021). arXiv:2102.03282.

arXiv: 2102.03282

[ 21 ] Kaifeng Bu, Dax Enshan Koh, Lu Li, Qingxian Luo y Yaobo Zhang. “Complejidad de Rademacher de circuitos cuánticos ruidosos” (2021). arXiv:2103.03139.

arXiv: 2103.03139

[ 22 ] Amira Abbas, David Sutter, Christa Zoufal, Aurélien Lucchi, Alessio Figalli y Stefan Woerner. “El poder de las redes neuronales cuánticas”. Naturaleza Ciencias Computacionales 1 (2021). arXiv:2011.00027.

https://doi.org/10.1038/s43588-021-00084-1

arXiv: 2011.00027

[ 23 ] Yuxuan Du, Zhuozhuo Tu, Xiao Yuan y Dacheng Tao. “Medida eficiente de la expresividad de algoritmos cuánticos variacionales”. Cartas de revisión física 128 (2022). arXiv:2104.09961.

https: / / doi.org/ 10.1103 / PhysRevLett.128.080506

arXiv: 2104.09961

[ 24 ] Leonardo Banchi, Jason Pereira y Stefano Pirandola. “Generalización en el aprendizaje automático cuántico: un punto de vista de la información cuántica”. PRX Quantum 2 (2021). arXiv:2102.08991.

https: / / doi.org/ 10.1103 / PRXQuantum.2.040321

arXiv: 2102.08991

[ 25 ] Hsin-Yuan Huang, Michael Broughton, Masoud Mohseni, Ryan Babbush, Sergio Boixo, Hartmut Neven y Jarrod R McClean. “El poder de los datos en el aprendizaje automático cuántico”. Comunicaciones de la naturaleza 12 (2021). arXiv:2011.01938.

https://doi.org/10.1038/s41467-021-22539-9

arXiv: 2011.01938

[ 26 ] Yunchao Liu, Srinivasan Arunachalam y Kristan Temme. “Una aceleración cuántica rigurosa y robusta en el aprendizaje automático supervisado”. Física de la naturaleza 17, 1013–1017 (2021). arXiv:2010.02174.

https: / / doi.org/ 10.1038 / s41567-021-01287-z

arXiv: 2010.02174

[ 27 ] Bernhard Schölkopf, Alexander J Smola, Francis Bach, et al. “Aprendizaje con kernels: máquinas de vectores de soporte, regularización, optimización y más”. Prensa del MIT. (2002).

https: / / doi.org/ 10.7551 / mitpress / 4175.001.0001

[ 28 ] Vladimir N Vapnik y A Ya Chervonenkis. “Sobre la convergencia uniforme de frecuencias relativas de eventos a sus probabilidades”. En Medidas de complejidad. Springer (2015).

https://doi.org/10.1007/978-3-319-21852-6_3

[ 29 ] Michael J Kearns y Robert E Schapire. “Aprendizaje eficiente sin distribución de conceptos probabilísticos”. Revista de Ciencias de la Computación y Sistemas 48 (1994).

https://doi.org/10.1016/S0022-0000(05)80062-5

[ 30 ] Michael M Lobo. “Fundamentos matemáticos del aprendizaje supervisado”. https://www-m5.ma.tum.de/foswiki/pub/M5/Allgemeines/MA4801_2020S/ML_notes_main.pdf (2020).

https: / / www-m5.ma.tum.de/ foswiki / pub / M5 / Allgemeines / MA4801_2020S / ML_notes_main.pdf

[ 31 ] Dyon van Vreumingen. “Aprendizaje espacial de características cuánticas: caracterización y posibles ventajas”. Tesis de maestría. Universidad de Leiden. (2020).

[ 32 ] Jae-Eun Park, Brian Quanz, Steve Wood, Heather Higgins y Ray Harishankar. “Mejora de la aplicación práctica a svm cuántica: de la teoría a la práctica” (2020). arXiv:2012.07725.

arXiv: 2012.07725

[ 33 ] John Shawe-Taylor, Peter L. Bartlett, Robert C. Williamson y Martin Anthony. “Minimización de riesgos estructurales sobre jerarquías dependientes de datos”. Transacciones IEEE sobre teoría de la información (1998).

https: / / doi.org/ 10.1109 / 18.705570

[ 34 ] Martin Anthony y Peter L. Bartlett. “Aprendizaje de funciones por interpolación”. Combinatoria, Probabilidad y Computación 9 (2000).

https: / / doi.org/ 10.1017 / S0963548300004247

[ 35 ] Peter L Bartlett y Philip M Long. “Predicción, aprendizaje, convergencia uniforme y dimensiones sensibles a la escala”. Revista de Ciencias de la Computación y Sistemas 56 (1998).

https: / / doi.org/ 10.1006 / jcss.1997.1557

[ 36 ] Scott Aaronson. “La capacidad de aprendizaje de los estados cuánticos”. Actas de la Royal Society A: Ciencias Matemáticas, Físicas y de Ingeniería 463 (2007). arXiv:quant-ph/0608142.

https: / / doi.org/ 10.1098 / rspa.2007.0113

arXiv: quant-ph / 0608142

Citado por

[1] Matthias C. Caro, Hsin-Yuan Huang, M. Cerezo, Kunal Sharma, Andrew Sornborger, Lukasz Cincio y Patrick J. Coles, "Generalización en el aprendizaje cuántico de máquinas a partir de pocos datos de entrenamiento", Comunicaciones de la naturaleza 13, 4919 (2022).

[2] Matthias C. Caro, Hsin-Yuan Huang, Nicholas Ezzell, Joe Gibbs, Andrew T. Sornborger, Lukasz Cincio, Patrick J. Coles y Zoë Holmes, “Generalización fuera de distribución para el aprendizaje de la dinámica cuántica”, arXiv: 2204.10268.

[3] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu, Shan You y Dacheng Tao, “Aprendebilidad de las redes neuronales cuánticas”, PRX Cuántico 2 4, 040337 (2021).

[4] Joe Gibbs, Zoë Holmes, Matthias C. Caro, Nicholas Ezzell, Hsin-Yuan Huang, Lukasz Cincio, Andrew T. Sornborger y Patrick J. Coles, "Simulación dinámica a través del aprendizaje automático cuántico con generalización demostrable", arXiv: 2204.10269.

[5] Sofiene Jerbi, Lukas J. Fiderer, Hendrik Poulsen Nautrup, Jonas M. Kübler, Hans J. Briegel y Vedran Dunjko, “Aprendizaje automático cuántico más allá de los métodos del núcleo”, arXiv: 2110.13162.

[6] Matthias C. Caro, Elies Gil-Fuster, Johannes Jakob Meyer, Jens Eisert y Ryan Sweke, “Límites de generalización dependientes de la codificación para circuitos cuánticos parametrizados”, arXiv: 2106.03880.

[7] Supanut Thanasilp, Samson Wang, M. Cerezo y Zoë Holmes, “Concentración exponencial y falta de entrenamiento en métodos de núcleo cuántico”, arXiv: 2208.11060.

[8] Masahiro Kobayashi, Kohei Nakaji y Naoki Yamamoto, “Overfitting in quantum machine learning and entangling dropout”, arXiv: 2205.11446.

[9] Brian Coyle, "Aplicaciones de aprendizaje automático para computadoras cuánticas ruidosas de escala intermedia", arXiv: 2205.09414.

[10] Evan Peters y Maria Schuld, "Generalización a pesar del sobreajuste en modelos de aprendizaje automático cuántico", arXiv: 2209.05523.

[11] Marco Fanizza, Yihui Quek y Matteo Rosati, “Aprendizaje de procesos cuánticos sin control de entrada”, arXiv: 2211.05005.

[12] Dylan Herman, Rudy Raymond, Muyuan Li, Nicolas Robles, Antonio Mezzacapo y Marco Pistoia, “Expressivity of Variational Quantum Machine Learning on the Boolean Cube”, arXiv: 2204.05286.

[13] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu, Shan You y Dacheng Tao, "Erratum: Learnability of Quantum Neural Networks [PRX QUANTUM 2, 040337 (2021)]", PRX Cuántico 3 3, 030901 (2022).

[14] Chih-Chieh Chen, Masaru Sogabe, Kodai Shiba, Katsuyoshi Sakamoto y Tomah Sogabe, “Límites de dimensión generales de Vapnik-Chervonenkis para el aprendizaje de circuitos cuánticos”, Journal of Physics: Complejidad 3 4, 045007 (2022).

[15] Yuxuan Du, Yibo Yang, Dacheng Tao y Min-Hsiu Hsieh, "Desmitificar el poder dependiente del problema de las redes neuronales cuánticas en la clasificación de clases múltiples", arXiv: 2301.01597.

Las citas anteriores son de ANUNCIOS SAO / NASA (última actualización exitosa 2023-01-15 10:53:14). La lista puede estar incompleta ya que no todos los editores proporcionan datos de citas adecuados y completos.

On Servicio citado por Crossref no se encontraron datos sobre las obras citadas (último intento 2023-01-15 10:53:12).

Este documento se publica en Quantum bajo el Creative Commons Reconocimiento 4.0 Internacional (CC BY 4.0) licencia. Los derechos de autor permanecen con los titulares de derechos de autor originales, como los autores o sus instituciones.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- Platoblockchain. Inteligencia del Metaverso Web3. Conocimiento amplificado. Accede Aquí.

- Fuente: https://quantum-journal.org/papers/q-2023-01-13-893/

- 1

- 10

- 11

- 1994

- 1998

- 2011

- 2012

- 2014

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 28

- 7

- 9

- a

- Abbas

- capacidad

- arriba

- RESUMEN

- de la máquina

- la exactitud

- Ventaja

- ventajas

- afiliaciones

- Alexander

- algoritmo

- algoritmos

- Todos

- Ámsterdam

- y

- Antonio

- Aplicación

- aplicaciones

- autor

- Autorzy

- Balance

- basado

- Benjamin

- entre

- Más allá de

- Bloquear

- Descanso

- Brian

- borde

- CA

- , que son

- candidatos

- capturar

- Casper

- chen

- clasificación

- de cerca

- Colapso

- comentario

- Los comunes

- Comunicaciónes

- conmutando

- completar

- complejidad

- cálculo

- computaciones

- computadora

- computadoras

- informática

- concentración

- conceptos

- constante

- control

- Convergencia

- derechos de autor,

- Cruz

- CWI

- datos

- David

- David

- profundidad

- A pesar de las

- Diego

- Dimensiones

- dimensiones

- discutir

- documento

- dinámica

- Edward

- Ingeniería

- Era

- Erika

- Eventos

- ejemplos

- exponencial

- Feature

- pocos

- encontrado

- Fundamentos

- Desde

- FS

- Juegos

- General

- Donar

- conceder

- Verde

- harvard

- jerarquía

- Destacado

- titulares

- Cómo

- Como Hacer

- Sin embargo

- HTTPS

- Híbrido

- híbrido cuántico-clásico

- ideas

- IEEE

- imagen

- imágenes

- importante

- es la mejora continua

- in

- información

- Las opciones de entrada

- inspirado

- instituciones

- Intelligence

- interesante

- Internacional

- Introducido

- Ene

- JavaScript

- JOE

- Juan

- Johnson

- revista

- Apellidos

- aprendizaje

- Abandonar

- Li

- Licencia

- Lista

- Largo

- máquina

- máquina de aprendizaje

- Máquinas

- Imanes

- Marco

- Marcus

- Martin

- dominar

- matemático

- max-ancho

- medir

- medidas

- métodos

- Meyer

- Michael

- minimización

- MIT

- modelo

- modelos

- molecular

- Mes

- más,

- Naturaleza

- del sistema,

- telecomunicaciones

- redes neuronales

- Nuevo

- Nicolas

- ruido

- habiertos

- optimización

- Opciones

- reconocida por

- Papel

- parámetros

- Tayrona

- Patrón de Costura

- (PDF)

- actuación

- Peter

- los libros físicos

- Física

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- posible

- industria

- Metodología

- prensa

- Proceso

- en costes

- Procesador

- destacado

- Demostrar.

- proporcionar

- publicado

- editor

- editores

- Cuántico

- ventaja cuántica

- algoritmos cuánticos

- computadoras cuánticas

- computación cuántica

- información cuántica

- aprendizaje de máquina cuántica

- EXTRAÑO

- RAY

- referencias

- Relaciones

- permanece

- Recursos

- Resultados

- una estrategia SEO para aparecer en las búsquedas de Google.

- Reseñas

- Dick

- riguroso

- Subir

- Riesgo

- ROBERT

- robusto

- Rosati

- real

- Ryan

- Diana

- Ciencia:

- Ciencia y Tecnología

- CIENCIAS

- scott aaronson

- Sets

- Sharma

- Shiba

- Simon

- simulación

- Tamaño

- chica

- Sociedades

- Fuente

- Espacio

- espacios

- Zonas

- estadístico

- Steve

- Sin embargo

- estructural

- ESTUDIO

- papa

- Con éxito

- tal

- adecuado

- RESUMEN

- superconductor

- SOPORTE

- te

- Tecnología

- La

- su

- por lo tanto

- Título

- a

- Formación

- Transacciones

- bajo

- comprensión

- entendido

- universidad

- actualizado

- Enlance

- vía

- volumen

- W

- sin

- Lobo

- funciona

- X

- año

- Usted

- Yuan

- zephyrnet