A medida que las organizaciones implementan modelos en producción, buscan constantemente formas de optimizar el rendimiento de sus modelos básicos (FM) que se ejecutan en los aceleradores más recientes, como Inferencia de AWS y GPU, para que puedan reducir sus costos y disminuir la latencia de respuesta para brindar la mejor experiencia a los usuarios finales. Sin embargo, algunos FM no utilizan completamente los aceleradores disponibles en las instancias en las que están implementados, lo que genera un uso ineficiente de los recursos de hardware. Algunas organizaciones implementan varios FM en la misma instancia para utilizar mejor todos los aceleradores disponibles, pero esto requiere una orquestación de infraestructura compleja que requiere mucho tiempo y es difícil de administrar. Cuando varios FM comparten la misma instancia, cada FM tiene sus propias necesidades de escalado y patrones de uso, lo que dificulta predecir cuándo es necesario agregar o eliminar instancias. Por ejemplo, un modelo puede usarse para impulsar una aplicación de usuario donde el uso puede aumentar durante ciertas horas, mientras que otro modelo puede tener un patrón de uso más consistente. Además de optimizar los costos, los clientes quieren brindar la mejor experiencia al usuario final reduciendo la latencia. Para hacer esto, a menudo implementan múltiples copias de un FM para atender las solicitudes de los usuarios en paralelo. Debido a que los resultados de FM pueden variar desde una sola oración hasta varios párrafos, el tiempo que lleva completar la solicitud de inferencia varía significativamente, lo que genera picos impredecibles en la latencia si las solicitudes se enrutan aleatoriamente entre instancias. Amazon SageMaker ahora admite nuevas capacidades de inferencia que le ayudan a reducir los costos de implementación y la latencia.

Ahora puede crear puntos finales basados en componentes de inferencia e implementar modelos de aprendizaje automático (ML) en un punto final de SageMaker. Un componente de inferencia (IC) abstrae su modelo de ML y le permite asignar CPU, GPU o AWS neurona aceleradores y políticas de escalado por modelo. Los componentes de inferencia ofrecen los siguientes beneficios:

- SageMaker colocará y empaquetará modelos de manera óptima en instancias de ML para maximizar la utilización, lo que generará ahorros de costos.

- SageMaker ampliará y reducirá cada modelo según su configuración para cumplir con los requisitos de su aplicación de aprendizaje automático.

- SageMaker escalará para agregar y eliminar instancias dinámicamente para garantizar que haya capacidad disponible y al mismo tiempo mantener la computación inactiva al mínimo.

- Puede reducir la escala a cero copias de un modelo para liberar recursos para otros modelos. También puede especificar mantener los modelos importantes siempre cargados y listos para atender el tráfico.

Con estas capacidades, puede reducir los costos de implementación del modelo en un 50 % en promedio. Los ahorros de costos variarán según su carga de trabajo y patrones de tráfico. Tomemos un ejemplo simple para ilustrar cómo empaquetar varios modelos en un único punto final puede maximizar la utilización y ahorrar costos. Supongamos que tiene una aplicación de chat que ayuda a los turistas a comprender las costumbres locales y las mejores prácticas creadas utilizando dos variantes de Llama 2: una adaptada para los visitantes europeos y la otra adaptada para los visitantes estadounidenses. Esperamos tráfico para el modelo europeo entre las 00:01 y las 11:59 UTC y para el modelo americano entre las 12:00 y las 23:59 UTC. En lugar de implementar estos modelos en sus propias instancias dedicadas, donde permanecerán inactivos la mitad del tiempo, ahora puede implementarlos en un único punto final para ahorrar costos. Puede reducir el modelo americano a cero cuando no sea necesario para liberar capacidad para el modelo europeo y viceversa. Esto le permite utilizar su hardware de manera eficiente y evitar desperdicios. Este es un ejemplo simple que utiliza dos modelos, pero puede ampliar fácilmente esta idea para empaquetar cientos de modelos en un único punto final que aumenta y disminuye automáticamente con su carga de trabajo.

En esta publicación, le mostramos las nuevas capacidades de los puntos finales de SageMaker basados en IC. También lo guiaremos en la implementación de múltiples modelos utilizando componentes de inferencia y API. Por último, detallamos algunas de las nuevas capacidades de observabilidad y cómo configurar políticas de escalado automático para sus modelos y administrar el escalado de instancias para sus puntos finales. También puede implementar modelos a través de nuestra nueva experiencia de usuario interactiva y simplificada. También admitimos capacidades de enrutamiento avanzadas para optimizar la latencia y el rendimiento de sus cargas de trabajo de inferencia.

Bloques de construcción

Echemos un vistazo más profundo y comprendamos cómo funcionan estas nuevas capacidades. La siguiente es una terminología nueva para el alojamiento de SageMaker:

- Componente de inferencia – Un objeto de alojamiento de SageMaker que puede utilizar para implementar un modelo en un punto final. Puede crear un componente de inferencia proporcionando lo siguiente:

- El modelo de SageMaker o la especificación de una imagen y artefactos del modelo compatibles con SageMaker.

- Calcule los requisitos de recursos, que especifican las necesidades de cada copia de su modelo, incluidos los núcleos de CPU, la memoria del host y la cantidad de aceleradores.

- copia modelo – Una copia en tiempo de ejecución de un componente de inferencia que es capaz de atender solicitudes.

- Escalado automático de instancias administradas – Una capacidad de alojamiento de SageMaker para aumentar o reducir la cantidad de instancias informáticas utilizadas para un punto final. El escalado de instancias reacciona al escalado de los componentes de inferencia.

Para crear un nuevo componente de inferencia, puede especificar una imagen de contenedor y un artefacto de modelo, o puede usar modelos de SageMaker que quizás ya haya creado. También debe especificar los requisitos de recursos informáticos, como la cantidad de núcleos de CPU del host, la memoria del host o la cantidad de aceleradores que su modelo necesita para ejecutarse.

Cuando implementa un componente de inferencia, puede especificar MinCopies para garantizar que el modelo ya esté cargado en la cantidad que necesita, listo para atender las solicitudes.

También tiene la opción de configurar sus políticas para que las copias del componente de inferencia se escalen a cero. Por ejemplo, si no tiene ninguna carga ejecutándose en un IC, se descargará la copia del modelo. Esto puede liberar recursos que pueden ser reemplazados por cargas de trabajo activas para optimizar la utilización y la eficiencia de su punto final.

A medida que las solicitudes de inferencia aumentan o disminuyen, la cantidad de copias de sus circuitos integrados también puede aumentar o reducir según sus políticas de escalado automático. SageMaker se encargará de la ubicación para optimizar el embalaje de sus modelos en términos de disponibilidad y costo.

Además, si habilita el escalado automático de instancias administradas, SageMaker escalará las instancias informáticas de acuerdo con la cantidad de componentes de inferencia que deben cargarse en un momento determinado para atender el tráfico. SageMaker ampliará las instancias y empaquetará sus instancias y componentes de inferencia para optimizar los costos y preservar el rendimiento del modelo. Aunque recomendamos el uso del escalado de instancias administradas, también tiene la opción de administrar el escalado usted mismo, si así lo desea, a través del escalado automático de aplicaciones.

SageMaker reequilibrará los componentes de inferencia y reducirá las instancias si los componentes de inferencia ya no las necesitan y le ahorrará costos.

Tutorial de las API

SageMaker ha introducido una nueva entidad llamada InferenceComponent. Esto desacopla los detalles de alojar el modelo ML del propio punto final. El InferenceComponent le permite especificar propiedades clave para alojar el modelo, como el modelo de SageMaker que desea utilizar o los detalles del contenedor y los artefactos del modelo. También especifica la cantidad de copias de los componentes que se implementarán y la cantidad de aceleradores (aceleradores GPU, Inf o Trn) o CPU (vCPU) necesarios. Esto le proporciona más flexibilidad para utilizar un único punto final para cualquier cantidad de modelos que planee implementar en él en el futuro.

Veamos las llamadas a la API de Boto3 para crear un punto final con un componente de inferencia. Tenga en cuenta que hay algunos parámetros que abordamos más adelante en esta publicación.

El siguiente es un código de ejemplo para CreateEndpointConfig:

El siguiente es un código de ejemplo para CreateEndpoint:

El siguiente es un código de ejemplo para CreateInferenceComponent:

Este desacoplamiento de InferenceComponent a un punto final proporciona flexibilidad. Puede alojar varios modelos en la misma infraestructura, agregándolos o eliminándolos a medida que cambien sus requisitos. Cada modelo se puede actualizar de forma independiente según sea necesario. Además, puede escalar modelos según las necesidades de su negocio. InferenceComponent También permite controlar la capacidad por modelo. En otras palabras, puede determinar cuántas copias de cada modelo desea alojar. Esta escala predecible le ayuda a cumplir con los requisitos de latencia específicos de cada modelo. En general, InferenceComponent le brinda mucho más control sobre sus modelos alojados.

En la siguiente tabla, mostramos una comparación lado a lado del enfoque de alto nivel para crear e invocar un punto final sin InferenceComponent y con InferenceComponent. Tenga en cuenta que CreateModel() ahora es opcional para puntos finales basados en IC.

| paso | Puntos finales basados en modelos | Puntos finales basados en componentes de inferencia |

| 1 | Crear modelo(…) | CrearEndpointConfig(…) |

| 2 | CrearEndpointConfig(…) | Crear punto final(...) |

| 3 | Crear punto final(...) | Crear componente de inferencia (...) |

| 4 | Invocar punto final(…) | InvokeEndpoint(InferneceComponentName='valor'…) |

La introducción de InferenceComponent le permite escalar a nivel de modelo. Ver Profundice en el escalado automático de instancias y IC para obtener más detalles sobre cómo InferenceComponent Funciona con escalado automático.

Al invocar el punto final de SageMaker, ahora puede especificar el nuevo parámetro InferenceComponentName para alcanzar el deseado InferenceComponentName. SageMaker se encargará de enrutar la solicitud a la instancia que aloja la solicitud. InferenceComponentName. Ver el siguiente código:

De forma predeterminada, SageMaker utiliza el enrutamiento aleatorio de las solicitudes a las instancias que respaldan su punto final. Si desea habilitar el enrutamiento de solicitudes menos pendientes, puede configurar la estrategia de enrutamiento en la configuración del punto final. RoutingConfig:

Las solicitudes menos pendientes enrutan rutas a las instancias específicas que tienen más capacidad para procesar solicitudes. Esto proporcionará un equilibrio de carga y una utilización de recursos más uniformes.

Además de nuestras localidaded en CreateInferenceComponent, las siguientes API ahora están disponibles:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

Registros y métricas de InferenceComponent

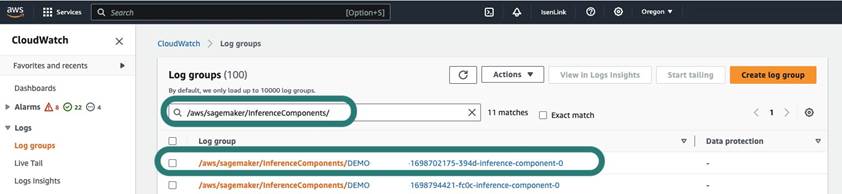

InferenceComponent los registros se encuentran en /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Todos los registros enviados a stderr y stdout en el contenedor se envían a estos registros en Reloj en la nube de Amazon.

Con la introducción de puntos finales basados en IC, ahora tiene la capacidad de ver métricas de instancia adicionales, métricas de componentes de inferencia y métricas de invocación.

Para instancias de SageMaker, ahora puede realizar un seguimiento de las GPUReservation y CPUReservation métricas para ver los recursos reservados para un punto final en función de los componentes de inferencia que haya implementado. Estas métricas pueden ayudarle a dimensionar sus políticas de endpoint y de escalado automático. También puede ver las métricas agregadas asociadas con todos los modelos implementados en un punto final.

SageMaker también expone métricas a nivel de componente de inferencia, lo que puede mostrar una vista más granular de la utilización de recursos para los componentes de inferencia que ha implementado. Esto le permite obtener una vista de cuánta utilización de recursos agregados, como GPUUtilizationNormalized y GPUMemoryUtilizationNormalized para cada componente de inferencia que haya implementado y que pueda tener cero o muchas copias.

Por último, SageMaker proporciona métricas de invocación, que ahora rastrean las invocaciones de componentes de inferencia de forma agregada (Invocations) o por copia instanciada (InvocationsPerCopy)

Para obtener una lista completa de métricas, consulte Métricas de invocación de puntos finales de SageMaker.

Escalado automático a nivel de modelo

Para implementar el comportamiento de escalado automático que describimos, al crear la configuración del punto final de SageMaker y el componente de inferencia, usted define el recuento de instancias inicial y el recuento de copias del modelo inicial, respectivamente. Después de crear el punto final y los IC correspondientes, para aplicar el escalado automático en el nivel de IC, primero debe registrar el objetivo de escalado y luego asociar la política de escalado al IC.

Al implementar la política de escalamiento, utilizamos SageMakerInferenceComponentInvocationsPerCopy, que es una nueva métrica introducida por SageMaker. Captura el número promedio de invocaciones por copia de modelo por minuto.

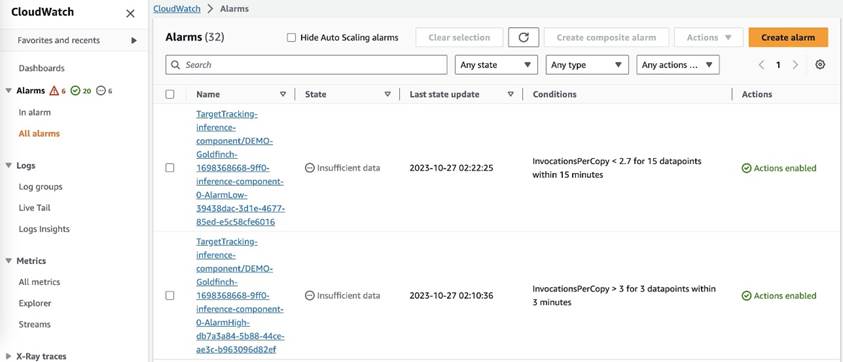

Después de configurar la política de escalado, SageMaker crea dos alarmas de CloudWatch para cada objetivo de escalado automático: una para activar el escalado horizontal si hay alarma durante 3 minutos (tres puntos de datos de 1 minuto) y otra para activar el escalamiento horizontal si hay alarma durante 15 minutos. (15 puntos de datos de 1 minuto), como se muestra en la siguiente captura de pantalla. El tiempo para activar la acción de escalado suele ser entre 1 y 2 minutos más que esos minutos porque el punto final necesita tiempo para publicar métricas en CloudWatch y también lleva tiempo para AutoScaling reaccionar. El período de recuperación es la cantidad de tiempo, en segundos, que transcurre después de que se completa una actividad de ampliación o ampliación antes de que pueda comenzar otra actividad de ampliación. Si el tiempo de recuperación de escalamiento horizontal es más corto que el tiempo de actualización del punto final, entonces no tiene ningún efecto, porque no es posible actualizar un punto final de SageMaker cuando está en Actualización de de estado.

Tenga en cuenta que, al configurar el escalado automático de nivel IC, debe asegurarse de que MaxInstanceCount El parámetro es igual o menor que el número máximo de circuitos integrados que este punto final puede manejar. Por ejemplo, si su punto final solo está configurado para tener una instancia en la configuración del punto final y esta instancia solo puede alojar un máximo de cuatro copias del modelo, entonces el MaxInstanceCount debe ser igual o menor que 4. Sin embargo, también puede utilizar la capacidad de escalado automático administrado proporcionada por SageMaker para escalar automáticamente el recuento de instancias en función del número de copias del modelo requerido para satisfacer la necesidad de más recursos informáticos. El siguiente fragmento de código demuestra cómo configurar el escalado de instancias administradas durante la creación de la configuración del punto final. De esta manera, cuando el escalado automático a nivel de IC requiere más recuento de instancias para alojar las copias del modelo, SageMaker escalará automáticamente el número de instancia para permitir que el escalado a nivel de IC sea exitoso.

Puede aplicar varias políticas de escalado automático en el mismo punto final, lo que significa que podrá aplicar la política de escalado automático tradicional a los puntos finales creados con circuitos integrados y escalar hacia arriba y hacia abajo según las otras métricas de los puntos finales. Para obtener más información, consulte Optimice sus implementaciones de aprendizaje automático con escalado automático en Amazon SageMaker. Sin embargo, aunque esto es posible, recomendamos utilizar el escalado de instancias administradas en lugar de administrar el escalado usted mismo.

Conclusión

En esta publicación, presentamos una nueva característica en la inferencia de SageMaker que lo ayudará a maximizar la utilización de instancias informáticas, escalar a cientos de modelos y optimizar costos, al mismo tiempo que brinda un rendimiento predecible. Además, proporcionamos un tutorial de las API y le mostramos cómo configurar e implementar componentes de inferencia para sus cargas de trabajo.

También apoyamos capacidades de enrutamiento avanzadas para optimizar la latencia y el rendimiento de sus cargas de trabajo de inferencia. SageMaker puede ayudarlo a optimizar sus cargas de trabajo de inferencia en términos de costo y rendimiento y brindarle granularidad a nivel de modelo para la administración. Hemos creado un conjunto de cuadernos que le mostrará cómo implementar tres modelos diferentes, utilizando diferentes contenedores y aplicando políticas de escalado automático en GitHub. ¡Lo alentamos a comenzar con el cuaderno 1 y ponerse manos a la obra con las nuevas capacidades de alojamiento de SageMaker hoy mismo!

Sobre los autores

James Park es arquitecto de soluciones en Amazon Web Services. Trabaja con Amazon.com para diseñar, construir e implementar soluciones tecnológicas en AWS y tiene un interés particular en la inteligencia artificial y el aprendizaje automático. En su tiempo libre le gusta buscar nuevas culturas, nuevas experiencias y mantenerse al día con las últimas tendencias tecnológicas. Puedes encontrarlo en Etiqueta LinkedIn.

James Park es arquitecto de soluciones en Amazon Web Services. Trabaja con Amazon.com para diseñar, construir e implementar soluciones tecnológicas en AWS y tiene un interés particular en la inteligencia artificial y el aprendizaje automático. En su tiempo libre le gusta buscar nuevas culturas, nuevas experiencias y mantenerse al día con las últimas tendencias tecnológicas. Puedes encontrarlo en Etiqueta LinkedIn.

melanie li, PhD, es especialista sénior en AI/ML TAM en AWS con sede en Sídney, Australia. Ayuda a los clientes empresariales a crear soluciones utilizando herramientas de IA/ML de última generación en AWS y brinda orientación sobre la arquitectura y la implementación de soluciones de ML con las mejores prácticas. En su tiempo libre, le encanta explorar la naturaleza y pasar tiempo con su familia y amigos.

melanie li, PhD, es especialista sénior en AI/ML TAM en AWS con sede en Sídney, Australia. Ayuda a los clientes empresariales a crear soluciones utilizando herramientas de IA/ML de última generación en AWS y brinda orientación sobre la arquitectura y la implementación de soluciones de ML con las mejores prácticas. En su tiempo libre, le encanta explorar la naturaleza y pasar tiempo con su familia y amigos.

marc karp es un Arquitecto de ML con el equipo de Servicio de Amazon SageMaker. Se enfoca en ayudar a los clientes a diseñar, implementar y administrar cargas de trabajo de ML a escala. En su tiempo libre le gusta viajar y explorar nuevos lugares.

marc karp es un Arquitecto de ML con el equipo de Servicio de Amazon SageMaker. Se enfoca en ayudar a los clientes a diseñar, implementar y administrar cargas de trabajo de ML a escala. En su tiempo libre le gusta viajar y explorar nuevos lugares.

alan bronceado es gerente sénior de productos en SageMaker y lidera los esfuerzos en la inferencia de modelos grandes. Le apasiona aplicar el aprendizaje automático al área de análisis. Fuera del trabajo, disfruta del aire libre.

alan bronceado es gerente sénior de productos en SageMaker y lidera los esfuerzos en la inferencia de modelos grandes. Le apasiona aplicar el aprendizaje automático al área de análisis. Fuera del trabajo, disfruta del aire libre.

Raghu Ramesha es arquitecto sénior de soluciones de aprendizaje automático en el equipo de servicios de Amazon SageMaker. Se centra en ayudar a los clientes a crear, implementar y migrar cargas de trabajo de producción de aprendizaje automático a SageMaker a escala. Se especializa en los dominios de aprendizaje automático, inteligencia artificial y visión por computadora, y tiene una maestría en Ciencias de la Computación de UT Dallas. En su tiempo libre le gusta viajar y la fotografía.

Raghu Ramesha es arquitecto sénior de soluciones de aprendizaje automático en el equipo de servicios de Amazon SageMaker. Se centra en ayudar a los clientes a crear, implementar y migrar cargas de trabajo de producción de aprendizaje automático a SageMaker a escala. Se especializa en los dominios de aprendizaje automático, inteligencia artificial y visión por computadora, y tiene una maestría en Ciencias de la Computación de UT Dallas. En su tiempo libre le gusta viajar y la fotografía.

Rupinder Grewal es un Arquitecto de Soluciones Sr. Ai/ML Especialista con AWS. Actualmente se enfoca en servir modelos y MLOps en SageMaker. Antes de este cargo, trabajó como ingeniero de aprendizaje automático creando y alojando modelos. Fuera del trabajo, le gusta jugar tenis y andar en bicicleta por senderos de montaña.

Rupinder Grewal es un Arquitecto de Soluciones Sr. Ai/ML Especialista con AWS. Actualmente se enfoca en servir modelos y MLOps en SageMaker. Antes de este cargo, trabajó como ingeniero de aprendizaje automático creando y alojando modelos. Fuera del trabajo, le gusta jugar tenis y andar en bicicleta por senderos de montaña.

Patel Dhawal es Arquitecto Principal de Aprendizaje Automático en AWS. Ha trabajado con organizaciones que van desde grandes empresas hasta empresas emergentes medianas en problemas relacionados con la computación distribuida y la inteligencia artificial. Se enfoca en el aprendizaje profundo, incluidos los dominios de NLP y Computer Vision. Ayuda a los clientes a lograr una inferencia de modelos de alto rendimiento en SageMaker.

Patel Dhawal es Arquitecto Principal de Aprendizaje Automático en AWS. Ha trabajado con organizaciones que van desde grandes empresas hasta empresas emergentes medianas en problemas relacionados con la computación distribuida y la inteligencia artificial. Se enfoca en el aprendizaje profundo, incluidos los dominios de NLP y Computer Vision. Ayuda a los clientes a lograr una inferencia de modelos de alto rendimiento en SageMaker.

Saurabh Trikande es gerente sénior de productos para Amazon SageMaker Inference. Le apasiona trabajar con clientes y está motivado por el objetivo de democratizar el aprendizaje automático. Se enfoca en los desafíos principales relacionados con la implementación de aplicaciones de ML complejas, modelos de ML de múltiples inquilinos, optimizaciones de costos y hacer que la implementación de modelos de aprendizaje profundo sea más accesible. En su tiempo libre, a Saurabh le gusta caminar, aprender sobre tecnologías innovadoras, seguir TechCrunch y pasar tiempo con su familia.

Saurabh Trikande es gerente sénior de productos para Amazon SageMaker Inference. Le apasiona trabajar con clientes y está motivado por el objetivo de democratizar el aprendizaje automático. Se enfoca en los desafíos principales relacionados con la implementación de aplicaciones de ML complejas, modelos de ML de múltiples inquilinos, optimizaciones de costos y hacer que la implementación de modelos de aprendizaje profundo sea más accesible. En su tiempo libre, a Saurabh le gusta caminar, aprender sobre tecnologías innovadoras, seguir TechCrunch y pasar tiempo con su familia.

Lakshmi Ramakrishnan es ingeniero principal en el equipo de la plataforma Amazon SageMaker Machine Learning (ML) en AWS, y proporciona liderazgo técnico para el producto. Ha trabajado en varios puestos de ingeniería en Amazon durante más de 9 años. Tiene una licenciatura en ingeniería en tecnología de la información del Instituto Nacional de Tecnología de Karnataka, India y una maestría en ciencias de la computación de la Universidad de Minnesota Twin Cities.

Lakshmi Ramakrishnan es ingeniero principal en el equipo de la plataforma Amazon SageMaker Machine Learning (ML) en AWS, y proporciona liderazgo técnico para el producto. Ha trabajado en varios puestos de ingeniería en Amazon durante más de 9 años. Tiene una licenciatura en ingeniería en tecnología de la información del Instituto Nacional de Tecnología de Karnataka, India y una maestría en ciencias de la computación de la Universidad de Minnesota Twin Cities.

david nigenda es ingeniero senior de desarrollo de software en el equipo de Amazon SageMaker y actualmente trabaja en la mejora de los flujos de trabajo de aprendizaje automático de producción, así como en el lanzamiento de nuevas funciones de inferencia. En su tiempo libre, intenta mantenerse al día con sus hijos.

david nigenda es ingeniero senior de desarrollo de software en el equipo de Amazon SageMaker y actualmente trabaja en la mejora de los flujos de trabajo de aprendizaje automático de producción, así como en el lanzamiento de nuevas funciones de inferencia. En su tiempo libre, intenta mantenerse al día con sus hijos.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- :posee

- :es

- :no

- :dónde

- $ UP

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- capacidad

- Poder

- Nuestra Empresa

- enviados

- aceleradores

- accesible

- Conforme

- Lograr

- la columna Acción

- lector activo

- actividad

- add

- la adición de

- adición

- Adicionales

- Adicionalmente

- dirección

- avanzado

- Después

- en contra

- agregar

- AI

- AI / ML

- Alan

- alarma

- Todos

- permitir

- permite

- ya haya utilizado

- también

- Aunque

- hacerlo

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- American

- cantidad

- an

- Analytics

- y

- Otra

- cualquier

- abejas

- API

- Aplicación

- aplicaciones

- Aplicá

- La aplicación de

- enfoque

- somos

- Reservada

- artificial

- inteligencia artificial

- AS

- Consejos

- asociado

- At

- Australia

- auto

- automáticamente

- disponibilidad

- Hoy Disponibles

- promedio

- evitar

- AWS

- apoyo

- basado

- BE

- porque

- antes

- comportamiento

- beneficios

- MEJOR

- y las mejores prácticas

- mejores

- entre

- build

- Construir la

- construido

- pero

- by

- , que son

- Calls

- PUEDEN

- capacidades

- capacidad

- capaz

- Capacidad

- capturas

- a ciertos

- retos

- desafiante

- el cambio

- Elige

- Cities

- código

- COM

- comparación

- completar

- ultima

- integraciones

- componente

- componentes

- exhaustivo

- Calcular

- computadora

- Ciencias de la Computación

- Visión por computador

- informática

- Configuración

- configurado

- consistente

- constantemente

- consumidor

- Envase

- Contenedores

- control

- Core

- Correspondiente

- Cost

- ahorro de costes

- Precio

- podría

- Para crear

- creado

- crea

- Creamos

- creación

- En la actualidad

- Clientes

- aduana

- Dallas

- datos

- puntos de datos

- Fecha

- disminuir

- a dedicados

- profundo

- deep learning

- más profundo

- Predeterminado

- definir

- Grado

- ahondar

- Democratizando

- demuestra

- Dependiente

- desplegar

- desplegado

- Desplegando

- despliegue

- Despliegues

- descrito

- Diseño

- deseado

- detalle

- detalles

- Determinar

- Desarrollo

- una experiencia diferente

- difícil

- distribuidos

- Computación distribuída

- do

- dominios

- No

- DE INSCRIPCIÓN

- durante

- dinamicamente

- cada una

- pasan fácilmente

- efecto

- eficiencia

- eficiente.

- esfuerzos

- habilitar

- facilita

- permite

- fomentar

- Punto final

- ingeniero

- Ingeniería

- garantizar

- Empresa

- empresas

- entidad

- igual

- Europea

- ejemplo

- esperar

- experience

- Experiencias

- explorar

- Explorar

- ampliar

- familia

- Feature

- Caracteristicas

- campo

- Encuentre

- Nombre

- Flexibilidad

- se centra

- siguiendo

- Fundación

- Digital XNUMXk

- Gratis

- amigos

- Desde

- completamente

- Además

- futuras

- obtener

- gif

- GitHub

- Donar

- dado

- da

- objetivo

- GPU

- GPU

- granular

- guía

- A Mitad

- encargarse de

- Manos

- Materiales

- Tienen

- he

- ayuda

- ayudando

- ayuda

- aquí

- Alta

- de alto nivel

- su

- Golpear

- mantiene

- fortaleza

- organizado

- hosting

- HORAS

- Cómo

- Como Hacer

- Sin embargo

- http

- HTTPS

- Cientos

- idea

- Idle

- if

- ilustrar

- imagen

- implementar

- implementación

- importante

- la mejora de

- in

- En otra

- Incluye

- aumente

- independientemente

- India

- ineficiente

- información

- tecnología de la información

- EN LA MINA

- inicial

- originales

- tecnologías innovadoras

- ejemplo

- Innovadora

- Intelligence

- interactivo

- intereses

- dentro

- Introducido

- Introducción

- IT

- SUS

- sí mismo

- jpg

- Guardar

- acuerdo

- Clave

- Niños

- large

- Grandes empresas

- Finalmente

- Estado latente

- luego

- más reciente

- lanzamiento

- Liderazgo

- líder

- aprendizaje

- menos

- Nivel

- como

- Etiqueta LinkedIn

- Lista

- Llama

- carga

- local

- situados

- por más tiempo

- Mira

- mirando

- ama

- máquina

- máquina de aprendizaje

- para lograr

- Realizar

- gestionan

- gestionado

- Management

- gerente

- administrar

- muchos

- dominar

- Máster

- Maximizar

- máximas

- Puede..

- significa

- Conoce a

- Salud Cerebral

- métrico

- Métrica

- migrado

- mínimo

- minuto

- Min

- ML

- MLOps

- modelo

- modelos

- más,

- motivado

- Montaña

- mucho más

- múltiples

- Nacional

- Naturaleza

- ¿ Necesita ayuda

- Nuevo

- nlp

- no

- nota

- cuaderno

- ahora

- número

- objeto

- of

- LANZAMIENTO

- a menudo

- on

- ONE

- , solamente

- sobre

- Optimización

- optimizando

- Optión

- or

- orquestación

- para las fiestas.

- Otro

- "nuestr

- salir

- al exterior

- salidas

- afuera

- excepcional

- Más de

- total

- EL DESARROLLADOR

- .

- Paralelo

- parámetro

- parámetros

- particular

- apasionado

- Patrón de Costura

- .

- para

- actuación

- período

- Doctor en Filosofía

- fotografía

- Colocar

- colocación

- Lugares

- plan

- plataforma

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- jugando

- puntos

- políticas

- política

- posible

- Publicación

- industria

- prácticas

- predecir

- Previsible

- conservación

- Director de la escuela

- Anterior

- problemas

- Producto

- gerente de producto

- Producción

- propiedades

- proporcionar

- previsto

- proporciona un

- proporcionando

- publicar

- la cantidad

- azar

- distancia

- que van

- Reaccionar

- Reacciona

- ready

- reequilibrar

- recomiendan

- reducir

- la reducción de

- remitir

- registrarte

- relacionado

- remove

- la eliminación de

- reemplazados

- solicita

- solicitudes

- exigir

- Requisitos

- Requisitos

- requiere

- reservados

- Recurso

- Recursos

- respectivamente

- respuesta

- Función

- También soy miembro del cuerpo docente de World Extreme Medicine (WEM) y embajadora europea de igualdad para The Transformational Travel Council (TTC). En mi tiempo libre, soy una incansable aventurera, escaladora, patrona de día, buceadora y defensora de la igualdad de género en el deporte y la aventura. En XNUMX, fundé Almas Libres, una ONG nacida para involucrar, educar y empoderar a mujeres y niñas a través del deporte urbano, la cultura y la tecnología.

- rutas

- enrutamiento

- Ejecutar

- correr

- tiempo de ejecución

- sabio

- Inferencia de SageMaker

- mismo

- Guardar

- Ahorros

- dices

- Escala

- escamas

- la ampliación

- Ciencia:

- segundos

- ver

- la búsqueda de

- mayor

- expedido

- sentencia

- ayudar

- de coches

- Servicios

- servicio

- set

- pólipo

- Varios

- Compartir

- ella

- tienes

- Mostrar

- mostró

- mostrado

- significativamente

- sencillos

- simplificado

- soltero

- sentarse

- Tamaño

- menores

- retazo

- So

- Software

- Desarrollo de software ad-hoc

- Soluciones

- algo

- especialista

- se especializa

- soluciones y

- especificación

- pasar

- Gastos

- espiga

- picos

- comienzo

- Startups

- el estado de la técnica

- Estado

- quedarse

- Sin embargo

- Estrategia

- exitosos

- tal

- abastecimiento

- SOPORTE

- soportes

- seguro

- Sydney

- mesa

- ¡Prepárate!

- toma

- Target

- equipo

- TechCrunch

- Técnico

- Tecnologías

- Tecnología

- tenis

- terminología

- que

- esa

- La

- El Área

- El futuro de las

- su

- Les

- luego

- Ahí.

- Estas

- ellos

- así

- aquellos

- Tres

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- equipo

- a

- seguir

- tradicional

- tráfico

- Viajar

- Tendencias

- detonante

- gemelo

- dos

- entender

- universidad

- imprevisible

- Actualizar

- actualizado

- Uso

- utilizan el

- usado

- Usuario

- experiencia como usuario

- usuarios

- usos

- usando

- generalmente

- UTC

- utilizar

- vicio

- Ver

- visión

- visitantes

- caminar

- tutorial

- quieres

- Residuos

- Camino..

- formas

- we

- web

- servicios web

- WELL

- cuando

- mientras

- que

- mientras

- seguirá

- sin

- palabras

- Actividades:

- trabajado

- flujos de trabajo

- trabajando

- funciona

- años

- Usted

- tú

- a ti mismo

- zephyrnet

- cero