Los datos están transformando todos los campos y todos los negocios. Sin embargo, dado que los datos crecen más rápido de lo que la mayoría de las empresas pueden rastrear, recopilar datos y obtener valor de esos datos es algo desafiante. A estrategia de datos moderna puede ayudarlo a crear mejores resultados comerciales con datos. AWS proporciona el conjunto de servicios más completo para el viaje de datos de extremo a extremo para ayudarte desbloquee el valor de sus datos y convertirlo en conocimiento.

Los científicos de datos pueden dedicar hasta el 80 % de su tiempo a preparar datos para proyectos de aprendizaje automático (ML). Este proceso de preparación es en gran parte un trabajo indiferenciado y tedioso, y puede involucrar varias API de programación y bibliotecas personalizadas. Wrangler de datos de Amazon SageMaker ayuda a los científicos e ingenieros de datos a simplificar y acelerar la preparación de datos tabulares y de series temporales y la ingeniería de características a través de una interfaz visual. Puede importar datos de varias fuentes de datos, como Servicio de almacenamiento simple de Amazon (Amazon S3), Atenea amazónica, Desplazamiento al rojo de Amazon, o incluso soluciones de terceros como Copo de nieve or ladrillos de datosy procese sus datos con más de 300 transformaciones de datos integradas y una biblioteca de fragmentos de código, para que pueda normalizar, transformar y combinar funciones rápidamente sin escribir ningún código. También puede traer sus transformaciones personalizadas en PySpark, SQL o Pandas.

Esta publicación demuestra cómo puede programar sus trabajos de preparación de datos para que se ejecuten automáticamente. También exploramos la nueva capacidad de Data Wrangler de conjuntos de datos parametrizados, que le permite especificar los archivos que se incluirán en un flujo de datos por medio de URI parametrizados.

Resumen de la solución

Data Wrangler ahora admite la importación de datos mediante un URI parametrizado. Esto permite una mayor flexibilidad porque ahora puede importar todos los conjuntos de datos que coincidan con los parámetros especificados, que pueden ser del tipo Cadena, Número, Fecha y hora y Patrón, en el URI. Además, ahora puede activar sus trabajos de transformación de Data Wrangler en un horario.

En esta publicación, creamos un flujo de muestra con el conjunto de datos Titanic para mostrar cómo puede comenzar a experimentar con estas dos nuevas funciones de Data Wrangler. Para descargar el conjunto de datos, consulte Titanic: aprendizaje automático a partir de un desastre.

Requisitos previos

Para obtener todas las funciones descritas en esta publicación, debe ejecutar la última versión del kernel de Data Wrangler. Para obtener más información, consulte Actualizar administrador de datos. Además, debe estar corriendo Estudio Amazon SageMaker JupyterLab 3. Para ver la versión actual y actualizarla, consulte Control de versiones de JupyterLab.

Estructura de archivo

Para esta demostración, seguimos una estructura de archivo simple que debe replicar para reproducir los pasos descritos en esta publicación.

- En el estudio, crear un nuevo cuaderno.

- Ejecute el siguiente fragmento de código para crear la estructura de carpetas que usamos (asegúrese de estar en la carpeta deseada en su árbol de archivos):

- Copia el

train.csvytest.csvarchivos del conjunto de datos Titanic original a las carpetastitanic_dataset/trainytitanic_dataset/test, respectivamente. - Ejecute el siguiente fragmento de código para llenar las carpetas con los archivos necesarios:

Dividimos el train.csv archivo del conjunto de datos del Titanic en nueve archivos diferentes, denominados part_x, donde x es el número de la pieza. La parte 0 tiene los primeros 100 registros, la parte 1 los siguientes 100 y así sucesivamente hasta la parte 8. Cada carpeta de nodo del árbol de archivos contiene una copia de las nueve partes de los datos de entrenamiento, excepto el train y test carpetas que contienen train.csv y test.csv.

Conjuntos de datos parametrizados

Los usuarios de Data Wrangler ahora pueden especificar parámetros para los conjuntos de datos importados de Amazon S3. Los parámetros del conjunto de datos se especifican en la URI de los recursos y su valor se puede cambiar dinámicamente, lo que permite una mayor flexibilidad para seleccionar los archivos que queremos importar. Los parámetros pueden ser de cuatro tipos de datos:

- Número – Puede tomar el valor de cualquier número entero

- Cordón – Puede tomar el valor de cualquier cadena de texto

- Patrón de Costura – Puede tomar el valor de cualquier expresión regular

- Fecha y hora – Puede tomar el valor de cualquiera de los formatos de fecha/hora admitidos

En esta sección, proporcionamos un tutorial de esta nueva característica. Esto está disponible solo después de importar su conjunto de datos a su flujo actual y solo para conjuntos de datos importados de Amazon S3.

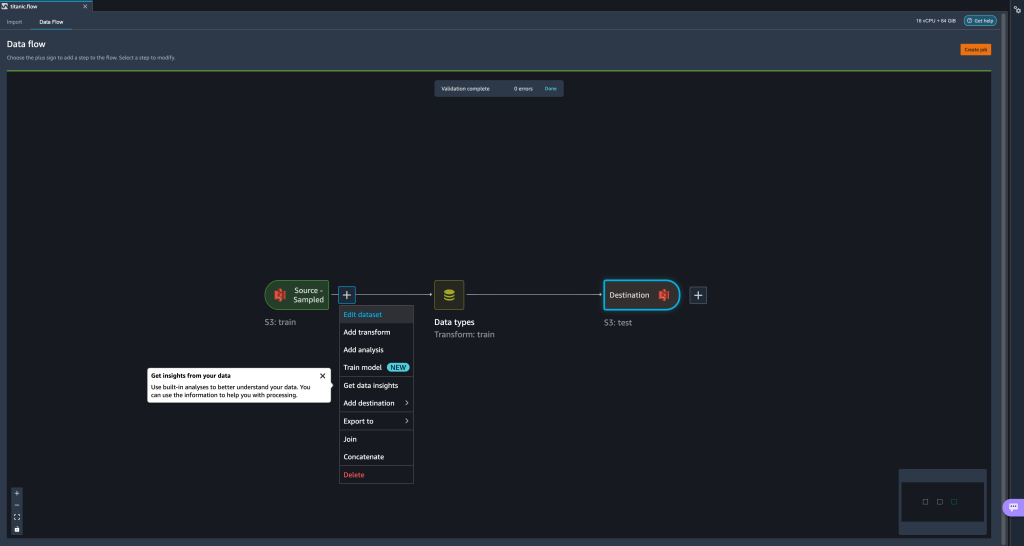

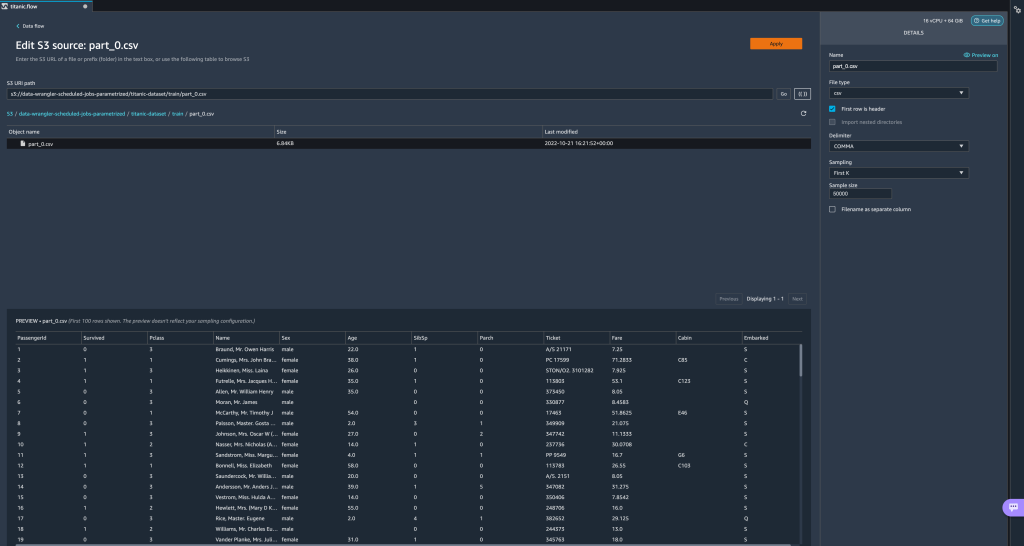

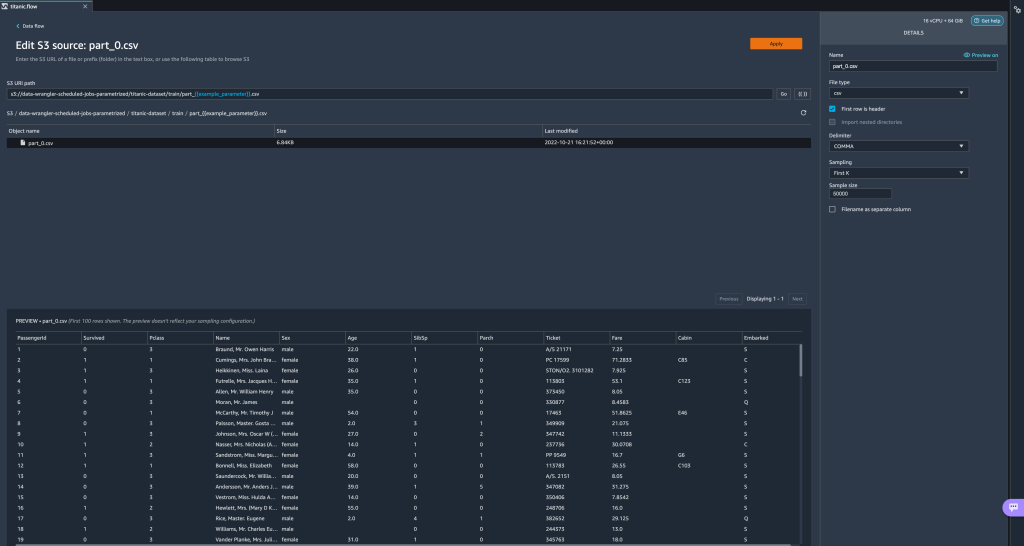

- Desde su flujo de datos, elija el signo más (+) al lado del paso de importación y elija Editar conjunto de datos.

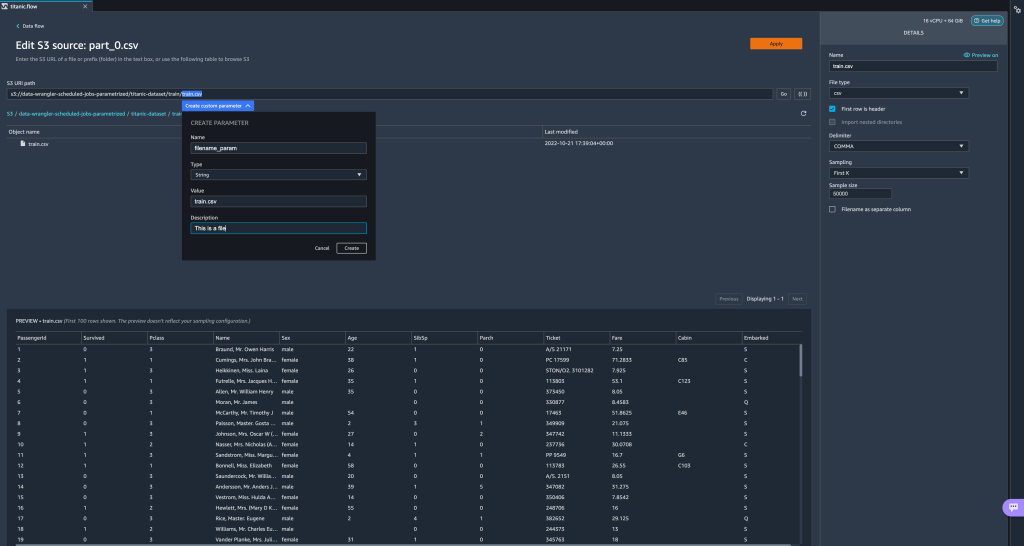

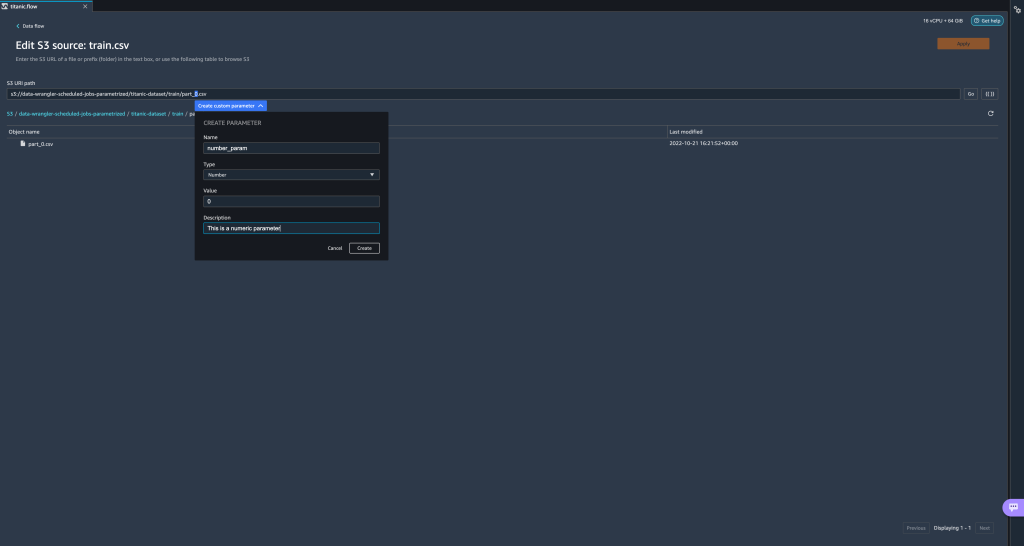

- El método preferido (y más fácil) para crear nuevos parámetros es resaltar una sección de su URI y elegir Crear parámetro personalizado en el menú desplegable. Debe especificar cuatro cosas para cada parámetro que desee crear:

- Nombre

- Tipo de Propiedad

- Valor por defecto

- Descripción

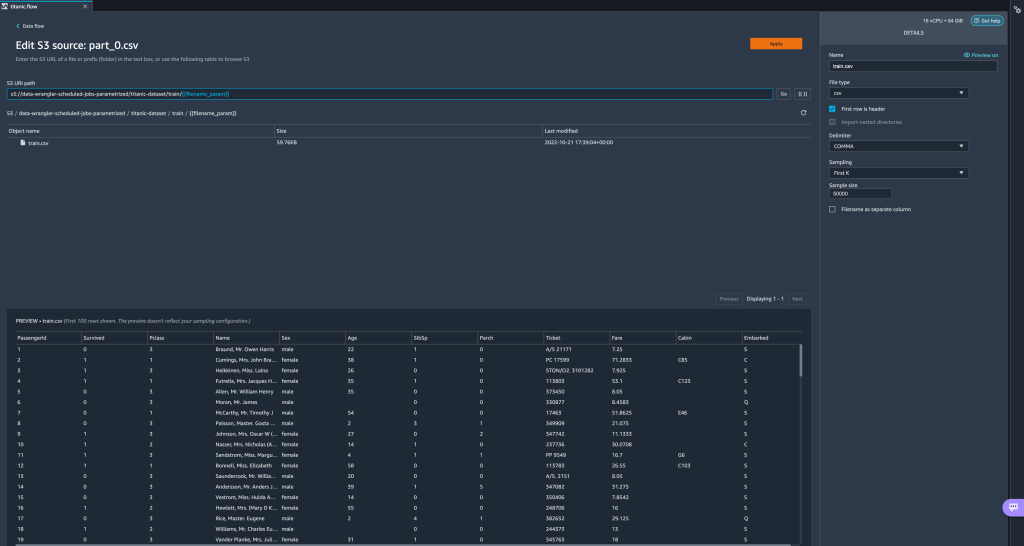

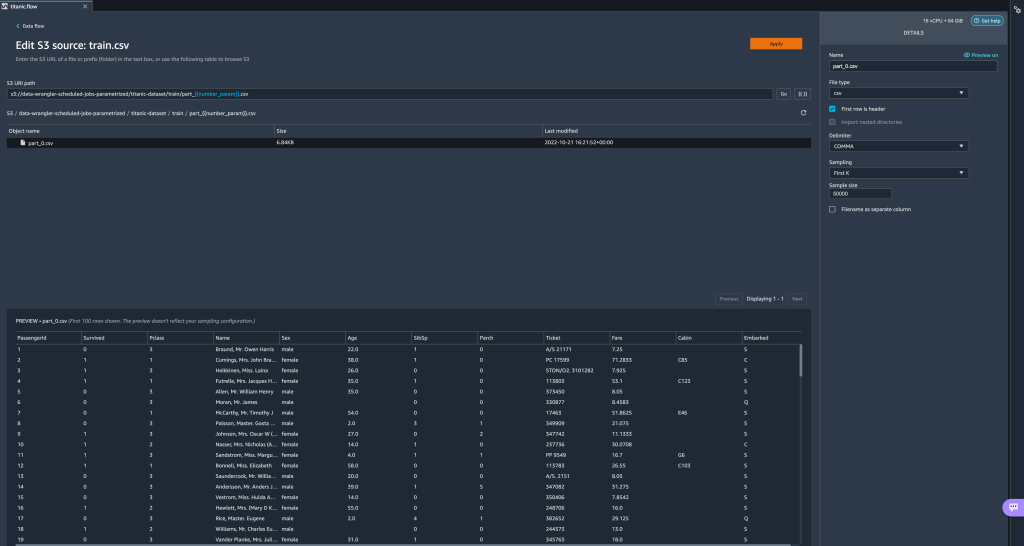

Aquí hemos creado un parámetro de tipo String llamadofilename_paramcon un valor predeterminado detrain.csv. Ahora puede ver el nombre del parámetro encerrado entre corchetes dobles, reemplazando la parte del URI que resaltamos anteriormente. Debido a que el valor definido para este parámetro fuetrain.csv, ahora vemos el archivotrain.csvenumerados en la tabla de importación.

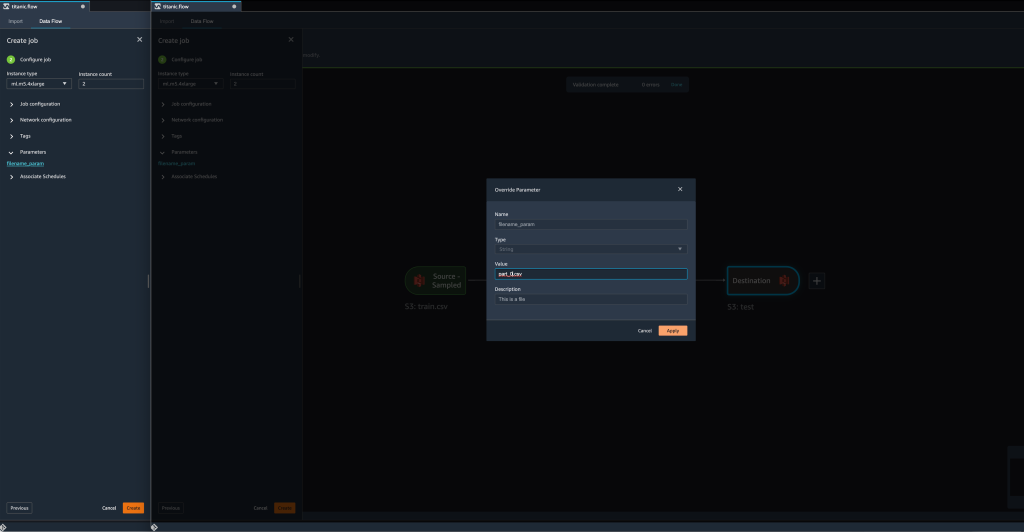

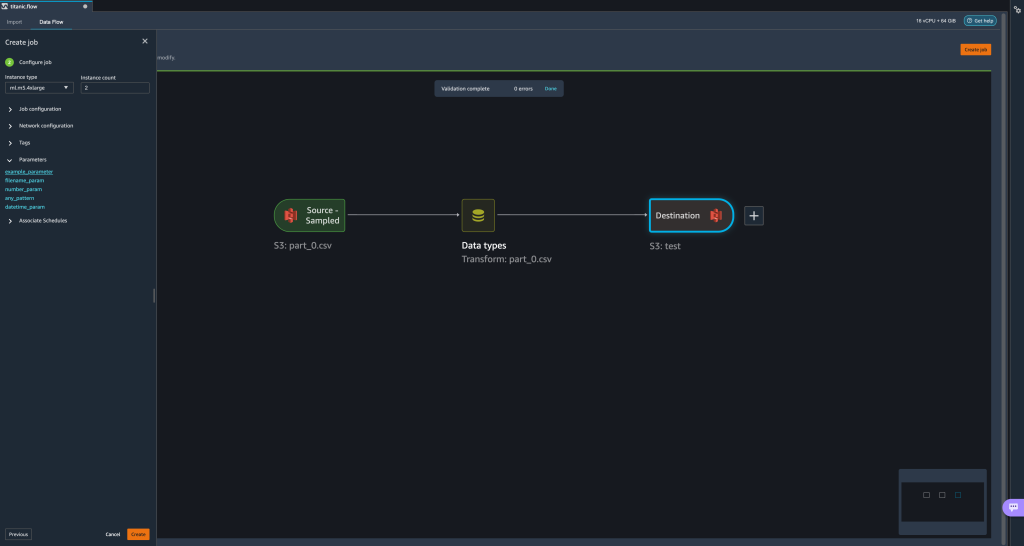

- Cuando tratamos de crear un trabajo de transformación, en el Configurar trabajo paso, ahora vemos un parámetros sección, donde podemos ver una lista de todos nuestros parámetros definidos.

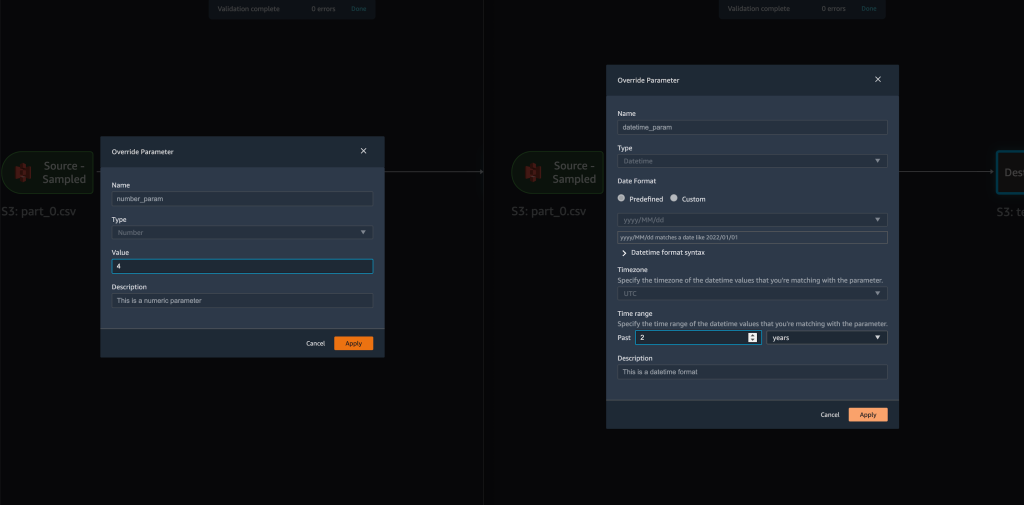

- Elegir el parámetro nos da la opción de cambiar el valor del parámetro, en este caso, cambiar el conjunto de datos de entrada para que se transforme de acuerdo con el flujo definido.

Suponiendo que cambiamos el valor defilename_paramentrain.csvapart_0.csv, el trabajo de transformación ahora tomapart_0.csv(siempre que un archivo con el nombrepart_0.csvexiste en la misma carpeta) como sus nuevos datos de entrada.

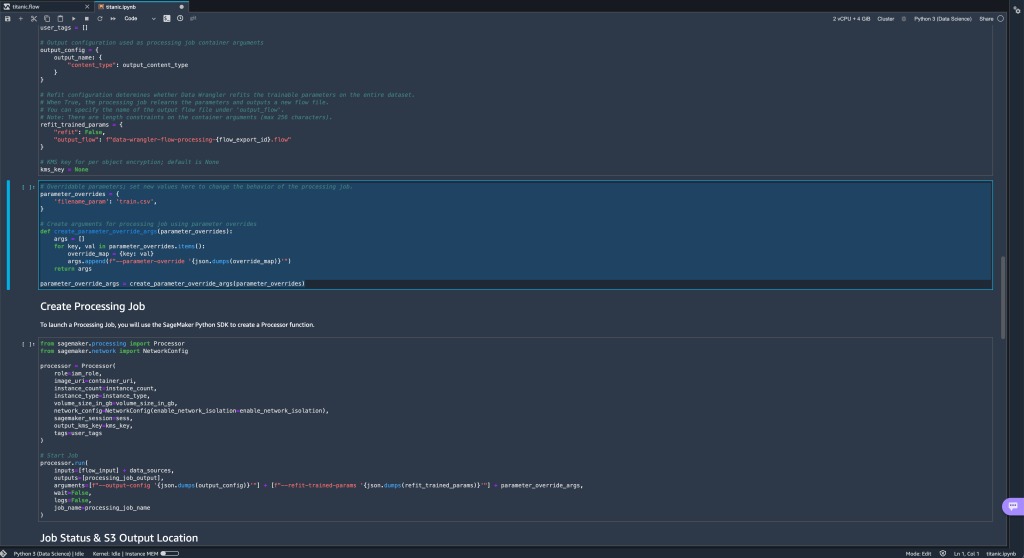

- Además, si intenta exportar su flujo a un destino de Amazon S3 (a través de un cuaderno Jupyter), ahora verá una nueva celda que contiene los parámetros que definió.

Tenga en cuenta que el parámetro toma su valor predeterminado, pero puede cambiarlo reemplazando su valor en elparameter_overridesdiccionario (sin modificar las claves del diccionario).

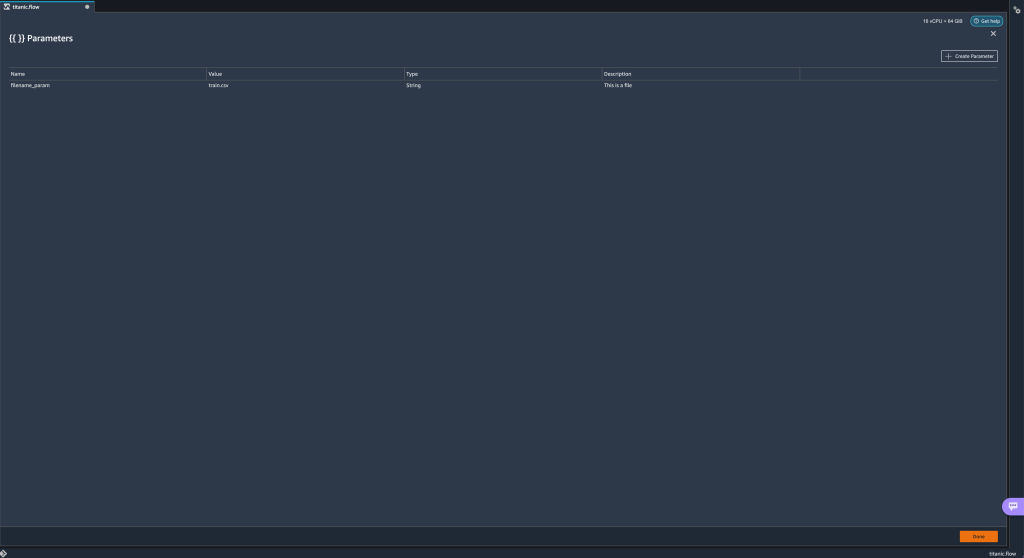

Además, puede crear nuevos parámetros desde el parámetros UI. - Ábralo eligiendo el icono de parámetros ({{}}) situado junto a la Go opción; ambos se encuentran junto al valor de la ruta URI.

Se abre una tabla con todos los parámetros que existen actualmente en su archivo de flujo (

Se abre una tabla con todos los parámetros que existen actualmente en su archivo de flujo (filename_paramen este punto). - Puede crear nuevos parámetros para su flujo eligiendo Crear parámetro.

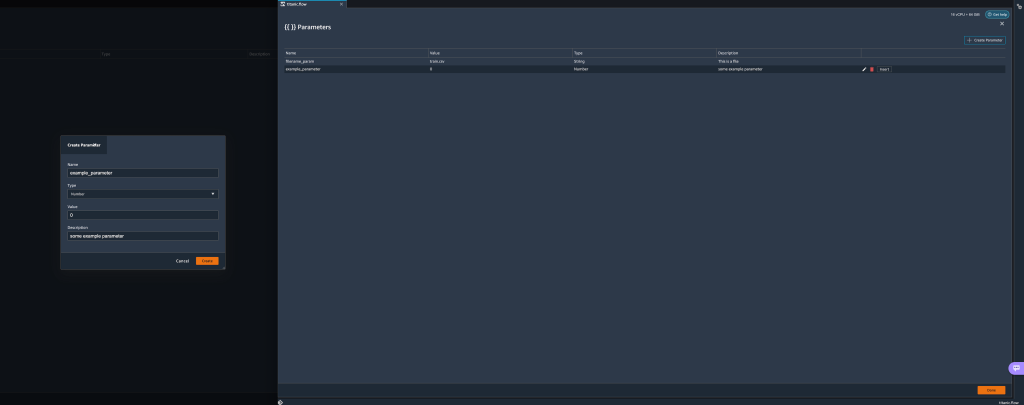

Se abre una ventana emergente que le permite crear un nuevo parámetro personalizado. - Aquí, hemos creado un nuevo

example_parametercomo tipo Número con un valor predeterminado de 0. Este parámetro recién creado ahora aparece en la parámetros mesa. Al pasar el cursor sobre el parámetro, se muestran las opciones. Editar, Borrary recuadro.

- Desde dentro del parámetros UI, puede insertar uno de sus parámetros en el URI seleccionando el parámetro deseado y eligiendo recuadro.

Esto agrega el parámetro al final de su URI. Debe moverlo a la sección deseada dentro de su URI.

- Cambie el valor predeterminado del parámetro, aplique el cambio (desde el modal), elija Goy elija el icono de actualización para actualizar la lista de vista previa utilizando el conjunto de datos seleccionado en función del valor del parámetro recién definido.

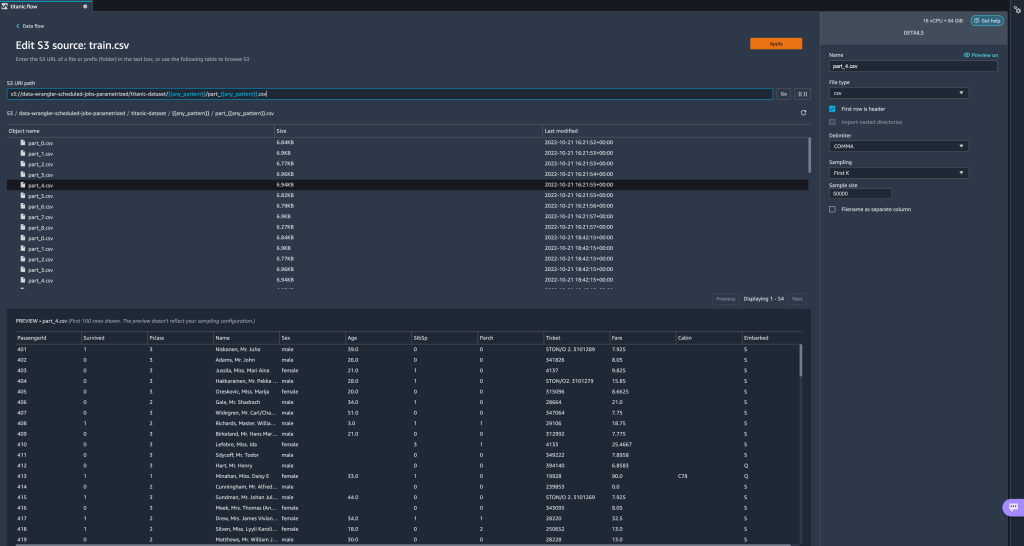

Exploremos ahora otros tipos de parámetros. Supongamos que ahora tenemos un conjunto de datos dividido en varias partes, donde cada archivo tiene un número de parte.

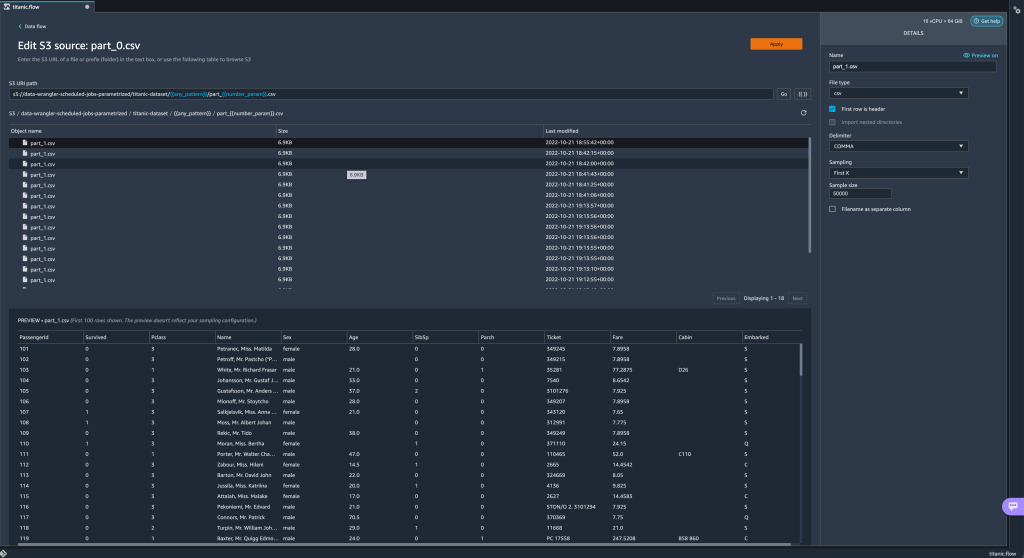

Exploremos ahora otros tipos de parámetros. Supongamos que ahora tenemos un conjunto de datos dividido en varias partes, donde cada archivo tiene un número de parte. - Si queremos cambiar dinámicamente el número de archivo, podemos definir un parámetro Número como se muestra en la siguiente captura de pantalla.

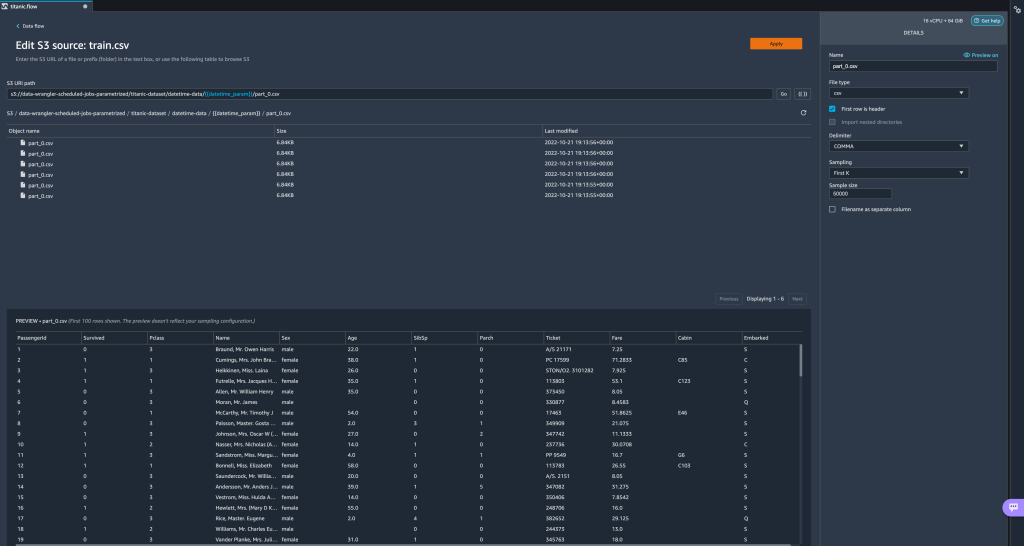

Tenga en cuenta que el archivo seleccionado es el que coincide con el número especificado en el parámetro.

Tenga en cuenta que el archivo seleccionado es el que coincide con el número especificado en el parámetro. Ahora vamos a demostrar cómo usar un parámetro de patrón. Supongamos que queremos importar todos los

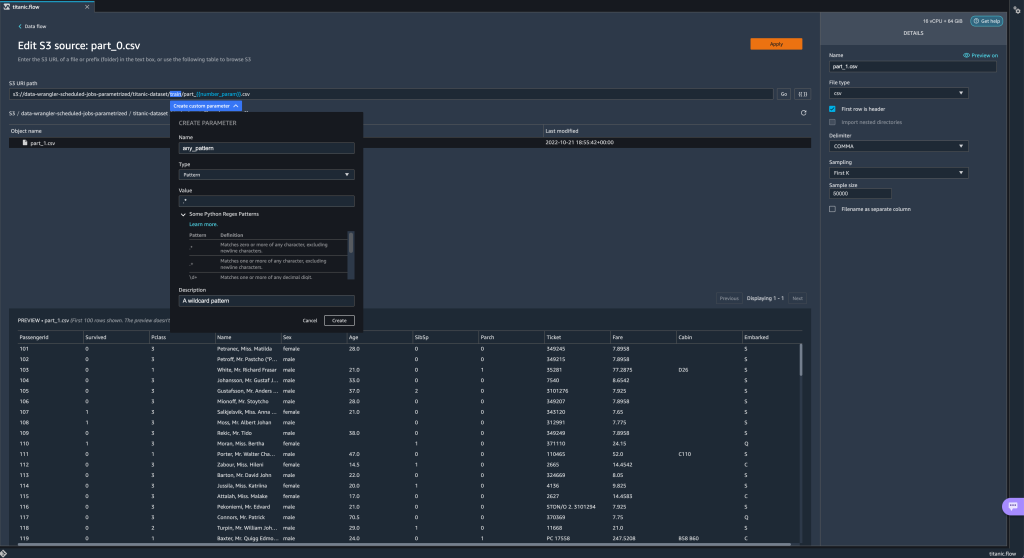

Ahora vamos a demostrar cómo usar un parámetro de patrón. Supongamos que queremos importar todos los part_1.csvarchivos en todas las carpetas bajo eltitanic-dataset/carpeta. Los parámetros de patrón pueden tomar cualquier expresión regular válida; hay algunos patrones de expresiones regulares que se muestran como ejemplos. - Cree un parámetro de Patrón llamado

any_patternpara que coincida con cualquier carpeta o archivo bajo eltitanic-dataset/carpeta con valor por defecto.*.Observe que el comodín no es un solo * (asterisco) sino que también tiene un punto. - Resaltar el

titanic-dataset/parte de la ruta y crea un parámetro personalizado. Esta vez elegimos el Patrón de Costura tipo. Este patrón selecciona todos los archivos llamados

Este patrón selecciona todos los archivos llamados part-1.csvdesde cualquiera de las carpetas bajotitanic-dataset/. Un parámetro se puede utilizar más de una vez en una ruta. En el siguiente ejemplo, usamos nuestro parámetro recién creado

Un parámetro se puede utilizar más de una vez en una ruta. En el siguiente ejemplo, usamos nuestro parámetro recién creado any_patterndos veces en nuestro URI para que coincida con cualquiera de los archivos de pieza en cualquiera de las carpetas entitanic-dataset/. Finalmente, creemos un parámetro Datetime. Los parámetros de fecha y hora son útiles cuando se trata de rutas que están divididas por fecha y hora, como las generadas por Manguera de bomberos de datos de Amazon Kinesis (consulta: Particionamiento dinámico en Kinesis Data Firehose). Para esta demostración, usamos los datos de la carpeta datetime-data.

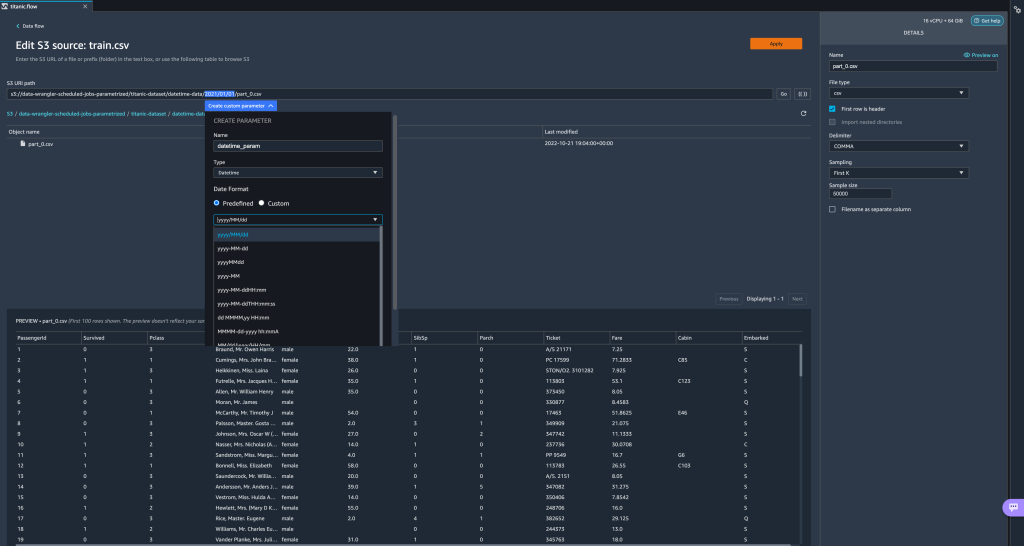

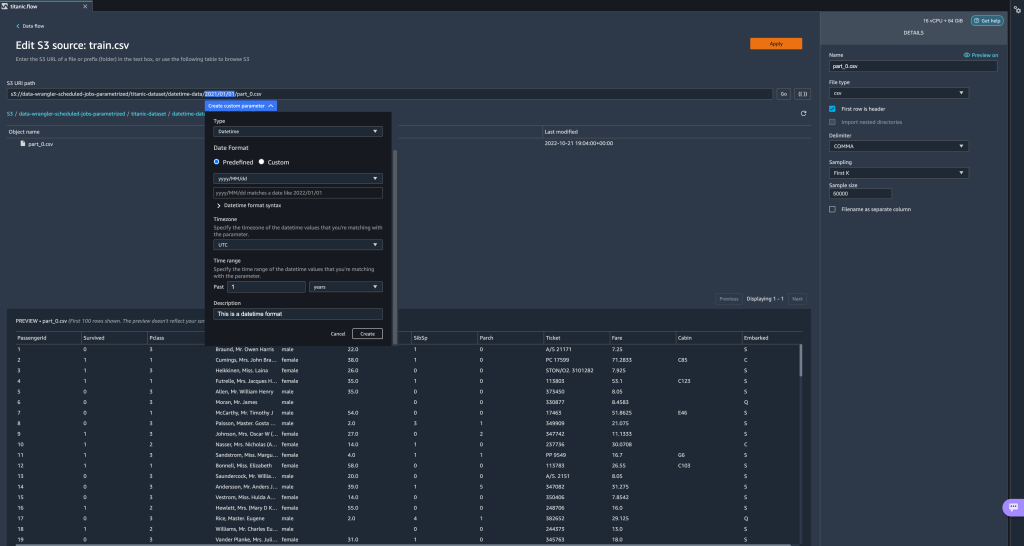

Finalmente, creemos un parámetro Datetime. Los parámetros de fecha y hora son útiles cuando se trata de rutas que están divididas por fecha y hora, como las generadas por Manguera de bomberos de datos de Amazon Kinesis (consulta: Particionamiento dinámico en Kinesis Data Firehose). Para esta demostración, usamos los datos de la carpeta datetime-data. - Seleccione la parte de su ruta que es una fecha/hora y cree un parámetro personalizado. Elegir la Fecha y hora tipo de parámetro.

Al elegir el tipo de datos Fecha y hora, debe completar más detalles. - En primer lugar, debe proporcionar un formato de fecha. Puede elegir cualquiera de los formatos de fecha/hora predefinidos o crear uno personalizado.

Para los formatos de fecha/hora predefinidos, la leyenda proporciona un ejemplo de una fecha que coincide con el formato seleccionado. Para esta demostración, elegimos el formato aaaa / MM / dd.

- A continuación, especifique una zona horaria para los valores de fecha/hora.

Por ejemplo, la fecha actual puede ser el 1 de enero de 2022 en una zona horaria, pero puede ser el 2 de enero de 2022 en otra zona horaria. - Finalmente, puede seleccionar el rango de tiempo, que le permite seleccionar el rango de archivos que desea incluir en su flujo de datos.

Puede especificar su intervalo de tiempo en horas, días, semanas, meses o años. Para este ejemplo, queremos obtener todos los archivos del último año. - Proporcione una descripción del parámetro y elija Crear.

Si usa varios conjuntos de datos con diferentes zonas horarias, la hora no se convierte automáticamente; necesita preprocesar cada archivo o fuente para convertirlo a una zona horaria. Los archivos seleccionados son todos los archivos en las carpetas correspondientes a los datos del año pasado.

Los archivos seleccionados son todos los archivos en las carpetas correspondientes a los datos del año pasado.

- Ahora, si creamos un trabajo de transformación de datos, podemos ver una lista de todos nuestros parámetros definidos y podemos anular sus valores predeterminados para que nuestros trabajos de transformación seleccionen los archivos especificados.

Programar trabajos de procesamiento

Ahora puede programar trabajos de procesamiento para automatizar la ejecución de trabajos de transformación de datos y exportar sus datos transformados a Amazon S3 o Tienda de funciones de Amazon SageMaker. Puedes programar los trabajos con el tiempo y periodicidad que se adapte a tus necesidades.

Uso de trabajos de procesamiento programado Puente de eventos de Amazon reglas para programar la ejecución del trabajo. Por lo tanto, como requisito previo, debe asegurarse de que el Gestión de identidades y accesos de AWS (IAM) que utiliza Data Wrangler, es decir, el Amazon SageMaker rol de ejecución de la instancia de Studio, tiene permisos para crear reglas de EventBridge.

Configurar gestión de identidades y accesos

Continúe con las siguientes actualizaciones en el rol de ejecución de IAM SageMaker correspondiente a la instancia de Studio donde se ejecuta el flujo de Data Wrangler:

- Adjunta AmazonEventBridgeAcceso completo política administrada.

- Adjunte una política para otorgar permiso para crear un trabajo de procesamiento:

- Otorgue permiso a EventBridge para asumir el rol agregando la siguiente política de confianza:

Como alternativa, si está utilizando una función diferente para ejecutar el trabajo de procesamiento, aplique las políticas descritas en los pasos 2 y 3 a esa función. Para obtener detalles sobre la configuración de IAM, consulte Crear un programa para procesar automáticamente nuevos datos.

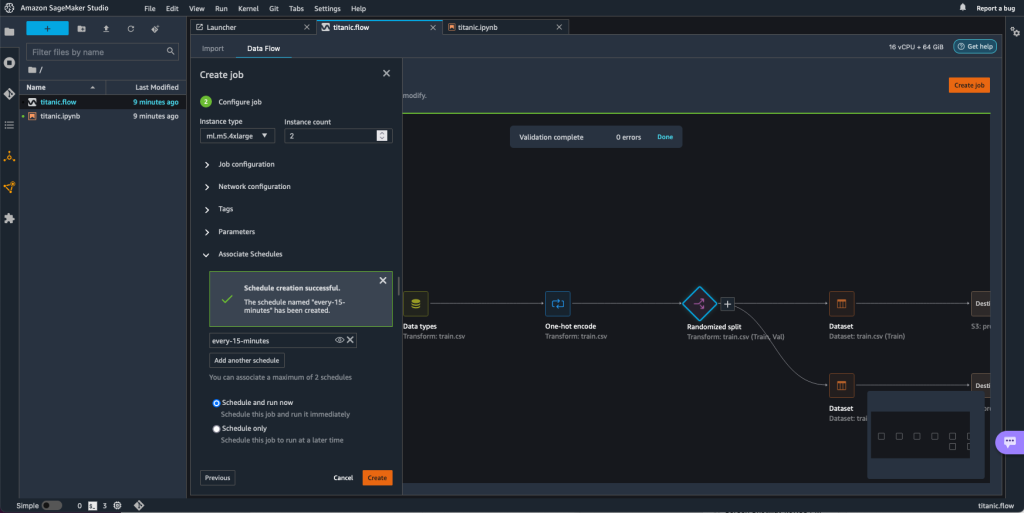

Crea un horario

Para crear una programación, abra su flujo en el editor de flujo de Data Wrangler.

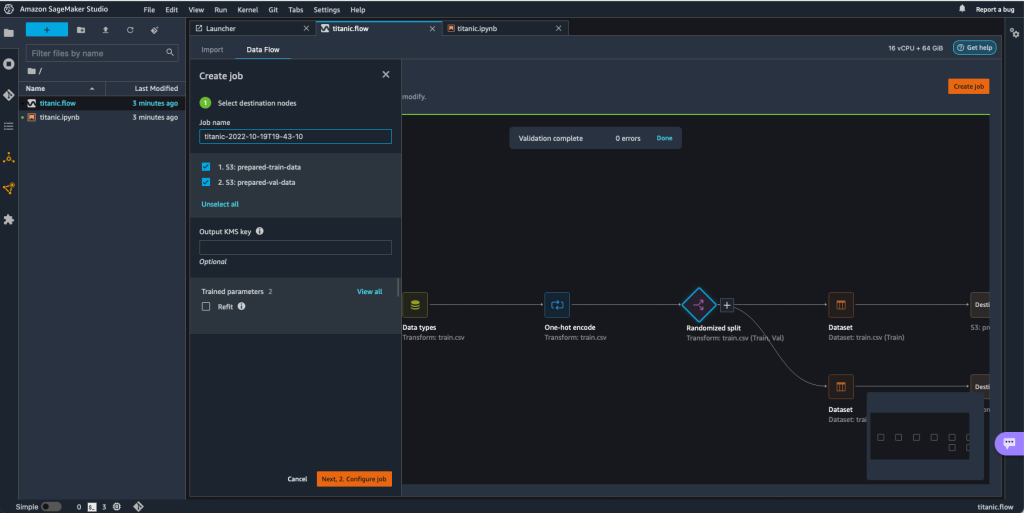

- En Flujo de datos pestaña, elegir Crear trabajo.

- Configura los campos obligatorios y elige A continuación, 2. Configurar trabajo.

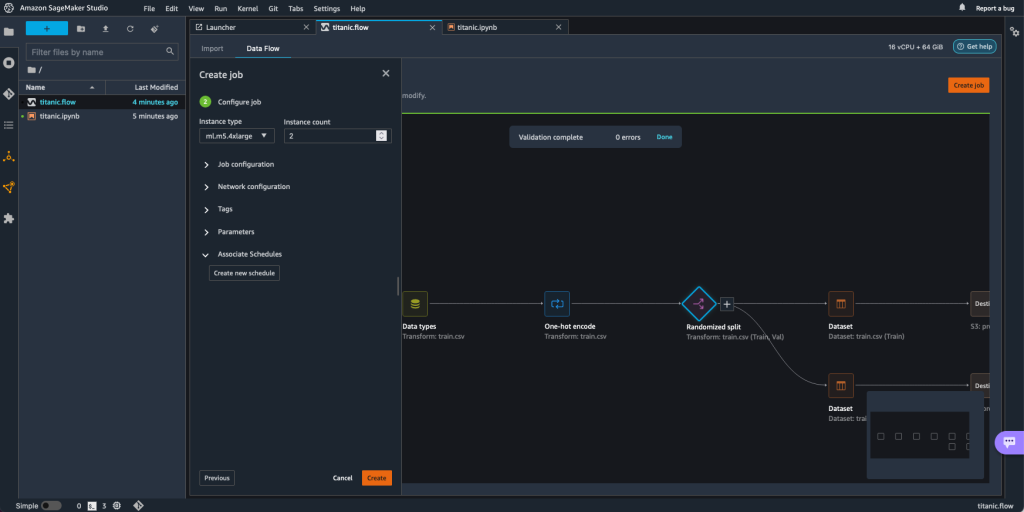

- Expandir Horarios asociados.

- Elige Crear nuevo horario.

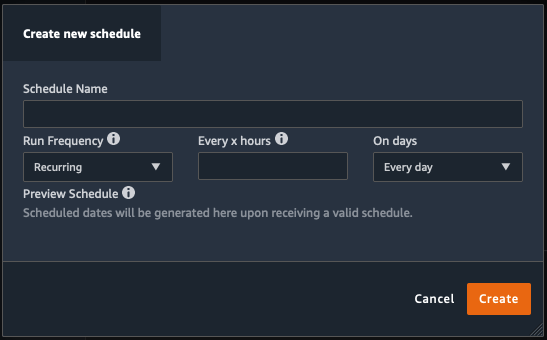

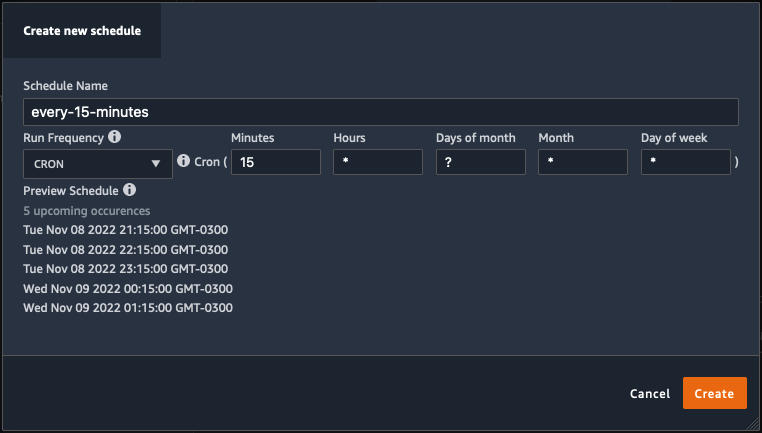

El Crear nuevo horario Se abre el cuadro de diálogo, donde define los detalles de la programación del trabajo de procesamiento.

El cuadro de diálogo ofrece una gran flexibilidad para ayudarlo a definir la programación. Puede tener, por ejemplo, el trabajo de procesamiento ejecutándose a una hora específica o cada X horas, en días específicos de la semana.

La periodicidad puede ser granular al nivel de minutos.

- Defina el nombre del horario y la periodicidad, luego elija Crear para guardar el horario.

- Tiene la opción de iniciar el trabajo de procesamiento de inmediato junto con la programación, que se ocupa de las ejecuciones futuras, o dejar que el trabajo se ejecute solo de acuerdo con la programación.

- También puede definir una programación adicional para el mismo trabajo de procesamiento.

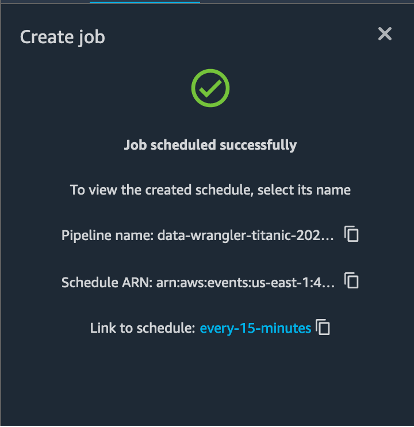

- Para finalizar la programación del trabajo de procesamiento, seleccione Crear.

Verá un mensaje de "Trabajo programado con éxito". Además, si elige dejar que el trabajo se ejecute solo de acuerdo con la programación, verá un enlace a la regla de EventBridge que acaba de crear.

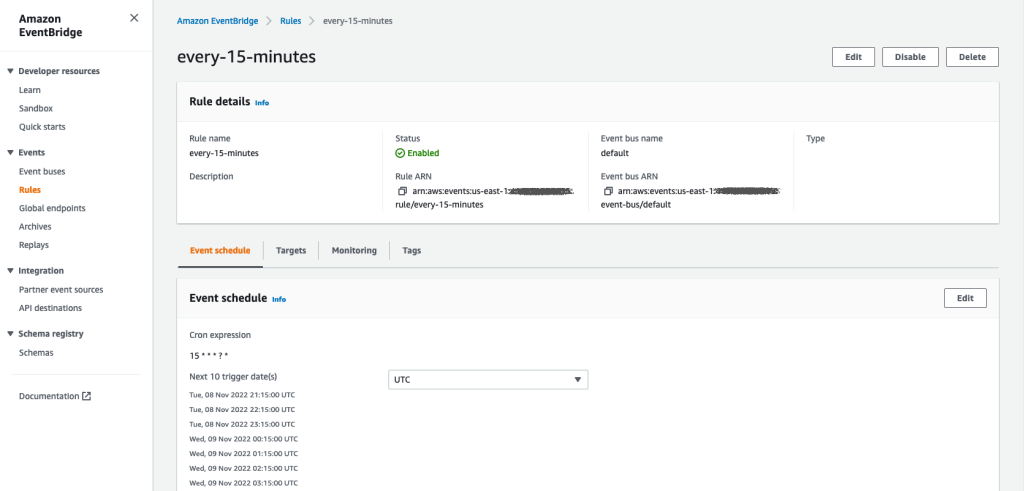

Si elige el enlace de programación, se abre una nueva pestaña en el navegador que muestra la regla de EventBridge. En esta página, puede realizar más modificaciones a la regla y realizar un seguimiento de su historial de invocaciones. Para detener la ejecución de su trabajo de procesamiento programado, elimine la regla de evento que contiene el nombre del programa.

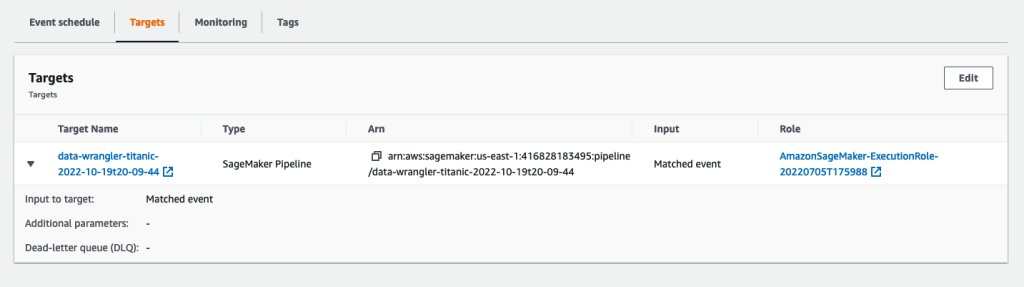

La regla de EventBridge muestra una canalización de SageMaker como su destino, que se activa de acuerdo con la programación definida y el trabajo de procesamiento se invoca como parte de la canalización.

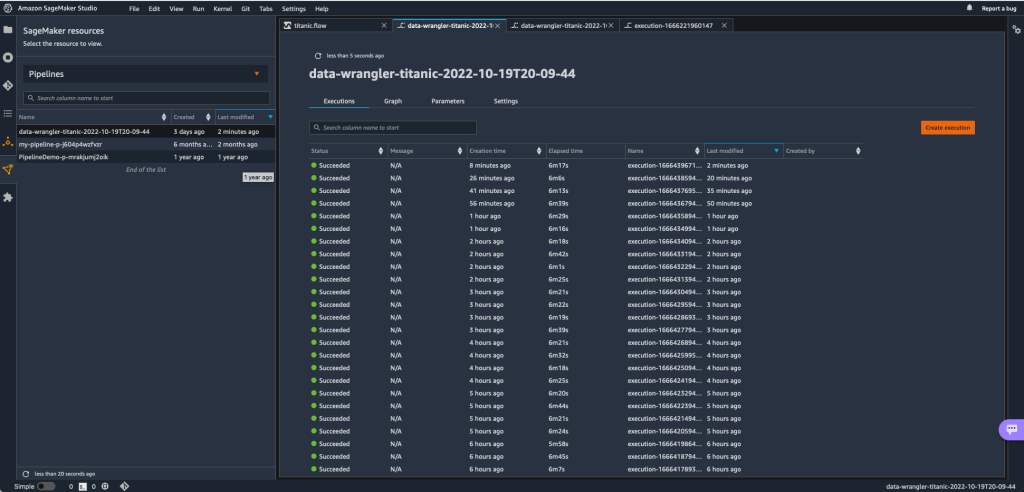

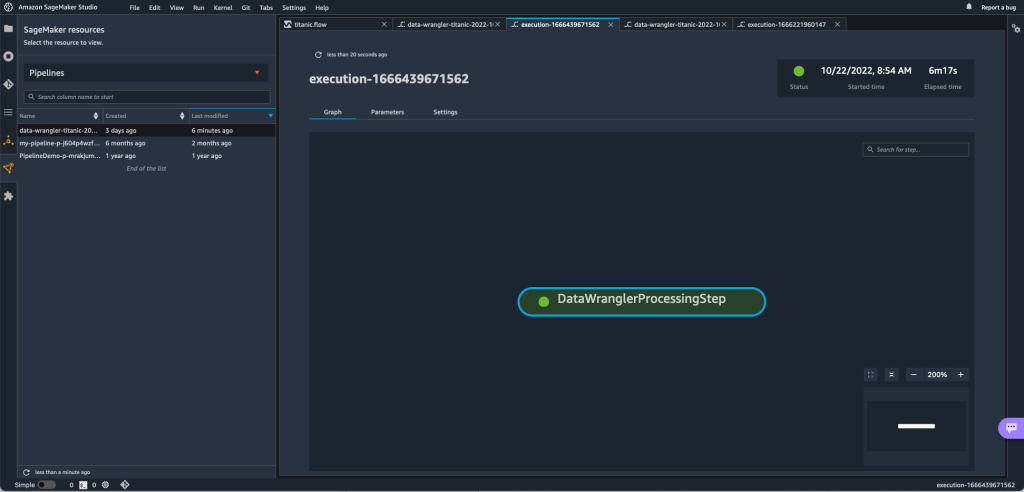

Para realizar un seguimiento de las ejecuciones de la canalización de SageMaker, puede volver a Studio, elegir el Recursos de SageMaker icono, elegir Pipelinesy elija el nombre de canalización del que desea realizar un seguimiento. Ahora puede ver una tabla con todas las ejecuciones actuales y pasadas y el estado de esa canalización.

Puede ver más detalles haciendo doble clic en una entrada específica.

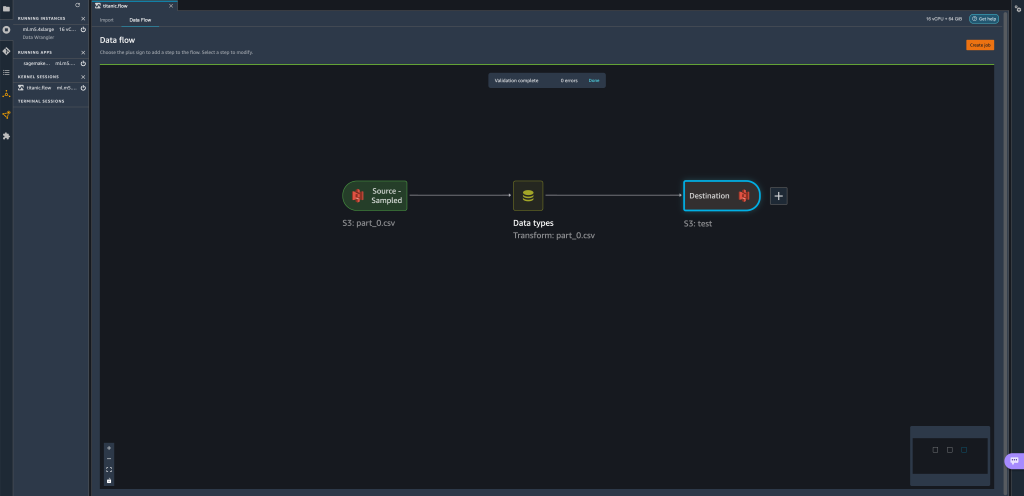

Limpiar

Cuando no esté utilizando Data Wrangler, se recomienda cerrar la instancia en la que se ejecuta para evitar incurrir en tarifas adicionales.

Para evitar perder trabajo, guarde su flujo de datos antes de apagar Data Wrangler.

- Para guardar su flujo de datos en Studio, elija Archive, A continuación, elija Guardar flujo de datos Wrangler. Data Wrangler guarda automáticamente su flujo de datos cada 60 segundos.

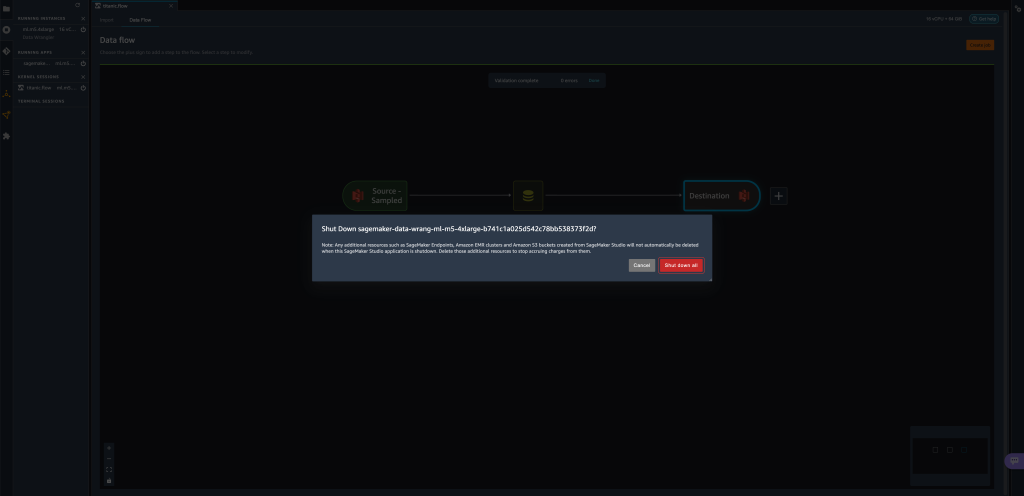

- Para cerrar la instancia de Data Wrangler, en Studio, elija Ejecución de instancias y kernels.

- under APLICACIONES EN EJECUCIÓN, elija el icono de apagado junto a la

sagemaker-data-wrangler-1.0aplicación.

- Elige Apagar todo para confirmar.

Data Wrangler se ejecuta en una instancia ml.m5.4xlarge. Esta instancia desaparece de INSTANCIAS EN EJECUCIÓN cuando cierra la aplicación Data Wrangler.

Después de cerrar la aplicación Data Wrangler, debe reiniciarse la próxima vez que abra un archivo de flujo de Data Wrangler. Esto puede tardar unos minutos.

Conclusión

En esta publicación, demostramos cómo puede usar parámetros para importar sus conjuntos de datos usando flujos de Data Wrangler y crear trabajos de transformación de datos en ellos. Los conjuntos de datos parametrizados permiten una mayor flexibilidad en los conjuntos de datos que utiliza y le permiten reutilizar sus flujos. También demostramos cómo puede configurar trabajos programados para automatizar sus transformaciones y exportaciones de datos a Amazon S3 o Feature Store, en el momento y la periodicidad que mejor se adapte a sus necesidades, directamente desde la interfaz de usuario de Data Wrangler.

Para obtener más información sobre el uso de flujos de datos con Data Wrangler, consulte Crear y usar un flujo de Wrangler de datos y Precios de Amazon SageMaker. Para comenzar con Data Wrangler, consulte Prepare datos de AA con Amazon SageMaker Data Wrangler.

Sobre los autores

david laredo es Arquitecto de Prototipos para el equipo de Prototipos e Ingeniería en la Nube de Amazon Web Services, donde ha ayudado a desarrollar múltiples prototipos de aprendizaje automático para clientes de AWS. Ha estado trabajando en aprendizaje automático durante los últimos 6 años, entrenando y ajustando modelos ML e implementando canalizaciones de extremo a extremo para producir esos modelos. Sus áreas de interés son NLP, aplicaciones ML y ML de extremo a extremo.

david laredo es Arquitecto de Prototipos para el equipo de Prototipos e Ingeniería en la Nube de Amazon Web Services, donde ha ayudado a desarrollar múltiples prototipos de aprendizaje automático para clientes de AWS. Ha estado trabajando en aprendizaje automático durante los últimos 6 años, entrenando y ajustando modelos ML e implementando canalizaciones de extremo a extremo para producir esos modelos. Sus áreas de interés son NLP, aplicaciones ML y ML de extremo a extremo.

givanildo alves es Arquitecto de Prototipos en el equipo de Prototipos e Ingeniería en la Nube de Amazon Web Services, que ayuda a los clientes a innovar y acelerar mostrando el arte de lo posible en AWS, y ya ha implementado varios prototipos en torno a la inteligencia artificial. Tiene una larga carrera en ingeniería de software y anteriormente trabajó como ingeniero de desarrollo de software en Amazon.com.br.

givanildo alves es Arquitecto de Prototipos en el equipo de Prototipos e Ingeniería en la Nube de Amazon Web Services, que ayuda a los clientes a innovar y acelerar mostrando el arte de lo posible en AWS, y ya ha implementado varios prototipos en torno a la inteligencia artificial. Tiene una larga carrera en ingeniería de software y anteriormente trabajó como ingeniero de desarrollo de software en Amazon.com.br.

Adrián Fuentes es Gerente de Programas en el equipo de Prototipos e Ingeniería en la Nube de Amazon Web Services, innovando para los clientes en aprendizaje automático, IoT y blockchain. Tiene más de 15 años de experiencia en la gestión e implementación de proyectos y 1 año de permanencia en AWS.

Adrián Fuentes es Gerente de Programas en el equipo de Prototipos e Ingeniería en la Nube de Amazon Web Services, innovando para los clientes en aprendizaje automático, IoT y blockchain. Tiene más de 15 años de experiencia en la gestión e implementación de proyectos y 1 año de permanencia en AWS.

- AI

- arte ai

- generador de arte ai

- robot ai

- Aprendizaje automático de Amazon

- Wrangler de datos de Amazon SageMaker

- Anuncios

- inteligencia artificial

- certificación de inteligencia artificial

- inteligencia artificial en banca

- robots de inteligencia artificial

- robots de inteligencia artificial

- software de inteligencia artificial

- Aprendizaje automático de AWS

- blockchain

- conferencia blockchain ai

- Coingenius

- inteligencia artificial conversacional

- criptoconferencia ai

- de dall

- proceso de datos

- deep learning

- google ai

- Intermedio (200)

- máquina de aprendizaje

- Conjuntos de datos parametrizados

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- escala ia

- Trabajos programados

- sintaxis

- Procedimientos técnicos

- zephyrnet