En el dinámico mundo del streaming en Amazon Music, cada búsqueda de una canción, podcast o lista de reproducción contiene una historia, un estado de ánimo o una avalancha de emociones esperando ser reveladas. Estas búsquedas sirven como puerta de entrada a nuevos descubrimientos, experiencias preciadas y recuerdos duraderos. La barra de búsqueda no sirve sólo para encontrar una canción; se trata de los millones de usuarios activos que inician su viaje personal hacia el mundo rico y diverso que Amazon Music tiene para ofrecer.

Ofrecer una experiencia superior al cliente para encontrar instantáneamente la música que buscan los usuarios requiere una plataforma que sea inteligente y responsiva. Amazon Music utiliza el poder de la IA para lograrlo. Sin embargo, optimizar la experiencia del cliente y al mismo tiempo gestionar el costo de la capacitación y la inferencia de los modelos de IA que potencian las capacidades de la barra de búsqueda, como el corrector ortográfico en tiempo real y la búsqueda vectorial, es difícil durante las horas pico de tráfico.

Amazon SageMaker proporciona un conjunto de servicios de un extremo a otro que permiten a Amazon Music crear, entrenar e implementar en la nube de AWS con un mínimo esfuerzo. Al encargarse del trabajo pesado indiferenciado, SageMaker le permite concentrarse en trabajar en sus modelos de aprendizaje automático (ML) y no preocuparse por cosas como la infraestructura. Como parte del modelo de responsabilidad compartida, SageMaker se asegura de que los servicios que brinda sean confiables, eficientes y escalables, mientras usted se asegura de que la aplicación de los modelos ML haga el mejor uso de las capacidades que brinda SageMaker.

En esta publicación, analizamos el viaje que realizó Amazon Music para optimizar el rendimiento y los costos utilizando SageMaker, NVIDIA Triton Inference Server y TensorRT. Nos sumergimos profundamente en mostrar cómo funciona esa barra de búsqueda aparentemente simple, pero intrincada, asegurando un viaje ininterrumpido al universo de Amazon Music con retrasos tipográficos frustrantes de poco a cero y resultados de búsqueda relevantes en tiempo real.

Amazon SageMaker y NVIDIA: ofrecen capacidades de revisión ortográfica y búsqueda vectorial rápidas y precisas

Amazon Music ofrece una amplia biblioteca de más de 100 millones de canciones y millones de episodios de podcasts. Sin embargo, encontrar la canción o el podcast correcto puede ser un desafío, especialmente si no sabes el título exacto, el artista o el nombre del álbum, o si la consulta buscada es muy amplia, como "podcasts de noticias".

Amazon Music ha adoptado un enfoque doble para mejorar el proceso de búsqueda y recuperación. El primer paso es introducir la búsqueda vectorial (también conocida como recuperación basada en incrustaciones), una técnica de aprendizaje automático que puede ayudar a los usuarios a encontrar el contenido más relevante que buscan mediante el uso de la semántica del contenido. El segundo paso implica introducir un modelo de corrección ortográfica basado en Transformer en la pila de búsqueda. Esto puede resultar especialmente útil al buscar música, porque es posible que los usuarios no siempre sepan la ortografía exacta del título de una canción o el nombre del artista. La corrección ortográfica puede ayudar a los usuarios a encontrar la música que buscan incluso si cometen un error ortográfico en su consulta de búsqueda.

La introducción de modelos Transformer en una canalización de búsqueda y recuperación (en la generación de incorporación de consultas necesaria para la búsqueda de vectores y el modelo generativo Seq2Seq Transformer en la corrección ortográfica) puede generar un aumento significativo en la latencia general, lo que afecta negativamente la experiencia del cliente. Por lo tanto, para nosotros se convirtió en una máxima prioridad optimizar la latencia de inferencia en tiempo real para los modelos de búsqueda de vectores y corrección ortográfica.

Amazon Music y NVIDIA se han unido para brindar la mejor experiencia posible al cliente en la barra de búsqueda, utilizando SageMaker para implementar capacidades de revisión ortográfica rápidas y precisas y sugerencias de búsqueda semántica en tiempo real utilizando técnicas basadas en búsqueda vectorial. La solución incluye el uso de alojamiento SageMaker impulsado por instancias G5 que utilizan GPU NVIDIA A10G Tensor Core, el contenedor de servidor de inferencia NVIDIA Triton compatible con SageMaker y el TensorRT de NVIDIA formato del modelo. Al reducir la latencia de inferencia del modelo de corrección ortográfica a 25 milisegundos en picos de tráfico y reducir la latencia de generación de incorporación de consultas de búsqueda en un 63 % en promedio y el costo en un 73 % en comparación con la inferencia basada en CPU, Amazon Music ha elevado el rendimiento de la barra de búsqueda.

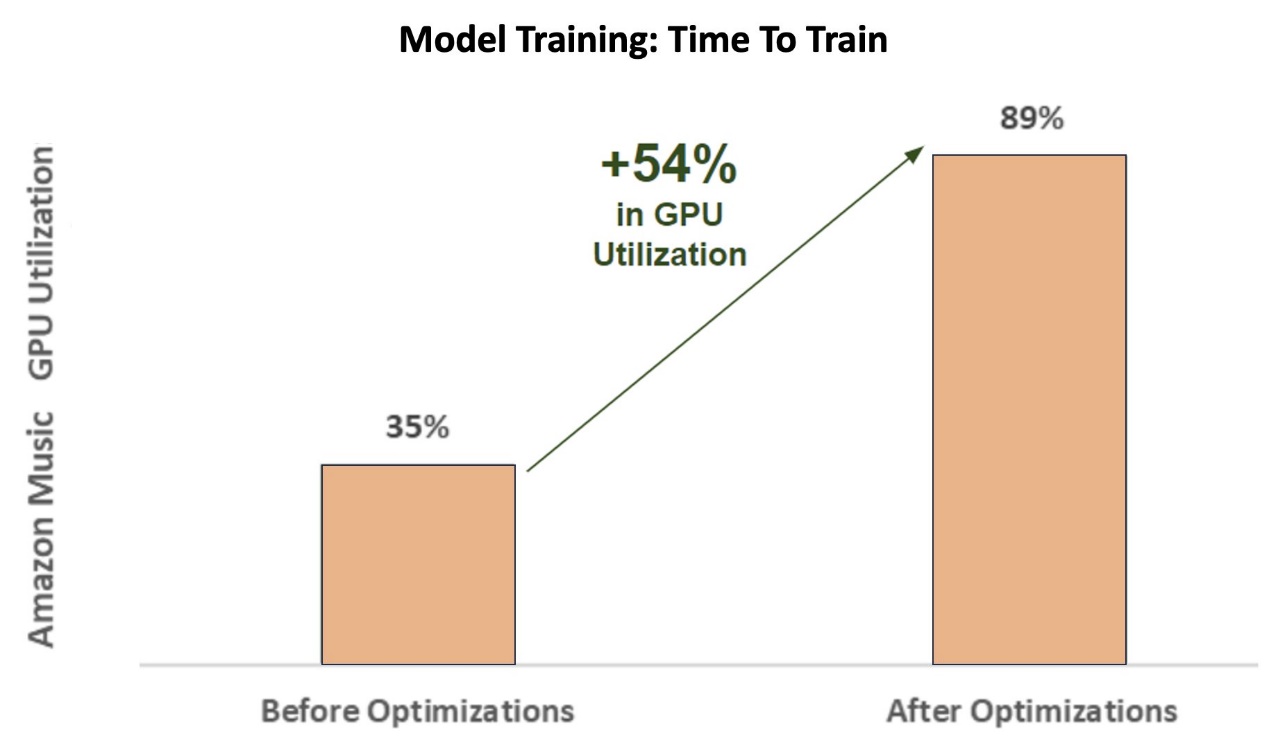

Además, al entrenar el modelo de IA para ofrecer resultados precisos, Amazon Music logró una enorme aceleración de 12 veces en el tiempo de entrenamiento para su modelo transformador de corrector ortográfico secuencia a secuencia BART, ahorrándoles tiempo y dinero al optimizar su utilización de GPU.

Amazon Music se asoció con NVIDIA para priorizar la experiencia de búsqueda del cliente y crear una barra de búsqueda con funcionalidades de búsqueda vectorial y corrección ortográfica bien optimizadas. En las siguientes secciones, compartimos más información sobre cómo se orquestaron estas optimizaciones.

Optimización del entrenamiento con las GPU NVIDIA Tensor Core

Obtener acceso a una GPU NVIDIA Tensor Core para el entrenamiento de modelos de lenguaje grandes no es suficiente para capturar su verdadero potencial. Hay pasos de optimización clave que deben realizarse durante el entrenamiento para maximizar completamente la utilización de la GPU. Sin embargo, una GPU infrautilizada conducirá sin duda a un uso ineficiente de los recursos, duraciones prolongadas de la capacitación y mayores costos operativos.

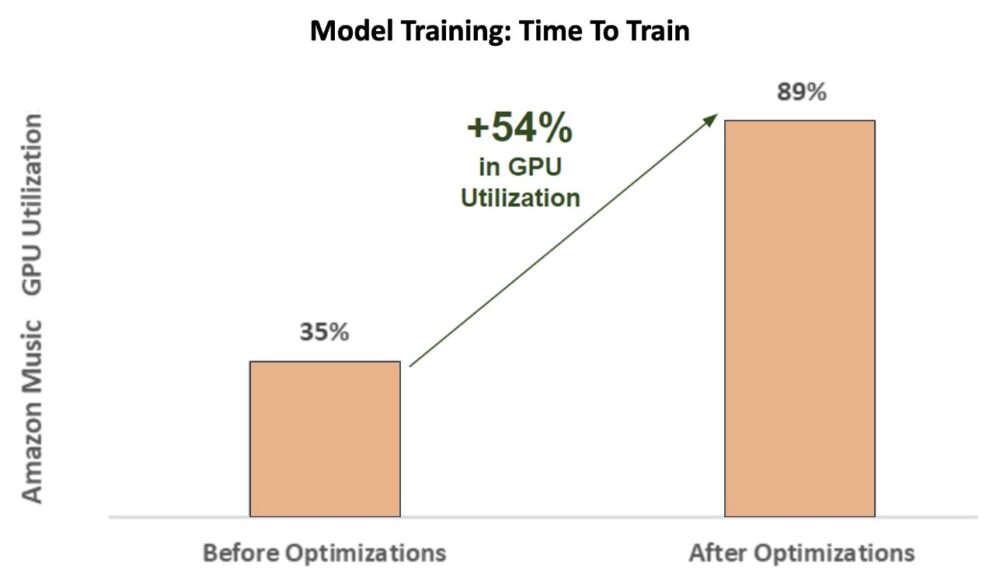

Durante las fases iniciales del entrenamiento del corrector ortográfico BART (base-bart) modelo de transformador en una instancia SageMaker ml.p3.24xlarge (8 GPU NVIDIA V100 Tensor Core), la utilización de GPU de Amazon Music fue de alrededor del 35 %. Para maximizar los beneficios de la capacitación acelerada por GPU de NVIDIA, los arquitectos de soluciones de AWS y NVIDIA ayudaron a Amazon Music a identificar áreas de optimización, particularmente en torno al tamaño del lote y los parámetros de precisión. Estos dos parámetros cruciales influyen en la eficiencia, velocidad y precisión del entrenamiento de modelos de aprendizaje profundo.

Las optimizaciones resultantes produjeron una utilización de la GPU V100 nueva y mejorada, estable en alrededor del 89 %, lo que redujo drásticamente el tiempo de capacitación de Amazon Music de 3 días a 5 a 6 horas. Cambiando el tamaño del lote de 32 a 256 y usando técnicas de optimización como ejecutar entrenamiento automático de precisión mixta En lugar de utilizar únicamente la precisión de FP32, Amazon Music pudo ahorrar tiempo y dinero.

El siguiente gráfico ilustra el aumento del 54 % en puntos porcentuales en la utilización de GPU después de las optimizaciones.

La siguiente figura ilustra la aceleración en el tiempo de entrenamiento.

Este aumento en el tamaño del lote permitió a la GPU NVIDIA procesar significativamente más datos simultáneamente en múltiples Tensor Cores, lo que aceleró el tiempo de entrenamiento. Sin embargo, es importante mantener un delicado equilibrio con la memoria, porque los lotes más grandes exigen más memoria. Tanto aumentar el tamaño del lote como emplear precisión mixta pueden ser fundamentales para desbloquear el poder de las GPU NVIDIA Tensor Core.

Después de entrenar el modelo para la convergencia, llegó el momento de optimizarlo para la implementación de inferencia en la barra de búsqueda de Amazon Music.

Corrección ortográfica: inferencia del modelo BART

Con la ayuda de instancias SageMaker G5 y NVIDIA Triton Inference Server (un software de servicio de inferencia de código abierto), así como NVIDIA TensorRT, un SDK para inferencia de aprendizaje profundo de alto rendimiento que incluye un optimizador de inferencia y tiempo de ejecución, Amazon Music limita su corrección ortográfica BART. (base-bart) modelan la latencia de inferencia del servidor a solo 25 milisegundos en picos de tráfico. Esto incluye gastos generales como equilibrio de carga, preprocesamiento, inferencia de modelos y tiempos de posprocesamiento.

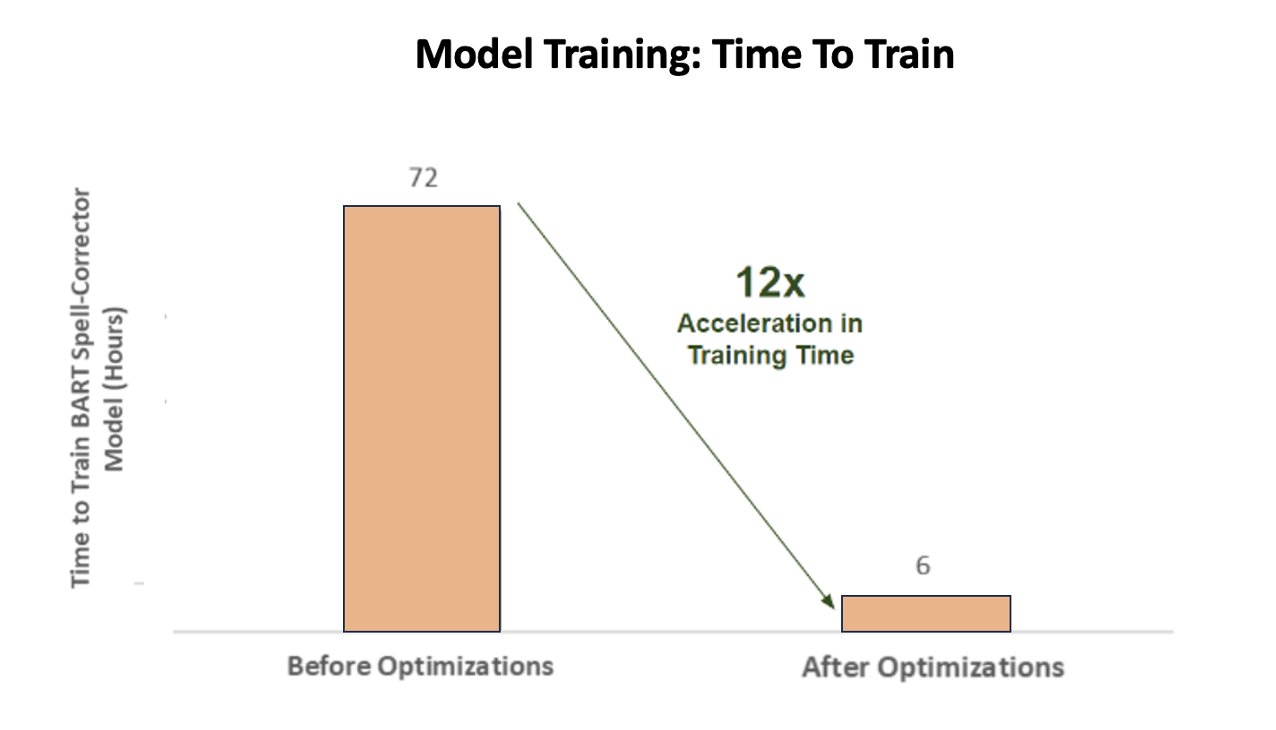

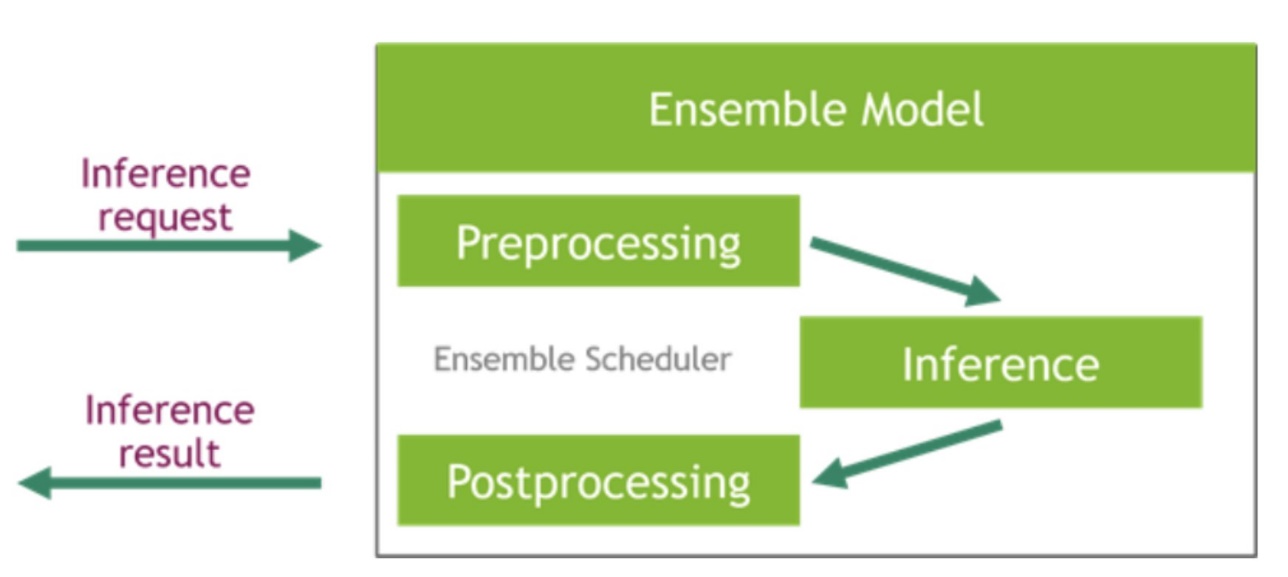

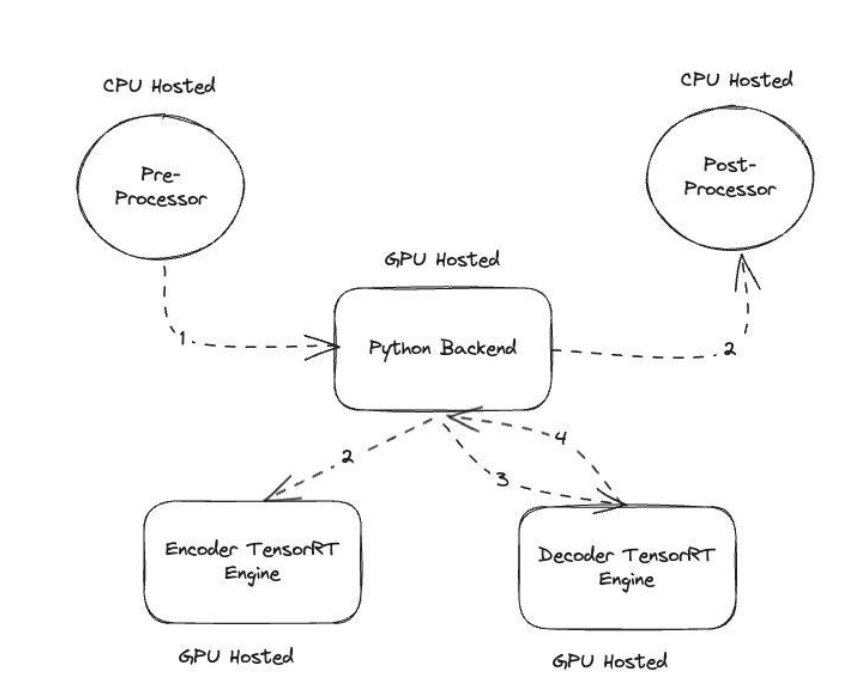

NVIDIA Triton Inference Server proporciona dos tipos de backends diferentes: uno para alojar modelos en GPU y un backend de Python donde puede traer su propio código personalizado para usarlo en los pasos de preprocesamiento y posprocesamiento. La siguiente figura ilustra la esquema de conjunto modelo.

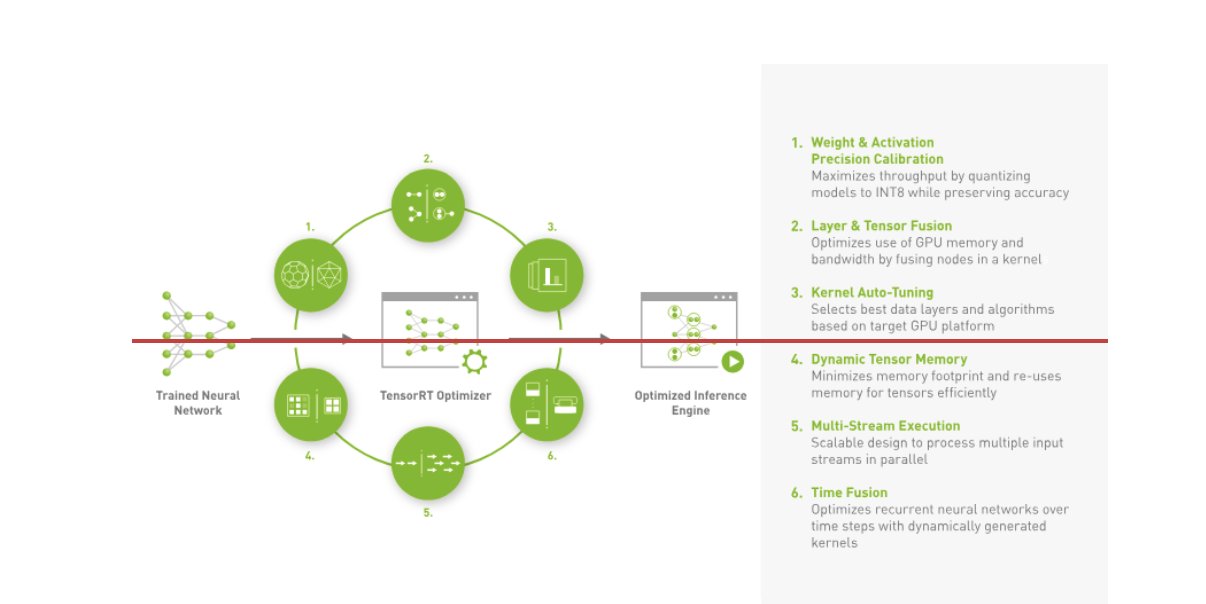

Amazon Music construyó su BART tubería de inferencia ejecutando los pasos de preprocesamiento (tokenización de texto) y posprocesamiento (tokens a texto) en las CPU, mientras que el paso de ejecución del modelo se ejecuta en GPU NVIDIA A10G Tensor Core. Un backend de Python se encuentra en medio de los pasos de preprocesamiento y posprocesamiento y es responsable de comunicarse con los modelos BART convertidos a TensorRT, así como con las redes de codificador/decodificador. TensorRT aumenta el rendimiento de inferencia con calibración de precisión, fusión de capas y tensores, ajuste automático del kernel, memoria tensorial dinámica, ejecución de secuencias múltiples y fusión de tiempo.

La siguiente figura ilustra el diseño de alto nivel de los módulos clave que conforman el canal de inferencia del modelo BART del corrector ortográfico.

Búsqueda de vectores: incrustación de consultas, generación de oraciones, inferencia del modelo BERT

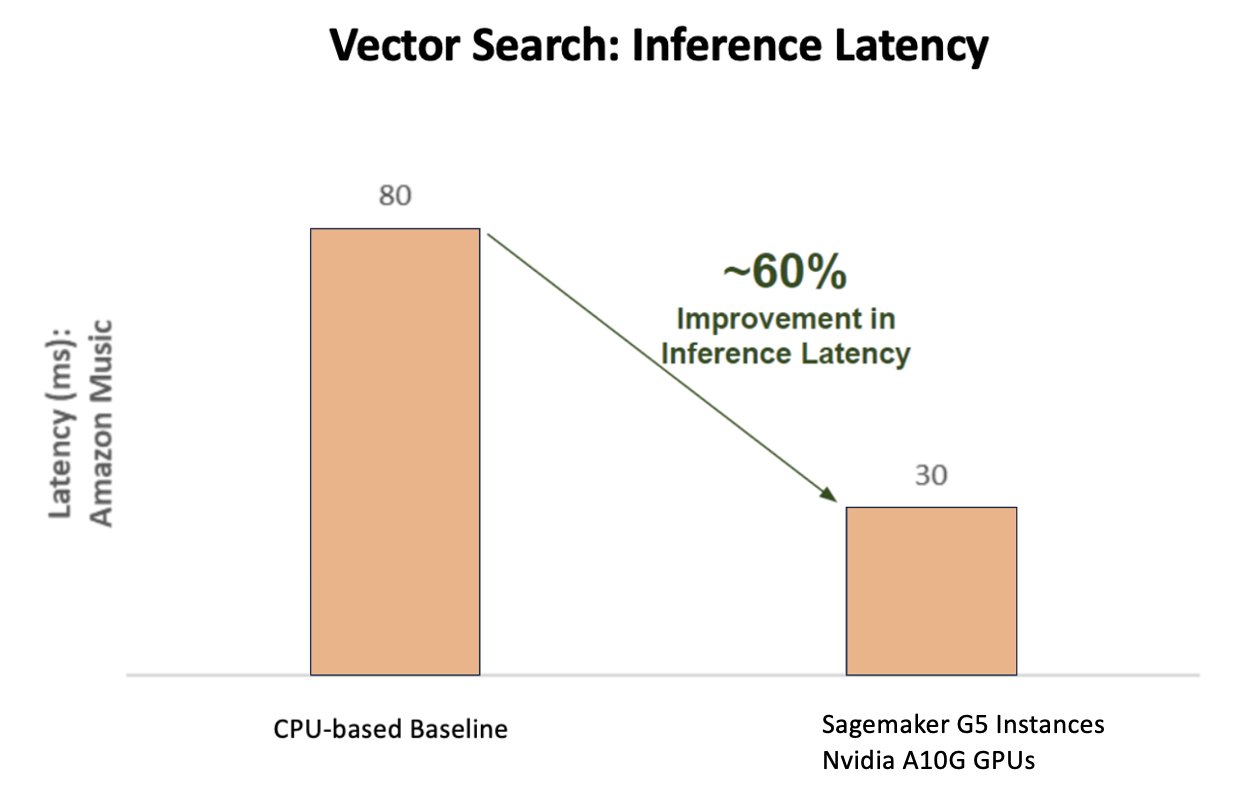

El siguiente gráfico ilustra la mejora del 60 % en la latencia (con p90 800–900 TPS) cuando se utiliza la plataforma de inferencia de IA de NVIDIA en comparación con una línea base basada en CPU.

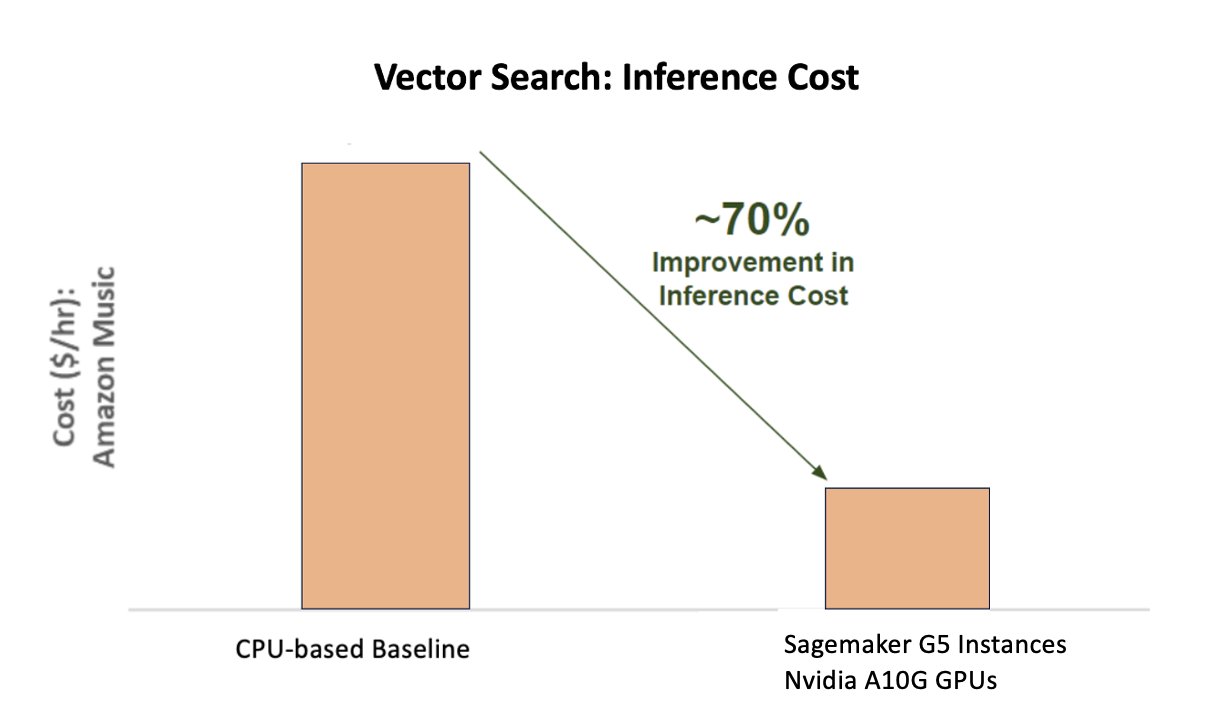

El siguiente gráfico muestra una mejora del 70 % en el costo al utilizar la plataforma de inferencia de IA de NVIDIA en comparación con una base basada en CPU.

La siguiente figura ilustra un SDK para la inferencia de aprendizaje profundo de alto rendimiento. Incluye un optimizador de inferencia de aprendizaje profundo y un tiempo de ejecución que ofrece baja latencia y alto rendimiento para aplicaciones de inferencia.

Para lograr estos resultados, Amazon Music experimentó con varios parámetros de implementación de Triton diferentes usando Analizador de modelos Tritón, una herramienta que ayuda a encontrar la mejor configuración del modelo NVIDIA Triton para implementar una inferencia eficiente. Para optimizar la inferencia de modelos, Triton ofrece características como procesamiento por lotes dinámico y ejecución simultánea de modelos, y tiene soporte de marco para otras capacidades de flexibilidad. El procesamiento por lotes dinámico recopila solicitudes de inferencia y las agrupa sin problemas en cohortes para maximizar el rendimiento y, al mismo tiempo, garantizar respuestas en tiempo real para los usuarios de Amazon Music. La capacidad de ejecución simultánea de modelos mejora aún más el rendimiento de la inferencia al alojar múltiples copias del modelo en la misma GPU. Finalmente, utilizando Analizador de modelos Tritón, Amazon Music pudo ajustar cuidadosamente los parámetros de alojamiento de inferencia de concurrencia de modelos y procesamiento por lotes dinámicos para encontrar configuraciones óptimas que maximicen el rendimiento de la inferencia utilizando tráfico simulado.

Conclusión

La optimización de las configuraciones con Triton Inference Server y TensorRT en SageMaker permitió a Amazon Music lograr resultados sobresalientes tanto para los procesos de capacitación como para los de inferencia. La plataforma SageMaker es la plataforma abierta de extremo a extremo para la producción de IA, que proporciona una rápida obtención de valor y la versatilidad para admitir todos los principales casos de uso de IA en hardware y software. Al optimizar la utilización de la GPU V100 para el entrenamiento y cambiar de CPU a instancias G5 utilizando las GPU NVIDIA A10G Tensor Core, así como al utilizar software optimizado de NVIDIA como Triton Inference Server y TensorRT, empresas como Amazon Music pueden ahorrar tiempo y dinero mientras aumentan el rendimiento en ambos. capacitación e inferencia, lo que se traduce directamente en una mejor experiencia del cliente y menores costos operativos.

SageMaker se encarga del trabajo pesado indiferenciado de la capacitación y el alojamiento de ML, lo que permite a Amazon Music ofrecer operaciones de ML confiables y escalables tanto en hardware como en software.

Le recomendamos que compruebe que sus cargas de trabajo estén optimizadas con SageMaker evaluando siempre sus opciones de hardware y software para ver si hay formas de lograr un mejor rendimiento con menores costos.

Para obtener más información sobre NVIDIA AI en AWS, consulte lo siguiente:

Sobre los autores

Siddharth Sharma es líder tecnológico de aprendizaje automático en el equipo de ciencia y modelado de Amazon Music. Se especializa en problemas de modelado relacionados con búsqueda, recuperación, clasificación y PNL. Siddharth tiene una amplia experiencia trabajando en problemas de aprendizaje automático a gran escala que son sensibles a la latencia, por ejemplo, orientación de anuncios, recuperación multimodal, comprensión de consultas de búsqueda, etc. Antes de trabajar en Amazon Music, Siddharth trabajó en empresas como Meta, Walmart Labs, Rakuten. sobre problemas de aprendizaje automático centrados en el comercio electrónico. Siddharth pasó la primera parte de su carrera trabajando con nuevas empresas de tecnología publicitaria del área de la bahía.

Siddharth Sharma es líder tecnológico de aprendizaje automático en el equipo de ciencia y modelado de Amazon Music. Se especializa en problemas de modelado relacionados con búsqueda, recuperación, clasificación y PNL. Siddharth tiene una amplia experiencia trabajando en problemas de aprendizaje automático a gran escala que son sensibles a la latencia, por ejemplo, orientación de anuncios, recuperación multimodal, comprensión de consultas de búsqueda, etc. Antes de trabajar en Amazon Music, Siddharth trabajó en empresas como Meta, Walmart Labs, Rakuten. sobre problemas de aprendizaje automático centrados en el comercio electrónico. Siddharth pasó la primera parte de su carrera trabajando con nuevas empresas de tecnología publicitaria del área de la bahía.

Tarun Sharma es un gerente de desarrollo de software que lidera la relevancia de búsqueda de música de Amazon. Su equipo de científicos e ingenieros de ML es responsable de proporcionar resultados de búsqueda personalizados y contextualmente relevantes a los clientes de Amazon Music.

Tarun Sharma es un gerente de desarrollo de software que lidera la relevancia de búsqueda de música de Amazon. Su equipo de científicos e ingenieros de ML es responsable de proporcionar resultados de búsqueda personalizados y contextualmente relevantes a los clientes de Amazon Music.

James Park es arquitecto de soluciones en Amazon Web Services. Trabaja con Amazon.com para diseñar, crear e implementar soluciones tecnológicas en AWS y tiene un interés particular en la IA y el aprendizaje automático. En su tiempo libre le gusta buscar nuevas culturas, nuevas experiencias y mantenerse al día con las últimas tendencias tecnológicas. Puede encontrarlo en Etiqueta LinkedIn.

James Park es arquitecto de soluciones en Amazon Web Services. Trabaja con Amazon.com para diseñar, crear e implementar soluciones tecnológicas en AWS y tiene un interés particular en la IA y el aprendizaje automático. En su tiempo libre le gusta buscar nuevas culturas, nuevas experiencias y mantenerse al día con las últimas tendencias tecnológicas. Puede encontrarlo en Etiqueta LinkedIn.

Kshitiz Gupta es arquitecto de soluciones en NVIDIA. Le gusta educar a los clientes de la nube sobre las tecnologías GPU AI que NVIDIA tiene para ofrecer y ayudarlos a acelerar sus aplicaciones de aprendizaje automático y aprendizaje profundo. Fuera del trabajo, le gusta correr, caminar y observar la vida silvestre.

Kshitiz Gupta es arquitecto de soluciones en NVIDIA. Le gusta educar a los clientes de la nube sobre las tecnologías GPU AI que NVIDIA tiene para ofrecer y ayudarlos a acelerar sus aplicaciones de aprendizaje automático y aprendizaje profundo. Fuera del trabajo, le gusta correr, caminar y observar la vida silvestre.

jiahong liu es arquitecto de soluciones en el equipo de proveedores de servicios en la nube de NVIDIA. Ayuda a los clientes a adoptar soluciones de inteligencia artificial y aprendizaje automático que aprovechan la computación acelerada de NVIDIA para abordar sus desafíos de capacitación e inferencia. En su tiempo libre, disfruta del origami, proyectos de bricolaje y jugar al baloncesto.

jiahong liu es arquitecto de soluciones en el equipo de proveedores de servicios en la nube de NVIDIA. Ayuda a los clientes a adoptar soluciones de inteligencia artificial y aprendizaje automático que aprovechan la computación acelerada de NVIDIA para abordar sus desafíos de capacitación e inferencia. En su tiempo libre, disfruta del origami, proyectos de bricolaje y jugar al baloncesto.

Tugrul Konuk es arquitecto senior de soluciones en NVIDIA y se especializa en capacitación a gran escala, aprendizaje profundo multimodal e informática científica de alto rendimiento. Antes de NVIDIA, trabajó en la industria energética, centrándose en el desarrollo de algoritmos para imágenes computacionales. Como parte de su doctorado, trabajó en aprendizaje profundo basado en la física para simulaciones numéricas a escala. En su tiempo libre le gusta leer, tocar la guitarra y el piano.

Tugrul Konuk es arquitecto senior de soluciones en NVIDIA y se especializa en capacitación a gran escala, aprendizaje profundo multimodal e informática científica de alto rendimiento. Antes de NVIDIA, trabajó en la industria energética, centrándose en el desarrollo de algoritmos para imágenes computacionales. Como parte de su doctorado, trabajó en aprendizaje profundo basado en la física para simulaciones numéricas a escala. En su tiempo libre le gusta leer, tocar la guitarra y el piano.

Rohil Bhargava es gerente de marketing de productos en NVIDIA y se centra en la implementación de marcos de aplicaciones y SDK de NVIDIA en plataformas CSP específicas.

Rohil Bhargava es gerente de marketing de productos en NVIDIA y se centra en la implementación de marcos de aplicaciones y SDK de NVIDIA en plataformas CSP específicas.

Eliuth Triana Isaza es gerente de relaciones con desarrolladores en NVIDIA y capacita a los MLOps de IA, DevOps, científicos y expertos técnicos de AWS de Amazon para dominar la pila informática de NVIDIA para acelerar y optimizar los modelos de Generative AI Foundation que abarcan desde la curación de datos, el entrenamiento de GPU, la inferencia de modelos y la implementación de producción en instancias de GPU de AWS. . Además, Eliuth es un apasionado del ciclismo de montaña, esquiador, tenis y jugador de póquer.

Eliuth Triana Isaza es gerente de relaciones con desarrolladores en NVIDIA y capacita a los MLOps de IA, DevOps, científicos y expertos técnicos de AWS de Amazon para dominar la pila informática de NVIDIA para acelerar y optimizar los modelos de Generative AI Foundation que abarcan desde la curación de datos, el entrenamiento de GPU, la inferencia de modelos y la implementación de producción en instancias de GPU de AWS. . Además, Eliuth es un apasionado del ciclismo de montaña, esquiador, tenis y jugador de póquer.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoData.Network Vertical Generativo Ai. Empodérate. Accede Aquí.

- PlatoAiStream. Inteligencia Web3. Conocimiento amplificado. Accede Aquí.

- PlatoESG. Carbón, tecnología limpia, Energía, Ambiente, Solar, Gestión de residuos. Accede Aquí.

- PlatoSalud. Inteligencia en Biotecnología y Ensayos Clínicos. Accede Aquí.

- Fuente: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :posee

- :es

- :no

- :dónde

- $ UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Poder

- Nuestra Empresa

- acelerado

- acelerador

- aceleración

- de la máquina

- lograr

- la exactitud

- preciso

- Lograr

- alcanzado

- a través de

- lector activo

- adición

- dirección

- Adopción

- Anuncios

- afectando

- Después

- AI

- Modelos AI

- casos de uso de ia

- Álbum

- algoritmos

- Todos

- permitir

- permitido

- Permitir

- permite

- también

- hacerlo

- Amazon

- Amazon Web Services

- Amazon.com

- an

- y

- Aplicación

- aplicaciones

- enfoque

- arquitectos

- somos

- Reservada

- áreas

- en torno a

- artista

- AS

- ayudando

- asistencias

- At

- promedio

- AWS

- Backend

- Balance

- equilibrio

- de caramelos

- basado

- Base

- Baloncesto

- Bay

- BE

- se convirtió en

- porque

- beneficios

- MEJOR

- mejores

- impulsar

- aumenta

- ambas

- llevar

- general

- build

- construido

- by

- PUEDEN

- capacidades

- capacidad

- capturar

- servicios sociales

- Carreras

- estudiar cuidadosamente

- cases

- retos

- desafiante

- Tabla

- comprobar

- querido

- opciones

- clientes

- Soluciones

- código

- COM

- cómo

- comunicado

- Empresas

- en comparación con

- computational

- informática

- competidor

- Configuración

- Envase

- contenido

- Convergencia

- Core

- Cost

- Precio

- arte

- crítico

- crucial

- CSP

- curaduría

- personalizado

- cliente

- experiencia del cliente

- Clientes

- datos

- Fecha

- Días

- disminuido

- profundo

- deep learning

- retrasos

- entregamos

- entregar

- entrega

- Demanda

- desplegar

- Desplegando

- despliegue

- Diseño

- Developer

- el desarrollo

- Desarrollo

- una experiencia diferente

- difícil

- directamente

- inmersión

- diverso

- Bricolaje

- No

- drásticamente,

- durante

- lugar de trabajo dinámico

- e

- comercio electrónico

- Temprano en la

- educar

- eficiencia

- eficiente

- esfuerzo

- elevado

- incrustación

- emociones

- empleando

- empoderamiento

- facilita

- fomentar

- de extremo a extremo

- energía

- certificados

- Mejora

- suficientes

- asegurando que

- especialmente

- etc.

- evaluación

- Incluso

- Cada

- ejecución

- experience

- Experiencias

- expertos

- RÁPIDO

- Caracteristicas

- Figura

- Finalmente

- Encuentre

- la búsqueda de

- Nombre

- Flexibilidad

- inundaciónes

- Focus

- centrado

- enfoque

- siguiendo

- formato

- Fundación

- Marco conceptual

- marcos

- Desde

- frustrante

- completamente

- funcionalidades

- promover

- fusión

- puerta

- generación de AHSS

- generativo

- IA generativa

- GPU

- GPU

- Manijas

- suceder

- Materiales

- Tienen

- he

- pesado

- levantar objetos pesados

- ayuda

- serviciales

- ayuda

- Alta

- de alto nivel

- Alto rendimiento

- su

- mantiene

- hosting

- HORAS

- Cómo

- Sin embargo

- HTML

- HTTPS

- identificar

- if

- ilustra

- Proyección de imagen

- implementar

- importante

- mejorar

- mejorado

- es la mejora continua

- in

- incluye

- aumente

- aumentado

- creciente

- energético

- ineficiente

- influir

- EN LA MINA

- inicial

- ejemplo

- instantáneamente

- intereses

- dentro

- introducir

- Presentamos

- IT

- SUS

- jpg

- solo

- Clave

- Tipo

- Saber

- conocido

- labs

- idioma

- large

- Gran escala

- mayores

- perdurable

- Estado latente

- más reciente

- .

- Lead

- líder

- APRENDE:

- aprendizaje

- Apalancamiento

- Biblioteca

- cirugía estética

- como

- límites

- Etiqueta LinkedIn

- carga

- mirando

- Baja

- inferior

- máquina

- máquina de aprendizaje

- mantener

- gran

- para lograr

- HACE

- gerente

- administrar

- Marketing

- dominar

- Maximizar

- Puede..

- Memorias

- Salud Cerebral

- Meta

- Ed. Media

- millones

- millones

- milisegundos

- mínimo

- Error

- mezclado

- ML

- MLOps

- modelo

- modelado

- modelos

- Módulos

- dinero

- más,

- MEJOR DE TU

- Montaña

- múltiples

- múltiples

- Música

- debe

- nombre

- negativamente

- telecomunicaciones

- Nuevo

- nlp

- Nvidia

- of

- LANZAMIENTO

- Ofertas

- on

- ONE

- , solamente

- habiertos

- de código abierto

- funcionamiento

- operativos.

- Operaciones

- óptimo

- optimización

- Optimización

- optimizado

- optimizando

- or

- orquestado

- solicite

- Otro

- salir

- afuera

- excepcional

- Más de

- total

- EL DESARROLLADOR

- parámetros

- parte

- particular

- particularmente

- asociado

- apasionado

- En pleno

- porcentaje

- actuación

- con

- Personalizado

- Doctor en Filosofía

- industrial

- plataforma

- Plataformas

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- jugador

- jugando

- Podcast

- Pódcasts

- punto

- póker

- posible

- Publicación

- posible

- industria

- alimentado

- Precisión

- Anterior

- priorizar

- lista de prioridades

- problemas

- Producto

- Producción

- proyecta

- proporcionar

- proveedor

- proporciona un

- proporcionando

- Python

- Búsqueda

- Clasificación

- Reading

- en tiempo real

- la reducción de

- remitir

- relacionado

- relaciones

- la relevancia

- confianza

- solicitudes

- requiere

- Recursos

- respuestas

- responsabilidad

- responsable

- sensible

- resultante

- Resultados

- Rico

- Derecho

- correr

- corre

- tiempo de ejecución

- sabio

- mismo

- Guardar

- ahorro

- escalable

- Escala

- Ciencia:

- científico

- los científicos

- Sdk

- SDK

- sin problemas

- Buscar

- Búsquedas

- búsqueda

- Segundo

- (secciones)

- ver

- la búsqueda de

- aparentemente

- semántica

- mayor

- sensible

- sentencia

- ayudar

- servidor

- de coches

- Proveedor de servicios

- Servicios

- servicio

- set

- ajustes

- Varios

- Compartir

- compartido

- Shows

- importante

- significativamente

- sencillos

- se sienta

- Tamaño

- tamaños

- inteligente

- Software

- Desarrollo de software ad-hoc

- a medida

- Soluciones

- canción

- Fuente

- abarcando

- se especializa

- especializada

- soluciones y

- velocidad

- HECHIZO

- ortografía

- gastado

- montón

- Comience a

- Startups

- quedarse

- estable

- paso

- pasos

- Historia

- en streaming

- tal

- superior

- SOPORTE

- Soportado

- seguro

- toma

- toma

- orientación

- equipo

- tecnología

- Técnico

- la técnica

- técnicas

- Tecnologías

- Tecnología

- texto

- esa

- La

- su

- Les

- Ahí.

- por lo tanto

- Estas

- ellos

- cosas

- así

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- rendimiento

- equipo

- veces

- Título

- a

- juntos

- Tokenization

- Tokens

- se

- del IRS

- parte superior

- TPS

- tráfico

- Entrenar

- entrenado

- Formación

- transformador

- Tendencias

- Tritón

- verdadero

- dos

- comprensión

- indudablemente

- Universo

- desbloqueo

- dio a conocer

- us

- utilizan el

- usado

- usuarios

- usos

- usando

- Utilizando

- propuesta de

- Vasto

- versatilidad

- muy

- Esperando

- caminar

- Walmart

- fue

- ver

- formas

- we

- web

- servicios web

- WELL

- tuvieron

- cuando

- mientras

- mientras

- seguirá

- Actividades:

- trabajado

- trabajando

- funciona

- mundo

- preocuparse

- aún

- cedió

- Usted

- tú

- zephyrnet