Ser capaz de decodificar las ondas cerebrales podría ayudar a los pacientes que han perdido la capacidad de hablar a comunicarse nuevamente y, en última instancia, podría proporcionar formas novedosas para que los humanos interactúen con las computadoras. Ahora los investigadores de Meta han demostrado que pueden decir qué palabras es alguien . utilizando grabaciones de escáneres cerebrales no invasivos.

Nuestra capacidad de sondear humana La actividad cerebral ha mejorado significativamente en las últimas décadas a medida que los científicos han desarrollado una variedad de tecnologías de interfaz cerebro-computadora (BCI) que pueden proporcionar una ventana a nuestros pensamientos e intenciones.

Los resultados más impresionantes provienen de dispositivos de registro invasivos, que implantan electrodos directamente en el sesos gray materia, combinado con AI que puede aprender a interpretart señales cerebrales. En los últimos años, esto ha maes posible decodificar oraciones completas de la actividad neuronal de alguien con un 97 por ciento de precisión, y traducir los intentos movimientos de escritura a mano directamente en el texto a velocidades comparablesle a los mensajes de texto.

Pero tener que implantar electrodos en el cerebro de alguien tiene desventajas obvias. Estos procedimientos riesgosos solo son médicamente justificables para pacientes que requieren un registro cerebral para ayudar a resolver otros problemas médicos, como la epilepsia. Y las sondas neuronales se degradan con el tiempo, lo que plantea la posibilidad de tener que reemplazarlas periódicamente.

Es por eso que los investigadores de la división de investigación de IA de Meta decidieron investigar si podrían lograr objetivos similares sin requerir una peligrosa cirugía cerebral.y. en un papel publicado en el servidor de preimpresión arXiv, el equipo informó que han desarrollado un sistema de inteligencia artificial que puede predecir qué palabras está escuchando alguien en función de la actividad cerebral registrada usando métodos no invasivos interfaces cerebro-computadora.

"Obviamente, es extremadamente invasivo colocar un electrodo dentro del cerebro de alguien”, Jean Remi King, científica investigadora del Laboratorio de Investigación de Inteligencia Artificial de Facebook (FAIR, por sus siglas en inglés), les dijo a HORA. "Así que queríamos intentar usar registros no invasivos de la actividad cerebral. Y el objetivo era construir un sistema de inteligencia artificial que pueda decodificar las respuestas cerebrales a las historias habladas”.

Los investigadores se basaron en cuatro conjuntos de datos de actividad cerebral preexistentes recopilados de 169 personas mientras escuchaban grabaciones de personas hablando. Cada voluntario fue registrado mediante magnetoencefalografía (MEG) o electroencefalografía (EEG), que utilizan diferentes tipos de sensores para captar la actividad eléctrica del cerebro desde el exterior del cráneo.

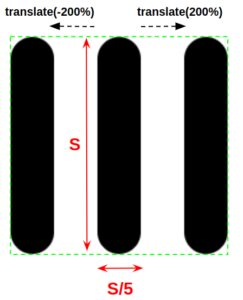

Su enfoque implicad dividir el cerebro y los datos de audio en Tres-fragmentos de un segundo de duración y lo alimentan a una red neuronal que luego buscaed para patrones que cUld conectar los dos. Después de entrenar a la IA con muchas horas de estos datos, la probaron con datos nunca antes vistos.

El sistema se desempeñó mejor en uno de los conjuntos de datos MEG, donde logró una precisión del 10 % entre los 72.5 primeros. Eso significa que cuando clasificó el 10 palabras con la mayor probabilidad de estar vinculadas al segmento de ondas cerebrales, la palabra correcta era existe 72.5 por ciento del tiempo.

Puede que no suene muy bien, pero es importante recordar que estaba seleccionando de un vocabulario potencial de 793 palabras. El sistema obtuvo una puntuación del 67.2 por ciento en el otro conjunto de datos MEG, pero le fue menos bien en los conjuntos de datos EEG, obteniendo el top 10 precisiones de solo 31.4 y 19.1.

Claramente, esto todavía está muy lejos de ser un sistema práctico, pero representa un progreso significativo en un problema difícil. Los BCI no invasivos tienen una relación señal-ruido mucho peor, por lo que descifrar la actividad neuronal de esta manera es un desafío, pero si tiene éxito, podría resultar en una tecnología de aplicación mucho más amplia.

Sin embargo, no todos están convencidos de que sea un problema solucionable. Thomas Knopfel del Imperial College London dijo New Scientist que tratar de sondear los pensamientos usando estos enfoques no invasivos fue como "tratando de transmitir una película HD a través de módems telefónicos analógicos antiguos”, y cuestionó si tales enfoques alguna vez alcanzarán niveles de precisión prácticos.

Compañías como Neuralink de Elon Musk también están apostando a que eventualmente superaremos nuestra aprensión en torno a los enfoques invasivos a medida que la tecnología mejore, abriendo la puerta a que la gente común obtenga implantes cerebrales.

Pero la investigación del equipo de Meta se encuentra en etapas muy tempranas y hay mucho margen para mejoras. Y las oportunidades comerciales para cualquiera que pueda descifrar el escaneo cerebral no invasivo probablemente proporcionarán mucha motivación para intentarlo.

- algoritmo

- inteligencia artificial

- blockchain

- Interfaz cerebro-computadora

- Coingenius

- informática

- criptografía

- cifrar

- ibm cuántico

- Platón

- platón ai

- Inteligencia de datos de Platón

- Juego de Platón

- PlatónDatos

- juego de platos

- computadoras cuánticas

- computación cuántica

- la física cuántica

- Centro de Singularidad

- Temas

- zephyrnet