QuOne Lab, Centro de Investigación e Innovación de Phanous, Teherán, Irán

¿Encuentra este documento interesante o quiere discutirlo? Scite o deje un comentario en SciRate.

Resumen

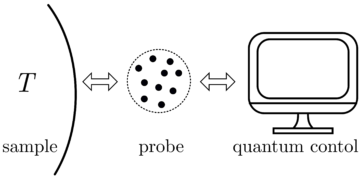

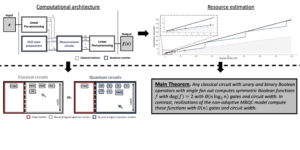

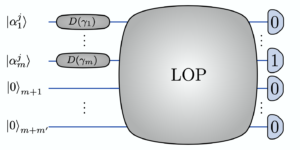

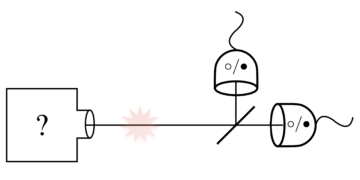

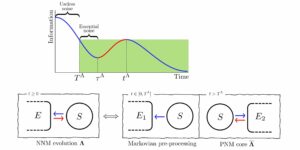

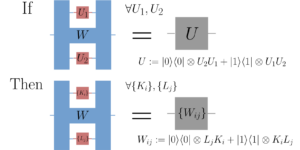

En el entrenamiento de funciones de modelo sobreparametrizadas vía descenso de gradiente, en ocasiones los parámetros no cambian significativamente y permanecen cerca de sus valores iniciales. Este fenómeno se denomina $textit{entrenamiento perezoso}$ y motiva la consideración de la aproximación lineal de la función del modelo en torno a los parámetros iniciales. En el régimen perezoso, esta aproximación lineal imita el comportamiento de la función parametrizada cuyo kernel asociado, denominado $textit{tangent kernel}$, especifica el rendimiento de entrenamiento del modelo. Se sabe que el entrenamiento perezoso ocurre en el caso de redes neuronales (clásicas) con grandes anchos. En este artículo, mostramos que el entrenamiento de $textit{geométricamente local}$ circuitos cuánticos parametrizados entra en el régimen perezoso para un gran número de qubits. Más precisamente, demostramos límites en la tasa de cambios de los parámetros de un circuito cuántico parametrizado geométricamente local en el proceso de entrenamiento, y en la precisión de la aproximación lineal de la función del modelo cuántico asociado; ambos límites tienden a cero a medida que crece el número de qubits. Apoyamos nuestros resultados analíticos con simulaciones numéricas.

► datos BibTeX

► referencias

[ 1 ] John Preskill. Computación cuántica en la era NISQ y más allá. Quantum, 2:79, 2018. doi: 10.22331 / q-2018-08-06-79.

https://doi.org/10.22331/q-2018-08-06-79

[ 2 ] Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Lukasz Cincio, et al. Algoritmos cuánticos variacionales. Nature Reviews Physics, 3(9):625–644, 2021. doi:10.1038/s42254-021-00348-9.

https://doi.org/10.1038/s42254-021-00348-9

[ 3 ] Jarrod R McClean, Sergio Boixo, Vadim N Smelyanskiy, Ryan Babbush y Hartmut Neven. Meseta estéril en paisajes de entrenamiento de redes neuronales cuánticas. Comunicaciones de la naturaleza, 9(1):1–6, 2018. doi:10.1038/s41467-018-07090-4.

https://doi.org/10.1038/s41467-018-07090-4

[ 4 ] Samson Wang, Enrico Fontana, Marco Cerezo, Kunal Sharma, Akira Sone, Lukasz Cincio y Patrick J Coles. Mesetas estériles inducidas por ruido en algoritmos cuánticos variacionales. Comunicaciones de la naturaleza, 12(1):1–11, 2021. doi:10.1038/s41467-021-27045-6.

https://doi.org/10.1038/s41467-021-27045-6

[ 5 ] Francisco Bach. Optimización sin esfuerzo a través de flujos de gradiente. https://francisbach.com/gradient-flows.

https:///francisbach.com/gradient-flows

[ 6 ] Arthur Jacot, Franck Gabriel y Clément Hongler. Núcleo de tangente neuronal: convergencia y generalización en redes neuronales. Avances en los sistemas de procesamiento de información neuronal (NeurIPS 2018), 31:8571–8580, 2018. doi:10.1145/3406325.3465355.

https: / / doi.org/ 10.1145 / 3406325.3465355

[ 7 ] Lenaic Chizat, Edouard Oyallon y Francis Bach. Sobre el entrenamiento perezoso en programación diferenciable. Avances en sistemas de procesamiento de información neuronal, 32, 2019.

[ 8 ] Kouhei Nakaji, Hiroyuki Tezuka y Naoki Yamamoto. Redes neuronales mejoradas cuánticamente en el marco del núcleo neuronal tangente. 2021. arXiv:2109.03786.

arXiv: 2109.03786

[ 9 ] Norihito Shirai, Kenji Kubo, Kosuke Mitarai y Keisuke Fujii. Núcleo de la tangente cuántica. 2021. arXiv:2111.02951.

arXiv: 2111.02951

[ 10 ] María Schuld y Nathan Killoran. Aprendizaje automático cuántico en espacios característicos de hilbert. física Rev. Lett., 122:040504, febrero de 2019. doi:10.1103/PhysRevLett.122.040504.

https: / / doi.org/ 10.1103 / PhysRevLett.122.040504

[ 11 ] Vojtěch Havlíček, Antonio D. Córcoles, Kristan Temme, Aram W. Harrow, Abhinav Kandala, Jerry M. Chow y Jay M. Gambetta. Aprendizaje supervisado con espacios de funciones mejorados cuánticamente. Nature, 567(7747):209–212, marzo de 2019. doi:10.1038/s41586-019-0980-2.

https://doi.org/10.1038/s41586-019-0980-2

[ 12 ] Junyu Liu, Francesco Tacchino, Jennifer R. Glick, Liang Jiang y Antonio Mezzacapo. Aprendizaje de representaciones a través de núcleos tangentes neuronales cuánticos. PRX Quantum, 3:030323, 2022. doi:10.1103/PRXQuantum.3.030323.

https: / / doi.org/ 10.1103 / PRXQuantum.3.030323

[ 13 ] Di Luo y James Halverson. Estados cuánticos de redes neuronales infinitas. 2021. arXiv:2112.00723.

arXiv: 2112.00723

[ 14 ] Junyu Liu, Khadijeh Najafi, Kunal Sharma, Francesco Tacchino, Liang Jiang y Antonio Mezzacapo. Una teoría analítica para la dinámica de amplias redes neuronales cuánticas. física Rev. Lett., 130(15):150601, 2023. doi:10.1103/PhysRevLett.130.150601.

https: / / doi.org/ 10.1103 / PhysRevLett.130.150601

[ 15 ] Junyu Liu, Zexi Lin y Liang Jiang. Pereza, meseta estéril y ruido en el aprendizaje automático, 2022. doi:10.48550/arXiv.2206.09313.

https:///doi.org/10.48550/arXiv.2206.09313

[ 16 ] Edward Farhi y Hartmut Neven. Clasificación con redes neuronales cuánticas en procesadores de corto plazo. 2018. arXiv:1802.06002.

arXiv: 1802.06002

[ 17 ] M. Cerezo, Akira Sone, Tyler Volkoff, Lukasz Cincio y Patrick J. Coles. mesetas estériles dependientes de la función de costo en circuitos cuánticos parametrizados poco profundos. Nature Communications, 12(1):1791, 2021. doi:10.1038/s41467-021-21728-w.

https: / / doi.org/ 10.1038 / s41467-021-21728-w

[ 18 ] Adrián Pérez-Salinas, Alba Cervera-Lierta, Elies Gil-Fuster y José I. Latorre. Recarga de datos para un clasificador cuántico universal. Cuántica, 4:226, 2020. doi:10.22331/q-2020-02-06-226.

https://doi.org/10.22331/q-2020-02-06-226

[ 19 ] Maria Schuld, Ryan Sweke y Johannes Jakob Meyer. Efecto de la codificación de datos en el poder expresivo de los modelos de aprendizaje automático cuántico variacional. física Rev. A, 103:032430, marzo de 2021. doi:10.1103/PhysRevA.103.032430.

https: / / doi.org/ 10.1103 / PhysRevA.103.032430

[ 20 ] Colin McDiarmid. En el método de las diferencias acotadas. En Surveys in combinatorics, 1989 (Norwich, 1989), volumen 141 de London Math. Soc. Lecture Note Ser., páginas 148–188. Universidad de Cambridge. Prensa, Cambridge, 1989. doi:10.1017/cbo9781107359949.008.

https: / / doi.org/ 10.1017 / cbo9781107359949.008

[ 21 ] Ville Bergholm, Josh Izaac, Maria Schuld, Christian Gogolin, M Sohaib Alam, Shahnawaz Ahmed, Juan Miguel Arrazola, Carsten Blank, Alain Delgado, Soran Jahangiri, et al. Pennylane: diferenciación automática de cálculos híbridos cuánticos-clásicos. 2018. arXiv:1811.04968.

arXiv: 1811.04968

[ 22 ] Kerstin Beer, Dmytro Bondarenko, Terry Farrelly, Tobias J Osborne, Robert Salzmann, Daniel Scheiermann y Ramona Wolf. Entrenamiento de redes neuronales cuánticas profundas. Comunicaciones de la naturaleza, 11(1):1–6, 2020. doi:10.1038/s41467-020-14454-2.

https://doi.org/10.1038/s41467-020-14454-2

Citado por

[1] Junyu Liu, Zexi Lin y Liang Jiang, "Pereza, meseta estéril y ruido en el aprendizaje automático", arXiv: 2206.09313, (2022).

[2] Yuxuan Du, Min-Hsiu Hsieh, Tongliang Liu, Shan You y Dacheng Tao, "Erratum: Learnability of Quantum Neural Networks [PRX QUANTUM 2, 040337 (2021)]", PRX Cuántico 3 3, 030901 (2022).

Las citas anteriores son de ANUNCIOS SAO / NASA (última actualización exitosa 2023-04-27 12:25:17). La lista puede estar incompleta ya que no todos los editores proporcionan datos de citas adecuados y completos.

No se pudo recuperar Crossref citado por datos durante el último intento 2023-04-27 12:25:15: No se pudieron obtener los datos citados por 10.22331 / q-2023-04-27-989 de Crossref. Esto es normal si el DOI se registró recientemente.

Este documento se publica en Quantum bajo el Creative Commons Reconocimiento 4.0 Internacional (CC BY 4.0) licencia. Los derechos de autor permanecen con los titulares de derechos de autor originales, como los autores o sus instituciones.

- Distribución de relaciones públicas y contenido potenciado por SEO. Consiga amplificado hoy.

- PlatoAiStream. Inteligencia de datos Web3. Conocimiento amplificado. Accede Aquí.

- Acuñando el futuro con Adryenn Ashley. Accede Aquí.

- Fuente: https://quantum-journal.org/papers/q-2023-04-27-989/

- :es

- :no

- 1

- 10

- 11

- 12

- 13

- 14

- 20

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 22

- 7

- 8

- 9

- a

- arriba

- RESUMEN

- de la máquina

- avances

- afiliaciones

- AL

- algoritmos

- Todos

- an

- Analítico

- y

- Andrés

- abr

- somos

- en torno a

- Arturo

- AS

- asociado

- autor

- Autorzy

- Automático

- BE

- cerveza

- Benjamin

- Más allá de

- ambas

- Descanso

- by

- , que son

- Cambridge

- case

- centro

- el cambio

- Cambios

- clasificación

- Cerrar

- comentario

- Los comunes

- Comunicaciónes

- completar

- computaciones

- informática

- consideración

- Convergencia

- derechos de autor,

- Cost

- podría

- Daniel

- datos

- profundo

- dependiente

- diferencias

- Diferenciación

- discutir

- do

- durante

- dinámica

- E & T

- Edward

- efecto

- Entra en

- Era

- expresivo

- Feature

- Feb

- Flujos

- Marco conceptual

- Francis

- Desde

- función

- funciones

- crece

- harvard

- titulares

- HTTPS

- Híbrido

- híbrido cuántico-clásico

- i

- if

- in

- Infinito

- información

- inicial

- Innovation

- instituciones

- interesante

- Internacional

- JavaScript

- Jennifer

- Juan

- revista

- conocido

- el lab

- large

- Apellidos

- aprendizaje

- Abandonar

- Lectura

- Licencia

- Lista

- local

- Londres

- máquina

- máquina de aprendizaje

- Marco

- las matemáticas

- Puede..

- Método

- Meyer

- modelo

- modelos

- Mes

- más,

- Naturaleza

- Cerca

- del sistema,

- telecomunicaciones

- red neural

- redes neuronales

- ruido

- normal

- número

- números

- of

- on

- habiertos

- optimización

- or

- reconocida por

- "nuestr

- Papel

- parámetros

- actuación

- un fenómeno mundial

- Física

- Platón

- Inteligencia de datos de Platón

- PlatónDatos

- industria

- precisamente

- Precisión

- prensa

- tratamiento

- procesadores

- Programación

- Demostrar.

- proporcionar

- publicado

- editor

- editores

- Cuántico

- algoritmos cuánticos

- computación cuántica

- aprendizaje de máquina cuántica

- qubits

- Rate

- recientemente

- referencias

- régimen

- registrado

- permanecer

- permanece

- representación

- la investigación

- Resultados

- Reseñas

- ROBERT

- Ryan

- superficial

- Sharma

- Mostrar

- significativamente

- Simon

- espacios

- Zonas

- Con éxito

- tal

- adecuado

- SOPORTE

- Todas las funciones a su disposición

- Teherán

- tezuka

- esa

- La

- su

- Estas

- así

- A través de esta formación, el personal docente y administrativo de escuelas y universidades estará preparado para manejar los recursos disponibles que derivan de la diversidad cultural de sus estudiantes. Además, un mejor y mayor entendimiento sobre estas diferencias y similitudes culturales permitirá alcanzar los objetivos de inclusión previstos.

- Título

- a

- Formación

- bajo

- Universal

- actualizado

- Enlance

- Valores

- vía

- volumen

- W

- quieres

- fue

- we

- amplio

- Lobo

- año

- Usted

- Yuan

- zephyrnet

- cero