Andmete ja mudelitulemuste eelarvamuste tuvastamine on vastutustundliku tehisintellekti (AI) ja masinõppe (ML) mudelite loomise põhinõue. Kahjuks ei ole kallutatuse tuvastamine enamiku praktikute jaoks lihtne ülesanne, kuna seda saab mõõta paljudel viisidel ja erinevate tegurite tõttu, mis võivad kallutatud tulemuseni kaasa aidata. Näiteks võib treeningandmete tasakaalustamata valimi võtmise tulemuseks olla mudel, mis on andmete teatud alamhulkade puhul vähem täpne. Kallutatust võib sisse viia ka ML-algoritm ise – isegi hästi tasakaalustatud koolitusandmestiku korral võivad tulemused eelistada teatud andmete alamhulka võrreldes teistega.

Eelarvamuste tuvastamiseks peate põhjalikult mõistma erinevat tüüpi eelarvamusi ja vastavaid kallutatuse mõõdikud. Näiteks selle kirjutamise ajal Amazon SageMaker Clarify pakub valida 21 erineva mõõdiku vahel.

Selles postituses kasutame sissetulekute prognoosimise kasutusjuhtumit (kasutajate sissetuleku ennustamine sellistest sisendfunktsioonidest nagu haridus ja nädalas töötatud tundide arv), et näidata SageMaker Clarify erinevat tüüpi eelarvamusi ja vastavaid mõõdikuid. Samuti töötame välja raamistiku, mis aitab teil otsustada, millised mõõdikud on teie rakenduse jaoks olulised.

SageMaker Clarify tutvustus

ML-mudeleid kasutatakse üha enam otsuste tegemisel erinevates valdkondades, nagu finantsteenused, tervishoid, haridus ja inimressursid. Paljudes olukordades on oluline mõista, miks ML-mudel konkreetse ennustuse tegi ja ka seda, kas ennustusi mõjutas eelarvamus.

SageMaker Clarify pakub tööriistu mõlema vajaduse jaoks, kuid selles postituses keskendume ainult eelarvamuste tuvastamise funktsioonidele. Seletavuse kohta lisateabe saamiseks vaadake lehte Bundesliga mängu faktide xGoals selgitamine Amazon SageMaker Clarify abil.

SageMaker Clarify on osa Amazon SageMaker, mis on täielikult hallatav teenus ML-mudelite ehitamiseks, koolitamiseks ja juurutamiseks.

Näited küsimuste kohta eelarvamuste kohta

Arutelu põhjendamiseks on järgmised mõned näidisküsimused, mis ML-i ehitajatel ja nende sidusrühmadel võivad erapoolikuse kohta tekkida. Loendis on mõned üldised küsimused, mis võivad olla asjakohased mitme ML-rakenduse jaoks, samuti küsimustest konkreetsete rakenduste, näiteks dokumentide otsimise kohta.

Arvestades treeningandmete huvigruppe (nt mehed vs. naised), võite küsida, milliseid mõõdikuid peaksin järgmistele küsimustele vastamiseks kasutama.

- Kas rühma esitus treeningandmetes peegeldab tegelikku maailma?

- Kas koolitusandmete sihtmärgised eelistavad ühte rühma teisele, määrates sellele positiivsemaid silte?

- Kas mudelil on erinevate rühmade jaoks erinev täpsus?

- Kas mudeli puhul, mille eesmärk on tuvastada kvalifitseeritud kandidaadid, on see erinevate rühmade jaoks sama täpne?

- Kas mudelis, mille eesmärk on hankida sisestuspäringu jaoks asjakohaseid dokumente, hangib mudel erinevatest rühmadest asjakohaseid dokumente samas proportsioonis?

Selle postituse ülejäänud osas töötame välja raamistiku, kuidas kaaluda nendele ja teistele küsimustele vastamist SageMaker Clarify'is saadaolevate mõõdikute kaudu.

Kasutage juhtumit ja konteksti

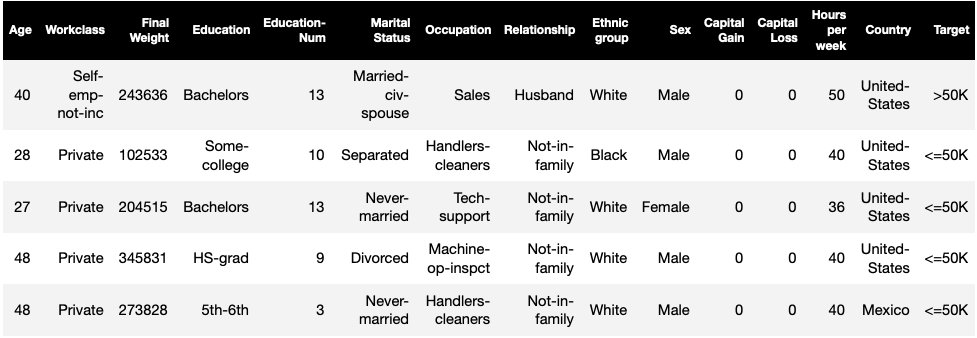

See postitus kasutab SageMaker Clarify töö olemasolevat näidet Õiglus ja seletatavus SageMaker Clarify märkmikuga ja selgitab genereeritud nihke meetrika väärtusi. Sülearvuti treenib XGBoosti mudelit UCI täiskasvanute andmestik (Dua, D. ja Graff, C. (2019). UCI masinõppe hoidla. Irvine, CA: California ülikooli info- ja arvutiteaduste kool).

ML-i ülesanne selles andmekogumis on ennustada, kas inimese aastane sissetulek on suurem või väiksem kui 50,000 XNUMX dollarit. Järgmine tabel näitab mõningaid juhtumeid koos nende funktsioonidega. Sissetulekute prognoosimise kallutatuse mõõtmine on oluline, sest saaksime neid prognoose kasutada otsuste tegemiseks, nagu sooduspakkumised ja sihitud turundus.

Eelarvamuslik terminoloogia

Enne sügavamale sukeldumist vaatame läbi mõned olulised terminoloogiad. Täieliku terminite loendi vaatamiseks vt Amazon SageMaker täpsustage erapoolikuse ja õigluse tingimusi.

- silt – sihtfunktsioon, mida ML-mudel on õpetatud ennustama. An täheldatud märgis viitab märgistuse väärtusele, mida on täheldatud mudeli koolitamiseks või testimiseks kasutatud andmetes. A ennustatud silt on ML-mudeli ennustatud väärtus. Sildid võivad olla binaarsed ja on sageli kodeeritud kui 0 ja 1. Eeldame, et 1 tähistab soodsat või positiivset silti (näiteks sissetulek, mis on suurem või võrdne $ 50,000 0), ja XNUMX ebasoodsat või negatiivset silti. Sildid võivad koosneda ka rohkem kui kahest väärtusest. Isegi sellistel juhtudel moodustavad üks või mitu väärtust soodsa märgi. Lihtsuse huvides käsitleb see postitus ainult binaarseid silte. Rohkem kui kahe väärtusega siltide ja pidevate väärtustega (näiteks regressiooniga) siltide käsitlemise üksikasjade kohta vt Amazoni tehisintellekti õigluse ja seletatavuse valge raamat.

- Facet – veerg või tunnus, mille suhtes nihet mõõdetakse. Meie näites on tahk

sexja võtab kaks väärtust:womanjaman, kodeeritud kuifemalejamaleandmetes (need andmed on võetud 1994. aasta rahvaloendusest ja jõustavad binaarse valiku). Kuigi postituses käsitletakse ühte tahku, millel on ainult kaks väärtust, siis keerukamate juhtumite kohta, mis hõlmavad mitut tahku või rohkem kui kahe väärtusega tahku, vt. Amazoni tehisintellekti õigluse ja seletatavuse valge raamat. - Erapoolikus – Sisendandmete või mudeli prognooside oluline tasakaalustamatus erinevate tahkude väärtuste vahel. See, mis on "oluline", sõltub teie rakendusest. Enamiku mõõdikute puhul ei tähenda väärtus 0 tasakaalustamatust. Kallutatuse mõõdikud rakenduses SageMaker Clarify on jagatud kahte kategooriasse.

- Eelkoolitus – Kui see on olemas, näitab treeningueelne kallutatus ainult andmete tasakaalustamatust.

- Järeltreening – Treeningujärgne eelarvamus võtab lisaks arvesse mudelite ennustusi.

Uurime iga kategooriat eraldi.

Koolituseelne eelarvamus

Eelkoolituse kallutatuse mõõdikud rakenduses SageMaker Täpsustage vastuse järgmisele küsimusele: kas kõigil tahkude väärtustel on andmetes võrdne (või sarnane) esitus? Oluline on kontrollida andmeid treeningueelse eelarvamuse osas, kuna see võib mudeli prognoosides muutuda treeningjärgseks kallutatuseks. Näiteks mudel, mis on treenitud tasakaalustamata andmetele, kus üks tahkväärtus ilmub väga harva, võib selle tahke väärtuse puhul näidata oluliselt halvemat täpsust. Võrdse esituse saab arvutada järgmistel juhtudel:

- Kogu treeninguandmed olenemata siltidest

- Ainult positiivsete siltidega treeningandmete alamhulk

- Iga silt eraldi

Järgmisel joonisel on kokkuvõte selle kohta, kuidas iga mõõdik sobib igasse kolme kategooriasse.

Mõned kategooriad koosnevad rohkem kui ühest mõõdikust. Põhimõõdikud (hallid kastid) vastavad selle kategooria eelarvamuste küsimusele kõige lihtsamal kujul. Valgetes kastides olevad mõõdikud hõlmavad lisaks erijuhtumeid (näiteks Simpsoni paradoks) ja kasutaja eelistusi (näiteks ennustava jõudluse arvutamisel keskendumine elanikkonna teatud osadele).

Tahkväärtuse esitus sõltumata siltidest

Ainus mõõdik selles kategoorias on klassi tasakaalustamatus (CI). Selle mõõdiku eesmärk on mõõta, kas kõik tahkude väärtused on andmetes võrdselt esindatud.

CI on kahe tahkväärtuse moodustatud andmete murdosa erinevus. Meie näite andmekogus tahke jaoks sex, näitab jaotus (näidatud sektordiagrammil), et naised moodustavad 32.4% treeningandmetest, samas kui mehed moodustavad 67.6%. Tulemusena:

CI = 0.676 - 0.324 = 0.352

Tõsiselt kõrge klassi tasakaalustamatus võib väiksema esitusega tahkväärtuse puhul halvendada prognoositavat jõudlust.

Facet väärtuse esitus ainult positiivsete siltide tasemel

Teine viis võrdse esituse mõõtmiseks on kontrollida, kas kõik tahkude väärtused sisaldavad sarnast osa positiivsete täheldatud märgistega proove. Positiivsed märgid koosnevad soodsatest tulemustest (näiteks antud laen, tööks valitud), seega aitab positiivsete siltide eraldi analüüsimine hinnata, kas soodsad otsused jagunevad ühtlaselt.

Meie näidisandmestikus jagunevad vaadeldud sildid positiivseteks ja negatiivseteks väärtusteks, nagu on näidatud järgmisel joonisel.

11.4% kõigist naistest ja 31.4% kõigist meestest on positiivse märgiga (tumeda varjundiga piirkond vasakul ja paremal). Seda erinevust mõõdab märgiste positiivsete proportsioonide erinevus (DPL).

DPL = 0.314 - 0.114 = 0.20

Selle kategooria täpsem mõõdik, siltide tingimuslik demograafiline erinevus (CDDL), mõõdab positiivsete siltide erinevusi, kuid kihistab need mõne teise muutuja alusel. See mõõdik aitab kontrollida Simpsoni paradoks, juhtum, kus kogu andmete arvutus näitab kallutatust, kuid andmete rühmitamisel mõne kõrvalteabe suhtes nihke kaob.

. 1973 UC Berkeley vastuvõtuuuring annab näite. Andmete järgi võeti mehi vastu rohkem kui naisi. Kui aga uuriti ülikoolide üksikute osakondade tasandil, võeti naisi igasse osakonda sarnase või kõrgema määraga. Seda tähelepanekut saab seletada Simpsoni paradoksiga, mis tekkis siin seetõttu, et naised kandideerisid koolidesse, mis olid konkurentsivõimelisemad. Selle tulemusena võeti naisi üldiselt vastu vähem kui mehi, kuigi koolide lõikes võeti neid vastu sarnase või kõrgema määraga.

Lisateavet CDDL-i arvutamise kohta vt Amazoni tehisintellekti õigluse ja seletatavuse valge raamat.

Tahkeväärtuse esitus iga sildi tasemel eraldi

Võrdsust esindatuses saab mõõta ka iga üksiku märgise, mitte ainult positiivse märgise puhul.

Selle kategooria mõõdikud arvutavad erinevate tahkude väärtuste siltide jaotuse erinevuse. Tahkeväärtuse sildi jaotus sisaldab kõiki vaadeldud sildi väärtusi koos selle sildi väärtusega proovide osaga. Näiteks märgiste jaotust kujutaval joonisel on 88.6% naistest täheldatud negatiivset märgist ja 11.4% positiivset täheldatud märgist. Seega on märgiste jaotus naiste puhul [0.886, 0.114] ja meeste puhul [0.686, 0.314].

Selle kategooria põhimõõdik, Kullback-Leibleri lahknevus (KL), mõõdab seda erinevust järgmiselt:

KL = [0.686 x log(0.686/0.886)] + [0.314 x log(0.314/0.114)] = 0.143

Selle kategooria täpsemad mõõdikud, Jenseni-Shannoni lahknevus (JS), Lp-norm (LP), koguvariatsiooni kaugus (TVD) ja Kolmogorov-Smirnov (KS), mõõdavad samuti jaotuste vahelist erinevust, kuid neil on erinevad matemaatilised omadused. Välja arvatud erijuhtudel, pakuvad nad KL-ga sarnaseid teadmisi. Näiteks kuigi KL-i väärtus võib olla lõpmatus, kui tahkude väärtus ei sisalda teatud siltidega näidiseid (näiteks negatiivse sildiga mehi pole), väldib JS neid lõpmatuid väärtusi. Nende erinevuste kohta lisateabe saamiseks vt Amazoni tehisintellekti õigluse ja seletatavuse valge raamat.

Seos DPL-i (2. kategooria) ja KL/JS/LP/TVD/KS (3. kategooria) levipõhiste mõõdikute vahel

Jaotuspõhised mõõdikud on loomulikumalt rakendatavad mittebinaarsete siltide puhul. Kuna positiivse sildi tasakaalustamatust saab kasutada negatiivse sildi tasakaalustamatuse arvutamiseks, annavad jaotusmõõdikud binaarsete siltide puhul sama ülevaate kui DPL-i puhul. Seetõttu võite sellistel juhtudel kasutada lihtsalt DPL-i.

Koolitusjärgne eelarvamus

Treeningujärgsed kallutatuse mõõdikud rakenduses SageMaker Clarify aitavad meil vastata kahele põhiküsimusele.

- Kas positiivsete (soodsate) mudelite prognoosides on kõik tahkväärtused esindatud sarnase kiirusega?

- Kas mudelil on sarnane prognoositav jõudlus kõigi tahkude väärtuste jaoks?

Järgmisel joonisel on näidatud, kuidas mõõdikud vastavad nendele küsimustele. Teist küsimust saab täiendavalt jaotada sõltuvalt sellest, millise märgise alusel toimivust mõõdetakse.

Võrdne esindatus positiivsete mudelite prognoosides

Selle kategooria mõõdikud kontrollivad, kas kõik tahkude väärtused sisaldavad sarnast osa proovidest, millel on mudeli poolt ennustatud positiivne silt. See mõõdikute klass on väga sarnane DPL-i ja CDDL-i eelõppemõõdikutega - ainus erinevus on see, et see kategooria arvestab vaadeldud siltide asemel ennustatud märgiseid.

Meie näidisandmekogus omistab mudel positiivse märgise 4.5% naistest ja 13.7% kõigist meestest.

Selle kategooria põhimõõdik Difference in Positive Proportions in Predicted Labels (DPPL) mõõdab positiivsete klasside määramise erinevust.

DPPL = 0.137 - 0.045 = 0.092

Pange tähele, kuidas koolitusandmetes oli suuremal osal meestest positiivne täheldatud märgis. Samamoodi omistatakse suuremale osale meestest positiivne ennustatud silt.

Liikudes edasi selle kategooria täpsemate mõõdikute juurde, mõõdab erinev mõju (DI) positiivsete klasside määramiste puhul sama erinevust, kuid erinevuse asemel arvutab see suhte:

DI = 0.045 / 0.137 = 0.328

Nii DI kui ka DPPL annavad kvalitatiivselt sarnaseid teadmisi, kuid erinevad mõnel nurgajuhtumil. Näiteks kipuvad suhtarvud plahvatuslikult kasvama väga suurteks numbriteks, kui nimetaja on väike. Võtke näiteks numbrid 0.1 ja 0.0001. Suhe on 0.1/0.0001 = 10,000 0.1, kusjuures erinevus on 0.0001–0.1 ≈ 0. Erinevalt teistest mõõdikutest, kus väärtus 1 ei viita nihkele, ei vasta DI puhul ükski nihe väärtusele XNUMX.

Tingimuslik demograafiline erinevus ennustatavates siltides (CDDPL) mõõdab erinevust tahkväärtuste esituses positiivses märgistuses, kuid nagu CDDL-i koolituseelne mõõdik, kontrollib see ka Simpsoni paradoksi.

Kontrafaktuaalne fliptest (FT) mõõdab, kas kahe tahu väärtuse sarnased valimid saavad mudelilt sarnased otsused. Mudelit, mis määrab kahele valimile, mis on üksteisega sarnased, kuid erinevad tahkude väärtuste poolest, erinevad otsused, võib pidada ebasoodsa (negatiivse) märgise tahke väärtuse suhtes kallutatud. Võttes arvesse esimest tahku väärtust (naised), hindab see, kas teise tahkväärtusega sarnastel liikmetel (mehed) on mudeli ennustus erinev. Sarnased liikmed valitakse k-lähima naabri algoritmi alusel.

Võrdne jõudlus

Mudeliprognoosidel võib olla sarnane esitus positiivsetes märgistes erinevate tahkude väärtustest, kuid mudeli jõudlus nendes rühmades võib oluliselt erineda. Paljudes rakendustes võib olla soovitav sarnane ennustav jõudlus erinevate tahkude väärtuste puhul. Selle kategooria mõõdikud mõõdavad eri tahkude väärtuste prognoositava toimivuse erinevust.

Kuna andmeid saab vaadeldud või prognoositud siltide põhjal tükeldada mitmel erineval viisil, on prognoositava toimivuse mõõtmiseks palju erinevaid viise.

Võrdne ennustav jõudlus olenemata siltidest

Võite kaaluda mudeli toimivust kogu andmete puhul, olenemata vaadeldavatest või prognoositud siltidest – see tähendab üldist täpsust.

Järgmised joonised näitavad, kuidas mudel klassifitseerib meie näidisandmestiku kahe tahu väärtuse sisendid. Tõelised negatiivsed (TN) on juhtumid, kus nii vaadeldud kui ka prognoositud märgis olid 0. Valepositiivsed (FP) on väärklassifikatsioonid, kus vaadeldud märgis oli 0, kuid ennustatud märgis oli 1. Tõelised positiivsed (TP) ja valenegatiivsed (FN) on määratletud sarnaselt.

|

|

Iga tahu väärtuse puhul on mudeli üldine jõudlus, st selle tahke väärtuse täpsus:

Täpsus = (TN + TP) / (TN + FP + FN + TP)

Selle valemiga on naiste täpsus 0.930 ja meeste puhul 0.815. See toob kaasa selle kategooria ainsa mõõdiku, täpsuse erinevuse (AD):

AD = 0.815 - 0.930 = -0.115

AD = 0 tähendab, et mõlema rühma täpsus on sama. Suuremad (positiivsed või negatiivsed) väärtused näitavad suuremaid erinevusi täpsuses.

Võrdne jõudlus ainult positiivsete siltide puhul

Saate piirata mudeli toimivuse analüüsi ainult positiivsete siltidega. Näiteks kui rakendus puudutab koosteliinil esinevate defektide tuvastamist, võib olla soovitav kontrollida, et erinevat tüüpi mittedefektsed osad (positiivne silt) klassifitseeritaks sama kiirusega mittedefektseteks. Seda kogust nimetatakse tagasikutsumiseks või tõeliseks positiivseks määraks:

Tagasikutsumine = TP / (TP + FN)

Meie näiteandmestiku puhul on tagasikutsumine naiste puhul 0.389 ja meeste puhul 0.425. See toob kaasa selle kategooria põhimõõdiku, meeldetuletamise erinevuse (RD):

RD = 0.425 - 0.389 = 0.036

Vaatleme nüüd selle kategooria kolme täpsemat mõõdikut, vaadake, milliseid kasutajaeelistusi need kodeerivad ja kuidas need erinevad RD põhimõõdikust.

Esiteks, selle asemel, et mõõta toimivust positiivselt täheldatud siltide järgi, võiksite seda mõõta positiivsete ennustatud siltide abil. Kui võtta arvesse tahkväärtust (nt naised) ja kõiki selle tahkväärtusega proove, mis mudeli järgi on positiivsed, siis mitu neist on tegelikult õigesti positiivseteks klassifitseeritud? Seda kogust nimetatakse aktsepteerimismääraks (AR) või täpsuseks:

AR = TP / (TP + FP)

Meie näites on naiste AR 0.977 ja meeste AR on 0.970. See toob kaasa erinevuse aktsepteerimismääras (DAR):

DAR = 0.970 - 0.977 = -0.007

Teine võimalus kallutatuse mõõtmiseks on kombineerida kaks eelmist mõõdikut ja mõõta, kui palju positiivsemaid ennustusi mudelid tahkväärtusele määravad võrreldes vaadeldud positiivsete siltidega. SageMaker Clarify mõõdab seda eelist mudeli järgi kui suhet selle tahke väärtuse vaadeldud positiivsete siltide arvu ja prognoositud positiivsete siltide arvu vahel ning viitab sellele kui tingimuslikule aktsepteerimisele (CA):

CA = (TP + FN) / (TP + FP)

Meie näites on naiste CA 2.510 ja meeste puhul 2.283. CA erinevus toob kaasa selle kategooria lõpliku mõõdiku, tingimusliku aktsepteerimise erinevuse (DCA):

DCA = 2.283 - 2.510 = -0.227

Võrdne jõudlus ainult negatiivsete siltide puhul

Sarnaselt positiivsetele siltidele saab kallutatust arvutada ka negatiivsete siltide jõudluse erinevusena. Negatiivsete siltide eraldi arvestamine võib teatud rakendustes olla oluline. Näiteks võiksime oma defektide tuvastamise näites tuvastada erinevat tüüpi defektseid osi (negatiivne silt) sama kiirusega.

Selle kategooria põhimõõdik, spetsiifilisus, on analoogne tagasikutsumise (tõelise positiivse määra) mõõdikuga. Spetsiifilisus arvutab mudeli täpsuse selle tahke väärtusega proovide puhul, millel on täheldatud negatiivne silt:

Eripära = TN / (TN + FP)

Meie näites (vt segaduste tabeleid) on naiste ja meeste spetsiifilisus vastavalt 0.999 ja 0.994. Järelikult on Spetsiifilisus Erinevus (SD) on:

SD = 0.994 - 0.999 = -0.005

Edasi liikudes, nagu vastuvõtumäära mõõdik, on negatiivsete siltide analoogne suurus – tagasilükkamise määr (RR) –:

RR = TN / (TN + FN)

Naiste RR on 0.927 ja meeste puhul 0.791, mis viib tagasilükkamise määra (DRR) mõõdikuni:

DRR = 0.927 - 0.791 = -0.136

Lõpuks on tingimusliku aktsepteerimise negatiivse märgise analoog, tingimuslik tagasilükkamine (CR), selle tahke väärtuse vaadeldud negatiivsete siltide ja prognoositud negatiivsete siltide arvu suhe:

CR = (TN + FP) / (TN + FN)

Naiste CR on 0.928 ja meeste puhul 0.796. Selle kategooria viimane mõõdik on tingimusliku tagasilükkamise erinevus (DCR):

DCR = 0.796 - 0.928 = 0.132

Võrdne jõudlus positiivsete ja negatiivsete siltide puhul

SageMaker Clarify ühendab kaks eelmist kategooriat, võttes arvesse mudeli jõudluse suhet positiivsetel ja negatiivsetel siltidel. Täpsemalt, SageMaker Clarify arvutab iga tahu väärtuse jaoks valenegatiivsete (FN) ja valepositiivsete (FP) suhte. Meie näites on naiste FN/FP suhe 679/10 = 67.9 ja meeste puhul 3678/84 = 43.786. See viib võrdse kohtlemise (TE) mõõdikuni, mis mõõdab FP/FN suhte erinevust:

TE = 67.9 - 43.786 = 24.114

Järgmine ekraanipilt näitab, kuidas saate koos SageMaker Clarify'ga kasutada Amazon SageMaker Studio erinevate nihkemõõdikute väärtuste, vahemike ja lühikirjelduste kuvamiseks.

Küsimused eelarvamuste kohta: millistest mõõdikutest alustada?

Tuletage meelde näidisküsimusi eelarvamuste kohta selle postituse alguses. Olles läbinud erinevate kategooriate mõõdikud, kaaluge küsimusi uuesti. Esimesele küsimusele, mis puudutab erinevate rühmade esitusi treeningandmetes, vastamiseks võiks alustada klassi tasakaalustamatuse (CI) mõõdikust. Sarnaselt võite ülejäänud küsimuste puhul alustada vastavalt märgiste positiivsete proportsioonide (DPL), täpsuse erinevuse (AD), aktsepteerimismäära erinevuse (DAR) ja tagasikutsumise erinevuse (RD) uurimisega.

Eelarvamus ilma tahkväärtusteta

Ekspositsiooni hõlbustamiseks välistas see treeningjärgsete mõõdikute kirjeldus üldistatud entroopiaindeksi (GE) mõõdiku. See mõõdik mõõdab kallutatust ilma tahkväärtust arvestamata ja võib olla abiks mudelivigade jaotumise hindamisel. Üksikasjade saamiseks vaadake Üldistatud entroopia (GE).

Järeldus

Selles postituses nägite, kuidas SageMaker Clarify 21 erinevat mõõdikut mõõdavad kallutatust ML-konveieri erinevatel etappidel. Sissetulekute prognoosimise kasutusjuhtumi kaudu õppisite tundma erinevaid mõõdikuid, kuidas oma kasutusjuhtumi jaoks mõõdikuid valida ja millistest võiks alustada.

Alustage oma vastutustundliku tehisintellekti teekonnaga, hinnates oma ML-mudelite eelarvamusi demomärkmiku abil Õiglus ja seletatavus SageMaker Clarify abil. SageMaker Clarify üksikasjaliku dokumentatsiooni, sealhulgas mõõdikute ametliku määratluse, leiate aadressilt Mis on masinõppe prognooside õiglus ja mudeli seletatavus. Kallutatuse mõõdikute avatud lähtekoodiga rakendamise kohta vaadake aws-sagemaker-clarify GitHubi hoidla. Üksikasjalikku arutelu, sealhulgas piiranguid, leiate aadressilt Amazoni tehisintellekti õigluse ja seletatavuse valge raamat.

Autoritest

Bilal Zafar on AWSi rakendusteadlane, kes tegeleb masinõppe õigluse, seletatavuse ja turvalisusega.

Bilal Zafar on AWSi rakendusteadlane, kes tegeleb masinõppe õigluse, seletatavuse ja turvalisusega.

Denis V. Batalov is a Solutions Architect for AWS, specializing in Machine Learning. He’s been with Amazon since 2005. Denis has a PhD in the field of AI. Follow him on Twitter: @dbatalov.

Michele Donini on AWS-i vanem rakendusteadlane. Ta juhib teadlaste meeskonda, kes tegeleb vastutustundliku tehisintellektiga ning tema uurimisvaldkonnad on algoritmiline õiglus ja seletatav masinõpe.

Michele Donini on AWS-i vanem rakendusteadlane. Ta juhib teadlaste meeskonda, kes tegeleb vastutustundliku tehisintellektiga ning tema uurimisvaldkonnad on algoritmiline õiglus ja seletatav masinõpe.

- AI

- ai kunst

- ai kunsti generaator

- on robot

- Amazon SageMaker

- tehisintellekti

- tehisintellekti sertifikaat

- tehisintellekt panganduses

- tehisintellekti robot

- tehisintellekti robotid

- tehisintellekti tarkvara

- AWS-i masinõpe

- blockchain

- plokiahela konverents ai

- coingenius

- vestluslik tehisintellekt

- krüptokonverents ai

- dall's

- sügav õpe

- google ai

- masinõpe

- Platon

- plato ai

- Platoni andmete intelligentsus

- Platoni mäng

- PlatoData

- platogaming

- skaala ai

- süntaks

- sephyrnet