See on AK Roy külalispostitus Qualcomm AI-st.

Amazon Elastic Compute Cloud (Amazon EC2) DL2q eksemplare, mida toidavad Qualcomm AI 100 Standard kiirendid, saab kasutada sügava õppimise (DL) töökoormuse kulutõhusaks juurutamiseks pilves. Neid saab kasutada ka Qualcommi seadmetes juurutatud DL-i töökoormuse jõudluse ja täpsuse arendamiseks ja kinnitamiseks. DL2q eksemplarid on esimesed, mis toovad Qualcommi tehisintelligentse (AI) tehnoloogia pilve.

Kaheksa Qualcomm AI 100 Standard kiirendi ja 128 GiB kiirendi kogumäluga saavad kliendid kasutada ka DL2q eksemplare populaarsete generatiivsete AI-rakenduste (nt sisu genereerimine, teksti kokkuvõte ja virtuaalsed assistendid) käitamiseks, aga ka klassikalisi AI-rakendusi loomuliku keele töötlemiseks. ja arvutinägemine. Lisaks on Qualcomm AI 100 kiirenditel sama AI-tehnoloogia, mida kasutatakse nutitelefonides, autonoomses juhtimises, personaalarvutites ja laiendatud reaalsusega peakomplektides, nii et DL2q-eksemplare saab enne kasutuselevõttu kasutada nende tehisintellekti töökoormuse arendamiseks ja kinnitamiseks.

Uued DL2q eksemplari esiletõstmised

Iga DL2q eksemplar sisaldab kaheksat Qualcomm Cloud AI100 kiirendit, mille koondjõudlus on üle 2.8 PetaOpsi Int8 järelduste jõudluse ja 1.4 PetaFlopi FP16 järelduste jõudluse. Eksemplaril on kokku 112 AI südamikku, kiirendi mälumaht 128 GB ja mälu ribalaius 1.1 TB sekundis.

Igal DL2q-i eksemplaril on 96 vCPU-d, süsteemimälu maht 768 GB ja see toetab võrgu ribalaiust 100 Gbps ja Amazon Elastic Block Store (Amazon EBS) salvestuskiirus 19 Gbps.

| Eksemplari nimi | vCPU-d | Cloud AI100 kiirendid | Kiirendi mälu | Kiirendi mälu BW (koond) | Juhtumi mälu | Eksemplaride võrgustik | Salvestus (Amazon EBS) ribalaius |

| DL2q.24xsuur | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Qualcomm Cloud AI100 kiirendi uuendus

Kiibil olev Cloud AI100 kiirendisüsteem (SoC) on spetsiaalselt loodud skaleeritav mitmetuumaline arhitektuur, mis toetab laia valikut süvaõppe kasutusjuhtumeid andmekeskusest servani. SoC kasutab skalaar-, vektor- ja tensorarvutussüdamike, mille valdkonna juhtiv on-die SRAM-i maht on 126 MB. Südamikud on omavahel ühendatud suure ribalaiusega väikese latentsusega kiibil (NoC) võrgusilmaga.

AI100 kiirendi toetab laia ja laia valikut mudeleid ja kasutusjuhtumeid. Allolev tabel toob esile mudeli toe ulatuse.

| Mudeli kategooria | Arv mudeleid | Näited |

| NLP | 157 | BERT, BART, FasterTransformer, T5, Z-kood MOE |

| Generatiivne AI – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| Generatiivne AI – pilt | 3 | Stabiilne difusioon v1.5 ja v2.1, OpenAI CLIP |

| CV – Piltide klassifikatsioon | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – objektide tuvastamine | 23 | YOLO v2, v3, v4, v5 ja v7, SSD-ResNet, RetinaNet |

| CV – muu | 15 | LPRnet, ülieraldusvõime/SRGAN, ByteTrack |

| Autode võrgud* | 53 | Taju ja LIDAR, jalakäija, sõidurada ja foorituvastus |

| Kokku | > 300 | |

* Enamik autotööstuse võrke on liitvõrgud, mis koosnevad üksikute võrkude liitmisest.

DL2q kiirendi suur sisseehitatud SRAM võimaldab tõhusalt rakendada täiustatud jõudlustehnikaid, nagu MX6 mikroeksponenti täpsus kaalude salvestamiseks ja MX9 mikroeksponenti täpsus kiirendi ja kiirendi vaheliseks suhtluseks. Mikroeksponenttehnoloogiat kirjeldatakse järgmises avatud arvutusprojekti (OCP) tööstusharu teadaandes: AMD, Arm, Intel, Meta, Microsoft, NVIDIA ja Qualcomm standardivad AI jaoks järgmise põlvkonna kitsaid täpseid andmevorminguid » Ava arvutusprojekt.

Eksemplari kasutaja saab kulupõhise toimivuse maksimeerimiseks kasutada järgmist strateegiat.

- Salvestage kaalud MX6 mikroeksponenti täpsusega kiirendi DDR-mällu. MX6 täpsuse kasutamine maksimeerib olemasoleva mälumahu ja mälu ribalaiuse ärakasutamist, et pakkuda oma klassi parimat läbilaskevõimet ja latentsust.

- Arvutage FP16-s, et tagada nõutav kasutusjuhtumi täpsus, kasutades samal ajal parimat kiibipõhist SRAM-i ja varu-TOP-sid kaardil, et rakendada suure jõudlusega madala latentsusega MX6 kuni FP16 tuumasid.

- Kasutage optimeeritud partii strateegiat ja suuremat partii suurust, kasutades saadaolevat suurt kiibil asuvat SRAM-i, et maksimeerida raskuste taaskasutamist, säilitades samal ajal maksimaalselt võimalikud aktiveerimised kiibil.

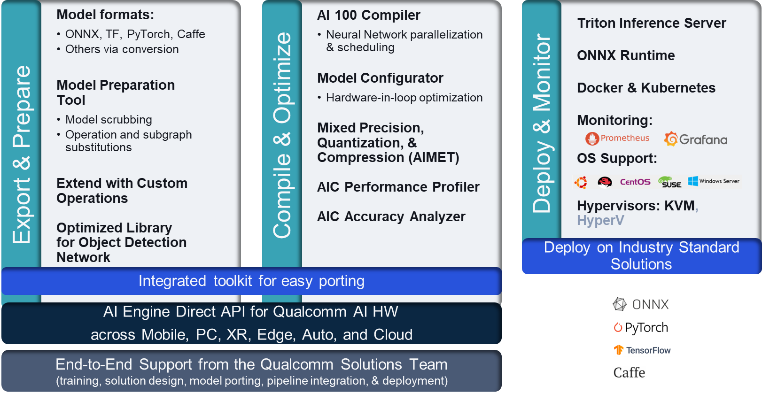

DL2q AI virn ja tööriistaahel

DL2q eksemplariga on kaasas Qualcomm AI Stack, mis pakub pilves ja teistes Qualcommi toodetes järjepidevat arendajakogemust kogu Qualcommi AI-s. Sama Qualcommi AI pinu ja baastehnoloogia töötab DL2q eksemplaridel ja Qualcomm edge seadmetes, pakkudes klientidele ühtset arendajakogemust koos ühtse API-ga kogu nende pilve-, auto-, personaalarvuti-, laiendatud reaalsuse ja nutitelefoni arenduskeskkondades.

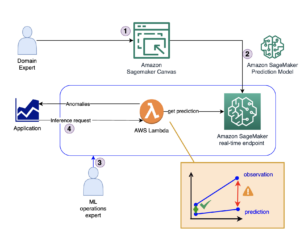

Tööriistaahel võimaldab eksemplari kasutajal kiiresti kasutusele võtta varem koolitatud mudeli, kompileerida ja optimeerida mudelit eksemplari võimaluste jaoks ning seejärel juurutada kompileeritud mudelid tootmise järelduste kasutusjuhtumite jaoks kolmes etapis, mis on näidatud järgmisel joonisel.

Mudeli jõudluse häälestamise kohta lisateabe saamiseks vaadake Cloud AI 100 peamised jõudlusparameetrid Dokumentatsioon.

Alustage DL2q eksemplaridega

Selles näites koostate ja juurutate eelkoolitatud BERT mudel Alates Kallistav nägu EC2 DL2q eksemplaril, kasutades eelehitatud saadaolevat DL2q AMI-d neljas etapis.

Võite kasutada kas eelnevalt ehitatud Qualcomm DLAMI või alustage Amazon Linux2 AMI-ga ja looge oma DL2q AMI platvormi Cloud AI 100 ja rakenduste SDK abil, mis on saadaval selles Amazon Simple Storage Service (Amazon S3) ämber: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

Järgmised sammud kasutavad eelehitatud DL2q AMI-d, Qualcomm Base AL2 DLAMI.

Kasutage SSH-d, et pääseda juurde oma DL2q eksemplarile Qualcomm Base AL2 DLAMI AMI abil ja järgige samme 1–4.

Samm 1. Seadistage keskkond ja installige vajalikud paketid

- Installige Python 3.8.

- Seadistage Python 3.8 virtuaalne keskkond.

- Aktiveerige Python 3.8 virtuaalne keskkond.

- Installige vajalikud paketid, mis on näidatud nõuded.txt dokument saadaval Qualcommi avalikul Githubi saidil.

- Importige vajalikud teegid.

Samm 2. Importige mudel

- Mudeli importimine ja märgistamine.

- Määratlege näidissisend ja ekstraheerige

inputIdsjaattentionMask. - Teisendage mudel ONNX-iks, mille saab seejärel kompilaatorisse edastada.

- Käitate mudelit FP16 täpsusega. Seega peate kontrollima, kas mudel sisaldab konstante väljaspool FP16 vahemikku. Andke mudel edasi

fix_onnx_fp16funktsioon uue ONNX-faili genereerimiseks koos vajalike parandustega.

Samm 3. Koostage mudel

. qaic-exec Mudeli koostamiseks kasutatakse käsurea liidese (CLI) kompilaatori tööriista. Selle kompilaatori sisendiks on etapis 2 loodud ONNX-fail. Kompilaator loob binaarfaili (nn. QPCJaoks Qualcommi programmi konteiner) määratud teel -aic-binary-dir argument.

Allolevas kompileerimiskäskluses kasutate mudeli kompileerimiseks nelja AI arvutustuuma ja ühe partii suurust.

QPC genereeritakse bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc kausta.

Samm 4. Käivitage mudel

Seadistage seanss, et käitada järeldusi Cloud AI100 Qualcommi kiirendis DL2q eksemplaris.

Qualcomm qaic Pythoni teek on API-de komplekt, mis toetab Cloud AI100 kiirendis järelduste käitamist.

- Seansi eksemplari loomiseks kasutage seansi API kutset. Seansi API kutse on qaic Pythoni teegi kasutamise sisenemispunkt.

- Restruktureerige väljundpuhvrist olevad andmed rakendusega

output_shapejaoutput_type. - Dekodeerige toodetud väljund.

Siin on sisendlause "Koer [MASK] matil" väljundid.

See on kõik. Vaid mõne sammuga kompileerisite ja käitasite PyTorchi mudeli Amazon EC2 DL2q eksemplaris. Lisateavet DL2q-eksemplari mudelite kasutuselevõtu ja kompileerimise kohta leiate aadressilt Cloud AI100 õpetuse dokumentatsioon.

Lisateavet selle kohta, millised DL-mudelite arhitektuurid sobivad hästi AWS DL2q-juhtumite ja praeguse mudeli tugimaatriksi jaoks, vaadake Qualcomm Cloud AI100 dokumentatsioon.

Nüüd saadaval

Saate täna käivitada DL2q eksemplare USA lääneosas (Oregon) ja Euroopas (Frankfurt) AWS-i piirkondades Nõudlusel, Reserveeritudja Kohtjuhtumidvõi osana a Säästuplaan. Nagu Amazon EC2 puhul tavaliselt, maksate ainult selle eest, mida kasutate. Lisateabe saamiseks vt Amazon EC2 hinnakujundus.

DL2q eksemplare saab juurutada kasutades AWS-i süvaõppe AMI-d (DLAMI)ja konteineri kujutised on saadaval hallatavate teenuste kaudu, nagu Amazon SageMaker, Amazon Elastic Kubernetes Service (Amazon EKS), Amazon Elastic Container Service (Amazon ECS)ja AWS ParallelCluster.

Lisateabe saamiseks külastage veebilehte Amazon EC2 DL2q eksemplar lehele ja saatke tagasisidet aadressile AWS re:Postitus EC2 jaoks või tavaliste AWS-i tugikontaktide kaudu.

Autoritest

AK Roy on Qualcommi pilve- ja andmekeskuse AI toodete ja lahenduste tootehalduse direktor. Tal on üle 20-aastane kogemus tootestrateegia ja -arenduse vallas, keskendudes praegu oma klassi parimatele jõudlusele ja jõudlusele / $ otsast lõpuni lahendustele tehisintellekti järelduste tegemiseks pilves, mitmesuguste kasutusjuhtude jaoks, sealhulgas GenAI, LLM-id, automaatne ja hübriid-AI.

AK Roy on Qualcommi pilve- ja andmekeskuse AI toodete ja lahenduste tootehalduse direktor. Tal on üle 20-aastane kogemus tootestrateegia ja -arenduse vallas, keskendudes praegu oma klassi parimatele jõudlusele ja jõudlusele / $ otsast lõpuni lahendustele tehisintellekti järelduste tegemiseks pilves, mitmesuguste kasutusjuhtude jaoks, sealhulgas GenAI, LLM-id, automaatne ja hübriid-AI.

Jianying Lang on AWS Worldwide Specialist Organisation (WWSO) peamine lahenduste arhitekt. Tal on üle 15-aastane töökogemus HPC ja AI valdkonnas. AWS-is keskendub ta sellele, et aidata klientidel kiirendatud andmetöötluseksemplaridel oma AI/ML töökoormust juurutada, optimeerida ja skaleerida. Ta on kirglik HPC ja AI valdkondade tehnikate kombineerimise vastu. Jianyingil on Boulderi Colorado ülikoolis doktorikraad arvutusfüüsikas.

Jianying Lang on AWS Worldwide Specialist Organisation (WWSO) peamine lahenduste arhitekt. Tal on üle 15-aastane töökogemus HPC ja AI valdkonnas. AWS-is keskendub ta sellele, et aidata klientidel kiirendatud andmetöötluseksemplaridel oma AI/ML töökoormust juurutada, optimeerida ja skaleerida. Ta on kirglik HPC ja AI valdkondade tehnikate kombineerimise vastu. Jianyingil on Boulderi Colorado ülikoolis doktorikraad arvutusfüüsikas.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :on

- :on

- $ UP

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15 aastat

- 15%

- 17

- 19

- 20

- 20 aastat

- 22

- 23

- 7

- 75

- 8

- 84

- a

- MEIST

- üle

- kiirendatud

- kiirendi

- kiirendid

- juurdepääs

- lisatud

- täpsus

- üle

- aktiveerimised

- Lisaks

- edasijõudnud

- agregaat

- AI

- AI / ML

- Materjal: BPA ja flataatide vaba plastik

- Ka

- Amazon

- Amazon EC2

- Amazon Web Services

- an

- ja

- Teadaanne

- mistahes

- API

- API-liidesed

- rakendused

- apps

- arhitektuur

- OLEME

- argument

- ARM

- kunstlik

- AS

- assistendid

- At

- auto

- auto

- autonoomne

- saadaval

- AWS

- TELGED

- Bandwidth

- baas

- BE

- enne

- alla

- Peale

- BIN

- Blokeerima

- Õitsema

- tooma

- lai

- puhver

- ehitama

- by

- helistama

- kutsutud

- CAN

- võimeid

- Võimsus

- kaart

- juhul

- kontrollima

- klassika

- Cloud

- Colorado

- kombineerimine

- KOMMUNIKATSIOON

- terviklik

- arvutuslik

- Arvutama

- arvuti

- Arvuti visioon

- arvutid

- arvutustehnika

- järjepidev

- Koosneb

- sidemed

- Konteiner

- sisaldab

- sisu

- Sisu genereerimine

- looma

- Praegune

- Kliendid

- andmed

- Datacenter

- sügav

- sügav õpe

- määratletud

- Kraad

- tarnima

- annab

- juurutada

- lähetatud

- kasutuselevõtu

- kirjeldatud

- arendama

- arendaja

- & Tarkvaraarendus

- seade

- seadmed

- Diffusion

- Juhataja

- dokumentatsioon

- koer

- sõidu

- dünaamiline

- serv

- tõhus

- kumbki

- töötab

- võimaldab

- Lõpuks-lõpuni

- kanne

- keskkond

- keskkondades

- Euroopa

- näide

- kogemus

- laiendatud reaalsus

- väljavõte

- vale

- tunnusjoon

- tagasiside

- vähe

- väli

- Valdkonnad

- Joonis

- fail

- esimene

- sobima

- Keskenduma

- keskendub

- järgima

- Järel

- eest

- avastatud

- neli

- Frankfurt

- Alates

- funktsioon

- fusioon

- üldiselt

- tekitama

- loodud

- põlvkond

- generatiivne

- Generatiivne AI

- GitHub

- antud

- hea

- külaline

- Külaline Postitus

- he

- kõrvaklapid

- aidates

- siin

- suur jõudlus

- rohkem

- rõhutab

- omab

- hpc

- HTML

- HTTPS

- hübriid

- i

- idx

- if

- pilt

- pildid

- rakendada

- täitmine

- import

- in

- Kaasa arvatud

- sisaldab

- eraldi

- tööstus

- juhtivad

- info

- sisend

- paigaldama

- Näiteks

- Intel

- Intelligentne

- omavahel seotud

- Interface

- IT

- jpg

- lihtsalt

- Võti

- Sõidurada

- keel

- suur

- Hilinemine

- algatama

- Õppida

- õppimine

- raamatukogud

- Raamatukogu

- valgus

- joon

- saadetised

- juhitud

- juhtimine

- mask

- maatriks

- max

- Maksimeerima

- maksimeerib

- maksimaalne

- Mälu

- silma

- Meta

- Microsoft

- minutit

- mudel

- mudelid

- modifitseeritud

- rohkem

- kõige

- nimi

- kitsas

- Natural

- Natural Language Processing

- vajalik

- Vajadus

- võrk

- võrgustike loomine

- võrgustikud

- Uus

- järgmise põlvkonna

- nüüd

- tuim

- Nvidia

- objekt

- of

- on

- Pardal

- Pardal

- ONE

- ainult

- avatud

- OpenAI

- optimeerima

- optimeeritud

- or

- Oregon

- organisatsioon

- OS

- Muu

- välja

- väljund

- väljundid

- üle

- enda

- pakette

- lehekülg

- osa

- sooritama

- Vastu võetud

- kirglik

- tee

- Maksma

- kohta

- jõudlus

- isiklik

- phd

- Füüsika

- inimesele

- Platon

- Platoni andmete intelligentsus

- PlatoData

- Punkt

- populaarne

- võimalik

- post

- sisse

- Täpsus

- varem

- Peamine

- töötlemine

- Toodetud

- toodab

- Toode

- tootehaldus

- Produktsioon

- Toodet

- Programm

- projekt

- annab

- pakkudes

- avalik

- Python

- pütorch

- qualcomm

- kiiresti

- valik

- RE

- Lugemine

- Reaalsus

- piirkondades

- nõutav

- Nõuded

- säilitamine

- tagasipöördumine

- taaskasutada

- Roy

- jooks

- jooksmine

- jookseb

- sama

- Säästa

- säästmine

- skaalautuvia

- Skaala

- SDK

- Teine

- vaata

- saatma

- Lause

- Jada

- teenus

- Teenused

- istung

- komplekt

- ta

- näidatud

- lihtne

- lihtsustama

- site

- SUURUS

- nutikas telefon

- nutitelefonid

- So

- Lahendused

- Pinge

- spetsialist

- Kestab

- standard

- algus

- alustatud

- Samm

- Sammud

- ladustamine

- salvestada

- ladustamine

- Strateegia

- Järgnevalt

- selline

- parem

- toetama

- Toetamine

- Toetab

- Sys

- süsteem

- tabel

- tehnikat

- Tehnoloogia

- tekst

- et

- .

- oma

- SIIS

- Need

- nad

- see

- kolm

- Läbi

- läbilaskevõime

- läbi

- et

- täna

- märkima

- tööriist

- tops

- tõrvik

- Summa

- liiklus

- koolitatud

- trafod

- tõsi

- häälestamine

- juhendaja

- ühtne

- Ülikool

- us

- kasutama

- kasutage juhtumit

- kasutamise juhtumid

- Kasutatud

- Kasutaja

- kasutamine

- tavaline

- v1

- KINNITAGE

- väärtus

- virtuaalne

- nägemus

- visiit

- we

- web

- veebiteenused

- Hästi

- Läände

- M

- mis

- kuigi

- lai

- Lai valik

- will

- koos

- sõna

- töö

- ülemaailmne

- aastat

- sa

- Sinu

- sephyrnet