Videomängude tööstuses on hinnanguliselt üle 3 miljardi kasutaja kogu maailmas1. See koosneb tohutul hulgal mängijatest, kes suhtlevad üksteisega praktiliselt iga päev. Kahjuks, nagu pärismaailmas, ei suhtle kõik mängijad asjakohaselt ja lugupidavalt. Püüdes luua ja säilitada sotsiaalselt vastutustundlikku mängukeskkonda, paluti AWS Professional Services luua mehhanism, mis tuvastab võrgumängijaga suhtlemisel sobimatu keele (toksilise kõne). Üldine äritulemus oli parandada organisatsiooni tegevust, automatiseerides olemasoleva käsitsi protsessi ja parandada kasutajakogemust, suurendades mängijatevahelise sobimatu suhtluse tuvastamise kiirust ja kvaliteeti, edendades lõpuks puhtamat ja tervislikumat mängukeskkonda.

Kliendi soov oli luua inglise keele detektor, mis liigitab hääle ja teksti väljavõtted nende enda kohandatud mürgiste keelte kategooriatesse. Nad soovisid esmalt kindlaks teha, kas antud keeleväljavõte on mürgine, ja seejärel liigitada väljavõtte konkreetsesse kliendi määratletud mürgisuse kategooriasse, nagu roppused või solvav keel.

AWS ProServe lahendas selle kasutusjuhtumi Generative AI Innovation Center (GAIIC) ja ProServe ML Delivery Team (MLDT) ühiste jõupingutustega. AWS GAIIC on AWS ProServe'i grupp, mis ühendab kliendid ekspertidega, et töötada välja generatiivseid AI-lahendusi paljude äriliste kasutusjuhtude jaoks, kasutades kontseptsiooni tõendi (PoC) konstruktsioone. Seejärel viib AWS ProServe MLDT PoC läbi tootmise, skaleerides, tugevdades ja integreerides lahenduse kliendi jaoks.

Seda kliendi kasutusjuhtumit tutvustatakse kahes eraldi postituses. See postitus (1. osa) on sügav sukeldumine teaduslikku metoodikasse. See selgitab lahenduse taga olevat mõtlemisprotsessi ja eksperimenteerimist, sealhulgas mudeli koolitus- ja arendusprotsessi. 2. osas süvenetakse tootmislahendusse, selgitatakse disainiotsuseid, andmevoogu ning mudeli koolituse ja juurutamise arhitektuuri illustreerimist.

See postitus hõlmab järgmisi teemasid:

- Väljakutsed, mille AWS ProServe pidi selle kasutusjuhtumi puhul lahendama

- Ajalooline kontekst suurte keelemudelite (LLM) kohta ja selle kohta, miks see tehnoloogia selle kasutusjuhtumi jaoks ideaalselt sobib

- AWS GAIICi PoC ja AWS ProServe MLDT lahendus andmeteaduse ja masinõppe (ML) vaatenurgast

Andmete väljakutse

Peamine väljakutse, millega AWS ProServe toksilise keeleklassifikaatori koolitamisel silmitsi seisis, oli saada kliendilt piisavalt märgistatud andmeid, et koolitada nullist täpne mudel. AWS sai kliendilt umbes 100 märgistatud andmete näidist, mis on palju vähem kui 1,000 näidist, mida soovitati LLM-i peenhäälestamiseks andmeteaduse kogukonnas.

Täiendava loomupärase väljakutsena on loomuliku keele töötlemise (NLP) klassifikaatorid ajalooliselt teadaolevalt väga kulukad ja nõuavad suurt hulka sõnavara, mida nimetatakse korpus, et teha täpseid ennustusi. Range ja tõhus NLP-lahendus oleks piisava hulga märgistatud andmete korral kohandatud keelemudeli koolitamine kliendi märgistatud andmete abil. Mudelit treenitakse ainult mängijate mängusõnavaraga, muutes selle kohandatud vastavalt mängudes kasutatavale keelele. Kliendil olid nii kulu- kui ka ajapiirangud, mis muutsid selle lahenduse elujõuliseks. AWS ProServe oli sunnitud leidma lahenduse täpse keele toksilisuse klassifikaatori koolitamiseks suhteliselt väikese märgistatud andmekogumiga. Lahendus peitus selles, mida nimetatakse ülekandmisõpe.

Ülekandeõppe idee on kasutada eelkoolitatud mudeli teadmisi ja rakendada neid erineva, kuid suhteliselt sarnase probleemi puhul. Näiteks kui kujutise klassifikaatorit õpetati ennustama, kas pilt sisaldab kassi, võite kasutada teadmisi, mille mudel omandas koolituse käigus, et ära tunda teisi loomi, näiteks tiigreid. Selle keelekasutusjuhtumi jaoks pidi AWS ProServe leidma eelnevalt koolitatud keeleklassifikaatori, mis oli koolitatud tuvastama mürgist keelt ja seda kliendi märgistatud andmete abil peenhäälestama.

Lahendus oli mürgise keele klassifitseerimiseks LLM-i leidmine ja viimistlemine. LLM-id on närvivõrgud, mida on koolitatud suure hulga, tavaliselt miljardite suuruste parameetrite abil, kasutades märgistamata andmeid. Enne AWS-i lahendusega tutvumist antakse järgmises jaotises ülevaade LLM-ide ajaloost ja nende ajaloolistest kasutusjuhtudest.

LLM-ide võimsuse ärakasutamine

LLM-idest on hiljuti saanud ML-i uusi rakendusi otsivate ettevõtete keskpunkt, sest ChatGPT saavutas avalikkuse tähelepanu, olles ajaloos kõige kiiremini kasvav tarbijarakendus.2, jõudes 100. aasta jaanuariks 2023 miljoni aktiivse kasutajani, vaid 2 kuud pärast selle avaldamist. LLM-id pole aga ML-ruumis uus tehnoloogia. Neid on laialdaselt kasutatud NLP-ülesannete täitmiseks, nagu sentimentide analüüsimine, korpuste kokkuvõtte tegemine, märksõnade eraldamine, kõne tõlkimine ja teksti klassifitseerimine.

Teksti järjestikuse olemuse tõttu olid korduvad närvivõrgud (RNN-d) olnud NLP-modelleerimise tipptasemel. Täpsemalt, kodeerija-dekooder võrguarhitektuur formuleeriti, kuna see lõi RNN-struktuuri, mis on võimeline võtma suvalise pikkusega sisendi ja genereerima suvalise pikkusega väljundit. See oli ideaalne NLP-ülesannete jaoks, nagu tõlkimine, kus ühe keele väljundfraasi oli võimalik ennustada teise keele sisendfraasi põhjal, tavaliselt sisendis ja väljundis erinev sõnade arv. Trafo arhitektuur3 (Vaswani, 2017) oli kodeerija-dekoodri läbimurdeline täiustus; see tutvustas mõistet enese tähelepanu, mis võimaldas mudelil keskenduda sisend- ja väljundfraaside erinevatele sõnadele. Tüüpilises kodeerija-dekooderis tõlgendab mudel iga sõna identsel viisil. Kuna mudel töötleb järjestikku iga sisendfraasi sõna, võib alguses olev semantiline teave fraasi lõpuks kaduda. Enesetähelepanu mehhanism muutis seda, lisades tähelepanukihi nii kodeerija kui ka dekoodri plokki, et mudel saaks väljundfraasis teatud sõna genereerimisel panna sisendfraasist teatud sõnadele erinevad kaalud. Nii sündis trafo mudeli alus.

Trafo arhitektuur oli aluseks kahele tänapäeval kõige tuntumale ja populaarsemale LLM-ile, kahesuunalisele kodeerija esindustele transformaatoritelt (BERT).4 (Radford, 2018) ja generatiivne eelkoolitatud transformer (GPT)5 (Devlin 2018). GPT mudeli hilisemad versioonid, nimelt GPT3 ja GPT4, on mootor, mis toidab ChatGPT rakendust. Retsepti viimane osa, mis muudab LLM-id nii võimsaks, on võime destilleerida teavet tohututest tekstikorpustest ilma ulatusliku märgistamise või eeltöötlemiseta protsessi nimega ULMFiT. Sellel meetodil on eelkoolitusfaas, kus saab kokku koguda üldteksti ja mudelit koolitatakse eelmiste sõnade põhjal järgmise sõna ennustamiseks; Siin on eeliseks see, et igasugune koolituseks kasutatav sisendtekst on oma olemuselt teksti järjekorra alusel eelsildistatud. LLM-id on tõesti võimelised õppima Interneti-mastaabis andmetest. Näiteks algne BERT-mudel oli eelkoolitatud BookCorpuse ja tervete ingliskeelsete Vikipeedia tekstiandmekogumitega.

See uus modelleerimisparadigma on toonud kaasa kaks uut kontseptsiooni: alusmudelid (FM-id) ja generatiivne AI. Erinevalt mudeli nullist koolitamisest ülesandespetsiifiliste andmetega, mis on tavaline klassikalise juhendatud õppe puhul, on LLM-id eelkoolitatud, et ammutada üldteadmisi laia teksti andmestikust, enne kui neid kohandatakse konkreetsete ülesannete või palju väiksema mahuga domeenidega. andmestik (tavaliselt sadade proovide suurusjärgus). Uus ML-i töövoog algab nüüd eelkoolitatud mudeliga, mida nimetatakse vundamendimudeliks. Oluline on rajada õigele vundamendile ning valikuvõimalusi, näiteks uusi, on järjest rohkem Amazon Titan FM-id, mille AWS avaldab osana Amazonase aluspõhi. Neid uusi mudeleid peetakse ka generatiivseteks, kuna nende väljundid on inimesele tõlgendatavad ja sisendandmetega samas andmetüübis. Kui varasemad ML-mudelid olid kirjeldavad, näiteks kasside ja koerte kujutiste klassifitseerimine, siis LLM-id on generatiivsed, kuna nende väljundiks on järgmine sisendsõnadel põhinev sõnade komplekt. See võimaldab neil toita interaktiivseid rakendusi, nagu ChatGPT, mis võivad olla nende loodud sisus väljendusrikkad.

Hugging Face on teinud koostööd AWS-iga demokratiseerida FM-id ning muuta need hõlpsasti juurdepääsetavaks ja nendega koostamiseks lihtsaks. Hugging Face on loonud a Transformers API mis ühendab rohkem kui 50 erinevat trafoarhitektuuri erinevatel ML-raamistikel, sealhulgas juurdepääsu eelkoolitatud mudelikaaludele nendes Mudel Hub, mis on selle postituse kirjutamise seisuga kasvanud üle 200,000 XNUMX mudelini. Järgmistes osades uurime kontseptsiooni tõestust, lahendust ja FM-e, mida testiti ja valiti selle kliendi jaoks mürgise kõne klassifikatsiooni kasutusjuhtumi lahendamiseks.

AWS GAIIC kontseptsiooni tõend

AWS GAIIC otsustas katsetada BERT-i arhitektuuriga LLM-i alusmudeleid, et täpsustada mürgist keeleklassifikaatorit. Kokku testiti kolme Hugging Face'i mudelikeskuse mudelit:

Kõik kolm mudeliarhitektuuri põhinevad BERTweet arhitektuur. BERTweet on koolitatud selle põhjal RoBERTa koolituseelne protseduur. RoBERTa eeltreeningu protseduur on BERT-i eelkoolituse replikatsiooniuuringu tulemus, milles hinnati hüperparameetrite häälestamise ja treeningkomplekti suuruse mõju, et parandada BERT-mudelite treenimise retsepti.6 (Liu 2019). Katse eesmärk oli leida eelkoolitusmeetod, mis parandas BERTi jõudlust ilma selle aluseks olevat arhitektuuri muutmata. Uuringu järeldusest leiti, et järgmised koolituseelsed muudatused parandasid oluliselt BERTi jõudlust:

- Suuremate partiidega mudeli koolitamine rohkemate andmete saamiseks

- Järgmise lause ennustamise eesmärgi eemaldamine

- Treening pikematel jadadel

- Treeningandmetele rakendatud maskeerimismustri dünaamiline muutmine

Bertweeti baasmudel kasutab eelnevat RoBERTa uuringu eelkoolitusprotseduuri, et koolitada BERT-i algne arhitektuur, kasutades 850 miljonit ingliskeelset säutsu. See on esimene avalik suuremahuline keelemudel, mis on ingliskeelsete säutsude jaoks eelkoolitatud.

Eelnevalt koolitatud säutse kasutavad FM-id arvati sobivat kasutusjuhtumiga kahel peamisel teoreetilisel põhjusel:

- Säutsu pikkus on väga sarnane võrgumänguvestlustes leiduva sobimatu või mürgise fraasi pikkusega

- Tweetid pärinevad suure hulga erinevate kasutajatega elanikkonnalt, mis on sarnased mänguplatvormidel leiduva elanikkonna omaga

AWS otsustas algtaseme saamiseks esmalt BERTweeti kliendi märgistatud andmetega täpsustada. Seejärel otsustas peenhäälestada veel kahte FM-i bertweet-base-offensive ja bertweet-base-hate-s, mis olid potentsiaalselt suurema täpsuse saavutamiseks spetsiaalselt välja õpetatud spetsiaalselt asjakohasemate mürgiste säutsude jaoks. Bertweet-base-ründemudel kasutab BertTweet FM-i baasi ja on täiendavalt koolitatud 14,100 XNUMX kommenteeritud säutsiga, mida peeti solvavaks.7 (Zampieri 2019). Bertweet-base-vihamudel kasutab ka põhilist BertTweet FM-i, kuid on täiendavalt koolitatud 19,600 XNUMX vihakõneks peetud säutsu kohta.8 (Basiili 2019).

PoC mudeli jõudluse edasiseks parandamiseks tegi AWS GAIIC kaks disainiotsust:

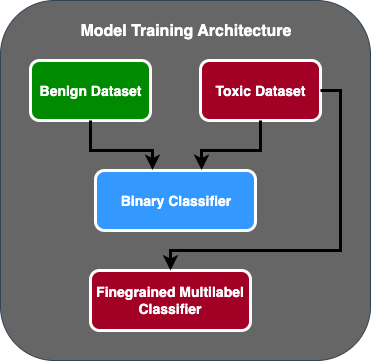

- Loodud kaheastmeline ennustusvoog, kus esimene mudel toimib binaarse klassifikaatorina, mis klassifitseerib, kas tekstiosa on mürgine või mitte. Teine mudel on peeneteraline mudel, mis liigitab teksti kliendi määratletud mürgitüüpide alusel. Ainult siis, kui esimene mudel ennustab teksti mürgiseks, edastatakse see teisele mudelile.

- Täiendas treeninguandmeid ja lisas avaliku Kaggle'i võistluse kolmanda osapoole märgistatud toksilise teksti andmestiku alamhulga (Pusle mürgisus) kliendilt saadud 100 originaalproovile. Nad kaardistasid pusle sildid seotud kliendi määratletud toksilisuse märgistega ja jagasid mudeli kinnitamiseks 80% treeningandmetena ja 20% katseandmetena.

Kasutatud AWS GAIIC Amazon SageMaker märkmikud oma peenhäälestuskatsete läbiviimiseks ja leidsid, et bertweet-base-ründemudel saavutas valideerimiskomplekti parimad tulemused. Järgmises tabelis on vaadeldud mõõdikute hinded kokku võetud.

| MUDEL | Täpsus | Tagasikutsumine | F1 | AUC |

| Binaarne | . 92 | . 90 | . 91 | . 92 |

| Peeneteraline | . 81 | . 80 | . 81 | . 89 |

Sellest hetkest alates andis GAIIC PoC-i üle AWS ProServe ML-i tarnemeeskonnale, et PoC toota.

AWS ProServe ML Delivery Team lahendus

Mudeliarhitektuuri tootmiseks palus klient AWS ProServe ML Delivery Teamil (MLDT) luua skaleeritav ja hõlpsasti hooldatav lahendus. Kaheetapilisel mudelil oli mõned hooldusprobleemid:

- Mudelid nõuaksid kahekordset mudeliseiret, mis muudab ümberõppe ajastuse ebajärjekindlaks. Võib juhtuda, et ühte mudelit tuleb sagedamini ümber õpetada kui teist.

- Kahe mudeli käitamise kulud suurenevad ühe mudeli asemel.

- Järeldamise kiirus aeglustub, kuna järeldus läbib kahte mudelit.

Nende väljakutsetega tegelemiseks pidi AWS ProServe MLDT välja mõtlema, kuidas muuta kaheastmeline mudeliarhitektuur ühtseks mudeliarhitektuuriks, säilitades samal ajal kaheastmelise arhitektuuri täpsuse.

Lahenduseks oli esmalt küsida kliendilt rohkem treeninguandmeid, seejärel viimistleda bertweet-base-rüvetav mudel kõikidel siltidel, sealhulgas mittetoksilistel näidistel, üheks mudeliks. Idee seisnes selles, et ühe mudeli peenhäälestamine rohkemate andmetega annaks sarnaseid tulemusi kui kaheetapilise mudeliarhitektuuri peenhäälestus vähematel andmetel. Kaheastmelise mudeliarhitektuuri viimistlemiseks värskendas AWS ProServe MLDT eelkoolitatud mudeli mitmemärgise klassifikatsioonipead, et lisada üks lisasõlm, mis esindab mittetoksilist klassi.

Järgmine on koodinäidis selle kohta, kuidas viimistleksite Hugging Face mudelijaoturi eelkoolitatud mudelit, kasutades nende trafode platvormi, ja muudate mudeli mitme märgistusega klassifitseerimispead, et ennustada soovitud klasside arvu. AWS ProServe MLDT kasutas seda kavandit peenhäälestuse alusena. See eeldab, et teil on rongiandmed ja valideerimisandmed valmis ja õiges sisendvormingus.

Esiteks imporditakse Hugging Face mudelikeskusest Pythoni moodulid ja soovitud eelkoolitatud mudel:

Seejärel laaditakse eelkoolitatud mudel ja valmistatakse peenhäälestamiseks ette. See on samm, kus määratakse mürgiste kategooriate arv ja kõik mudeli parameetrid:

Mudeli peenhäälestus algab koolitus- ja valideerimisandmekogumite teede sisestamisega:

AWS ProServe MLDT sai veel umbes 5,000 märgistatud andmeproovi, millest 3,000 olid mittetoksilised ja 2,000 mürgised, ning viimistles kõik kolm bertweeti baasmudelit, ühendades kõik sildid üheks mudeliks. Nad kasutasid neid andmeid lisaks 5,000 PoC proovile, et täpsustada uusi üheastmelisi mudeleid, kasutades sama 80% rongikomplekti ja 20% katsekomplekti meetodit. Järgmine tabel näitab, et tulemuslikkuse hinded olid võrreldavad kaheetapilise mudeli tulemustega.

| MUDEL | Täpsus | Tagasikutsumine | F1 | AUC |

| bertweet-base (1-etapp) | . 76 | . 72 | . 74 | . 83 |

| bertweet-base-hate (1-etapp) | . 85 | . 82 | . 84 | . 87 |

| bertweet-base-offensive (1-etapp) | . 88 | . 83 | . 86 | . 89 |

| bertweet-base-offensive (2-etapp) | . 91 | . 90 | . 90 | . 92 |

Üheastmelise mudeli lähenemisviisiga saavutati kulude ja hoolduse täiustused, vähendades samal ajal täpsust vaid 3%. Pärast kompromisside kaalumist valis klient üheetapilise mudeli tootmiseks AWS ProServe MLDT.

Peenhäälestades üht mudelit rohkem märgistatud andmetega, suutis AWS ProServe MLDT pakkuda lahenduse, mis vastas kliendi mudeli täpsuse künnisele, samuti täitis nende nõudmised hoolduse lihtsuse osas, vähendades samal ajal kulusid ja suurendades töökindlust.

Järeldus

Suur mänguklient otsis võimalust avastada oma suhtluskanalites mürgist keelt, et edendada sotsiaalselt vastutustundlikku mängukeskkonda. AWS GAIIC lõi mürgise keeledetektori PoC, viimistledes LLM-i mürgise keele tuvastamiseks. Seejärel värskendas AWS ProServe MLDT mudelitreeningu voogu kaheetapilise lähenemisviisi asemel üheetapilisele lähenemisviisile ja valmistas LLM-i kliendi jaoks mastaapseks kasutamiseks.

Selles postituses demonstreerib AWS LLM-i peenhäälestamise tõhusust ja praktilisust selle kliendi kasutusjuhtumi lahendamiseks, jagab konteksti alusmudelite ja LLM-ide ajaloo kohta ning tutvustab töövoogu AWS Generative AI Innovation Centeri ja AWS ProServe ML vahel. Kohaletoimetamise meeskond. Selle seeria järgmises postituses sukeldume sügavamale sellesse, kuidas AWS ProServe MLDT valmistas SageMakeri abil saadud üheetapilise mudeli.

Kui olete huvitatud koostööst AWS-iga generatiivse AI lahenduse loomiseks, võtke ühendust aadressil GAIIC. Nad hindavad teie kasutusjuhtumit, koostavad generatiivsel tehisintellektil põhineva kontseptsiooni tõendi ja neil on võimalused laiendada koostööd AWS-iga, et rakendada saadud PoC tootmisse.

viited

- Mängijate demograafia: faktid ja statistika maailma kõige populaarsema hobi kohta

- ChatGPT püstitas kõige kiiremini kasvava kasutajaskonna rekordi – analüütiku märkus

- Vaswani et al., "Tähelepanu on kõik, mida vajate"

- Radford et al., "Keelemõistmise parandamine generatiivse eelkoolituse abil"

- Devlin et al., "BERT: kahesuunaliste sügavate transformaatorite eelkoolitus keele mõistmiseks"

- Yinhan Liu et al., "RoBERTa: tugevalt optimeeritud BERTi eelkoolitusmeetod"

- Marcos Zampieri jt, „SemEval-2019 6. ülesanne: solvava keele tuvastamine ja kategoriseerimine sotsiaalmeedias (OffensEval)”

- Valerio Basile jt, „SemEval-2019 ülesanne 5: sisserändajate ja naiste vastu suunatud vihakõne mitmekeelne tuvastamine Twitteris”

Autoritest

James Poquiz on Californias Orange'i maakonnas asuv AWS-i professionaalsete teenuste andmeteadlane. Tal on arvutiteaduse bakalaureusekraad California ülikoolist Irvine'is ja tal on mitmeaastane andmevaldkonnas töötamise kogemus, olles mänginud palju erinevaid rolle. Täna töötab ta skaleeritavate ML-lahenduste juurutamise ja juurutamisega, et saavutada AWS-i klientide jaoks äritulemusi.

James Poquiz on Californias Orange'i maakonnas asuv AWS-i professionaalsete teenuste andmeteadlane. Tal on arvutiteaduse bakalaureusekraad California ülikoolist Irvine'is ja tal on mitmeaastane andmevaldkonnas töötamise kogemus, olles mänginud palju erinevaid rolle. Täna töötab ta skaleeritavate ML-lahenduste juurutamise ja juurutamisega, et saavutada AWS-i klientide jaoks äritulemusi.

Han mees on andmeteaduse ja masinõppe vanemjuht koos AWS-i professionaalsete teenustega, mis asub San Diegos, CA. Tal on Northwesterni ülikooli inseneriteaduste doktorikraad ja mitmeaastane kogemus juhtimiskonsultandina, kes nõustab kliente tootmise, finantsteenuste ja energeetika vallas. Täna töötab ta kirglikult koos võtmeklientidega erinevatest tööstusharudest, et arendada ja rakendada AWS-is ML- ja GenAI lahendusi.

Han mees on andmeteaduse ja masinõppe vanemjuht koos AWS-i professionaalsete teenustega, mis asub San Diegos, CA. Tal on Northwesterni ülikooli inseneriteaduste doktorikraad ja mitmeaastane kogemus juhtimiskonsultandina, kes nõustab kliente tootmise, finantsteenuste ja energeetika vallas. Täna töötab ta kirglikult koos võtmeklientidega erinevatest tööstusharudest, et arendada ja rakendada AWS-is ML- ja GenAI lahendusi.

Safa Tinaztepe on AWS-i professionaalsete teenustega täielik andmeteadlane. Tal on Emory ülikooli arvutiteaduse bakalaureusekraad ja ta on huvitatud MLO-de, hajutatud süsteemide ja web3 vastu.

Safa Tinaztepe on AWS-i professionaalsete teenustega täielik andmeteadlane. Tal on Emory ülikooli arvutiteaduse bakalaureusekraad ja ta on huvitatud MLO-de, hajutatud süsteemide ja web3 vastu.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Autod/elektrisõidukid, Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- BlockOffsets. Keskkonnakompensatsiooni omandi ajakohastamine. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/aws-performs-fine-tuning-on-a-large-language-model-llm-to-classify-toxic-speech-for-a-large-gaming-company/

- :on

- :on

- :mitte

- : kus

- 000

- 1

- 100

- 14

- 16

- 19

- 200

- 2017

- 2018

- 2019

- 2023

- 50

- 7

- a

- võime

- Võimalik

- MEIST

- juurdepääs

- täpsus

- täpne

- Saavutada

- saavutada

- aktiivne

- õigusaktid

- lisatud

- lisades

- lisamine

- aadress

- nõustamine

- pärast

- vastu

- AI

- AL

- Materjal: BPA ja flataatide vaba plastik

- lubatud

- võimaldab

- Ka

- Amazon

- Amazon Web Services

- summa

- summad

- an

- analüütik

- analüüsides

- ja

- loomad

- Teine

- mistahes

- taotlus

- rakendused

- rakendatud

- kehtima

- lähenemine

- asjakohaselt

- umbes

- arhitektuur

- OLEME

- argumendid

- Kunst

- AS

- hinnata

- seotud

- oletab

- At

- tähelepanu

- automatiseerimine

- AWS

- AWS-i professionaalsed teenused

- baas

- põhineb

- Baseline

- alus

- BE

- sest

- muutuma

- olnud

- enne

- Algus

- taga

- on

- alla

- kasu

- BEST

- vahel

- suurem

- Miljard

- miljardeid

- Blokeerima

- sündinud

- mõlemad

- läbimurre

- lai

- ehitama

- Ehitab

- äri

- ettevõtted

- kuid

- by

- CA

- California

- kutsutud

- CAN

- võimeline

- pildistatud

- juhul

- juhtudel

- CAT

- kategooriad

- kategoriseerimine

- Kategooria

- Kassid

- keskus

- kindel

- väljakutse

- väljakutseid

- muutunud

- muutuv

- kanalid

- ChatGPT

- Valisin

- valitud

- klass

- klassid

- klassifikatsioon

- Klassifitseerige

- kliendid

- kood

- koostöö

- kombineerimine

- Tulema

- tuleb

- edastama

- KOMMUNIKATSIOON

- kogukond

- ettevõte

- võrreldav

- konkurents

- arvuti

- Arvutiteadus

- mõiste

- mõisted

- järeldus

- kaaluda

- koosneb

- piiranguid

- konsultant

- tarbija

- sisaldab

- sisu

- kontekst

- parandada

- Maksma

- kulukas

- kulud

- võiks

- maakond

- KATTED

- looma

- loodud

- tava

- klient

- Kliendid

- andmed

- andmeteadus

- andmeteadlane

- andmekogumid

- päev

- otsustatud

- otsused

- loetakse

- sügav

- sügav sukeldumine

- sügavam

- määratlema

- määratletud

- tarnima

- esitatud

- tarne

- süvenema

- demokratiseerima

- Demograafia

- näitab

- juurutamine

- kasutuselevõtu

- Disain

- soovitud

- avastama

- Detection

- Määrama

- arendama

- & Tarkvaraarendus

- DID

- Diego

- erinev

- erinevad

- jagatud

- hajutatud süsteemid

- ei

- domeen

- Domeenid

- kahekordistada

- dubleeritud

- ajal

- E&T

- iga

- leevendada

- lihtne

- Tõhus

- tõhusus

- mõju

- jõupingutusi

- lõpp

- energia

- Mootor

- Inseneriteadus

- Inglise

- suurendama

- piisavalt

- sisene

- Kogu

- keskkond

- epohh

- Hinnanguliselt

- hinnatud

- KUNAGI

- Iga

- näide

- olemasolevate

- kogemus

- eksperiment

- katseid

- ekspertide

- Selgitama

- selgitades

- uurima

- väljendusrikas

- laiendama

- ulatuslik

- laialdaselt

- lisatasu

- väljavõte

- nägu

- silmitsi seisnud

- andmed

- mood

- kiiremini

- kiiremini kasvav

- vähe

- Joonis

- lõplik

- finants-

- finantsteenused

- leidma

- esimene

- sobima

- voog

- Keskenduma

- Järel

- eest

- formaat

- avastatud

- Sihtasutus

- raamistikud

- Alates

- edasi

- saadud

- mäng

- Mängud

- mäng

- Mängutööstus

- kogutud

- Üldine

- tekitama

- teeniva

- generatiivne

- Generatiivne AI

- saama

- antud

- Goes

- läheb

- Grupp

- Kasvavad

- kasvanud

- olnud

- Olema

- võttes

- he

- juhataja

- tervislikumaks

- siin

- rohkem

- ajalooline

- ajalooliselt

- ajalugu

- Kuidas

- Kuidas

- aga

- HTTPS

- Keskus

- inim-

- sajad

- Hüperparameetrite häälestamine

- idee

- ideaalne

- identiques

- identifitseerimiseks

- if

- pilt

- pildid

- Immigrandid

- rakendada

- rakendamisel

- import

- oluline

- impordi

- parandama

- paranenud

- paranemine

- parandusi

- in

- sisaldama

- Kaasa arvatud

- kasvav

- tööstus

- info

- omane

- olemuselt

- Innovatsioon

- sisend

- Integreerimine

- suhtlevad

- interaktsioonid

- interaktiivne

- huvitatud

- el

- sisse

- sisse

- Tutvustab

- IT

- ITS

- Jaanuar

- Pusle

- ühine

- lihtsalt

- Võti

- märksõnad

- teadmised

- teatud

- märgistamine

- Labels

- keel

- suur

- suuremahuline

- pärast

- panema

- kiht

- õppimine

- Pikkus

- vähem

- nagu

- LLM

- koormus

- enam

- otsin

- kadunud

- Partii

- Langetamine

- masin

- masinõpe

- tehtud

- põhiline

- säilitada

- hooldus

- tegema

- TEEB

- Tegemine

- mees

- juhtimine

- juht

- käsiraamat

- tootmine

- palju

- suur

- mai..

- mehhanism

- Meedia

- mõdu

- meetod

- Metoodika

- meetriline

- miljon

- ML

- MLOps

- mudel

- modelleerimine

- mudelid

- Muudatused

- Moodulid

- järelevalve

- kuu

- rohkem

- kõige

- Populaarseim

- palju

- nimelt

- Natural

- Natural Language Processing

- loodus

- vaja

- võrk

- võrgustikud

- närvivõrgud

- Uus

- järgmine

- nlp

- sõlme

- nüüd

- number

- numbrid

- saamine

- of

- maha

- solvav

- sageli

- on

- ONE

- Internetis

- online-mängude

- ainult

- Operations

- vastupidine

- optimeeritud

- Valikud

- or

- oranž

- et

- originaal

- Muu

- välja

- Tulemus

- tulemusi

- väljund

- üle

- üldine

- ülevaade

- enda

- paari

- paradigma

- parameeter

- parameetrid

- osa

- partnerlusega

- Vastu võetud

- minevik

- Muster

- täiuslik

- täitma

- jõudlus

- täidab

- faas

- phd

- fraasid

- tükk

- inimesele

- Platon

- Platoni andmete intelligentsus

- PlatoData

- mängis

- mängija

- mängijad

- palun

- PoC

- Punkt

- populaarne

- rahvastik

- post

- Postitusi

- potentsiaalselt

- võim

- võimas

- volitused

- Täpsus

- ennustada

- ennustada

- prognoosimine

- ennustus

- Ennustused

- Ennustab

- eelmine

- varem

- Probleem

- menetlus

- protsess

- Protsessid

- töötlemine

- tootma

- Produktsioon

- ROBUS

- professionaalne

- edendama

- Edendamine

- tõend

- tõendi mõiste

- tingimusel

- annab

- avalik

- panema

- Python

- kvaliteet

- valik

- jõudma

- jõuda

- valmis

- reaalne

- päris maailm

- põhjustel

- saadud

- hiljuti

- retsept

- tunnistama

- soovitatav

- rekord

- suhteliselt

- vabastama

- vabastatud

- asjakohane

- replikatsioon

- esindama

- nõudma

- vastutav

- Vastutustundlik mängimine

- kaasa

- tulemuseks

- Tulemused

- Reuters

- õige

- rangelt

- Tõusma

- tugevus

- rollid

- jooks

- jooksmine

- salveitegija

- sama

- San

- San Diego

- skaalautuvia

- Skaala

- ketendamine

- teadus

- teaduslik

- teadlane

- kriimustada

- Teine

- Osa

- lõigud

- vanem

- Lause

- tunne

- eri

- Jada

- Seeria

- teenib

- Teenused

- komplekt

- Komplektid

- mitu

- Aktsiad

- tutvustatud

- Näitused

- sarnane

- alates

- ühekordne

- SUURUS

- aeglustub

- väike

- väiksem

- So

- sotsiaalmeedia

- Sotsiaalse meedia

- seltskondlikult

- Ainult

- lahendus

- Lahendused

- LAHENDAGE

- Lahendamine

- mõned

- otsisin

- Ruum

- konkreetse

- eriti

- kõne

- kiirus

- jagada

- algab

- riik

- stats

- Samm

- Veel

- struktuur

- Uuring

- oluliselt

- selline

- piisav

- süsteemid

- tabel

- kohandatud

- võtab

- võtmine

- Ülesanne

- ülesanded

- meeskond

- Tehnoloogia

- test

- katsetatud

- kui

- et

- .

- Riik

- oma

- Neile

- SIIS

- teoreetiline

- Seal.

- Need

- nad

- see

- arvasin

- kolm

- künnis

- Läbi

- Seega

- aeg

- korda

- ajastamine

- Titan

- et

- täna

- Teemasid

- Summa

- Rong

- koolitatud

- koolitus

- üle

- trafo

- trafod

- Tõlge

- tõeliselt

- Pöörake

- piiksuma

- tweets

- kaks

- tüüp

- liigid

- tüüpiline

- tüüpiliselt

- lõpuks

- aluseks

- mõistmine

- kahjuks

- Ülikool

- California Ülikool

- ajakohastatud

- kasutama

- kasutage juhtumit

- Kasutatud

- Kasutaja

- User Experience

- Kasutajad

- kasutusalad

- kasutamine

- KINNITAGE

- kinnitamine

- sort

- suur

- versioonid

- vertikaalid

- väga

- kaudu

- Video

- videomängud

- praktiliselt

- Hääl

- vs

- tahan

- tagaotsitav

- oli

- Tee..

- we

- web

- veebiteenused

- Web3

- kaalumine

- Hästi

- hästi tuntud

- olid

- millal

- kas

- mis

- kuigi

- miks

- lai

- Lai valik

- Wikipedia

- will

- koos

- jooksul

- ilma

- Naised

- sõna

- sõnad

- töövoog

- töö

- töötab

- maailm

- oleks

- kirjutamine

- aastat

- sa

- Sinu

- sephyrnet