Radioloogiaaruanded on põhjalikud pikad dokumendid, mis kirjeldavad ja tõlgendavad radioloogilise pildiuuringu tulemusi. Tavalise töövoo korral jälgib, loeb ja tõlgendab radioloog pilte ning võtab seejärel lühidalt kokku peamised tulemused. Kokkuvõte (või mulje) on aruande kõige olulisem osa, kuna see aitab arstidel ja patsientidel keskenduda aruande kriitilisele sisule, mis sisaldab teavet kliiniliste otsuste tegemiseks. Selge ja mõjuva mulje loomine nõuab palju rohkem pingutust kui lihtsalt leidude kordamine. Seetõttu on kogu protsess töömahukas, aeganõudev ja tõrgeteta. Sageli kulub selleks aastaid koolitus et arstid saaksid koguda piisavalt teadmisi lühikeste ja informatiivsete radioloogiaaruannete kokkuvõtete kirjutamiseks, rõhutades veelgi protsessi automatiseerimise olulisust. Lisaks aruannete tulemuste kokkuvõtte automaatne genereerimine on radioloogilise aruandluse jaoks ülioluline. See võimaldab tõlkida aruandeid inimloetavasse keelde, leevendades seeläbi patsientide koormust pikkade ja ebaselgete aruannete lugemisel.

Selle probleemi lahendamiseks teeme ettepaneku kasutada generatiivset tehisintellekti – AI tüüpi, mis võib luua uut sisu ja ideid, sealhulgas vestlusi, lugusid, pilte, videoid ja muusikat. Generatiivset AI-d toidavad masinõppe (ML) mudelid – väga suured mudelid, mis on eelkoolitatud suure hulga andmemahtude jaoks ja mida tavaliselt nimetatakse alusmudeliteks (FM). Hiljutised edusammud ML-is (täpsemalt trafopõhise närvivõrgu arhitektuuri leiutamine) on toonud kaasa miljardeid parameetreid või muutujaid sisaldavate mudelite tõusu. Selles postituses pakutud lahendus kasutab eelkoolitatud suurte keelemudelite (LLM) peenhäälestamist, et aidata koostada kokkuvõtteid radioloogiaaruannete leidude põhjal.

See postitus näitab strateegiat avalikult kättesaadavate LLM-ide viimistlemiseks radioloogiaaruannete kokkuvõtte tegemiseks AWS-i teenuste abil. LLM-id on näidanud märkimisväärseid võimeid loomuliku keele mõistmisel ja genereerimisel, toimides alusmudelitena, mida saab kohandada erinevate valdkondade ja ülesannetega. Eelkoolitatud mudeli kasutamisel on olulisi eeliseid. See vähendab arvutuskulusid, vähendab süsiniku jalajälge ja võimaldab teil kasutada tipptasemel mudeleid, ilma et peaksite neid nullist koolitama.

Meie lahendus kasutab FLAN-T5 XL FM, kasutades Amazon SageMaker JumpStart, mis on ML-jaotur, mis pakub algoritme, mudeleid ja ML-lahendusi. Näitame, kuidas seda sülearvuti abil saavutada Amazon SageMaker Studio. Eelkoolitatud mudeli peenhäälestus hõlmab konkreetsete andmete täiendavat koolitust, et parandada jõudlust erineva, kuid seotud ülesande täitmisel. See lahendus hõlmab mudeli FLAN-T5 XL peenhäälestamist, mis on täiustatud versioon T5 (Tekst-teksti edastustransformer) üldotstarbelised LLM-id. T5 raamib loomuliku keele töötlemise (NLP) ülesanded ümber ühtseks teksti-teksti vorminguks, erinevalt BERT-stiilis mudelid, mis suudavad väljastada ainult klassisildi või sisendi ulatuse. See on peenhäälestatud kokkuvõtlikuks ülesandeks 91,544 XNUMX vabatekstilise radioloogiaaruande jaoks, mis on saadud MIMIC-CXR andmestik.

Ülevaade lahendusest

Selles jaotises käsitleme meie lahenduse põhikomponente: ülesande strateegia valimine, LLM-i peenhäälestus ja tulemuste hindamine. Samuti illustreerime lahenduse arhitektuuri ja samme lahenduse rakendamiseks.

Tehke kindlaks ülesande strateegia

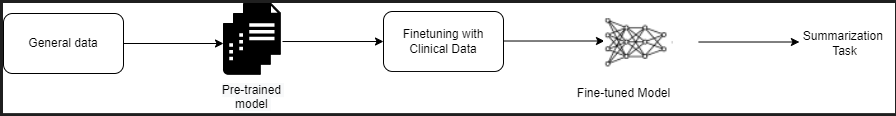

Kliiniliste aruannete kokkuvõtte automatiseerimiseks on erinevaid strateegiaid. Näiteks võiksime kasutada spetsiaalset keelemudelit, mis on eelnevalt kliiniliste aruannete põhjal nullist välja õpetatud. Teise võimalusena võiksime kliinilise ülesande täitmiseks avalikult kättesaadavat üldotstarbelist keelemudelit otse peenhäälestada. Peenhäälestatud domeeniagnostilise mudeli kasutamine võib olla vajalik seadetes, kus treenitakse a keelemudel nullist on liiga kulukas. Selles lahenduses demonstreerime viimast lähenemist FLAN -T5 XL mudeli kasutamisele, mida me täpsustame radioloogiaaruannete kokkuvõtte kliinilise ülesande jaoks. Järgmine diagramm illustreerib mudeli töövoogu.

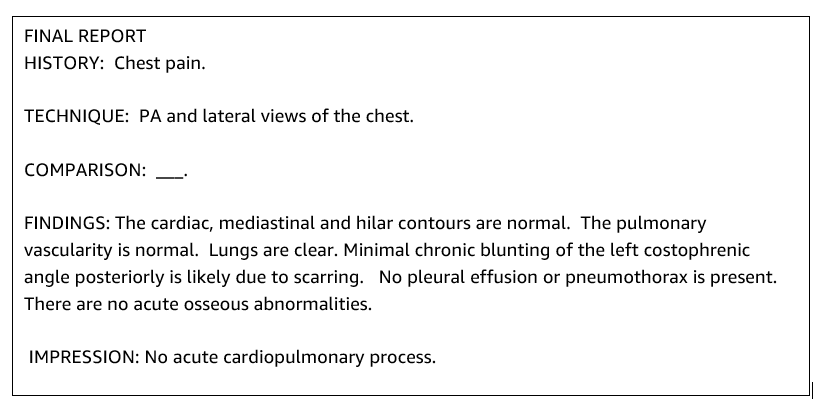

Tüüpiline radioloogiaaruanne on hästi organiseeritud ja sisutihe. Sellistel aruannetel on sageli kolm peamist osa:

- Taust - Annab üldist teavet patsiendi demograafilise teabe kohta, olulist teavet patsiendi, kliinilise ajaloo ja asjakohase haigusloo kohta ning üksikasju uuringuprotseduuride kohta

- Järeldused - Esitab üksikasjaliku eksami diagnoosi ja tulemused

- trükkimine – võtab lühidalt kokku kõige silmapaistvamad leiud või leidude tõlgendused koos olulisuse hinnangu ja võimaliku diagnoosiga, mis põhineb täheldatud kõrvalekalletel

Kasutades radioloogiaaruannete leidude jaotist, genereerib lahendus jäljendiosa, mis vastab arstide kokkuvõttele. Järgmine joonis on radioloogiaaruande näide.

Täpsustage üldotstarbelist LLM-i kliinilise ülesande jaoks

Selle lahenduse puhul peenhäälestame mudelit FLAN-T5 XL (mudeli kõigi parameetrite häälestamine ja ülesande jaoks optimeerimine). Täpsustame mudelit kliinilise domeeni andmestiku abil MIMIC-CXR, mis on avalikult kättesaadav rindkere röntgenülesvõtete andmestik. Selle mudeli täpsustamiseks SageMaker Kiirstardi kaudu tuleb märgistatud näited esitada paaride {prompt, completion} kujul. Sel juhul kasutame MIMIC-CXR andmestiku algaruannete paare {Findings, Impression}. Järelduste tegemiseks kasutame järgmises näites näidatud viipa:

![]()

Mudel on peenhäälestatud kiirendatud andmetöötlusel ml.p3.16xsuur 64 virtuaalse protsessori ja 488 GiB mäluga eksemplar. Valideerimiseks valiti juhuslikult 5% andmekogumist. SageMakeri koolitustöö aeg koos peenhäälestusega oli 38,468 11 sekundit (umbes XNUMX tundi).

Hinnake tulemusi

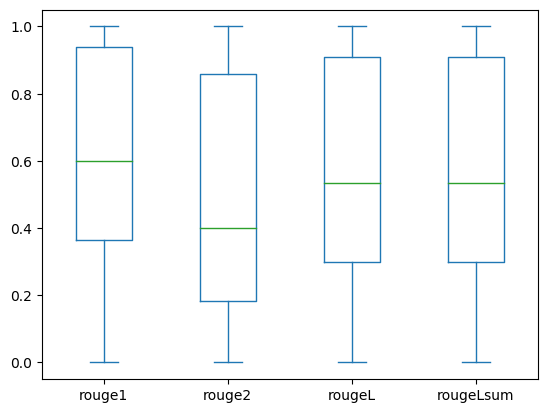

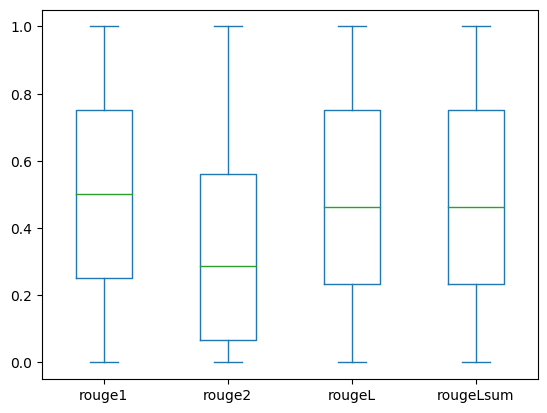

Kui koolitus on lõppenud, on oluline tulemusi hinnata. Loodud mulje kvantitatiivseks analüüsiks kasutame RED (Recall-Oriented Understudy for Gisting Evaluation), kokkuvõtte hindamiseks kõige sagedamini kasutatav mõõdik. See mõõdik võrdleb automaatselt koostatud kokkuvõtet viite või viidete kogumiga (inimtoodetud) kokkuvõtte või tõlkega. ROUGE1 viitab kattumisele unigrammid (iga sõna) kandidaadi (mudeli väljund) ja viitekokkuvõtete vahel. ROUGE2 viitab kattumisele biggrammid (kaks sõna) kandidaadi ja viitekokkuvõtete vahel. ROUGEL on lausetaseme mõõdik ja viitab kahe tekstiosa vahelisele pikimale ühisele alamjadale (LCS). See ignoreerib tekstis reavahetust. ROUGELsum on kokkuvõtliku taseme mõõdik. Selle mõõdiku puhul ei ignoreerita tekstis reavahetusi, vaid neid tõlgendatakse lausepiiridena. Seejärel arvutatakse LCS iga viite- ja kandidaatlausete paari vahel ning seejärel arvutatakse liit-LCS. Nende skooride liitmiseks antud võrdlus- ja kandidaatlausete kogumi kohta arvutatakse keskmine.

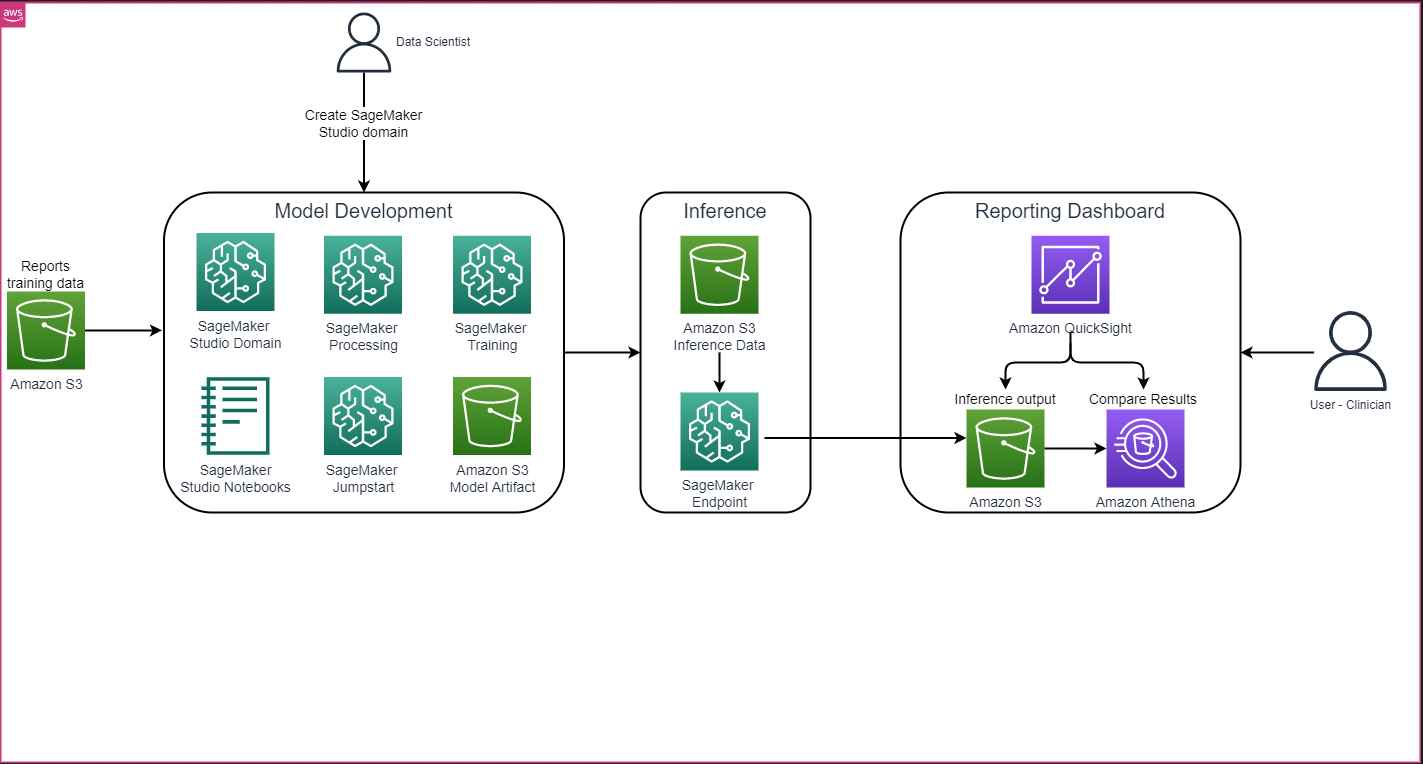

Läbikäik ja arhitektuur

Lahenduse üldine arhitektuur, nagu on näidatud järgmisel joonisel, koosneb peamiselt mudeliarenduskeskkonnast, mis kasutab SageMaker Studiot, mudeli juurutamist koos SageMakeri lõpp-punktiga ja aruandluspaneelist, mis kasutab Amazon QuickSight.

Järgmistes jaotistes demonstreerime SageMaker JumpStartis saadaoleva LLM-i peenhäälestamist domeenispetsiifilise ülesande kokkuvõtte tegemiseks SageMaker Python SDK kaudu. Eelkõige käsitleme järgmisi teemasid:

- Arenduskeskkonna seadistamise sammud

- Ülevaade radioloogiaaruannete andmekogumitest, mille alusel mudelit peenhäälestatakse ja hinnatakse

- FLAN-T5 XL mudeli peenhäälestamise demonstratsioon, kasutades programmiliselt SageMaker JumpStart koos SageMaker Python SDK-ga

- Eelkoolitatud ja peenhäälestatud mudelite järeldamine ja hindamine

- Eelkoolitatud mudeli ja peenhäälestatud mudelite tulemuste võrdlus

Lahendus on saadaval aadressil Radioloogiaaruande mulje loomine, kasutades generatiivset AI-d suure keelemudeliga AWS-is GitHub repo.

Eeldused

Alustamiseks vajate AWS-i konto milles saate kasutada SageMaker Studio. Kui teil seda veel pole, peate SageMaker Studio jaoks looma kasutajaprofiili.

Selles postituses kasutatud koolituseksemplari tüüp on ml.p3.16xlarge. Pange tähele, et p3 eksemplari tüüp nõuab teenusekvoodi limiidi suurendamist.

. MIMIC CXR andmestik pääseb ligi andmete kasutamise lepingu kaudu, mis nõuab kasutaja registreerimist ja volitamisprotsessi lõpuleviimist.

Seadistage arenduskeskkond

Arenduskeskkonna seadistamiseks loote S3 ämbri, konfigureerite märkmiku, looge lõpp-punktid ja juurutage mudelid ning loote QuickSighti armatuurlaua.

Looge S3 ämber

Looge S3 ämber kutsutud llm-radiology-bucket koolituse ja hindamise andmekogumite majutamiseks. Seda kasutatakse ka mudeliartefakti salvestamiseks mudeli arendamise ajal.

Konfigureerige märkmik

Tehke järgmised toimingud.

- Käivitage SageMaker Studio kas SageMakeri konsoolist või AWS-i käsurea liides (AWS CLI).

Lisateabe saamiseks domeeniga liitumise kohta vt Sisseehitatud Amazon SageMakeri domeeniga.

- Loo uus SageMaker Studio märkmik aruande andmete puhastamiseks ja mudeli peenhäälestamiseks. Kasutame Python 3 tuumaga ml.t2.medium 4vCPU+3GiB sülearvuti eksemplari.

- Installige sülearvutisse vastavad paketid, näiteks

nest-asyncio,IPyWidgets(Jupyteri sülearvuti interaktiivsete vidinate jaoks) ja SageMaker Python SDK:

Eelkoolitatud ja peenhäälestatud mudelite kohta järelduste tegemiseks luua lõpp-punkt ja juurutada iga mudel märkmikus järgmiselt:

- Looge mudeliklassist Model objekt, mida saab juurutada HTTPS-i lõpp-punkti.

- Looge HTTPS-i lõpp-punkt mudeliobjekti eelehitatud versiooniga

deploy()meetod:

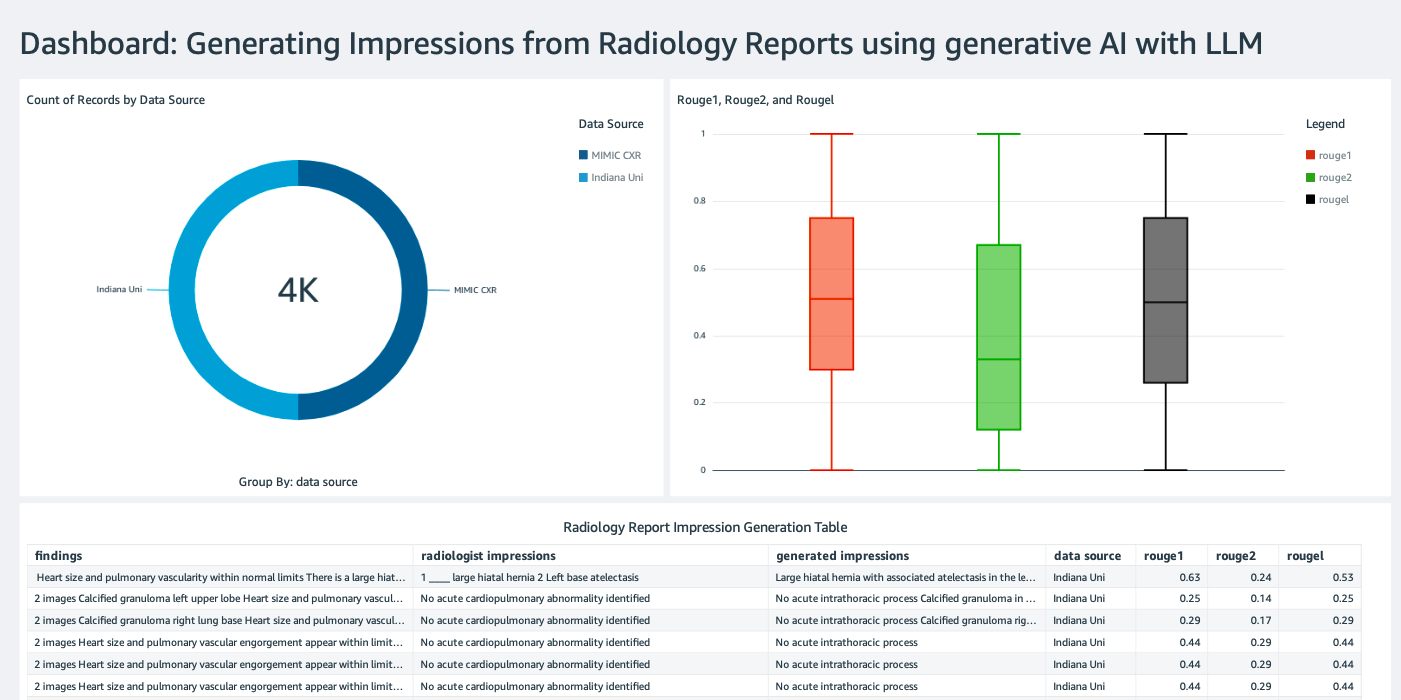

Looge QuickSighti armatuurlaud

Loo QuickSighti armatuurlaud koos Athena andmeallikaga järeldustega Amazoni lihtne salvestusteenus (Amazon S3), et võrrelda järelduste tulemusi põhitõega. Järgmine ekraanipilt näitab meie näidisjuhtpaneeli.

Radioloogiaaruannete andmekogumid

Mudel on nüüd peenhäälestatud, kõik mudeli parameetrid on häälestatud 91,544 XNUMX aruandest, mis on alla laaditud MIMIC-CXR v2.0 andmestik. Kuna kasutasime ainult radioloogiaraporti tekstiandmeid, laadisime alla ainult ühe tihendatud aruandefaili (mimic-cxr-reports.zip) MIMIC-CXR veebisaidilt. Nüüd hindame peenhäälestatud mudelit 2,000 aruande põhjal (mida nimetatakse dev1 andmestik) eraldi andis välja selle andmestiku alamhulga. Kasutame veel 2,000 radioloogiaaruannet (viidatud kui dev2) peenhäälestatud mudeli hindamiseks rindkere röntgenikiirte kogust alates Indiana ülikooli haiglavõrk. Kõik andmestikud loetakse JSON-failidena ja laaditakse üles äsja loodud S3 ämbrisse llm-radiology-bucket. Pange tähele, et kõik andmestikud ei sisalda vaikimisi kaitstud terviseteavet (PHI). kogu tundlik teave asendatakse kolme järjestikuse allkriipsuga (___) teenuseosutajate poolt.

Täpsustage SageMaker Python SDK-ga

Peenhäälestamiseks on model_id on täpsustatud kui huggingface-text2text-flan-t5-xl SageMaker JumpStart mudelite loendist. The training_instance_type on määratud kujul ml.p3.16xlarge ja inference_instance_type kui ml.g5.2xsuur. JSON-vormingus treeningandmeid loetakse S3 ämbrist. Järgmine samm on kasutada SageMaker JumpStart ressursi URI-de ekstraktimiseks valitud model_id, sealhulgas image_uri ( Amazoni elastsete konteinerite register (Amazon ECR) URI Dockeri pildi jaoks), model_uri (eelkoolitatud mudeliartefakt Amazon S3 URI) ja script_uri (koolituse skript):

Samuti on väljundi asukoht S3 ämbris kaustana seadistatud.

Ainult üks hüperparameeter, epochs, muudetakse väärtuseks 3 ja kõik ülejäänud on seatud vaikimisi:

Treeningu mõõdikud nagu eval_loss (valideerimise kaotamise korral), loss (treeningukaotuse korral) ja epoch Jälgitavad on määratletud ja loetletud:

Kasutame SageMaker JumpStart ressursi URI-sid (image_uri, model_uri, script_uri), mis on varem tuvastatud, et luua hindaja ja peenhäälestada seda treeningandmete komplektis, määrates andmestiku S3 tee. Hindaja klass nõuab entry_point parameeter. Sel juhul kasutab JumpStart transfer_learning.py. Kui seda väärtust ei määrata, ei õnnestu koolitustööd käivitada.

Selle koolitustöö täitmine võib võtta tunde; seetõttu on soovitatav määrata ooteparameetri väärtuseks Väär ja jälgida SageMakeri konsoolis koolitustöö olekut. Kasuta TrainingJobAnalytics funktsioon treeningmõõdikute jälgimiseks erinevatel ajatemplitel:

Järelduste lõpp-punktide juurutamine

Võrdluste tegemiseks kasutame nii eelkoolitatud kui ka peenhäälestatud mudelite jaoks järelduste lõpp-punkte.

Esiteks hankige järeldus Dockeri kujutise URI abil model_idja kasutage seda URI-d, et luua eelkoolitatud mudelist SageMakeri mudeli eksemplar. Juurutage eelkoolitatud mudel, luues mudeliobjekti eelseadistatud HTTPS-i lõpp-punkti deploy() meetod. SageMaker API kaudu järelduste tegemiseks läbige kindlasti klass Predictor.

Korrake eelmist sammu, et luua peenhäälestatud mudelist SageMakeri mudeli eksemplar ja luua mudeli juurutamiseks lõpp-punkt.

Hinnake mudeleid

Esiteks määrake kokkuvõtliku teksti pikkus, mudeli väljundite arv (peab olema suurem kui 1, kui on vaja luua mitu kokkuvõtet) ja kiirte arv tala otsing.

Koostage järelduspäring JSON-i kasuliku koormusena ja kasutage seda eelkoolitatud ja peenhäälestatud mudelite lõpp-punktide päringute tegemiseks.

Arvutage kokkuvõte ROUGE hinded (ROUGE1, ROUGE2, ROUGEL, ROUGELsum), nagu varem kirjeldatud.

Võrrelge tulemusi

Järgmises tabelis on esitatud hindamistulemused dev1 ja dev2 andmestikud. Hindamise tulemus on dev1 (2,000 leidu MIMIC CXR radioloogiaaruandest) näitab koondkeskmise paranemist ligikaudu 38 protsendipunkti võrra. ROUGE1 ja ROUGE2 hinded võrreldes eelkoolitatud mudeliga. Dev2 puhul on ROUGE31 ja ROUGE25 skoorides paranenud 1 protsendipunkti ja 2 protsendipunkti. Üldiselt parandas peenhäälestus ROUGELsumi skoori 38.2 protsendipunkti ja 31.3 protsendipunkti. dev1 ja dev2 vastavalt andmekogumeid.

|

Hindamine Andmebaas |

Eelkoolitatud mudel | Peenhäälestatud mudel | ||||||

| ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | ROUGE1 | ROUGE2 | ROUGEL | ROUGELsum | |

dev1 |

0.2239 | 0.1134 | 0.1891 | 0.1891 | 0.6040 | 0.4800 | 0.5705 | 0.5708 |

dev2 |

0.1583 | 0.0599 | 0.1391 | 0.1393 | 0.4660 | 0.3125 | 0.4525 | 0.4525 |

Järgmised kastigraafikud kujutavad ROUGE skooride jaotust dev1 ja dev2 peenhäälestatud mudeli abil hinnatud andmestikke.

|

|

(kulle): dev1 |

(b): dev2 |

Järgmine tabel näitab, et hindamisandmekogumite ROUGE skooridel on ligikaudu sama mediaan ja keskmine ning seetõttu jaotuvad need sümmeetriliselt.

| Andmekogumid | Partituur | Loendama | Keskmine | Tavaline kõrvalekalle | Miinimum | 25% protsentiil | 50% protsentiil | 75% protsentiil | Maksimaalne |

dev1 |

ROUGE1 | 2000.00 | 0.6038 | 0.3065 | 0.0000 | 0.3653 | 0.6000 | 0.9384 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.4798 | 0.3578 | 0.0000 | 0.1818 | 0.4000 | 0.8571 | 1.0000 | |

| ROUGE L | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

| ROUGELsum | 2000.00 | 0.5706 | 0.3194 | 0.0000 | 0.3000 | 0.5345 | 0.9101 | 1.0000 | |

dev2 |

ROUGE 1 | 2000.00 | 0.4659 | 0.2525 | 0.0000 | 0.2500 | 0.5000 | 0.7500 | 1.0000 |

| ROUGE 2 | 2000.00 | 0.3123 | 0.2645 | 0.0000 | 0.0664 | 0.2857 | 0.5610 | 1.0000 | |

| ROUGE L | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 | |

| ROUGE Lsum | 2000.00 | 0.4529 | 0.2554 | 0.0000 | 0.2349 | 0.4615 | 0.7500 | 1.0000 |

Koristage

Edaspidiste tasude vältimiseks kustutage ressursid, mille lõite järgmise koodiga:

Järeldus

Selles postituses näitasime, kuidas FLAN-T5 XL mudelit kliinilise domeenispetsiifilise kokkuvõtliku ülesande jaoks SageMaker Studio abil täpsustada. Usalduse suurendamiseks võrdlesime ennustusi põhitõega ja hindasime tulemusi ROUGE mõõdikute abil. Näitasime, et konkreetse ülesande jaoks peenhäälestatud mudel annab paremaid tulemusi kui üldise NLP-ülesande jaoks eelkoolitatud mudel. Tahaksime juhtida tähelepanu sellele, et üldotstarbelise LLM-i peenhäälestus välistab eelkoolituse kulud üldse.

Kuigi siin esitatud töö keskendub rindkere röntgenaruannetele, võib seda laiendada suurematele andmekogudele, millel on erinev anatoomia ja moodus, nagu MRI ja CT, mille puhul võivad radioloogilised aruanded olla mitmete leidudega keerulisemad. Sellistel juhtudel võivad radioloogid luua muljeid kriitilisuse järjekorras ja lisada järelmeetmete soovitusi. Lisaks võimaldaks selle rakenduse jaoks tagasisideahela loomine radioloogidel mudeli toimivust aja jooksul parandada.

Nagu selles postituses näitasime, loob peenhäälestatud mudel muljeid kõrgete ROUGE skooridega radioloogiaaruannete jaoks. Võite proovida LLM-e täpsustada erinevate osakondade muude domeenispetsiifiliste meditsiiniliste aruannete põhjal.

Autoritest

Dr Adewale Akinfaderin on AWSi tervishoiu ja bioteaduste vanemteadur. Tema teadmised on reprodutseeritavad ja täielikud AI/ML meetodid, praktilised teostused ning globaalsete tervishoiu klientide abistamine interdistsiplinaarsete probleemide skaleeritavate lahenduste formuleerimisel ja väljatöötamisel. Tal on kaks magistrikraadi füüsikas ja doktorikraad tehnikateaduses.

Dr Adewale Akinfaderin on AWSi tervishoiu ja bioteaduste vanemteadur. Tema teadmised on reprodutseeritavad ja täielikud AI/ML meetodid, praktilised teostused ning globaalsete tervishoiu klientide abistamine interdistsiplinaarsete probleemide skaleeritavate lahenduste formuleerimisel ja väljatöötamisel. Tal on kaks magistrikraadi füüsikas ja doktorikraad tehnikateaduses.

Priya Padate on AWSi vanempartnerlahenduste arhitekt, kellel on laialdased teadmised tervishoiu ja bioteaduste vallas. Priya juhib partneritega turule mineku strateegiaid ja juhib lahenduste arendamist, et kiirendada AI-l/ML-põhist arendust. Ta on kirglik tehnoloogia kasutamise vastu, et muuta tervishoiutööstus paremaks patsiendihoolduse tulemuste saavutamiseks.

Priya Padate on AWSi vanempartnerlahenduste arhitekt, kellel on laialdased teadmised tervishoiu ja bioteaduste vallas. Priya juhib partneritega turule mineku strateegiaid ja juhib lahenduste arendamist, et kiirendada AI-l/ML-põhist arendust. Ta on kirglik tehnoloogia kasutamise vastu, et muuta tervishoiutööstus paremaks patsiendihoolduse tulemuste saavutamiseks.

Ekta Walia Bhullar, PhD, on AI/ML-i vanemkonsultant AWS Healthcare and Life Sciences (HCLS) professionaalsete teenuste äriüksuses. Tal on ulatuslik kogemus AI/ML rakendamisel tervishoiuvaldkonnas, eriti radioloogias. Väljaspool tööd, kui radioloogias tehisintellektist ei räägi, meeldib talle joosta ja matkata.

Ekta Walia Bhullar, PhD, on AI/ML-i vanemkonsultant AWS Healthcare and Life Sciences (HCLS) professionaalsete teenuste äriüksuses. Tal on ulatuslik kogemus AI/ML rakendamisel tervishoiuvaldkonnas, eriti radioloogias. Väljaspool tööd, kui radioloogias tehisintellektist ei räägi, meeldib talle joosta ja matkata.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Autod/elektrisõidukid, Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- ChartPrime. Tõsta oma kauplemismängu ChartPrime'iga kõrgemale. Juurdepääs siia.

- BlockOffsets. Keskkonnakompensatsiooni omandi ajakohastamine. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/automatically-generate-impressions-from-findings-in-radiology-reports-using-generative-ai-on-aws/

- :on

- :on

- :mitte

- : kus

- $ UP

- 000

- 1

- 100

- 11

- 116

- 125

- 16

- 20

- 22

- 25

- 26%

- 29

- 31

- 36

- 7

- 700

- 8

- 9

- 91

- a

- Võimalik

- MEIST

- kiirendama

- kiirendatud

- pääses

- täitma

- Kogunema

- Lisaks

- edusammud

- vastu

- koondamine

- Kokkulepe

- AI

- AI / ML

- algoritme

- Materjal: BPA ja flataatide vaba plastik

- võimaldab

- juba

- Ka

- kokku

- Amazon

- Amazon SageMaker

- Amazon Web Services

- summad

- an

- analüüs

- ja

- Teine

- mistahes

- API

- taotlus

- lähenemine

- umbes

- arhitektuur

- OLEME

- argument

- AS

- hindamine

- At

- Automaatne

- automaatselt

- automatiseerimine

- saadaval

- keskmine

- vältima

- AWS

- baas

- põhineb

- BE

- sest

- enne

- on

- Kasu

- Parem

- vahel

- suurem

- miljardeid

- mõlemad

- piirid

- Kast

- koormus

- äri

- kuid

- by

- kutsutud

- CAN

- kandidaat

- võimeid

- süsinik

- mis

- juhul

- juhtudel

- muutunud

- koormuste

- valimine

- klass

- puhastamine

- selge

- kliiniline

- arstid

- kood

- kogumine

- ühine

- tavaliselt

- võrdlema

- võrreldes

- täitma

- lõpetamist

- keeruline

- komponendid

- terviklik

- arvutamine

- arvutustehnika

- lühike

- usaldus

- järjestikune

- koosneb

- konsool

- konsultant

- sisaldama

- Konteiner

- sisu

- sisu

- kontrast

- vestlused

- vastab

- Maksma

- kulukas

- kulud

- võiks

- Paar

- looma

- loodud

- loomine

- kriitiline

- kriitilisus

- tava

- Kliendid

- armatuurlaud

- andmed

- andmeteadlane

- andmekogumid

- Otsuse tegemine

- vaikimisi

- määratletud

- Kraad

- Demograafia

- näitama

- Näidatud

- näitab

- osakonnad

- juurutada

- lähetatud

- kasutuselevõtu

- kirjeldama

- kirjeldatud

- üksikasjalik

- detailid

- arendama

- & Tarkvaraarendus

- erinev

- otse

- arutama

- arutame

- jagatud

- jaotus

- laevalaadija

- arstid

- dokumendid

- domeen

- Domeenid

- Ära

- juhtida

- ajam

- kõvakettad

- ajal

- iga

- Ajalugu

- jõupingutusi

- kumbki

- kõrvaldab

- teine

- võimaldama

- võimaldab

- Lõpuks-lõpuni

- Lõpp-punkt

- Inseneriteadus

- tõhustatud

- piisavalt

- Kogu

- keskkond

- epohh

- ajajärgud

- viga

- eriti

- oluline

- hindama

- hinnatud

- hindamine

- hindamine

- eksam

- näide

- näited

- täitma

- laiendatud

- kogemus

- teadmised

- ulatuslik

- Laialdased kogemused

- väljavõte

- ei

- vale

- tagasiside

- Joonis

- fail

- Faile

- järeldused

- Keskenduma

- keskendub

- Järel

- järgneb

- eest

- vorm

- formaat

- Sihtasutus

- Alates

- funktsioon

- edasi

- Pealegi

- tulevik

- Üldine

- Üldine otstarve

- tekitama

- loodud

- genereerib

- põlvkond

- generatiivne

- Generatiivne AI

- saama

- antud

- Globaalne

- Turule minema

- koolilõpetaja

- suurem

- Maa

- Olema

- võttes

- he

- Tervis

- terviseinfo

- tervishoid

- tervishoiutööstus

- aitama

- aidates

- aitab

- siin

- Suur

- esiletõstmine

- Matk

- tema

- ajalugu

- võõrustaja

- Lahtiolekuajad

- Kuidas

- Kuidas

- HTML

- http

- HTTPS

- Keskus

- Kallistav Nägu

- inim-

- ID

- ideid

- tuvastatud

- if

- illustreerib

- pilt

- pildid

- Imaging

- mõjuv

- rakendada

- rakendused

- import

- oluline

- parandama

- paranemine

- in

- sisaldama

- Kaasa arvatud

- Suurendama

- tööstus

- info

- informatiivne

- sisend

- paigaldama

- Näiteks

- interaktiivne

- tõlgendus

- sisse

- leiutis

- IT

- töö

- Tööturg

- Json

- lihtsalt

- ainult üks

- hoidma

- Võti

- silt

- keel

- suur

- algatama

- õppimine

- Led

- Pikkus

- elu

- Maaülikooli

- nagu

- meeldib

- LIMIT

- joon

- nimekiri

- Loetletud

- LLM

- asub

- liising

- kaotus

- masin

- masinõpe

- tegema

- mai..

- keskmine

- meditsiini-

- keskmine

- Mälu

- meetod

- meetodid

- meetriline

- Meetrika

- võib

- protokoll

- ML

- mudel

- mudelid

- Jälgida

- rohkem

- kõige

- MRI

- palju

- mitmekordne

- muusika

- peab

- nimi

- Natural

- Natural Language Processing

- vajalik

- Vajadus

- võrk

- Närvivõrgus

- Uus

- äsja

- järgmine

- nlp

- märkmik

- nüüd

- number

- objekt

- saadud

- of

- pakkumine

- sageli

- on

- Pardal

- ONE

- ainult

- optimeerimine

- or

- et

- originaal

- Muu

- meie

- välja

- tulemusi

- väljund

- väljaspool

- üle

- üldine

- ignoreerimine

- ülevaade

- pakette

- paar

- paari

- parameeter

- parameetrid

- osa

- eriline

- partner

- partnerid

- sooritama

- kirglik

- tee

- patsient

- patsientidel

- protsent

- täitma

- jõudlus

- phd

- Füüsika

- tükki

- Platon

- Platoni andmete intelligentsus

- PlatoData

- Punkt

- võrra

- post

- potentsiaal

- sisse

- Praktiline

- Ennustused

- Predictor

- esitatud

- kingitusi

- eelkõige

- Probleem

- probleeme

- protsess

- töötlemine

- Toodetud

- professionaalne

- profiil

- esitama

- pakutud

- kaitstud

- tingimusel

- pakkujad

- annab

- avalikult

- Python

- kvantitatiivne

- Lugenud

- Lugemine

- hiljuti

- soovitused

- soovitatav

- vähendab

- viited

- nimetatud

- viitab

- regulaaravaldis

- Registreerimine

- seotud

- asjakohane

- tähelepanuväärne

- asendatakse

- aru

- Aruandlus

- Aruanded

- taotleda

- nõutav

- Vajab

- ressurss

- Vahendid

- vastavalt

- REST

- kaasa

- Tulemused

- Tulu

- Tõusma

- jooks

- jooksmine

- salveitegija

- sama

- skaalautuvia

- TEADUSED

- teadlane

- kriimustada

- SDK

- Otsing

- sekundit

- Osa

- lõigud

- vaata

- väljavalitud

- vanem

- tundlik

- Lause

- eri

- teenus

- Teenused

- teenindavad

- komplekt

- kehtestamine

- seaded

- ta

- peaks

- näitas

- näidatud

- Näitused

- tähendus

- märkimisväärne

- lihtne

- lihtsalt

- väike

- So

- lahendus

- Lahendused

- LAHENDAGE

- mõned

- sille

- spetsialiseeritud

- konkreetse

- eriti

- määratletud

- algus

- alustatud

- modernne

- olek

- Samm

- Sammud

- Veel

- ladustamine

- salvestada

- Lood

- strateegiad

- Strateegia

- stuudio

- selline

- KOKKUVÕTE

- kindel

- tabel

- Võtma

- võtab

- Ülesanne

- ülesanded

- Tehnoloogia

- kui

- et

- .

- Neile

- SIIS

- Seal.

- sellega

- seetõttu

- Need

- see

- need

- kolm

- Läbi

- aeg

- et

- liiga

- Teemasid

- jälgida

- Rong

- koolitus

- üle

- Muutma

- trafo

- Tõlge

- Tõde

- püüdma

- kaks

- tüüp

- tüüpiline

- rõhutab

- mõistmine

- ühtne

- üksus

- Ülikool

- laetud

- kasutama

- Kasutatud

- Kasutaja

- kasutusalad

- kasutamine

- kinnitamine

- väärtus

- Väärtused

- eri

- suur

- versioon

- kaudu

- Videod

- virtuaalne

- ootama

- oli

- we

- web

- veebiteenused

- veebisait

- millal

- mis

- kuigi

- laius

- will

- koos

- jooksul

- ilma

- sõna

- sõnad

- Töö

- töövoog

- oleks

- kirjutamine

- röntgen

- aastat

- sa

- Sinu

- sephyrnet