Eelmisel nädalal Tehnoloogiainnovatsiooni instituut (TII) käivitatud TII Falcon LLM, avatud lähtekoodiga põhikeele mudel (LLM). Treenitud 1 triljoni žetooniga Amazon SageMaker, Falconil on tipptasemel jõudlus (nr 1 Kallistava näo edetabel kirjutamise ajal), olles samas suhteliselt kerge ja odavam hostida kui teised LLM-id, nagu lama-65B. Selles postituses näitame, kuidas juurutada Falconit selliste rakenduste jaoks nagu keele mõistmine ja automatiseeritud kirjutamisabi, kasutades SageMakeris suuri mudelijäreldamise sügavaid õppekonteinereid.

Falcon on maandunud SageMakerile

TII on Abu Dhabi rakendusuuringute organisatsioon Kõrgtehnoloogia teadusnõukogu; selle teadlastest, teadlastest ja inseneridest koosnev meeskond on pühendunud transformatiivsete tehnoloogiate avastamisele ja teaduslike läbimurrete väljatöötamisele, mis tagavad meie ühiskonna tulevikukindluse. Selle aasta alguses asus TII koolitama tipptasemel avatud lähtekoodiga LLM-i ning kasutas selle töö tegemiseks SageMakeri infrastruktuuri, tööriistu ja teadmisi (et saada lisateavet selle mudeli SageMakeris väljaõppe kohta , viitama Tehnoloogiainnovatsiooni instituut koolitab Amazon SageMakeril tipptasemel Falcon LLM 40B vundamendimudelit). Selle pingutuse tulemus on TII Falcon LLM.

1 triljonil žetoonil treenitud Falconil on selle vastu tipptasemel jõudlus Eleutheri AI keelemudeli hindamise rakmed ja on praegu lehel 1 Kallistava näo edetabel täpsuse huvides. Mudel on saadaval kahes erinevas suuruses – Falcon-40B ja Falcon-7B – ning seda saab kasutada tipptasemel jõudluse tagamiseks sellistes rakendustes nagu keele mõistmine, vestluskogemused ja automaatne kirjutamisabi. See postitus aitab teil alustada Falconi juurutamist SageMakeris, et seda tüüpi domeenides teha täpseid järeldusi.

SageMakeri suurte mudelite järelduste DLC-d lihtsustavad LLM-i hostimist

LLM-ide, nagu Falcon-40B ja Falcon-7B, hostimine võib olla keeruline. Suuremad mudelid on sageli täpsemad, kuna need sisaldavad miljardeid parameetreid, kuid nende suurus võib põhjustada ka aeglasema järelduste latentsuse või halvema läbilaskevõime. LLM-i hostimine võib vastuvõetava jõudluse saavutamiseks vajada rohkem GPU-mälu ja optimeeritud tuumasid. Asja veelgi keerulisemaks muutmiseks mahuvad väiksemad mudelid nagu Falcon-7B üldiselt ühele GPU-le, näiteks NVIDIA A10G eksemplarile, mis toidab AWS G5 eksemplaritüüpe, kuid suuremad mudelid, nagu Falcon-40B, ei saa seda teha. Kui see juhtub, tuleb suurema mudeli mitmeks osaks killustamiseks ja mitme GPU mälu ärakasutamiseks kasutada selliseid strateegiaid nagu tensori paralleelsus. Väiksemate mudelite jaoks kasutatavad pärandhostimislahendused seda tüüpi funktsioone tavaliselt ei paku, mis suurendab raskusi.

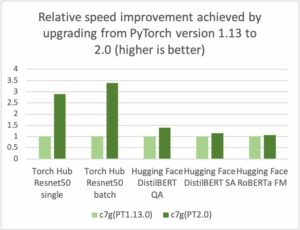

Abiks võivad olla SageMakeri suurte mudelijärelduste (LMI) süvaõppekonteinerid (DLC). LMI DLC-d on täielik täielik lahendus LLM-ide, nagu Falcon-40B, hostimiseks. Esiotsa sisaldavad need suure jõudlusega mudeliserverit (DJL Serving), mis on loodud suurte mudelite järelduste tegemiseks koos selliste funktsioonidega nagu loa voogesitus ja automaatne mudeli replikatsioon eksemplaris, et suurendada läbilaskevõimet. Taustasüsteemis sisaldavad LMI DLC-d ka mitmeid suure jõudlusega paralleelseid mootoreid, nagu DeepSpeed ja FasterTransformer, mis suudavad killustada ja hallata mudeli parameetreid mitmes GPU-s. Need mootorid sisaldavad ka populaarsete trafomudelite jaoks optimeeritud tuumasid, mis võivad kiirendada järelduste tegemist kuni kolm korda kiiremini. LMI DLC-de puhul peate lihtsalt looma konfiguratsioonifaili, et alustada LLM-i hostimist SageMakeris. SageMaker LMI DLC-de kohta lisateabe saamiseks vaadake Mudeli paralleelsus ja suure mudeli järeldus ja meie saadaolevate piltide loend. Võite vaadata ka meie eelmist postitust hostimise kohta Bloom-175B SageMakeris kasutades LMI DLC-sid.

Lahenduse ülevaade

See postitus juhendab teid, kuidas hostida Falcon-40B, kasutades SageMakeris DeepSpeedit, kasutades LMI DLC-sid. Falcon-40B nõuab, et kasutaksime mitut A10 GPU-d, samas kui Falcon-7B nõuab ainult ühte GPU-d. Oleme koostanud ka näiteid, mida saate viidata Falcon-40B ja Falcon-7B hostidele, kasutades nii DeepSpeedi kui ka Accelerate'i. Meie koodinäited leiate aadressilt GitHub.

Seda näidet saab käivitada SageMakeri märkmiku eksemplarides või Amazon SageMaker Studio märkmikud. Falcon-40B majutamiseks LMI ja DeepSpeediga peame kasutama eksemplari ml.g5.24xlarge. Need eksemplarid pakuvad 4x NVIDIA A10G GPU-d, millest igaüks toetab 96 GiB GPU mälu. Lisaks pakub host 96 vCPU-d ja 384 GiB hostimälu. LMI-konteiner aitab lahendada suure osa LLM-ide hostimisega seotud eristamata rasketest probleemidest, sealhulgas mudeli allalaadimisest ja mudeli artefakti partitsioonidest, nii et selle parameetreid saab levitada mitme GPU vahel.

SageMakeri masinõppe (ML) eksemplaride kvoodid võivad kontode lõikes erineda. Kui saate selle postituse jälgimise ajal veateate, mis näitab, et olete ületanud oma g5.24xlarge eksemplaride kvoodi, saate limiiti suurendada Teenuskvootide konsool.

Märkmiku tutvustus

Alustuseks installime ja impordime meie näite jaoks vajalikud sõltuvused. Kasutame nii Boto3 SDK-d kui ka SageMakeri SDK-d. Pange tähele, et me kasutame Amazoni lihtne salvestusteenus (Amazon S3), et salvestada mudeliartefakte, mida SageMaker ja LMI kasutada vajavad, seega seadistasime vastavalt S3 prefiksi muutuja. Vaadake järgmist koodi:

Seejärel loome oma tööruumi jaoks kohaliku kausta, et salvestada meie mudeliartefakte:

Esmalt loome a serving.properties konfiguratsioonifail meie loodud kohalikus kataloogis. See serving.properties fail näitab LMI konteinerile ja esiotsa DJL teenindusteegile, millist mudeli paralleelsus- ja järelduste optimeerimise mootorit me kasutada tahame. Leiate nii DeepSpeedi kui ka Hugging Face Accelerate'i konfiguratsioonivalikud Konfiguratsioonid ja seaded. Siin pange tähele, et seadsime option.model_id parameeter, et määrata, millisest Kallistava näo mudelist tõmmata. SageMaker muudab Hugging Face mudelitega töötamise lihtsaks ja see üks rida on kõik, mida vajate. Lisaks seadsime option.tensor_parallel_degree väärtusele 4, sest meie ml.g5.24xsuurel eksemplaril on neli GPU-d. See parameeter määrab, mitu partitsiooni mudelist luua ja levitada. Pange tähele, et kui oleksime kasutanud kaheksa graafikaprotsessoriga suuremat eksemplari (nt ml.g5.48xlarge) ja määranud ikkagi väärtuseks 4, siis LMI loob mudelist automaatselt kaks koopiat (kaks koopiat, mis on jagatud nelja GPU vahel). Vaadake järgmist koodi:

Võib ka välja vahetada tiiuae/falcon-40b koos tiiuae/falcon-40b-instruct kui see vastab teie vajadustele paremini.

Lisame ka a requirements.txt fail, mille saate määrata vajalike pakettide installimiseks:

Viimane asi, mida vajame, on model.py fail, mida teie mudeliga kasutatakse:

See on kõik! Praeguseks oleme loonud kõik artefaktid, mida Falcon-40B DeepSpeediga juurutamiseks vajate! Pakime kataloogi *.tar.gz faili ja laadime selle Amazon S3 üles. Pange tähele, et tegelikku mudelit pole sellesse faili alla laaditud ega pakitud. LMI konteiner laadib mudeli alla otse Hugging Face'ist. Teil on ka võimalus sihtida S3 ämbrit, kui soovite oma mudeli koopiat asukohta, mille allalaadimine on tõhusam. LMI sisaldab ka optimeerimist suure jõudlusega Amazon S3-st allalaadimiseks. Vaadake järgmist koodi:

Siinkohal jääb üle vaid määratleda konteiner, mida soovime kasutada, ja luua mudelobjekt:

Seejärel loome lõpp-punkti konfiguratsiooni ja loome lõpp-punkti:

Konfiguratsioonielemendid, mida edukaks hostimiseks meeles pidada

Suure mudeli hostimise puhul on oluline tagada, et Hugging Face'i mudeli allalaadimiseks jääks piisavalt aega. Meie testides kulus Falcon-40B eksemplari allalaadimiseks umbes 90 minutit. Peamised konfiguratsioonikomplektid, mis seda võimaldavad, on ContainerStartupHealthCheckTimeoutInSeconds ja ModelDataDownloadTimeoutInSeconds. Veenduge, et SageMakeri lõpp-punkti konfiguratsiooni väärtus oleks kõigi nende jaoks 3600. Lisaks on palju lihtsam alla laadida Amazon S3-st, mitte algse mudeli loomaaiast, kasutades LMI-konteinereid, mis on spetsiaalselt loodud LLMS-i jaoks ja kasutavad utiliiti S5cmd, mis lühendab mudeli allalaadimisaega umbes 10 minutini.

Lõpp-punkti olekut saate jälgida helistades DescribeEndpoint, mis annab teile teada, kui kõik on valmis. Teie lõpp-punkt on nüüd valmis järeldustaotlustele vastama! Kuna LMI tegeleb mudeli jaotamise ja orkestreerimisega teie eest, töödeldakse iga taotlust kõigi nelja graafikaprotsessoriga, mis on saadaval meie ml.g4xlarge eksemplaris. See võimaldab meil majutada LLM-e ja suurendada jõudlust, kui skaleerite GPU-kiirendeid horisontaalselt. Vaadake järgmist koodi:

Kui olete lõpetanud ja soovite lõpp-punkti konfiguratsiooni, lõpp-punkti ja mudeliobjekti kustutada, saate käivitada järgmised käsud.

Selle koodi, millele selles postituses viitasime, leiate täielikust osast märkmik GitHubis.

Järeldus

SageMakeri hostimine ja LMI DLC muudavad LLM-ide, nagu Falcon-40B, hostimise lihtsaks. See võtab diferentseerimata raskuste tõstmise, korraldades seda, mida on vaja mudelite hostimiseks mitmes GPU-s, ja pakub teie vajadustele vastavaid konfigureeritavaid valikuid. Lisaks muutub Hugging Face mudelite kasutamine väga lihtsaks, kuna nendele mudelitele on sisseehitatud tugi.

Selles postituses näitasime, kuidas saate kasutada SageMakerit Falcon-40B mudeli hostimiseks, kasutades DeepSpeedit. Lisaks esitasime näiteid GitHub et majutada Falcon-40B, kasutades Accelerate, ja väiksemaid Falcon-7B mudeleid. Soovitame teil seda proovida LMI-ga SageMakeriga ja tutvuda seni kõige paremini toimiva avalikult saadaoleva LLM-iga!

Autoritest

Jamesi park on Amazon Web Servicesi lahenduste arhitekt. Ta teeb koostööd Amazon.com-iga, et kavandada, ehitada ja juurutada AWS-is tehnoloogilised lahendused ning ta on eriti huvitatud AI-st ja masinõppest. Vabal ajal meeldib talle otsida uusi kultuure, uusi kogemusi ja olla kursis uusimate tehnoloogiatrendidega. Leiate ta aadressilt LinkedIn.

Jamesi park on Amazon Web Servicesi lahenduste arhitekt. Ta teeb koostööd Amazon.com-iga, et kavandada, ehitada ja juurutada AWS-is tehnoloogilised lahendused ning ta on eriti huvitatud AI-st ja masinõppest. Vabal ajal meeldib talle otsida uusi kultuure, uusi kogemusi ja olla kursis uusimate tehnoloogiatrendidega. Leiate ta aadressilt LinkedIn.

Abhi Shivaditya on AWS-i lahenduste vanemarhitekt, kes teeb koostööd strateegiliste ülemaailmsete ettevõtete organisatsioonidega, et hõlbustada AWS-i teenuste kasutuselevõttu sellistes valdkondades nagu tehisintellekt, hajutatud andmetöötlus, võrgundus ja salvestusruum. Tema teadmised seisnevad süvaõppes loomuliku keele töötlemise (NLP) ja arvutinägemise valdkondades. Abhi abistab kliente suure jõudlusega masinõppemudelite tõhusal juurutamisel AWS-i ökosüsteemis.

Abhi Shivaditya on AWS-i lahenduste vanemarhitekt, kes teeb koostööd strateegiliste ülemaailmsete ettevõtete organisatsioonidega, et hõlbustada AWS-i teenuste kasutuselevõttu sellistes valdkondades nagu tehisintellekt, hajutatud andmetöötlus, võrgundus ja salvestusruum. Tema teadmised seisnevad süvaõppes loomuliku keele töötlemise (NLP) ja arvutinägemise valdkondades. Abhi abistab kliente suure jõudlusega masinõppemudelite tõhusal juurutamisel AWS-i ökosüsteemis.

Robert Van Dusen on Amazon SageMakeri vanem tootejuht. Ta juhib süvaõppe mudelite optimeerimist selliste rakenduste jaoks nagu suurte mudelite järeldus.

Robert Van Dusen on Amazon SageMakeri vanem tootejuht. Ta juhib süvaõppe mudelite optimeerimist selliste rakenduste jaoks nagu suurte mudelite järeldus.

Evandro Franco on AI/ML spetsialistilahenduste arhitekt, kes töötab Amazon Web Servicesis. Ta aitab AWS-i klientidel lisaks AWS-ile ületada AI/ML-iga seotud äriprobleeme. Ta on rohkem kui 15 aastat töötanud tehnoloogiaga alates tarkvaraarendusest, infrastruktuurist, serverita ja masinõppeni.

Evandro Franco on AI/ML spetsialistilahenduste arhitekt, kes töötab Amazon Web Servicesis. Ta aitab AWS-i klientidel lisaks AWS-ile ületada AI/ML-iga seotud äriprobleeme. Ta on rohkem kui 15 aastat töötanud tehnoloogiaga alates tarkvaraarendusest, infrastruktuurist, serverita ja masinõppeni.

Qing Lan on AWS-i tarkvaraarenduse insener. Ta on Amazonis töötanud mitmete väljakutset pakkuvate toodetega, sealhulgas suure jõudlusega ML järelduslahenduste ja suure jõudlusega logimissüsteemiga. Qingi meeskond käivitas Amazon Advertisingis edukalt esimese miljardi parameetriga mudeli, mille latentsusaeg on väga väike. Qingil on põhjalikud teadmised infrastruktuuri optimeerimise ja süvaõppe kiirendamise kohta.

Qing Lan on AWS-i tarkvaraarenduse insener. Ta on Amazonis töötanud mitmete väljakutset pakkuvate toodetega, sealhulgas suure jõudlusega ML järelduslahenduste ja suure jõudlusega logimissüsteemiga. Qingi meeskond käivitas Amazon Advertisingis edukalt esimese miljardi parameetriga mudeli, mille latentsusaeg on väga väike. Qingil on põhjalikud teadmised infrastruktuuri optimeerimise ja süvaõppe kiirendamise kohta.

Frank Liu on AWS-i süvaõppe tarkvarainsener. Ta keskendub uuenduslike süvaõppe tööriistade loomisele tarkvarainseneridele ja teadlastele. Vabal ajal meeldib talle sõprade ja perega matkata.

Frank Liu on AWS-i süvaõppe tarkvarainsener. Ta keskendub uuenduslike süvaõppe tööriistade loomisele tarkvarainseneridele ja teadlastele. Vabal ajal meeldib talle sõprade ja perega matkata.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- EVM Finance. Detsentraliseeritud rahanduse ühtne liides. Juurdepääs siia.

- Quantum Media Group. IR/PR võimendatud. Juurdepääs siia.

- PlatoAiStream. Web3 andmete luure. Täiustatud teadmised. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/deploy-falcon-40b-with-large-model-inference-dlcs-on-amazon-sagemaker/

- :on

- :on

- :mitte

- : kus

- $ UP

- 1

- 10

- 100

- 13

- 14

- 15 aastat

- 15%

- 20

- 22

- 27

- 7

- 8

- 9

- a

- MEIST

- kiirendama

- kiirendid

- vastuvõetav

- vastavalt

- Kontod

- täpsus

- täpne

- Saavutada

- üle

- tegelik

- lisades

- lisamine

- Lisaks

- aadress

- Vastuvõtmine

- ADEelis

- reklaam

- vastu

- AI

- AI / ML

- Materjal: BPA ja flataatide vaba plastik

- võimaldama

- võimaldab

- Ka

- Kuigi

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- an

- ja

- mistahes

- API-liidesed

- rakendused

- rakendatud

- OLEME

- valdkondades

- ümber

- kunstlik

- tehisintellekti

- AS

- Abi

- abistab

- seotud

- At

- auto

- Automatiseeritud

- Automaatne

- automaatselt

- saadaval

- AWS

- Taustaprogramm

- BE

- sest

- muutub

- olnud

- alustama

- on

- Parem

- vahel

- miljardeid

- uhke

- keha

- mõlemad

- läbimurdeid

- ehitama

- Ehitus

- sisseehitatud

- äri

- kuid

- by

- helistama

- kutsudes

- CAN

- ei saa

- väljakutseid

- raske

- kontrollima

- kood

- COM

- suhteliselt

- täitma

- koosnevad

- arvuti

- Arvuti visioon

- arvutustehnika

- konfiguratsioon

- tasu

- Konteiner

- Konteinerid

- jutukas

- looma

- loodud

- Praegu

- Kliendid

- kärped

- andmed

- kuupäev

- pühendunud

- sügav

- sügav õpe

- Määratleb

- näitama

- juurutada

- juurutamine

- Disain

- kavandatud

- & Tarkvaraarendus

- DIKT

- erinev

- Raskus

- otse

- avastus

- levitada

- jagatud

- hajutatud arvutus

- do

- Domeenid

- tehtud

- Ära

- lae alla

- iga

- Ajalugu

- lihtsam

- lihtne

- ökosüsteemi

- tõhusalt

- jõupingutusi

- julgustama

- lõpp

- Lõpuks-lõpuni

- Lõpp-punkt

- Mootor

- insener

- Inseneride

- Mootorid

- tagades

- ettevõte

- viga

- hindamine

- kõik

- näide

- näited

- ületanud

- täitmine

- kallis

- Kogemused

- teadmised

- nägu

- hõlbustada

- pere

- kiiremini

- FUNKTSIOONID

- fail

- leidma

- esimene

- sobima

- keskendub

- Järel

- eest

- avastatud

- Sihtasutus

- neli

- sõbrad

- Alates

- esi-

- Esiots

- funktsionaalsus

- edasi

- üldiselt

- generaator

- saama

- Andma

- Globaalne

- Go

- GPU

- GPU

- olnud

- Varred

- käed-

- juhtub

- Olema

- he

- raske

- raske tõstmine

- aitama

- aitab

- siin

- Suur

- suur jõudlus

- teda

- tema

- horisontaalselt

- võõrustaja

- Hosting

- maja

- Kuidas

- Kuidas

- HTML

- http

- HTTPS

- if

- pilt

- import

- oluline

- importivate

- in

- sügavuti minev

- sisaldama

- hõlmab

- Kaasa arvatud

- Suurendama

- näitab

- Infrastruktuur

- Innovatsioon

- uuenduslik

- sisend

- sisendite

- paigaldama

- paigaldamine

- Näiteks

- selle asemel

- Instituut

- Intelligentsus

- suhtlevad

- huvi

- sisse

- IT

- kirjed

- ITS

- töö

- jpg

- Json

- hoidma

- Võti

- teadmised

- keel

- suur

- suurem

- viimane

- Hilinemine

- hiljemalt

- käivitatud

- Leads

- Õppida

- õppimine

- lahkus

- Pärand

- vähem

- Raamatukogu

- peitub

- elu

- tõstmine

- kerge

- nagu

- LIMIT

- joon

- LLM

- kohalik

- liising

- metsaraie

- Madal

- masin

- masinõpe

- tegema

- TEEB

- juhtima

- juht

- palju

- Mälu

- meeles

- protokoll

- ML

- mudel

- mudelid

- Jälgida

- rohkem

- palju

- mitmekordne

- peab

- Natural

- Natural Language Processing

- vajalik

- Vajadus

- vajadustele

- võrgustike loomine

- Uus

- nlp

- märkmik

- nüüd

- Nvidia

- objekt

- of

- pakkuma

- sageli

- on

- ONE

- ainult

- avatud lähtekoodiga

- optimeerimine

- optimeeritud

- valik

- Valikud

- or

- Korraldus

- organisatsioon

- organisatsioonid

- originaal

- OS

- Muu

- meie

- välja

- väljund

- Ületada

- enda

- pakend

- pakendatud

- pakette

- Parallel

- parameeter

- parameetrid

- eriline

- tee

- jõudlus

- tükki

- torujuhe

- Platon

- Platoni andmete intelligentsus

- PlatoData

- Punkt

- populaarne

- post

- volitused

- Predictor

- valmis

- eelmine

- Töödeldud

- töötlemine

- Toode

- tootejuht

- Toodet

- omadused

- anda

- tingimusel

- annab

- avalikult

- eesmärk

- valmis

- saama

- piirkond

- seotud

- replikatsioon

- taotleda

- nõudma

- nõutav

- Vajab

- teadustöö

- Teadlased

- Reageerida

- kaasa

- tagasipöördumine

- Roll

- jooks

- salveitegija

- Skaala

- teaduslik

- teadlased

- SDK

- vaata

- otsib

- vanem

- Serverita

- Teenused

- teenindavad

- istung

- komplekt

- mitu

- näitas

- lihtne

- lihtsustama

- lihtsalt

- ühekordne

- SUURUS

- väiksem

- So

- Ühiskond

- tarkvara

- tarkvaraarenduse

- Tarkvara insener

- lahendus

- Lahendused

- spetsialist

- spetsiaalselt

- laiali

- algus

- alustatud

- käivitamisel

- modernne

- olek

- Veel

- ladustamine

- salvestada

- lihtne

- Strateegiline

- strateegiad

- streaming

- edukas

- Edukalt

- selline

- Kostüüm

- toetama

- vahetama

- süsteem

- Võtma

- võtab

- sihtmärk

- meeskond

- Tehnoloogiad

- Tehnoloogia

- öelda

- testid

- kui

- et

- .

- oma

- SIIS

- Seal.

- Need

- nad

- asi

- asjad

- see

- Sel aastal

- kolm

- Läbi

- läbilaskevõime

- aeg

- korda

- et

- sümboolne

- märgid

- võttis

- töövahendid

- ülemine

- tõrvik

- Rong

- koolitatud

- rongid

- muundav

- trafo

- trafod

- Trends

- triljon

- püüdma

- kaks

- tüüp

- liigid

- tüüpiliselt

- mõistmine

- laetud

- us

- kasutama

- Kasutatud

- kasutamine

- kasulikkus

- väärtus

- väga

- nägemus

- tahan

- oli

- we

- web

- veebiteenused

- nädal

- Hästi

- M

- Mis on

- millal

- samas kui

- mis

- kuigi

- will

- koos

- jooksul

- töö

- töötab

- halvem

- oleks

- kirjutamine

- aasta

- aastat

- sa

- Sinu

- sephyrnet

- ZOO