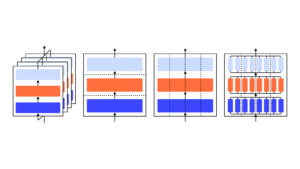

Näitame, et GPT-3 mudel võib õppida väljendama ebakindlust oma vastuste suhtes loomulikus keeles – ilma mudeli logite kasutamata. Küsimuse esitamisel genereerib mudel nii vastuse kui ka usaldustaseme (nt “90% usaldus” või “kõrge usaldusväärsus”). Need tasemed vastavad tõenäosustele, mis on hästi kalibreeritud. Mudel jääb jaotuse nihke ajal ka mõõdukalt kalibreerituks ja on tundlik oma vastuste ebakindluse suhtes, mitte jäljendada inimnäiteid. Meile teadaolevalt on see esimene kord, kui mudel väljendab oma vastuste kalibreeritud ebakindlust loomulikus keeles. Kalibreerimise testimiseks tutvustame CalibratedMath ülesannete komplekti. Võrdleme sõnadega väljendatud määramatuse kalibreerimist ("verbaliseeritud tõenäosus") mudeli logititest eraldatud määramatusega. Mõlemat tüüpi määramatused on võimelised kalibreerimist jaotuse nihke korral üldistama. Samuti pakume tõendeid selle kohta, et GPT-3 võime kalibreerimist üldistada sõltub eelnevalt väljaõpetatud varjatud esitustest, mis korreleeruvad selle vastuste episteemilise ebakindlusega.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- Platoblockchain. Web3 metaversiooni intelligentsus. Täiustatud teadmised. Juurdepääs siia.

- Allikas: https://openai.com/research/teaching-models-to-express-their-uncertainty-in-words

- :on

- a

- võime

- MEIST

- ja

- vastus

- vastuseid

- OLEME

- CAN

- võimeline

- võrdlema

- usaldus

- sõltub

- jaotus

- e

- tõend

- näited

- ekspress

- väljendatud

- esimene

- Esimest korda

- eest

- Alates

- genereerib

- antud

- Suur

- HTTPS

- inim-

- in

- kehtestama

- ITS

- teadmised

- keel

- Õppida

- Tase

- taset

- kaart

- mudel

- mudelid

- Natural

- of

- on

- enda

- Platon

- Platoni andmete intelligentsus

- PlatoData

- anda

- küsimus

- pigem

- jäänused

- s

- tundlik

- suunata

- näitama

- näidatud

- komplekt

- ülesanded

- õpetamine

- Testimine

- et

- .

- oma

- Need

- aeg

- et

- Ebakindlus

- all

- kasutama

- Hästi

- koos

- sõnad

- sephyrnet