Tehisintellekt (AI) on viimasel ajal tekitanud furoori võimalusega muuta inimeste lähenemist ja lahendamist erinevatele ülesannetele ja keerulistele probleemidele. Alates tervishoiust kuni rahanduseni on AI ja sellega seotud masinõppe mudelid näidanud oma potentsiaali keeruliste protsesside sujuvamaks muutmisel, otsustusmudelite täiustamisel ja väärtuslike teadmiste avastamisel.

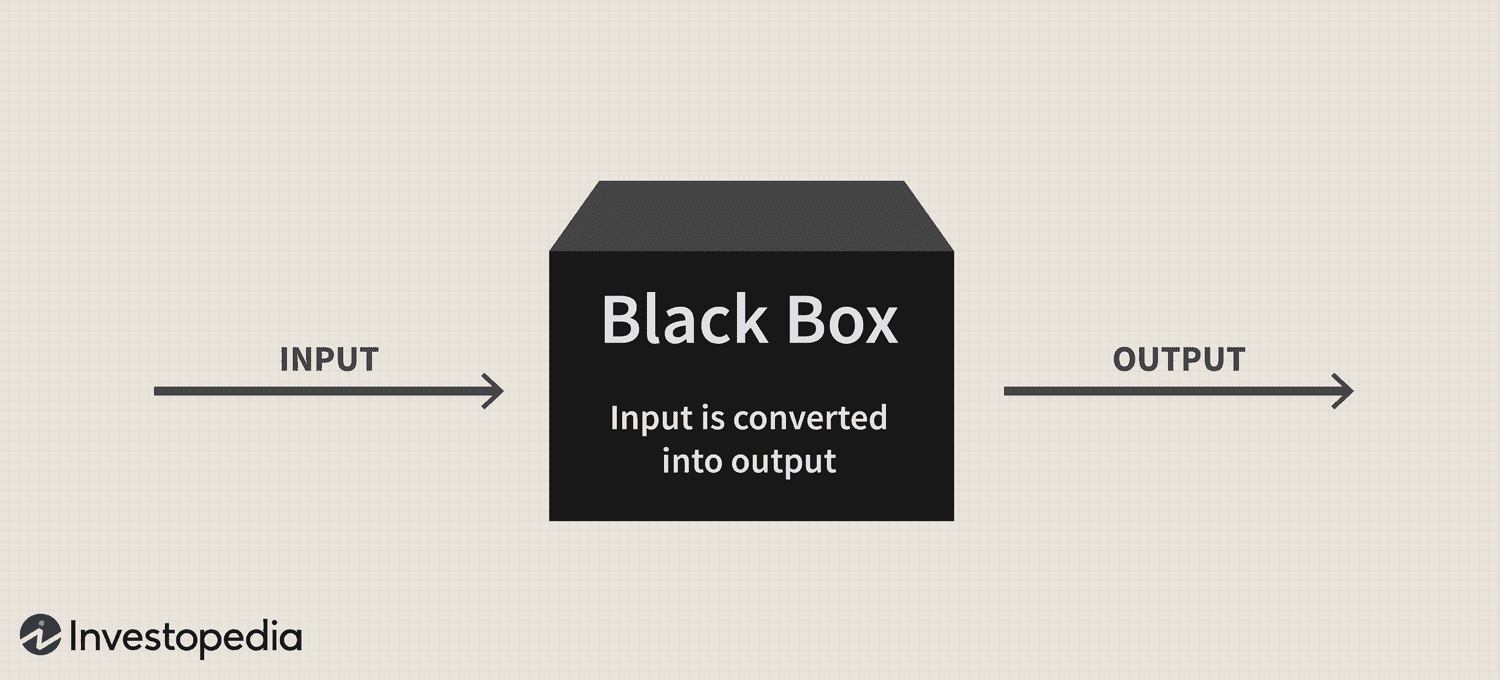

Kuid vaatamata tehnoloogia tohutule potentsiaalile on püsiv "musta kasti" probleem endiselt selle kasutuselevõtul oluliseks väljakutseks, tekitades küsimusi nende keerukate süsteemide läbipaistvuse ja tõlgendatavuse kohta.

Lühidalt, musta kasti probleem tuleneb raskustest mõista, kuidas AI-süsteemid ja masinõppemudelid andmeid töötlevad ning ennustusi või otsuseid loovad. Need mudelid tuginevad sageli keerukatele algoritmidele, mis pole inimestele kergesti arusaadavad, mis põhjustab vastutuse ja usalduse puudumise.

Seega, kuna tehisintellekt integreerub üha enam meie elu erinevatesse aspektidesse, on selle probleemiga tegelemine ülioluline, et tagada selle võimsa tehnoloogia vastutustundlik ja eetiline kasutamine.

Must kast: ülevaade

"Musta kasti" metafoor tuleneb arusaamast, et tehisintellektisüsteemid ja masinõppemudelid toimivad viisil, mis on inimmõistmise eest varjatud, sarnaselt suletud, läbipaistmatu karbi sisuga. Need süsteemid on üles ehitatud keerukatele matemaatilistele mudelitele ja suuremõõtmelistele andmekogumitele, mis loovad keerukaid suhteid ja mustreid, mis juhivad nende otsustusprotsesse. Kuid need sisemised toimimised ei ole inimestele kergesti ligipääsetavad ega arusaadavad.

Praktikas on tehisintellekti musta kasti probleem raskusi tehisintellektisüsteemi ennustuste või otsuste taga olevate põhjenduste dešifreerimisel. See probleem on eriti levinud süvaõppemudelites, nagu närvivõrgud, kus mitu omavahel ühendatud sõlmede kihti töötlevad ja muudavad andmeid hierarhiliselt. Nende mudelite keerukus ja nende teostatavad mittelineaarsed teisendused muudavad nende väljundite põhjuste leidmise äärmiselt keeruliseks.

Tehisintellektil põhineva turundusanalüütika juhtpaneeli BR Groupi tegevjuht Nikita Brudnov ütles Cointelegraphile, et läbipaistvuse puudumine selles, kuidas tehisintellekti mudelid teatud otsuste ja ennustusteni jõuavad, võib olla paljudes kontekstides problemaatiline, nagu meditsiiniline diagnoos, finantsotsuste tegemine ja kohtumenetlused, mis mõjutavad oluliselt tehisintellekti jätkuvat kasutuselevõttu.

Ajakiri: Joe Lubin: tõde ETH asutajate jagunemise ja "Crypto Google" kohta

"Viimastel aastatel on palju tähelepanu pööratud tehisintellekti mudelite poolt tehtud otsuste tõlgendamise ja selgitamise tehnikate arendamisele, nagu funktsioonide tähtsuse skooride genereerimine, otsuste piiride visualiseerimine ja kontrafaktuaalsete hüpoteetiliste selgituste tuvastamine," ütles ta ja lisas:

"Kuid need tehnikad on alles lapsekingades ja pole garantiid, et need on kõigil juhtudel tõhusad."

Lisaks usub Brudnov, et edasise detsentraliseerimise korral võivad regulaatorid nõuda, et tehisintellektisüsteemide tehtud otsused oleksid läbipaistvamad ja vastutustundlikumad, et tagada nende eetiline kehtivus ja üldine õiglus. Ta soovitas ka, et tarbijad võivad kõhkleda tehisintellektil põhinevate toodete ja teenuste kasutamises, kui nad ei mõista nende toimimist ja otsustusprotsessi.

DFG – aktiivselt tehisintellektiga seotud tehnoloogiatesse investeeriva investeerimisühingu – asutaja James Wo usub, et musta kasti probleem ei mõjuta lähitulevikus kasutuselevõttu. Wo sõnul ei huvita enamik kasutajaid, kuidas olemasolevad AI-mudelid töötavad, ja nad saavad neist vähemalt praegu hea meelega kasulikku.

"Keskperspektiivis, kui nende platvormide uudsus kaob, on musta kasti metoodika suhtes kindlasti rohkem skeptilisust. Küsimused suurenevad ka siis, kui tehisintellekti kasutamine siseneb krüpto- ja Web3-sse, kus on rahalised panused ja tagajärjed, mida tuleb arvestada, ”möönis ta.

Mõju usaldusele ja läbipaistvusele

Üks valdkond, kus läbipaistvuse puudumine võib usaldust oluliselt mõjutada, on AI-põhine meditsiiniline diagnostika. Näiteks saavad AI mudelid analüüsida keerulisi meditsiinilisi andmeid tervishoius, et luua diagnoose või ravisoovitusi. Kui aga arstid ja patsiendid ei saa aru nende soovituste põhjustest, võivad nad seada kahtluse alla nende arusaamade usaldusväärsuse ja kehtivuse. See skeptitsism võib veelgi põhjustada kõhklusi tehisintellekti lahenduste kasutuselevõtul, mis võib takistada patsientide ravi ja personaliseeritud meditsiini arengut.

Finantsvaldkonnas saab AI-süsteeme kasutada krediidiskoori määramiseks, pettuste tuvastamiseks ja riskide hindamiseks. Kuid musta kasti probleem võib tekitada ebakindlust nende krediidiskooride õigluse ja täpsuse või pettusehoiatuste põhjuste osas, piirates tehnoloogia võimet tööstust digitaliseerida.

Krüptotööstus seisab silmitsi ka musta kasti probleemi tagajärgedega. Näiteks digitaalsete varade ja plokiahela tehnoloogia juured on detsentraliseerituses, avatuses ja kontrollitavuses. AI-süsteemid, millel puudub läbipaistvus ja tõlgendatavus, eraldavad selles ruumis kasutajate ootusi ja AI-põhiste lahenduste tegelikkust.

Regulatiivsed probleemid

Regulatiivsest vaatenurgast kujutab tehisintellekti musta kasti probleem ainulaadseid väljakutseid. Alustuseks võib tehisintellekti protsesside läbipaistmatus muuta regulaatoritel üha keerulisemaks hinnata nende süsteemide vastavust olemasolevatele reeglitele ja juhistele. Lisaks võib läbipaistvuse puudumine raskendada reguleerivate asutuste võimet töötada välja uusi raamistikke, mis suudavad tegeleda tehisintellekti rakendustest tulenevate riskide ja väljakutsetega.

Seadusandjatel võib olla raskusi tehisintellektisüsteemide õigluse, erapoolikuste ja andmete privaatsuse tavade ning nende võimaliku mõju hindamisega tarbijate õigustele ja turu stabiilsusele. Lisaks võib reguleerivatel asutustel ilma tehisintellektil juhitavate süsteemide otsustusprotsessidest selge arusaamata tekkida raskusi võimalike haavatavuste tuvastamisel ja riskide maandamiseks asjakohaste kaitsemeetmete tagamisel.

Üks märkimisväärne regulatiivne areng selle tehnoloogia osas on olnud Euroopa Liidu tehisintellekti seadus, mis liigub lähemale saada osa bloki põhikirjast pärast ajutise poliitilise kokkuleppe saavutamist 27. aprillil.

Tehisintellektiseaduse põhieesmärk on luua ELis tehisintellekti arendamiseks usaldusväärne ja vastutustundlik keskkond. Seadusandjad on kasutusele võtnud klassifikatsioonisüsteemi, mis liigitab erinevat tüüpi tehisintellekti riskide järgi: vastuvõetamatu, kõrge, piiratud ja minimaalne. See raamistik on loodud erinevate tehisintellekti musta kasti probleemiga seotud probleemide lahendamiseks, sealhulgas läbipaistvuse ja vastutusega seotud probleemid.

Suutmatus AI-süsteeme tõhusalt jälgida ja reguleerida on juba pingestanud suhteid erinevate tööstusharude ja reguleerivate asutuste vahel.

Eelmise kuu alguses oli populaarne AI vestlusbot ChatGPT Itaalias 29 päevaks keelatud, mis on peamiselt tingitud privaatsusprobleemidest, mille riigi andmekaitseagentuur tõstatas ELi andmekaitse üldmääruste (GDPR) kahtlustatavate rikkumiste tõttu. Platvormil lubati aga oma teenuseid jätkata 29. aprillil pärast seda, kui tegevjuht Sam Altman teatas, et tema ja tema meeskond on astunud konkreetseid samme, et järgida regulaatori nõudmisi, sealhulgas avalikustada andmetöötlustavad ja rakendada vanusepiiranguid. piiramismeetmed.

Tehisintellektisüsteemide ebapiisav reguleerimine võib õõnestada üldsuse usaldust tehisintellekti rakenduste vastu, kuna kasutajad tunnevad üha enam muret loomupäraste eelarvamuste, ebatäpsuste ja eetiliste tagajärgede pärast.

Musta kasti probleemi lahendamine

Tehisintellekti musta kasti probleemi tõhusaks lahendamiseks on oluline kasutada läbipaistvust, tõlgendatavust ja vastutust edendavate lähenemisviiside kombinatsiooni. Kaks sellist täiendavat strateegiat on seletatav AI (XAI) ja avatud lähtekoodiga mudelid.

XAI on uurimisvaldkond, mille eesmärk on ületada lõhe tehisintellektisüsteemide keerukuse ja inimese tõlgendatavuse vajaduse vahel. XAI keskendub selliste tehnikate ja algoritmide väljatöötamisele, mis suudavad anda tehisintellektist lähtuvatele otsustele inimlikult arusaadavaid selgitusi, pakkudes ülevaadet nende valikute põhjustest.

XAI-s sageli kasutatavad meetodid hõlmavad asendusmudeleid, funktsioonide tähtsuse analüüsi, tundlikkuse analüüsi ja kohalikke tõlgendatavaid mudeli-agnostilisi selgitusi. XAI rakendamine erinevates tööstusharudes võib aidata sidusrühmadel paremini mõista tehisintellektist lähtuvaid protsesse, suurendada usaldust tehnoloogia vastu ja hõlbustada regulatiivsete nõuete täitmist.

Koos XAI-ga võib avatud lähtekoodiga AI mudelite kasutuselevõtu edendamine olla tõhus strateegia musta kasti probleemi lahendamiseks. Avatud lähtekoodiga mudelid annavad täieliku juurdepääsu AI-süsteeme juhtivatele algoritmidele ja andmetele, võimaldades kasutajatel ja arendajatel nende aluseks olevaid protsesse kontrollida ja mõista.

See suurem läbipaistvus võib aidata luua usaldust ja edendada koostööd arendajate, teadlaste ja kasutajate vahel. Lisaks võib avatud lähtekoodiga lähenemisviis luua tugevamaid, vastutustundlikumaid ja tõhusamaid tehisintellektisüsteeme.

Musta kasti probleem krüptoruumis

Musta kasti probleemil on olulised tagajärjed krüptoruumi erinevatele aspektidele, sealhulgas kauplemisstrateegiatele, turuprognoosidele, turvameetmetele, tokeniseerimisele ja nutikatele lepingutele.

Kauplemisstrateegiate ja turuennustuste valdkonnas koguvad AI-põhised mudelid populaarsust, kuna investorid püüavad algoritmilist kauplemist ära kasutada. Kuid musta kasti probleem takistab kasutajatel arusaamist nende mudelite toimimisest, mistõttu on nende tõhususe ja võimalike riskide hindamine keeruline. Järelikult võib see läbipaistmatus põhjustada ka põhjendamatut usaldust tehisintellektipõhiste investeerimisotsuste vastu või panna investorid liigselt sõltuma automatiseeritud süsteemidest.

Tehisintellektil on oluline roll plokiahela ökosüsteemi turvameetmete tõhustamisel, tuvastades petturlikud tehingud ja kahtlased tegevused. Sellegipoolest muudab musta kasti probleem nende AI-põhiste turbelahenduste kontrollimise protsessi keerulisemaks. Läbipaistvuse puudumine otsuste tegemisel võib kahandada usaldust turvasüsteemide vastu, tekitades muret nende võime pärast kaitsta kasutaja varasid ja teavet.

Tokeniseerimine ja nutikad lepingud – plokiahela ökosüsteemi kaks olulist komponenti – on samuti tunnistajaks tehisintellekti suurenenud integratsioonile. Musta kasti probleem võib aga varjata AI-ga loodud žetoonide või nutika lepingu täitmise loogikat.

Kuna tehisintellekt teeb revolutsiooni erinevates tööstusharudes, muutub musta kasti probleemi lahendamine üha aktuaalsemaks. Teadlaste, arendajate, poliitikakujundajate ja valdkonna sidusrühmade vahelist koostööd soodustades saab välja töötada lahendusi, mis edendavad läbipaistvust, vastutust ja usaldust tehisintellektisüsteemide vastu. Seega on huvitav näha, kuidas see uudne tehnoloogiline paradigma edasi areneb.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoAiStream. Web3 andmete luure. Täiustatud teadmised. Juurdepääs siia.

- Tuleviku rahapaja Adryenn Ashley. Juurdepääs siia.

- Ostke ja müüge IPO-eelsete ettevõtete aktsiaid koos PREIPO®-ga. Juurdepääs siia.

- Allikas: https://cointelegraph.com/news/ai-s-black-box-problem-challenges-and-solutions-for-a-transparent-future

- :on

- :on

- :mitte

- : kus

- 2023

- 27

- a

- võime

- MEIST

- juurdepääs

- juurdepääsetav

- aruandekohustus

- vastutav

- täpsus

- üle

- tegu

- aktiivselt

- tegevus

- lisades

- Lisaks

- aadress

- adresseerimine

- vastu

- Vastuvõtmine

- Vastuvõtmine

- edusammud

- mõjutada

- pärast

- agentuur

- Kokkulepe

- AI

- AI seadus

- AI vestlusrobot

- Tehisintellekti toega

- Eesmärgid

- Märguanded

- algoritmiline

- algoritmiline kauplemine

- algoritme

- Materjal: BPA ja flataatide vaba plastik

- juba

- Ka

- vahel

- an

- analüüs

- analytics

- analüüsima

- ja

- teatas

- rakendused

- lähenemine

- lähenemisviisid

- asjakohane

- Aprill

- OLEME

- PIIRKOND

- ümber

- kunstlik

- tehisintellekti

- AS

- aspektid

- hindamine

- vara

- seotud

- At

- tähelepanu

- Automatiseeritud

- BE

- muutuma

- muutub

- saada

- olnud

- taga

- usub,

- Parem

- vahel

- erapoolikus

- kalduvusi

- Must

- blockchain

- plokiahela ökosüsteem

- Plokkheli tehnoloogia

- asutused

- raamat

- piirid

- Kast

- ühendamine

- ehitama

- usalduse loomine

- ehitatud

- ettevõtted

- by

- CAN

- ei saa

- kapitaliseerima

- mis

- juhtudel

- tegevjuht

- kindel

- väljakutse

- väljakutseid

- raske

- chatbot

- ChatGPT

- valikuid

- klassifikatsioon

- klassifitseerimissüsteem

- selge

- arstid

- Cointelegraph

- koostöö

- kombinatsioon

- täiendavad

- keeruline

- keerukus

- Vastavus

- komponendid

- mõista

- mures

- Murettekitav

- Tagajärjed

- Järelikult

- Arvestama

- tarbija

- Tarbijaõigused

- Tarbijad

- sisu

- kontekstid

- jätkas

- pidev

- leping

- lepingud

- tuum

- võiks

- riigi

- looma

- loodud

- krediit

- otsustav

- krüpto

- Krüptotööstus

- krüptovälja

- armatuurlaud

- andmed

- andmekaitse

- andmetöötlus

- andmekaitse

- andmekogumid

- detsentraliseerimine

- otsus

- Otsuse tegemine

- otsused

- pühendunud

- sügav

- sügav õpe

- kindlasti

- nõudmisi

- Näidatud

- kavandatud

- Vaatamata

- Detection

- arendama

- arenenud

- Arendajad

- arenev

- & Tarkvaraarendus

- erinev

- raske

- raskusi

- Raskus

- digitaalne

- Digitaalsed varad

- digiteerida

- do

- domeen

- Ära

- ajam

- kaks

- kergesti

- ökosüsteemi

- Tõhus

- tõhusalt

- tõhusus

- töötavad

- võimaldades

- suurendama

- suurendamine

- tagama

- tagades

- Siseneb

- keskkond

- oluline

- ETH

- eetiline

- EU

- Euroopa

- hindama

- arenema

- näide

- täitmine

- olemasolevate

- ootused

- selgitades

- nägu

- nägu

- hõlbustades

- õiglus

- tunnusjoon

- rahastama

- finants-

- Firma

- keskendub

- eest

- lähemas

- vorm

- Soodustama

- edendamine

- Asutaja

- Asutajad

- Raamistik

- raamistikud

- pettus

- pettuste avastamine

- pettusega

- Alates

- täis

- funktsioon

- edasi

- Pealegi

- tulevik

- kasumi saamine

- lõhe

- GDPR

- Üldine

- üldised andmed

- tekitama

- teeniva

- anda

- Grupp

- garantii

- suunata

- suunised

- olnud

- õnnelik

- Olema

- he

- tervishoid

- aitama

- Suur

- takistab

- tema

- Kuidas

- aga

- HTTPS

- inim-

- Inimestel

- identifitseerimiseks

- if

- tohutu

- mõju

- mõjutavad

- täitmine

- rakendamisel

- mõjud

- tähtsus

- in

- võimetus

- sisaldama

- Kaasa arvatud

- Suurendama

- kasvanud

- üha rohkem

- tööstusharudes

- tööstus

- info

- omane

- teadmisi

- integreeritud

- integratsioon

- Intelligentsus

- omavahel seotud

- huvi

- huvitav

- sisse

- investeering

- Investorid

- Investeerib

- probleem

- küsimustes

- IT

- Itaalia

- ITS

- puudus

- viimane

- seadusandjad

- kihid

- viima

- juhtivate

- õppimine

- kõige vähem

- Õigus

- kohtumenetlus

- nagu

- piiratud

- Elab

- kohalik

- loogika

- masin

- masinõpe

- tehtud

- tegema

- Tegemine

- viis

- palju

- Turg

- turu ennustused

- Turundus

- matemaatiline

- mai..

- meetmed

- meditsiini-

- meditsiinilised andmed

- meditsiin

- Metoodika

- võib

- minimaalne

- Leevendada

- mudelid

- Jälgida

- kuu

- rohkem

- Pealegi

- kõige

- liikuv

- palju

- mitmekordne

- tingimata

- Vajadus

- võrgustikud

- närvivõrgud

- Sellegipoolest

- Uus

- ei

- sõlmed

- märkimisväärne

- Mõiste

- romaan

- uudsus

- nüüd

- of

- maha

- pakkumine

- sageli

- on

- kunagi

- läbipaistmatu

- avatud lähtekoodiga

- Avatus

- töötama

- or

- meie

- üldine

- makstud

- paradigma

- osa

- eriti

- patsient

- patsientidel

- mustrid

- Inimesed

- täitma

- Isikliku

- Koht

- inimesele

- Platvormid

- Platon

- Platoni andmete intelligentsus

- PlatoData

- mängima

- poliitikakujundajad

- poliitiline

- populaarne

- populaarsus

- võimalus

- potentsiaal

- potentsiaalselt

- võimas

- Praktiline

- tavad

- Ennustused

- esitada

- kingitusi

- levinud

- eelkõige

- privaatsus

- Probleem

- probleeme

- Menetlused

- protsess

- Protsessid

- töötlemine

- Toodet

- edendama

- Edendamine

- kaitse

- anda

- ajutine

- avalik

- heategevuslik ühing

- küsimus

- Küsimused

- tõstatatud

- tõstmine

- põhjendus

- jõuda

- Reaalsus

- realm

- hiljuti

- hiljuti

- soovitused

- kohta

- Reguleerige

- Määrus

- määrused

- Regulaatorid

- regulatiivne

- seotud

- Suhted

- usaldusväärsus

- lootma

- tagajärjed

- nõudma

- Nõuded

- teadustöö

- Teadlased

- vastutav

- kaasa

- Jätka

- murranguliseks muuta

- teeb revolutsiooni

- õigusi

- Oht

- riskianalüüsi

- riskide

- jõuline

- Roll

- eeskirjade

- tagatisi

- Ütlesin

- Sam

- Sam Altman

- Hinded

- turvalisus

- Turvameetmed

- vaata

- otsima

- Tundlikkus

- Teenused

- Komplektid

- näitama

- märkimisväärne

- märgatavalt

- lihtsalt

- Skeptitsism

- nutikas

- arukas leping

- Tarkvaralepingud

- Lahendused

- LAHENDAGE

- keeruline

- allikas

- Ruum

- konkreetse

- jagada

- Stabiilsus

- huvirühmad

- seisma

- seisab

- varred

- Sammud

- Veel

- strateegiad

- Strateegia

- kiirendama

- võitlus

- selline

- kahtlane

- süsteem

- süsteemid

- Tandem

- ülesanded

- meeskond

- tech

- tehnikat

- Tehnoloogiad

- Tehnoloogia

- tingimused

- et

- .

- oma

- Neile

- Seal.

- Need

- nad

- see

- et

- Tokeniseerimine

- märgid

- Jälg

- Kauplemine

- Trading Strategies

- Tehingud

- Muutma

- muundumised

- läbipaistvus

- läbipaistev

- ravi

- Usalda

- usaldusväärne

- Tõde

- kaks

- liigid

- Ebakindlus

- paljastama

- aluseks

- mõistma

- arusaadav

- mõistmine

- ainulaadne

- peale

- us

- kasutama

- Kasutaja

- Kasutajad

- kasulikkus

- väärtuslik

- eri

- Kontrollimine

- Rikkumised

- tähtis

- Haavatavused

- oli

- Web3

- millal

- mis

- will

- koos

- jooksul

- ilma

- tunnistajaks

- wo

- Töö

- toimingud

- aastat

- sephyrnet