Eelmisel aastal teatasime üldisest saadavusest RStudio Amazon SageMakeris, valdkonna esimene täielikult hallatav RStudio Workbenchi integreeritud arenduskeskkond (IDE) pilves. Saate kiiresti käivitada tuttava RStudio IDE ja valida selle aluseks olevaid arvutusressursse üles ja alla ilma oma tööd katkestamata, muutes masinõppe (ML) ja analüütikalahenduste loomise R-vormingus lihtsaks.

Üha suureneva andmemahu genereerimisega kasvavad ML ja statistilise analüüsi jaoks kasutatavad andmekogumid koos. See toob kaasa suurema arendusaja ja arvutusliku infrastruktuuri haldamise väljakutsed. Nende väljakutsete lahendamiseks on andmeteadlased püüdnud rakendada paralleelseid andmetöötlusmeetodeid. Paralleelne andmetöötlus või andmete paralleelsus, võtab suuri olemasolevaid andmekogumeid ja jaotab need mitme töötleja või sõlme vahel, et andmeid korraga kasutada. See võib võimaldada suuremate andmekogumite kiiremat töötlemisaega ja optimeerida arvutuskasutust. See võib aidata ML-i praktikutel luua andmestiku genereerimiseks korduvkasutatavaid mustreid ning samuti vähendada arvutustaristu koormust ja kulusid.

Lahenduse ülevaade

Jooksul Amazon SageMaker, kasutavad paljud kliendid SageMakeri töötlemine et aidata rakendada paralleelset andmetöötlust. Rakenduse SageMaker Processing abil saate kasutada SageMakeris lihtsustatud ja hallatud kogemust oma andmetöötluse töökoormuse (nt funktsioonide projekteerimine, andmete valideerimine, mudeli hindamine ja mudeli tõlgendamine) käitamiseks. See toob palju eeliseid, kuna puudub pikaajaline infrastruktuur, mida hallata – töötlemisjuhtumite töötlemine katkeb, kui tööd on lõpetatud, keskkondi saab standardida konteinerite ja andmete kaudu. Amazoni lihtne salvestusteenus (Amazon S3) on natiivselt eksemplaride vahel jaotatud ning infrastruktuuri sätted on mälu, arvutus- ja salvestusruumi osas paindlikud.

SageMaker Processing pakub võimalusi andmete levitamiseks. Paralleelseks andmetöötluseks peate kasutama ShardedByS3Key valik S3DataDistributionType jaoks. Kui see parameeter on valitud, võtab SageMaker Processing ette antud n eksemplare ja objekte levitada 1/n objektid sisendandmeallikast kõigis eksemplarides. Näiteks kui kaks eksemplari on varustatud nelja andmeobjektiga, saab iga eksemplar kaks objekti.

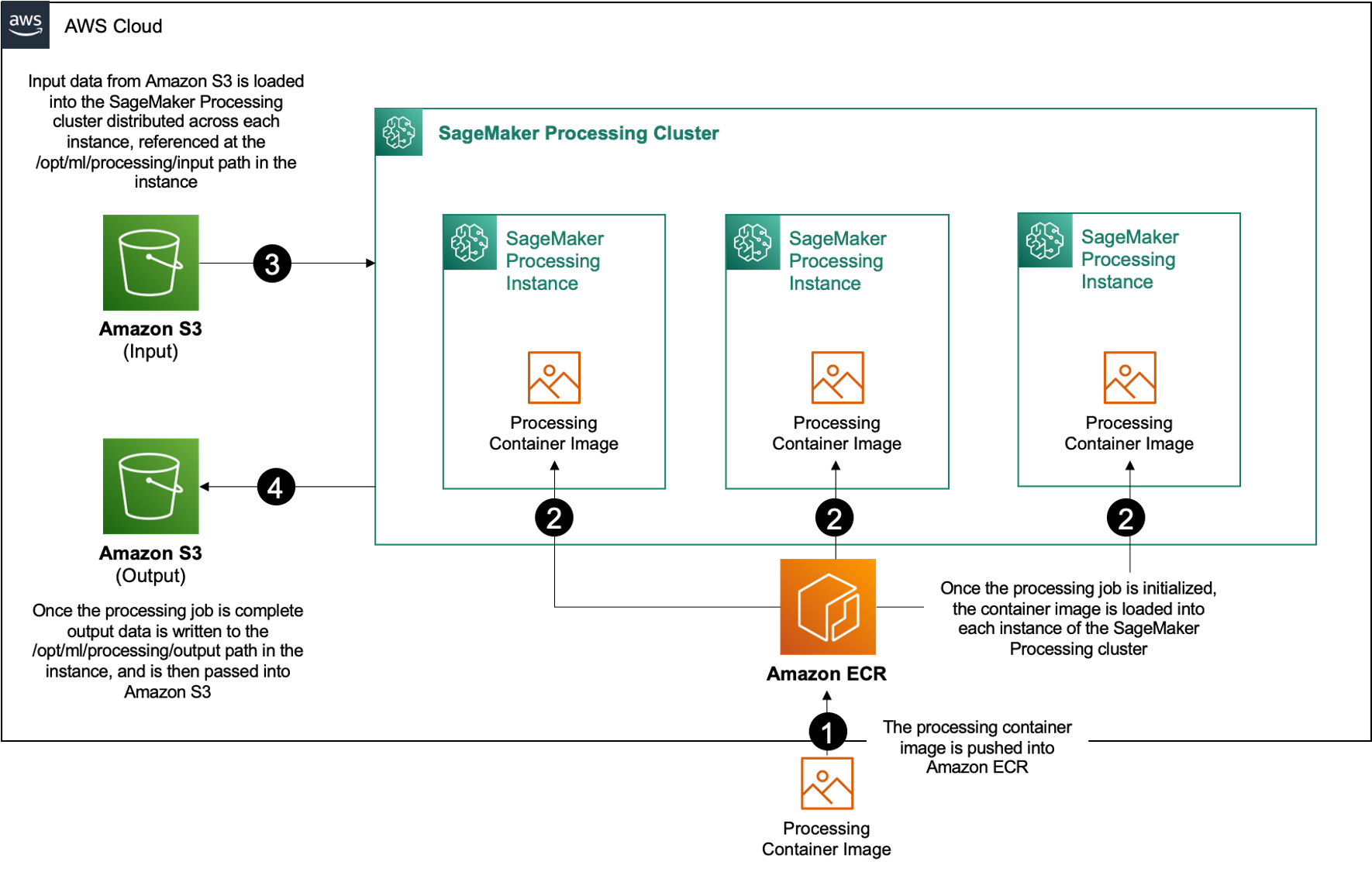

SageMaker Processing nõuab töötlemistööde käitamiseks kolme komponenti:

- Konteinerkujutis, millel on teie kood ja sõltuvused andmetöötluse töökoormuste käitamiseks

- Amazon S3 sisendandmete allika tee

- Tee Amazon S3 väljundandmeallikani

Protsess on näidatud järgmisel diagrammil.

Selles postituses näitame teile, kuidas kasutada RStudiot SageMakeris, et liidestuda mitmete SageMakeri töötlemistöödega, et luua paralleelne andmetöötluskonveier, kasutades R programmeerimiskeel.

Lahendus koosneb järgmistest sammudest:

- Seadistage RStudio projekt.

- Töötlemiskonteineri kujutise koostamine ja registreerimine.

- Käivitage kaheastmeline töötlemiskonveier:

- Esimene samm võtab mitu andmefaili ja töötleb neid töötlemistööde seerias.

- Teine samm ühendab väljundfailid ja jagab need rongi-, testi- ja valideerimisandmekomplektideks.

Eeldused

Täitke järgmised eeltingimused:

- Seadistage RStudio SageMaker Workbenchis. Lisateabe saamiseks vaadake Täielikult hallatava RStudio väljakuulutamine andmeteadlaste jaoks mõeldud Amazon SageMakeris.

- Looge SageMakeris RStudioga kasutaja, kellel on sobivad juurdepääsuõigused.

Seadistage RStudio projekt

RStudio projekti seadistamiseks toimige järgmiselt.

- Liikuge oma Amazon SageMaker Studio SageMakeri konsooli juhtpaneelil.

- Käivitage oma rakendus RStudio keskkonnas.

- Alustage uut RStudio seanssi.

- eest Seansi nimi, sisestage nimi.

- eest Juhtumi tüüp ja pilt, kasutage vaikesätteid.

- Vali Alusta seanssi.

- Liikuge seansse.

- Vali Uus projekt, Versioonihaldus, ja siis Valige Git.

- eest Hoidla URL, sisenema

https://github.com/aws-samples/aws-parallel-data-processing-r.git - Jätke ülejäänud valikud vaikevalikuks ja valige Loo projekt.

Võite navigeerida lehele aws-parallel-data-processing-R kataloogis Faile hoidla vaatamiseks vahekaarti. Hoidla sisaldab järgmisi faile:

Container_Build.rmd/datasetbank-additional-full-data1.csvbank-additional-full-data2.csvbank-additional-full-data3.csvbank-additional-full-data4.csv

/dockerDockerfile-ProcessingParallel_Data_Processing.rmd/preprocessingfilter.Rprocess.R

Ehitage konteiner

Selles etapis koostame oma töötlemiskonteineri kujutise ja lükkame selle edasi Amazoni elastsete konteinerite register (Amazon ECR). Tehke järgmised sammud.

- Liikuge

Container_Build.rmdfaili. - Paigaldage SageMaker Studio Image Build CLI käivitades järgmise lahtri. Enne selle toimingu sooritamist veenduge, et teil oleksid nõutavad õigused. See on CLI, mis on loodud ümbrikupiltide tõukamiseks ja registreerimiseks Studios.

- Käivitage järgmine lahter, et luua ja registreerida meie töötlemiskonteiner:

Pärast töö edukat käivitamist saate väljundi, mis näeb välja järgmine:

Käivitage töötlemiskonveier

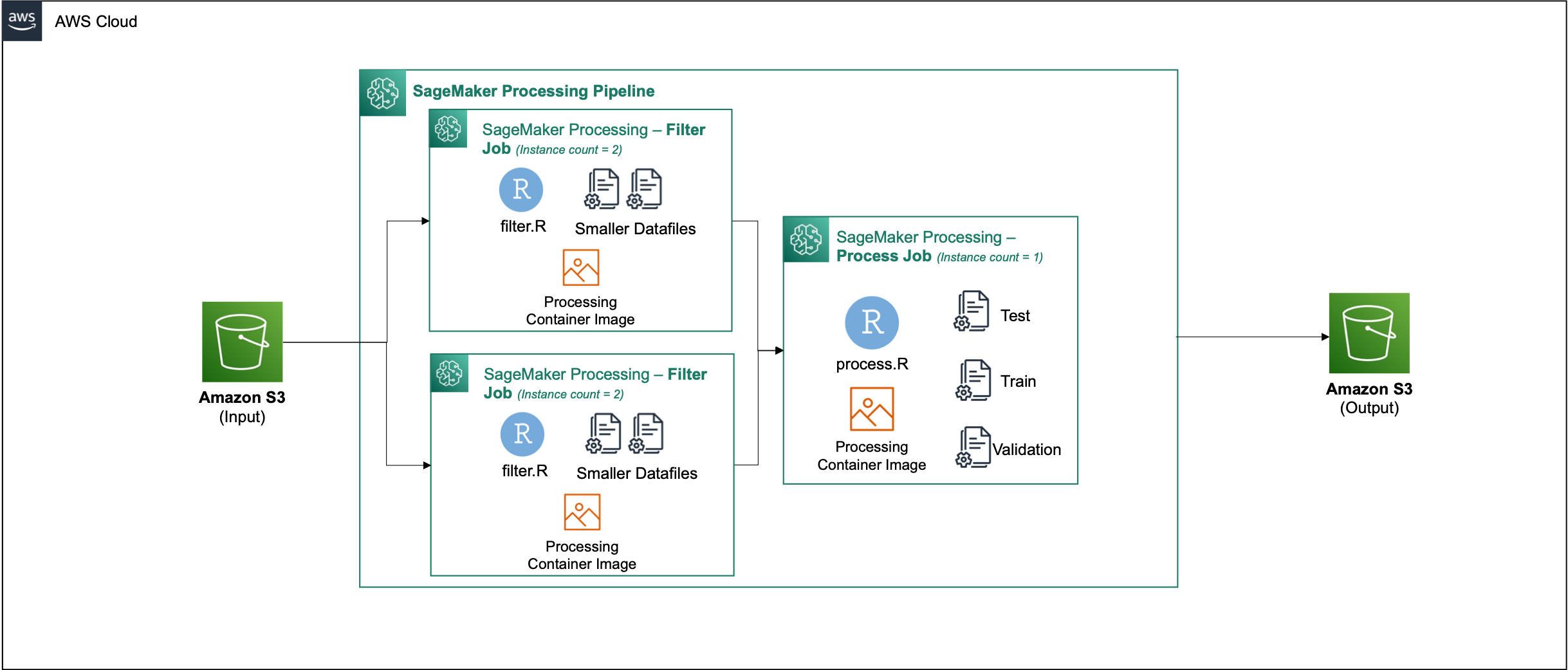

Pärast konteineri koostamist navigeerige lehele Parallel_Data_Processing.rmd faili. See fail sisaldab mitmeid samme, mis aitavad meil luua paralleelset andmetöötluskonveieri SageMaker Processingi abil. Järgmine diagramm kujutab torujuhtme etappe, mille me lõpetame.

Alustage pakettide importimise etapi käivitamisega. Importige vajalikud RStudio paketid koos SageMaker SDK-ga:

Nüüd seadistage oma SageMakeri täitmisroll ja keskkonna üksikasjad:

Initsialiseerige eelmises etapis ehitatud ja registreeritud konteiner:

Siit uurime üksikasjalikumalt kõiki töötlemisetappe.

Laadige andmestik üles

Meie näiteks kasutame Pangaturunduse andmestik UCI-lt. Oleme andmestiku juba mitmeks väiksemaks failiks jaganud. Failide Amazon S3 üleslaadimiseks käivitage järgmine kood:

Pärast failide üleslaadimist liikuge järgmise sammu juurde.

Tehke paralleelne andmetöötlus

Selles etapis võtame andmefailid ja teostame teatud veergude filtreerimiseks funktsioonide projekteerimise. See töö on jaotatud töötlemisjuhtumite seeria vahel (meie näites kasutame kahte).

Me kasutame filter.R faili andmete töötlemiseks ja konfigureerige töö järgmiselt:

Nagu varem mainitud, peate paralleelse andmetöötlustöö käitamisel kohandama sisendparameetrit vastavalt andmete jagamise viisile ja andmete tüübile. Seetõttu pakume killustumismeetodit S3Prefix:

Pärast nende parameetrite sisestamist jaotab SageMaker Processing andmed võrdselt valitud eksemplaride arvu vahel.

Reguleerige parameetreid vastavalt vajadusele ja seejärel käivitage töö instantseerimiseks lahter.

Looge koolituse, testimise ja valideerimise andmekogumid

Selles etapis võtame töödeldud andmefailid, ühendame need ja jagame testi-, koolitus- ja valideerimisandmekogumiteks. See võimaldab meil andmeid oma mudeli koostamiseks kasutada.

Me kasutame process.R faili andmete töötlemiseks ja konfigureerige töö järgmiselt:

Parameetrite kohandamine on vajalik ja seejärel käivitage töö instantseerimiseks lahter.

Käivitage torujuhe

Pärast kõigi sammude loomist käivitage iga etapi käitamiseks töötlemiskonveier, käivitades järgmise lahtri:

Iga töö jaoks kuluv aeg sõltub valitud eksemplari suurusest ja arvust.

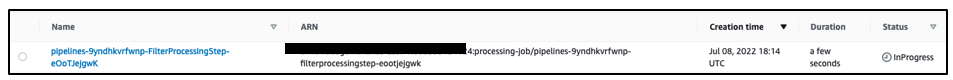

Navigeerige SageMakeri konsooli, et näha kõiki oma töötlemistöid.

Alustame filtreerimistööga, nagu on näidatud järgmisel ekraanipildil.

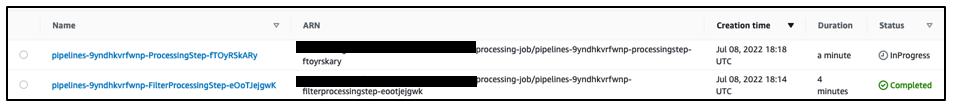

Kui see on lõpetatud, liigub konveier andmetöötlustöö juurde.

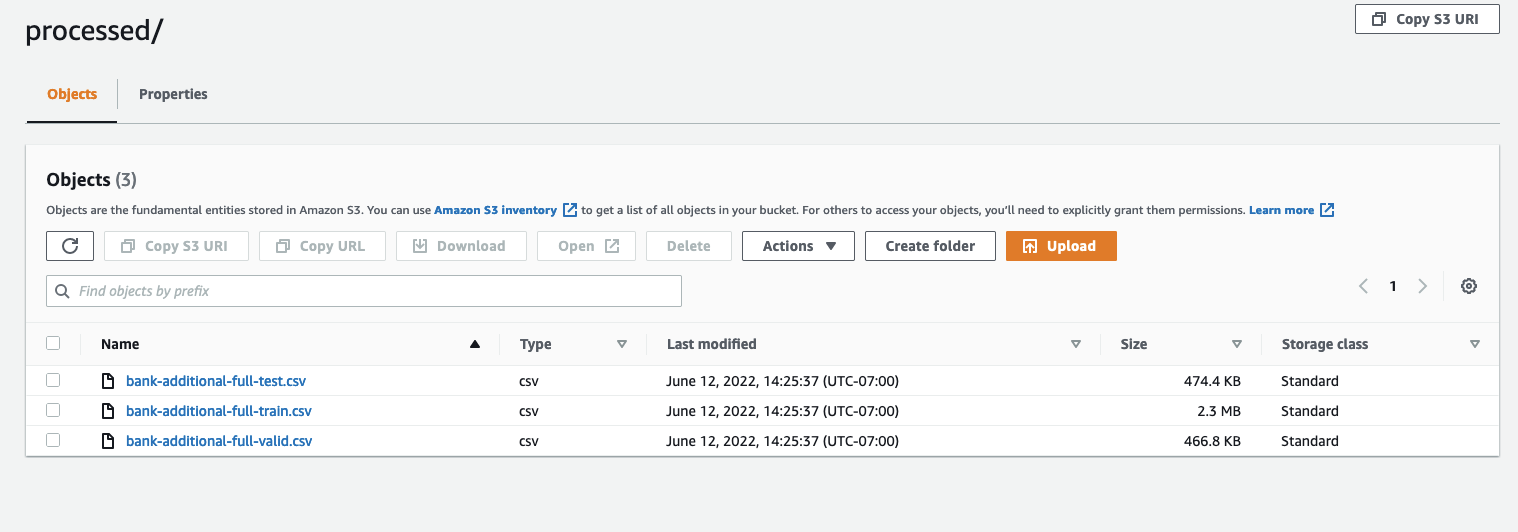

Kui mõlemad tööd on lõpetatud, navigeerige oma S3 ämbrisse. Vaata sisse sagemaker-rstudio-example kaust, all processed. Näete rongi-, katse- ja valideerimisandmekogumite faile.

Järeldus

Kuna andmehulk, mida on vaja üha keerukamate mudelite loomiseks, on suurem, peame muutma oma lähenemisviisi andmete töötlemisele. Paralleelne andmetöötlus on tõhus meetod andmestiku genereerimise kiirendamiseks ning koos kaasaegsete pilvekeskkondade ja tööriistadega, nagu RStudio on SageMaker ja SageMaker Processing, võib see eemaldada suure osa infrastruktuuri haldamise, plaadikoodi genereerimise ja keskkonnahalduse diferentseerimata raskest tõstmisest. Selles postituses vaatasime läbi, kuidas saate SageMakeris RStudios paralleelset andmetöötlust rakendada. Soovitame teil seda proovida, kloonides GitHubi hoidla, ja kui teil on soovitusi, kuidas kogemust paremaks muuta, esitage probleem või tõmbetaotlus.

Selles lahenduses kasutatavate funktsioonide ja teenuste kohta lisateabe saamiseks vaadake RStudio Amazon SageMakeris ja Amazon SageMakeri töötlemine.

Autoritest

Raj Pathak on lahenduste arhitekt ja tehniline nõustaja Fortune 50 ja keskmise suurusega FSI (pangandus, kindlustus, kapitaliturud) klientidele kogu Kanadas ja Ameerika Ühendriikides. Raj on spetsialiseerunud masinõppele koos dokumentide ekstraktimise, kontaktkeskuse teisendamise ja arvutinägemise rakendustega.

Raj Pathak on lahenduste arhitekt ja tehniline nõustaja Fortune 50 ja keskmise suurusega FSI (pangandus, kindlustus, kapitaliturud) klientidele kogu Kanadas ja Ameerika Ühendriikides. Raj on spetsialiseerunud masinõppele koos dokumentide ekstraktimise, kontaktkeskuse teisendamise ja arvutinägemise rakendustega.

Jake Wen on AWS-i lahenduste arhitekt, kelle kirg on ML-koolitus ja loomuliku keele töötlemine. Jake aitab väike- ja keskmise suurusega ettevõtete klientidel disaini- ja juhtimisoskustega rakendusi laialdaselt luua ja juurutada. Väljaspool tööd naudib ta matkamist.

Jake Wen on AWS-i lahenduste arhitekt, kelle kirg on ML-koolitus ja loomuliku keele töötlemine. Jake aitab väike- ja keskmise suurusega ettevõtete klientidel disaini- ja juhtimisoskustega rakendusi laialdaselt luua ja juurutada. Väljaspool tööd naudib ta matkamist.

Aditi Rajnish on Waterloo ülikooli esimese aasta tarkvaratehnika tudeng. Tema huvide hulka kuuluvad arvutinägemine, loomuliku keele töötlemine ja äärearvutus. Ta on kirglik ka kogukonnapõhise STEM-i teavitamise ja propageerimise vastu. Vabal ajal võib teda leida kaljuronimisest, klaverit mängimast või ideaalse skooni küpsetamise õppimisest.

Aditi Rajnish on Waterloo ülikooli esimese aasta tarkvaratehnika tudeng. Tema huvide hulka kuuluvad arvutinägemine, loomuliku keele töötlemine ja äärearvutus. Ta on kirglik ka kogukonnapõhise STEM-i teavitamise ja propageerimise vastu. Vabal ajal võib teda leida kaljuronimisest, klaverit mängimast või ideaalse skooni küpsetamise õppimisest.

Sean Morgan on AWS-i AI/ML-lahenduste arhitekt. Tal on kogemusi pooljuhtide ja akadeemilise uurimistöö valdkonnas ning ta kasutab oma kogemusi, et aidata klientidel AWS-is oma eesmärke saavutada. Vabal ajal on Sean aktiivne avatud lähtekoodiga kaastööline ja hooldaja ning on TensorFlow lisandmoodulite erihuvirühma juht.

Sean Morgan on AWS-i AI/ML-lahenduste arhitekt. Tal on kogemusi pooljuhtide ja akadeemilise uurimistöö valdkonnas ning ta kasutab oma kogemusi, et aidata klientidel AWS-is oma eesmärke saavutada. Vabal ajal on Sean aktiivne avatud lähtekoodiga kaastööline ja hooldaja ning on TensorFlow lisandmoodulite erihuvirühma juht.

Paul Wu on lahenduste arhitekt, kes töötab Texases AWSi Greenfield Businessis. Tema valdkonnad hõlmavad konteinereid ja migratsioone.

Paul Wu on lahenduste arhitekt, kes töötab Texases AWSi Greenfield Businessis. Tema valdkonnad hõlmavad konteinereid ja migratsioone.

- AI

- ai kunst

- ai kunsti generaator

- on robot

- Amazon SageMaker

- tehisintellekti

- tehisintellekti sertifikaat

- tehisintellekt panganduses

- tehisintellekti robot

- tehisintellekti robotid

- tehisintellekti tarkvara

- AWS-i masinõpe

- blockchain

- plokiahela konverents ai

- coingenius

- vestluslik tehisintellekt

- krüptokonverents ai

- dall's

- sügav õpe

- google ai

- masinõpe

- Platon

- plato ai

- Platoni andmete intelligentsus

- Platoni mäng

- PlatoData

- platogaming

- skaala ai

- süntaks

- sephyrnet