Mudeleid tootmises juurutades otsivad organisatsioonid pidevalt viise, kuidas optimeerida oma uusimates kiirendites töötavate alusmudelite (FM-ide) jõudlust, näiteks AWS Inferentia ja GPU-d, et nad saaksid vähendada oma kulusid ja vähendada reageerimise latentsust, et pakkuda lõppkasutajatele parimat kasutuskogemust. Mõned FM-id ei kasuta aga täielikult ära nende eksemplaride jaoks saadaolevaid kiirendeid, mis põhjustab riistvararessursside ebaefektiivset kasutamist. Mõned organisatsioonid juurutavad samasse eksemplari mitu FM-i, et paremini kasutada kõiki saadaolevaid kiirendeid, kuid see nõuab keerukat infrastruktuuri orkestreerimist, mis on aeganõudev ja raskesti hallatav. Kui sama eksemplari jagavad mitu FM-i, on igal FM-il oma skaleerimisvajadused ja kasutusmustrid, mistõttu on keeruline ennustada, millal on vaja eksemplare lisada või eemaldada. Näiteks võib üht mudelit kasutada kasutajarakenduse toiteks, kus kasutus võib teatud tundide jooksul tõusta, samas kui teisel mudelil võib olla ühtlasem kasutusmuster. Lisaks kulude optimeerimisele soovivad kliendid pakkuda parimat lõppkasutaja kogemust, vähendades latentsust. Selleks juurutavad nad sageli mitu FM-i koopiat, et väljastada kasutajate päringuid paralleelselt. Kuna FM-väljundid võivad ulatuda ühest lausest mitme lõiguni, varieerub järelduspäringu täitmiseks kuluv aeg märkimisväärselt, mis põhjustab ettearvamatuid latentsusaegu, kui päringud suunatakse juhuslikult eksemplaride vahel. Amazon SageMaker toetab nüüd uusi järeldusvõimalusi, mis aitavad teil vähendada juurutuskulusid ja latentsust.

Nüüd saate luua järelduste komponendipõhiseid lõpp-punkte ja juurutada masinõppe (ML) mudeleid SageMakeri lõpp-punktis. Järelduskomponent (IC) võtab teie ML-mudeli kokku ja võimaldab teil määrata protsessoreid, GPU-sid või AWS Neuron kiirendid ja skaleerimispoliitikad mudeli kohta. Järelduskomponendid pakuvad järgmisi eeliseid:

- SageMaker paigutab ja pakendab mudelid optimaalselt ML-eksemplaridesse, et maksimeerida kasutust, mis toob kaasa kulude kokkuhoiu.

- SageMaker skaleerib iga mudelit üles ja alla vastavalt teie konfiguratsioonile, et see vastaks teie ML-rakenduse nõuetele.

- SageMaker skaleerib eksemplaride lisamiseks ja eemaldamiseks dünaamiliselt, et tagada võimsuse kättesaadavus, hoides jõudeoleku arvutusi minimaalsena.

- Saate vähendada mudeli nullkoopiat, et vabastada ressursse teiste mudelite jaoks. Samuti saate määrata, et olulised mudelid oleksid alati laaditud ja liikluse teenindamiseks valmis.

Nende võimaluste abil saate vähendada mudeli juurutamise kulusid keskmiselt 50%. Kulude kokkuhoid sõltub teie töökoormusest ja liiklusharjumustest. Toome lihtsa näite, et illustreerida, kuidas mitme mudeli pakkimine ühte lõpp-punkti võib maksimeerida kasutust ja säästa kulusid. Oletame, et teil on vestlusrakendus, mis aitab turistidel mõista kohalikke tavasid ja parimaid tavasid, mis on loodud kasutades kahte Llama 2 varianti: üks on peenhäälestatud Euroopa külastajatele ja teine Ameerika külastajatele. Ootame liiklust Euroopa mudelile vahemikus 00–01 UTC ja Ameerika mudelile ajavahemikus 11–59 UTC. Selle asemel, et juurutada neid mudeleid eraldiseisvates eksemplarides, kus nad poole ajast jõude seisavad, saate nüüd kulude kokkuhoiuks juurutada need ühes lõpp-punktis. Saate vähendada Ameerika mudelit nullini, kui seda pole vaja Euroopa mudeli jaoks võimsuse vabastamiseks ja vastupidi. See võimaldab teil oma riistvara tõhusalt kasutada ja vältida raiskamist. See on lihtne näide, mis kasutab kahte mudelit, kuid saate seda ideed hõlpsalt laiendada, et pakkida sadu mudeleid ühte lõpp-punkti, mis skaleerub teie töökoormusega automaatselt üles ja alla.

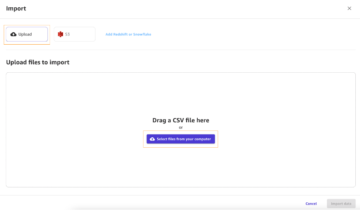

Selles postituses näitame teile IC-põhiste SageMakeri lõpp-punktide uusi võimalusi. Samuti juhendame teid mitme mudeli juurutamisel, kasutades järelduskomponente ja API-sid. Lõpuks kirjeldame üksikasjalikult mõningaid uusi jälgitavuse võimalusi ja seda, kuidas seadistada mudelite jaoks automaatse skaleerimise poliitikaid ja hallata oma lõpp-punktide eksemplari skaleerimist. Mudeleid saate juurutada ka meie uue lihtsustatud interaktiivse kasutuskogemuse kaudu. Toetame ka täiustatud marsruutimise võimalusi, et optimeerida teie järelduste töökoormuste latentsust ja jõudlust.

Ehituskivid

Vaatame põhjalikumalt ja mõistame, kuidas need uued võimalused töötavad. Järgmine on SageMakeri hostimise uus terminoloogia:

- Järelduskomponent – SageMakeri hostimisobjekt, mida saate kasutada mudeli lõpp-punkti juurutamiseks. Järelduskomponendi saate luua, esitades järgmised andmed:

- SageMakeri mudel või SageMakeriga ühilduva pildi ja mudeli artefaktide spetsifikatsioon.

- Arvutage ressursinõuded, mis täpsustavad teie mudeli iga koopia vajadused, sealhulgas protsessori tuumad, hostimälu ja kiirendite arv.

- Mudeli koopia – Järelduskomponendi käitusaegne koopia, mis suudab päringuid teenindada.

- Hallatud eksemplari automaatne skaleerimine – SageMakeri hostimisvõimalus lõpp-punkti jaoks kasutatavate arvutusjuhtumite arvu suurendamiseks või vähendamiseks. Eksemplari skaleerimine reageerib järelduskomponentide skaleerimisele.

Uue järelduskomponendi loomiseks saate määrata konteineri kujutise ja mudeli artefakti või kasutada SageMakeri mudeleid, mille olete võib-olla juba loonud. Samuti peate määrama arvutusressursinõuded, nagu hosti protsessori tuumade arv, hosti mälu või kiirendite arv, mida teie mudel vajab.

Järelduskomponendi juurutamisel saate määrata MinCopies tagamaks, et mudel on juba teie soovitud koguses laaditud ja valmis päringuid teenindama.

Samuti on teil võimalus seada oma poliitikad nii, et järelduskomponendi koopiad ulatuksid nullini. Näiteks kui teil ei ole IC-le vastu koormust, laaditakse mudeli koopia maha. See võib vabastada ressursse, mida saab asendada aktiivsete töökoormustega, et optimeerida lõpp-punkti kasutamist ja tõhusust.

Kui järeldustaotlused suurenevad või vähenevad, võib teie IC-de koopiate arv teie automaatse skaleerimise poliitika alusel samuti suureneda või väheneda. SageMaker tegeleb paigutusega, et optimeerida teie mudelite pakkimist saadavuse ja hinna järgi.

Lisaks, kui lubate hallatud eksemplari automaatse skaleerimise, skaleerib SageMaker eksemplare vastavalt järelduskomponentide arvule, mis tuleb liikluse teenindamiseks teatud ajahetkel laadida. SageMaker suurendab eksemplaride ulatust ning pakib teie eksemplarid ja järelduskomponendid, et optimeerida kulusid, säilitades samal ajal mudeli jõudluse. Kuigi soovitame kasutada hallatud eksemplari skaleerimist, saate rakenduse automaatse skaleerimise kaudu soovi korral ka skaleerimist ise hallata.

SageMaker tasakaalustab järelduskomponendid ja vähendab eksemplare, kui neid enam järelduskomponentide jaoks ei vajata, ning säästab teie kulusid.

API-de tutvustus

SageMaker on kasutusele võtnud uue olemi nimega the InferenceComponent. See lahutab ML-mudeli hostimise üksikasjad lõpp-punktist endast. The InferenceComponent võimaldab teil määrata mudeli hostimise võtmeatribuudid, näiteks SageMakeri mudel, mida soovite kasutada, või konteineri üksikasjad ja mudeli artefaktid. Samuti saate määrata juurutavate komponentide endi koopiate arvu ja vajalike kiirendite (GPU-d, Inf- või Trn-kiirendid) või protsessori (vCPU-d) arvu. See annab teile suurema paindlikkuse, et kasutada ühte lõpp-punkti mis tahes arvu mudelite jaoks, mida kavatsete sellesse tulevikus juurutada.

Vaatame Boto3 API-kutseid, et luua järelduskomponendiga lõpp-punkt. Pange tähele, et on mõningaid parameetreid, mida käsitleme selles postituses hiljem.

Järgmine on näidiskood CreateEndpointConfig:

Järgmine on näidiskood CreateEndpoint:

Järgmine on näidiskood CreateInferenceComponent:

See lahtisidumine InferenceComponent lõpp-punktini pakub paindlikkust. Saate samas infrastruktuuris hostida mitut mudelit, lisades või eemaldades neid vastavalt teie vajadustele. Iga mudelit saab vajadusel iseseisvalt värskendada. Lisaks saate mudeleid skaleerida vastavalt oma ettevõtte vajadustele. InferenceComponent võimaldab teil juhtida ka võimsust mudelite kaupa. Teisisõnu saate määrata, mitut eksemplari igast mudelist hostida. See prognoositav skaleerimine aitab teil täita iga mudeli spetsiifilisi latentsusnõudeid. Üldiselt InferenceComponent annab teile hostitud mudelite üle palju suurema kontrolli.

Järgmises tabelis näitame kõrvuti võrdlust kõrgetasemelisest lähenemisviisist lõpp-punkti loomisel ja kutsumisel ilma InferenceComponent ja koos InferenceComponent. Pange tähele, et CreateModel() on nüüd IC-põhiste lõpp-punktide jaoks valikuline.

| Samm | Mudelipõhised lõpp-punktid | Järeldage komponendipõhiseid lõpp-punkte |

| 1 | Loo mudel (…) | Loo EndpointConfig (…) |

| 2 | Loo EndpointConfig (…) | Loo lõpp-punkt (…) |

| 3 | Loo lõpp-punkt (…) | CreateInferenceComponent(…) |

| 4 | InvokeEndpoint (…) | InvokeEndpoint(InferneceComponentName='value'…) |

Sissejuhatus InferenceComponent võimaldab teil skaleerida mudeli tasemel. Vaata Tutvuge eksemplari ja IC automaatse skaleerimisega lisateabe saamiseks selle kohta, kuidas InferenceComponent töötab automaatse skaleerimisega.

SageMakeri lõpp-punkti kutsumisel saate nüüd määrata uue parameetri InferenceComponentName soovitud tabamiseks InferenceComponentName. SageMaker tegeleb päringu suunamisega eksemplari, mis majutab taotletud objekti InferenceComponentName. Vaadake järgmist koodi:

Vaikimisi kasutab SageMaker päringute juhuslikku suunamist teie lõpp-punkti toetavatele eksemplaridele. Kui soovite lubada kõige vähem ootel olevate päringute marsruutimist, saate määrata marsruutimisstrateegia lõpp-punkti konfiguratsioonis RoutingConfig:

Vähim ootelolevad päringud suunavad marsruudid konkreetsetesse eksemplaridesse, millel on taotluste töötlemiseks rohkem võimsust. See tagab ühtlasema koormuse tasakaalustamise ja ressursside kasutamise.

Lisaks CreateInferenceComponent, on nüüd saadaval järgmised API-d:

DescribeInferenceComponentDeleteInferenceComponentUpdateInferenceComponentListInferenceComponents

InferenceComponent logid ja mõõdikud

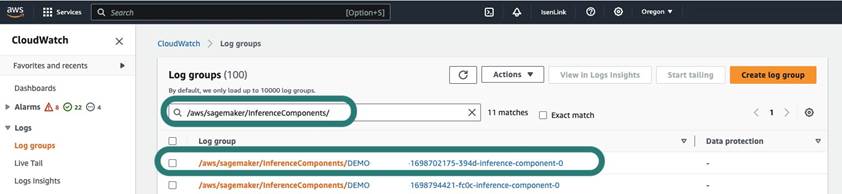

InferenceComponent palgid asuvad /aws/sagemaker/InferenceComponents/<InferenceComponentName>. Kõik konteineris olevatele stderrile ja stdout-ile saadetud logid saadetakse nendele sisselogimistele Amazon CloudWatch.

IC-põhiste lõpp-punktide kasutuselevõtuga on teil nüüd võimalus vaadata täiendavaid eksemplarimõõdikuid, järelduskomponentide mõõdikuid ja kutsumismõõdikuid.

SageMakeri eksemplaride puhul saate nüüd jälgida GPUReservation ja CPUReservation mõõdikud, et näha lõpp-punkti jaoks reserveeritud ressursse teie juurutatud järelduskomponentide põhjal. Need mõõdikud aitavad teil määrata lõpp-punkti ja automaatse skaleerimise poliitika suurust. Saate vaadata ka kõigi lõpp-punkti juurutatud mudelitega seotud koondmõõdikuid.

SageMaker paljastab mõõdikud ka järelduskomponentide tasemel, mis võib näidata üksikasjalikumat ülevaadet teie juurutatud järelduskomponentide ressursside kasutamisest. See võimaldab teil saada ülevaate sellest, kui palju on ressursside kogukasutust, näiteks GPUUtilizationNormalized ja GPUMemoryUtilizationNormalized iga juurutatud järelduskomponendi jaoks, millel võib olla null või palju koopiaid.

Lõpuks pakub SageMaker kutsumismõõdikuid, mis jälgivad nüüd järelduskomponentide kutsumisi koondatult (Invocations) või instantseeritud koopia kohta (InvocationsPerCopy)

Mõõdikute põhjaliku loendi saamiseks vaadake SageMakeri lõpp-punkti kutsumise mõõdikud.

Mudeli tasemel automaatne skaleerimine

Kirjeldatud automaatse skaleerimise käitumise rakendamiseks määrate SageMakeri lõpp-punkti konfiguratsiooni ja järelduskomponendi loomisel vastavalt esialgse eksemplaride arvu ja esialgse mudeli koopiate arvu. Pärast lõpp-punkti ja vastavate IC-de loomist peate IC-tasemel automaatse skaleerimise rakendamiseks esmalt registreerima skaleerimise sihtmärgi ja seejärel siduma skaleerimispoliitika IC-ga.

Skaleerimispoliitika rakendamisel kasutame SageMakerInferenceComponentInvocationsPerCopy, mis on SageMakeri uus mõõdik. See salvestab keskmise kutsete arvu mudeli koopia kohta minutis.

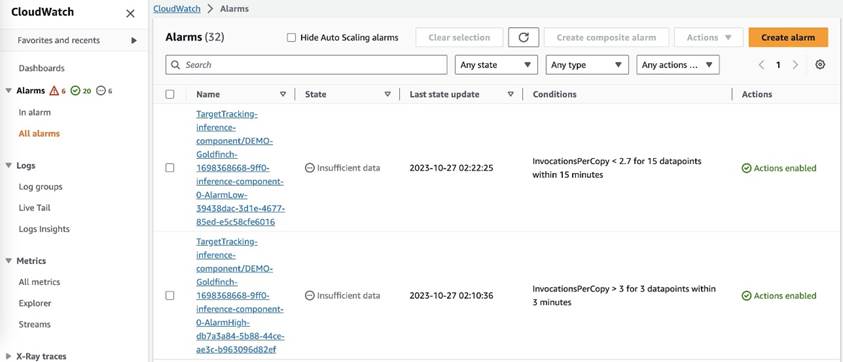

Pärast skaleerimispoliitika määramist loob SageMaker iga automaatse skaleerimise sihtmärgi jaoks kaks CloudWatchi häiret: ühe, et käivitada skaleerimine, kui häire on 3 minutit (kolm 1-minutilist andmepunkti) ja üks, mis käivitab skaleerimise, kui häire on 15 minutit. (15 1-minutilist andmepunkti), nagu on näidatud järgmisel ekraanipildil. Aeg skaleerimistoimingu käivitamiseks on tavaliselt 1–2 minutit pikem kui need minutid, kuna lõpp-punktil kulub aega, et CloudWatchis mõõdikud avaldada, ja aega kulub ka AutoScaling reageerima. Jahtumisperiood on ajavahemik sekundites, mis kulub pärast suurendamis- või vähendamistegevuse lõppemist, enne kui saab alata uus mastaapne tegevus. Kui skaleerimise jahtumine on lõpp-punkti värskendamise ajast lühem, siis see ei toimi, kuna SageMakeri lõpp-punkti ei ole võimalik värskendada, kui see on Ajakohastamine status.

Pange tähele, et IC-taseme automaatse skaleerimise seadistamisel peate veenduma, et MaxInstanceCount parameeter on võrdne või väiksem kui maksimaalne arv IC-sid, mida see lõpp-punkt saab käsitleda. Näiteks kui teie lõpp-punkt on konfigureeritud nii, et lõpp-punkti konfiguratsioonis oleks ainult üks eksemplar ja see eksemplar saab majutada ainult kuni nelja mudeli koopiat, siis MaxInstanceCount peaks olema võrdne 4-ga või sellest väiksem. Siiski saate kasutada ka SageMakeri pakutavat hallatud automaatse skaleerimise võimalust, et automaatselt skaleerida eksemplaride arvu vastavalt nõutavale mudelikoopianumbrile, et täita rohkemate arvutusressursside vajadus. Järgmine koodilõik näitab, kuidas seadistada hallatud eksemplari skaleerimist lõpp-punkti konfiguratsiooni loomise ajal. Sel viisil, kui IC-taseme automaatne skaleerimine nõuab mudelikoopiate majutamiseks rohkem eksemplaride arvu, skaleerib SageMaker automaatselt eksemplari numbrit, et IC-taseme skaleerimine oleks edukas.

Saate sama lõpp-punkti suhtes rakendada mitut automaatse skaleerimise poliitikat, mis tähendab, et saate rakendada traditsioonilist automaatse skaleerimise poliitikat IC-dega loodud lõpp-punktidele ning skaleerida üles ja alla muude lõpp-punkti mõõdikute alusel. Lisateabe saamiseks vaadake Optimeerige oma masinõppe juurutusi Amazon SageMakeri automaatse skaleerimisega. Kuigi see on võimalik, soovitame siiski kasutada hallatud eksemplari skaleerimist, mitte skaleerimist ise hallata.

Järeldus

Selles postituses tutvustasime SageMakeri järelduse uut funktsiooni, mis aitab teil maksimeerida arvutusjuhtumite kasutamist, skaleerida sadade mudeliteni ja optimeerida kulusid, pakkudes samal ajal prognoositavat jõudlust. Lisaks esitasime API-de ülevaate ja näitasime, kuidas konfigureerida ja juurutada oma töökoormuste jaoks järelduskomponente.

Toetame ka täiustatud marsruutimise võimalused et optimeerida oma järelduste töökoormuste latentsust ja jõudlust. SageMaker aitab teil optimeerida oma järelduste töökoormust kulude ja jõudluse osas ning pakkuda teile mudelitasemel detailsust haldamiseks. Oleme loonud a märkmike komplekt mis näitab teile, kuidas juurutada kolme erinevat mudelit, kasutades erinevaid konteinereid ja rakendades GitHubis automaatse skaleerimise eeskirju. Soovitame teil alustada sülearvutiga 1 ja juba täna tutvuda SageMakeri uute hostimisvõimalustega!

Autoritest

Jamesi park on Amazon Web Servicesi lahenduste arhitekt. Ta teeb koostööd Amazon.com-iga, et kavandada, ehitada ja juurutada AWS-is tehnoloogilised lahendused ning ta on eriti huvitatud AI-st ja masinõppest. Vabal ajal meeldib talle otsida uusi kultuure, uusi kogemusi ja olla kursis uusimate tehnoloogiatrendidega. Leiad ta siit LinkedIn.

Jamesi park on Amazon Web Servicesi lahenduste arhitekt. Ta teeb koostööd Amazon.com-iga, et kavandada, ehitada ja juurutada AWS-is tehnoloogilised lahendused ning ta on eriti huvitatud AI-st ja masinõppest. Vabal ajal meeldib talle otsida uusi kultuure, uusi kogemusi ja olla kursis uusimate tehnoloogiatrendidega. Leiad ta siit LinkedIn.

Melanie Li, PhD, on Austraalias Sydneys asuva AWS-i AI/ML-i vanemspetsialist TAM. Ta aitab ettevõtte klientidel luua lahendusi, kasutades AWS-i tipptasemel AI/ML-i tööriistu, ning annab juhiseid ML-lahenduste väljatöötamiseks ja rakendamiseks parimate tavade alusel. Vabal ajal meeldib talle loodusega tutvuda ning pere ja sõpradega aega veeta.

Melanie Li, PhD, on Austraalias Sydneys asuva AWS-i AI/ML-i vanemspetsialist TAM. Ta aitab ettevõtte klientidel luua lahendusi, kasutades AWS-i tipptasemel AI/ML-i tööriistu, ning annab juhiseid ML-lahenduste väljatöötamiseks ja rakendamiseks parimate tavade alusel. Vabal ajal meeldib talle loodusega tutvuda ning pere ja sõpradega aega veeta.

Marc Karp on ML arhitekt koos Amazon SageMaker Service meeskonnaga. Ta keskendub sellele, et aidata klientidel kavandada, juurutada ja hallata ML töökoormust ulatuslikult. Vabal ajal meeldib talle reisida ja avastada uusi kohti.

Marc Karp on ML arhitekt koos Amazon SageMaker Service meeskonnaga. Ta keskendub sellele, et aidata klientidel kavandada, juurutada ja hallata ML töökoormust ulatuslikult. Vabal ajal meeldib talle reisida ja avastada uusi kohti.

Alan Tan on SageMakeri vanem tootejuht, kes juhib jõupingutusi suurte mudelite järelduste tegemisel. Ta on kirglik masinõppe rakendamisest analüütika valdkonnas. Väljaspool tööd naudib ta õues olemist.

Alan Tan on SageMakeri vanem tootejuht, kes juhib jõupingutusi suurte mudelite järelduste tegemisel. Ta on kirglik masinõppe rakendamisest analüütika valdkonnas. Väljaspool tööd naudib ta õues olemist.

Raghu Ramesha on Amazon SageMaker Service'i meeskonna ML-lahenduste vanemarhitekt. Ta keskendub sellele, et aidata klientidel luua, juurutada ja ML-i tootmise töökoormust SageMakerile ulatuslikult üle viia. Ta on spetsialiseerunud masinõppele, tehisintellektile ja arvutinägemisvaldkondadele ning tal on magistrikraadi arvutiteaduses TÜ Dallases. Vabal ajal meeldib talle reisida ja pildistada.

Raghu Ramesha on Amazon SageMaker Service'i meeskonna ML-lahenduste vanemarhitekt. Ta keskendub sellele, et aidata klientidel luua, juurutada ja ML-i tootmise töökoormust SageMakerile ulatuslikult üle viia. Ta on spetsialiseerunud masinõppele, tehisintellektile ja arvutinägemisvaldkondadele ning tal on magistrikraadi arvutiteaduses TÜ Dallases. Vabal ajal meeldib talle reisida ja pildistada.

Rupinder Grewal on AWS-iga Sr Ai/ML spetsialistide lahenduste arhitekt. Praegu keskendub ta mudelite ja MLO-de teenindamisele SageMakeris. Enne seda rolli on ta töötanud masinõppeinsenerina mudelite ehitamise ja hostimise kohta. Töövälisel ajal meeldib talle tennist mängida ja mägiradadel jalgrattaga sõita.

Rupinder Grewal on AWS-iga Sr Ai/ML spetsialistide lahenduste arhitekt. Praegu keskendub ta mudelite ja MLO-de teenindamisele SageMakeris. Enne seda rolli on ta töötanud masinõppeinsenerina mudelite ehitamise ja hostimise kohta. Töövälisel ajal meeldib talle tennist mängida ja mägiradadel jalgrattaga sõita.

Dhawal Patel on AWS-i peamine masinõppearhitekt. Ta on töötanud hajutatud andmetöötluse ja tehisintellektiga seotud probleemide lahendamisel organisatsioonidega alates suurettevõtetest kuni keskmise suurusega idufirmadeni. Ta keskendub süvaõppele, sealhulgas NLP ja Computer Vision domeenidele. Ta aitab klientidel teha SageMakeris suure jõudlusega mudeli järeldusi.

Dhawal Patel on AWS-i peamine masinõppearhitekt. Ta on töötanud hajutatud andmetöötluse ja tehisintellektiga seotud probleemide lahendamisel organisatsioonidega alates suurettevõtetest kuni keskmise suurusega idufirmadeni. Ta keskendub süvaõppele, sealhulgas NLP ja Computer Vision domeenidele. Ta aitab klientidel teha SageMakeris suure jõudlusega mudeli järeldusi.

Saurabh Trikande on Amazon SageMaker Inference'i vanemtootejuht. Ta on kirglik töö klientidega ja teda motiveerib eesmärk demokratiseerida masinõpe. Ta keskendub põhiprobleemidele, mis on seotud keeruliste ML-rakenduste, mitme rentniku ML-mudelite, kulude optimeerimise ja süvaõppemudelite juurutamise kättesaadavamaks muutmisega. Vabal ajal naudib Saurabh matkamist, uuenduslike tehnoloogiate õppimist, TechCrunchi jälgimist ja perega aega veetmist.

Saurabh Trikande on Amazon SageMaker Inference'i vanemtootejuht. Ta on kirglik töö klientidega ja teda motiveerib eesmärk demokratiseerida masinõpe. Ta keskendub põhiprobleemidele, mis on seotud keeruliste ML-rakenduste, mitme rentniku ML-mudelite, kulude optimeerimise ja süvaõppemudelite juurutamise kättesaadavamaks muutmisega. Vabal ajal naudib Saurabh matkamist, uuenduslike tehnoloogiate õppimist, TechCrunchi jälgimist ja perega aega veetmist.

Lakshmi Ramakrishnan on AWS-i Amazon SageMaker Machine Learningi (ML) platvormimeeskonna peainsener, pakkudes toote tehnilist juhtimist. Ta on töötanud Amazonis mitmel insenerirollil üle 9 aasta. Tal on India Karnataka riiklikust tehnoloogiainstituudist pärit infotehnoloogia bakalaureusekraad ja arvutiteaduse magistrikraad Minnesota sõpruslinnade ülikoolist.

Lakshmi Ramakrishnan on AWS-i Amazon SageMaker Machine Learningi (ML) platvormimeeskonna peainsener, pakkudes toote tehnilist juhtimist. Ta on töötanud Amazonis mitmel insenerirollil üle 9 aasta. Tal on India Karnataka riiklikust tehnoloogiainstituudist pärit infotehnoloogia bakalaureusekraad ja arvutiteaduse magistrikraad Minnesota sõpruslinnade ülikoolist.

David Nigenda on Amazon SageMakeri meeskonna tarkvaraarenduse vaneminsener, kes töötab praegu tootmismasinõppe töövoogude täiustamise ja uute järeldusfunktsioonide käivitamise kallal. Vabal ajal püüab ta oma lastega sammu pidada.

David Nigenda on Amazon SageMakeri meeskonna tarkvaraarenduse vaneminsener, kes töötab praegu tootmismasinõppe töövoogude täiustamise ja uute järeldusfunktsioonide käivitamise kallal. Vabal ajal püüab ta oma lastega sammu pidada.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/reduce-model-deployment-costs-by-50-on-average-using-sagemakers-latest-features/

- :on

- :on

- :mitte

- : kus

- $ UP

- 1

- 10

- 100

- 114

- 12

- 13

- 15%

- 150

- 16

- 22

- 360

- 362

- 500

- 7

- 9

- a

- võime

- Võimalik

- MEIST

- kokkuvõtteid

- kiirendid

- juurdepääsetav

- Vastavalt

- Saavutada

- tegevus

- aktiivne

- tegevus

- lisama

- lisades

- lisamine

- Täiendavad lisad

- Lisaks

- aadress

- edasijõudnud

- pärast

- vastu

- agregaat

- AI

- AI / ML

- Alan

- alarm

- Materjal: BPA ja flataatide vaba plastik

- võimaldama

- võimaldab

- juba

- Ka

- Kuigi

- alati

- Amazon

- Amazon SageMaker

- Amazon Web Services

- Amazon.com

- ameerika

- summa

- an

- analytics

- ja

- Teine

- mistahes

- API

- API-liidesed

- taotlus

- rakendused

- kehtima

- Rakendades

- lähenemine

- OLEME

- PIIRKOND

- kunstlik

- tehisintellekti

- AS

- Partner

- seotud

- At

- Austraalia

- auto

- automaatselt

- kättesaadavus

- saadaval

- keskmine

- vältima

- AWS

- toetus

- põhineb

- BE

- sest

- enne

- käitumine

- Kasu

- BEST

- parimaid tavasid

- Parem

- vahel

- ehitama

- Ehitus

- ehitatud

- äri

- kuid

- by

- kutsutud

- Kutsub

- CAN

- võimeid

- võime

- võimeline

- Võimsus

- lööb

- kindel

- väljakutseid

- raske

- muutma

- Vali

- Linnad

- kood

- COM

- võrdlus

- täitma

- Lõpetab

- keeruline

- komponent

- komponendid

- terviklik

- Arvutama

- arvuti

- Arvutiteadus

- Arvuti visioon

- arvutustehnika

- konfiguratsioon

- konfigureeritud

- järjepidev

- pidevalt

- tarbivad

- Konteiner

- Konteinerid

- kontrollida

- tuum

- Vastav

- Maksma

- kulude kokkuhoid

- kulud

- võiks

- looma

- loodud

- loob

- loomine

- loomine

- Praegu

- Kliendid

- toll

- Dallas

- andmed

- andmepunktid

- kuupäev

- vähenema

- pühendunud

- sügav

- sügav õpe

- sügavam

- vaikimisi

- määratlema

- Kraad

- süvenema

- Demokraatlik

- näitab

- Olenevalt

- juurutada

- lähetatud

- juurutamine

- kasutuselevõtu

- kasutuselevõtt

- kirjeldatud

- Disain

- soovitud

- detail

- detailid

- Määrama

- & Tarkvaraarendus

- erinev

- raske

- jagatud

- hajutatud arvutus

- do

- Domeenid

- Ära

- alla

- ajal

- dünaamiliselt

- iga

- kergesti

- mõju

- efektiivsus

- tõhusalt

- jõupingutusi

- võimaldama

- lubatud

- võimaldab

- julgustama

- Lõpp-punkt

- insener

- Inseneriteadus

- tagama

- ettevõte

- ettevõtete

- üksus

- võrdne

- Euroopa

- näide

- ootama

- kogemus

- Kogemused

- uurima

- Avastades

- laiendama

- pere

- tunnusjoon

- FUNKTSIOONID

- väli

- leidma

- esimene

- Paindlikkus

- keskendub

- Järel

- eest

- Sihtasutus

- neli

- tasuta

- sõbrad

- Alates

- täielikult

- Pealegi

- tulevik

- saama

- gif

- GitHub

- Andma

- antud

- annab

- eesmärk

- GPU

- GPU

- granuleeritud

- juhised

- Pool

- käepide

- Käed

- riistvara

- Olema

- he

- aitama

- aidates

- aitab

- siin

- Suur

- kõrgetasemeline

- teda

- tema

- Tulemus

- omab

- võõrustaja

- võõrustas

- Hosting

- Lahtiolekuajad

- Kuidas

- Kuidas

- aga

- http

- HTTPS

- sajad

- idee

- Idle

- if

- Illustreerima

- pilt

- rakendada

- rakendamisel

- oluline

- Paranemist

- in

- Teistes

- Kaasa arvatud

- Suurendama

- iseseisvalt

- India

- ebaefektiivne

- info

- infotehnoloogia

- Infrastruktuur

- esialgne

- uuenduslik

- uuenduslikke tehnoloogiaid

- Näiteks

- selle asemel

- Instituut

- Intelligentsus

- interaktiivne

- huvi

- sisse

- sisse

- Sissejuhatus

- IT

- ITS

- ise

- jpg

- hoidma

- pidamine

- Võti

- lapsed

- suur

- Suured ettevõtted

- viimaseks

- Hilinemine

- pärast

- hiljemalt

- käivitamine

- Juhtimine

- juhtivate

- õppimine

- kõige vähem

- Tase

- nagu

- nimekiri

- Laama

- koormus

- kohalik

- asub

- enam

- Vaata

- otsin

- armastab

- masin

- masinõpe

- tegema

- Tegemine

- juhtima

- juhitud

- juhtimine

- juht

- juhtiv

- palju

- meister

- meistrid

- Maksimeerima

- maksimaalne

- mai..

- vahendid

- Vastama

- Mälu

- meetriline

- Meetrika

- rännanud

- miinimum

- minut

- protokoll

- ML

- MLOps

- mudel

- mudelid

- rohkem

- motiveeritud

- Mountain

- palju

- mitmekordne

- riiklik

- loodus

- Vajadus

- vaja

- vajadustele

- Uus

- nlp

- ei

- meeles

- märkmik

- nüüd

- number

- objekt

- of

- pakkuma

- sageli

- on

- ONE

- ainult

- peale

- optimeerima

- optimeerimine

- valik

- or

- Korraldus

- organisatsioonid

- Muu

- meie

- välja

- väljas

- väljundid

- väljaspool

- tasumata

- üle

- üldine

- enda

- Pakk

- Parallel

- parameeter

- parameetrid

- eriline

- kirglik

- Muster

- mustrid

- kohta

- jõudlus

- periood

- phd

- fotograafia

- Koht

- paigutus

- Kohad

- kava

- inimesele

- Platon

- Platoni andmete intelligentsus

- PlatoData

- mängimine

- võrra

- Poliitika

- poliitika

- võimalik

- post

- võim

- tavad

- ennustada

- ennustatav

- säilitamine

- Peamine

- Eelnev

- probleeme

- protsess

- Toode

- tootejuht

- Produktsioon

- omadused

- anda

- tingimusel

- annab

- pakkudes

- avaldama

- kogus

- juhuslik

- valik

- alates

- Reageerima

- reageerib

- valmis

- tasakaalustamist

- soovitama

- vähendama

- vähendamine

- viitama

- registreerima

- seotud

- kõrvaldama

- eemaldades

- asendatakse

- taotleda

- Taotlusi

- nõudma

- nõutav

- Nõuded

- Vajab

- reserveeritud

- ressurss

- Vahendid

- vastavalt

- vastus

- Roll

- rollid

- liinidel

- Marsruutimine

- jooks

- jooksmine

- runtime

- salveitegija

- SageMakeri järeldus

- sama

- Säästa

- Hoiused

- ütlema

- Skaala

- Kaalud

- ketendamine

- teadus

- sekundit

- vaata

- otsib

- vanem

- Saadetud

- Lause

- teenima

- teenus

- Teenused

- teenindavad

- komplekt

- kehtestamine

- mitu

- Jaga

- ta

- peaks

- näitama

- näitas

- näidatud

- märgatavalt

- lihtne

- lihtsustatud

- ühekordne

- istuma

- SUURUS

- väiksem

- jupp

- So

- tarkvara

- tarkvaraarenduse

- Lahendused

- mõned

- spetsialist

- spetsialiseerunud

- konkreetse

- täpsustus

- kulutama

- Kulutused

- ora

- naelu

- algus

- Alustavatel

- modernne

- olek

- viibides

- Veel

- Strateegia

- edukas

- selline

- varustamise

- toetama

- Toetab

- kindel

- sydney

- tabel

- Võtma

- võtab

- sihtmärk

- meeskond

- TechCrunch

- Tehniline

- Tehnoloogiad

- Tehnoloogia

- tennis

- terminoloogia

- kui

- et

- .

- Piirkond

- Tulevik

- oma

- Neile

- SIIS

- Seal.

- Need

- nad

- see

- need

- kolm

- Läbi

- aeg

- et

- töövahendid

- jälgida

- traditsiooniline

- liiklus

- Reisimine

- Trends

- vallandada

- kaksik

- kaks

- mõistma

- Ülikool

- prognoosimatu

- Värskendused

- ajakohastatud

- Kasutus

- kasutama

- Kasutatud

- Kasutaja

- User Experience

- Kasutajad

- kasutusalad

- kasutamine

- tavaliselt

- UTC

- ära kasutama

- pahe

- vaade

- nägemus

- Külastajad

- kõndima

- läbikäiguks

- tahan

- Jäätmed

- Tee..

- kuidas

- we

- web

- veebiteenused

- Hästi

- millal

- samas kui

- mis

- kuigi

- will

- koos

- ilma

- sõnad

- Töö

- töötas

- Töövoogud

- töö

- töötab

- aastat

- sa

- Sinu

- ise

- sephyrnet

- null