Suured keelemudelid (LLM-id) on muutnud loomuliku keele töötlemise (NLP) valdkonna, parandades selliseid ülesandeid nagu keele tõlkimine, teksti kokkuvõtete tegemine ja sentimentide analüüs. Kuna aga nende mudelite suurus ja keerukus kasvab, on nende toimivuse ja käitumise jälgimine muutunud üha keerulisemaks.

LLM-ide toimivuse ja käitumise jälgimine on nende ohutuse ja tõhususe tagamiseks ülioluline ülesanne. Meie pakutud arhitektuur pakub skaleeritavat ja kohandatavat lahendust veebipõhiseks LLM-i jälgimiseks, võimaldades meeskondadel kohandada teie jälgimislahendust teie konkreetsete kasutusjuhtude ja -nõuetega. AWS-i teenuseid kasutades pakub meie arhitektuur LLM-i käitumist reaalajas ja võimaldab meeskondadel kiiresti tuvastada ja lahendada kõik probleemid või kõrvalekalded.

Selles postituses demonstreerime mõnda mõõdikut veebipõhise LLM-i jälgimiseks ja nende vastavat arhitektuuri, kasutades AWS-teenuseid, näiteks Amazon CloudWatch ja AWS Lambda. See pakub kohandatavat lahendust kaugemale sellest, mis on võimalik mudeli hindamine töökohad Amazonase aluspõhi.

Ülevaade lahendusest

Esimene asi, mida tuleb arvestada, on see, et erinevad mõõdikud nõuavad erinevaid arvutuslikke kaalutlusi. Modulaarne arhitektuur, kus iga moodul saab võtta mudeli järelduste andmeid ja luua oma mõõdikuid, on vajalik.

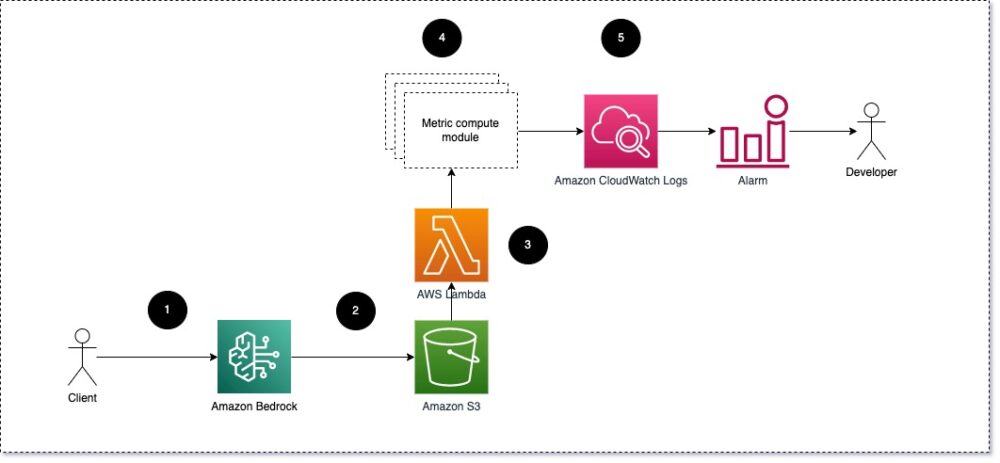

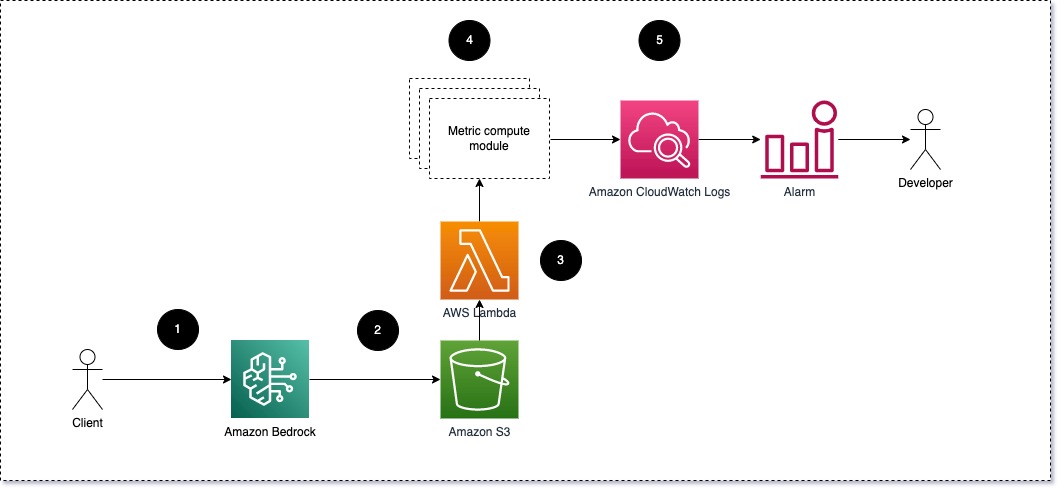

Soovitame igal moodulil võtta sissetulevad järelduspäringud LLM-ile, edastades viipade ja lõpetamise (vastuse) paarid meetrikaarvutusmoodulitele. Iga moodul vastutab oma mõõdikute arvutamise eest sisendviipa ja lõpetamise (vastuse) suhtes. Need mõõdikud edastatakse CloudWatchile, mis saab need koondada ja töötada koos CloudWatchi häiretega, et saata teatisi teatud tingimustel. Järgmine diagramm illustreerib seda arhitektuuri.

Joonis 1: Meetriarvutusmoodul – lahenduse ülevaade

Töövoog sisaldab järgmisi samme:

- Kasutaja esitab Amazon Bedrockile taotluse rakenduse või kasutajaliidese osana.

- Amazon Bedrock salvestab päringu ja lõpetamise (vastuse). Amazoni lihtne salvestusteenus (Amazon S3) vastavalt konfiguratsioonile kutsete logimine.

- Amazon S3-sse salvestatud fail loob sündmuse, mis käivitab lambda funktsioon. Funktsioon kutsub mooduleid.

- Moodulid postitavad oma vastavad mõõdikud aadressile CloudWatchi mõõdikud.

- Häiresignaalid saab arendusmeeskonda ootamatutest mõõdikute väärtustest teavitada.

Teine asi, mida LLM-i jälgimise rakendamisel arvestada, on jälgimiseks õigete mõõdikute valimine. Kuigi on palju potentsiaalseid mõõdikuid, mida saate LLM-i toimivuse jälgimiseks kasutada, selgitame selles postituses mõnda kõige laiemat mõõdikut.

Järgmistes jaotistes tõstame esile mõned asjakohased mooduli mõõdikud ja nende vastava meetrika arvutamise mooduli arhitektuuri.

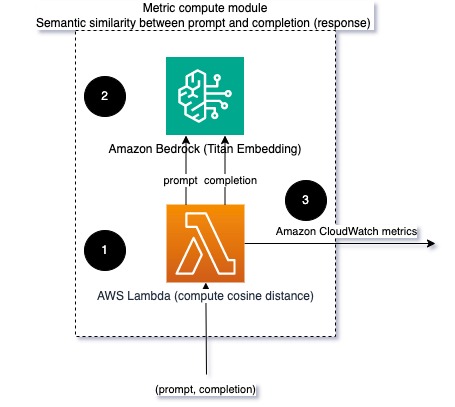

Semantiline sarnasus viipa ja lõpetamise vahel (vastus)

LLM-ide käitamisel saate kinni pidada iga päringu viipa ja lõpetamise (vastuse) ning teisendada need manustamismudeli abil manusteks. Manustused on suuremõõtmelised vektorid, mis esindavad teksti semantilist tähendust. Amazoni titaan pakub selliseid mudeleid Titan Embeddingsi kaudu. Võttes nende kahe vektori vahel vahemaa, näiteks koosinus, saate kvantifitseerida, kui semantiliselt sarnased on viip ja lõpetamine (vastus). Sa võid kasutada SciPy or skikit õppima vektorite vahelise koosinuskauguse arvutamiseks. Järgmine diagramm illustreerib selle meetrika arvutamise mooduli arhitektuuri.

Joonis 2: Meetriarvutusmoodul – semantiline sarnasus

See töövoog sisaldab järgmisi põhietappe:

- Lambda funktsioon võtab voogesitatud sõnumi vastu Amazon kinesis mis sisaldab viipa ja lõpetamise (vastuse) paari.

- Funktsioon saab nii viipa kui ka lõpetamise (vastuse) manustamise ja arvutab koosinuskauguse kahe vektori vahel.

- Funktsioon saadab selle teabe CloudWatchi mõõdikutesse.

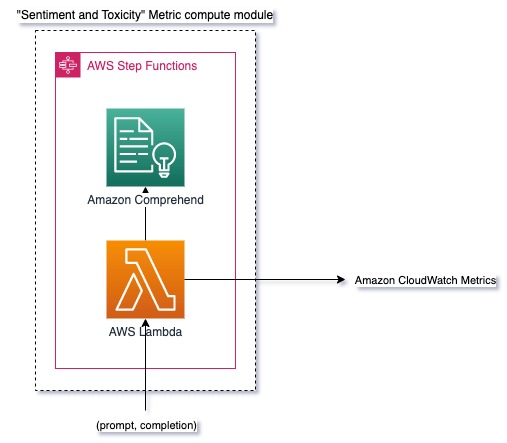

Sentiment ja toksilisus

Sentimentide jälgimine võimaldab teil hinnata vastuste üldist tooni ja emotsionaalset mõju, samas kui toksilisuse analüüs annab olulise mõõdupuu solvava, lugupidamatu või kahjuliku keele esinemise kohta LLM-i väljundites. Kõiki sentimenti või toksilisuse muutusi tuleks hoolikalt jälgida, et tagada mudeli ootuspärane käitumine. Järgmine diagramm illustreerib meetrika arvutamise moodulit.

Joonis 3: Mõõdiku arvutamise moodul – sentiment ja toksilisus

Töövoog sisaldab järgmisi samme:

- Lambda funktsioon saab Amazon Kinesise kaudu viipe ja lõpetamise (vastuse) paari.

- AWS Step Functions orkestreerimise kaudu kutsub funktsioon välja Amazoni mõistmine avastada tunne ja toksilisus.

- Funktsioon salvestab teabe CloudWatchi mõõdikutesse.

Lisateavet meeleolu ja toksilisuse tuvastamise kohta Amazon Comprehendiga leiate aadressilt Looge tugev tekstipõhine toksilisuse ennustaja ja Märgistage kahjulik sisu, kasutades Amazon Comprehendi toksilisuse tuvastamist.

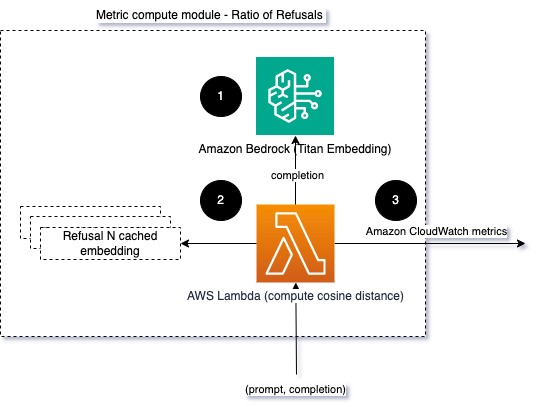

Keeldumiste suhe

Keeldumiste sagenemine, näiteks kui LLM keeldub lõpetamisest teabe puudumise tõttu, võib tähendada, et pahatahtlikud kasutajad üritavad LLM-i kasutada viisil, mis on mõeldud selle vanglasse murdmiseks, või seda, et kasutajate ootused ei ole täidetud ja nad saavad madala väärtusega vastuseid. Üks viis selle esinemise sageduse mõõtmiseks on võrrelda kasutatud LLM-mudeli standardseid keeldumisi LLM-i tegelike vastustega. Näiteks on järgmised mõned Anthropici Claude v2 LLM levinud keeldumisfraasid:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

Fikseeritud viipade komplekti puhul võib keeldumiste arvu suurenemine olla signaal, et mudel on muutunud liiga ettevaatlikuks või tundlikuks. Samuti tuleks hinnata pöördjuhtu. See võib olla signaal, et modell on nüüd rohkem altid mürgistesse või kahjulikesse vestlustesse.

Terviklikkuse ja keeldumissuhte modelleerimiseks saame võrrelda vastust teadaolevate keeldumisfraasidega LLM-ilt. See võib olla tegelik klassifikaator, mis võib selgitada, miks mudel taotlusest keeldus. Saate võtta jälgitava mudeli koosinuskauguse vastuse ja teadaolevate keeldumisreaktsioonide vahel. Järgmine diagramm illustreerib seda meetrika arvutamise moodulit.

Joonis 4: Mõõdiku arvutamise moodul – keeldumiste suhe

Töövoog koosneb järgmistest sammudest:

- Lambda funktsioon võtab vastu viipa ja lõpetamise (vastuse) ning saab Amazon Titani abil vastusest manustamise.

- Funktsioon arvutab koosinuse või eukleidese kauguse vastuse ja mällu salvestatud olemasolevate keeldumisviipade vahel.

- Funktsioon saadab selle keskmise CloudWatchi mõõdikutesse.

Teine võimalus on kasutada hägune sobitamine lihtsaks, kuid vähem võimsaks lähenemisviisiks, et võrrelda teadaolevaid keeldumisi LLM-i väljundiga. Vaadake Pythoni dokumentatsioon näiteks.

kokkuvõte

LLM-i jälgitavus on LLM-ide usaldusväärse ja usaldusväärse kasutamise tagamiseks kriitiline tava. LLM-ide jälgimine, mõistmine ning täpsuse ja usaldusväärsuse tagamine võib aidata teil nende tehisintellekti mudelitega seotud riske maandada. Jälgides hallutsinatsioone, halbu lõpetamisi (vastuseid) ja viipasid, saate tagada, et teie LLM püsib õigel teel ja pakub väärtust, mida teie ja teie kasutajad otsivad. Selles postituses arutasime näidete tutvustamiseks mõnda mõõdikut.

Vundamendimudelite hindamise kohta lisateabe saamiseks vaadake Vundamendimudelite hindamiseks kasutage SageMaker Clarify'ija sirvige lisateavet näiteks märkmikud saadaval meie GitHubi hoidlas. Samuti saate uurida viise, kuidas LLM-i hindamisi laialdaselt rakendada Rakendage LLM-i hindamine mastaapselt, kasutades Amazon SageMaker Clarify ja MLOps teenuseid. Lõpuks soovitame viidata Hinnake suuri keelemudeleid kvaliteedi ja vastutustunde osas LLM-ide hindamise kohta lisateabe saamiseks.

Autoritest

Bruno Klein on masinõppe vaneminsener, kellel on AWS Professional Services Analyticsi praktika. Ta aitab klientidel rakendada suurandmete ja analüüsilahendusi. Väljaspool tööd meeldib talle perega aega veeta, reisida ja uusi toite proovida.

Bruno Klein on masinõppe vaneminsener, kellel on AWS Professional Services Analyticsi praktika. Ta aitab klientidel rakendada suurandmete ja analüüsilahendusi. Väljaspool tööd meeldib talle perega aega veeta, reisida ja uusi toite proovida.

Rushabh Lokhande on vanem andme- ja ML-insener, kellel on AWS Professional Services Analyticsi praktika. Ta aitab klientidel rakendada suurandmete, masinõppe ja analüüsilahendusi. Väljaspool tööd meeldib talle perega aega veeta, lugeda, joosta ja golfi mängida.

Rushabh Lokhande on vanem andme- ja ML-insener, kellel on AWS Professional Services Analyticsi praktika. Ta aitab klientidel rakendada suurandmete, masinõppe ja analüüsilahendusi. Väljaspool tööd meeldib talle perega aega veeta, lugeda, joosta ja golfi mängida.

- SEO-põhise sisu ja PR-levi. Võimenduge juba täna.

- PlatoData.Network Vertikaalne generatiivne Ai. Jõustage ennast. Juurdepääs siia.

- PlatoAiStream. Web3 luure. Täiustatud teadmised. Juurdepääs siia.

- PlatoESG. Süsinik, CleanTech, Energia, Keskkond päikeseenergia, Jäätmekäitluse. Juurdepääs siia.

- PlatoTervis. Biotehnoloogia ja kliiniliste uuringute luureandmed. Juurdepääs siia.

- Allikas: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :on

- :on

- :mitte

- : kus

- 1

- 100

- 143

- 32

- 455

- 7

- a

- MEIST

- täpsus

- tegelik

- Täiendavad lisad

- aadress

- agregaat

- AI

- AI assistent

- AI mudelid

- võimaldab

- Ka

- Kuigi

- am

- Amazon

- Amazoni mõistmine

- Amazon kinesis

- Amazon SageMaker

- Amazon Web Services

- an

- analüüs

- analytics

- ja

- kõrvalekalded

- Antroopne

- mistahes

- taotlus

- lähenemine

- lähenemisviisid

- arhitektuur

- OLEME

- AS

- assistent

- seotud

- At

- saadaval

- keskmine

- AWS

- AWS-i professionaalsed teenused

- AWS-i astmefunktsioonid

- Halb

- BE

- muutuma

- käitumine

- on

- vahel

- Peale

- Suur

- Big andmed

- mõlemad

- kuid

- by

- Kutsub

- CAN

- ei saa

- juhul

- juhtudel

- ettevaatlik

- raske

- valimine

- klassifikaator

- lähedalt

- ühine

- võrdlema

- võrrelda

- lõpetamist

- keerukus

- mõista

- arvutamine

- Arvutama

- arvutustehnika

- Tingimused

- konfiguratsioon

- Arvestama

- kaalutlused

- koosneb

- sisu

- kontekst

- jätkama

- vestlused

- võiks

- loodud

- loob

- kriitiline

- Kliendid

- kohandatav

- andmed

- annab

- näitama

- avastama

- & Tarkvaraarendus

- arendusmeeskond

- skeem

- erinev

- arutatud

- kaugus

- do

- kaks

- iga

- tõhusus

- kumbki

- kinnistamine

- võimaldab

- võimaldades

- tegelema

- insener

- piisavalt

- tagama

- tagades

- hindama

- hinnatud

- hindamine

- hindamine

- hindamised

- sündmus

- näide

- näited

- olemasolevate

- ootused

- oodatav

- Selgitama

- uurima

- pere

- vähe

- väli

- viigipuu

- fail

- Lõpuks

- esimene

- fikseeritud

- Järel

- toit

- eest

- Sihtasutus

- Alates

- funktsioon

- funktsioonid

- gabariit

- saab

- saamine

- GitHub

- golf

- Kasvama

- Juhtub

- kahjulik

- Olema

- he

- aitama

- kasulik

- aitab

- Esile tõstma

- aus

- Kuidas

- aga

- HTML

- http

- HTTPS

- i

- identifitseerima

- illustreerib

- mõju

- rakendada

- rakendamisel

- oluline

- Paranemist

- in

- hõlmab

- Sissetulev

- Suurendama

- üha rohkem

- info

- sisend

- terviklikkuse

- ette nähtud

- Interface

- sisse

- inverse

- kutsub

- küsimustes

- IT

- ITS

- jailbreak

- Tööturg

- jpg

- Võti

- teatud

- puudus

- keel

- suur

- Õppida

- õppimine

- vähem

- LLM

- otsin

- masin

- masinõpe

- tegema

- TEEB

- pahatahtlik

- palju

- keskmine

- tähendus

- mõõtma

- Mälu

- sõnum

- mõdu

- meetriline

- Meetrika

- Leevendada

- ML

- MLOps

- mudel

- mudelid

- modulaarne

- moodulid

- Moodulid

- Jälgida

- jälgitakse

- järelevalve

- rohkem

- Natural

- Natural Language Processing

- vajalik

- Uus

- nlp

- teated

- nüüd

- of

- solvav

- Pakkumised

- sageli

- on

- ONE

- ones

- Internetis

- valik

- or

- Korraldus

- meie

- väljund

- väljundid

- väljaspool

- üldine

- ülevaade

- enda

- paar

- paari

- osa

- Vastu võetud

- Mööduv

- kohta

- jõudlus

- fraasid

- Platon

- Platoni andmete intelligentsus

- PlatoData

- mängimine

- võimalik

- post

- potentsiaal

- võimas

- tava

- olemasolu

- töötlemine

- tootma

- professionaalne

- küsib

- pakutud

- anda

- annab

- Python

- kvaliteet

- kiiresti

- suhe

- Lugemine

- reaalajas

- saab

- soovitama

- viitama

- keeldumine

- keeldus

- asjakohane

- usaldusväärsus

- usaldusväärne

- Hoidla

- esindama

- taotleda

- Taotlusi

- nõudma

- Nõuded

- suhtes

- need

- vastus

- vastuste

- vastutav

- revolutsiooniliselt

- õige

- riskide

- jõuline

- jooksmine

- ohutus

- salveitegija

- salvestatud

- skaalautuvia

- Skaala

- Teine

- lõigud

- semantiline

- saatma

- saadab

- vanem

- tundlik

- tunne

- Teenused

- komplekt

- Vahetused

- peaks

- presentatsioon

- Signaali

- sarnane

- lihtne

- SUURUS

- lahendus

- Lahendused

- mõned

- ruumiline

- konkreetse

- Kulutused

- standard

- Samm

- Sammud

- ladustamine

- lihtne

- otseülekanne

- selline

- soovitama

- kindel

- sobivalt

- Võtma

- võtmine

- Ülesanne

- ülesanded

- meeskond

- meeskonnad

- tehnikat

- tekst

- et

- .

- teave

- oma

- Neile

- Seal.

- Need

- nad

- asi

- see

- Läbi

- aeg

- Titan

- et

- TONE

- jälgida

- Muutma

- Tõlge

- Reisimine

- usaldusväärne

- üritab

- kaks

- mõistmine

- Ootamatu

- kasutama

- Kasutatud

- Kasutaja

- Kasutajaliides

- Kasutajad

- kasutamine

- väärtus

- Väärtused

- kaudu

- nähtavus

- Tee..

- kuidas

- we

- web

- veebiteenused

- M

- Mis on

- millal

- samas kui

- mis

- miks

- Wikipedia

- koos

- Töö

- töövoog

- sa

- Sinu

- sephyrnet